ICCV2021 | SMCA:即插即用的共同注意力模型,可使DETR收敛加速10倍

点击上方“视学算法”,选择加"星标"或“置顶”

计算机视觉领域顶级会议 ICCV(国际计算机视觉大会)于10月11日至17日正式召开。据大会官方统计,ICCV 2021共收到6236篇投稿,其中1617篇论文被接收,接收率为25.9%。上海人工智能实验室多篇论文入选ICCV 2021,本期与读者分享论文解读:《Fast Convergence of DETR with Spatially Modulated Co-Attention》。该论文提出了SMCA,一种即插即用的简单的共同注意力模型,通过在共同注意力机制中引入待检测物体的高斯分布权重,SMCA可使DETR的解码器能更快地在全局特征中定位待检测的物体特征,从而加速DETR收敛。SMCA-DETR在物体检测和全景分割中可以快速收敛,并且取得优秀的检测和分割结果。

论文链接:https://openaccess.thecvf.com/content/ICCV2021/papers/Gao_Fast_Convergence_of_DETR_With_Spatially_Modulated_Co-Attention_ICCV_2021_paper.pdf

代码链接:https://github.com/gaopengcuhk/SMCA-DETR

图1 SMCA和DETR收敛速度的对比

1. Motivation

最近提出的DETR[1]将Transformer结构引入了目标检测任务,并实现了与Faster-RCNN[2]等两阶段目标检测算法相当的性能。同时,DETR去除了以往目标检测算法中需要人工设计的Anchor和NMS等操作,大大简化了目标检测算法的流程。然而,DETR的收敛速度十分缓慢,需要训练500epochs才能取得比较好的检测精度,为开展进一步的研究造成了一定的困难。

论文认为DETR收敛速度较慢的原因之一,来自于其中的共同注意力(Co-Attention)机制。不同于以往基于局部特征的目标检测算法,DETR使用了一系列物体查询向量(Object Queries)与图像的全局特征进行交互,基于共同注意力机制自适应地从图像的不同位置获取物体特征,从而预测物体的边界框坐标及其类别。然而在这一过程中,与每个物体查询向量进行交互的特征区域可能包含大范围的背景,或其他无关的物体。因此,DETR的解码器(Decoder)需要更长的训练时间来使物体查询向量能较为准确地定位物体。

为了解决上述问题,论文提出了一种即插即用的空间调制共同注意力模块(Spatially Modulated Co-attention, SMCA),通过在共同注意力机制中引入物体的高斯分布模型,将每个物体查询向量在共同注意力机制中的搜索范围调整到物体中心附近的一定距离内,从而加速了DETR的收敛。另一方面,受到特征金字塔网络(FPN)[3]等工作在多尺度特征上研究的启发,在编码器(Encoder)中引入了对多尺度特征的编码。通过层内Intra-Scale Self-Attention)和层间(Multi-Scale Self-Attention)自注意力机制以及尺度选择注意力机制,SMCA可以高效地编码图像的多尺度信息,并在解码器中自适应地选择合适尺度的特征,从而提高检测精度。

2. SMCA

1)空间调制的共同注意力模型

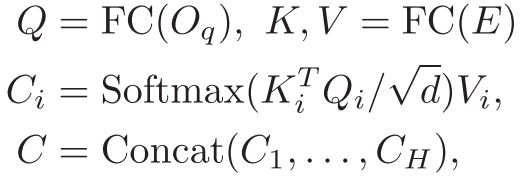

论文首先对DETR中解码器的共同注意力机制进行回顾。对于给定的物体查询向量 和编码器输出的全局图像特征 ,DETR根据变换后两者的注意力矩阵对全局特征进行聚合,从而更新物体查询向量。在这一过程中,共同注意力机制中的特征聚合范围可以直接通过调整注意力矩阵的权重来改变。

因此,SMCA的核心就是通过将可学习的共同注意力权重与预先设定的物体查询向量的空间先验相结合,将特征聚合的范围限制在查询向量估计的物体位置周围,从而加快特征的聚合过程。

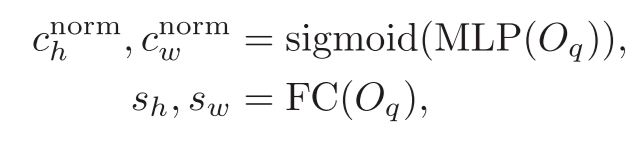

SMCA的共同注意力模型如图2中橙色部分所示,对于每一个给定的物体查询向量 ,SMCA首先对物体的中心位置 以及尺度 进行预测;

并使用预测值生成物体的二维高斯分布 ,其中, 用以调节高斯分布的带宽;

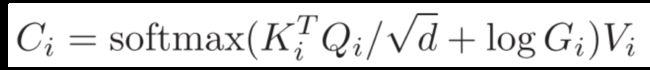

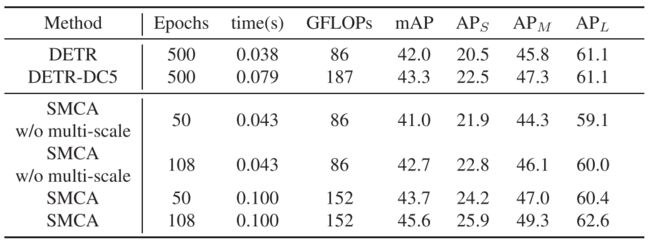

最后,将物体的二维高斯分布与共同注意力模型中的注意力矩阵结合,得到空间调制的多头注意力矩阵如下:

值得注意的是,SMCA在多头注意力模型中的每一分支使用了不同的空间位置估计,分别聚焦于物体上的不同位置,从而更全面地提取物体特征。

2)多尺度融合的共同注意力模型

受到特征金字塔网络的启发,论文进一步在SMCA中引入了多尺度特征的融合机制。如图2下半部分所示,SMCA首先从Backbone网络中获得下采样16倍、32倍和64倍的三个不同尺度的特征图作为解码器的输入。然后在解码器中交替使用层内和层间的自注意力机制(不同尺度的特征分别进行编码/多层特征统一进行编码)编码特征,在这一过程中不同尺度的参数进行了共享。

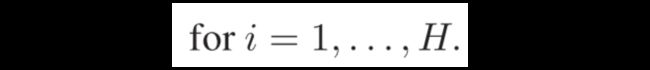

在解码器中,SMCA引入了相对应的尺度选择机制。对于编码器输出的三种不同尺度的特征,SMCA首先根据物体查询向量预测尺度选择的权重:

随后在不同尺度的特征上分别进行特征聚合,最后加权求和得到输出的物体特征。

3. Performance

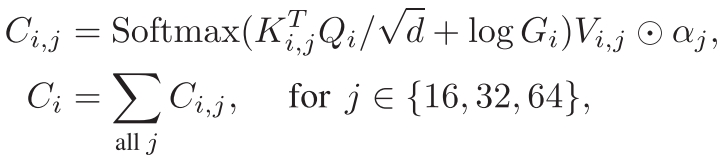

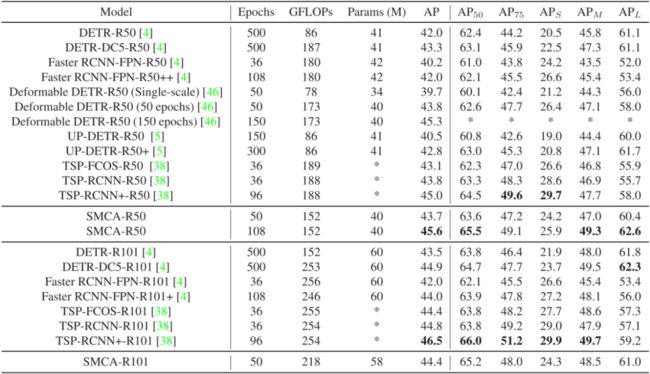

首先,论文将SMCA与基础的DETR模型进行了比较。实验结果如表1所示,通过简单地替换DETR中现有的共同注意力机制并使用多尺度特征,SMCA将DETR的收敛速度提升了接近10倍,并取得了更高的性能。

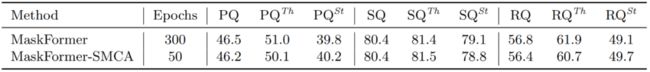

其次,论文在下游任务,如全景分割上也对SMCA机制进行了测试。基于MaskFormer[4] ResNet50模型,在将网络中的共同注意力机制替换为SMCA后(未使用多尺度特征融合),论文中的方法仅使用1/6的训练时间即取得了和原模型相当的结果。

表2 SMCA在Panoptic Segmentation任务上的结果

表2 SMCA在Panoptic Segmentation任务上的结果

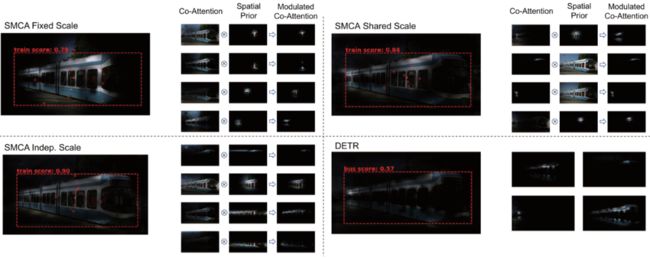

此外,为了进一步验证本文所提出的共同注意力机制的有效性,论文对解码器中的注意力权重以及预测的物体位置进行了可视化。如图3所示,相较于原始的DETR,通过在多头注意力模型的每一分支中对位置和尺寸分别进行预测,SMCA可以产生更加准确和紧凑的注意力权重分布,加速了对于物体特征的提取过程。

最后,如表3所示,与其他同类方法相比,SMCA可以使用类似或更少的训练时间取得相当的检测结果,证明了本文所提出方法的有效性。

图4 可视化结果

[1] N. Carion, F. Massa, G. Synnaeve, N.Usunier, A. Kirillov, and S. Zagoruyko, “End-to-End Object Detection withTransformers,” in In European Conference on Computer Vision, 2020, pp.213–229.

[2] S.Ren, K. He, R. Girshick, and J. Sun, “Faster R-CNN: Towards real-time objectdetection with region proposal networks,” in Advances in Neural InformationProcessing Systems, 2015, vol. 2015-January.

[3] T.Y. Lin, P. Dollár, R. Girshick, K. He, B. Hariharan, and S. Belongie, “Featurepyramid networks for object detection,” in Proceedings of the IEEEConference on Computer Vision and Pattern Recognition (CVPR), 2017, vol.2017-Janua, pp. 936–944.

[4] B.Cheng, A. G. Schwing, and A. Kirillov, “Per-Pixel Classification is Not All YouNeed for Semantic Segmentation,” arXiv, 2021.

如需了解更多详情,可访问本文第一作者,上海人工智能实验室青年科学家高鹏的个人主页 https://gaopengcuhk.github.io/

![]()

点个在看 paper不断!