RetinaNet与点云聚类耦合的深度学习个体树分割方法研究

ABSTRACT

人类活动的增加对全球森林资源造成了严重干扰,如何准确识别单株树木已成为森林资源调查的重要任务。为了得到准确的个体树木数量,本文以针叶林和针阔混交林为实验样本,以数字正射影像图和机载激光雷达点云为研究数据。我们提出了一种基于RetinaNet模型和PCS算法的深度学习单树分割方法,通过在地块(具有高、中、低密度)进行比较分析(经典分水岭算法和层堆叠算法)。实验结果表明,本文提出的方法可以解决高密度森林中单棵树的分割问题,提高其自动化程度。与Watershed算法和Layer stacking算法相比,F-Measure分别提高了6%-29%和7%-20%。也就是说,本文提出的单棵树分割结果不仅可以提高单棵树分割的精度,而且可以保持较高的检测率,可以满足单棵树提取的准确性和高效率,从而满足现代林业调查的需要。

INDEX TERMS: 深度学习,单棵树分割,机载激光雷达,数字正射影像图,计算机图形学。

I. INTRODUCTION

森林作为最重要的自然资源之一,在人类的发展和生存中具有不可替代的作用。随着城市化和工业化的加速,森林资源的过度利用造成了森林生态系统的严重失衡,对全球碳循环产生了相当大的影响[1]。个体作为森林的基本单位,快速准确的获取树木信息可以为监测和管理森林资源提供有效的保障[2]。传统的单株木调查方法是手工进行的,劳动强度大、周期长、成本高,难以满足调查时效性的需要[3]。

机载激光雷达是一种新兴的主动遥感技术,具有非常高的距离分辨能力、抗干扰能力和树冠穿透能力,可以快速准确地获取多次回波信息,尤其是森林空间的三维坐标信息[4]。机载激光雷达在林业调查中的应用,可以获得森林面积的地形特征,以及树木的三维结构特征,如树高、冠层直径、冠层面积等,为森林生长提供数据支持模型和生物量估计[5]。因此,单棵树分割提出了一个基本步骤来准确估计树木的三维结构参数[6]。

现有的个体树分割方法可以分为两类。第一类是通过基于树冠高度模型(CHM)[7]的数字高程模型和数字表面模型获得的,以局部最大CHM中的最高点作为树顶,用于个体树分割。例如,分水岭算法[8]基于CHM进行个体树分割,具有移动窗口的最大值[9]和多级分割[10]。然而,在CHM变换过程中需要进行插值,这容易导致信息的丢失,因为CHM只能保留地表高程信息,从而覆盖低植被。导致一些小树无法准确提取,影响分割结果的准确性[11],[12]。另一类是基于归一化的点云方法,通过计算海量的3D点云,对树顶点进行聚类。与CHM分割方法相比,这类方法不需要插值生成光栅图像,避免了单个树木信息在格式转换过程中的信息丢失,如K-means聚类[13],点云分割(PCS)[14]和层堆叠算法[15]等。目前,随着计算机技术的飞速发展,它已经逐渐成为单株树木提取研究的主流[16]。然而,在密集复杂的森林环境中,通过上述方法进行的单木分割存在较多的过分割和欠分割现象[17]、[18]。

针对上述问题,Sun等[19]完善了K-means聚类算法,提高了单棵树分割的准确率,但效果并不明显。数字正射影像图(DOM),作为无人机遥感的产物,精度高,现状强,可广泛应用于测绘、林业等领域[20]。深度学习是近年来的研究热点,在图像特征提取和目标识别方面表现良好。其中,基于深度学习框架结合高分辨率多源遥感数据的目标检测已得到广泛应用[21],如船舶检测[22]、建筑物选择[23]、汽车检测[24]等。

现有的单棵树分割方法如果遇到各种复杂的森林环境,很多都会涉及到复杂的参数设置,从而降低了方法的自动化程度。深度学习通过多层次的框架进行计算,结合高分辨率DOM可以大大提高准确性和自动化程度。在此基础上,本文提出了一种基于深度学习和点云聚类的单棵树分割方法,结合机载LiDAR点云和DOM,可以提取出准确的单棵树,为深入开发提供参考和帮助。林业调查领域的无人机遥感与深度学习方法研究。

本文的研究目标主要包括:(1)利用无人机采集机载LiDAR数据和DOM; (2) 用DOM训练深度学习检测模型,提取DOM中的树冠作为有效mask,提高DOM利用率;(3)结合机载雷达数据,采用局部最大值法计算mask内对应点云的最大高程作为初始树顶点,以减弱个别树过分割现象的发生; (4)用PCS算法从树的顶点开始迭代计算,提取个体树的分割和个体树的结构参数,对分割现象下的个体树进行优化,提高个体树分割的准确性;(5)评估本文提出的方法的单棵树分割性能,并将其与两种经典分割算法进行比较,包括分水岭算法和层堆叠算法。

II. MATERIALS AND METHODS

A. DATA

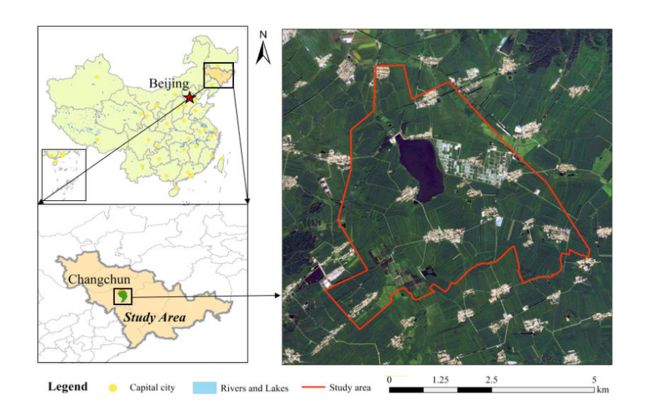

本文所用激光雷达数据于2020年6月在吉林省长春市获取。地理位置如图1所示,采用大疆无人机搭载R250机载激光运动测量系统进行测量,飞行高度为500m,飞行高度为500m。飞行速度120km/h,激光扫描视场角70°,单向覆盖面积750m2,相机视地覆盖范围500m×668m。

为保证方法的可靠性,选择针叶林、针阔混交林作为两个研究区,其中针叶林主要覆盖松树等树种,针阔混交林主要覆盖松树等树种。杨树和松树。机载激光雷达测量采集的数据包括点云数据、DOM数据(像素大小为0.1×0.1m)和测区惯性测量单元数据。

在研究区内,相应地布置了高密度、中密度和低密度三个样地,并在每个样地上设置了编号桩。在针叶林中,将样地按密度等级从低到高划分为样地1、样地2、样地3,然后以同样的方式对针阔混交林进行区划,将这些样地编号为样地图4、图5和图6。通过在每个样本字段中找出它们,验证了单个树分割数量的准确性。并且在每个样地中,通过激光测高仪测量了可以识别为编号的单棵树,以及每棵树的高度和冠层宽度。

图1. 研究地点。

B. METHODS AND ACCURACY

研究方法如图2所示。首先,无人机搭载机载LiDAR和摄像头采集现场数据,获取DOM和原始点云。然后,对点云进行过滤和归一化,得到归一化的点云。其次,利用深度学习中的RetinaNet模型检测DOM中的个体树冠,提取个体树冠的轮廓作为mask。之后,以树冠mask为初始树顶点,提取归一化点云的局部区域最大值,最后作为种子点,通过PCS算法进行单棵树的分割,得到相应的结果。

图 2. 建议方法的工作流程。

1)基于深度学习的DOM个体树检测

深度学习是机器学习的一个重要分支,强调从连续层学习[25]。分类[26]、检测[27]、分割[28]是计算机理解图像的三个层次。其中,分类是指将DOM的结构转化为树木的信息,分割是指对DOM的像素点的描述,检测侧重于树木的位置信息以及DOM中的类别信息。

RetinaNet是Facebook AI团队在2018年提出的一种新的单阶段目标检测工具,用于解决密集检测问题[29]。其结构如下图所示:

根据图3,ResNet[30]、特征金字塔网络(FPN)[31]和2个全卷积网络(FCN)[32]、[33]的组成,RetinaNet可以解决误分和漏分严重不平衡的问题在DOM个体树检测中,以改进的交叉熵Focal Loss作为损失函数。

在主干网络中,ResNet是基于卷积神经网络提取个体树的有效特征,FPN负责通过ResNet形成个体树的多尺度特征,其中对特征图集进行增强,得到多尺度区域信息。RetinaNet的最大优势在于它可以通过焦点损失消除交叉熵(CE)计算[34]。

公式(1)是一种传统的神经网络CE损失函数,在图形的检测和分类中得到了广泛的应用。

C E ( p , y ) = { − log ( p ) y = 1 − log ( 1 − p ) otherwise ( 1 ) C E(p, y)= \begin{cases}-\log (p) & y=1 \\ -\log (1-p) & \text { otherwise }\end{cases} \quad\quad\quad\quad(1) CE(p,y)={−log(p)−log(1−p)y=1 otherwise (1)

其中, y ∈ { ± 1 } y \in\{\pm 1\} y∈{±1}表示ground-truth;预测单个树样本的概率属于 1。简单来说,可以用 p t p_t pt代替 p p p,因此:

p t = { p y = 1 1 − p otherwise ( 2 ) p_t= \begin{cases}p & y=1 \\ 1-p & \text { otherwise }\end{cases} \quad\quad\quad\quad(2) pt={p1−py=1 otherwise (2)

为了消除个体树样本的不平衡选择,我们引入了权重因子 α \alpha α;同理,我们定义 α t \alpha_t αt如下:

α t = { α y = 1 1 − α otherwise ( 3 ) \alpha_t= \begin{cases}\alpha & y=1 \\ 1-\alpha & \text { otherwise }\end{cases} \quad\quad\quad\quad(3) αt={α1−αy=1 otherwise (3)

定义 α t \alpha_t αt后,CE损失函数可写为:

C E ( p t ) = − α t log ( p t ) ( 4 ) C E\left(p_t\right)=-\alpha_t \log \left(p_t\right) \quad\quad\quad\quad(4) CE(pt)=−αtlog(pt)(4)

平衡CE可以解决单个树样本在一个阶段的错误分类和漏分类之间的不平衡,无法区分单个树样本检测的难易程度,因此模型在训练中可能会出错[35]。因此,我们引入了超参数 γ \gamma γ如下:

F L ( p t ) = − ( 1 − p t ) γ log ( p t ) γ ∈ ( 0 , 5 ) ( 5 ) F L\left(p_t\right)=-\left(1-p_t\right)^\gamma \log \left(p_t\right) \quad \gamma \in(0, \quad 5) \quad\quad\quad\quad(5) FL(pt)=−(1−pt)γlog(pt)γ∈(0,5)(5)

式中,当 p t p_t pt接近1时,FL接近于0,因此,我们可以推测单个树样本可能是一个容易分类的样本,即损失的贡献值会更小。相反,如果 p t p_t pt接近0,FL接近1,这意味着损失的贡献值将保持不变(与CE相比),从而指导模型识别更复杂的个体树样本,有效提高模型的准确率检测单个树样本。

将公式(4)和(5)结合起来,得到 RetinaNet [36] 的最终损失函数如下:

F L ( p t ) = − α t ( 1 − p t ) γ log ( p t ) ( 6 ) F L\left(p_t\right)=-\alpha_t\left(1-p_t\right)^\gamma \log \left(p_t\right) \quad\quad\quad\quad(6) FL(pt)=−αt(1−pt)γlog(pt)(6)

其中, p t p_t pt代表准确率, t t t代表平衡因子, γ \gamma γ代表焦点参数。

2)基于点云PCS算法的个体树分割

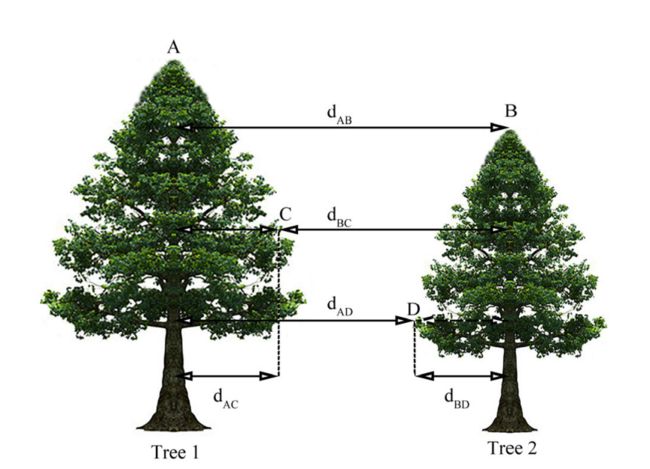

基于点云聚类,以树顶与归一化点云中的最高点之间的一定距离作为树顶点,进行距离的迭代计算[37],进行单棵树的分割,原理如图所示图4。

PCS算法首先需要设置一个二维的欧式距离作为阈值,然后将归一化的点云从最高点到最低点进行分割。如果点云与目标树顶部的水平距离大于设定的阈值,则该点将被确定为另一棵树。反之,将确定到目标树。如图4所示,树1为目标树,A点为最高点。由于 d A B \mathrm{d}_{\mathrm{AB}} dAB大于设定的阈值,B被确定为树2的顶点。由于 d A C \mathrm{d}_{\mathrm{AC}} dAC < 阈值 < d B C \mathrm{d}_{\mathrm{BC}} dBC,点C属于树1。因此,依次进行迭代计算,直到完成单独的树分割。

3) 准确度评估方法

为了评估本文提出的方法在森林单棵树分割中的表现,我们在统计中选择F-Measure值,并以准确率和检测的召回率作为评估指标对三种单棵树分割方法进行定量评估 [38],公式表示如下:

Precision = T P T P + F P ( 7 ) \text { Precision }=\frac{\mathrm{TP}}{\mathrm{TP}+\mathrm{FP}} \quad\quad\quad\quad(7) Precision =TP+FPTP(7)

Recall = T P T P + F N ( 8 ) \text { Recall }=\frac{\mathrm{TP}}{\mathrm{TP}+\mathrm{FN}} \quad\quad\quad\quad(8) Recall =TP+FNTP(8)

F − Measure = 2 × Precision × Recall Precision + Recall ( 9 ) \mathrm{F}-\text { Measure }=2 \times \frac{\text { Precision } \times \text { Recall }}{\text { Precision }+\text { Recall }} \quad\quad\quad\quad(9) F− Measure =2× Precision + Recall Precision × Recall (9)

根据公式,真阳性(TP)是正确的个体树分割数;误报(FP)是单个树错过的点数;假阴性(FN)是单个树的过度分割次数,即错误分割; F-measure是准确率和召回率的加权平均值。 Precision表示单棵树提取的准确率,recall反映了所提方法的检测能力,F-measure表示单棵树分割的整体准确率。

表 1. 训练样本数据集信息。

图 4. PCS算法原理。

III. EXPERIMENTS AND ANALYSES

A. 实验设计

1) 建立模型和训练样本

该模型在Windows 10的PyTorch框架下运行,CPU为Inter-i9-9900K处理器,GPU为NVIDIA GTX 1080Ti,内存为16GB,通过Python编程训练和测试。

本文以单棵树为目标。由于研究区的杨树在高分辨率图像中具有两个不同的特征,因此将杨树根据其特征设置为T1和T2,对应的类值为11和22。松树为类别T,类别值为1,在正射影像图中标记树冠,即根据图像中树冠的特征,将目标范围连接到与图像边缘平行的表面上,进行深度学习。导出训练数据时,图片格式为JPG,块大小为256×256,stride X为128,stride Y为128,元数据格式为Pascal Visual Object Classes,旋转角度参数为30◦。为了提高训练模型的泛化能力和鲁棒性,选择水平旋转的样本来增加样本量。训练样本导出后的图像数据集信息如表1所示:

分区标记图像和标签以9:1的比例随机分为训练集和测试集。在分类中,根据复杂度(强度和尺度变化)将图像平均分配到训练集和测试集,以保证实验的有效性。非最大抑制和预测概率的阈值为0.1。

2) RETINANET 模型单棵树检测

训练样本和RetinaNet网络用于模型训练,RetinaNet训练参数如下图所示:

(a) 设置batch-size值为16,即每张训练图片为16。

(b) 设置 epochs 为 20,即应用于训练模型的数据集通过神经网络向前和向后传输 20 次。

© 将比例设置为 (1, 0.8, 和 0.63),表示每个像素按比例放大或缩小的比例序列。

(d) 设置比率设置为 (0.5, 1, 和 2),表示矩形锚框。

(e) 采用 Resnet34 作为训练新模型的框架。预配置的神经网络,即训练模型网络的深度为34层。

通过上述参数训练目标检测模型,模型的损失函数如图5所示:

图 5. 损失函数模型。

图5(a)为单针阔叶林的检测模型损失函数,图5(b)为针阔混交林的检测模型损失函数。从图5可以看出,随着模型的不断学习过程,训练样本的损失函数是向下的,训练精度是向上的,说明我们的模型是一个全局优化过程。分别是前 100 个周期,因为 RetinaNet 模型在处理对象分类中的压倒性样本时表现出不兼容,因此其梯度主要由这些容易分类的样本决定。在训练中,神经网络遇到了一些受光学因素影响的批次样本,例如图像失真、变形或椒盐噪声等,破坏了模型的学习效率,导致回归损失函数值出现剧烈波动。针叶林模型经过50个周期,针阔混交林模型经过100个周期后,训练样本的准确率和损失收敛,拟合能力强,可以完成单棵树的DOM检测。

使用RetinaNet模型检测单个树DOM。通过随机选择部分检测结果,公式(7)用于评估准确性。结果如图6所示。

图6(a)显示了在针叶林中随机选取的验证样本,单木检测的精度为96%。图6 (b)显示了在针阔混交林中随机选择的验证样本,单木检测的精度为87%。基于深度学习的单株树检测算法具有较高的精度,但该方法主要基于计算机图形学中的技术。误分和漏分误差受光学因素的影响,如气溶胶、能见度和太阳入射角等,利用激光雷达获得的点云可以对其影响进行衰减。为此,本文提出了一种基于深度学习的DOM图像单木检测算法,结合PCS点云单木分割方法,提高单木分割的准确性。

3) PCS个体树分割

在深度学习的检测中,会出现错误分割,包括过分割和欠分割。针对过分割问题,对过滤后的点云进行归一化处理,以减弱地形对后续单木分割的影响。由于研究区域内的所有树木都高于2m,2m以下的点云被隔离,不参与后续的单棵树分割,这可以减少单棵树分割中过分割的发生。对于欠分割,PCS算法是用深度学习提取的树冠mask切割归一化的点云,得到树冠点云簇,计算每个点云簇的最大高度作为树顶点。以树木顶点间的最小2D欧氏距离为阈值,开始点云分割,获取单棵树的位置、树高和树冠直径。分割结果如图7所示。

B.结果分析

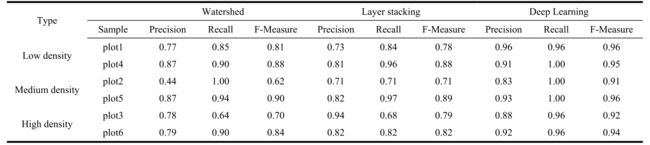

不同密度和树种的单木分割精度评价结果如表2所示。所有样本的平均准确率为90.5%,检测率的平均准确率为98%,表明该算法在提高准确率和检测率的前提下,具有较好的全检率。

表 2.不同物种和密度下个体树分割精度的深度学习模型评估。

图 7. 单个树分割的结果(a-针叶林、b-针叶和阔叶混交林)。

F-measure是一个相对平衡的精度指标。在低密度和高密度样地中,不同树种的总体精度相似。但在中密度样地中,针阔混交林的总体精度高于针叶林。AVE F-Measure是低密度样地96%、中密度样地94%、高密度样地93%的异地平均精度。因此,本文提出的方法可用于高精度的单木分割。

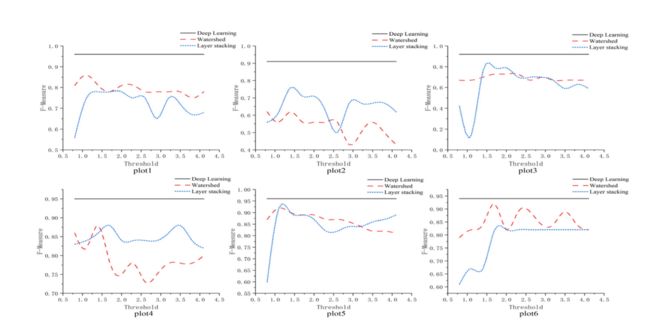

本文测试了两种常用的单棵树分割方法,即Watershed算法和Layer stacking算法,并以F-Measure作为评价指标对本文方法进行比较。分水岭算法是基于分水岭结构进行图像分割,以CHM为被水覆盖的自然地形。图像中每个像素的灰度值代表该点的高度,每个受局部极小值影响的区域称为集水盆地,每个盆地的边界称为分水岭。在每个最小区域的表面上开一个小孔,让水涌出并淹没周围的区域。那么每个受影响的最小区域就是图像中对应于同源盆地的区域。层堆叠算法是一种基于点云的个体树分割方法。将整层的森林点云以1 m的高度间隔切片,将每一层的树点云分开。然后,K-means 聚类方法是将每一层的点云聚类,形成一个堆叠图形。最后设置一个固定窗口,确定堆叠图中的局部最大值作为树的中心进行分割。由于这两种算法在单棵树分割时都需要设置阈值来减弱过分割和欠分割,避免陷入局部区域。分别计算了不同树种和密度下阈值为0.8~4.1的6个样地的结果。

图8显示了三种F-measures与单个树分割方法之间的样条表的比较,表明了不同阈值的Watershed算法和Layer stacking算法的平均精度。在针叶林(样地1∼3)和针阔混交林(样地4∼6)中,两种常用算法的分割精度随着阈值的变化而波动较大,其中分水岭算法达到了最优分割阈值为1.4时的精度,当阈值为1.7时,Layer stacking算法达到最优的单棵树分割精度。在平均准确率方面,所提方法的性能优于其他两种方法,论文中所有样本地块均高于0.9,最低和最高准确率分别为0.91和0.96,而另一论文中的两种方法只有0.14和0.92。随着森林结构复杂度的增加,三种方法的平均准确率下降。因此,在密集复杂的森林环境中,高精度的单棵树分割仍然是一项艰巨的挑战。

表3给出了不同分割算法和阈值下高密度针阔混交林样地6的精度、检出率和平均精度的具体值。表中,随着阈值的不断变化,Watershed算法和Layer stacking算法的准确率也在不断变化。在样地6中,当阈值为1.7时,分水岭算法取得了最优的分割效果,精度为0.88,检测率为0.96,平均精度为0.92。

图 8. 三种单独的树分割方法的平均准确度比较。

表 3 高密度针阔混交林不同阈值精度对比

Layer stacking算法的精度在阈值大于等于1.7后是稳定的,没有随着阈值的变化而变化。由于本文算法不受阈值影响,其准确率始终保持在90%以上。从以上数据分析可知,两种常见的单棵树分割算法由于阈值因素的影响,准确率不稳定。经过多次实验,发现两种算法的最高准确率(图8)也低于本文提出的算法,在研究领域具有较高的分割准确率。

在将提取的单木与野外调查数据匹配之后,参照提取的单木结构参数(树的高度和树冠直径)来评估精度。在实验中,来自样地1至6的正确检测的个体树用于参与计算,换句话说,具有遗漏或错误分类点的个体树将不参与精度分析。提取的单木结构参数统计结果如下:树高和冠幅的估计值与实测地面值的平均相对误差分别为1.97%和1.01%,均方根误差(RMSE)分别为0.452m和0.4052m。线性回归方程用于拟合数据集。图9(a)显示了实地估计和测量高度的散点图。图9(b)显示了田间估计和测量的冠层直径的散点图。经计算,概率检验的P值小于0.01,因此相关 R 2 \mathrm{R}^2 R2可以作为树高和冠幅的精度指标。对于估计的树高, R 2 \mathrm{R}^2 R2=0.9742,线性回归的斜率接近1,具有较高的拟合效果。对于估算的树冠直径, R 2 \mathrm{R}^2 R2=0.9329,相关性强,精度高。

表 4. 各种方法与最佳阈值的准确性比较。

图 9. 单个树参数的参数散点图。

IV. DISCUSSION

以DOM和LiDAR点云作为研究数据,结合RetinaNet检测模型和深度学习中的PCS算法作为单棵树的分割方法,有别于现有的单棵树分割方法,包括分水岭算法和层堆叠算法。分水岭算法可以将点云转化为带有灰度信息的CHM,CHM中不同的灰度值用来表示高程信息。单个树的分割是通过数学形态学[39]进行的。然而,分水岭算法仅限于冠层形状规则的树种,在塔形或伞形树冠分割中表现良好。另外,点云变换的CHM需要插值,在CHM中可能会出现图像噪声和信息丢失,导致单棵树的过分割和欠分割,需要高斯滤波器通过设置最优阈值来平滑CHM。从而提高了分割的精度。通过深度学习中的检测模型对DOM进行检测,避免点云变换的CHM信息缺失。

层堆叠算法采用自上而下的区域增长聚类方法。通过分析点云的空间分布特征,找到树的顶点作为种子点,结合多种距离阈值进行迭代计算,实现树的个体分割。然而,Layer stacking算法很难处理高密度的森林。例如,具有紧密分布的树冠的两棵高度相似的树可能被错误地识别为一棵树,导致单个树分割不足。此外,具有许多分支的大树可能会被错误地检测为多棵树,从而导致过度分割[40]。通过激光雷达点云和DOM的相互验证,采用RetinaNet模型的思路,避免了不断切换阈值的过程,大大提高了算法的自动化程度。

表 4 给出了分水岭算法和层堆叠算法在最优阈值条件下与本文算法的分割精度对比结果。与其他两种算法相比,该算法在低密度样本中的精度提高了4%-23%,检测率提高了4%-15%,平均准确率提高了7%-18%。在中等密度地块中,精度和检出率分别提高了6%-39%和0-29%。在高密度样品中,精密度、检出率和平均准确率分别提高了6%-13%、6%-32%和10%-22%。在样图3中发现,本文算法的精度低于Layer stacking算法,因为Layer stacking计算的检测率只有0.68,即在100棵树的情况下,Layer stacking算法只能检测到68棵树,68棵树中有94%被正确检测。然而,所提出的算法检测到96棵树,正确率为88%。因此,Layer stacking算法在牺牲检测率的情况下提高了精度,而提出的算法在保持高检测率的情况下具有较高的精度。基于分割后的单棵树点云,提取森林三维结构参数的树高和冠层直径,结合实测数据进行精度分析。树木高度与冠层直径的相关性R2均大于90%,具有较高的精度,满足了现代林业对森林结构参数调查的需要。

适当的数据处理方法可以提高单棵树分割的准确性。根据得到的单棵树分割结果,可以进一步计算和提取其他森林结构参数,如森林冠层密度、叶面积指数和森林蓄积量[41]。此外,利用机载激光雷达数据与多源遥感数据相结合,提取森林结构参数,可以进一步提高森林参数结果的准确性,也是一个重要的研究方向。本研究主要研究针阔混交林,主要包括松树和杨树树种。在高分辨率遥感影像中,树冠形状比较规则。我们通过该算法提取了大部分个体树,但仍然存在一些欠分割和过度分割(DOM和LiDAR点云无法检测到与高冠层完全重叠的低冠层)。因此,如何准确提取此类具有高冠层重叠的单棵树将是未来的研究热点。

V. CONCLUSION

为了提高单株树木分割的准确率,我们提出了一种基于RetinaNet模型和PCS算法的深度学习单株树木分割方法:首先,采用RetinaNet模型检测DOM中的单株树木树冠作为mask;其次,采用mask对LiDAR点云进行聚类,通过局部区域最大化的方法获得每棵树树冠的最大高程点作为单株树的初始种子点;最后,以种子点为指导,用PCS算法进行单木分割。我们利用不同森林环境下的6块样地进行精度分析,得出以下结论:

(1)研究了低、中、高三种样地密度下的单木分割精度。获得了较高的准确率(总体准确率> 90%)和检测率(总体召回率> 95%)。原因是高分辨率的DOM (0.1 × 0.1m)具有丰富的空间信息,与LiDAR点云的三维空间特征互补,在单木分割中具有更高的精度和更高的检出率。

(2)由于RetinaNet模型只需在研究区域内选取训练样本即可获得高精度的检测结果,不需要随着森林密度的变化设置各种阈值,从而大大提高了单木分割的自动化程度。

(3)本文提出的方法实现了高精度的单木分割,解决了高密度森林环境下郁闭度分布的分割问题,降低了欠分割和过分割的发生频率。

论文链接:https://ieeexplore.ieee.org/stamp/stamp.jsp?tp=&arnumber=9535121

REFERENCES

[1] W. Chen, X. Hu, W. Chen, Y . Hong, and M. Yang, ‘‘Airborne LiDAR remote sensing for individual tree forest inventory using trunk detectionaided mean shift clustering techniques,’’ Remote Sens., vol. 10, no. 7, p. Jul. 2018.

[2] S. Xu, N. Ye, S. Xu, and F. Zhu, ‘‘A supervoxel approach to the segmentation of individual trees from LiDAR point clouds,’’ Remote Sens. Lett., vol. 9, no. 6, pp. 515–523, 2018.

[3] X. Chen, K. Jiang, Y . Zhu, X. Wang, and T. Y un, ‘‘Individual tree crown segmentation directly from UAV-borne LiDAR data using the PointNet of deep learning,’’ Forests, vol. 12, no. 2, p. Jan. 2021.

[4] P . Wang, Y . Q. Xing, C. Wang, and X. H. Xing, ‘‘A graph cut-based approach for individual tree detection using airborne LiDAR data,’’ J. Univ.Chin. Acad. Sci., vol. 36, no. 3, pp. 385–391, 2019.

[5] E. Næsset, ‘‘Predicting forest stand characteristics with airborne scanning laser using a practical two-stage procedure and field data,’’ Remote Sens.Environ., vol. 80, no. 1, pp. 88–99, 2002.

[6] W. Dai, B. Yang, Z. Dong, and A. Shaker, ‘‘A new method for 3D individual tree extraction using multispectral airborne LiDAR point clouds,’’ ISPRS J. Photogramm. Remote Sens., vol. 144, pp. Oct. 2018.

[7] J. Hyyppa, O. Kelle, M. Lehikoinen, and M. Inkinen, ‘‘A segmentationbased method to retrieve stem volume estimates from 3-D tree height models produced by laser scanners,’’ IEEE Trans. Geosci. Remote Sens., vol. 39, no. 5, pp. May 2001.

[8] M. Q. Zhao, ‘‘Research on image segmentation algorithm based on watershed algorithm,’’ M.S. thesis, Xi’an Univ. Posts Telecommun., 2020.

[9] X. S. Liu, J. W. Huang, and H. B. Ju, ‘‘Research progress in the methods and applications of individual tree crown’s automatic extraction by high spatial resolution remote sensing,’’ J. Zhejiang F orestry College, vol. 27, no. 1, pp. 126–133, 2010.

[10] N. Wang, J. Min, J. L. Guo, and N. He, ‘‘On the remote sensing classification of tree species based on multi-scale feature transfer learning,’’ J. Ezhou Univ., vol. 28, no. 2, pp. 93–97, 2021.

[11] W. J. Li, R. R. Wang, W. Shi, and T. T. Su, ‘‘Crown extraction method of individual tree based on multi-spectral image of UA V ,’’ J. Fujian Agricult.Forestry Univ. Natural Sci. Ed., vol. 49, no. 5, pp. 639–645, 2020.

[12] F. Z. Liu, H. Liu, and T. Y un, ‘‘Individual tree crown separation using the improved watershed method,’’ J. F orestry Eng., vol. 5, no. 5, pp. 109–116, 2020.

[13] L. N. Huo and X. L. Zhang, ‘‘Individual tree information extraction and accuracy evaluation based on airborne LiDAR point cloud by multilayer clustering method,’’ Scientia Silvae Sinicae, vol. 57, no. 1, pp. 85–94, 2021.

[14] L. Jing, B. Hu, J. Li, and T. Noland, ‘‘Automated delineation of individual tree crowns from LiDAR data by multi-scale analysis and segmentation,’’ Photogramm. Eng. Remote Sens., vol. 78, no. 12, pp. 1275–1284, 2012.

[15] E. Ayrey, S. Fraver, J. A. Kershaw, Jr., L. S. Kenefic, D. Hayes, A. R. Weiskittel, and B. E. Roth, ‘‘Layer stacking: A novel algorithm for individual forest tree segmentation from LiDAR point clouds,’’ Can. J.Remote Sens., vol. 43, no. 1, pp. 16–27, 2017.

[16] Z. Y . Li, Q. W. Liu, and Y . Pang, ‘‘Review on forest parameters inversion using LiDAR,’’ Nat. Remote Sens. Bull., vol. 20, no. 5, pp. 1138–1150, 2016.

[17] P . H. Li, X. Shen, J. S. Dai, and L. Cao, ‘‘Comparisons and accuracy assessments of LiDAR-based tree segmentation approaches in planted forests,’’ Scientia Silvae Sinicae, vol. 54, no. 12, pp. 127–136, 2018.

[18] Y . Lin, H. W. Ji, and Q. Ye, ‘‘Research on method of extracting single tree characteristics from LiDAR point,’’ Comput. Meas. Control, vol. 25, no. 6, pp. 142–147, 2017.

[19] G. Sun, Y . Xin, and C. Yan, ‘‘Estimating single tree height based on improved K-means algorithm,’’ F orest Eng., vol. 35, no. 6, pp. 31–35, 2019.

[20] H. M. Zhang, ‘‘Application and practice of digital orthophoto map,’’ Jiangxi Cehui, no. 3, pp. 53–54, 2015.

[21] C. X. Gao and N. Sang, ‘‘Deep learning for object detection in remote sensing image,’’ Bull. Surveying Mapping, no. S1, pp. 108–111, 2014.

[22] P . Y . Shao, X. Q. Lv, P . P . Huang, W. Xu, and Y . F. Dong, ‘‘Research on the robustness of SAR image ship detection algorithms based on deep learning,’’ in Proc. China High Resolution Earth Observ. Conf., 2020, p. 18.

[23] P . P . Zhu, S. P . Li, L. Q. Zhang, and Y . Li, ‘‘Multitask learning-based building extraction from high-resolution remote sensing images,’’ J. GeoInf. Sci., vol. 23, no. 3, pp. 514–523, 2021.

[24] J. J. Lie, L. Guo, Z. H. Liang, Y . Li, and Z. T. Su, ‘‘UA V image vehicle detection based on RetinaNet model,’’ China Sci. Technol. Achievements, vol. 20, no. 20, pp. 49–50, 2019.

[25] K. X. Chen, Z. L. Zhu, X. M. Deng, C. X. Ma, and H. A. Wang, ‘‘Deep learning for multi-scale object detection: A survey,’’ J. Softw., vol. 32, no. 4, pp. 1201–1227, 2021.

[26] Y . L. Wan, X. W. Zhong, H. Liu, and Y . R. Qian, ‘‘Survey of application of convolutional neural network in classification of hyperspectral images,’’ Comput. Eng. Appl., vol. 57, no. 4, pp. 1–10, 2021.

[27] Y . L. Yang, H. Huang, Y . M. Hu, D. Z. Wang, and Y . B. Li, ‘‘Automatic detection method of road diseases based on LeNet convolutional neural network,’’ Internet Things Technol., vol. 11, no. 1, pp. 47–50, 2021.

[28] P . Huang, Q. Zheng, and C. Liang, ‘‘Overview of image segmentation methods,’’ J. Wuhan Univ. Natural Sci. Ed., vol. 66, no. 6, pp. 519–531, 2020.

[29] T.-Y . Lin, P . Goyal, R. Girshick, K. He, and P . Dollar, ‘‘Focal loss for dense object detection,’’ IEEE Trans. Pattern Anal. Mach. Intell., vol. 42, no. 2, pp. Feb. 2020.

[30] Y . Zhang, Z. M. Zhao, X. Y . Wang, H. Q. Feng, and J. Lin, ‘‘Construction of green tea recognition model based on ResNet convolutional neural network,’’ J. Tea Sci., vol. 41, no. 2, pp. 261–271, 2021.

[31] T. N. Quang, S. Lee, and B. C. Song, ‘‘Object detection using improved bidirectional feature pyramid network,’’ Electronics, vol. 10, no. 6, p. Mar. 2021.

[32] P . Yang, G. Zhang, L. Wang, L. Xu, Q. Deng, and M.-H. Yang, ‘‘A partaware multi-scale fully convolutional network for pedestrian detection,’’ IEEE Trans. Intell. Transp. Syst., vol. 22, no. 2, pp. Feb. 2021.

[33] Q. Yao, J. L. Gu, J. Lv, L. J. Guo, J. Tang, B. J. Yang, and W. G. Xu, ‘‘Automatic detection model for pest damage symptoms on rice canopy based on improved RetinaNet,’’ Trans. Chin. Soc. Agricult. Eng., vol. 36, no. 15, pp. 182–188, 2020.

[34] G. W. Liu, C. X. hang, B. Li, Y . Yang, and W. S. Zhang, ‘‘Detection of birds’ nest in catenary based on improved RetinaNet model,’’ J. Data Acquisition Process., vol. 35, no. 3, pp. 563–571, 2020.

[35] X. T. Deng, T. Y . Cao, Z. Fang, and Y . F. Zheng, ‘‘Research on detection of people with camouflage pattern via improving RetinaNet,’’ Comput. Eng.Appl., vol. 57, no. 5, pp. 190–196, 2021.

[36] Z. L. Tan and X. C. Chen, ‘‘Application research of RetinaNet image recognition technology in coal mine target monitoring,’’ Mining Saf. Environ.Protection, vol. 47, no. 5, pp. 65–70, 2020.

[37] Q. L. Yang, ‘‘Comparison of airborne LiDAR single wood segmentation methods and analysis of influencing factors,’’ M.S. thesis, Xinjiang Univ., Ürümqi, China, 2018.

[38] C. C. Chen, X. Li, and H. Y. Huang, ‘‘3D segmentation of individual tree canopy in forest nursery based on drone image-matching point cloud,’’ Trans. Chin. Soc. Agricult. Machinery, vol. 49, no. 2, pp. 149–155, 2018.

[39] L. Geng, M. Z. Li, W. Y . Fan, and B. Wang, ‘‘Individual tree structure parameters and effective crown of the stand extraction base on airborn LiDAR data,’’ Scientia Silvae Sinicae, vol. 54, no. 7, pp. 62–72, 2018.

[40] C. Y . Zhao, Y . Q. Xing, D. Huo, Y . T. Jiao, and H. T. Y ou, ‘‘Key technologies of three-dimensional geometric reconstruction of larch crown shape based on LiDAR data,’’ J. Northwest F orestry Univ., vol. 30, no. 2, pp. 186–190, 2015.

[41] J. J. Liu, ‘‘Individual tree recognition and individual tree structure parameters extraction based on UA V imagery,’’ M.S. thesis, Zhejiang A&F Univ., Hangzhou, China, 2020. Accessed: Apr. 26, 2021.