2022-5-8:OpenCV入门(四)core组件进阶

1.LUT函数:Look up table

Mat lookUpTable(1,256,CV_8U);

u从三个都说副高fdffffDdqqqdqddq FQFQ2Q2W GW 问对方成为亲卫队请问我去问驱蚊器委屈委屈强强

char* p = lookUpTable.data;

for(int i = 0 ; i < 256 ; ++i)

p[i] = table[i];

//然后调用函数(I是输入 J是输出):

for (int i = 0; i < times; ++i)

LUT(I, lookUpTable, J);

2.计时函数:getTickCount()和getTickFrequency()

getTickCount()返回CPU自某个事件以来走过的时钟周期数

getTickFrequency()返回CPU一秒钟所走的时钟周期数

double time0 = static_cast<double>(getTickCount());//记录起始时间

//进行图像处理操作。。。。。

time0 = ((double)getTickCount() - time0)/getTickFrequency();

cout<<"此方法运行事件:"<<time0<<"秒"<<endl;//输出运行时间

3.访问图像中像素的三类方法:

方法一 指针访问:C操作符[];

方法二 迭代器iterator

方法三 动态地址计算

#include //---------------------------------【colorReduce( )函数】---------------------------------

// 描述:使用【指针访问:C操作符[ ]】方法版的颜色空间缩减函数

//----------------------------------------------------------------------------------------------

void colorReduce(Mat& inputImage, Mat& outputImage, int div)

{

//参数准备

outputImage = inputImage.clone(); //拷贝实参到临时变量

int rowNumber = outputImage.rows; //行数

int colNumber = outputImage.cols * outputImage.channels(); //列数 x 通道数=每一行元素的个数

//双重循环,遍历所有的像素值

for (int i = 0; i < rowNumber; i++) //行循环

{

uchar* data = outputImage.ptr<uchar>(i); //获取第i行的首地址

for (int j = 0; j < colNumber; j++) //列循环

{

// ---------【开始处理每个像素】-------------

data[j] = data[j] / div * div + div / 2;

//*data++ = *data / div * div + div / 2;//也可以写成这样

// ----------【处理结束】---------------------

} //行处理结束

}

}

//-------------------------------------【colorReduce( )函数】-----------------------------

// 描述:使用【迭代器】方法版的颜色空间缩减函数

//----------------------------------------------------------------------------------------------

void colorReduce(Mat& inputImage, Mat& outputImage, int div)

{

//参数准备

outputImage = inputImage.clone(); //拷贝实参到临时变量

//获取迭代器

Mat_<Vec3b>::iterator it = outputImage.begin<Vec3b>(); //初始位置的迭代器

Mat_<Vec3b>::iterator itend = outputImage.end<Vec3b>(); //终止位置的迭代器

//存取彩色图像像素

for(;it != itend;++it)

{

// ------------------------【开始处理每个像素】--------------------

(*it)[0] = (*it)[0]/div*div + div/2;

(*it)[1] = (*it)[1]/div*div + div/2;

(*it)[2] = (*it)[2]/div*div + div/2;

// ------------------------【处理结束】----------------------------

}

}

//----------------------------------【colorReduce( )函数】-------------------------------

// 描述:使用【动态地址运算配合at】方法版本的颜色空间缩减函数

//----------------------------------------------------------------------------------------------

void colorReduce(Mat& inputImage, Mat& outputImage, int div)

{

//参数准备

outputImage = inputImage.clone(); //拷贝实参到临时变量

int rowNumber = outputImage.rows; //行数

int colNumber = outputImage.cols; //列数

//存取彩色图像像素

for(int i = 0;i < rowNumber;i++)

{

for(int j = 0;j < colNumber;j++)

{

// ------------------------【开始处理每个像素】--------------------

outputImage.at<Vec3b>(i,j)[0] = outputImage.at<Vec3b>(i,j)[0]/div*div + div/2; //蓝色通道

outputImage.at<Vec3b>(i,j)[1] = outputImage.at<Vec3b>(i,j)[1]/div*div + div/2; //绿色通道

outputImage.at<Vec3b>(i,j)[2] = outputImage.at<Vec3b>(i,j)[2]/div*div + div/2; //红是通道

// -------------------------【处理结束】----------------------------

} // 行处理结束

}

}

``

## 4.ROI(region of interest):感兴趣区域

```cpp

Mat imageROI;

//方法一

imageROI = srcImage(Rect(200, 250, logoImage.cols, logoImage.rows));

//方法二

//imageROI= srcImage4(Range(250,250+logoImage.rows),Range(200,200+logoImage.cols));

5.分离颜色通道、多通道图像混合

通道分离:split函数

通道合并:merge函数

vector<Mat> channels;

split(srcImage, channels);//分离色彩通道

Mat imageBlueChannel = channels.at(0);

Mat imageGreenChannel = channels.at(1);

Mat imageRedChannel = channels.at(2);

merge(channels, srcImage);//将三个单通道重新合并成一个三通道

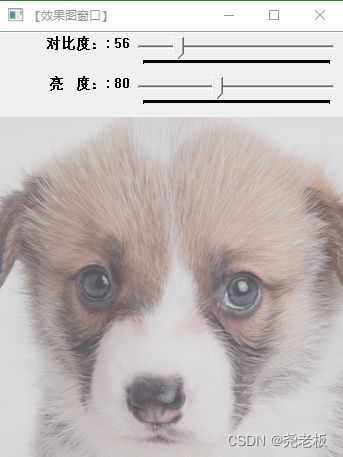

6.图像对比度、亮度值调整

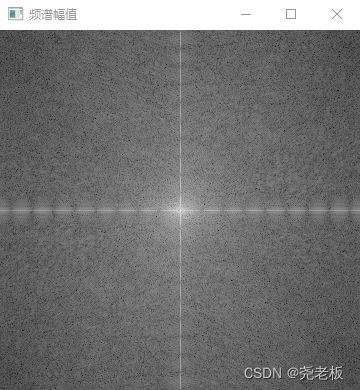

#include 7.离散傅里叶变换

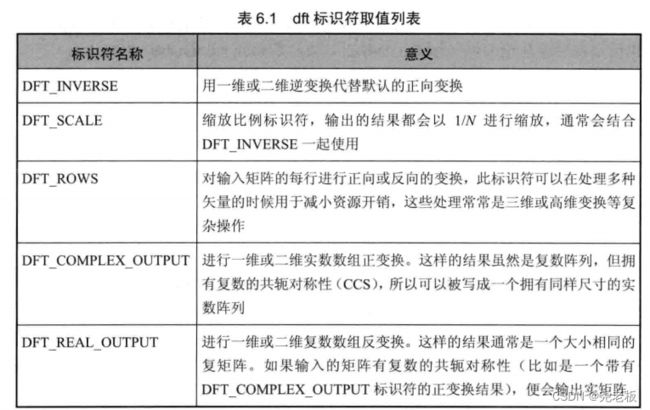

void dft(InputArray src, OutputArray dst, int flags=0, int nonzeroRows=0)//第一个参数为输入矩阵;第二个参数为运算结果;第三个参数为转换的标识符(下表);第四个参数为想要处理的那一行值,函数会假设只有输入矩阵的第一个非零行包含非零元素。

int getOptimalDFTSize(int vecsize)//返回给定向量尺寸的DFT最优尺寸大小

void copyMakeBorder(InputArray src, OutputArray dst, int top, int bottom, int left, int right, int borderType, const Scalar&value=Scalar() )

//扩充图像边界

//第一个参数为输入图像;第二个参数为输出图像;第三到第六个参数:需要在四个方向边界扩充的像素数;第七个参数为边界类型,常用为BORDER_CONSTANT;第八个参数为const Scalar&类型的value,有默认值Scalar()。

void magnitude(InputArray x,InputArray y,OutputArray magnitude)

//计算二维矢量的幅值

//第一个参数为浮点型X坐标值,实部;第二个参数为浮点型Y坐标值,虚部;第三个参数为输出的幅值

//X和Y的平方和再开根号

void log(InputArray src, OutputArray dst)

//计算自然对数

void normalize(InputArray src, OutputArray dst, double alpha=1,double beta=0, int norm_type=NORM_L2, int dtype=-1, InputArray mask =noArray())

//矩阵归一化

//第一个参数为输入图像;第二个参数为输出图像;第三个参数为归一化后的最大值,第四个参数为归一化后的最小值;第五个参数为归一化类型;第六个参数取负值时,输出矩阵和src有同样的类型,否则有同样的通道数;第七个参数为可选的操作掩膜。

#include "opencv2/core/core.hpp"

#include "opencv2/imgproc/imgproc.hpp"

#include "opencv2/highgui/highgui.hpp"

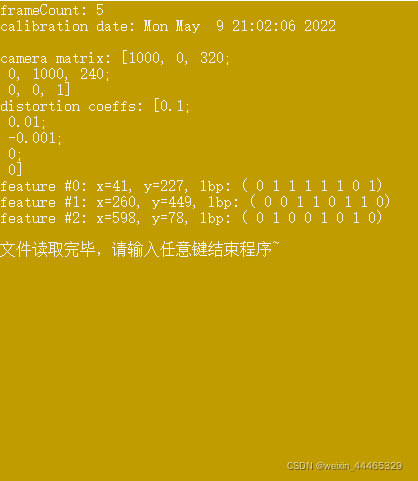

#include 8.输入输出XML和YAML文件

一. XML、YAML文件的打开

- 文件写操作

//第一种

FileStorage fs

fs.open("abs.xml",FileStorage::WRITE);

//第二种

FileStorage fs("abs.xml",FileStorage::WRITE);

- 文件读操作

//第一种

FileStorage fs

fs.open("abs.xml",FileStorage::READ);

//第二种

FileStorage fs("abs.xml",FileStorage::READ);

二. 进行文件读写操作

- 文本和数字的输入和输出

//写入文件

fs << "iterationNr" << 100;

//读取文件

int itNr;

fs["iterationNr"] >> itNr;

itNr = (int) fs["iterationNr"];

- OpenCV数据结构的输入和输出

//数据结构的初始化

Mat R = Mat_<uchar>::eye(3,3),

Mat T = Mat_<double>::zeros(3,1);

//向 Mat中写入数据

fs << "R" << R;

fs << "T" << T;

//从 Mat中读取数据

fs ["R"] << R;

fs ["T"] >> T;

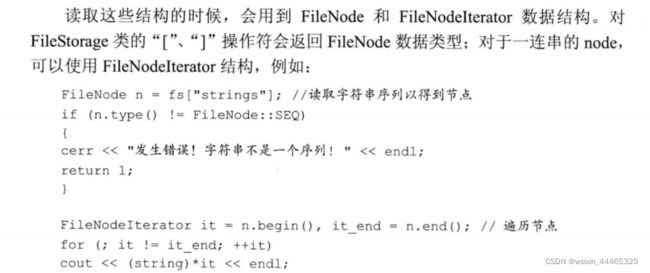

三. vector(arrays)和maps的输入和输出

对于vector结构输入和输出,要在第一个元素之前加上"[“,最后一个元素之前加上”]"。

fs << "strings" << "[";//开始读入string文本序列

fs << "imagel.jpg" << "Awesomeness" <<"baboon.jpg";

fs << "]";//关闭序列

对于map结构,替换成“{ }”

fs << "Mapping" ;//开始读入Mapping文本序列

fs << "{" << "One" << 1;

fs <<"Twp" << 2 << "}";//关闭序列

fs.release();

文件写入示例

#include "opencv2/opencv.hpp"

#include 文件读取示例

#include "opencv2/opencv.hpp"

#include