Deformable ConvNets v2

Deformable ConvNets v2

可变形卷积网络的优越性能源于其对物体几何变化的适应能力。通过对其自适应行为的研究,我们发现虽然对其神经特征的空间支持比常规的转换更符合对象结构,但这种支持可能会远远超出感兴趣的区域,导致特征受到不相关图像内容的影响。为了解决这个问题,我们再次提出了一种可变形的ConvNets,通过增强建模能力和更强的训练来提高其聚焦于相关图像区域的能力。通过更全面地整合网络内的可变形卷积,并引入modulation mechanism,扩大了变形建模的范围,增强了建模能力。为了有效地利用这种丰富的建模能力,我们通过提出的特征模仿方案来指导网络训练,帮助网络学习反映RCNN特征的对象焦点和分类能力的特征。新版本的可变形ConvNets比原来的模型有显著的性能提升,并在对象检测和实例分割的COCO基准上产生了领先的结果。

1. Introduction

由于比例、姿势、viewpoint and part deformation引起的几何变化是物体识别和检测中的一大挑战。目前解决这一问题的最先进的方法是可变形卷积网络(DCNv1)[8],它引入了两个模块来帮助CNN对这种变化进行建模。其中一个模块是可变形卷积,其中标准卷积的grid sampling locations根据前一层的特征图发生偏移。另一种是可变形RoIpooling,其中RoIpooling中的bin位置需要学习偏移量[16]。将这些模块集成到神经网络中,使其能够根据对象的结构调整其特征表示,特别是通过变形其采样和池化方式来适应对象的结构。该方法大大提高了目标检测的精度。

研究发现,一个样本的激活单元往往聚集在它所在的物体周围。然而,对一个物体的覆盖是不精确的,很可能会扩散超出感兴趣区域。在使用来自更具挑战性的COCO数据集[29]的图像对spatial support进行更深入的分析时,我们观察到这种行为变得更加明显。这些发现表明,可变形卷积存在更大的潜力。

在本文中,我们提出了一个新版本的Deformable ConvNets,称为Deformable ConvNets v2 (DCNv2),增强了学习可变形卷积的建模能力。这种建模能力的增强以两种互补的形式出现。首先是扩大了网络中可变形卷积层的使用范围。通过装备更多具有偏移学习能力的卷积层,使DCNv2能够在更大范围的特征层上控制采样。第二种是可变形卷积模块中的modulation mechanism,每个样本不仅经过学习偏移,而且还调整学习特征的比重( but is also modulated by a learned feature amplitude)。因此,网络模块被赋予了改变其样本的空间分布和相对影响的能力。

为了充分发挥DCNv2增加的建模能力,需要进行有效的训练。受神经网络中知识蒸馏工作的启发[2,22],我们利用教师网络来实现这一目的,教师在训练中提供指导。我们专门利用R-CNN[17]作为教师。由于R-CNN是一个专门针对裁剪图像内容进行分类的网络,因此R-CNN学习的特征不受感兴趣区域之外的无关信息的影响。为了模拟这个特性,DCNv2在训练中加入了一个特征模拟损失( a feature mimicking loss),这有利于学习与R-CNN一致的特性。通过这种方法,DCNv2为其增强的可变形采样提供了一个强大的训练信号。

通过所提出的更改,可变形模块仍然是轻量级的,并且可以很容易地融入到现有的网络架构中。具体来说,我们将DCNv2纳入到Faster R-CNN[33]和Mask R-CNN[20]系统中,并采用多种骨干网络。在COCO基准上的大量实验证明了DCNv2比DCNv1在对象检测和实例分割方面的显著改进。DCNv2的代码将被发布。

2. Analysis of Deformable ConvNet Behavior

2.1. Spatial Support Visualization

为了更好地理解可变形ConvNets的行为,我们通过有效接感受野、有效采样位置和误差约束显著区域(error-bounded saliency regions)来可视化网络节点的空间支持。这三种模式提供了不同和互补的视角,以了解有助于节点响应的底层图像区域。

Effective receptive fields 并非所有的像素在一个网络节点的感受野内的贡献是相等的。这些贡献的差异用一个有效感受野,其值计算为 节点响应的梯度与强度扰动的关系。的每个图像像素[31] (whose values are calculated as the gradient of the node response with respect to intensity perturbations of each image pixel [31])。我们利用有效感受野来检查单个像素对网络节点的相对影响,但是注意到这个度量没有反映完整图像区域的结构化影响。

Effective sampling / bin locations 在[8]中,(堆叠)卷积层的采样位置和RoIpooling层中的sampling bins被可视化,用于理解Deformable ConvNets的行为。然而,这些采样位置对网络节点的相对贡献没有被讨论。相反,我们将包含这些信息(采用位置)的有效采样位置可视化,计算为网络节点相对于sampling/bin位置的梯度,以便了解它们的贡献强度。

Error-bounded saliency regions 如果我们去除不影响网络节点的图像区域,网络节点的响应不会改变,正如最近关于图像显著性的研究所证明的[41,44,13,7]。基于这一性质,我们可以在较小的误差范围内,将节点的支持区域确定为与完整图像响应相同的最小图像区域。我们将其称为误差约束的显著性区域(error-bounded saliency region),它可以通过逐步掩盖图像的部分并计算所产生的节点响应来找到,如附录中更详细的描述.误差约束的显著性区域有利于比较来自不同网络的支持区域。

2.2. Spatial Support of Deformable ConvNets

分析了可变形网络在目标检测中的视觉支持区域。我们使用的regular ConvNet作为基线,由一个Faster R-CNN+ResNet-50[21]对象检测器和对齐的roipoolg(Aligned RoIpooling在[20]中称为RoIAlign。我们在本文中使用 "对齐的RoIpooling "这个术语是为了在其他相关术语的背景下更清楚地描述它。) [20]组成。ResNet-50中的所有卷积层都应用在整个输入图像上。在conv5阶段的有效步长从32像素减少到16像素,以提高特征图的分辨率.在ResNet-101的conv4特征之上添加了RPN[33]头。在conv5特征的基础上,我们添加了Fast R-CNN头[16],它是由对齐的RoIpooling和两个全连接(fc)层组成,然后是分类和bounding box回归分支。

我们按照[8]中的程序将对象检测器转化为其deformable counterpart。在conv5阶段的三层3x3卷积被可变形卷积层所取代。同时,对齐的RoIpooling层也被可变形的RoIPooling所取代。两个网络都是 在COCO基准上进行训练和可视化。值得注意的是,当偏移学习率设置为零时。 可变形的更快R-CNN探测器退化为普通的Faster R-CNN与对齐的RoIpooling。

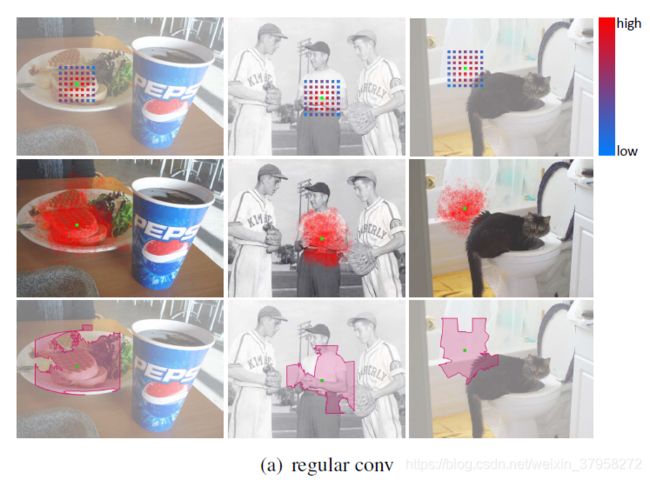

图1。对常规ConvNet、DCNv1和DCNv2中conv5阶段最后一层节点的空间支持。常规的ConvNet基线是Faster R-CNN+ResNet-50。在每个子图中,有效采样位置、有效感受野和误差有界显著区域从上到下显示。(c)中省略了有效取样位置,因为它们与(b)中的相似,提供了有限的附加值信息。那个可视化节点(绿色点)位于小对象(左)、大对象(中)和背景(右)。

利用三种可视化方式,我们考察了图1(a)~(b)中conv5阶段最后一层节点的空间支持。还显示了[8]中分析的采样位置。从这些可视化方式中,我们做出以下观察。

- 常规ConvNets可以在一定程度上模拟几何变化,具体表现为空间支持与图像内容的变化。得益于深度ConvNets强大的表示能力,网络权重的学习可以适应一定程度的几何变换。

- 通过引入可变形卷积,网络对几何变换的建模能力大大增强,即使在具有挑战性的COCO基准上也是如此。空间支持更加适应图像内容,前景节点的支持覆盖了整个物体,而背景节点的支持范围扩大,涵盖了更大的背景。然而,空间支持的范围可能是不精确的,前景节点的有效感受野和误差有界显著区域包括与检测无关的背景区域。

- 所介绍的三种类型的空间支持可视化比[8]中使用的采样位置更有参考价值。例如,这一点可以从常规ConvNets中看出,它沿网格有固定的采样位置,但实际上是通过网络权重调整其有效的空间支持。对于可变形ConvNets来说也是如此,它的预测受到学习的偏置值和网络权重的共同影响。如同[8]中所做的那样,仅仅考察取样位置可能会导致对可变形ConvNets的误导性结论。

图2. 每个RoI检测头中2fc节点的空间支持,直接进行分类和bounding box回归分支。可视化是在regular ConvNet,DCNv1和DCNv2上进行的。regular ConvNet基线是Faster R-CNN + ResNet-50。在每个子图中,从上到下行显示了有效的bin位置、有效的感受野和错误约束的显著性区域,除了©(e),其中有效的bin位置被忽略,因为它们比(a)(b)中的位置提供了很少的额外理解。输入的RoIs(绿框)是在一个小物体(左),一个大物体(中间)和背景(右)上。

图2(a)(b)显示了每个RoI检测头中2fc节点的空间支持,它的后面直接是分类和bounding box回归分支。有效bin位置的可视化表明,物体前景上的bin一般会从分类分支中获得更大的梯度,从而对预测施加更大的影响。这一观察结果对对齐的RoIpooling和可变形的RoIpooling都适用。在可变形的RoIpooling中,由于引入了可学习的bin偏移,与对齐的RoIpooling相比,覆盖对象前景的bin比例要大得多.因此,downstream Fast R-CNN头可以从相关bin中获得更多信息。同时,对齐ropooling和变形ropooling中的误差有界显著区域都没有完全集中在目标前景上,这说明RoI之外的图像内容会影响预测结果。根据最近的一项研究[6],这种特征干扰可能对检测有害。

虽然很明显,与普通ConvNets相比,可变形ConvNets适应几何变化的能力明显提高,但也可以看出,它们的空间支持可能超出了感兴趣的区域.因此,我们寻求升级可变形ConvNets,使它们能够更好地关注相关的图像内容,并提供更高的检测精度。

3. More Deformable ConvNets

为了提高网络适应几何变化的能力,我们提出了一些改变来提高其建模能力,并帮助它利用这种增强的能力。

3.1. Stacking More Deformable Conv Layers

我们发现可变形的ConvNets可以在具有挑战性的基准上有效地建模几何变换,因此我们大胆地将更多的regular conv层替换为可变形的对应层。我们期望通过堆叠更多的可变形conv层,可以进一步增强整个网络的几何变换建模能力。

本文将可变形卷积应用于ResNet-50中conv3、conv4和conv5阶段的所有3x3-conv层。因此,网络中有12层可变形卷积。相比之下,在[8]中只使用了三层可变形卷积,都是在conv5阶段。在[8]中观察到,对于相对简单和小规模的PASCAL VOC基准,当堆叠超过三层时,性能会饱和。此外,COCO上误导性的偏移可视化可能阻碍了对更具挑战性的基准的进一步探索。在实验中,我们观察到在conv3-conv5阶段使用可变形层可以在COCO上实现目标检测的精度和效率之间的最佳折衷。详见第5.2节。

3.2. Modulated Deformable Modules

为了进一步加强可变形ConvNets对空间支持区域的操控能力,我们引入了一种modulation mechanism,通过这种机制,可变形ConvNets模块不仅可以在感知输入特征时调整偏移量,而且还可以从不同的空间位置/bins调整输入特征的权重。有了它,Deformable ConvNets模块不仅可以在感知输入特征时调整偏移量,还可以调整不同空间位置/bins的输入特征权重。在极端情况下,一个模块可以通过将其特征权重设置为零来决定不感知来自特定位置/bins的信号。因此,来自相应空间位置的图像内容将大大降低或不影响模块的输出。因此,modulation mechanism为网络模块提供了另一个自由度来调整其空间支持区域。

给定K个采样位置的卷积核,让 w k w_k wk和 p k p_k pk分别表示第k个位置的权重和预先指定的偏移量。例如, K = 9 K=9 K=9和 p k ∈ { ( − 1 , − 1 ) , ( − 1 , 0 ) , . . . , ( 1 , 1 ) } p_k\in\{(-1,-1),(-1,0),...,(1,1)\} pk∈{(−1,−1),(−1,0),...,(1,1)}定义了一个3x3的卷积核(dilation 1)。让 x ( p ) x(p) x(p)和 y ( p ) y(p) y(p)代表输入特征图x和输出特征图y位置p的特征。调整后的可变形卷积可以表示为

其中 Δ p k \Delta p_k Δpk和 Δ m k \Delta m_k Δmk是位置k的可学习的偏移量和缩放因子。缩放因子 Δ m k \Delta m_k Δmk在[0,1]范围内, Δ p k \Delta p_k Δpk是一个无约束范围的实数。因为 p + p k + Δ p k p+p_k+\Delta p_k p+pk+Δpk通常不是整数,与[8]一样,采用双线性插值进行计算 x ( p + p k + Δ p k ) x(p+p_k+\Delta p_k) x(p+pk+Δpk)。 Δ p k \Delta p_k Δpk和 Δ m k \Delta m_k Δmk是通过一个单独的卷积层应用于相同的输入特征图x得到的。该卷积层与当前卷积层具有相同的空间分辨率和扩展比例(dilation)。输出通道数量是3K,其中前2K通道对应学习的偏移量(x,y方向的偏移量 ) { Δ p k } k = 1 K \{\Delta p_k\}^K_{k=1} {Δpk}k=1K,剩余的K个通道进一步送入sigmoid层,得到缩放因子 { Δ m k } k = 1 K \{\Delta m_k\}^K_{k=1} {Δmk}k=1K。在这个单独的卷积层中的核权重被初始化为零。因此, Δ p k \Delta p_k Δpk和 Δ m k \Delta m_k Δmk的初始值是0和0.5(sigmoid(0))。增加的conv层的偏移和调制学习的学习率设置为现有层的0.1倍。

modulated deformable RoIpooling的设计与此类似.给定一个输入RoI,RoIpooling将其分为K个空间bin(如7x7)。在每个bin,采用均匀空间间隔的采样网格(例如2x2)。对网格上的采样值进行平均,计算出bin输出。让 Δ p k \Delta p_k Δpk和 Δ m k \Delta m_k Δmk代表第k个bin的可学习的偏移量和缩放大小。The output binning feature y(k) is computed as

p k j p_{kj} pkj是第k个bin中的第j个网格单元格(grid cell)的采样位置, n k n_k nk表示采样的网格单元格数。利用双线性插值来获得特征 x ( p k j + Δ p k ) x(p_{kj}+\Delta p_k) x(pkj+Δpk)。 Δ p k \Delta p_k Δpk和 Δ m k \Delta m_k Δmk 的值是由输入特征图上的同级分支产生的。在这个分支中,RoIpooling在RoI上生成特征,然后是两个1024-D的fc层(初始化为0.01的高斯分布)。在此基础上,一个额外的fc层产生3k通道的输出(权重初始化为零)。前2K个通道是归一化的可学习偏移量,其中元素与RoI的宽度和高度相乘,计算得到 { Δ p k } k = 1 K \{\Delta p_k\}^K_{k=1} {Δpk}k=1K。其余的K通道经过sigmoid层归一化后,产生了 { Δ m k } K = 1 K \{\Delta m_k\}^K_{K=1} {Δmk}K=1K。增加的fc层的偏移学习的学习率与现有层的学习率相同。

3.3. RCNN Feature Mimicking

正如在图2中观察到的那样,对于常规ConvNets和可变形ConvNets来说,每个RoI分类节点的错误约束的显著性区域可以延伸到RoI之外.因此,RoI之外的图像内容可能会影响提取的特征,从而降低物体检测的最终结果。在[6]中,作者发现冗余上下文是Faster R-CNN检测错误的一个合理来源。结合其他动机(例如,在分类和边界盒回归分支之间共享较少的特征),作者建议将Faster R-CNN和R-CNN的分类得分结合起来,以获得最终的检测得分。**由于R-CNN分类得分主要集中在输入RoI中的裁剪图像内容上,加入这些内容将有助于缓解冗余上下文问题,提高检测精度。**但是,由于Faster-RCNN和R-CNN分支都需要在训练和推理中应用,所以组合系统的速度很慢。

同时,Deformable ConvNets在调整空间支持区域方面也很强大。特别是对于Deformable ConvNets v2来说,modulated deformable RoIpooling module可以简单地设置bins的缩放大小,以排除多余的背景信息。然而,我们在5.3节的实验表明,即使使用modulated deformable module,也不能通过标准的Faster R-CNN训练程序很好地学习这种表示,我们怀疑这是因为传统的Faster RCNN训练损失不能有效地驱动表征的学习。需要额外的指导来引导训练。

**在最近的特征模仿工作(feature mimicking )的激励下[2,22,28],我们在Deformable Faster R-CNN的每RoI特征上加入了一个特征模仿损失(feature mimic loss),以迫使它们与从裁剪图像中提取的R-CNN特征相似。这个辅助训练目标是为了驱动Deformable Faster R-CNN学习更多类似R-CNN的 "聚焦 "特征表示。**我们注意到,基于图2中可视化的空间支持区域,对于图像背景上的negative RoIs来说,聚焦的特征表示很可能不是最优的。对于背景区域,可能需要考虑更多的背景信息,以免产生假阳性检测。因此,特征模仿损失只在与ground-truth objects充分重合的positive RoIs上执行。

训练可变形的Faster R-CNN的网络架构如图3所示。除了Faster R-CNN网络外,还增加了一个额外的R-CNN分支用于特征模仿。给定一个用于特征模仿的RoI b,对其对应的图像patch进行裁剪并调整大小为224x224像素。在R-CNN分支中,主干网对调整后的图像块进行操作,并生成14x14空间分辨率的特征图。一个(modulated)可变形RoIpooling层被应用于特征图的顶部,其中输入的RoI覆盖了整个已调整大小的图像块(左上角为(0,0),高度和宽度为224像素)。之后,连接两层1024-D的fc层,产生输入图像patch的 R-CNN 特征表示,用 f R C N N ( b ) f_{RCNN}(b) fRCNN(b)。下面采用(C+1)路Softmax分类器进行分类,其中C表示前景类的数量,加上背景类的数量。R-CNN特征表示 f R C N N ( b ) f_{RCNN}(b) fRCNN(b)和Faster R-CNN中的对应物 f F R C N N ( b ) f_{FRCNN}(b) fFRCNN(b)之间强制执行特征模仿损失, f F R C N N ( b ) f_{FRCNN}(b) fFRCNN(b)也是1024-D,由Fast R-CNN头部的2个fc层产生。特征模拟损失定义在 f R C N N ( b ) f_{RCNN}(b) fRCNN(b)和 f F R C N N ( b ) f_{FRCNN}(b) fFRCNN(b)之间的余弦相似度上,计算公式为:

Ω \Omega Ω表示用于特征模拟训练的采样roi集合。在SGD训练中,给定一个输入图像,由RPN生成的32个positive region proposals被随机采样到 Ω \Omega Ω。在R-CNN分类头上强制执行交叉熵分类损失,也是在 Ω \Omega Ω中的RoIs上计算的,网络训练由特征模仿损失和R-CNN分类损失,加上Faster R-CNN中的原始损失项驱动。新引入的两个损失项的损失权重是原来Faster R-CNN损失项的0.1倍。

R-CNN和Faster R-CNN分支中相应模块之间的网络参数是共享的,包括骨干网络、 (modulated) deformable RoIpooling和2个fc头(两个分支中的分类头是不共享的)。在推理中,只在测试图像上应用Faster R-CNN网络,没有辅助R-CNN分支。因此,在推理中,R-CNN特征模仿没有引入额外的计算。

4. Related Work

Deformation Modeling 变形建模是计算机视觉中长期存在的问题,在设计 translation-invariant特征方面已经做出了巨大的努力。在深度学习时代之前,著名的作品包括尺度不变特征变换(SIFT)[30]、oriented FAST and rotated BRIEF(ORB)[34]以及deformable part-based models(DPM)[12]。这类工作受限于人为设计的特征的劣质表示能力和它们所处理的几何变换的受限系列(例如,仿射变换)。空间变换网络(STN)[25]是第一个关于学习深度CNN的翻译不变特征的工作。

它学会了将全局仿射变换应用于扭曲特征映射,但这种变换不足以模拟在许多视觉任务中遇到的更复杂的几何变化。可变形ConvNets不执行全局参数转换和特征扭曲,而是通过所提出的可变形卷积和可变形RoIpooling模块中的可学习偏移,以局部和密集的方式对特征映射进行采样。在复杂的目标检测中,首先要解决的问题是复杂的视觉模型(如几何变换)和复杂的视觉检测问题。

我们的工作通过增强可变形ConvNets的建模能力和简化网络训练来扩展它。与原始模型相比,新版本的可变形ConvNets产生了显著的性能提升。

Relation Networks and Attention Modules 关系网络和注意力模块最早是在自然语言处理[14,15,4,36]和物理系统建模[3,38,23,35,10,32]中提出的。注意力/关系模块通过聚合一组元素(如句子中的所有单词)的特征来影响单个元素(如句子中的一个单词),其中聚合权重通常是根据元素之间的特征相似性来定义的。它们在捕捉这些任务中的长距离依赖关系和上下文信息方面非常强大。最近,[24]和[37]的并行工作成功地将关系网络和注意力模块扩展到图像领域,分别用于建模长距离的对象-对象和像素-像素关系。在[19]中,提出了一种可学习的区域特征提取器,从像素-物体关系的角度统一了之前的区域特征提取模块。这种方法的一个常见问题是,聚集权重和聚集操作需要以成对的方式对元素进行计算,这将导致与元素数量(例如,图像中的所有像素)成二次方的大量计算。我们开发的方法可以被看作是一种特殊的注意机制,其中只有稀疏的元素集合具有非零的聚集权重(例如,在所有图像像素中,3x3像素)。参与元素由可学习偏移量指定,聚集权重由调制机制控制。计算开销与单元数成线性关系,与整个网络的计算开销相比可以忽略不计(见表1)。

,3x3像素)。参与元素由可学习偏移量指定,聚集权重由调制机制控制。计算开销与单元数成线性关系,与整个网络的计算开销相比可以忽略不计(见表1)。