开源代码和软件汇总!激光雷达和相机联合标定(2004-2021)

作者 | 十点雨 编辑 | 我爱计算机视觉

原文链接:https://zhuanlan.zhihu.com/p/404762012

点击下方卡片,关注“自动驾驶之心”公众号

ADAS巨卷干货,即可获取

点击进入→自动驾驶之心【多传感器融合】技术交流群

后台回复【相机标定】获取超详细的单目双目相机模型介绍、内外参标定算法原理视频!

LiDAR Camera Calibration (LCC)系列,主要介绍激光雷达相机外参标定相关内容。本文主要介绍相关的开源代码和软件,主要包括target-based和targetless两类方法,每个方法对应标题后说明了方法的提出年份和开源代码的语言(c : c++, p: python, m: matlab)。

Github同步更新:https://github.com/Deephome/Awesome-LiDAR-Camera-Calibration▊ 1. target-based方法

一般就是使用标定板,可以是一块普通的矩形板,可以添加视觉效果(比如棋盘格,ArUco),可以在矩形板上镂空出特定形状。

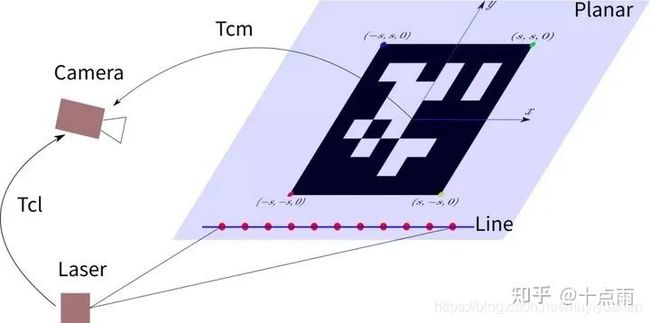

1.0 CamLaserCalibraTool (2004c)

主要参考了华盛顿大学2004年的论文,旷视提供了开源实现和博客解读。2D激光雷达和相机标定。主要利用点到平面和边缘的约束。详情见旷视的博客和开源:

github:https://github.com/MegviiRobot/CamLaserCalibraTool

博客:https://zhuanlan.zhihu.com/p/137501892

参考论文:http://citeseerx.ist.psu.edu/viewdoc/download?doi=10.1.1.80.7118&rep=rep1&type=pdf1.1 LCCT (2005m)

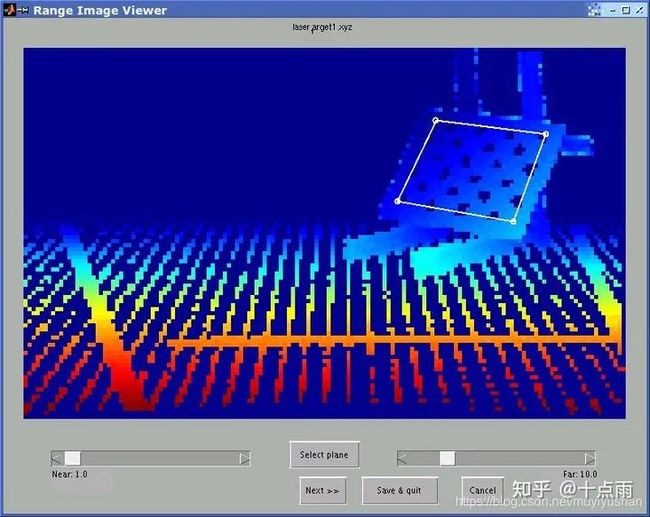

来自CMU Robotics Institute, 已知最早3D Laser与相机标定的工作(2005年),基于matlab的图形用户界面,进行激光雷达相机外参标定。

target-based方法,使用标定板,采集多个点云图像对,在点云对应的深度图(range image)上框选标定板平面区域,即可求解外参(两阶段)。

第一阶段,分别最小化两个坐标系中相机中心到平面距离和平面法向量的差异,依次线性求解平移和旋转;第二阶段,最小化point-to-plane距离,迭代求解。

官方网站:http://www.cs.cmu.edu/~ranjith/lcct.html

参考论文:https://www.ri.cmu.edu/pub_files/pub4/unnikrishnan_ranjith_2005_3/unnikrishnan_ranjith_2005_3.pdf1.2 cam_lidar_calib (2010c)

来自密歇根大学,ROS / C++实现。

使用checkerboard,最少需要3个视图。自动提取特征,图像中提取checkerboard在相机坐标系中的法向量和距相机原点的距离,点云中提取checkerboard的平面点。

Github开源:https://github.com/SubMishMar/cam_lidar_calib

参考论文: http://robots.engin.umich.edu/publications/gpandey-2010a.pdf1.3 lidar_camera_calibration (2017c)

来自印度IIIT Robotics Research Lab,ROS package (C++)实现, 介绍了两种方法。第一种方法是基于2D-3D correspondence,采用中空矩形纸板作为目标,在图像上手动标记角点2D像素,在点云中手动框选线段,利用直线相交求解3D角点,然后利用PnP+ransac求解外参。缺点是手动标记像素点,误差较大。

第二种方法是基于3D-3D correspondence,与方法一主要区别是图像中特征的提取。通过采用ArUco二维码,可直接计算出角点在相机坐标系的3D坐标,然后利用ICP求解外参。

github开源:https://github.com/ankitdhall/lidar_camera_calibration

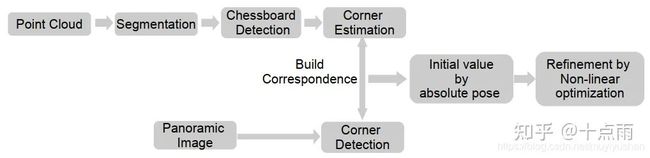

参考论文:https://arxiv.org/pdf/1705.09785v1.pdf1.4 ILCC (2017p)

来自日本名古屋大学Nagoya University,python实现。完整流程如下:

该方法的3D角点提取方式比较独特。基于点云反射强度和chessboard颜色模式的相关性,利用一个chessboard model来拟合(匹配)分割的点云,从而利用chessboard model的角点位置表示chessboard点云中角点位置。

github开源:https://github.com/mfxox/ILCC

参考论文:https://arxiv.org/pdf/1708.05514.pdf1.5 plycal (2018c)

来自HKUST,C++实现。

采用要给矩形板作为target。首先对激光雷达和相机时间同步,图像纠正。全自动地在图像中提取矩形板角点和边缘,在点云中提取矩形板的边缘和平面点。矩形特征2D-3D匹配。采用point-to-line和point-inside-polygon约束进行优化。

github开源:https://github.com/ram-lab/plycal

参考论文:https://www.semanticscholar.org/paper/Extrinsic-Calibration-of-Lidar-and-Camera-with-Liao-Chen/c52748f676ff0b082db61a49dee2d153205197441.6 Matlab Lidar Toolbox (2018m)

target-based方法,使用了chessboard, 理论上采集一个pose就可以求解。特征提取分别自动提取chessboard在相机和激光雷达坐标系的平面和边缘信息,利用line correspondence (direction constraint + point to line constraint)和plane correspondence (normal constraint + point to plane constraint)进行标定。

官方文档:https://ww2.mathworks.cn/help/lidar/ug/lidar-and-camera-calibration.html

参考论文:http://www.cs.cmu.edu/~kaess/pub/Zhou18iros.pdf

csdn博客:https://blog.csdn.net/qq_27339501/article/details/110224436只能使用matlab的lidar toolbox,看不到源代码,该方法与plycal(2018c)的标定板点云特征提取方法类似。

1.7 extrinsic_lidar_camera_calibration (2020m)

来自 Robotics Institute, University of Michigan。matlab实现。

主要创新点是标定板点云的角点估计方法。假设在lidar原点有一个大小已知的参考标定板(reference target),希望标定板点云通过H变换后,与这个参考标定板尽量重合。优化求解H,将参考标定板角点反变换,即可得到点云中的角点位置。

之前方法采用先拟合边缘再直线相交的思路,只利用了边缘点,受点云深度测量误差影响,最后提取的四个角点可能与target真实几何不兼容。该方法的角点估计考虑了所有点,估计的四个角点也是与真实target形状兼容。

该方法与ILCC(2017p)方法类似,都是通过与一个参考的标定板拟合,从而对标定板点云参数化建模,求得角点。只是ILCC利用了点云反射强度,本方法只利用点云几何信息。

该开源代码也实现了Matlab Lidar Toolbox (2018m)参考论文中点云边缘提取的方法:

1)先ransac拟合平面

2)找到每条scanline的端点(边缘点)

3)将标定板点云投影到拟合平面

4)拟合每条scan line

5)将边缘点投影到拟合的scan line

6)用ransac拟合边缘,去除边缘点粗差

github开源:https://github.com/UMich-BipedLab/extrinsic_lidar_camera_calibration

参考论文:https://arxiv.org/pdf/1910.03126.pdf1.8 livox_camera_lidar_calibration(2020c)

Livox官方提供的Lidar-Camera标定代码,图像和点云都是手动标点。

github开源:https://github.com/Livox-SDK/livox_camera_lidar_calibration1.9 ACSC (2020p)

来自北航,python实现,针对固态激光雷达Livox.

提出多帧点云集成精化算法(temporal-spatial-based geometric feature refinement)和基于反射强度分布的角点估计方法(reflectance intensity distribution-based 3D corner estimation )。自动提取2D和3D角点,然后用基于Ransac的PnP求解。

github开源:https://github.com/HViktorTsoi/ACSC

参考论文:https://arxiv.org/abs/2011.085161.10 velo2cam_calibration (2021c)

来自 Intelligent Systems Lab (LSI), Universidad Carlos III de Madrid, Leganes, ROS + C++实现。可以将激光雷达、单目相机、立体相机进行任意成对标定。需要比较特殊的标定板:

github开源:https://github.com/beltransen/velo2cam_calibration

参考论文:https://arxiv.org/pdf/2101.04431.pdf1.11 autoware

采用标定板的方法 (calibration_tookit, autoware1.10之后没有)

github: https://github.com/XidianLemon/calibration_camera_lidar

博客: https://adamshan.blog.csdn.net/article/details/81670732

https://www.cnblogs.com/xiangzh/p/14137345.html

直接手动选点的方法 :https://dlonng.com/posts/autoware-calibr-1最新版只有autoware_camera_lidar_calibrator, 直接手动选点的方法,在下文介绍。

使用标定板结果更准确一些,但是操作不方便。

1)需要手动grab多个关键帧

2)使用glviewer显示点云,不好调整视角

3)需要手动选择平面点云

▊ 2. targetless方法

2.1 apollo

是基于自然场景的targetless方法,不需要手动标记,但是需要较准确初值。

(一个比较好的标定场景,包含路灯,树木,道路等物体)

注意:核心代码没有开源

github文档:https://github.com/ApolloAuto/apollo/blob/master/docs/quickstart/apollo_2_0_sensor_calibration_guide.md

csdn博客https://blog.csdn.net/learning_tortosie/article/details/82351553?utm_medium=distribute.pc_relevant.none-task-blog-baidujs_baidulandingword-0&spm=1001.2101.3001.42422.2 autoware

没有target,但是需要手动标记图像和点云中的对应点,至少选择9对。

github文档:https://github.com/Autoware-AI/utilities/tree/master/autoware_camera_lidar_calibrator

csdn博客:https://blog.csdn.net/learning_tortosie/article/details/823476942.3 ExtrinsicCalib (2012c)

先将图像进行灰度化和直方图均衡化,得到灰度图像,然后根据点云的反射强度和法向量特征将点云投影为图像,使用标准化互信息衡量灰度图像和点云生成图像之间相关性。使用粒子群优化算法不断改变外参,直到粒子收敛,达到标准化互信息的最大值。

论文:http://robots.engin.umich.edu/publications/gpandey-2012a.pdf

官网:http://robots.engin.umich.edu/SoftwareData/ExtrinsicCalib局限性:对于图像,光照会影响像素亮度,且存在阴影问题;点云强度则不同,由于激光是主动式。因此,利用多视图数据,可以尽量避免光照、阴影造成的噪声,使误差函数相对平滑,便于优化。

2.4 CamVox (2020c)

来自南方科技大学。图像先灰度化再提取边缘,点云先分别得到反射强度图和深度图,再提取边缘。通过ICP优化,求解最佳外参。

github:https://github.com/xuankuzcr/CamVox

论文:https://arxiv.org/pdf/2011.11357.pdf2.4 livox camera calib (2020c)

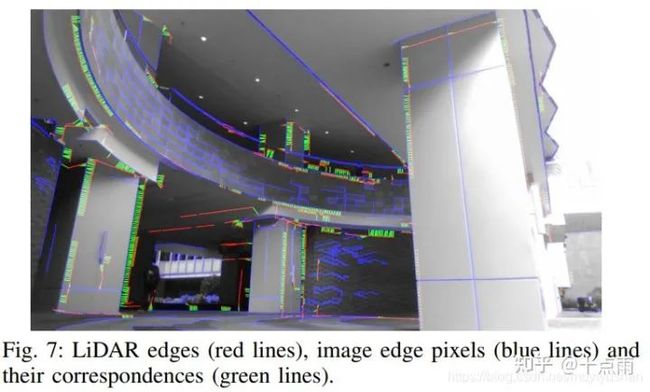

来自香港大学。分别提取点云和图像中的边缘特征,然后匹配特征,最后优化求解最佳外参来更好地对齐点云边缘和图像边缘。

论文:https://arxiv.org/pdf/2103.01627v2.pdf

作者:Chongjian Yuan (香港大学)

Github:https://github.com/hku-mars/livox_camera_calib

论文详细解读请参考:https://blog.csdn.net/muyiyushan/article/details/118573929往期回顾

超全汇总!多传感器离线/在线时空联合标定方法

【自动驾驶之心】全栈技术交流群

自动驾驶之心是首个自动驾驶开发者社区,聚焦目标检测、语义分割、全景分割、实例分割、关键点检测、车道线、目标跟踪、3D目标检测、BEV感知、多传感器融合、SLAM、光流估计、深度估计、轨迹预测、高精地图、规划控制、模型部署落地、自动驾驶仿真测试、硬件配置、AI求职交流等方向;

加入我们:自动驾驶之心技术交流群汇总!

自动驾驶之心【知识星球】

想要了解更多自动驾驶感知(分类、检测、分割、关键点、车道线、3D目标检测、多传感器融合、目标跟踪、光流估计、轨迹预测)、自动驾驶定位建图(SLAM、高精地图)、自动驾驶规划控制、领域技术方案、AI模型部署落地实战、行业动态、岗位发布,欢迎扫描下方二维码,加入自动驾驶之心知识星球(三天内无条件退款),日常分享论文+代码,这里汇聚行业和学术界大佬,前沿技术方向尽在掌握中,期待交流!