AAAI 2021 | 多模态最新进展解读

作者:孙宇冲

单位:中国人民大学

多模态学习旨在使计算机拥有处理不同来源信息的能力,近年来成为了人工智能领域的研究热点。多模态学习将不同模态信息进行融合,学习不同模态信息之间的关联。人类对信息的处理其实也是多模态的,如人可以同时利用视觉和听觉信息理解说话人的情感、可以通过视觉信息补全文本中的缺失信息等。多模态学习不仅可以用在视觉、听觉和自然语言信息的融合,也可以广泛用在雷达、传感器等信息的分析处理。因此多模态学习的研究和应用也越来越广泛。

在AAAI 2021上有许多多模态方向的相关研究,以下对AAAI 2021上多模态相关研究的最新进展作总结:

01

Image-Text多模态研究

常见的图文多模态研究的任务主要有Image Caption、图文跨模态检索等,在AAAI 2021上也有多模态翻译、视觉故事生成、多模态命名实体识别等相关研究。

近年来出现了许多图文预训练模型,在 AAAI 2021上,百度提出的ERNIE-VIL[1]模型利用场景图中结构化的知识,使用场景图预测任务进行预训练,使模型能够进行细粒度的语义对齐。VIVO[2]模型使用Image-Tag进行预训练,使语义标签能和图片中的region特征对齐,在下游的Image Caption任务中,解决了新物体(Novel Object)识别的问题。RpBERT[3]使用多模态BERT模型来完成多模态命名实体识别任务,提出的Relation Propagation机制可以根据图片文本之间的相关性更好地利用视觉信息。

Wang et al. [4]研究了多模态翻译任务,使用了Object-masking损失使模型可以把翻译的实体和图片中相关的Object相联系。Chen et al. [5]研究了视觉故事讲述任务,先使用常识知识进行概念选择,然后使用预训练模型从概念和图片生成完整的故事,增强了故事的丰富性和多样性。Zhang et al.[6]也研究了多模态命名实体识别问题,提出一种多模态图融合的方法融合语义单元信息。

02

Video-Text多模态研究

AAAI 2021上关于Video-Text多模态的研究主要有视频描述生成、视频文本对齐等。

Yang et al. [7]提出一种非自回归方法用于视频描述生成,该方法先并行地从视频中提取出visual words并生成句子模板,然后再通过细粒度的解码生成完整的描述。Lin et al. [8]使用多个Decoder相互学习,实验表明该策略对每一个Decoder的效果都有改善,作者还提出使用frame-mask的方式来解决one-to-many问题。

Chen et al. [9]研究了Text-Video检索中存在的领域适应问题,作者提出了一个UDAVR(Unsupervised Domain Adaptation for Video Retrieval)评测基准,并使用CAPQ(Concept-Aware-Pseudo-Query)模型学习具有区分性和可转移性的特征来连接跨领域的差异。Bao et al. [10]提出了dense events grounding问题,提出了DepNet(Dense Events Propagation Network)模型,通过聚合与传播机制有效捕捉事件的时序关系和语义联系,实验结果表明,该方法相较于单事件grounding具有明显的性能优势。Xiao et al. [11]提出了BPNet,使用两阶段的方法来研究自然语言视频定位,结合了Anchor-based和Anchor-free方式的优点。

03

其他多模态研究

除了对图片、视频和文本模态的研究,在AAAI 2021上也有对音频、电子健康记录和传感器等模态信息的研究,一些研究者利用多模态方法研究了社会关系抽取、情感识别和虚假新闻检测等问题。

Huang et al. [12]研究了面向音频的多模态机器理解,其目标是在给定音频和文本信息的基础上回答问题。电子健康记录(EHR, electronic health records)具有复杂的多模态结构,Xu et al. [13]使用神经结构搜索(NAS)和多模态融合架构搜索(MUFASA)来同时选择单模态和跨模态的网络架构,该方法在公开的EHR数据集上的效果优于单模态NAS。VMLoc[14]模型使用Prodoct-of-Experts和注意力机制融合多个传感器的输入,模型在RGB-D数据集上验证了模型的有效性。

Wan et al. [15]研究了结合文本和人脸图像进行社会关系抽取,实验表明该方法优于基于BERT的文本单模态baseline。Yu et al. [16]和Zhang et al. [17]研究了多模态情感识别问题,前者设计了多任务学习来增强模态特征表示的一致性和差异性,后者则关注了多标签情感分类问题。Silva et al. [18]研究了利用多模态数据进行跨域假新闻检测,利用新闻记录中保留特定领域和跨领域的知识来检测跨领域新闻数据集中的假新闻。

参考文献

[1] ERNIE-ViL: Knowledge Enhanced Vision-Language Representations Through Scene Graph

[2] VIVO: Visual Vocabulary Pre-Training for Novel Object Captioning

[3] RpBERT: A Text-Image Relation Propagation-Based BERT Model for Multimodal NER

[4] Efficient Object-Level Visual Context Modeling for Multimodal Machine Translation: Masking Irrelevant Objects Helps Grounding

[5] Commonsense Knowledge Aware Concept Selection For Diverse and Informative Visual Storytelling

[6] Multi-modal Graph Fusion for Named Entity Recognition with Targeted Visual Guidance

[7] Non-Autoregressive Coarse-to-Fine Video Captioning

[8] Augmented Partial Mutual Learning with Frame Masking for Video Captioning

[9] Mind-the-Gap! Unsupervised Domain Adaptation for Text-Video Retrieval

[10] Dense Events Grounding in Video

[11] Boundary Proposal Network for Two-Stage Natural Language Video Localization

[12] Audio-Oriented Multimodal Machine Comprehension via Dynamic Inter- and Intra-modality Attention

[13] MUFASA: Multimodal Fusion Architecture Search for Electronic Health Records

[14] VMLoc: Variational Fusion For Learning-Based Multimodal Camera Localization

[15] FL-MSRE: A Few-Shot Learning based Approach to Multimodal Social Relation Extraction

[16] Learning Modality-Specific Representations with Self-Supervised Multi-Task Learning for Multimodal Sentiment Analysis

[17] Multi-modal Multi-label Emotion Recognition with Heterogeneous Hierarchical Message Passing

[18] Embracing Domain Differences in Fake News: Cross-domain Fake News Detection using Multimodal Data

推荐阅读:

AAAI 2021 | 图神经网络·最新进展解读

AAAI 2021 | 机器翻译·最新进展解读

AAAI 2021 | 情感分析·最新进展解读

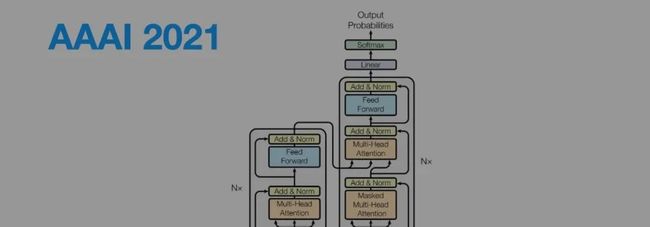

AAAI 2021 | Transformer·最新进展解读

【关于智源社区】

智源社区隶属于北京智源人工智能研究院,我们致力于创建一个AI领域内行人的交流平台。

在这里你有机会参与全年线上线下百场专题论坛,与顶尖学者零距离接触;也可以与同行探讨领域前沿,碰撞思想火花。如果你更想进入微信群与更多同行人发起实时讨论,或者加入「青源会」结识更多研究伙伴,或者成为智源社区编辑参与更多文字工作,欢迎填写以下表单(扫描二维码)进行申请。