目标检测(2)--YOLOV3、YOLOV3SPP

目录

(一)YOLOV3

一、导论

二、基本思想

1、backbone的改进

2、针对多尺度预测编辑

3、bounding box预测

4、正负样本的匹配

5、多标签分类

三、损失函数

(二)YOLOV3 SPP

一、导论

二、SPP模块

三、Mosaic图像增强

四、DIOU

五、Focal loss

(一)YOLOV3

一、导论

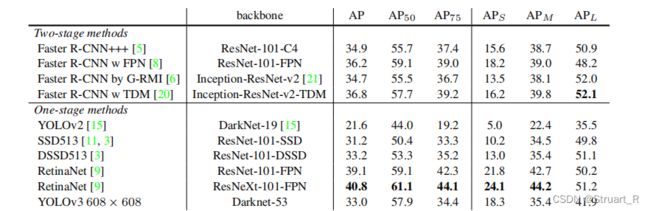

YOLOV3:An Incremental Improvement,是Joseph Redmon在2018年CVPR中发表的新一篇论文,对于从YOLOV2到YOLOV3来说,主要改进了原来darknet-19网络结构为darknet-53,使用逻辑回归代替了softmax,提高了目标检测的准确性。

YOLOV3相比于其他模型的准确率与反应时间的提升:

二、基本思想

1、backbone的改进

(1)将原来darknet-19网络结构改进为为darknet-53。

(2)convolutional和residual模块为:

(3)concatenate层将darknet-53中的中间层与up sampling上采样后进行张量拼接,达到多尺度特征融合的目的,会扩充张量的维度。而相比与残差层的add步骤,add是不会导致张量增加,只是直接的相加操作。

(4)相比与darknet-19来说,用卷积层进行下采样替代了maxpooling层,在每一个卷积层后都加入了BN层好Leaky ReLU激活函数以防过拟合,引入Residual残差网络以免梯度消失或爆炸。

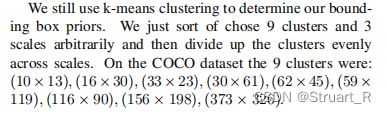

2、针对多尺度预测

为了应对多尺度预测的目标,YOLOV3通过darknet-53中的中间层与网络外多次up sampling的输出进行拼接,并通过再卷积生成三个预测特征矩阵输出,以预测大中小三种不同尺寸的目标。由于YOLOV3选择三种不同的shape进行输入,则预测的anchors就有9种,原论文利用coco数据集并通过K-means聚类算法得出下面的anchors尺寸。

由原论文可知,每个边界框需要五个参数即x,y,w,h,confidence(置信度),类别总数为80类,对于N*N的特征矩阵,网络输出张量为N*N*(3*(4+1+80))

三个特征矩阵输出为[13,13,255]、[26,26,255]、[52,52,255]。

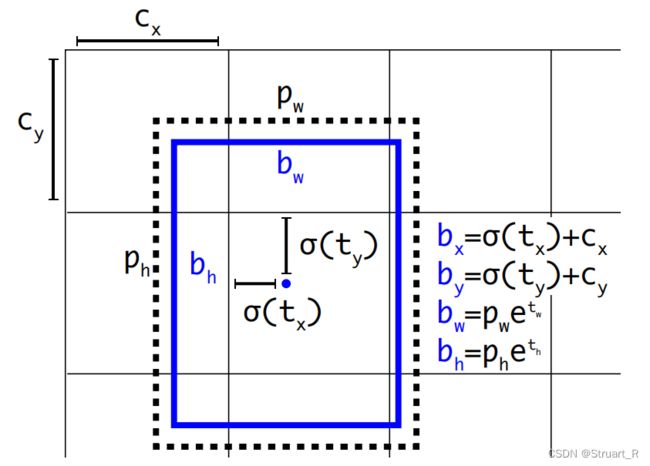

3、bounding box预测

boundingbox预测仍然遵循YOLOV2的目标边界框预测方式。

4、正负样本的匹配

针对每一个GT层都会分配一个正样本,与GT层重合程度最大的bounding box prior作为其正样本,如果bounding box与GT层重合但不是最大,但是又超过了某一阈值(threshold),则会丢弃这一样本。除了正样本以外均作为负样本,负样本只有目标损失,不存在置信度损失和分类损失。

5、多标签分类

YOLOV3将YOLOV2中单标签分类预测改进为多标签分类预测,使用逻辑回归(sigmoid函数)替代原来的softmax作为逻辑分类器。YOLOV2中,算法只认定某一目标从属于特定一个类别,根据网络输出类别得分最大值归属于该类,而在复杂场景下,某一目标可能从属于多个类别,甚至存在嵌套类别,即泛类,而通过sigmoid函数,可以将输出约束到0 to 1,当某一目标的输出经过函数处理后的值大于设定阈值,则认定该目标框所对应的目标所属于该类,完成多标签分类。

三、损失函数

YOLOV3损失函数=目标置信度损失+目标分类损失+目标定位偏移量损失

![]()

置信度损失:

采用二值交叉熵损失,其中使用Sigmoid函数计算c^i,表示预测目标矩形框i内存在目标的sigmoid概率。O^i∈(0,1),0表示边界框i中不存在真实目标,1表示存在。

![]()

![]()

目标分类损失:

采用二值交叉熵损失,将同一目标同时归为多类,来应对更复杂的场景。C^ij表示网络预测目标边界框i内存在第j类目标的Sigmoid概率,O^ij∈(0,1)表示预测目标边界框i中是否真实存在第j类目标。

![]()

目标定位偏移量损失:

采用真实偏差值与与偏差值差值的平方和,其中l表示预测矩形框的坐标偏移量,g-hat表示GT box与默认框的坐标偏移量,g表示真实目标框参数,b表示bounding box与默认框的坐标偏移量,c和p表示默认矩形框参数。

![]()

![]()

![]()

![]()

参考视频:yolov3理论讲解_哔哩哔哩_bilibili

参考文献:https://pjreddie.com/media/files/papers/YOLOv3.pdf

(二)YOLOV3 SPP

一、导论

YOLOV3 SPP在YOLOV3基础上添加了若干trick模块,其中重要的改进有SPP模块,Mosaic图像增强,CIOU替代IOU来计算交并比。

二、SPP模块

SPP模块借鉴空间金字塔思想,实现局部特征和全局特征的融合。如图可知,SPP模块由四个分支组成,且SPP模块在下面三个输出特征层之上,而非在每一个上采样后都加入SPP模块(理论上这种方式可以优化,但是换来更长的响应时间),在经过SPP模块后,张量中channel应变为原来的4倍,B,H,W不变。

下图为使用不同的trick后的响应时间和识别效果的参数,其中SPP3为使用三个spp模块,上文提到的括号中的形式 。

SPP空间金字塔网络:George Mason Federated Login Service

三、Mosaic图像增强

Mosaic图像增强方法来源于YOLOV4原论文中,主要思想通过将四张图片随机裁剪,再拼接到一张图片上作为训练数据,这种做法丰富了图片的背景,并且四张图片拼接在一起提高了batch_size,在进行batch normalization的时候也会计算四张图片,所以降低了对batch_size的依赖性。

四、DIOU

YOLOV3 SPP中使用了更为贴近目标框的DIOU损失函数计算方式

回归损失最重要的三个参数:重叠面积、中心点距离、长宽比,而CIOU做到了更为贴近真实情况的损失函数计算方法,但在YOLOV3 SPP中未达到明显效果,固使用DIOU。

IOU、GIOU、DIOU、CIOU损失函数:一文详解目标检测损失函数:IOU、GIOU、DIOU、CIOU_视学算法的博客-CSDN博客

五、Focal loss

由于一张图像中能够匹配到目标的候选框(正样本)个数一般只有十几个或者几十个,而未被匹配的候选框(负样本)大概有数万个,在这些负样本中,大部分都是简单易分的,对训练网络起不到作用,但由于数量太多会淹没掉少量但有助于训练的样本。

提出hard negative mining思想,通过预分类记录其对应特征和分类器得到的概率,对其重新训练,按概率值进行排序,再使用排序后的对应特征重新训练分类器,并多次迭代的方法,来实现样本选择。

在YOLOV3 SPP中,使用Focal Loss通过对损失函数计算中二值交叉熵损失添加因子γ来降低易分负样本的损失贡献。

![]()

六、利用YOLOV3模型实时目标检测

注意:该代码只能用权重文件后缀为weights的,后缀为pt或pth的需要转换。

import numpy

import cv2

import os

import time

yolo_dir = 'D:/PycharmProjects/Yolo3_spp' # YOLO文件路径

weightsPath = os.path.join(yolo_dir, 'weights','yolov3.weights') # 权重文件

configPath = os.path.join(yolo_dir, 'cfg','yolov3.cfg') # 配置文件

labelsPath = os.path.join(yolo_dir, 'data','coco.names') # label名称windows darknet python

imgPath = os.path.join(yolo_dir, 'test_1.jpeg') # 测试图像

CONFIDENCE = 0.5 # 过滤弱检测的最小概率

THRESHOLD = 0.4 # 非最大值抑制阈值

net = cv2.dnn.readNet(configPath, weightsPath)

print("[INFO] loading YOLO from disk...") # # 可以打印下信息

clicked = False

def onMouse(event, x, y, flags, param):

global clicked

if event == cv2.EVENT_LBUTTONUP:

clicked = True

#cameraCapture=cv2.VideoCapture('video_2.m4s') #检测所提供的视频

cameraCapture = cv2.VideoCapture(0) # 打开编号为0的摄像头

cv2.namedWindow('detected image') # 给视频框命名

cv2.setMouseCallback('detected image', onMouse)

print ('显示摄像头图像,点击鼠标左键或按任意键退出')

success, frame = cameraCapture.read()

while success and cv2.waitKey(1) == -1 and not clicked: # 当循环没结束,并且剩余的帧数大于零时进行下面的程序

# 加载图片、转为blob格式、送入网络输入层

blobImg = cv2.dnn.blobFromImage(frame, 1.0 / 255.0, (416, 416), None, True,

False) # # net需要的输入是blob格式的,用blobFromImage这个函数来转格式

net.setInput(blobImg) # # 调用setInput函数将图片送入输入层

# 获取网络输出层信息(所有输出层的名字),设定并前向传播

outInfo = net.getUnconnectedOutLayersNames() # # 前面的yolov3架构也讲了,yolo在每个scale都有输出,outInfo是每个scale的名字信息,供net.forward使用

start = time.time()

layerOutputs = net.forward(outInfo) # 得到各个输出层的、各个检测框等信息,是二维结构。

end = time.time()

print("[INFO] YOLO took {:.6f} seconds".format(end - start)) # # 可以打印下信息

# 拿到图片尺寸

(H, W) = frame.shape[:2]

# 过滤layerOutputs

# layerOutputs的第1维的元素内容: [center_x, center_y, width, height, objectness, N-class score data]

# 过滤后的结果放入:

boxes = [] # 所有边界框(各层结果放一起)

confidences = [] # 所有置信度

classIDs = [] # 所有分类ID

# # 1)过滤掉置信度低的框框

for out in layerOutputs: # 各个输出层

for detection in out: # 各个框框

# 拿到置信度

scores = detection[5:] # 各个类别的置信度

classID = numpy.argmax(scores) # 最高置信度的id即为分类id

confidence = scores[classID] # 拿到置信度

# 根据置信度筛查

if confidence > CONFIDENCE:

box = detection[0:4] * numpy.array([W, H, W, H]) # 将边界框放会图片尺寸

(centerX, centerY, width, height) = box.astype("int")

x = int(centerX - (width / 2))

y = int(centerY - (height / 2))

boxes.append([x, y, int(width), int(height)])

confidences.append(float(confidence))

classIDs.append(classID)

# # 2)应用非最大值抑制(non-maxima suppression,nms)进一步筛掉

idxs = cv2.dnn.NMSBoxes(boxes, confidences, CONFIDENCE, THRESHOLD) # boxes中,保留的box的索引index存入idxs

# 得到labels列表

with open(labelsPath, 'rt') as f:

labels = f.read().rstrip('\n').split('\n')

# 应用检测结果

numpy.random.seed(42)

COLORS = numpy.random.randint(0, 255, size=(len(labels), 3),

dtype="uint8") # 框框显示颜色,每一类有不同的颜色,每种颜色都是由RGB三个值组成的,所以size为(len(labels), 3)

if len(idxs) > 0:

for i in idxs.flatten(): # indxs是二维的,第0维是输出层,所以这里把它展平成1维

(x, y) = (boxes[i][0], boxes[i][1])

(w, h) = (boxes[i][2], boxes[i][3])

color = [int(c) for c in COLORS[classIDs[i]]]

cv2.rectangle(frame, (x, y), (x + w, y + h), color, 2) # 线条粗细为2px

text = "{}: {:.4f}".format(labels[classIDs[i]], confidences[i])

cv2.putText(frame, text, (x, y - 5), cv2.FONT_HERSHEY_SIMPLEX, 0.5, color,

2) # cv.FONT_HERSHEY_SIMPLEX字体风格、0.5字体大小、粗细2px

cv2.imshow('detected image', frame)

success, frame = cameraCapture.read() # 摄像头获取下一帧

cv2.destroyWindow('detected image')

cameraCapture.release()

通过行人行走视频检测当前视频中的行人,但是由于YOLOV3的FPS较低,所以检测视频极其卡顿。

参考视频:yolov3spp理论讲解(包括CIoU以及Focal Loss)_哔哩哔哩_bilibili