无框架 使用c++从零开始实现 卷积 全连接 softmax 入门深度学习 CPU版 梯度下降

经过一段时间的努力,用C++把卷积写完了。因为深度学习太火了,所以 忍不住就试试。先是找资料看看需要什么,然后进行学习,恶补线性代数、微积分、概率论,感觉能用到的知识点学差不多就开始代码【真要等到全学会再动手写代码,以我的智商估计就没有然后了】。现在成熟框架很多,为了更好的理解原理选择自己造轮子,能力有限,所以这个过程很漫长也很痛苦!

太多的技术细节网上都有资料,我也不用多说,因为没有大神讲的透彻,理论是一回事,实际做又是另一回事。理论上的事儿我只说两点,第一个是多层卷积卷积核的数量,第二个是梯度下降和调参的关系,因为我在学习和编码的过程中出现了错误的想法,所以说一下。剩下的看代码。

一. 卷积核

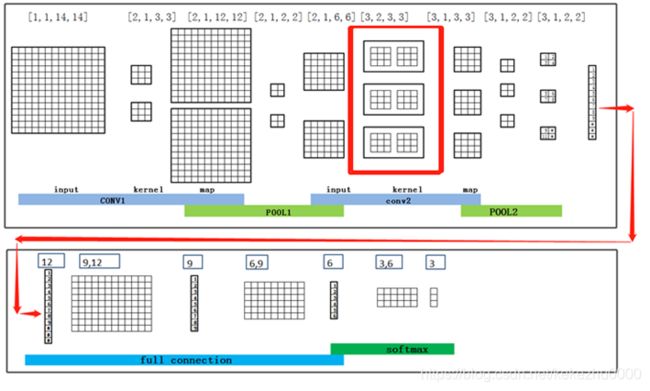

先说一下多层卷积卷积核,程序用的都是数组,所以卷积的数据存储都是4维,分别用block、depth、row、column,可以理解为盒子里面插卡片,block 表示盒子个数,depth表示盒子里卡片张数、row 和column 表示卡片大小,看下面的示意图,这只是个简单的例子,注意红框里面的卷积核,是3个block,每个block里面有2个depth,应该是2*3个卷积核,我在最开始理解的时候理解为每个block里面有1个depth,所以正确率一直上不去。

如果说有2个input 希望输出10个map,那卷积核应该有多少呢?

2x10 = 20

二. 梯度下降

再说一下梯度下降,可能数学好的同志们这都不叫事儿,但是不好的就另当别论了。

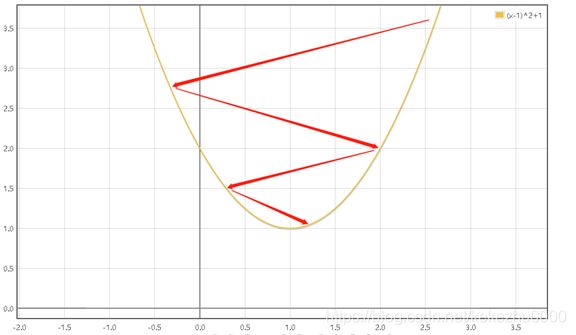

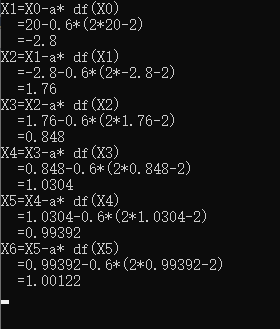

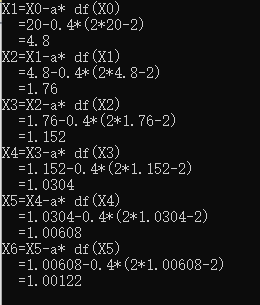

假如我们的目标函数:(X-1)^2+1,为了是目标函数的导数最小,更新X的值 ,开始我的想法是X越小越接近答案,现在想起来都觉得郁闷,居然有这种想法。实际情况是随着X变化找到最小的斜率,其实就是X=1,当学习速率是0.6的时候用计算机计算效果如下:

当我们设定学习速率是0.4的时候,应该是下面的效果:

目标就是X=1,程序很简单,就几行代码,有兴趣的可以自己试试,体会一下调参的感觉,网络再复杂也就这个意思吧!

long double x = 20;

long double a = 0.4;

for (int i = 0; i < 10000;i++){

cout << "X" << i + 1 << "=" << "X" << i << "-" << "a* df(" << "X" << i <<")"<< endl;

cout <<" ="<< x << "-" << a << "*" << "(2*" << x << "-2" << ")" << endl;

cout << " =" << x - a*(2 * x - 2) << endl;

x = x - a*(2 * x - 2);

}

三. 测试效果

先是拿MNIST数据集测试程序效果,都说这个数据集被玩坏了,我感觉这个挺好。

我用了三层卷积,每个卷积后面加POOL,POOL用的是平均值,没用最大值,有兴趣可以自己改一下就可以,三层全连接还有结尾的softmax,正确率99.33%,然后我又自己随意写了一些进行测试。代码可以调整,卷积和全连接可以增加或者减少,也可以只用全连接,测试各种搭配的效果。

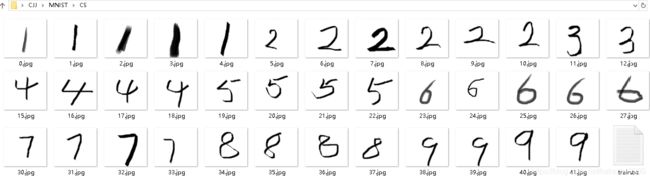

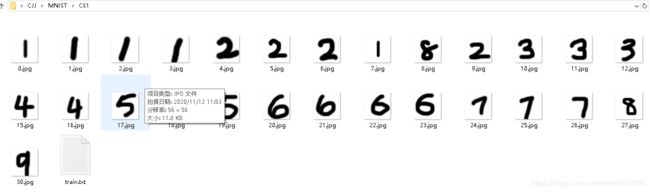

这个样子的测试正确率最高94%,这是在PS上面用柔性笔写的,还有一些模仿MNIST数据集,在模仿的像一点儿准确率会更高。

下面这个样子的数据测试正确率70%,这个跟MNIST的样式差距已经很大了,能到70%的正确率还算不错,MNIST这个是黑底白字,我写的是白底黑子,所以要对数据进行处理,代码里面只要修改一下ARRAY.cpp文件中的一个值就能完成转换。

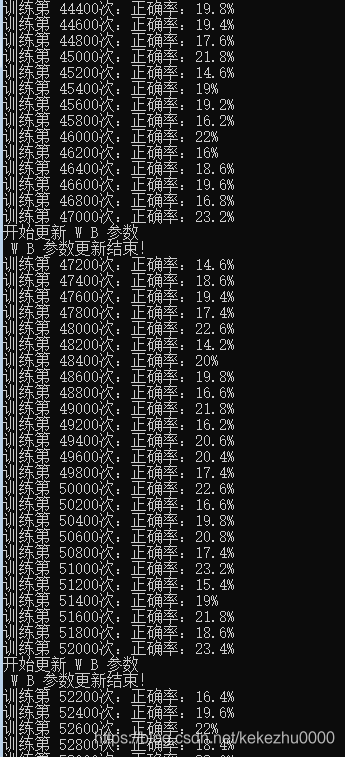

这是训练时更新W B 参数效果,速度还可以,正确率到80%左右的时候会变慢,90%之后会更慢,这也是符合规律的,数据太长了,我只复制了一部分。这里不得不说一下,最开始的时候程序到处都是错误,运行好久正确率没任何变化,后来随着优化和修改,正确率提升的越来越快,那种感觉就一个字“爽”。

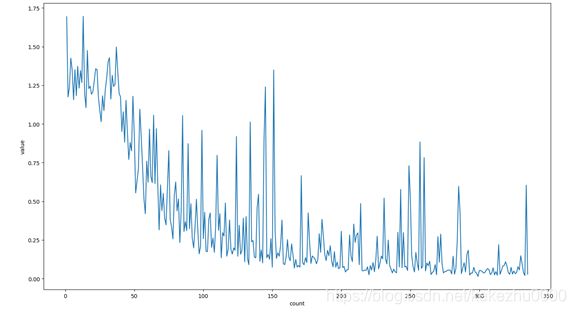

下图是softmax层loss函数曲线,整体还算可以,但是那几凸起看着还是挺扎心的,我在全连接的输入层和隐藏层都加入了Dropout处理,Dropout丢弃概率是50%,所以曲线一直跳动,曲线很难看但是识别效果确实不错。

下面是画曲线的代码,用的python,就这几行很简单

#!/usr/bin/env python

# -*- coding: GBK -*-

from numpy import *

import numpy as np

from matplotlib import pyplot as plt

yw=loadtxt('Arr_delta_layer_output.txt',dtype='float')

xw = np.arange(1,len(yw)+1)

plt.title("")

plt.xlabel("count")

plt.ylabel("value")

plt.plot(xw,yw)

plt.show()

汉字识别:

代码也可以进行汉字的识别,但是不能识别太多类别,因为程序是基于CPU运行的,没有做加速GPU处理,所以对好几千分类来说太困难了,速度是不能接受的,如果也做个10分类,20分类都还能接受,准确率不低于数字识别,随着分类得增加,训练速度越来越慢,到50分类的运行速度就已经不行了,这个实验过程也不错,你会体会到特征的数量直接影响分类的数量和准确率。10分类的情况下,三层卷积结束,数据传入全连接输入层有几千个特征,准确率肯定能很高,如果到全连接有几千的特征值,非要做3755个汉字分类那肯定是不行的。有空再造个轮子,写个GPU的版本,主要是学习,如果使用GPU速度会有极大的提升,那时候就有底气做几千分类的训练了。

下图是我做50分类的训练曲线截图,是不是很崩溃

四. 代码

如果已经看了很多资料,依然有很多不明白的地方,看下面的代码应该会有很大的帮助,技术文档对照代码,我感觉对程序员来说是再好不过的快速学习方法了。当然实践最重要,但是要踩很多坑。

开发环境:win10 、vs2010、 opencv2.4.8

Opencv配置可以看这个,写的很棒文章链接: http://blog.csdn.net/poem_qianmo/article/details/19809337

使用opencv为的是在开始做数据归一化的时候好处理,因为数据集的加载、图片大小的改变都很方便。

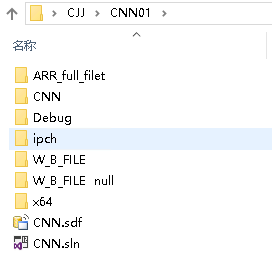

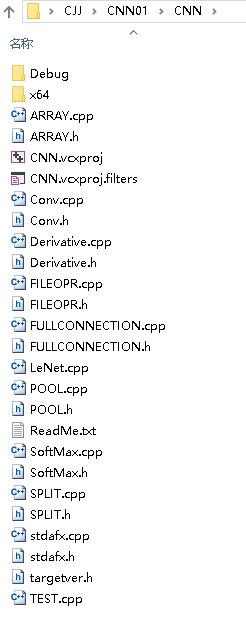

先看一下代码总体结构

废话少说上代码

1、 ARRAY.h

将数组的操作进行封装方便调用,训练的时候可以在控制台输出,也可以输出到txt文件,看效果也方便,cpp文件太长了,后面会随工程打包,方便下载。

#ifndef ARRAY_H

#define ARRAY_H

#include 2、 Conv.h

文件中有同名函数有带下划线和不带下划线的,带下划线的是正确的,不带下划线的是错误的,为自己当时产生如此愚蠢的想法做个纪念,没有删除,有兴趣的可以看看,如果是你来写,会不会有那样错误的想法。

#ifndef CONV_H

#define CONV_H

class Array;

class Conv

{

public:

Conv();

Conv(int _depth, int _row, int _column);

~Conv();

//深度

int depth;

//行

int row;

//列

int column;

double jz[10];

double *dt;// = new double[1];

long double *Matrix1D;

long double **Matrix2D;

long double ***Matrix3D;

/*

函数说明:卷积向前传播函数

参数说明:

ARR_inMat:卷积输入矩阵

ARR_kernel:卷积核矩阵

ARR_outMat:卷积运算后的Feature Map

ARR_bias:偏置值

stride:卷积步幅

ZeroPadd:矩阵外层补零层数。

0代表不做处理,1代表外围补一圈0,2代表补两圈

【一般是再最开始对原始图像处理的时候添加,以便更好的获取边缘特征,提高识别率】

*/

int forword_(Array *ARR_inMat, Array *ARR_kernel, Array *ARR_outMat, Array *ARR_bias, int stride, int ZeroPadd, char Activation);

/*

函数说明:卷积向前传播函数

参数说明:

ARR_inMat:卷积输入矩阵

ARR_filter:卷积核矩阵

ARR_outMat:卷积运算后的Feature Map

ARR_bias:偏置值

stride:卷积步幅

ZeroPadd:矩阵外层补零层数。

0代表不做处理,1代表外围补一圈0,2代表补两圈

【一般是再最开始对原始图像处理的时候添加,以便更好的获取边缘特征,提高识别率】

*/

int forword(Array *ARR_inMat, Array *ARR_filter, Array *ARR_outMat, Array *ARR_bias, int stride, int ZeroPadd);

/* 函数说明:卷积反向梯度计算,更新ARR_filter和 ARR_bias,

参数说明:

向前计算输出: *ARR_outMat_forword_Out

样本标签: *lable

过滤层: *ARR_filter

修正值: *ARR_bias

误差值δ: *ARR_datle

步幅 : stride

速率μ : rate

*/

int backwordUpdateGradient(Array *ARR_inMat, Array *ARR_outMat_forword_Out, Array *ARR_filter, Array *ARR_bias, Array *ARR_delta_feature_map, int stride, double rate);

/* 函数说明:卷积反向梯度计算,更新ARR_filter和 ARR_bias,

参数说明:

向前计算输出: *ARR_outMat_forword_Out

样本标签: *lable

过滤层: *ARR_filter

修正值: *ARR_bias

误差值δ: *ARR_datle

步幅 : stride

速率μ : rate

*/

int backwordUpdateGradient_(Array *ARR_inMat, Array *ARR_outMat_forword_Out, Array *ARR_kernel, Array *ARR_bias, Array *ARR_delta_feature_map, int stride, double rate);

/* 函数说明:反向网络误差传播

因为二层以后的卷积涉及到卷积层从FeatureMap反向传播误差的操作,

第一层卷积不涉及到这步操作,为了使单个函数看起来更简洁,逻辑更简单,特意添加这个函数

参数说明:

向前计算输出: *ARR_outMat_forword_Out

样本标签: *lable

过滤层: *ARR_kernel

修正值: *ARR_bias

误差值δ: *ARR_datle

pool反向δ:ARR_delta_feature_map 从pool层传递到feature_map的网络误差

步幅 : stride

速率μ : rate

*/

int backwordSpreadGradient(Array *ARR_inMat, Array *ARR_outMat_forword_Out, Array *ARR_filter, Array *ARR_bias, Array *ARR_datle, Array *ARR_delta_feature_map, int stride, double rate);

/* 函数说明:反向网络误差传播 误差从 fuetureMay 传递到 卷积输入层 input

函数是为多层卷积设计的,一层卷积时用不到这个函数,因为一层卷积

不涉及到featuremap层向input层传播误差δ

参数说明:

卷积输入矩阵:ARR_inMat (方法中暂时没用到)

向前计算输出: *ARR_outMat_forword_Out

样本标签: *lable

过滤层: *ARR_kernel

修正值: *ARR_bias

卷积输入矩阵误差值δ: *ARR_datle

pool反向传回δ:ARR_delta_feature_map (从pool层传递到feature_map的网络误差)

步幅 : stride

速率μ : rate

激活函数:char Activation

*/

int backwordSpreadGradient_(Array *ARR_inMat, Array *ARR_outMat_forword_Out, Array *ARR_filter, Array *ARR_bias, Array *ARR_datle, Array *ARR_delta_feature_map, int stride, double rate, char Activation);

/* 函数说明:单层卷积测试中的反向计算参数说明

参数说明:

向前计算输出: *ARR_outMat_forword_Out

样本标签: *lable

过滤层: *ARR_filter

修正值: *ARR_bias

误差值δ: *ARR_datle

步幅 : stride

速率μ : rate

*/

int backword_CS(Array *ARR_inMat, Array *ARR_outMat_forword_Out, Array *ARR_lable, Array *ARR_filter, Array *ARR_bias, Array *ARR_datle, int stride, double rate);

};

#endif CONV_H

3、Conv.cpp 向前卷积

这个图做的太好了,引用一下,如有冒犯我会删除

可以随便在网上找一个讲的差不多的卷积例子,然后对照代码看一下就能明白,后面的POOL 层、全连接层、softmax层 都能找到解释,然后根据自己的理解和代码进行比对,再跑代码试试,很快就能理解!

#include "stdafx.h"

#include "Conv.h"

#include

//cout<<"["<

DX += (ARR_filter->Mat3D[kk][kr][kc]) * (ARR_inMat->Mat3D[k][i + kr][j + kc]);

//cout<<"input:["<

js_count++;

}

}

//DX = tanh(DX + ARR_bias->Mat1D[kk]);

DX = Der.Relu_Fun(DX + ARR_bias->Mat1D[kk]);

ARR_outMat->Mat3D[kk][row][col] = DX;

}

//ARR_outMat->OutArr3D();

//====================================

if (ARR_inMat->column == (j + ARR_filter->column)){//当计算完当前行最后一个切片时退出

break;

}

col++;

}

if (ARR_inMat->row == (i + ARR_filter->row)){//当计算完最后一行切片时退出

break;

}

row++;

}

}

// ARR_outMat->OutArr3D();

return 1;

}

4、Pool.cpp 平均值法下采样

代码也适应不同的filtres,例如:3*3,一定要注意,Feature Map一定要是filtres 的整倍数

最大值的代码没写,有兴趣的可以自己添加

#include "stdafx.h"

#include 5、FULLCONNECTION.cpp 全连接代码

这个就不上图了,比较好理解

代码包括一个 forward_input 输入层函数,还有一个forward_hide隐藏层函数,如果只需要一个全连接可以直接用forward_input函数,因为代码包含四维转一维的处理,如果要添加多个隐藏层,可以直接在后面调用forward_hide函数。forward_hide函数可以直接做输出连接softmax层。

#include "stdafx.h"

#include "FULLCONNECTION.h"

#include "ARRAY.h"

#include "FILEOPR.h"

#include **6、SoftMax.cpp **

这个就是将输出转换成 概率

#include "stdafx.h"

#include

DX += Arr_SoftMax_input->Mat1D[j] * Arr_SoftMax_filter->Mat2D[i][j];

}

Arr_SoftMax_output->Mat1D[i] = exp(DX);

DX = 0.0;

}

//Arr_SoftMax_output->OutArr1D();

for (int i = 0; i<Arr_SoftMax_output->column; i++){//10

ZS += Arr_SoftMax_output->Mat1D[i];

}

for (int i = 0; i<Arr_SoftMax_output->column; i++){//10

Arr_SoftMax_output->Mat1D[i] = Arr_SoftMax_output->Mat1D[i] / ZS;

}

//Arr_SoftMax_output->OutArr1D();

}

**7、TEST.cpp 测试主程序 **

// CNN.cpp : 定义控制台应用程序的入口点。

// Author:njm

//

#include "stdafx.h"

#include 在文件中会看到“_cs”的函数,这是我最开始做的时候添加的,因为代码写的错误太多,理解原理的混沌期写出来的不敢想象,怎么改正确率都上不去,于是我就把每一层都拆开,添加梯度验证,最开始我在网上发过类似求助,如何验证代码正确性,但是没有得到答案。其实原理很简单,你的网络再深不也都是链式求导吗,所以一层一层验证没有问题,就算代码只有一个卷积,如果代码正确,也可以用loss函数画出漂亮的曲线,根据曲线对代码做大概的判断。用什么激活函数怎么求导一定要正确,这里还是要提醒一下,一定要自己用笔在纸上面推导一下,太有用了,要不然心里总是没底,至少我是这样。有兴趣的可以自己改一下试试。

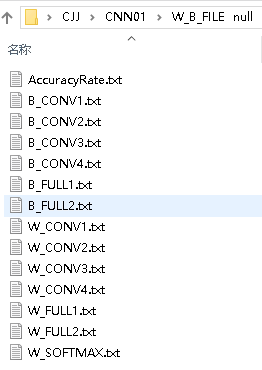

8、项目目录介绍

ARR_full_filet:里面是存放损失函数记录的损失值,可以用来生成曲线

W_B_FILE:存储每层的W B的最新参数,现在里面存放的参数正确率是99.33%

W_B_FILE null:这里面也是存储最新参数的txt文件,只是文件内容是空的,每次需要重新训练的时候可以直接把这个文件夹的复制到W_B_FILE里面,他里面的文件结构是这样的,看下图:

第一个存储的是正确率,后面的依次存储每一层的值,如果你想要的做个5层卷积,就需要添加两个空的txt文件。

1、B_CONV5.txt

2、W_CONV5.txt

全连接也是这样做,添加带FULL的文件,然后再修改一下写入代码就好了,下面是写入文件代码,很简单。

//正确率提升了需要更新 W B 和正确率

if ((dl_zp / dou_train_num) > zql){

cout << "开始更新 W B 参数" << endl;

ostringstream s_zql;

s_zql << (dl_zp / dou_train_num);

FL.write_cover("E:\\CJJ\\CNNOCR\\W_B_FILE\\B_CONV1.txt", ARR_bias.OutArr1DTXT());

FL.write_cover("E:\\CJJ\\CNNOCR\\W_B_FILE\\B_CONV2.txt", ARR_bias_two.OutArr1DTXT());

FL.write_cover("E:\\CJJ\\CNNOCR\\W_B_FILE\\B_CONV3.txt", ARR_bias_three.OutArr1DTXT());

//FL.write_cover("E:\\CJJ\\CNNOCR\\W_B_FILE\\B_CONV4.txt", ARR_bias_four.OutArr1DTXT());

FL.write_cover("E:\\CJJ\\CNNOCR\\W_B_FILE\\W_CONV1.txt", ARR_filet.OutArr4DTXT());

FL.write_cover("E:\\CJJ\\CNNOCR\\W_B_FILE\\W_CONV2.txt", ARR_filet_two.OutArr4DTXT());

FL.write_cover("E:\\CJJ\\CNNOCR\\W_B_FILE\\W_CONV3.txt", ARR_filet_three.OutArr4DTXT());

//FL.write_cover("E:\\CJJ\\CNNOCR\\W_B_FILE\\W_CONV4.txt", ARR_filet_four.OutArr4DTXT());

FL.write_cover("E:\\CJJ\\CNNOCR\\W_B_FILE\\B_FULL1.txt", ARR_full_bias.OutArr1DTXT());

FL.write_cover("E:\\CJJ\\CNNOCR\\W_B_FILE\\B_FULL2.txt", ARR_full_bias_hide.OutArr1DTXT());

FL.write_cover("E:\\CJJ\\CNNOCR\\W_B_FILE\\W_FULL1.txt", ARR_full_filet.OutArr2DTXT());

FL.write_cover("E:\\CJJ\\CNNOCR\\W_B_FILE\\W_FULL2.txt", ARR_full_filet_hide.OutArr2DTXT());

FL.write_cover("E:\\CJJ\\CNNOCR\\W_B_FILE\\W_SOFTMAX.txt", Arr_SoftMax_filter.OutArr2DTXT());

FL.write_cover("E:\\CJJ\\CNNOCR\\W_B_FILE\\AccuracyRate.txt", s_zql.str() + " ");

cout << " W B 参数更新结束!" << endl;

}

CS里面是存储的是

CS1存储的是

dataset存储的是中文训练和测试数据集,因为3755个字的数据集好几个G太大了,所以我只上传了前200个字,每个字的1586个模板尺寸是50*50,训练1268个,测试318个。

MNISTMAGE 、MNISTMAGECS这两个就不说了,都懂得。

TEST.CPP这个是测试主文件,LeNet.cpp是训练主文件,Derivative.CPP是求导用的,FILEOPR.cpp文件操作 ,SPLIT.cpp负责txt文件与程序中数组的相互转换。

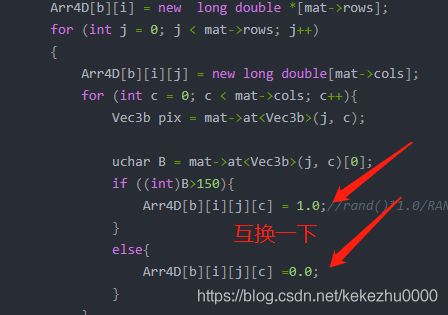

注意

因为mnist图片是黑背景,所以在测试白背景的时候要修改一下ARRAY.CPP文件中代码,如果想要训练白背景数据集,也要对这儿的代码进行修改。代码中的路径是绝对路径,所以解压后要放到E盘,直接VS打开就能运行

Array::Array(Mat *mat,int block, int Depth, int ROW_NUM, int COL_NUMC, long double ****Arr4D, char init){

//Array::TEMPPOINTER_4D = Array::Mat4D;

Array::block = block;

Array::depth = Depth;

Array::row = ROW_NUM;

Array::column = COL_NUMC;

for (int b = 0; b < block; b++)

{

Arr4D[b] = new long double **[Depth];

for (int i = 0; i < Depth; i++)

{

Arr4D[b][i] = new long double *[mat->rows];

for (int j = 0; j < mat->rows; j++)

{

Arr4D[b][i][j] = new long double[mat->cols];

for (int c = 0; c < mat->cols; c++){

Vec3b pix = mat->at<Vec3b>(j, c);

uchar B = mat->at<Vec3b>(j, c)[0];

if ((int)B>150){

Arr4D[b][i][j][c] = 1.0;//rand()*1.0/RAND_MAX;//2.0 * rand() / RAND_MAX - 1.0;

}

else{

Arr4D[b][i][j][c] =0.0;

}

}

}

}

}

Array::Mat4D = Arr4D;

}

源代码和数据集连接:

链接:https://pan.baidu.com/s/1YAQoNNbBRItWbbsURi7tEA

提取码:200Y

**在这里插入图片描述