1.Pytorch框架下使用yolov3-tiny网络模型 训练自己的数据集

在Pytorch框架下使用yolov3-tiny网络模型 ,训练自己的数据集

1.本文参考链接如下:

https://blog.csdn.net/gbz3300255/article/details/106094880

https://blog.csdn.net/sinat_27634939/article/details/89884011

2.项目地址

本文所用到的项目代码:

https://github.com/ultralytics/yolov3/releases

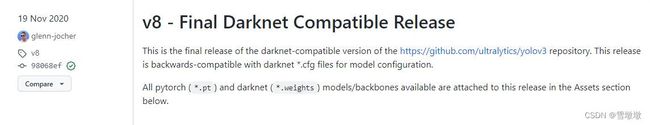

点击https://github.com/ultralytics/yolov3/releases,这里我们需要v8-Final Darknet Compatible Release下的Assets中的Source.code(zip)和yolov3-tiny.weights。

注意点:

(1)这里用到的代码不是该链接(https://github.com/ultralytics/yolov3)下的项目,因为我们需要用到cfg/yolov3-tiny3.cfg,而最新的项目里已经没有该文件了,所以我们需要使用旧版项目。

3.训练步骤

(1)准备数据集

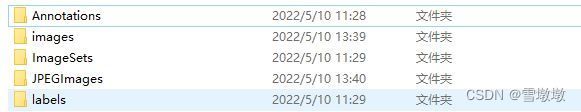

在data文件下新建5个文件夹,分别是Annotations、images、ImageSets、JPEGImages、labels

在Annotations存放的是xml文件,标注工具在这里使用的是“精灵标注助手”。图片可以是jpg格式或者bmp格式(其他格式还没有试过)

images和JPEGImages放的是训练图片。

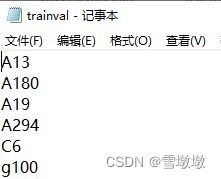

(2)在根目录下新建makeTxt.py,该代码的目的是划分训练集、验证集、测试集的比例,可根据自己的情况进行修改比例,运行后会在ImageSets文件夹下生成test、train、trainval和val四个文档。

文档中放的是文件名,如下图所示:

makeTxt.py中的代码如下:

import os

import random

trainval_percent = 0.1

train_percent = 0.9

xmlfilepath = 'data/Annotations'

txtsavepath = 'data/ImageSets'

total_xml = os.listdir(xmlfilepath)

num = len(total_xml)

list = range(num)

tv = int(num * trainval_percent)

tr = int(tv * train_percent)

trainval = random.sample(list, tv)

train = random.sample(trainval, tr)

ftrainval = open('data/ImageSets/trainval.txt', 'w')

ftest = open('data/ImageSets/test.txt', 'w')

ftrain = open('data/ImageSets/train.txt', 'w')

fval = open('data/ImageSets/val.txt', 'w')

for i in list:

name = total_xml[i][:-4] + '\n'

if i in trainval:

ftrainval.write(name)

if i in train:

ftest.write(name)

else:

fval.write(name)

else:

ftrain.write(name)

ftrainval.close()

ftrain.close()

fval.close()

ftest.close()

(3)在根目录下新建voc_label.py,该代码作用是将xmL文件转换成yolov数据集格式以及在data目录下生成test、train、val文档。文档中内容类似下图:

注意点:如果是jpg图片,那么就将代码中的“bmp”转换为“jpg”,classes注意修改一下,在这里我多解释几句:classes中的内容和xml标注文档中的类别是一样的,xml中的内容如下图所示:

classes = [“chongqiebuliang”, “yashang”, “zangwu”, “bianxing”, “mozhou”, “qipao”]

运行之后0就代表"chongqiebuliang"、1代表"yashang"、2代表"zangwu"、3代表"bianxing"、4代表"mozhou"、5代表"qipao"

代码如下:

import xml.etree.ElementTree as ET

import pickle

import os

from os import listdir, getcwd

from os.path import join

sets = ['train', 'test', 'val']

classes = ["chongqiebuliang", "yashang", "zangwu", "bianxing", "mozhou", "qipao"]

def convert(size, box):

dw = 1. / size[0]

dh = 1. / size[1]

x = (box[0] + box[1]) / 2.0

y = (box[2] + box[3]) / 2.0

w = box[1] - box[0]

h = box[3] - box[2]

x = x * dw

w = w * dw

y = y * dh

h = h * dh

return (x, y, w, h)

def convert_annotation(image_id):

in_file = open('data/Annotations/%s.xml' % (image_id))

out_file = open('data/labels/%s.txt' % (image_id), 'w')

tree = ET.parse(in_file)

root = tree.getroot()

size = root.find('size')

w = int(size.find('width').text)

h = int(size.find('height').text)

for obj in root.iter('object'):

difficult = obj.find('difficult').text

cls = obj.find('name').text

if cls not in classes or int(difficult) == 1:

continue

cls_id = classes.index(cls)

xmlbox = obj.find('bndbox')

b = (float(xmlbox.find('xmin').text), float(xmlbox.find('xmax').text), float(xmlbox.find('ymin').text),

float(xmlbox.find('ymax').text))

bb = convert((w, h), b)

out_file.write(str(cls_id) + " " + " ".join([str(a) for a in bb]) + '\n')

wd = getcwd()

print(wd)

for image_set in sets:

if not os.path.exists('data/labels/'):

os.makedirs('data/labels/')

image_ids = open('data/ImageSets/%s.txt' % (image_set)).read().strip().split()

list_file = open('data/%s.txt' % (image_set), 'w')

for image_id in image_ids:

list_file.write('data/images/%s.bmp\n' % (image_id))

convert_annotation(image_id)

list_file.close()

(4)配置文件

在data目录下新建rbc.data和rbc.names两个文件:

rbc.data中的内容如下:

classes=6

train=data/train.txt

valid=data/test.txt

names=data/rbc.names

backup=backup/

eval=coco

rbc.names中的内容如下:

chongqiebuliang

yashang

zangwu

bianxing

mozhou

qipao

(5)修改cfg/yolov3-tiny.cfg中的内容:

classes我划分了6类,filters=3*(n+5),(n代表分为几类),所以filters=33。ctrl+f搜索80将yolov3-tiny.cfg中的80改为6,接着搜索255(3*(80+5)=255)将255改为33,保存退出

(6)准备权重文件:

在根目录下新建weights文件夹(E:\Pytorch\Github\yolov3\yolov3-8\yolov3-8\weights),在这里面放置两个文件:

yolov3-tiny-conv.15和yolov3-tiny.weights文件。这两个文件我放在百度网盘中,大家自行提取

链接:https://pan.baidu.com/s/1wY_zo6matB_wsr9YHnF–w

提取码:8kzw

(7)运行train文件:

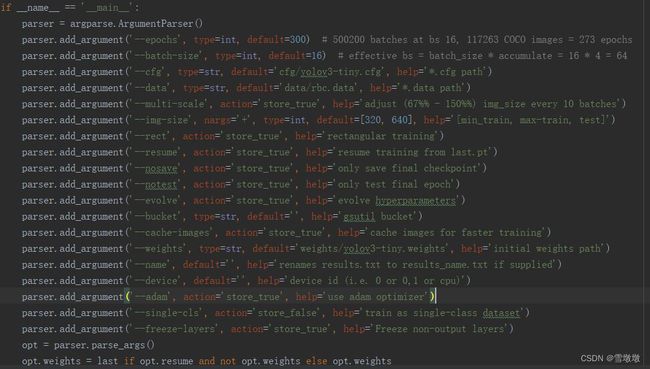

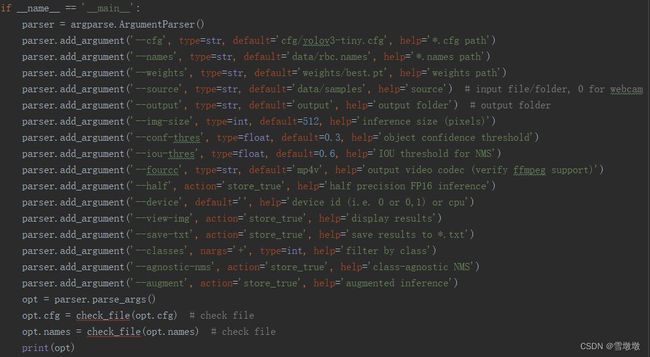

修改代码“if name == ‘main’:”下的部分代码:

比如cfg文件、data文件、权重文件以及“ parser.add_argument(‘–single-cls’, action=‘store_false’, help=‘train as single-class dataset’)”(这句代码默认训练单类别,我训练多个类别,因此将store_true改为store_false),

可以根据我给的截图进行修改:

运行后在weights文件夹中生成last.pt和best.pt。

(8)测试训练效果

将图片放在data/samples文件夹下,然后运行detect.py,需要修改的地方和train.py差不多,在这里附上截图,大家自行参考:

运行后会在根目录output文件夹中输出检测结果。

(9)将训练好的yolov3-ting权重导出成onnx模型

打开models.py,将ONNX_EXPORT =False中的False改为True,

ONNX_EXPORT = True

然后运行detect.py,会在weights文件下生成best.onnx。(因为我是用训练好的best.pt)

4.可能遇到的问题点:

(1)运行voc_label.py程序报错:

difficult = obj.find(‘difficult’).text AttributeError: ‘NoneType’ object has no …

可能原因:你的xml文件中没有“difficult,或者是你的xml文件中的是大写的“Difficult”

如果是上述第一个错误,那可以试试我推荐的标注软件进行重新标注。

(2)1.TypeError: can’t convert cuda:0 device type tensor to numpy. Use Tensor.cpu() to copy the tensor to host memory first.

解决方法参考如下链接:

https://blog.csdn.net/SpadgerZ/article/details/115584829

我是在下面这个路径中修改报错代码的。

C:\Users\user1\python_soft\anaconda\envs\pytorch\Lib\site-packages\torch