Auto-sklearn 安装及用于分子性质预测

简介

Auto-sklearn 是一个自动化机器学习工具包,是 scikit-learn 直接替代品,是建立在sklearn进一步封装的基础上。Auto-sklearn不需要用户进行超参数的调节和模型的选择,而是自动进行。它利用了最近在贝叶斯优化、元学习和集成构建方面的优势。

安装

当然要先安装好sklearn,再安装auto-sklearn

pip install smac #贝叶斯优化核心库

pip install sklearn -U

pip install auto-sklearn

由于网速的原因,加上auto-sklearn可能有很多的依赖包,所以可能无法安装成功,那么需要源码安装。

首先下载auto-sklearn的安装包

wget https://files.pythonhosted.org/packages/2b/04/a3e58aeba5320fc9d8859cde68390636f24189499b88daa797821a1320e2/auto-sklearn-0.14.6.tar.gz

解压:

tar -xvf auto-sklearn-0.14.6.tar.gz

cd auto-sklearn-0.14.6

随后:

python setup.py make

python setup.py install

如果遇上没有的包需要单独安装,另外,auto-sklearn对sklearn的要求是大于0.24.0但是小于0.25.0。

用于分子性质预测

auto-sklearn的使用方法算是超级简单,直接命令行的傻瓜式。

这里还是使用上次的数据集《机器学习模型的超参数优化用于分子性质预测》。

导入包:

import numpy as np

import pandas as pd

from sklearn.model_selection import train_test_split

from sklearn.metrics import mean_squared_error

from sklearn.metrics import r2_score

from sklearn.metrics import mean_absolute_error

import autosklearn.regression

import autosklearn.metrics

import matplotlib.pyplot as plt

import seaborn as sns

导入数据:

data = pd.read_csv('Test.csv',index_col=0)

data

X = data.iloc[:,:-1] #特征

y = data.loc[:,'MM'] #预测值

X_train, X_test, y_train, y_test = train_test_split(

X, y, test_size=0.25, random_state=96

)

创建auto-sklearn评估器并训练:

estimator_askl = autosklearn.regression.AutoSklearnRegressor(

time_left_for_this_task=1800,

seed=42,

resampling_strategy='cv',

resampling_strategy_arguments={'folds': 3},

n_jobs=-1,

metric=autosklearn.metrics.r2,

)

estimator_askl.fit(X_train, y_train)

这里对autosklearn.regression.AutoSklearnRegressor的参数进行解释:

AutoSklearnRegressor:专门进行回归任务;

time_left_for_this_task:搜索合适模型的时间限制(以秒为单位)。 通过增加这个值,auto-sklearn 有更高的机会找到更好的模型;

resampling_strategy:如何处理过拟合,这里使用交叉验证,即cv的方法;

resampling_strategy_arguments:处理过拟合方法的参数,这里是5重交叉验证;

查看训练集上的表现:

y_train_pred = estimator_askl.predict(X_train)

#计算R2,RMSE,MAE,训练集

rmse = np.sqrt(mean_squared_error(y_train, y_train_pred))

r2 = r2_score(y_train, y_train_pred)

mae = mean_absolute_error(y_train, y_train_pred)

print('训练集 MAE:{:.3f}, RMSE:{:.3}, R2:{:.3}'.format(mae, rmse, r2))

输出:训练集 MAE:0.624, RMSE:0.787, R2:0.644

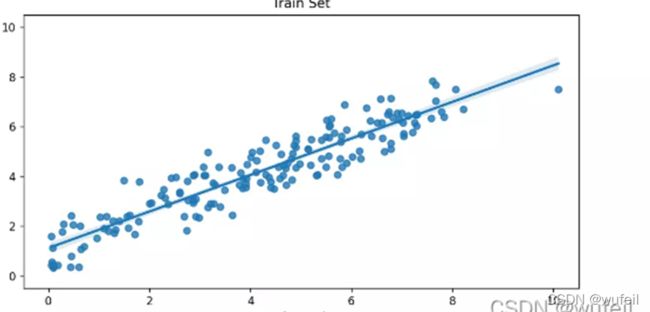

拟合曲线:

%matplotlib notebook

y_train_pred = estimator_askl.predict(X_train)

sns.regplot(y_train, y_train_pred)

plt.xlim(-0.5,10.5)

plt.ylim(-0.5,10.5)

plt.title('Train Set')

查看测试集上的表现:

y_test_pred = estimator_askl.predict(X_test)

#计算R2,RMSE,MAE,测试集

rmse = np.sqrt(mean_squared_error(y_test, y_test_pred))

r2 = r2_score(y_test, y_test_pred)

mae = mean_absolute_error(y_test, y_test_pred)

print('测试集 MAE:{:.3f}, RMSE:{:.3}, R2:{:.3}'.format(mae, rmse, r2))

```bash

输出:测试集 MAE:0.961, RMSE:1.07, R2:0.763

作图:

%matplotlib notebook

sns.regplot(y_test, y_test_pred)

plt.xlim(-0.5,10.5)

plt.ylim(-0.5,10.5)

plt.title('Test Set')

在这里插入图片描述

从结果来看,上次使用GradientBoostingRegressor模型结合超参数的网格搜索,其R2为0.62, 这次的auto-sklearn则展现出了R2为0.66,说明auto-sklearn是一个非常好用的机器学习工具。