Python深度学习篇

Python深度学习篇一《什么是深度学习》

Excerpt

在过去的几年里,人工智能(AI)一直是媒体大肆炒作的热点话题。机器学习、深度学习 和人工智能都出现在不计其数的文章中,而这些文章通常都发表于非技术出版物。我们的未来被描绘成拥有智能聊天机器人、自动驾驶汽车和虚拟助手,这一未来有时被渲染成可 …

在过去的几年里,人工智能(AI)一直是媒体大肆炒作的热点话题。机器学习、深度学习 和人工智能都出现在不计其数的文章中,而这些文章通常都发表于非技术出版物。我们的未来被描绘成拥有智能聊天机器人、自动驾驶汽车和虚拟助手,这一未来有时被渲染成可怕的景象, 有时则被描绘为乌托邦,人类的工作将十分稀少,大部分经济活动都由机器人或人工智能体 (AI agent)来完成。对于未来或当前的机器学习从业者来说,重要的是能够从噪声中识别出信号, 从而在过度炒作的新闻稿中发现改变世界的重大进展。我们的未来充满风险,而你可以在其中发挥积极的作用:读完本书后,你将会成为人工智能体的开发者之一。那么我们首先来回答下列问题:到目前为止,深度学习已经取得了哪些进展?深度学习有多重要?接下来我们要做什么?媒体炒作是否可信? 本章将介绍关于人工智能、机器学习以及深度学习的必要背景。

1.1 人工智能、机器学习与深度学习

首先,在提到人工智能时,我们需要明确定义所讨论的内容。什么是人工智能、机器学习 与深度学习(见图 1-1)?这三者之间有什么关系

图 1-1 人工智能、机器学习与深度学习

1.1.1 人工智能

人工智能诞生于20 世纪 50 年代,当时计算机科学这一新兴领域的少数先驱开始提出疑问: 计算机是否能够“思考”?我们今天仍在探索这一问题的答案。人工智能的简洁定义如下:努力将通常由人类完成的智力任务自动化。因此,人工智能是一个综合性的领域,不仅包括机器学习与深度学习,还包括更多不涉及学习的方法。例如,早期的国际象棋程序仅包含程序员精心编写的硬编码规则,并不属于机器学习。在相当长的时间内,许多专家相信,只要程序员精心编写足够多的明确规则来处理知识,就可以实现与人类水平相当的人工智能。这一方法被称 为符号主义人工智能(symbolic AI),从 20 世纪50 年代到80 年代末是人工智能的主流范式。 在 20 世纪 80 年代的专家系统(expert system)热潮中,这一方法的热度达到了顶峰。

虽然符号主义人工智能适合用来解决定义明确的逻辑问题,比如下国际象棋,但它难以给出明确的规则来解决更加复杂、模糊的问题,比如图像分类、语音识别和语言翻译。于是出现了一种新的方法来替代符号主义人工智能,这就是机器学习(machine learning)。

1.1.2 机器学习

在维多利亚时代的英格兰,埃达 • 洛夫莱斯伯爵夫人是查尔斯 • 巴贝奇的好友兼合作者,后者发明了分析机(Analytical Engine),即第一台通用的机械式计算机。虽然分析机这一想法富有远见,并且相当超前,但它在19 世纪三四十年代被设计出来时并没有打算用作通用计算机, 因为当时还没有“通用计算”这一概念。它的用途仅仅是利用机械操作将数学分析领域的某些计算自动化,因此得名“分析机”。1843 年,埃达 • 洛夫莱斯伯爵夫人对这项发明评论道:“分析机谈不上能创造什么东西。它只能完成我们命令它做的任何事情……它的职责是帮助我们去实现我们已知的事情。”

随后,人工智能先驱阿兰 • 图灵在其1950 年发表的具有里程碑意义的论文“计算机器和智能”中,引用了上述评论并将其称为“洛夫莱斯伯爵夫人的异议”。图灵在这篇论文中介绍了图 灵测试以及日后人工智能所包含的重要概念。在引述埃达 • 洛夫莱斯伯爵夫人的同时,图灵还思考了这样一个问题:通用计算机是否能够学习与创新?他得出的结论是“能”。

机器学习的概念就来自于图灵的这个问题:对于计算机而言,除了“我们命令它做的任何事情”之外,它能否自我学习执行特定任务的方法?计算机能否让我们大吃一惊?如果没有程序员精心编写的数据处理规则,计算机能否通过观察数据自动学会这些规则?

图灵的这个问题引出了一种新的编程范式。在经典的程序设计(即符号主义人工智能的范 式)中,人们输入的是规则(即程序)和需要根据这些规则进行处理的数据,系统输出的是答案 (见图 1-2)。利用机器学习,人们输入的是数据和从这些数据中预期得到的答案,系统输出的是规则。这些规则随后可应用于新的数据,并使计算机自主生成答案。

图 1-2 机器学习:一种新的编程范式

机器学习系统是训练出来的,而不是明确地用程序编写出来的。将与某个任务相关的许多示例输入机器学习系统,它会在这些示例中找到统计结构,从而最终找到规则将任务自动化。 举个例子,你想为度假照片添加标签,并且希望将这项任务自动化,那么你可以将许多人工 好标签的照片输入机器学习系统,系统将学会将照片与特定标签联系在一起的统计规则。

虽然机器学习在20 世纪90 年代才开始蓬勃发展,但它迅速成为人工智能最受欢迎且最成 功的分支领域。这一发展的驱动力来自于速度更快的硬件与更大的数据集。机器学习与数理统计密切相关,但二者在几个重要方面有所不同。不同于统计学,机器学习经常用于处理复杂的大型数据集(比如包含数百万张图像的数据集,每张图像又包含数万个像素),用经典的统计分 析(比如贝叶斯分析)来处理这种数据集是不切实际的。因此,机器学习(尤其是深度学习) 呈现出相对较少的数学理论(可能太少了),并且是以工程为导向的。这是一门需要上手实践的 学科,想法更多地是靠实践来证明,而不是靠理论推导。

1.1.3 从数据中学习表示

为了给出深度学习的定义并搞清楚深度学习与其他机器学习方法的区别,我们首先需要知道机器学习算法在做什么。前面说过,给定包含预期结果的示例,机器学习将会发现执行一项数据处理任务的规则。因此,我们需要以下三个要素来进行机器学习。

- **输入数据点。**例如,你的任务是语音识别,那么这些数据点可能是记录人们说话的声音 文件。如果你的任务是为图像添加标签,那么这些数据点可能是图像。

- **预期输出的示例。**对于语音识别任务来说,这些示例可能是人们根据声音文件整理生成 的文本。对于图像标记任务来说,预期输出可能是“狗”“猫”之类的标签。

- **衡量算法效果好坏的方法。**这一衡量方法是为了计算算法的当前输出与预期输出的差距。 衡量结果是一种反馈信号,用于调节算法的工作方式。这个调节步骤就是我们所说的学习。

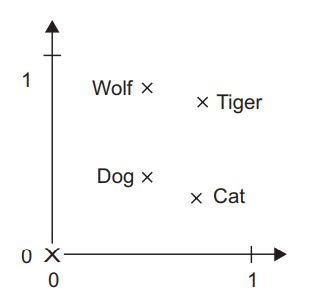

机器学习模型将输入数据变换为有意义的输出,这是一个从已知的输入和输出示例中进行 “学习”的过程。因此,机器学习和深度学习的核心问题在于有意义地变换数据,换句话说,在于学习输入数据的有用表示(representation)——这种表示可以让数据更接近预期输出。在进一步讨论之前,我们需要先回答一个问题:什么是表示?这一概念的核心在于以一种不同的方式来查看数据(即表征数据或将数据编码)。例如,彩色图像可以编码为RGB(红- 绿 - 蓝)格式或 HSV(色相 - 饱和度 - 明度)格式,这是对相同数据的两种不同表示。在处理某些任务时,使用某种表示可能会很困难,但换用另一种表示就会变得很简单。举个例子,对于“选择图像中所有红色像素”这个任务,使用 RGB 格式会更简单,而对于“降 低图像饱和度”这个任务,使用 HSV 格式则更简单。机器学习模型都是为输入数据寻找合适的表示——对数据进行变换,使其更适合手头的任务(比如分类任务)。

我们来具体说明这一点。考虑x 轴、y 轴和在这个(x, y) 坐标系 中由坐标表示的一些点,如图 1-3 所示。

图 1-3 一些样本数据

可以看到,图中有一些白点和一些黑点。假设我们想要开发一个算法,输入一个点的坐标(x, y),就能够判断这个点是黑色还是白 色。在这个例子中:

- 输入是点的坐标;

- 预期输出是点的颜色;

- 衡量算法效果好坏的一种方法是,正确分类的点所占的百分比。

这里我们需要的是一种新的数据表示,可以明确区分白点与黑点。可用的方法有很多,这 里用的是坐标变换,如图 1-4 所示。

图 1-4 坐标变换

在这个新的坐标系中,点的坐标可以看作数据的一种新的表示。这种表示很棒!利用这种新的表示,用一条简单的规则就可以描述黑 / 白分类问题:“x>0 的是黑点”或“x<0 的是白点”。 这种新的表示基本上解决了该分类问题。

在这个例子中,我们人为定义了坐标变换。但是,如果我们尝试系统性地搜索各种可能的坐标变换,并用正确分类的点所占百分比作为反馈信号,那么我们做的就是机器学习。机器学习中的学习指的是,寻找更好数据表示的自动搜索过程。

所有机器学习算法都包括自动寻找这样一种变换:这种变换可以根据任务将数据转化为更加有用的表示。这些操作可能是前面提到的坐标变换,也可能是线性投影(可能会破坏信息)、平移、 非线性操作(比如“选择所有x>0 的点”),等等。机器学习算法在寻找这些变换时通常没有什么创造性,而仅仅是遍历一组预先定义好的操作,这组操作叫作假设空间(hypothesis space)。

这就是机器学习的技术定义:**在预先定义好的可能性空间中,利用反馈信号的指引来寻找输入数据的有用表示。**这个简单的想法可以解决相当多的智能任务,从语音识别到自动驾驶都能解决。

现在你理解了学习的含义,下面我们来看一下深度学习的特殊之处。

1.1.4 深度学习之“深度”

深度学习是机器学习的一个分支领域:它是从数据中学习表示的一种新方法,强调从连续 的层(layer)中进行学习,这些层对应于越来越有意义的表示。“深度学习”中的“深度”指的并不是利用这种方法所获取的更深层次的理解,而是指一系列连续的表示层。数据模型中包含多少层,这被称为模型的深度(depth)。这一领域的其他名称包括分层表示学习(layered representations learning)和层级表示学习(hierarchical representations learning)。现代深度学习通常包含数十个甚至上百个连续的表示层,这些表示层全都是从训练数据中自动学习的。与此相反,其他机器学习方法的重点往往是仅仅学习一两层的数据表示,因此有时也被称为浅层学习(shallow learning)。

在深度学习中,这些分层表示几乎总是通过叫作神经网络(neural network)的模型来学习得到的。神经网络的结构是逐层堆叠。神经网络这一术语来自于神经生物学,然而,虽然深度学习的一些核心概念是从人们对大脑的理解中汲取部分灵感而形成的,但深度学习模型不是大脑模型。没有证据表明大脑的学习机制与现代深度学习模型所使用的相同。你可能会读到一些流行科学的文章,宣称深度学习的工作原理与大脑相似或者是根据大脑的工作原理进行建模的, 但事实并非如此。对于这一领域的新人来说,如果认为深度学习与神经生物学存在任何关系, 那将使人困惑,只会起到反作用。你无须那种“就像我们的头脑一样”的神秘包装,**最好也忘掉读过的深度学习与生物学之间的假想联系。**就我们的目的而言,深度学习是从数据中学习表示的一种数学框架。

深度学习算法学到的表示是什么样的?我们来看一个多层网络(见图 1-5)如何对数字图像进行变换,以便识别图像中所包含的数字。

图 1-5 用于数字分类的深度神经网络

如图1-6 所示,这个网络将数字图像转换成与原始图像差别越来越大的表示,而其中关于 最终结果的信息却越来越丰富。你可以将深度网络看作多级信息蒸馏操作:信息穿过连续的过滤器,其纯度越来越高(即对任务的帮助越来越大)。

这就是深度学习的技术定义:**学习数据表示的多级方法。**这个想法很简单,但事实证明, 非常简单的机制如果具有足够大的规模,将会产生魔法般的效果。

图 1-6 数字图像分类模型学到的深度表示

1.1.5 用三张图理解深度学习的工作原理

现在你已经知道,机器学习是将输入(比如图像)映射到目标(比如标签“猫”),这一过程是通过观察许多输入和目标的示例来完成的。你还知道,深度神经网络通过一系列简单的数据变换(层)来实现这种输入到目标的映射,而这些数据变换都是通过观察示例学习到的。下面来具体看一下这种学习过程是如何发生的。

神经网络中每层对输入数据所做的具体操作保存在该层的权重(weight)中,其本质是一串数字。用术语来说,每层实现的变换由其权重来参数化(parameterize,见图1-7)。权重有时也被称为该层的参数(parameter)。在这种语境下,学习的意思是为神经网络的所有层找到一组权重值,使得该网络能够将每个示例输入与其目标正确地一一对应。但重点来了:一个深度神经网络可能包含数千万个参数。找到所有参数的正确取值可能是一项非常艰巨的任务,特别是考虑到修改某个参数值将会影响其他所有参数的行为。

图 1-7 神经网络是由其权重来参数化

想要控制一件事物,首先需要能够观察它。想要控制神经网络的输出,**就需要能够衡量该输出与预期值之间的距离。**这是神经网络损失函数(loss function)的任务,该函数也叫目标函数(objective function)。损失函数的输入是网络预测值与真实目标值(即你希望网络输出的结果),然后计算一个距离值,衡量该网络在这个示例上的效果好坏(见图 1-8)。

图 1-8 损失函数用来衡量网络输出结果的质量

深度学习的基本技巧是利用这个距离值作为反馈信号来对权重值进行微调,以降低当前示例对应的损失值(见图1-9)。这种调节由优化器(optimizer)来完成,它实现了所谓的反向传播(backpropagation)算法,这是深度学习的核心算法。下一章中会详细地解释反向传播的工作原理。

一开始对神经网络的权重随机赋值,因此网络只是实现了一系列随机变换。其输出结果自然也和理想值相去甚远,相应地,损失值也很高。但随着网络处理的示例越来越多,权重值也在向正确的方向逐步微调,损失值也逐渐降低。这就是训练循环(training loop),将这种循环重复足够多的次数(通常对数千个示例进行数十次迭代),得到的权重值可以使损失函数最小。具有最小损失的网络,其输出值与目标值尽可能地接近,这就是训练好的网络。再次强调,这是一个简单的机制,一旦具有足够大的规模,将会产生魔法般的效果。

1.1.6 深度学习已经取得的进展

虽然深度学习是机器学习一个相当有年头的分支领域,但在21 世纪前十年才崛起。在随后 的几年里,它在实践中取得了革命性进展,在视觉和听觉等感知问题上取得了令人瞩目的成果,而这些问题所涉及的技术,在人类看来是非常自然、非常直观的,但长期以来却一直是机器难以解决的。

特别要强调的是,深度学习已经取得了以下突破,它们都是机器学习历史上非常困难的领域:

- 接近人类水平的图像分类

- 接近人类水平的语音识别

- 接近人类水平的手写文字转录

- 更好的机器翻译

- 更好的文本到语音转换

- 数字助理,比如谷歌即时(Google Now)和亚马逊 Alexa

- 接近人类水平的自动驾驶

- 更好的广告定向投放,Google、百度、必应都在使用

- 更好的网络搜索结果

- 能够回答用自然语言提出的问题

- 在围棋上战胜人类

我们仍然在探索深度学习能力的边界。我们已经开始将其应用于机器感知和自然语言理解 之外的各种问题,比如形式推理。如果能够成功的话,这可能预示着深度学习将能够协助人类进行科学研究、软件开发等活动。

1.1.7 不要相信短期炒作

虽然深度学习近年来取得了令人瞩目的成就,但人们对这一领域在未来十年间能够取得的成就似乎期望过高。虽然一些改变世界的应用(比如自动驾驶汽车)已经触手可及,但更多的应用可能在长时间内仍然难以实现,比如可信的对话系统、达到人类水平的跨任意语言的机器翻译、达到人类水平的自然语言理解。我们尤其不应该把达到人类水平的通用智能(human-level general intelligence)的讨论太当回事。在短期内期望过高的风险是,一旦技术上没有实现,那么研究投资将会停止,而这会导致在很长一段时间内进展缓慢。

这种事曾经发生过。人们曾对人工智能极度乐观,随后是失望与怀疑,进而导致资金匮乏。 这种循环发生过两次,最早始于20 世纪60 年代的符号主义人工智能。在早期的那些年里,人们激动地预测着人工智能的未来。马文 • 闵斯基是符号主义人工智能方法最有名的先驱和支持者之一,他在 1967 年宣称:“在一代人的时间内……将基本解决创造‘人工智能’的问题。”三 年后的1970 年,他做出了更为精确的定量预测:“在三到八年的时间里,我们将拥有一台具有人类平均智能的机器。”在2016 年,这一目标看起来仍然十分遥远,遥远到我们无法预测需要 多长时间才能实现。但在 20 世纪 60 年代和 70 年代初,一些专家却相信这一目标近在咫尺(正 如今天许多人所认为的那样)。几年之后,由于这些过高的期望未能实现,研究人员和政府资金 均转向其他领域,这标志着第一次人工智能冬天(AI winter)的开始(这一说法来自“核冬天”, 因为当时是冷战高峰之后不久)。

这并不是人工智能的最后一个冬天。20 世纪80 年代,一种新的符号主义人工智能——专家系统(expert system)——开始在大公司中受到追捧。最初的几个成功案例引发了一轮投资热潮,进而全球企业都开始设立人工智能部门来开发专家系统。1985 年前后,各家公司每年在这项技术上的花费超过 10 亿美元。但到了 20 世纪 90 年代初,这些系统的维护费用变得很高,难以扩展,并且应用范围有限,人们逐渐对其失去兴趣。于是开始了第二次人工智能冬天。

我们可能正在见证人工智能炒作与让人失望的第三次循环,而且我们仍处于极度乐观的阶 段。最好的做法是降低我们的短期期望,确保对这一技术领域不太了解的人能够清楚地知道深度学习能做什么、不能做什么。

1.1.8 人工智能的未来

虽然我们对人工智能的短期期望可能不切实际,但长远来看前景是光明的。我们才刚刚开 始将深度学习应用于许多重要的问题,从医疗诊断到数字助手,在这些问题上深度学习都发挥 了变革性作用。过去五年里,人工智能研究一直在以惊人的速度发展,这在很大程度上是由于人工智能短短的历史中前所未见的资金投入,但到目前为止,这些进展却很少能够转化为改变 世界的产品和流程。深度学习的大多数研究成果尚未得到应用,至少尚未应用到它在各行各业 中能够解决的所有问题上。你的医生和会计师都还没有使用人工智能。你在日常生活中可能也 不会用到人工智能。当然,你可以向智能手机提出简单的问题并得到合理的回答,也可以在亚 马逊网站上得到相当有用的产品推荐,还可以在谷歌相册(Google Photos)网站搜索“生日” 并立刻找到上个月你女儿生日聚会的照片。与过去相比,这些技术已大不相同,但这些工具仍然只是日常生活的陪衬。人工智能仍需进一步转变为我们工作、思考和生活的核心。

眼下,我们似乎很难相信人工智能会对世界产生巨大影响,因为它还没有被广泛地部署应用——正如1995 年,我们也难以相信互联网在未来会产生的影响。当时,大多数人都没有认识到互联网与他们的关系,以及互联网将如何改变他们的生活。今天的深度学习和人工智能也是如此。但不要怀疑:人工智能即将到来。在不远的未来,人工智能将会成为你的助手,甚至成为你的朋友。它会回答你的问题,帮助你教育孩子,并关注你的健康。它还会将生活用品送到你家门口,并开车将你从A地送到B地。它还会是你与日益复杂的、信息密集的世界之间的接口。 更为重要的是,人工智能将会帮助科学家在所有科学领域(从基因学到数学)取得突破性进展, 从而帮助人类整体向前发展。

在这个过程中,我们可能会经历一些挫折,也可能会遇到新的人工智能冬天,正如互联网行业那样,在 1998—1999 年被过度炒作,进而在 21 世纪初遭遇破产,并导致投资停止。但我们最终会实现上述目标。人工智能最终将应用到我们社会和日常生活的几乎所有方面,正如今天的互联网一样。

不要相信短期的炒作,但一定要相信长期的愿景。人工智能可能需要一段时间才能充分发挥其潜力。这一潜力的范围大到难以想象,但人工智能终将到来,它将以一种奇妙的方式改变我们的世界。

1.2 深度学习之前:机器学习简史

深度学习已经得到了人工智能历史上前所未有的公众关注度和产业投资,但这并不是机器学习的第一次成功。可以这样说,当前工业界所使用的绝大部分机器学习算法都不是深度学习算法。深度学习不一定总是解决问题的正确工具:有时没有足够的数据,深度学习不适用;有时用其他算法可以更好地解决问题。如果你第一次接触的机器学习就是深度学习,那你可能会发现手中握着一把深度学习“锤子”,而所有机器学习问题看起来都像是“钉子”。为了避免陷入这个误区,唯一的方法就是熟悉其他机器学习方法并在适当的时候进行实践。

关于经典机器学习方法的详细讨论已经超出了本书范围,但我们将简要回顾这些方法,并介绍这些方法的历史背景。这样我们可以将深度学习放入机器学习的大背景中,并更好地理解深度学习的起源以及它为什么如此重要。

1.2.1 概率建模

概率建模(probabilistic modeling)是统计学原理在数据分析中的应用。它是最早的机器学习形式之一,至今仍在广泛使用。其中最有名的算法之一就是朴素贝叶斯算法。

朴素贝叶斯是一类基于应用贝叶斯定理的机器学习分类器,它假设输入数据的特征都是独立的。这是一个很强的假设,或者说“朴素的”假设,其名称正来源于此。这种数据分析方法比计算机出现得还要早,在其第一次被计算机实现(很可能追溯到20 世纪50 年代)的几十年前就已经靠人工计算来应用了。贝叶斯定理和统计学基础可以追溯到18 世纪,你学会了这两点就可以开始使用朴素贝叶斯分类器了。

另一个密切相关的模型是 logistic 回归(logistic regression,简称logreg),它有时被认为是 现代机器学习的“hello world”。不要被它的名称所误导——logreg 是一种分类算法,而不是回 归算法。与朴素贝叶斯类似,logreg 的出现也比计算机早很长时间,但由于它既简单又通用, 至今仍然很有用。面对一个数据集,数据科学家通常会首先尝试使用这个算法,以便初步熟悉 手头的分类任务。

1.2.2 早期神经网络

神经网络早期的迭代方法已经完全被本文所介绍的现代方法所取代,但仍有助于我们了解深度学习的起源。虽然人们早在20 世纪50 年代就将神经网络作为玩具项目,并对其核心思想进行研究,但这一方法在数十年后才被人们所使用。在很长一段时间内,一直没有训练大型神经网络的有效方法。这一点在20 世纪80 年代中期发生了变化,当时很多人都独立地重新发现了反向传播算法——一种利用梯度下降优化来训练一系列参数化运算链的方法(后面将给出这些概念的具体定义),并开始将其应用于神经网络。

贝尔实验室于1989 年第一次成功实现了神经网络的实践应用,当时 Yann LeCun 将卷积神经网络的早期思想与反向传播算法相结合,并将其应用于手写数字分类问题,由此得到名为 LeNet 的网络,在 20 世纪 90 年代被美国邮政署采用,用于自动读取信封上的邮政编码。

1.2.3 核方法

上节所述神经网络取得了第一次成功,并在 20 世纪90 年代开始在研究人员中受到一定的重视,但一种新的机器学习方法在这时声名鹊起,很快就使人们将神经网络抛诸脑后。这种方法就是核方法(kernel method)。核方法是一组分类算法,其中最有名的就是支持向量机(SVM, support vector machine)。虽然Vladimir Vapnik 和 Alexey Chervonenkis 早在1963 年就发表了较早版本的线性公式,但 SVM的现代公式由Vladimir Vapnik和Corinna Cortes于20世纪90年代 初在贝尔实验室提出,并发表于 1995 年。

SVM 的目标是通过在属于两个不同类别的两组数据点之间找到良好决策边界(decision boundary,见图1-10)来解决分类问题。决策边界可以看作一条直线或一个平面,将 训练数据 划分为两块空间,分别对应于两个类别。对于新数据点的分类,你只需判断它位于决策边界的哪一侧。

图 1-10 决策边界

SVM 通过两步来寻找决策边界。

将数据映射到一个新的高维表示,这时决策边界可以用一个超平面来表示(如果数据像图 1-10那样是二维的,那么超平面就是一条直线)。尽量让超平面与每个类别最近的数据点之间的距离最大化,从而计算出良好决策边界(分割超平面),这一步叫作间隔最大化(maximizing the margin)。这样决策边界可以很好地推广到训练数据集之外的新样本。

将数据映射到高维表示从而使分类问题简化,这一技巧可能听起来很不错,但在实践中通 常是难以计算的。这时就需要用到核技巧(kernel trick,核方法正是因这一核心思想而得名)。 其基本思想是:要想在新的表示空间中找到良好的决策超平面,你不需要在新空间中直接计算 点的坐标,只需要在新空间中计算点对之间的距离,而利用核函数(kernel function)可以高效 地完成这种计算。核函数是一个在计算上能够实现的操作,将原始空间中的任意两点映射为这 两点在目标表示空间中的距离,完全避免了对新表示进行直接计算。核函数通常是人为选择的, 而不是从数据中学到的——对于 SVM 来说,只有分割超平面是通过学习得到的。

SVM 刚刚出现时,在简单的分类问题上表现出了最好的性能。当时只有少数机器学习方法得到大量的理论支持,并且适合用于严肃的数学分析,因而非常易于理解和解释,SVM 就是其中之一。由于 SVM 具有这些有用的性质,很长一段时间里它在实践中非常流行。

但是,SVM 很难扩展到大型数据集,并且在图像分类等感知问题上的效果也不好。SVM 是一种比较浅层的方法,因此要想将其应用于感知问题,首先需要手动提取出有用的表示(这叫作特征工程),这一步骤很难,而且不稳定。

1.2.4 决策树、随机森林与梯度提升机

决策树(decision tree)是类似于流程图的结构,可以对输入数据点进行分类或根据给定输入来预测输出值(见图1-11)。决策树的可视化和解释都很简单。在21 世纪前十年,从数据中学习得到的决策树开始引起研究人员的广泛关注。到了 2010 年,决策树经常比核方法更受欢迎。

图 1-11 决策树:需要学习的参数是关于数据的问题。举个例子,问题可能是:

“数据中第 2 个系数是否大于 3.5 ?”

特别是随机森林(random forest)算法,它引入了一种健壮且实用的决策树学习方法,即 首先构建许多决策树,然后将它们的输出集成在一起。随机森林适用于各种各样的问题—— **对于任何浅层的机器学习任务来说,它几乎总是第二好的算法。**广受欢迎的机器学习竞赛网站 Kaggle 在 2010 年上线后,随机森林迅速成为平台上人们的最爱,直到 2014 年才被 梯度提升机 所取代。与随机森林类似,梯度提升机(gradient boosting machine)也是将弱预测模型(通常是决策树)集成的机器学习技术。它使用了梯度提升方法,通过迭代地训练新模型来专门解决之前模型的弱点,从而改进任何机器学习模型的效果。将梯度提升技术应用于决策树时,得到的模型与随机森林具有相似的性质,但在绝大多数情况下效果都比随机森林要好。它可能是目前处理非感知数据最好的算法之一(如果非要加个“之一”的话)。和深度学习一样,它也是 Kaggle 竞赛中最常用的技术之一。

1.2.5 回到神经网络

虽然神经网络几乎被整个科学界完全忽略,但仍有一些人在继续研究神经网络,并在2010 年左右开始取得重大突破。这些人包括:多伦多大学Geoffrey Hinton 的小组、蒙特利尔大学的 Yoshua Bengio、纽约大学的 Yann LeCun 和瑞士的 IDSIA。

2011 年,来自IDSIA 的 Dan Ciresan 开始利用GPU 训练的深度神经网络赢得学术性的图像分类竞赛,这是现代深度学习第一次在实践中获得成功。但真正的转折性时刻出现在 2012 年, 当年Hinton 小组参加了每年一次的大规模图像分类挑战赛ImageNet。ImageNet 挑战赛在当时 以困难著称,参赛者需要对 140 万张高分辨率彩色图像进行训练,然后将其划分到 1000 个不同 的类别中。2011 年,获胜的模型基于经典的计算机视觉方法,其 top-5 精度 a 只有 74.3%。到了 2012 年,由 Alex Krizhevsky 带领并由Geoffrey Hinton 提供建议的小组,实现了83.6% 的 top-5 精度——这是一项重大突破。此后,**这项竞赛每年都由深度卷积神经网络所主导。**到了 2015 年, 获胜者的精度达到了 96.4%,此时 ImageNet 的分类任务被认为是一个已经完全解决的问题。

自 2012 年以来,深度卷积神经网络(convnet)已成为所有计算机视觉任务的首选算法。更 一般地说,它在所有感知任务上都有效。在2015 年和2016 年的主要计算机视觉会议上,几乎所有演讲都与 convnet 有关。与此同时,深度学习也在许多其他类型的问题上得到应用,比如自然语言处理。它已经在大量应用中完全取代了SVM 与决策树。举个例子,欧洲核子研究中心 (CERN)多年来一直使用基于决策树的方法来分析来自大型强子对撞机(LHC)ATLAS 探测器 的粒子数据,但CERN 最终转向基于Keras 的深度神经网络,因为它的性能更好,而且在大型数据集上易于训练

1.2.6 深度学习有何不同

深度学习发展得如此迅速,主要原因在于它在很多问题上都表现出更好的性能。但这并不是唯一的原因。深度学习还让解决问题变得更加简单,因为它将特征工程完全自动化,而这曾经是机器学习工作流程中最关键的一步。

先前的机器学习技术(浅层学习)仅包含将输入数据变换到一两个连续的表示空间,通常使用简单的变换,比如高维非线性投影(SVM)或决策树。但这些技术通常无法得到复杂问题所需要的精确表示。因此,人们必须竭尽全力让初始输入数据更适合用这些方法处理,也必须手动为数据设计好的表示层。这叫作特征工程。与此相反,深度学习完全将这个步骤自动化:**利用深度学习,你可以一次性学习所有特征,而无须自己手动设计。**这极大地简化了机器学习工作流程,通常将复杂的多阶段流程替换为一个简单的、端到端的深度学习模型。 你可能会问,如果问题的关键在于有多个连续表示层,那么能否重复应用浅层方法,以实现和深度学习类似的效果?在实践中,如果连续应用浅层学习方法,其收益会随着层数增加迅速降低,因为三层模型中最优的第一表示层并不是单层或双层模型中最优的第一表示层。**深度学习的变革性在于,模型可以在同一时间共同学习所有表示层,而不是依次连续学习(这被称为贪婪学习)。**通过共同的特征学习,一旦模型修改某个内部特征,所有依赖于该特征的其他特征都会相应地自动调节适应,无须人为干预。一切都由单一反馈信号来监督:模型中的每一处变化都是为了最终目标服务。这种方法比贪婪地叠加浅层模型更加强大,因为它可以通过将复杂、 抽象的表示拆解为很多个中间空间(层)来学习这些表示,每个中间空间仅仅是前一个空间的简单变换。

深度学习从数据中进行学习时有两个基本特征:第一,**通过渐进的、逐层的方式形成越来越复杂的表示;**第二,**对中间这些渐进的表示共同进行学习,每一层的变化都需要同时考虑上下两层的需要。**总之,这两个特征使得深度学习比先前的机器学习方法更加成功。

1.2.7 机器学习现状

要想了解机器学习算法和工具的现状,一个好方法是看一下 Kaggle 上的机器学习竞赛。 Kaggle 上的竞争非常激烈(有些比赛有数千名参赛者,并提供数百万美元的奖金),而且涵盖了各种类型的机器学习问题,所以它提供了一种现实方法来评判哪种方法有效、哪种方法无效。 那么哪种算法能够可靠地赢得竞赛呢?顶级参赛者都使用哪些工具?

在 2016 年和 2017 年,Kaggle 上主要有两大方法:梯度提升机和深度学习。具体而言,梯度提升机用于处理结构化数据的问题,而深度学习则用于图像分类等感知问题。使用前一种方法的人几乎都使用优秀的XGBoost 库,它同时支持数据科学最流行的两种语言:Python 和 R。 使用深度学习的 Kaggle 参赛者则大多使用Keras 库,因为它易于使用,非常灵活,并且支持 Python。

要想在如今的应用机器学习中取得成功,你应该熟悉这两种技术:梯度提升机,用于浅层学习问题;深度学习,用于感知问题。用术语来说,你需要熟悉 XGBoost 和 Keras,它们是目前主宰 Kaggle 竞赛的两个库。有了本书,你已经向这个目标迈出了一大步。

1.3 为什么是深度学习,为什么是现在

深度学习用于计算机视觉的两个关键思想,即卷积神经网络和反向传播,在1989 年就已经为人们所知。长短期记忆(LSTM,long short-term memory)算法是深度学习处理时间序列的基础,它在 1997 年就被开发出来了,而且此后几乎没有发生变化。那么为什么深度学习在 2012 年之后才开始取得成功?这二十年间发生了什么变化?

总的来说,三种技术力量在推动着机器学习的进步:

- 硬件

- 数据集和基准

- 算法上的改进

由于这一领域是靠实验结果而不是理论指导的,所以只有当合适的数据和硬件可用于尝试新想法时(或者将旧想法的规模扩大,事实往往也是如此),才可能出现算法上的改进。机器学习不是数学或物理学,靠一支笔和一张纸就能实现重大进展。它是一门工程科学。

在 20 世纪 90 年代和 21 世纪前十年,真正的瓶颈在于数据和硬件。但在这段时间内发生了 下面这些事情:互联网高速发展,并且针对游戏市场的需求开发出了高性能图形芯片。

1.3.1 硬件

从 1990 年到2010 年,非定制CPU 的速度提高了约5000 倍。因此,现在可以在笔记本电 脑上运行小型深度学习模型,但在 25 年前是无法实现的。

但是,对于计算机视觉或语音识别所使用的典型深度学习模型,所需要的计算能力要比笔记本电脑的计算能力高几个数量级。在20 世纪前十年里,NVIDIA 和 AMD 等公司投资数十亿 美元来开发快速的大规模并行芯片(图形处理器,GPU),以便为越来越逼真的视频游戏提供图 形显示支持。这些芯片是廉价的、单一用途的超级计算机,用于在屏幕上实时渲染复杂的3D场景。 这些投资为科学界带来了好处。2007 年,NVIDIA 推出了 CUDA,作为其 GPU 系列的编程接口。 少量GPU 开始在各种高度并行化的应用中替代大量CPU 集群,并且最早应用于物理建模。深度神经网络主要由许多小矩阵乘法组成,它也是高度并行化的。2011 年前后,一些研究人员开始编写神经网络的 CUDA 实现,而 Dan Ciresana 和 Alex Krizhevskyb 属于第一批人。

这样,游戏市场资助了用于下一代人工智能应用的超级计算。有时候,大事件都是从游戏 开始的。今天,NVIDIA TITAN X(一款游戏GPU,在2015 年底售价1000 美元)可以实现单精度6.6 TFLOPS 的峰值,即每秒进行6.6 万亿次 float32 运算。这比一台现代笔记本电脑的速度要快约 350 倍。使用一块 TITAN X 显卡,只需几天就可以训练出几年前赢得 ILSVRC 竞赛 的 ImageNet 模型。与此同时,大公司还在包含数百个 GPU 的集群上训练深度学习模型,这种类型的GPU 是专门针对深度学习的需求开发的,比如 NVIDIA Tesla K80。如果没有现代GPU, 这种集群的超级计算能力是不可能实现的。

此外,深度学习行业已经开始超越GPU,开始投资于日益专业化的高效芯片来进行深度学习。2016 年,Google 在其年度I/O 大会上展示了张量处理器(TPU)项目,它是一种新的芯片设计,其开发目的完全是为了运行深度神经网络。据报道,它的速度比最好的 GPU 还要快 10 倍, 而且能效更高。

1.3.2 数据

人工智能有时被称为新的工业革命。如果深度学习是这场革命的蒸汽机,那么数据就是煤炭, 即驱动智能机器的原材料,没有煤炭一切皆不可能。就数据而言,除了过去20 年里存储硬件的 指数级增长(遵循摩尔定律),最大的变革来自于互联网的兴起,它使得收集与分发用于机器学习的超大型数据集变得可行。如今,大公司使用的图像数据集、视频数据集和自然语言数据集, 如果没有互联网的话根本无法收集。例如,Flickr 网站上用户生成的图像标签一直是计算机视觉的数据宝库。YouTube 视频也是一座宝库。维基百科则是自然语言处理的关键数据即

如果有一个数据集是深度学习兴起的催化剂的话,那么一定是 ImageNet 数据集。它包含 140 万张图像,这些图像已经被人工划分为1000 个图像类别(每张图像对应1 个类别)。但 ImageNet 的特殊之处不仅在于其数量之大,还在于与它相关的年度竞赛。

正如 Kaggle 自 2010 年以来所展示的那样,公开竞赛是激励研究人员和工程师挑战极限的极好方法。研究人员通过竞争来挑战共同基准,这极大地促进了近期深度学习的兴起。

1.3.3 算法

除了硬件和数据之外,直到20 世纪前十年的末期,我们仍没有可靠的方法来训练非常深的神经网络。因此,神经网络仍然很浅,仅使用一两个表示层,无法超越更为精确的浅层方法, 比如 SVM 和随机森林。关键问题在于通过多层叠加的梯度传播。随着层数的增加,用于训练神经网络的反馈信号会逐渐消失。

这一情况在2009—2010 年左右发生了变化,当时出现了几个很简单但很重要的算法改进, 可以实现更好的梯度传播。

- 更好的神经层激活函数(activation function)。

- 更好的权重初始化方案(weight-initialization scheme),一开始使用逐层预训练的方法, 不过这种方法很快就被放弃了。

- 更好的优化方案(optimization scheme),比如 RMSProp 和 Adam。

只有这些改进可以训练 10 层以上的模型时,深度学习才开始大放异彩。

最后,在2014 年、2015 年和2016 年,人们发现了更先进的有助于梯度传播的方法,比如 批标准化、残差连接和深度可分离卷积。今天,我们可以从头开始训练上千层的模型。

1.3.4 新的投资热潮

随着深度学习于 2012—2013 年在计算机视觉领域成为新的最优算法,并最终在所有感知任务上都成为最优算法,业界领导者开始注意到它。接下来就是逐步升温的业界投资热潮,远远 超出了人工智能历史上曾经出现过的任何投资。

2011 年,就在深度学习大放异彩之前,在人工智能方面的风险投资总额大约为 1900 万美元,

几乎全都投给了浅层机器学习方法的实际应用。到了 2014 年,这一数字已经涨到了惊人的3.94 亿美元。这三年里创办了数十家创业公司,试图从深度学习炒作中获利。与此同时,Google、 Facebook、百度、微软等大型科技公司已经在内部研究部门进行投资,其金额很可能已经超过 了风险投资的现金流。其中只有少数金额被公之于众:2013 年,Google 收购了深度学习创业公 司 DeepMind,报道称收购价格为5 亿美元,这是历史上对人工智能公司的最高收购价格。2014 年,百度在硅谷启动了深度学习研究中心,为该项目投资3 亿美元。2016 年,深度学习硬件创 业公司 Nervana Systems 被英特尔收购,收购价格逾 4 亿美元。

机器学习,特别是深度学习,已成为这些科技巨头产品战略的核心。2015 年末,Google 首 席执行官 Sundar Pichai 表示:“机器学习这一具有变革意义的核心技术将促使我们重新思考做所 有事情的方式。我们用心将其应用于所有产品,无论是搜索、广告、YouTube 还是 Google Play。 我们尚处于早期阶段,但你将会看到我们系统性地将机器学习应用于所有这些领域。”

由于这波投资热潮,短短五年间从事深度学习的人数从几千人涨到数万人,研究进展也达 到了惊人的速度。目前没有迹象表明这种趋势会在短期内放缓。

1.3.5 深度学习的大众化

有许多新面孔进入深度学习领域,而主要的驱动因素之一是该领域所使用工具集的大众化。在早期,从事深度学习需要精通C++ 和CUDA,而它们只有少数人才能掌握。如今,**具有基本的Python 脚本技能,就可以从事高级的深度学习研究。**这主要得益于 Theano 及随后的 TensorFlow 的开发,以及 Keras 等用户友好型库的兴起。Theano 和 TensorFlow 是两个符号式的 张量运算的 Python 框架,都支持自动求微分,这极大地简化了新模型的实现过程。Keras 等用户友好型库则使深度学习变得像操纵乐高积木一样简单。Keras 在 2015 年初发布,并且很快就 成为大量创业公司、研究生和研究人员转向该领域的首选深度学习解决方案。

1.3.6 这种趋势会持续吗

深度神经网络成为企业投资和研究人员纷纷选择的正确方法,它究竟有何特别之处?换句话说,深度学习是否只是难以持续的昙花一现? 20 年后我们是否仍在使用深度神经网络?

深度学习有几个重要的性质,证明了它确实是人工智能的革命,并且能长盛不衰。20 年后 我们可能不再使用神经网络,但我们那时所使用的工具都是直接来自于现代深度学习及其核心概念。这些重要的性质可大致分为以下三类。

- 简单。深度学习不需要特征工程,它将复杂的、不稳定的、工程量很大的流程替换为简 单的、端到端的可训练模型,这些模型通常只用到五六种不同的张量运算。

- 可扩展。深度学习非常适合在GPU或TPU上并行计算,因此可以充分利用摩尔定律。此外, 深度学习模型通过对小批量数据进行迭代来训练,因此可以在任意大小的数据集上进行 训练。(唯一的瓶颈是可用的并行计算能力,而由于摩尔定律,这一限制会越来越小。)

- 多功能与可复用。与之前的许多机器学习方法不同,深度学习模型无须从头开始就可以 在附加数据上进行训练,因此可用于连续在线学习,这对于大型生产模型而言是非常重 要的特性。此外,训练好的深度学习模型可用于其他用途,因此是可以重复使用的。举 个例子,可以将一个对图像分类进行训练的深度学习模型应用于视频处理流程。这样我 们可以将以前的工作重新投入到日益复杂和强大的模型中。这也使得深度学习可以适用 于较小的数据集。

深度学习数年来一直备受关注,我们还没有发现其能力的界限。每过一个月,我们都会学到新的用例和工程改进,从而突破先前的局限。在一次科学革命之后,科学发展的速度通常会 遵循一条 S 形曲线:首先是一个快速发展时期,接着随着研究人员受到严重限制而逐渐稳定下来, 然后进一步的改进又逐渐增多。深度学习在 2017 年似乎处于这条 S 形曲线的前半部分,在未来几年将会取得更多进展。

Python深度学习篇二《神经网络的数学基础》

Excerpt

前言 前期回顾:Python深度学习篇一《什么是深度学习》 上面这篇里面写了深度学习的历史及概念的介绍。 好,接下来切入正题。 要理解深度学习,需要熟悉很多简单的数学概念:张量、张量运算、微分、梯度下降等。 本章目的是用不那么技术化的文字帮你建立 …

前言

前期回顾:Python深度学习篇一《什么是深度学习》

上面这篇里面写了深度学习的历史及概念的介绍。

好,接下来切入正题。

要理解深度学习,需要熟悉很多简单的数学概念:张量、张量运算、微分、梯度下降等。 本章目的是用不那么技术化的文字帮你建立对这些概念的直觉。特别地,我们将避免使用数学符号,因为数学符号可能会令没有任何数学背景的人反感,而且对解释问题也不是绝对必要的。

本章将首先给出一个神经网络的示例,引出张量和梯度下降的概念,然后逐个详细介绍。 请记住,这些概念对于理解后续章节中的示例至关重要。

读完本章后,你会对神经网络的工作原理有一个直观的理解,然后就可以学习神经网络的实际应用了(从第 3 章开始)。

2.1 初识神经网络

我们来看一个具体的神经网络示例,使用Python 的 Keras 库来学习手写数字分类。如果你 没用过 Keras 或类似的库,可能无法立刻搞懂这个例子中的全部内容。甚至你可能还没有安装 Keras。没关系,下一章会详细解释这个例子中的每个步骤。因此,如果其中某些步骤看起来有 些随意,或者像魔法一样,也请你不要担心。下面我们要开始了。

我们这里要解决的问题是,将手写数字的灰度图像(28 像素×28 像素)划分到10 个类别 中(0~9)。我们将使用 MNIST 数据集,它是机器学习领域的一个经典数据集,其历史几乎和这个领域一样长,而且已被人们深入研究。这个数据集包含 60000 张训练图像和 10000 张测试图 像,由美国国家标准与技术研究院(National Institute of Standards and Technology,即 MNIST 中 的 NIST)在20 世纪80 年代收集得到。你可以将“解决”MNIST 问题看作深度学习的“Hello World”,正是用它来验证你的算法是否按预期运行。当你成为机器学习从业者后,会发现 MNIST一次又一次地出现在科学论文、博客文章等中。图2-1给出了MNIST数据集的一些样本。

关于类和标签的说明

在机器学习中,分类问题中的某个类别叫作类(class)。数据点叫作样本(sample)。某 个样本对应的类叫作标签(label)。

图 2-1 MNIST 数字图像样本

你不需要现在就尝试在计算机上运行这个例子。但如果你想这么做的话,首先需要安装 Keras,安装方法见 3.3 节。

MNIST 数据集预先加载在 Keras 库中,其中包括 4 个 Numpy 数组。

代码清单 2-1 加载 Keras 中的 MNIST 数据集

from keras.datasets import mnist

(train_images, train_labels), (test_images, test_labels) = mnist.load_data()

train_images 和 train_labels 组成了训练集(training set),模型将从这些数据中进行学习。然后在测试集(test set,即 test_images 和 test_labels)上对模型进行测试。

图像被编码为 Numpy 数组,而标签是数字数组,取值范围为 0~9。图像和标签一一对应。

我们来看一下训练数据:

>>> train_images.shape

(60000, 28, 28)

>>> len(train_labels)

60000

>>> train_labels

array([5, 0, 4, ..., 5, 6, 8], dtype=uint8)

下面是测试数据:

>>> test_images.shape

(10000, 28, 28)

>>> len(test_labels)

10000

>>> test_labels

array([7, 2, 1, ..., 4, 5, 6], dtype=uint8)

接下来的工作流程如下:首先,将训练数据(train_images 和 train_labels)输入神经网络;其次,网络学习将图像和标签关联在一起;最后,网络对 test_images 生成预测, 而我们将验证这些预测与 test_labels 中的标签是否匹配。

下面我们来构建网络。再说一遍,你现在不需要理解这个例子的全部内容。

代码清单 2-2 网络架构

from keras import models from keras import layers

network = models.Sequential() network.add(layers.Dense(512, activation='relu', input_shape=(28 * 28,))) network.add(layers.Dense(10, activation='softmax'))

神经网络的核心组件是层(layer),它是一种数据处理模块,你可以将它看成数据过滤器。 进去一些数据,出来的数据变得更加有用。具体来说,层从输入数据中提取表示——我们期望这种表示有助于解决手头的问题。大多数深度学习都是将简单的层链接起来,从而实现渐进式的数据蒸馏(data distillation)。深度学习模型就像是数据处理的筛子,包含一系列越来越精细的数据过滤器(即层)。

本例中的网络包含2 个 Dense 层,它们是密集连接(也叫全连接)的神经层。第二层(也是最后一层)是一个10 路 softmax 层,它将返回一个由10 个概率值(总和为1)组成的数组。 每个概率值表示当前数字图像属于 10 个数字类别中某一个的概率。

要想训练网络,我们还需要选择编译(compile)步骤的三个参数。

- 损失函数(loss function):网络如何衡量在训练数据上的性能,即网络如何朝着正确的方向前进。

- 优化器(optimizer):基于训练数据和损失函数来更新网络的机制。

- 在训练和测试过程中需要监控的指标(metric):本例只关心精度,即正确分类的图像所 占的比例。

后续两章会详细解释损失函数和优化器的确切用途。

代码清单 2-3 编译步骤

network.compile(optimizer='rmsprop',

loss='categorical_crossentropy',

metrics=['accuracy'])

在开始训练之前,我们将对数据进行预处理,将其变换为网络要求的形状,并缩放到所有值都在[0, 1] 区间。比如,之前训练图像保存在一个uint8类型的数组中,其形状为 (60000, 28, 28),取值区间为 [0, 255]。我们需要将其变换为一个 float32 数组,其形状为 (60000, 28 * 28),取值范围为 0~1。

代码清单 2-4 准备图像数据

train_images = train_images.reshape((60000, 28 * 28))

train_images = train_images.astype('float32') / 255

test_images = test_images.reshape((10000, 28 * 28))

test_images = test_images.astype('float32') / 255

我们还需要对标签进行分类编码,第 3 章将会对这一步骤进行解释。

代码清单 2-5 准备标签

from keras.utils import to_categorical

train_labels = to_categorical(train_labels)

test_labels = to_categorical(test_labels)

现在我们准备开始训练网络,在 Keras 中这一步是通过调用网络的 fit 方法来完成的—— 我们在训练数据上拟合(fit)模型。

>>> network.fit(train_images, train_labels, epochs=5, batch_size=128)

Epoch 1/5

60000/60000 [=============================] - 9s - loss: 0.2524 - acc: 0.9273

Epoch 2/5

51328/60000 [=======================>.....] - ETA: 1s - loss: 0.1035 - acc: 0.9692

训练过程中显示了两个数字:一个是网络在训练数据上的损失(loss),另一个是网络在 训练数据上的精度(acc)。

我们很快就在训练数据上达到了0.989(98.9%)的精度。现在我们来检查一下模型在测试集上的性能。

>>> test_loss, test_acc = network.evaluate(test_images, test_labels)

>>> print('test_acc:', test_acc)

test_acc: 0.9785

测试集精度为97.8%,比训练集精度低不少。训练精度和测试精度之间的这种差距是过拟合(overfit)造成的。过拟合是指机器学习模型在新数据上的性能往往比在训练数据上要差,它是第 3 章的核心主题。

第一个例子到这里就结束了。你刚刚看到了如何构建和训练一个神经网络,用不到 20 行的 Python 代码对手写数字进行分类。下一章会详细介绍这个例子中的每一个步骤,并讲解其背后的原理。接下来你将要学到张量(输入网络的数据存储对象)、张量运算(层的组成要素)和梯度下降(可以让网络从训练样本中进行学习)。

2.2 神经网络的数据表示

前面例子使用的数据存储在多维Numpy 数组中,也叫张量(tensor)。一般来说,当前所有机器学习系统都使用张量作为基本数据结构。张量对这个领域非常重要,重要到Google 的 TensorFlow 都以它来命名。那么什么是张量?

张量这一概念的核心在于,它是一个数据容器。它包含的数据几乎总是数值数据,因此它是数字的容器。你可能对矩阵很熟悉,它是二维张量。张量是矩阵向任意维度的推广[注意, 张量的维度(dimension)通常叫作轴(axis)]。

2.2.1 标量(0D 张量)

仅包含一个数字的张量叫作标量(scalar,也叫标量张量、零维张量、0D 张量)。在 Numpy 中,一个 float32 或 float64 的数字就是一个标量张量(或标量数组)。你可以用 ndim 属性来查看一个 Numpy 张量的轴的个数。标量张量有 0 个轴(ndim == 0)。张量轴的个数也叫作阶(rank)。下面是一个 Numpy 标量。

>>> import numpy as np

>>> x = np.array(12)

>>> x array(12)

>>> x.ndim

0

2.2.2 向量(1D 张量)

数字组成的数组叫作向量(vector)或一维张量(1D 张量)。一维张量只有一个轴。下面是 一个 Numpy 向量。

>>> x = np.array([12, 3, 6, 14, 7])

>>> x array([12, 3, 6, 14, 7])

>>> x.ndim

1

这个向量有5 个元素,所以被称为 5D 向量。不要把 5D 向量和 5D 张量弄混!5D 向量只有一个轴,沿着轴有 5 个维度,而 5D 张量有5 个轴(沿着每个轴可能有任意个维度)。维度 (dimensionality)可以表示沿着某个轴上的元素个数(比如 5D 向量),也可以表示张量中轴的个 数(比如 5D 张量),这有时会令人感到混乱。对于后一种情况,技术上更准确的说法是 5 阶张量 (张量的阶数即轴的个数),但 5D 张量这种模糊的写法更常见。

2.2.3 矩阵(2D 张量)

向量组成的数组叫作矩阵(matrix)或二维张量(2D 张量)。矩阵有 2 个轴(通常叫作行和列)。你可以将矩阵直观地理解为数字组成的矩形网格。下面是一个 Numpy 矩阵。

>>> x = np.array([[5, 78, 2, 34, 0],

[6, 79, 3, 35, 1],

[7, 80, 4, 36, 2]])

>>> x.ndim

2

第一个轴上的元素叫作行(row),第二个轴上的元素叫作列(column)。在上面的例子中, [5, 78, 2, 34, 0] 是 x 的第一行,[5, 6, 7] 是第一列。

2.2.4 3D 张量与更高维张量

将多个矩阵组合成一个新的数组,可以得到一个3D 张量,你可以将其直观地理解为数字 组成的立方体。下面是一个 Numpy 的 3D 张量。

>>> x = np.array([[[5, 78, 2, 34, 0],

[6, 79, 3, 35, 1],

[7, 80, 4, 36, 2]],

[[5, 78, 2, 34, 0],

[6, 79, 3, 35, 1],

[7, 80, 4, 36, 2]],

[[5, 78, 2, 34, 0],

[6, 79, 3, 35, 1],

[7, 80, 4, 36, 2]]])

>>> x.ndim

3

将多个 3D 张量组合成一个数组,可以创建一个 4D 张量,以此类推。深度学习处理的一般 是 0D 到 4D 的张量,但处理视频数据时可能会遇到 5D 张量。

2.2.5 关键属性

张量是由以下三个关键属性来定义的。

- 轴的个数(阶)。例如,3D 张量有3 个轴,矩阵有2 个轴。这在

Numpy等 Python 库中 也叫张量的ndim。 - 形状。这是一个整数元组,表示张量沿每个轴的维度大小(元素个数)。例如,前面矩阵示例的形状为 (3, 5),

3D张量示例的形状为 (3, 3, 5)。向量的形状只包含一个元素,比如 (5,),而标量的形状为空,即 ()。 - 数据类型(在Python 库中通常叫作

dtype)。这是张量中所包含数据的类型,例如,张量的类型可以是float32、uint8、float64等。在极少数情况下,你可能会遇到字符 (char)张量。注意,Numpy(以及大多数其他库)中不存在字符串张量,因为张量存储在预先分配的连续内存段中,而字符串的长度是可变的,无法用这种方式存储。

为了具体说明,我们回头看一下 MNIST 例子中处理的数据。首先加载 MNIST 数据集。

from keras.datasets import mnist

(train_images, train_labels), (test_images, test_labels) = mnist.load_data()

接下来,我们给出张量 train_images 的轴的个数,即 ndim 属性。

>>> print(train_images.ndim)

3

下面是它的形状

>>> print(train_images.shape)

(60000, 28, 28)

下面是它的数据类型,即 dtype 属性。

>>> print(train_images.dtype)

uint8

所以,这里 train_images 是一个由 8 位整数组成的 3D 张量。更确切地说,它是60000个矩阵组成的数组,每个矩阵由 28×28 个整数组成。每个这样的矩阵都是一张灰度图像,元素取值范围为 0~255。

我们用 Matplotlib 库(Python 标准科学套件的一部分)来显示这个 3D 张量中的第 4 个数字, 如图 2-2 所示。

代码清单 2-6 显示第 4 个数字

digit = train_images[4]

import matplotlib.pyplot as plt

plt.imshow(digit, cmap=plt.cm.binary)

plt.show()

图 2-2 数据集中的第 4 个样本

2.2.6 在 Numpy 中操作张量

在前面的例子中,我们使用语法 train_images[i] 来选择沿着第一个轴的特定数字。选择张量的特定元素叫作张量切片(tensor slicing)。我们来看一下 Numpy 数组上的张量切片运算。

下面这个例子选择第10~100 个数字(不包括第100 个),并将其放在形状为(90, 28, 28) 的数组中。

>>> my_slice = train_images[10:100]

>>> print(my_slice.shape)

(90, 28, 28)

它等同于下面这个更复杂的写法,给出了切片沿着每个张量轴的起始索引和结束索引。

注意,: 等同于选择整个轴。

>>> my_slice = train_images[10:100, :, :]

>>> my_slice.shape

(90, 28, 28)

>>> my_slice = train_images[10:100, 0:28, 0:28]

>>> my_slice.shape

(90, 28, 28)

一般来说,你可以沿着每个张量轴在任意两个索引之间进行选择。例如,你可以在所有图像的右下角选出 14 像素×14 像素的区域:

my_slice = train_images[:, 14:, 14:]

也可以使用负数索引。与 Python 列表中的负数索引类似,它表示与当前轴终点的相对位置。 你可以在图像中心裁剪出 14 像素×14 像素的区域:

my_slice = train_images[:, 7:-7, 7:-7]

2.2.7 数据批量的概念

通常来说,深度学习中所有数据张量的第一个轴(0 轴,因为索引从0 开始)都是样本轴 (samples axis,有时也叫样本维度)。在 MNIST 的例子中,样本就是数字图像。

此外,深度学习模型不会同时处理整个数据集,而是将数据拆分成小批量。具体来看,下面是 MNIST 数据集的一个批量,批量大小为 128。

batch = train_images[:128]

然后是下一个批量。

batch = train_images[128:256]

然后是第 n 个批量。

batch = train_images[128 * n:128 * (n + 1)]

对于这种批量张量,第一个轴(0轴)叫作批量轴(batch axis)或批量维度(batch dimension)。 在使用 Keras 和其他深度学习库时,你会经常遇到这个术语。

2.2.8 现实世界中的数据张量

我们用几个你未来会遇到的示例来具体介绍数据张量。你需要处理的数据几乎总是以下类别之一。

- 向量数据:2D 张量,形状为 (samples, features)。

- 时间序列数据或序列数据:3D 张量,形状为 (samples, timesteps, features)。

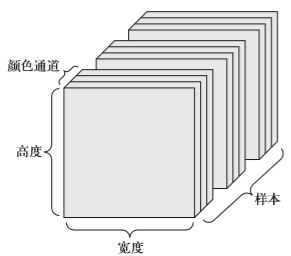

- 图像:4D 张量,形状为 (samples, height, width, channels) 或(samples, channels, height, width)。

- 视频:5D 张量,形状为 (samples, frames, height, width, channels) 或(samples, frames, channels, height, width)。

2.2.9 向量数据

这是最常见的数据。对于这种数据集,每个数据点都被编码为一个向量,因此一个数据批量就被编码为 2D 张量(即向量组成的数组),其中第一个轴是样本轴,第二个轴是特征轴。

我们来看两个例子。

- 人口统计数据集,其中包括每个人的年龄、邮编和收入。每个人可以表示为包含 3 个值 的向量,而整个数据集包含100 000 个人,因此可以存储在形状为 (100000, 3) 的 2D 张量中。

- 文本文档数据集,我们将每个文档表示为每个单词在其中出现的次数(字典中包含 20 000 个常见单词)。每个文档可以被编码为包含20 000 个值的向量(每个值对应于 字典中每个单词的出现次数),整个数据集包含500 个文档,因此可以存储在形状为 (500, 20000) 的张量中。

2.2.10 时间序列数据或序列数据

当时间(或序列顺序)对于数据很重要时,应该将数据存储在带有时间轴的3D 张量中。 每个样本可以被编码为一个向量序列(即2D 张量),因此一个数据批量就被编码为一个 3D 张 量(见图 2-3)。

图 2-3 时间序列数据组成的 3D 张量

根据惯例,时间轴始终是第 2 个轴(索引为 1 的轴)。我们来看几个例子。

- 股票价格数据集。每一分钟,我们将股票的当前价格、前一分钟的最高价格和前一分钟的最低价格保存下来。因此每分钟被编码为一个3D 向量,整个交易日被编码为一个形 状为 (390, 3) 的 2D 张量(一个交易日有 390 分钟),而 250 天的数据则可以保存在一 个形状为 (250, 390, 3) 的 3D 张量中。这里每个样本是一天的股票数据。

- 推文数据集。我们将每条推文编码为280 个字符组成的序列,而每个字符又来自于128 个字符组成的字母表。在这种情况下,每个字符可以被编码为大小为 128 的二进制向量 (只有在该字符对应的索引位置取值为1,其他元素都为0)。那么每条推文可以被编码 为一个形状为 (280, 128) 的 2D 张量,而包含100 万条推文的数据集则可以存储在一 个形状为 (1000000, 280, 128) 的张量中。

2.2.11 图像数据

图像通常具有三个维度:高度、宽度和颜色深度。虽然灰度图像(比如MNIST 数字图像) 只有一个颜色通道,因此可以保存在2D 张量中,但按照惯例,图像张量始终都是 3D 张量,灰度图像的彩色通道只有一维。因此,如果图像大小为256×256,那么128 张灰度图像组成的批量可以保存在一个形状为 (128, 256, 256, 1) 的张量中,而128 张彩色图像组成的批量则可以保存在一个形状为 (128, 256, 256, 3)的张量中(见图2-4)。

图 2-4 图像数据组成的 4D 张量(通道在前的约定)

图像张量的形状有两种约定:通道在后(channels-last)的约定(在 TensorFlow 中使用)和 通道在前(channels-first)的约定(在 Theano 中使用)。Google 的 TensorFlow 机器学习框架将颜色深度轴放在最后:(samples, height, width, color_depth)。与此相反,Theano 将图像深度轴放在批量轴之后:(samples, color_depth, height, width)。如果采用 Theano 约定,前面的两个例子将变成 (128, 1, 256, 256) 和 (128, 3, 256, 256)。 Keras 框架同时支持这两种格式。

2.2.12 视频数据

视频数据是现实生活中需要用到5D 张量的少数数据类型之一。视频可以看作一系列帧, 每一帧都是一张彩色图像。由于每一帧都可以保存在一个形状为 (height, width, color_ depth) 的 3D 张量中,因此一系列帧可以保存在一个形状为(frames, height, width, color_depth) 的 4D 张量中,而不同视频组成的批量则可以保存在一个5D 张量中,其形状为 (samples, frames, height, width, color_depth)。

举个例子,一个以每秒4 帧采样的60 秒 YouTube 视频片段,视频尺寸为144×256,这个视频共有 240 帧。4 个这样的视频片段组成的批量将保存在形状为 (4, 240, 144, 256, 3) 的张量中。总共有 106168320 个值!如果张量的数据类型(dtype)是 float32,每个值都是 32 位,那么这个张量共有 405MB。好大!你在现实生活中遇到的视频要小得多,因为它们不以 float32 格式存储,而且通常被大大压缩,比如 MPEG 格式。

2.3 神经网络的“齿轮”:张量运算

所有计算机程序最终都可以简化为二进制输入上的一些二进制运算(AND、OR、NOR 等), 与此类似,深度神经网络学到的所有变换也都可以简化为数值数据张量上的一些张量运算(tensor operation),例如加上张量、乘以张量等。

在最开始的例子中,我们通过叠加 Dense 层来构建网络。Keras 层的实例如下所示。

keras.layers.Dense(512, activation='relu')

这个层可以理解为一个函数,输入一个 2D 张量,返回另一个 2D 张量,即输入张量的新表示。具体而言,这个函数如下所示(其中 W 是一个 2D 张量,b 是一个向量,二者都是该层的属性)。

output = relu(dot(W, input) + b)

我们将上式拆开来看。这里有三个张量运算:输入张量和张量 W 之间的点积运算(dot)、 得到的 2D 张量与向量 b 之间的加法运算(+)、最后的 relu 运算。relu(x) 是 max(x, 0)。

注意 虽然本节的内容都是关于线性代数表达式,但你却找不到任何数学符号。我发现,对于没有数学背景的程序员来说,如果用简短的 Python 代码而不是数学方程来表达数学概念, 他们将更容易掌握。所以我们自始至终将会使用 Numpy 代码。

2.3.1 逐元素运算

relu 运算和加法都是逐元素(element-wise)的运算,即该运算独立地应用于张量中的每个元素,也就是说,这些运算非常适合大规模并行实现(向量化实现,这一术语来自于 1970—1990 年间向量处理器超级计算机架构)。如果你想对逐元素运算编写简单的 Python 实现,那么可以用 for 循环。下列代码是对逐元素 relu 运算的简单实现。

def naive_relu(x):

assert len(x.shape) == 2

x = x.copy()

for i in range(x.shape[0]):

for j in range(x.shape[1]):

x[i, j] = max(x[i, j], 0)

return x

对于加法采用同样的实现方法。

def naive_add(x, y):

assert len(x.shape) == 2

assert x.shape == y.shape

x = x.copy()

for i in range(x.shape[0]):

for j in range(x.shape[1]):

x[i, j] += y[i, j]

return x

根据同样的方法,你可以实现逐元素的乘法、减法等。

在实践中处理 Numpy 数组时,这些运算都是优化好的 Numpy 内置函数,这些函数将大量运算交给安装好的基础线性代数子程序(BLAS,basic linear algebra subprograms)实现(没装的话,应该装一个)。BLAS 是低层次的、高度并行的、高效的张量操作程序,通常用 Fortran 或 C 语言来实现。

因此,在 Numpy 中可以直接进行下列逐元素运算,速度非常快。

import numpy as np

z = x + y

z = np.maximum(z, 0.)

2.3.2 广播

上一节 naive_add 的简单实现仅支持两个形状相同的 2D 张量相加。但在前面介绍的 Dense 层中,我们将一个 2D 张量与一个向量相加。如果将两个形状不同的张量相加,会发生 什么?

如果没有歧义的话,较小的张量会被广播(broadcast),以匹配较大张量的形状。广播包含以下两步。

- 向较小的张量添加轴(叫作广播轴),使其 ndim 与较大的张量相同。

- 将较小的张量沿着新轴重复,使其形状与较大的张量相同。

来看一个具体的例子。假设 X 的形状是 (32, 10),y 的形状是 (10,)。首先,我们给 y 添加空的第一个轴,这样 y 的形状变为 (1, 10)。然后,我们将 y 沿着新轴重复 32 次,这样得到的张量 Y 的形状为 (32, 10),并且 Y[i, :] == y for i in range(0, 32)。现在, 我们可以将 X 和 Y 相加,因为它们的形状相同。

在实际的实现过程中并不会创建新的 2D 张量,因为那样做非常低效。重复的操作完全是虚拟的,它只出现在算法中,而没有发生在内存中。但想象将向量沿着新轴重复 10 次,是一种很有用的思维模型。下面是一种简单的实现。

def naive_add_matrix_and_vector(x, y):

assert len(x.shape) == 2

assert len(y.shape) == 1

assert x.shape[1] == y.shape[0]

x = x.copy()

for i in range(x.shape[0]):

for j in range(x.shape[1]):

x[i, j] += y[j]

return x

如果一个张量的形状是 (a, b, … n, n+1, … m),另一个张量的形状是 (n, n+1, … m),那么你通常可以利用广播对它们做两个张量之间的逐元素运算。广播操作会自动应用 于从 a 到 n-1 的轴。

下面这个例子利用广播将逐元素的 maximum 运算应用于两个形状不同的张量。

import numpy as np

x = np.random.random((64, 3, 32, 10))

y = np.random.random((32, 10))

z = np.maximum(x, y)

2.3.3 张量点积

点积运算,也叫张量积(tensor product,不要与逐元素的乘积弄混),是最常见也最有用的张量运算。与逐元素的运算不同,它将输入张量的元素合并在一起。

在 Numpy、Keras、Theano 和 TensorFlow 中,都是用 * 实现逐元素乘积。TensorFlow 中的点积使用了不同的语法,但在 Numpy 和 Keras 中,都是用标准的 dot 运算符来实现点积。

import numpy as np

z = np.dot(x, y)

数学符号中的点(.)表示点积运算。

z=x.y

从数学的角度来看,点积运算做了什么?我们首先看一下两个向量 x 和 y 的点积。其计算过程如下。

def naive_vector_dot(x, y):

assert len(x.shape) == 1

assert len(y.shape) == 1

assert x.shape[0] == y.shape[0]

z = 0.

for i in range(x.shape[0]):

z += x[i] * y[i]

return z

注意,两个向量之间的点积是一个标量,而且只有元素个数相同的向量之间才能做点积。

你还可以对一个矩阵 x 和一个向量 y 做点积,返回值是一个向量,其中每个元素是 y 和 x 的每一行之间的点积。其实现过程如下。

import numpy as np

def naive_matrix_vector_dot(x, y):

assert len(x.shape) == 2

assert len(y.shape) == 1

assert x.shape[1] == y.shape[0]

z = np.zeros(x.shape[0])

for i in range(x.shape[0]):

for j in range(x.shape[1]):

z[i] += x[i, j] * y[j]

return z

你还可以复用前面写过的代码,从中可以看出矩阵 - 向量点积与向量点积之间的关系。

def naive_matrix_vector_dot(x, y):

z = np.zeros(x.shape[0])

for i in range(x.shape[0]):

z[i] = naive_vector_dot(x[i, :], y)

return z

注意,如果两个张量中有一个的 ndim 大于 1,那么 dot 运算就不再是对称的,也就是说, dot(x, y) 不等于 dot(y, x)。

当然,点积可以推广到具有任意个轴的张量。最常见的应用可能就是两个矩阵之间的点积。 对于两个矩阵 x 和 y,当且仅当 x.shape[1] == y.shape[0] 时,你才可以对它们做点积 (dot(x, y))。得到的结果是一个形状为 (x.shape[0], y.shape[1]) 的矩阵,其元素为 x 的行与 y 的列之间的点积。其简单实现如下。

def naive_matrix_dot(x, y):

assert len(x.shape) == 2

assert len(y.shape) == 2

assert x.shape[1] == y.shape[0]

z = np.zeros((x.shape[0], y.shape[1]))

for i in range(x.shape[0]):

for j in range(y.shape[1]):

row_x = x[i, :]

column_y = y[:, j]

z[i, j] = naive_vector_dot(row_x, column_y)

return z

为了便于理解点积的形状匹配,可以将输入张量和输出张量像图 2-5 中那样排列,利用可视化来帮助理解。

图 2-5 图解矩阵点积

图 2-5 中,x、y 和 z 都用矩形表示(元素按矩形排列)。x 的行和 y 的列必须大小相同,因此 x 的宽度一定等于 y 的高度。如果你打算开发新的机器学习算法,可能经常要画这种图。

更一般地说,你可以对更高维的张量做点积,只要其形状匹配遵循与前面 2D 张量相同的原则:

(a, b, c, d) . (d,) -> (a, b, c)

(a, b, c, d) . (d, e) -> (a, b, c, e)

以此类推。

2.3.4 张量变形

第三个重要的张量运算是张量变形(tensor reshaping)。虽然前面神经网络第一个例子的 Dense 层中没有用到它,但在将图像数据输入神经网络之前,我们在预处理时用到了这个运算。

train_images = train_images.reshape((60000, 28 * 28))

张量变形是指改变张量的行和列,以得到想要的形状。变形后的张量的元素总个数与初始张量相同。简单的例子可以帮助我们理解张量变形。

>>> x = np.array([[0., 1.],

[2., 3.],

[4., 5.]])

>>> print(x.shape)

(3, 2)

>>> x = x.reshape((6, 1))

>>> x

array([[ 0.],

[ 1.],

[ 2.],

[ 3.],

[ 4.],

[ 5.]])

>>> x = x.reshape((2, 3))

>>> x

array([[ 0., 1., 2.],

[ 3., 4., 5.]])

经常遇到的一种特殊的张量变形是转置(transposition)。对矩阵做转置是指将行和列互换, 使 x[i, :] 变为 x[:, i]。

>>> x = np.zeros((300, 20))

>>> x = np.transpose(x)

>>> print(x.shape)

(20, 300)

2.3.5 张量运算的几何解释

对于张量运算所操作的张量,其元素可以被解释为某种几何空间内点的坐标,因此所有的张量运算都有几何解释。举个例子,我们来看加法。首先有这样一个向量:

A = [0.5, 1]

它是二维空间中的一个点(见图 2-6)。

图 2-6 二维空间中的一个点

常见的做法是将向量描绘成原点到这个点的箭头, 如图 2-7 所示。

![]()

图 2-7 将二维空间中的一个点描绘成一个箭头

假设又有一个点:B = [1, 0.25],将它与前面的 A 相加。从几何上来看,这相当于将两 个向量箭头连在一起,得到的位置表示两个向量之和对应的向量(见图 2-8)。

通常来说,仿射变换、旋转、缩放等基本的几何操作都可以表示为张量运算。举个例子,要将一个二维向量旋转 theta 角,可以通过与一个 2×2 矩阵做点积来实现,这个矩阵为 R = [u, v],其中 u 和 v 都是平面向量:u = [cos(theta), sin(theta)],v = [-sin(theta), cos(theta)]。

2.3.6 深度学习的几何解释

前面讲过,神经网络完全由一系列张量运算组成,而这些张量运算都只是输入数据的几何变换。因此,你可以将神经网络解释为高维空间中非常复杂的几何变换,这种变换可以通过许 多简单的步骤来实现。

对于三维的情况,下面这个思维图像是很有用的。想象有两张彩纸:一张红色,一张蓝色。

将其中一张纸放在另一张上。现在将两张纸一起揉成小球。这个皱巴巴的纸球就是你的输入数据,每张纸对应于分类问题中的一个类别。神经网络(或者任何机器学习模型)要做的就是找 到可以让纸球恢复平整的变换,从而能够再次让两个类别明确可分。通过深度学习,这一过程 可以用三维空间中一系列简单的变换来实现,比如你用手指对纸球做的变换,每次做一个动作, 如图 2-9 所示。

图 2-9 解开复杂的数据流形

让纸球恢复平整就是机器学习的内容:为复杂的、高度折叠的数据流形找到简洁的表示。 现在你应该能够很好地理解,为什么深度学习特别擅长这一点:它将复杂的几何变换逐步分解为一长串基本的几何变换,这与人类展开纸球所采取的策略大致相同。深度网络的每一层都通过变换使数据解开一点点——许多层堆叠在一起,可以实现非常复杂的解开过程。

2.4 神经网络的“引擎”:基于梯度的优化

上一节介绍过,我们的第一个神经网络示例中,每个神经层都用下述方法对输入数据进行 变换。

output = relu(dot(W, input) + b)

在这个表达式中,W 和 b 都是张量,均为该层的属性。它们被称为该层的权重(weight)或 可训练参数(trainable parameter),分别对应 kernel 和 bias 属性。这些权重包含网络从观察 训练数据中学到的信息。

一开始,这些权重矩阵取较小的随机值,这一步叫作随机初始化(random initialization)。 当然,W 和 b 都是随机的,relu(dot(W, input) + b) 肯定不会得到任何有用的表示。虽然得到的表示是没有意义的,但这是一个起点。下一步则是根据反馈信号逐渐调节这些权重。这个逐渐调节的过程叫作训练,也就是机器学习中的学习。

上述过程发生在一个训练循环(training loop)内,其具体过程如下。必要时一直重复这些 步骤。

- 抽取训练样本 x 和对应目标 y 组成的数据批量。

- 在 x 上运行网络[这一步叫作前向传播(

forward pass)],得到预测值y_pred。 - 计算网络在这批数据上的损失,用于衡量

y_pred和 y 之间的距离。 - 更新网络的所有权重,使网络在这批数据上的损失略微下降。

最终得到的网络在训练数据上的损失非常小,即预测值 y_pred 和预期目标 y 之间的距离 非常小。网络“学会”将输入映射到正确的目标。乍一看可能像魔法一样,但如果你将其简化为基本步骤,那么会变得非常简单。

第一步看起来非常简单,只是输入 / 输出(I/O)的代码。第二步和第三步仅仅是一些张量运算的应用,所以你完全可以利用上一节学到的知识来实现这两步。难点在于第四步:更新网络的权重。考虑网络中某个权重系数,你怎么知道这个系数应该增大还是减小,以及变化多少?

一种简单的解决方案是,保持网络中其他权重不变,只考虑某个标量系数,让其尝试不同的取值。假设这个系数的初始值为 0.3。对一批数据做完前向传播后,网络在这批数据上的损失是 0.5。如果你将这个系数的值改为 0.35 并重新运行前向传播,损失会增大到 0.6。但如果你将 这个系数减小到 0.25,损失会减小到 0.4。在这个例子中,将这个系数减小 0.05 似乎有助于使损失最小化。对于网络中的所有系数都要重复这一过程。

但这种方法是非常低效的,因为对每个系数(系数很多,通常有上千个,有时甚至多达上百万个)都需要计算两次前向传播(计算代价很大)。一种更好的方法是利用网络中所有运算都是可微(differentiable)的这一事实,计算损失相对于网络系数的梯度(gradient),然后向梯度 的反方向改变系数,从而使损失降低。

如果你已经了解可微和梯度这两个概念,可以直接跳到 2.4.3 节。如果不了解,下面两小节 有助于你理解这些概念。

2.4.1 什么是导数

假设有一个连续的光滑函数 f(x) = y,将实数 x 映射为另一个实数 y。由于函数是连续的, x 的微小变化只能导致 y 的微小变化——这就是函数连续性的直观解释。假设 x 增大了一个很小的因子 epsilon_x,这导致 y 也发生了很小的变化,即 epsilon_y:

f(x + epsilon_x) = y + epsilon_y

此外,由于函数是光滑的(即函数曲线没有突变的角度),在某个点 p 附近,如果 epsilon_x 足够小,就可以将 f 近似为斜率为 a 的线性函数,这样 epsilon_y 就变成了 a * epsilon_x:

f(x + epsilon_x) = y + a * epsilon_x

显然,只有在 x 足够接近 p 时,这个线性近似才有效。

斜率 a 被称为 f 在 p 点的导数(derivative)。如果 a 是负的,说明 x 在 p 点附近的微小变化将导致 f(x) 减小(如图 2-10 所示);如果 a 是正的,那么 x 的微小变化将导致 f(x) 增大。 此外,a 的绝对值(导数大小)表示增大或减小的速度快慢。

图 2-10 f 在 p 点的导数

对于每个可微函数 f(x)(可微的意思是“可以被求导”。例如,光滑的连续函数可以被求导), 都存在一个导数函数 f'(x),将 x 的值映射为 f 在该点的局部线性近似的斜率。例如,cos(x) 的导数是 -sin(x),f(x) = a * x 的导数是 f'(x) = a,等等。

如果你想要将 x 改变一个小因子 epsilon_x,目的是将 f(x) 最小化,并且知道 f 的导数, 那么问题解决了:导数完全描述了改变 x 后 f(x) 会如何变化。如果你希望减小 f(x) 的值,只 需将 x 沿着导数的反方向移动一小步。

2.4.2 张量运算的导数:梯度

梯度(gradient)是_张量运算的导数_。它是导数这一概念向多元函数导数的推广。多元函数是以张量作为输入的函数。

假设有一个输入向量 x、一个矩阵 W、一个目标 y 和一个损失函数 loss。你可以用 W 来计算预测值 y_pred,然后计算损失,或者说预测值 y_pred 和目标 y 之间的距离。

y_pred = dot(W, x)

loss_value = loss(y_pred, y)

如果输入数据 x 和 y 保持不变,那么这可以看作将 W 映射到损失值的函数。

loss_value = f(W)

假设 W 的当前值为 W0。f 在 W0 点的导数是一个张量 gradient(f)(W0),其形状与 W 相同, 每个系数 gradient(f)(W0)[i, j] 表示改变 W0[i, j] 时 loss_value 变化的方向和大小。 张量 gradient(f)(W0) 是函数 f(W) = loss_value 在 W0 的导数。

前面已经看到,单变量函数 f(x) 的导数可以看作函数 f 曲线的斜率。同样,gradient(f) (W0) 也可以看作表示 f(W) 在 W0 附近曲率(curvature)的张量。

对于一个函数 f(x),你可以通过将 x 向导数的反方向移动一小步来减小 f(x) 的值。同 样,对于张量的函数 f(W),你也可以通过将 W 向梯度的反方向移动来减小 f(W),比如 W1 = W0 - step * gradient(f)(W0),其中 step 是一个很小的比例因子。也就是说,沿着曲率的反方向移动,直观上来看在曲线上的位置会更低。注意,比例因子 step 是必需的,因为 gradient(f)(W0) 只是 W0 附近曲率的近似值,不能离 W0 太远。

2.4.3 随机梯度下降

给定一个可微函数,理论上可以用解析法找到它的最小值:函数的最小值是导数为 0 的点, 因此你只需找到所有导数为 0 的点,然后计算函数在其中哪个点具有最小值。

将这一方法应用于神经网络,就是用解析法求出最小损失函数对应的所有权重值。可以通过对方程 gradient(f)(W) = 0 求解 W 来实现这一方法。这是包含 N 个变量的多项式方程, 其中 N 是网络中系数的个数。N=2 或 N=3 时可以对这样的方程求解,但对于实际的神经网络是 无法求解的,因为参数的个数不会少于几千个,而且经常有上千万个。

相反,你可以使用 2.4 节开头总结的四步算法:基于当前在随机数据批量上的损失,一点一点地对参数进行调节。由于处理的是一个可微函数,你可以计算出它的梯度,从而有效地实 现第四步。沿着梯度的反方向更新权重,损失每次都会变小一点。

- 抽取训练样本 x 和对应目标 y 组成的数据批量。

- 在 x 上运行网络,得到预测值 y_pred。

- 计算网络在这批数据上的损失,用于衡量 y_pred 和 y 之间的距离。

- 计算损失相对于网络参数的梯度[一次反向传播(backward pass)]。

- 将参数沿着梯度的反方向移动一点,比如 W -= step * gradient,从而使这批数据上的损失减小一点。

这很简单!我刚刚描述的方法叫作小批量随机梯度下降(mini-batch stochastic gradient descent, 又称为小批量 SGD)。术语随机(stochastic)是指每批数据都是随机抽取的(stochastic 是 random 在科学上的同义词 a)。图 2-11 给出了一维的情况,网络只有一个参数,并且只有一个训练样本。

图 2-11 沿着一维损失函数曲线的随机梯度下降(一个需要学习的参数)

如你所见,直观上来看,为 step 因子选取合适的值是很重要的。如果取值太小,则沿着曲线的下降需要很多次迭代,而且可能会陷入局部极小点。如果取值太大,则更新权重值之后 可能会出现在曲线上完全随机的位置。

注意,小批量 SGD 算法的一个变体是每次迭代时只抽取一个样本和目标,而不是抽取一批数据。这叫作真 SGD(有别于小批量 SGD)。还有另一种极端,每一次迭代都在所有数据上运行,这叫作批量 SGD。这样做的话,每次更新都更加准确,但计算代价也高得多。这两个极端之间的有效折中则是选择合理的批量大小。

图 2-11 描述的是一维参数空间中的梯度下降,但在实践中需要在高维空间中使用梯度下降。 神经网络的每一个权重参数都是空间中的一个自由维度,网络中可能包含数万个甚至上百万个参数维度。为了让你对损失曲面有更直观的认识,你还可以将梯度下降沿着二维损失曲面可视化, 如图 2-12 所示。但你不可能将神经网络的实际训练过程可视化,因为你无法用人类可以理解的方式来可视化 1000000 维空间。因此最好记住,在这些低维表示中形成的直觉在实践中不一定 总是准确的。这在历史上一直是深度学习研究的问题来源。

图 2-12 沿着二维损失曲面的梯度下降(两个需要学习的参数)

此外,SGD 还有多种变体,其区别在于计算下一次权重更新时还要考虑上一次权重更新, 而不是仅仅考虑当前梯度值,比如带动量的 SGD、Adagrad、RMSProp 等变体。这些变体被称为优化方法(optimization method)或优化器(optimizer)。其中动量的概念尤其值得关注,它在许多变体中都有应用。动量解决了 SGD 的两个问题:收敛速度和局部极小点。图 2-13 给出了 损失作为网络参数的函数的曲线。

图 2-13 局部极小点和全局最小点

如你所见,在某个参数值附近,有一个局部极小点(local minimum):在这个点附近,向 左移动和向右移动都会导致损失值增大。如果使用小学习率的 SGD 进行优化,那么优化过程可 能会陷入局部极小点,导致无法找到全局最小点。

使用动量方法可以避免这样的问题,这一方法的灵感来源于物理学。有一种有用的思维图像, 就是将优化过程想象成一个小球从损失函数曲线上滚下来。如果小球的动量足够大,那么它不会 卡在峡谷里,最终会到达全局最小点。动量方法的实现过程是每一步都移动小球,不仅要考虑当 前的斜率值(当前的加速度),还要考虑当前的速度(来自于之前的加速度)。这在实践中的是指, 更新参数 w 不仅要考虑当前的梯度值,还要考虑上一次的参数更新,其简单实现如下所示。

past_velocity = 0.

momentum = 0.1

while loss > 0.01:

w, loss, gradient = get_current_parameters()

velocity = past_velocity * momentum - learning_rate * gradient

w = w + momentum * velocity - learning_rate * gradient

past_velocity = velocity

update_parameter(w)

2.4.4 链式求导:反向传播算法

在前面的算法中,我们假设函数是可微的,因此可以明确计算其导数。在实践中,神经网 络函数包含许多连接在一起的张量运算,每个运算都有简单的、已知的导数。例如,下面这个 网络 f 包含 3 个张量运算 a、b 和 c,还有 3 个权重矩阵 W1、W2 和 W3。

f(W1, W2, W3) = a(W1, b(W2, c(W3)))

根据微积分的知识,这种函数链可以利用下面这个恒等式进行求导,它称为链式法则(chain rule):(f(g(x)))’ = f’(g(x)) * g’(x)。将链式法则应用于神经网络梯度值的计算,得到的算法叫作反向传播(backpropagation,有时也叫反式微分,reverse-mode differentiation)。反 向传播从最终损失值开始,从最顶层反向作用至最底层,利用链式法则计算每个参数对损失值 的贡献大小。

现在以及未来数年,人们将使用能够进行符号微分(symbolic differentiation)的现代框架来实现神经网络,比如 TensorFlow。也就是说,给定一个运算链,并且已知每个运算的导数,这些框架就可以利用链式法则来计算这个运算链的梯度函数,将网络参数值映射为梯度值。对于这样的函数,反向传播就简化为调用这个梯度函数。由于符号微分的出现,你无须手动实现反向传播算法。因此,我们不会在本节浪费你的时间和精力来推导反向传播的具体公式。你只需 充分理解基于梯度的优化方法的工作原理。

2.5 回顾第一个例子

你已经读到了本章最后一节,现在应该对神经网络背后的原理有了大致的了解。我们回头 看一下第一个例子,并根据前面三节学到的内容来重新阅读这个例子中的每一段代码。

下面是输入数据。

(train_images, train_labels), (test_images, test_labels) = mnist.load_data()

train_images = train_images.reshape((60000, 28 * 28))

train_images = train_images.astype('float32') / 255

test_images = test_images.reshape((10000, 28 * 28))

test_images = test_images.astype('float32') / 255

现在你明白了,输入图像保存在 float32 格式的 Numpy 张量中,形状分别为 (60000, 784)(训练数据)和 (10000, 784)(测试数据)。

下面是构建网络。

network = models.Sequential()

network.add(layers.Dense(512, activation='relu', input_shape=(28 * 28,)))

network.add(layers.Dense(10, activation='softmax'))

现在你明白了,这个网络包含两个 Dense 层,每层都对输入数据进行一些简单的张量运算, 这些运算都包含权重张量。权重张量是该层的属性,里面保存了网络所学到的知识(knowledge)。

下面是网络的编译。

network.compile(optimizer='rmsprop',

loss='categorical_crossentropy',

metrics=['accuracy'])

现在你明白了,categorical_crossentropy 是损失函数,是用于学习权重张量的反馈信号,在训练阶段应使它最小化。你还知道,减小损失是通过小批量随机梯度下降来实现的。 梯度下降的具体方法由第一个参数给定,即 rmsprop 优化器。

最后,下面是训练循环。

network.fit(train_images, train_labels, epochs=5, batch_size=128)

现在你明白在调用 fit 时发生了什么:网络开始在训练数据上进行迭代(每个小批量包含 128 个样本),共迭代 5 次[在所有训练数据上迭代一次叫作一个轮次(epoch)]。在每次迭代过程中,网络会计算批量损失相对于权重的梯度,并相应地更新权重。5 轮之后,网络进行了 2345 次梯度更新(每轮 469 次),网络损失值将变得足够小,使得网络能够以很高的精度对手写数字进行分类。

到目前为止,你已经了解了神经网络的大部分知识。

Python深度学习篇三《神经网络入门》

Excerpt

前言 前期回顾:Python深度学习篇二《神经网络的数学基础》 上面这篇里面写了深度学习的所需的基础知识。 好,接下来切入正题。 本章的目的是让你开始用神经网络来解决实际问题。你将进一步巩固在第2 章第一个示例 中学到的知识,还会将学到的知识应用于 …

前言

前期回顾:Python深度学习篇二《神经网络的数学基础》

上面这篇里面写了深度学习的所需的基础知识。

好,接下来切入正题。

本章的目的是让你开始用神经网络来解决实际问题。你将进一步巩固在第2 章第一个示例 中学到的知识,还会将学到的知识应用于三个新问题,这三个问题涵盖神经网络最常见的三种 使用场景:二分类问题、多分类问题和标量回归问题。

本章将进一步介绍神经网络的核心组件,即层、网络、目标函数和优化器;还会简要介绍 Keras,它是贯穿本书的Python 深度学习库。你还将建立深度学习工作站,安装好TensorFlow 和Keras,并支持GPU。最后,我们将用三个介绍性示例深入讲解如何使用神经网络解决实际问题, 这三个示例分别是:

- 将电影评论划分为正面或负面(二分类问题)

- 将新闻按主题分类(多分类问题)

- 根据房地产数据估算房屋价格(回归问题)

学完本章,你将能够使用神经网络解决简单的机器问题,比如对向量数据的分类问题和回归问题。然后,你就可以从第 4 章开始建立对机器学习更加具有原则性、理论性的理解。

3.1 神经网络剖析

前面几章介绍过,训练神经网络主要围绕以下四个方面。

- 层,多个层组合成网络(或模型)。

- 输入数据和相应的目标。

- 损失函数,即用于学习的反馈信号。

- 优化器,决定学习过程如何进行。

你可以将这四者的关系可视化,如图3-1 所示:多个层链接在一起组成了网络,将输入数据映射为预测值。然后损失函数将这些预测值与目标进行比较,得到损失值,用于衡量网络预 测值与预期结果的匹配程度。优化器使用这个损失值来更新网络的权重。

![]()

图 3-1 网络、层、损失函数和优化器之间的关系

我们来进一步研究层、网络、损失函数和优化器。

3.1.1 层:深度学习的基础组件

我们在第2章中介绍过,神经网络的基本数据结构是层。层是一个数据处理模块,将一个或多个输入张量转换为一个或多个输出张量。有些层是无状态的,但大多数的层是有状态的,即层的权重。权重是利用随机梯度下降学到的一个或多个张量,其中包含网络的知识。

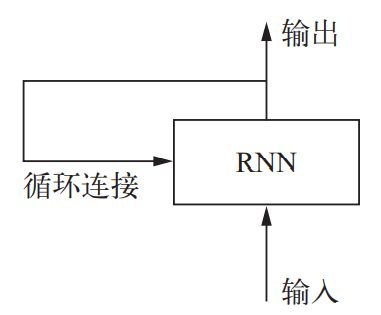

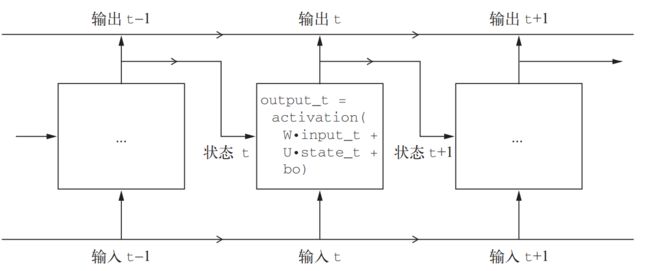

不同的张量格式与不同的数据处理类型需要用到不同的层。例如,简单的向量数据保存在形状为 (samples, features) 的 2D 张量中,通常用密集连接层[densely connected layer,也叫全连接层(fully connected layer)或密集层(dense layer),对应于Keras 的 Dense 类]来处理。序列数据保存在形状为 (samples, timesteps, features) 的 3D 张量中,通常用循环层(recurrent layer,比如Keras 的 LSTM 层)来处理。图像数据保存在4D 张量中,通常用二维卷积层(Keras 的 Conv2D)来处理。

你可以将层看作深度学习的乐高积木,Keras 等框架则将这种比喻具体化。在 Keras 中,构 建深度学习模型就是将相互兼容的多个层拼接在一起,以建立有用的数据变换流程。这里层兼 容性(layer compatibility)具体指的是每一层只接受特定形状的输入张量,并返回特定形状的输 出张量。看看下面这个例子。

from keras import layers

layer = layers.Dense(32, input_shape=(784,))

我们创建了一个层,只接受第一个维度大小为784 的 2D 张量(第0 轴是批量维度,其大小没有指定,因此可以任意取值)作为输入。这个层将返回一个张量,第一个维度的大小变成 了 32。

因此,这个层后面只能连接一个接受32 维向量作为输入的层。使用Keras 时,你无须担心兼容性,因为向模型中添加的层都会自动匹配输入层的形状,例如下面这段代码。

from keras import models

from keras import layers

model = models.Sequential()

model.add(layers.Dense(32, input_shape=(784,)))

model.add(layers.Dense(32))

其中第二层没有输入形状(input_shape)的参数,相反,它可以自动推导出输入形状等 于上一层的输出形状。

3.1.2 模型:层构成的网络

深度学习模型是层构成的有向无环图。最常见的例子就是层的线性堆叠,将单一输入映射为单一输出。

但随着深入学习,你会接触到更多类型的网络拓扑结构。一些常见的网络拓扑结构如下。

- 双分支(two-branch)网络

- 多头(multihead)网络

- Inception 模块

网络的拓扑结构定义了一个假设空间(hypothesis space)。你可能还记得第1章里 机器学习 的定义:“在预先定义好的可能性空间中,利用反馈信号的指引来寻找输入数据的有用表示。” 选定了网络拓扑结构,意味着将可能性空间(假设空间)限定为一系列特定的张量运算,将输入数据映射为输出数据。然后,你需要为这些张量运算的权重张量找到一组合适的值。

选择正确的网络架构更像是一门艺术而不是科学。虽然有一些最佳实践和原则,但只有动手实践才能让你成为合格的神经网络架构师。后面几章将教你构建神经网络的详细原则,也会帮你建立直觉,明白对于特定问题哪些架构有用、哪些架构无用。

3.1.3 损失函数与优化器:配置学习过程的关键

一旦确定了网络架构,你还需要选择以下两个参数。

- 损失函数(目标函数)——在训练过程中需要将其最小化。它能够衡量当前任务是否已 成功完成。

- 优化器——决定如何基于损失函数对网络进行更新。它执行的是随机梯度下降(SGD) 的某个变体。

具有多个输出的神经网络可能具有多个损失函数(每个输出对应一个损失函数)。但是,梯度下降过程必须基于单个标量损失值。因此,对于具有多个损失函数的网络,需要将所有损失函数取平均,变为一个标量值。

选择正确的目标函数对解决问题是非常重要的。网络的目的是使损失尽可能最小化,因此, 如果目标函数与成功完成当前任务不完全相关,那么网络最终得到的结果可能会不符合你的预期。想象一下,利用 SGD 训练一个愚蠢而又无所不能的人工智能,给它一个蹩脚的目标函数:“将所有活着的人的平均幸福感最大化”。为了简化自己的工作,这个人工智能可能会选择杀死绝大多数人类,只留几个人并专注于这几个人的幸福——因为平均幸福感并不受人数的影响。这可能并不是你想要的结果!请记住,你构建的所有神经网络在降低损失函数时和上述的人工智能 一样无情。因此,一定要明智地选择目标函数,否则你将会遇到意想不到的副作用。

幸运的是,对于分类、回归、序列预测等常见问题,你可以遵循一些简单的指导原则来选 择正确的损失函数。例如,对于二分类问题,你可以使用二元交叉熵(binary crossentropy)损 失函数;对于多分类问题,可以用分类交叉熵(categorical crossentropy)损失函数;对于回归 问题,可以用均方误差(mean-squared error)损失函数;对于序列学习问题,可以用联结主义 时序分类(CTC,connectionist temporal classification)损失函数,等等。只有在面对真正全新的 研究问题时,你才需要自主开发目标函数。在后面几章里,我们将详细说明对于各种常见任务,应选择哪种损失函数。

3.2 Keras 简介

本书的代码示例全都使用Keras 实现。Keras 是一个Python 深度学习框架,可以方便地定 义和训练几乎所有类型的深度学习模型。Keras 最开始是为研究人员开发的,其目的在于快速实验。

Keras 具有以下重要特性。

- 相同的代码可以在 CPU 或 GPU 上无缝切换运行。

- 具有用户友好的 API,便于快速开发深度学习模型的原型。

- 内置支持卷积网络(用于计算机视觉)、循环网络(用于序列处理)以及二者的任意 组合。

- 支持任意网络架构:多输入或多输出模型、层共享、模型共享等。这也就是说,Keras 能够构建任意深度学习模型,无论是生成式对抗网络还是神经图灵机。

Keras 基于宽松的 MIT 许可证发布,这意味着可以在商业项目中免费使用它。它与所有版本的 Python 都兼容(截至 2017 年年中,从 Python 2.7 到 Python 3.6 都兼容)。

Keras 已有200 000 多个用户,既包括创业公司和大公司的学术研究人员和工程师,也包括 研究生和业余爱好者。Google、Netflix、Uber、CERN、Yelp、Square 以及上百家创业公司都在用 Keras 解决各种各样的问题。Keras 还是机器学习竞赛网站 Kaggle 上的热门框架,最新的深 度学习竞赛中,几乎所有的优胜者用的都是 Keras 模型,如图 3-2 所示。

![]()

图 3-2 不同深度学习框架的 Google 网页搜索热度的变化趋势

3.2.1 Keras、TensorFlow、Theano 和 CNTK

Keras 是一个模型级(model-level)的库,为开发深度学习模型提供了高层次的构建模块。 它不处理张量操作、求微分等低层次的运算。相反,它依赖于一个专门的、高度优化的张量库来完成这些运算,这个张量库就是Keras 的后端引擎(backend engine)。 Keras 没有选择单个张量库并将Keras 实现与这个库绑定,而是以模块化的方式处理这个问题(见图3-3)。因此,几个不同的后端引擎都可以无缝嵌入到 Keras 中。目前,Keras 有三个后端实现:TensorFlow 后端、 Theano 后端和微软认知工具包(CNTK,Microsoft cognitive toolkit)后端。未来 Keras 可能会扩 展到支持更多的深度学习引擎。

![]()

图 3-3 深度学习的软件栈和硬件栈

TensorFlow、CNTK 和 Theano 是当今深度学习的几个主要平台。Theano 由蒙特利尔大学的 MILA 实验室开发,TensorFlow 由 Google 开发,CNTK 由微软开发。你用 Keras 写的每一段代码都可以在这三个后端上运行,无须任何修改。也就是说,你在开发过程中可以在两个后端之 间无缝切换,这通常是很有用的。例如,对于特定任务,某个后端的速度更快,那么我们就可以无缝切换过去。我们推荐使用TensorFlow 后端作为大部分深度学习任务的默认后端,因为它的应用最广泛,可扩展,而且可用于生产环境。

通过 TensorFlow(或 Theano、CNTK), Keras 可以在 CPU 和GPU 上无缝运行。在 CPU 上运行 时,TensorFlow 本身封装了一个低层次的张量运算库,叫作Eigen;在GPU 上运行时,TensorFlow 封装了一个高度优化的深度学习运算库,叫作 NVIDIA CUDA 深度神经网络库(cuDNN)。

3.2.2 使用 Keras 开发:概述

你已经见过一个Keras 模型的示例,就是 MNIST 的例子。典型的Keras 工作流程就和那个 例子类似。

- 定义训练数据:输入张量和目标张量。

- 定义层组成的网络(或模型),将输入映射到目标。

- 配置学习过程:选择损失函数、优化器和需要监控的指标。

- 调用模型的 fit 方法在训练数据上进行迭代。

定义模型有两种方法:

一种是使用 Sequential 类(仅用于层的线性堆叠,这是目前最常 见的网络架构),另一种是函数式 API(functional API,用于层组成的有向无环图,让你可以构 建任意形式的架构)。

前面讲过,这是一个利用 Sequential 类定义的两层模型(注意,我们向第一层传入了输入数据的预期形状)。

from keras import models

from keras import layers

model = models.Sequential()

model.add(layers.Dense(32, activation='relu', input_shape=(784,)))

model.add(layers.Dense(10, activation='softmax'))

下面是用函数式 API 定义的相同模型。

input_tensor = layers.Input(shape=(784,))

x = layers.Dense(32, activation='relu')(input_tensor)

output_tensor = layers.Dense(10, activation='softmax')(x)

model = models.Model(inputs=input_tensor, outputs=output_tensor)

利用函数式API,你可以操纵模型处理的数据张量,并将层应用于这个张量,就好像这些 层是函数一样。

注意 第7章有关于函数式 API 的详细指南。在那之前,我们的代码示例中只会用到 Sequential 类。

一旦定义好了模型架构,使用 Sequential 模型还是函数式API 就不重要了。接下来的步 骤都是相同的。

配置学习过程是在编译这一步,你需要指定模型使用的优化器和损失函数,以及训练过程中想要监控的指标。下面是单一损失函数的例子,这也是目前最常见的。

from keras import optimizers

model.compile(optimizer=optimizers.RMSprop(lr=0.001),

loss='mse',

metrics=['accuracy'])

最后,学习过程就是通过 fit() 方法将输入数据的 Numpy 数组(和对应的目标数据)传 入模型,这一做法与 Scikit-Learn 及其他机器学习库类似。

model.fit(input_tensor, target_tensor, batch_size=128, epochs=10)

在接下来的几章里,你将会在这些问题上培养可靠的直觉:哪种类型的网络架构适合解决 哪种类型的问题?如何选择正确的学习配置?如何调节模型使其给出你想要的结果?我们将在 3.4~3.6 节讲解三个基本示例,分别是二分类问题、多分类问题和回归问题。

3.3 建立深度学习工作站

在开始开发深度学习应用之前,你需要建立自己的深度学习工作站。虽然并非绝对必要, 但强烈推荐你在现代NVIDIA GPU 上运行深度学习实验。某些应用,特别是卷积神经网络的图 像处理和循环神经网络的序列处理,在 CPU 上的速度非常之慢,即使是高速多核 CPU 也是如此。 即使是可以在 CPU 上运行的深度学习应用,使用现代 GPU 通常也可以将速度提高 5 倍或 10 倍。 如果你不想在计算机上安装 GPU,也可以考虑在 AWS EC2 GPU 实例或 Google 云平台上运行深 度学习实验。但请注意,时间一长,云端 GPU 实例可能会变得非常昂贵。

无论在本地还是在云端运行,最好都使用 UNIX 工作站。虽然从技术上来说可以在 Windows 上使用 Keras(Keras 的三个后端都支持 Windows),但我们不建议这么做。在附录 A 的安装说明中, 我们以安装了 Ubuntu 的计算机为例。如果你是Windows 用户,最简单的解决方案就是安装 Ubuntu 双系统。这看起来可能有点麻烦,但从长远来看,使用 Ubuntu 将会为你省去大量时间和麻烦。 注意,使用 Keras 需要安装 TensorFlow、CNTK 或Theano(如果你希望能够在三个后端之间 来回切换,那么可以安装三个)。本书将重点介绍TensorFlow,并简要介绍一下Theano,不会涉及CNTK。

3.3.1 Jupyter 笔记本:运行深度学习实验的首选方法

Jupyter 笔记本是运行深度学习实验的好方法,特别适合运行本书中的许多代码示例。它广 泛用于数据科学和机器学习领域。笔记本(notebook)是Jupyter Notebook 应用生成的文件,可以在浏览器中编辑。它可以执行Python代码,还具有丰富的文本编辑功能,可以对代码进行注释。 笔记本还可以将冗长的实验代码拆分为可独立执行的短代码,这使得开发具有交互性,而且如果后面的代码出现问题,你也不必重新运行前面的所有代码。

我们推荐使用Jupyter 笔记本来上手Keras,虽然这并不是必需的。你也可以运行独立的 Python 脚本,或者在IDE(比如PyCharm)中运行代码。本书所有代码示例都以开源笔记本的 形式提供,你可以在本书网站上下载:https://www.manning.com/books/deep-learning-with-python。

3.3.2 运行 Keras:两种选择

想要在实践中使用 Keras,我们推荐以下两种方式。

- 使用官方的 EC2 深度学习

Amazon系统映像(AMI),并在EC2上以Jupyter笔记本的方式运行Keras 实验。如果你的本地计算机上没有GPU,你可以选择这种方式。附录B 给 出了详细指南。 - 在本地UNIX 工作站上从头安装。然后你可以运行本地Jupyter 笔记本或常规的Python 代码库。如果你已经拥有了高端的NVIDIA GPU,可以选择这种方式。附录A 给出了基于 Ubuntu 的详细安装指南。

3.3.3 在云端运行深度学习任务:优点和缺点

如果你还没有可用于深度学习的GPU(即最新的高端NVIDIA GPU),那么在云端运行深度学习实验是一种简单又低成本的方法,让你无须额外购买硬件就可以上手。如果你使用 Jupyter 笔记本,那么在云端运行的体验与在本地运行完全相同。截至 2017 年年中,最容易上手 深度学习的云产品肯定是 AWS EC2。附录 B 给出了在 EC2 GPU 实例上运行 Jupyter 笔记本的详细指南。

但如果你是深度学习的重度用户,从长期来看这种方案是难以持续的,甚至几个星期都不行。EC2 实例的价格很高:附录B 推荐的实例(p2.xlarge 实例,计算能力一般)在2017 年 年中的价格是每小时0.90 美元。与此相对的是,一款可靠的消费级GPU 价格在1000~1500 美 元——这个价格一直相当稳定,而这种GPU 的性能则在不断提高。如果你准备认真从事深度学 习,那么应该建立具有一块或多块 GPU 的本地工作站。

简而言之,EC2 是很好的上手方法。你完全可以在EC2 GPU 实例上运行本书的代码示例。 但如果你想成为深度学习的高手,那就自己买 GPU。

3.3.4 深度学习的最佳 GPU

如果你准备买一块GPU,应该选择哪一款呢?首先要注意,一定要买NVIDIA GPU。 NVIDIA 是目前唯一一家在深度学习方面大规模投资的图形计算公司,现代深度学习框架只能 在 NVIDIA 显卡上运行。

截至2017 年年中,我们推荐NVIDIA TITAN Xp 为市场上用于深度学习的最佳显卡。如果预算较少,你也可以考虑GTX 1060。如果你读到本节的时间是在2018 年或更晚,请花点时间在网上查找最新的推荐,因为每年都会推出新的模型。

从这一节开始,我们将认为你的计算机已经安装好Keras 及其依赖,最好支持GPU。在继续阅读之前请确认已经完成此步骤。阅读附录中的详细指南,还可以在网上搜索进一步的帮助。 安装 Keras 及常见的深度学习依赖的教程有很多。

下面我们将深入讲解 Keras 示例。

3.4 电影评论分类:二分类问题

二分类问题可能是应用最广泛的机器学习问题。在这个例子中,你将学习根据电影评论的 文字内容将其划分为正面或负面。

3.4.1 IMDB 数据集

本节使用IMDB 数据集,它包含来自互联网电影数据库(IMDB)的50000 条严重两极分 化的评论。数据集被分为用于训练的 25 000 条评论与用于测试的 25 000 条评论,训练集和测试 集都包含 50% 的正面评论和 50% 的负面评论。

为什么要将训练集和测试集分开?因为你不应该将训练机器学习模型的同一批数据再用于测试模型!模型在训练数据上的表现很好,并不意味着它在前所未见的数据上也会表现得很好, 而且你真正关心的是模型在新数据上的性能(因为你已经知道了训练数据对应的标签,显然不再需要模型来进行预测)。例如,你的模型最终可能只是记住了训练样本和目标值之间的映射关系,但这对在前所未见的数据上进行预测毫无用处。下一章将会更详细地讨论这一点。

与 MNIST 数据集一样,IMDB 数据集也内置于 Keras 库。它已经过预处理:评论(单词序列) 已经被转换为整数序列,其中每个整数代表字典中的某个单词。

下列代码将会加载 IMDB 数据集(第一次运行时会下载大约 80MB 的数据)。

代码清单 3-1 加载 IMDB 数据集

from keras.datasets import imdb

(train_data, train_labels), (test_data, test_labels) = imdb.load_data( num_words=10000)

参数 num_words=10000 的意思是仅保留训练数据中前10 000 个最常出现的单词。低频单 词将被舍弃。这样得到的向量数据不会太大,便于处理。

train_data 和 test_data 这两个变量都是评论组成的列表,每条评论又是单词索引组成 的列表(表示一系列单词)。train_labels 和 test_labels 都是0 和 1 组成的列表,其中0 代表负面(negative), 1 代表正面(positive)。

>>> train_data[0] [1, 14, 22, 16, ... 178, 32]

>>> train_labels[0] 1

由于限定为前 10 000 个最常见的单词,单词索引都不会超过 10 000。

>>> max([max(sequence) for sequence in train_data]) 9999

下面这段代码很有意思,你可以将某条评论迅速解码为英文单词。

word_index = imdb.get_word_index()

reverse_word_index = dict([(value, key) for (key, value) in word_index.items()])

decoded_review = ' '.join([reverse_word_index.get(i - 3, '?') for i in train_data[0]])

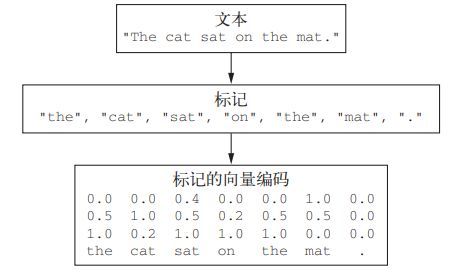

3.4.2 准备数据

你不能将整数序列直接输入神经网络。你需要将列表转换为张量。转换方法有以下两种。

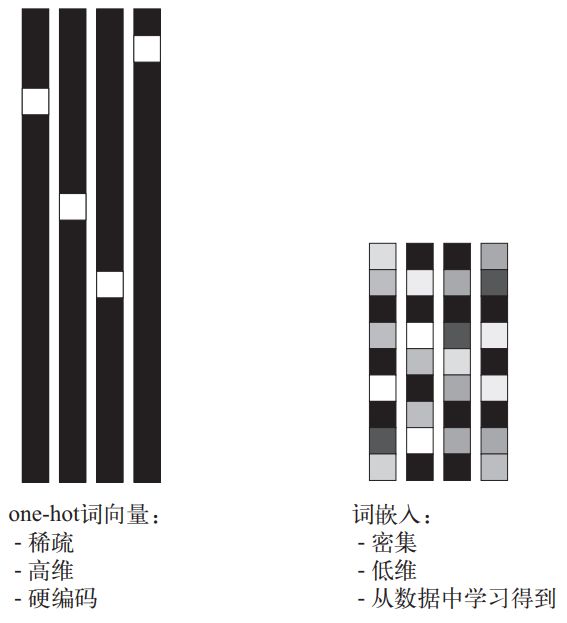

- 填充列表,使其具有相同的长度,再将列表转换成形状为 (samples, word_indices) 的整数张量,然后网络第一层使用能处理这种整数张量的层(即 Embedding 层,本书 后面会详细介绍)。

- 对列表进行 one-hot 编码,将其转换为 0 和 1 组成的向量。举个例子,序列 [3, 5] 将会 被转换为10 000 维向量,只有索引为3 和 5 的元素是1,其余元素都是0。然后网络第 一层可以用 Dense 层,它能够处理浮点数向量数据。

下面我们采用后一种方法将数据向量化。为了加深理解,你可以手动实现这一方法,如下 所示。

代码清单 3-2 将整数序列编码为二进制矩阵

import numpy as np

def vectorize_sequences(sequences, dimension=10000):

results = np.zeros((len(sequences), dimension))

for i, sequence in enumerate(sequences):

results[i, sequence] = 1.

return results

x_train = vectorize_sequences(train_data)

x_test = vectorize_sequences(test_data)

样本现在变成了这样:

>>> x_train[0]

array([ 0., 1., 1., ..., 0., 0., 0.])

你还应该将标签向量化,这很简单。

y_train = np.asarray(train_labels).astype('float32')

y_test = np.asarray(test_labels).astype('float32')

现在可以将数据输入到神经网络中。

3.4.3 构建网络

输入数据是向量,而标签是标量(1 和 0),这是你会遇到的最简单的情况。有一类网络在这种问题上表现很好,就是带有relu 激活的全连接层(Dense)的简单堆叠,比如 Dense(16, activation=‘relu’)。

传入 Dense 层的参数(16)是该层隐藏单元的个数。一个隐藏单元(hidden unit)是该层 表示空间的一个维度。我们在第2 章讲过,每个带有 relu 激活的 Dense 层都实现了下列张量 运算:

output = relu(dot(W, input) + b)

16 个隐藏单元对应的权重矩阵 W 的形状为 (input_dimension, 16),与 W 做点积相当于 将输入数据投影到16 维表示空间中(然后再加上偏置向量 b 并应用 relu 运算)。你可以将表 示空间的维度直观地理解为“网络学习内部表示时所拥有的自由度”。隐藏单元越多(即更高维 的表示空间),网络越能够学到更加复杂的表示,但网络的计算代价也变得更大,而且可能会导 致学到不好的模式(这种模式会提高训练数据上的性能,但不会提高测试数据上的性能)。

对于这种 Dense 层的堆叠,你需要确定以下两个关键架构:

- 网络有多少层;

- 每层有多少个隐藏单元。

第 4 章中的原则将会指导你对上述问题做出选择。现在你只需要相信我选择的下列架构:

- 两个中间层,每层都有 16 个隐藏单元;

- 第三层输出一个标量,预测当前评论的情感。

中间层使用 relu 作为激活函数,最后一层使用 sigmoid 激活以输出一个 0~1 范围内的概率 值(表示样本的目标值等于1 的可能性,即评论为正面的可能性)。relu(rectified linear unit, 整流线性单元)函数将所有负值归零(见图3-4),而 sigmoid 函数则将任意值“压缩”到 [0, 1] 区间内(见图 3-5),其输出值可以看作概率值。

![]()

图 3-4 整流线性单元函数

![]()

图 3-5 sigmoid 函数

图 3-6 显示了网络的结构。代码清单 3-3 是其 Keras 实现,与前面见过的 MNIST 例子类似。

![]()

图 3-6 三层网络

代码清单 3-3 模型定义

from keras import models

from keras import layers

model = models.Sequential() model.add(layers.Dense(16, activation='relu', input_shape=(10000,)))

model.add(layers.Dense(16, activation='relu')) model.add(layers.Dense(1, activation='sigmoid'))

什么是激活函数?为什么要使用激活函数?

如果没有 relu 等激活函数(也叫非线性), Dense 层将只包含两个线性运算——点积 和加法:

output = dot(W, input) + b

这样 Dense 层就只能学习输入数据的线性变换(仿射变换):该层的假设空间是从输 入数据到16 位空间所有可能的线性变换集合。这种假设空间非常有限,无法利用多个表示 层的优势,因为多个线性层堆叠实现的仍是线性运算,添加层数并不会扩展假设空间。 为了得到更丰富的假设空间,从而充分利用多层表示的优势,你需要添加非线性或激 活函数。relu 是深度学习中最常用的激活函数,但还有许多其他函数可选,它们都有类似 的奇怪名称,比如 prelu、elu 等。

最后,你需要选择损失函数和优化器。由于你面对的是一个二分类问题,网络输出是一 个概率值(网络最后一层使用sigmoid 激活函数,仅包含一个单元),那么最好使用 binary crossentropy(二元交叉熵)损失。这并不是唯一可行的选择,比如你还可以使用mean squared_error(均方误差)。但对于输出概率值的模型,交叉熵(crossentropy)往往是最好 的选择。交叉熵是来自于信息论领域的概念,用于衡量概率分布之间的距离,在这个例子中就 是真实分布与预测值之间的距离。

下面的步骤是用 rmsprop 优化器和 binary_crossentropy 损失函数来配置模型。注意, 我们还在训练过程中监控精度。

代码清单 3-4 编译模型

model.compile(optimizer='rmsprop',

loss='binary_crossentropy',

metrics=['accuracy'])

上述代码将优化器、损失函数和指标作为字符串传入,这是因为rmsprop、binary_ crossentropy 和 accuracy 都是Keras 内置的一部分。有时你可能希望配置自定义优化器的 参数,或者传入自定义的损失函数或指标函数。前者可通过向 optimizer 参数传入一个优化器 类实例来实现,如代码清单 3-5 所示;后者可通过向 loss 和 metrics 参数传入函数对象来实现, 如代码清单 3-6 所示。

代码清单 3-5 配置优化器

from keras import optimizers

model.compile(optimizer=optimizers.RMSprop(lr=0.001),

loss='binary_crossentropy',

metrics=['accuracy'])

代码清单 3-6 使用自定义的损失和指标

from keras import losses

from keras import metrics

model.compile(optimizer=optimizers.RMSprop(lr=0.001),

loss=losses.binary_crossentropy,

metrics=[metrics.binary_accuracy])

3.4.4 验证你的方法

为了在训练过程中监控模型在前所未见的数据上的精度,你需要将原始训练数据留出 10 000 个样本作为验证集。

代码清单 3-7 留出验证集

x_val = x_train[:10000] partial_x_train = x_train[10000:]

y_val = y_train[:10000] partial_y_train = y_train[10000:]

现在使用512 个样本组成的小批量,将模型训练20 个轮次(即对 x_train 和 y_train 两 个张量中的所有样本进行20 次迭代)。与此同时,你还要监控在留出的 10 000 个样本上的损失 和精度。你可以通过将验证数据传入 validation_data 参数来完成。

代码清单 3-8 训练模型

model.compile(optimizer='rmsprop',

loss='binary_crossentropy',

metrics=['acc'])

history = model.fit(partial_x_train,

partial_y_train,

epochs=20,

batch_size=512,

validation_data=(x_val, y_val))

在 CPU 上运行,每轮的时间不到2 秒,训练过程将在20 秒内结束。每轮结束时会有短暂 的停顿,因为模型要计算在验证集的 10 000 个样本上的损失和精度。

注意,调用 model.fit() 返回了一个 History 对象。这个对象有一个成员 history,它 是一个字典,包含训练过程中的所有数据。我们来看一下。

>>> history_dict = history.history

>>> history_dict.keys()

dict_keys(['val_acc', 'acc', 'val_loss', 'loss'])

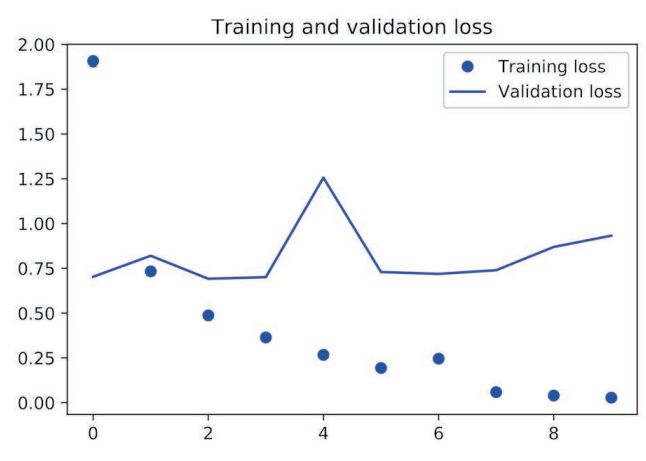

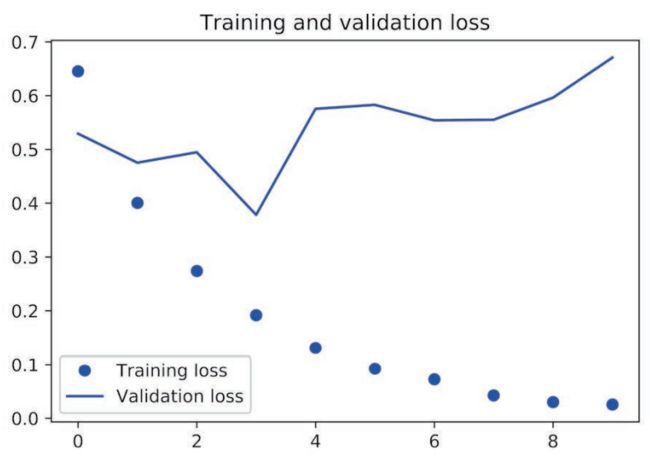

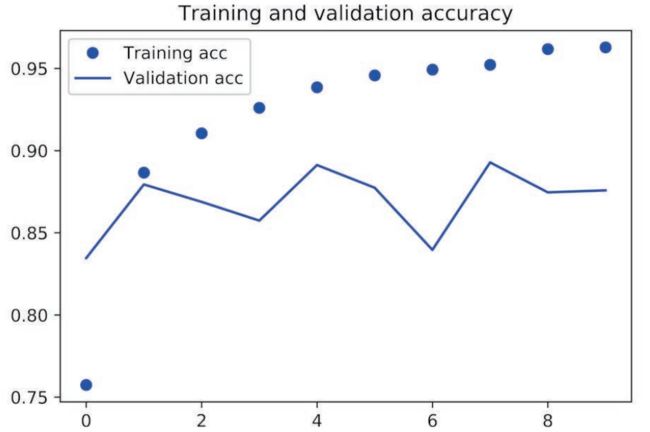

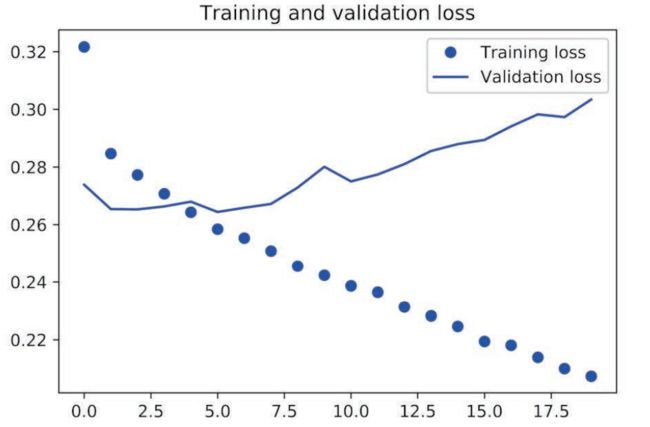

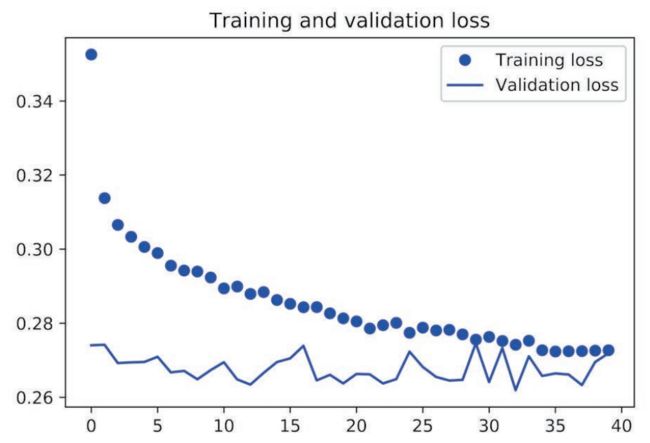

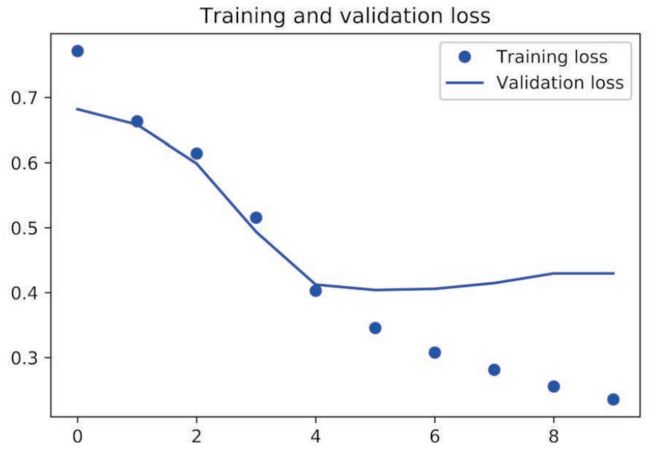

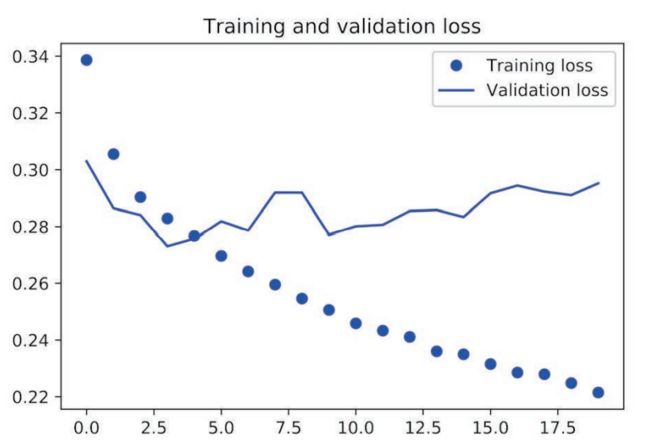

字典中包含4 个条目,对应训练过程和验证过程中监控的指标。在下面两个代码清单中, 我们将使用Matplotlib 在同一张图上绘制训练损失和验证损失(见图3-7),以及训练精度和验 证精度(见图 3-8)。请注意,由于网络的随机初始化不同,你得到的结果可能会略有不同。

代码清单 3-9 绘制训练损失和验证损失

import matplotlib.pyplot as plt

history_dict = history.history

loss_values = history_dict['loss']

val_loss_values = history_dict['val_loss']

epochs = range(1, len(loss_values) + 1)

plt.plot(epochs, loss_values, 'bo', label='Training loss')

plt.plot(epochs, val_loss_values, 'b', label='Validation loss')

plt.title('Training and validation loss')

plt.xlabel('Epochs')

plt.ylabel('Loss')

plt.legend()

plt.show()

![]()

图 3-7 训练损失和验证损失

代码清单 3-10 绘制训练精度和验证精度

plt.clf()

acc = history_dict['acc']

val_acc = history_dict['val_acc']

plt.plot(epochs, acc, 'bo', label='Training acc')

plt.plot(epochs, val_acc, 'b', label='Validation acc')

plt.title('Training and validation accuracy')

plt.xlabel('Epochs') plt.ylabel('Accuracy') plt.legend()

plt.show()

![]()

图 3-8 训练精度和验证精度

如你所见,训练损失每轮都在降低,训练精度每轮都在提升。这就是梯度下降优化的预期结果——你想要最小化的量随着每次迭代越来越小。但验证损失和验证精度并非如此:它们似乎在第四轮达到最佳值。这就是我们之前警告过的一种情况:模型在训练数据上的表现越来越好, 但在前所未见的数据上不一定表现得越来越好。准确地说,你看到的是过拟合(overfit):在第 二轮之后,你对训练数据过度优化,最终学到的表示仅针对于训练数据,无法泛化到训练集之外的数据。

在这种情况下,为了防止过拟合,你可以在3 轮之后停止训练。通常来说,你可以使用许 多方法来降低过拟合,我们将在第 4 章中详细介绍。

我们从头开始训练一个新的网络,训练 4 轮,然后在测试数据上评估模型。

代码清单 3-11 从头开始重新训练一个模型

model = models.Sequential()

model.add(layers.Dense(16, activation='relu', input_shape=(10000,)))

model.add(layers.Dense(16, activation='relu'))

model.add(layers.Dense(1, activation='sigmoid'))

model.compile(optimizer='rmsprop',

loss='binary_crossentropy',

metrics=['accuracy'])

model.fit(x_train, y_train, epochs=4, batch_size=512)

results = model.evaluate(x_test, y_test)

最终结果如下所示。

>>> results [0.2929924130630493, 0.88327999999999995]

这种相当简单的方法得到了 88% 的精度。利用最先进的方法,你应该能够得到接近 95% 的 精度。

3.4.5 使用训练好的网络在新数据上生成预测结果

训练好网络之后,你希望将其用于实践。你可以用 predict 方法来得到评论为正面的可能性大小。

>>> model.predict(x_test)

array([[ 0.98006207]

[ 0.99758697]

[ 0.99975556]

...,

[ 0.82167041]

[ 0.02885115]

[ 0.65371346]]

, dtype=float32)

如你所见,网络对某些样本的结果非常确信(大于等于 0.99,或小于等于 0.01),但对其他 结果却不那么确信(0.6 或 0.4)。

3.4.6 进一步的实验

通过以下实验,你可以确信前面选择的网络架构是非常合理的,虽然仍有改进的空间。

- 前面使用了两个隐藏层。你可以尝试使用一个或三个隐藏层,然后观察对验证精度和测 试精度的影响。

- 尝试使用更多或更少的隐藏单元,比如 32 个、64 个等。

- 尝试使用 mse 损失函数代替 binary_crossentropy。

- 尝试使用 tanh 激活(这种激活在神经网络早期非常流行)代替 relu。

3.4.7 小结

下面是你应该从这个例子中学到的要点。

- 通常需要对原始数据进行大量预处理,以便将其转换为张量输入到神经网络中。单词序 列可以编码为二进制向量,但也有其他编码方式。

- 带有 relu 激活的 Dense 层堆叠,可以解决很多种问题(包括情感分类),你可能会经 常用到这种模型。

- 对于二分类问题(两个输出类别),网络的最后一层应该是只有一个单元并使用 sigmoid 激活的 Dense 层,网络输出应该是 0~1 范围内的标量,表示概率值。

- 对于二分类问题的 sigmoid 标量输出,你应该使用 binary_crossentropy 损失函数。

- 无论你的问题是什么,rmsprop 优化器通常都是足够好的选择。这一点你无须担心。

- 随着神经网络在训练数据上的表现越来越好,模型最终会过拟合,并在前所未见的数据 上得到越来越差的结果。一定要一直监控模型在训练集之外的数据上的性能。

3.5 新闻分类:多分类问题

上一节中,我们介绍了如何用密集连接的神经网络将向量输入划分为两个互斥的类别。但如果类别不止两个,要怎么做?

本节你会构建一个网络,将路透社新闻划分为 46 个互斥的主题。因为有多个类别,所以 这是多分类(multiclass classification)问题的一个例子。因为每个数据点只能划分到一个类别, 所以更具体地说,这是单标签、多分类(single-label, multiclass classification)问题的一个例 子。如果每个数据点可以划分到多个类别(主题),那它就是一个多标签、多分类(multilabel, multiclass classification)问题。

3.5.1 路透社数据集

本节使用路透社数据集,它包含许多短新闻及其对应的主题,由路透社在 1986 年发布。它是一个简单的、广泛使用的文本分类数据集。它包括 46 个不同的主题:某些主题的样本更多, 但训练集中每个主题都有至少 10 个样本。

与 IMDB 和 MNIST 类似,路透社数据集也内置为 Keras 的一部分。我们来看一下。

代码清单 3-12 加载路透社数据集

from keras.datasets import reuters

(train_data, train_labels), (test_data, test_labels) = reuters.load_data(

num_words=10000)

与 IMDB 数据集一样,参数 num_words=10000 将数据限定为前 10 000 个最常出现的单词。 我们有 8982 个训练样本和 2246 个测试样本。

>>> len(train_data)

8982

>>> len(test_data)

2246

与 IMDB 评论一样,每个样本都是一个整数列表(表示单词索引)。

>>> train_data[10]

[1, 245, 273, 207, 156, 53, 74, 160, 26, 14, 46, 296, 26, 39, 74, 2979,

3554, 14, 46, 4689, 4329, 86, 61, 3499, 4795, 14, 61, 451, 4329, 17, 12]

如果好奇的话,你可以用下列代码将索引解码为单词。

代码清单 3-13 将索引解码为新闻文本

word_index = reuters.get_word_index()

reverse_word_index = dict([(value, key) for (key, value) in word_index.items()])

decoded_newswire = ' '.join([reverse_word_index.get(i - 3, '?') for i in

train_data[0]])

样本对应的标签是一个 0~45 范围内的整数,即话题索引编号。

>>> train_labels[10]

3

3.5.2 准备数据

你可以使用与上一个例子相同的代码将数据向量化。

代码清单 3-14 编码数据

import numpy as np

def vectorize_sequences(sequences, dimension=10000):

results = np.zeros((len(sequences), dimension))

for i, sequence in enumerate(sequences):

results[i, sequence] = 1.

return results

x_train = vectorize_sequences(train_data)

x_test = vectorize_sequences(test_data)

将标签向量化有两种方法:你可以将标签列表转换为整数张量,或者使用 one-hot 编码。 one-hot 编码是分类数据广泛使用的一种格式,也叫分类编码(categorical encoding)。6.1 节给出 了 one-hot 编码的详细解释。在这个例子中,标签的 one-hot 编码就是将每个标签表示为全零向量, 只有标签索引对应的元素为 1。其代码实现如下。

def to_one_hot(labels, dimension=46):

results = np.zeros((len(labels), dimension))

for i, label in enumerate(labels):

results[i, label] = 1.

return results

one_hot_train_labels = to_one_hot(train_labels)

one_hot_test_labels = to_one_hot(test_labels)

注意,Keras 内置方法可以实现这个操作,你在 MNIST 例子中已经见过这种方法。

from keras.utils.np_utils import to_categorical

one_hot_train_labels = to_categorical(train_labels)

one_hot_test_labels = to_categorical(test_labels)

3.5.3 构建网络

这个主题分类问题与前面的电影评论分类问题类似,两个例子都是试图对简短的文本片段 进行分类。但这个问题有一个新的约束条件:输出类别的数量从 2 个变为 46 个。输出空间的维度要大得多。

对于前面用过的 Dense 层的堆叠,每层只能访问上一层输出的信息。如果某一层丢失了与 分类问题相关的一些信息,那么这些信息无法被后面的层找回,也就是说,每一层都可能成为信息瓶颈。上一个例子使用了 16 维的中间层,但对这个例子来说 16 维空间可能太小了,无法 学会区分 46 个不同的类别。这种维度较小的层可能成为信息瓶颈,永久地丢失相关信息。

出于这个原因,下面将使用维度更大的层,包含 64 个单元。

代码清单 3-15 模型定义

from keras import models

from keras import layers

model = models.Sequential()

model.add(layers.Dense(64, activation='relu', input_shape=(10000,)))

model.add(layers.Dense(64, activation='relu'))

model.add(layers.Dense(46, activation='softmax'))

关于这个架构还应该注意另外两点。

- 网络的最后一层是大小为 46 的

Dense层。这意味着,对于每个输入样本,网络都会输出一个 46 维向量。这个向量的每个元素(即每个维度)代表不同的输出类别。 - 最后一层使用了

softmax激活。你在 MNIST 例子中见过这种用法。网络将输出在 46 个不同输出类别上的概率分布——对于每一个输入样本,网络都会输出一个 46 维向量, 其中 output[i] 是样本属于第 i 个类别的概率。46 个概率的总和为 1。

对于这个例子,最好的损失函数是 categorical_crossentropy(分类交叉熵)。它用于衡量两个概率分布之间的距离,这里两个概率分布分别是网络输出的概率分布和标签的真实分布。通过将这两个分布的距离最小化,训练网络可使输出结果尽可能接近真实标签。

代码清单 3-16 编译模型

model.compile(optimizer='rmsprop',

loss='categorical_crossentropy',

metrics=['accuracy'])

3.5.4 验证你的方法

我们在训练数据中留出 1000 个样本作为验证集。

代码清单 3-17 留出验证集

x_val = x_train[:1000]

partial_x_train = x_train[1000:]

y_val = one_hot_train_labels[:1000]

partial_y_train = one_hot_train_labels[1000:]

现在开始训练网络,共 20 个轮次。

代码清单 3-18 训练模型

history = model.fit(partial_x_train,

partial_y_train,

epochs=20,

batch_size=512,

validation_data=(x_val, y_val))

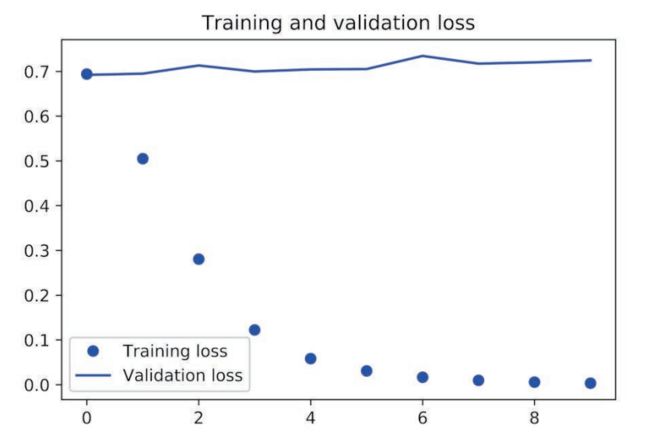

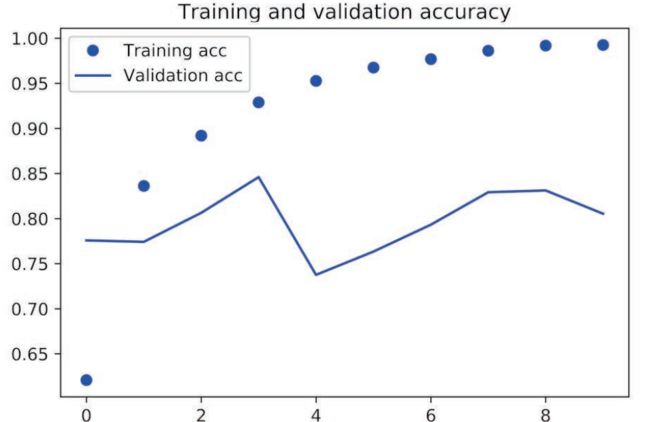

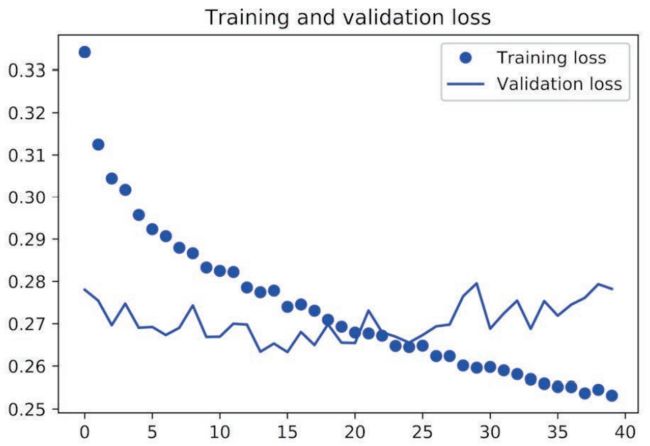

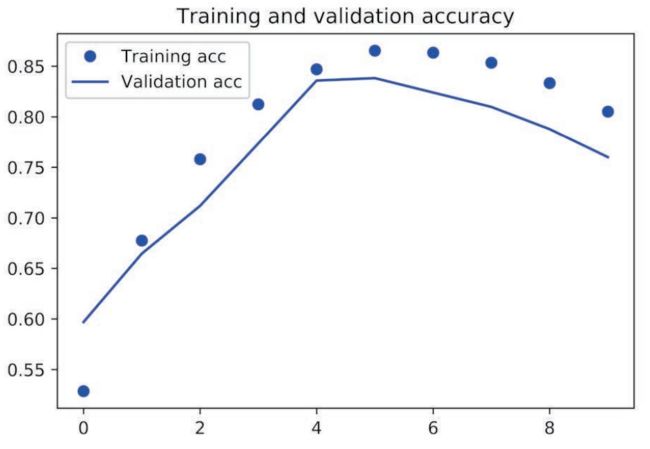

最后,我们来绘制损失曲线和精度曲线(见图 3-9 和图 3-10)。

![]()

图 3-9 训练损失和验证损失

![]()

图 3-10 训练精度和验证精度

代码清单 3-19 绘制训练损失和验证损失

import matplotlib.pyplot as plt

loss = history.history['loss']

val_loss = history.history['val_loss']

epochs = range(1, len(loss) + 1)

plt.plot(epochs, loss, 'bo', label='Training loss')

plt.plot(epochs, val_loss, 'b', label='Validation loss')

plt.title('Training and validation loss')

plt.xlabel('Epochs')

plt.ylabel('Loss')

plt.legend()

plt.show()

代码清单 3-20 绘制训练精度和验证精度

plt.clf()

acc = history.history['acc']

val_acc = history.history['val_acc']

plt.plot(epochs, acc, 'bo', label='Training acc')

plt.plot(epochs, val_acc, 'b', label='Validation acc')

plt.title('Training and validation accuracy')

plt.xlabel('Epochs')

plt.ylabel('Accuracy')

plt.legend()

plt.show()

网络在训练 9 轮后开始过拟合。我们从头开始训练一个新网络,共 9 个轮次,然后在测试 集上评估模型。

代码清单 3-21 从头开始重新训练一个模型

model = models.Sequential()

model.add(layers.Dense(64, activation='relu', input_shape=(10000,)))

model.add(layers.Dense(64, activation='relu'))

model.add(layers.Dense(46, activation='softmax'))

model.compile(optimizer='rmsprop',

loss='categorical_crossentropy',

metrics=['accuracy'])

model.fit(partial_x_train,

partial_y_train,

epochs=9,

batch_size=512,

validation_data=(x_val, y_val))

results = model.evaluate(x_test, one_hot_test_labels)

最终结果如下。

>>> results

[0.9565213431445807, 0.79697239536954589]

这种方法可以得到约 80% 的精度。对于平衡的二分类问题,完全随机的分类器能够得到 50% 的精度。但在这个例子中,完全随机的精度约为 19%,所以上述结果相当不错,至少和随机的基准比起来还不错。

>>> import copy

>>> test_labels_copy = copy.copy(test_labels)

>>> np.random.shuffle(test_labels_copy)

>>> hits_array = np.array(test_labels) == np.array(test_labels_copy)

>>> float(np.sum(hits_array)) / len(test_labels)

0.18655387355298308

3.5.5 在新数据上生成预测结果

你可以验证,模型实例的 predict 方法返回了在 46 个主题上的概率分布。我们对所有测试数据生成主题预测。

代码清单 3-22 在新数据上生成预测结果

predictions = model.predict(x_test)

predictions 中的每个元素都是长度为 46 的向量。

>>> predictions[0].shape

(46,)

这个向量的所有元素总和为 1。

>>> np.sum(predictions[0])

1.0

最大的元素就是预测类别,即概率最大的类别。

>>> np.argmax(predictions[0])

4

3.5.6 处理标签和损失的另一种方法

前面提到了另一种编码标签的方法,就是将其转换为整数张量,如下所示。

y_train = np.array(train_labels)

y_test = np.array(test_labels)

对于这种编码方法,唯一需要改变的是损失函数的选择。对于代码清单 3-21 使用的损失函数 categorical_crossentropy,标签应该遵循分类编码。对于整数标签,你应该使用 sparse_categorical_crossentropy。

model.compile(optimizer='rmsprop',

loss='sparse_categorical_crossentropy',

metrics=['acc'])

这个新的损失函数在数学上与 categorical_crossentropy 完全相同,二者只是接口不同。

3.5.7 中间层维度足够大的重要性

前面提到,最终输出是 46 维的,因此中间层的隐藏单元个数不应该比 46 小太多。现在来 看一下,如果中间层的维度远远小于 46(比如 4 维),造成了信息瓶颈,那么会发生什么?

代码清单 3-23 具有信息瓶颈的模型

model = models.Sequential()

model.add(layers.Dense(64, activation='relu', input_shape=(10000,)))

model.add(layers.Dense(4, activation='relu'))

model.add(layers.Dense(46, activation='softmax'))

model.compile(optimizer='rmsprop',

loss='categorical_crossentropy',

metrics=['accuracy'])

model.fit(partial_x_train,

partial_y_train,

epochs=20,

batch_size=128,

validation_data=(x_val, y_val))

现在网络的验证精度最大约为 71%,比前面下降了 8%。导致这一下降的主要原因在于,你 试图将大量信息(这些信息足够恢复 46 个类别的分割超平面)压缩到维度很小的中间空间。网 络能够将大部分必要信息塞入这个四维表示中,但并不是全部信息。

3.5.8 进一步的实验

- 尝试使用更多或更少的隐藏单元,比如 32 个、128 个等。

- 前面使用了两个隐藏层,现在尝试使用一个或三个隐藏层。

3.6 预测房价:回归问题

前面两个例子都是分类问题,其目标是预测输入数据点所对应的单一离散的标签。另一种 常见的机器学习问题是回归问题,它预测一个连续值而不是离散的标签,例如,根据气象数据 预测明天的气温,或者根据软件说明书预测完成软件项目所需要的时间。

注意 不要将回归问题与 logistic 回归算法混为一谈。令人困惑的是,logistic 回归不是回归算法, 而是分类算法。

3.6.1 波士顿房价数据集

本节将要预测 20 世纪 70 年代中期波士顿郊区房屋价格的中位数,已知当时郊区的一些数 据点,比如犯罪率、当地房产税率等。本节用到的数据集与前面两个例子有一个有趣的区别。 它包含的数据点相对较少,只有 506 个,分为 404 个训练样本和 102 个测试样本。输入数据的 每个特征(比如犯罪率)都有不同的取值范围。例如,有些特性是比例,取值范围为 0~1;有 的取值范围为 1~12;还有的取值范围为 0~100,等等。

代码清单 3-24 加载波士顿房价数据

from keras.datasets import boston_housing

(train_data, train_targets), (test_data, test_targets) = boston_housing.load_data()

我们来看一下数据。

>>> train_data.shape

(404, 13)

>>> test_data.shape

(102, 13)

如你所见,我们有 404 个训练样本和 102 个测试样本,每个样本都有 13 个数值特征,比如 人均犯罪率、每个住宅的平均房间数、高速公路可达性等。

目标是房屋价格的中位数,单位是千美元。

>>> train_targets

array([ 15.2, 42.3, 50. ... 19.4, 19.4, 29.1])

房价大都在 10 000~50 000 美元。如果你觉得这很便宜,不要忘记当时是 20 世纪 70 年代中 期,而且这些价格没有根据通货膨胀进行调整。

3.6.2 准备数据

将取值范围差异很大的数据输入到神经网络中,这是有问题的。网络可能会自动适应这种 取值范围不同的数据,但学习肯定变得更加困难。对于这种数据,普遍采用的最佳实践是对每 个特征做标准化,即对于输入数据的每个特征(输入数据矩阵中的列),减去特征平均值,再除 以标准差,这样得到的特征平均值为 0,标准差为 1。用 Numpy 可以很容易实现标准化。

代码清单 3-25 数据标准化

mean = train_data.mean(axis=0)

train_data -= mean

std = train_data.std(axis=0)

train_data /= std

test_data -= mean

test_data /= std

注意,用于测试数据标准化的均值和标准差都是在训练数据上计算得到的。在工作流程中, 你不能使用在测试数据上计算得到的任何结果,即使是像数据标准化这么简单的事情也不行。

3.6.3 构建网络

由于样本数量很少,我们将使用一个非常小的网络,其中包含两个隐藏层,每层有 64 个单 元。一般来说,训练数据越少,过拟合会越严重,而较小的网络可以降低过拟合。

代码清单 3-26 模型定义

from keras import models

from keras import layers

def build_model():

model = models.Sequential()

model.add(layers.Dense(64, activation='relu',

input_shape=(train_data.shape[1],)))

model.add(layers.Dense(64, activation='relu'))

model.add(layers.Dense(1))

model.compile(optimizer='rmsprop', loss='mse', metrics=['mae'])

return model

网络的最后一层只有一个单元,没有激活,是一个线性层。这是标量回归(标量回归是预测单一连续值的回归)的典型设置。添加激活函数将会限制输出范围。例如,如果向最后一层 添加 sigmoid 激活函数,网络只能学会预测 0~1 范围内的值。这里最后一层是纯线性的,所以 网络可以学会预测任意范围内的值。

注意,编译网络用的是 mse 损失函数,即均方误差(MSE,mean squared error),预测值与 目标值之差的平方。这是回归问题常用的损失函数。

在训练过程中还监控一个新指标:平均绝对误差(MAE,mean absolute error)。它是预测值 与目标值之差的绝对值。比如,如果这个问题的 MAE 等于 0.5,就表示你预测的房价与实际价格平均相差 500 美元。

3.6.4 利用 K 折验证来验证你的方法

为了在调节网络参数(比如训练的轮数)的同时对网络进行评估,你可以将数据划分为训练集和验证集,正如前面例子中所做的那样。但由于数据点很少,验证集会非常小(比如大约 100 个样本)。因此,验证分数可能会有很大波动,这取决于你所选择的验证集和训练集。也就是说,验证集的划分方式可能会造成验证分数上有很大的方差,这样就无法对模型进行可靠的评估。

在这种情况下,最佳做法是使用 K 折交叉验证(见图 3-11)。这种方法将可用数据划分为 K 个分区(K 通常取 4 或 5),实例化 K 个相同的模型,将每个模型在 K-1 个分区上训练,并在剩下的一个分区上进行评估。模型的验证分数等于 K 个验证分数的平均值。这种方法的代码实现很简单。

![]()

图 3-11 3 折交叉验证

代码清单 3-27 K 折验证

import numpy as np

k = 4

num_val_samples = len(train_data) // k

num_epochs = 100

all_scores = []

for i in range(k):

print('processing fold #', i)

val_data = train_data[i * num_val_samples: (i + 1) * num_val_samples]

val_targets = train_targets[i * num_val_samples: (i + 1) * num_val_samples]

partial_train_data = np.concatenate(

[train_data[:i * num_val_samples],

train_data[(i + 1) * num_val_samples:]],

axis=0)

partial_train_targets = np.concatenate(

[train_targets[:i * num_val_samples],

train_targets[(i + 1) * num_val_samples:]],

axis=0)

model = build_model()

model.fit(partial_train_data, partial_train_targets,

epochs=num_epochs, batch_size=1, verbose=0)

val_mse, val_mae = model.evaluate(val_data, val_targets, verbose=0)

all_scores.append(val_mae)

设置 num_epochs = 100,运行结果如下。

>>> all_scores

[2.588258957792037, 3.1289568449719116, 3.1856116051248984, 3.0763342615401386]

>>> np.mean(all_scores)

2.9947904173572462

每次运行模型得到的验证分数有很大差异,从 2.6 到 3.2 不等。平均分数(3.0)是比单一分数更可靠的指标——这就是 K 折交叉验证的关键。在这个例子中,预测的房价与实际价格平均相差 3000 美元,考虑到实际价格范围在 10 000~50 000 美元,这一差别还是很大的。

我们让训练时间更长一点,达到 500 个轮次。为了记录模型在每轮的表现,我们需要修改训练循环,以保存每轮的验证分数记录。

代码清单 3-28 保存每折的验证结果

num_epochs = 500

all_mae_histories = []

for i in range(k):

print('processing fold #', i)

val_data = train_data[i * num_val_samples: (i + 1) * num_val_samples]

val_targets = train_targets[i * num_val_samples: (i + 1) * num_val_samples]

partial_train_data = np.concatenate(

[train_data[:i * num_val_samples],

train_data[(i + 1) * num_val_samples:]],

axis=0)

partial_train_targets = np.concatenate(

[train_targets[:i * num_val_samples],

train_targets[(i + 1) * num_val_samples:]],

axis=0)

model = build_model()

history = model.fit(partial_train_data, partial_train_targets,

validation_data=(val_data, val_targets),

epochs=num_epochs, batch_size=1, verbose=0)

mae_history = history.history['val_mean_absolute_error']

all_mae_histories.append(mae_history)

然后你可以计算每个轮次中所有折 MAE 的平均值。

代码清单 3-29 计算所有轮次中的 K 折验证分数平均值

average_mae_history = [

np.mean([x[i] for x in all_mae_histories]) for i in range(num_epochs)]

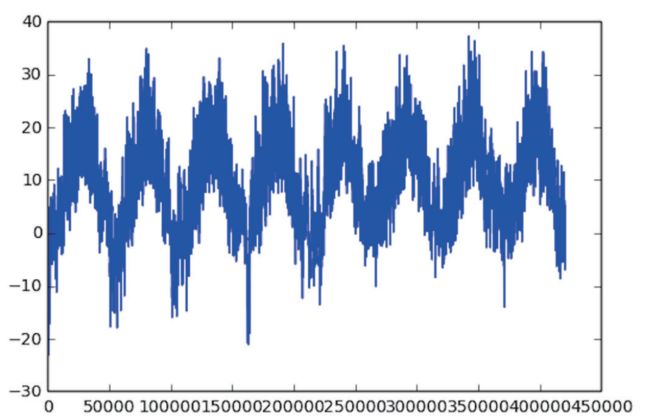

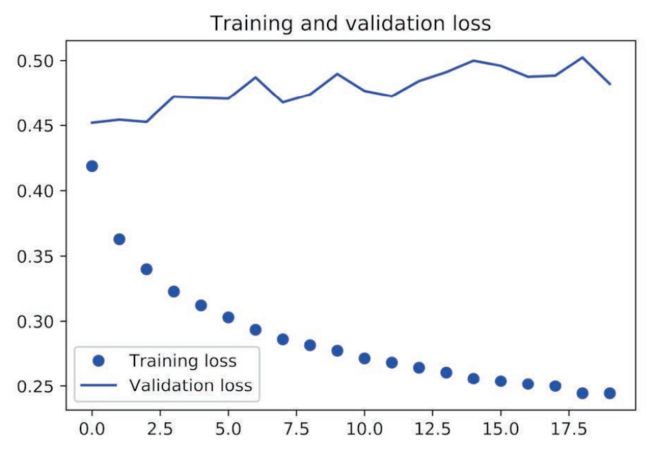

我们画图来看一下,见图 3-12。

代码清单 3-30 绘制验证分数

import matplotlib.pyplot as plt

plt.plot(range(1, len(average_mae_history) + 1), average_mae_history)

plt.xlabel('Epochs')

plt.ylabel('Validation MAE')

plt.show()

![]()

图 3-12 每轮的验证 MAE

因为纵轴的范围较大,且数据方差相对较大,所以难以看清这张图的规律。我们来重新绘制一张图。

- 删除前 10 个数据点,因为它们的取值范围与曲线上的其他点不同。

- 将每个数据点替换为前面数据点的指数移动平均值,以得到光滑的曲线。

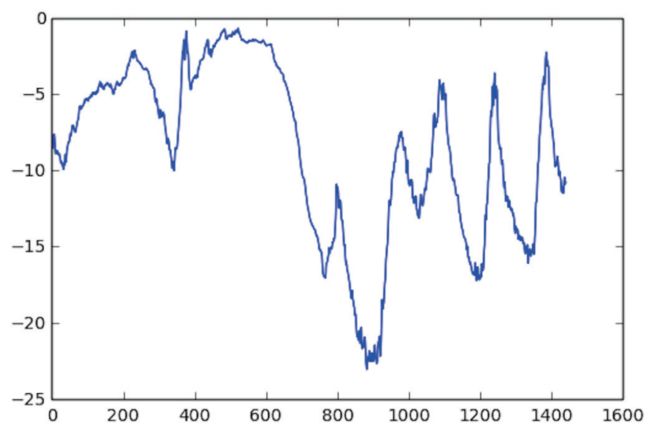

结果如图 3-13 所示。

代码清单 3-31 绘制验证分数(删除前 10 个数据点)

def smooth_curve(points, factor=0.9):

smoothed_points = []

for point in points:

if smoothed_points:

previous = smoothed_points[-1]

smoothed_points.append(previous * factor + point * (1 - factor))

else:

smoothed_points.append(point)

return smoothed_points

smooth_mae_history = smooth_curve(average_mae_history[10:])

plt.plot(range(1, len(smooth_mae_history) + 1), smooth_mae_history)

plt.xlabel('Epochs')

plt.ylabel('Validation MAE')

plt.show()

从图 3-13 可以看出,验证 MAE 在 80 轮后不再显著降低,之后就开始过拟合。

![]()

图 3-13 每轮的验证 MAE(删除前 10 个数据点)

完成模型调参之后(除了轮数,还可以调节隐藏层大小),你可以使用最佳参数在所有训练 数据上训练最终的生产模型,然后观察模型在测试集上的性能。

代码清单 3-32 训练最终模型

model = build_model()

model.fit(train_data, train_targets,

epochs=80, batch_size=16, verbose=0)

test_mse_score, test_mae_score = model.evaluate(test_data, test_targets)

最终结果如下。

>>> test_mae_score

2.5532484335057877

你预测的房价还是和实际价格相差约 2550 美元。

3.6.5 小结

下面是你应该从这个例子中学到的要点。

- 回归问题使用的损失函数与分类问题不同。回归常用的损失函数是均方误差(MSE)。

- 同样,回归问题使用的评估指标也与分类问题不同。显而易见,精度的概念不适用于回 归问题。常见的回归指标是平均绝对误差(MAE)。

- 如果输入数据的特征具有不同的取值范围,应该先进行预处理,对每个特征单独进行 缩放。

- 如果可用的数据很少,使用 K 折验证可以可靠地评估模型。

- 如果可用的训练数据很少,最好使用隐藏层较少(通常只有一到两个)的小型网络,以 避免严重的过拟合。

Python深度学习篇四《机器学习基础》

Excerpt

前言 前期回顾:Python深度学习篇三《神经网络入门》 上面这篇里面写了关于向量数据最常见的机器学习任务。 好,接下来切入正题。 本章包括以下内容: 除分类和回归之外的机器学习形式 评估机器学习模型的规范流程 为深度学习准备数据 特征工程 解 …

前言

前期回顾:Python深度学习篇三《神经网络入门》

上面这篇里面写了关于向量数据最常见的机器学习任务。

好,接下来切入正题。

本章包括以下内容:

- 除分类和回归之外的机器学习形式

- 评估机器学习模型的规范流程

- 为深度学习准备数据

- 特征工程

- 解决过拟合

- 处理机器学习问题的通用工作流程

学完第 3 章的三个实例,你应该已经知道如何用神经网络解决分类问题和回归问题,而且 也看到了机器学习的核心难题:过拟合。本章会将你对这些问题的直觉固化为解决深度学习问 题的可靠的概念框架。我们将把所有这些概念——模型评估、数据预处理、特征工程、解决过 拟合——整合为详细的七步工作流程,用来解决任何机器学习任务。

4.1 机器学习的四个分支

在前面的例子中,你已经熟悉了三种类型的机器学习问题:二分类问题、多分类问题和标量回归问题。这三者都是监督学习(supervised learning)的例子,其目标是学习训练输入与训练目标之间的关系。

监督学习只是冰山一角——机器学习是非常宽泛的领域,其子领域的划分非常复杂。机器学习算法大致可分为四大类,我们将在接下来的四小节中依次介绍。

4.1.1 监督学习

监督学习是目前最常见的机器学习类型。给定一组样本(通常由人工标注),它可以学会将 输入数据映射到已知目标[也叫标注(annotation)]。本书前面的四个例子都属于监督学习。一 般来说,近年来广受关注的深度学习应用几乎都属于监督学习,比如光学字符识别、语音识别、 图像分类和语言翻译。

虽然监督学习主要包括分类和回归,但还有更多的奇特变体,主要包括如下几种。

- 序列生成(sequence generation)。给定一张图像,预测描述图像的文字。序列生成有时 可以被重新表示为一系列分类问题,比如反复预测序列中的单词或标记。

- 语法树预测(syntax tree prediction)。给定一个句子,预测其分解生成的语法树。

- 目标检测(object detection)。给定一张图像,在图中特定目标的周围画一个边界框。这 个问题也可以表示为分类问题(给定多个候选边界框,对每个框内的目标进行分类)或 分类与回归联合问题(用向量回归来预测边界框的坐标)。

- 图像分割(image segmentation)。给定一张图像,在特定物体上画一个像素级的掩模(mask)。

4.1.2 无监督学习

无监督学习是指在没有目标的情况下寻找输入数据的有趣变换,其目的在于数据可视化、 数据压缩、数据去噪或更好地理解数据中的相关性。无监督学习是数据分析的必备技能,在解 决监督学习问题之前,为了更好地了解数据集,它通常是一个必要步骤。降维(dimensionality reduction)和聚类(clustering)都是众所周知的无监督学习方法。

4.1.3 自监督学习

自监督学习是监督学习的一个特例,它与众不同,值得单独归为一类。自监督学习是没有人工标注的标签的监督学习,你可以将它看作没有人类参与的监督学习。标签仍然存在(因为总要有什么东西来监督学习过程),但它们是从输入数据中生成的,通常是使用启发式算法生成的。

举个例子,自编码器(autoencoder)是有名的自监督学习的例子,其生成的目标就是未经修改的输入。同样,给定视频中过去的帧来预测下一帧,或者给定文本中前面的词来预测下一个词, 都是自监督学习的例子[这两个例子也属于时序监督学习(temporally supervised learning),即用未来的输入数据作为监督]。注意,监督学习、自监督学习和无监督学习之间的区别有时很模糊, 这三个类别更像是没有明确界限的连续体。自监督学习可以被重新解释为监督学习或无监督学 习,这取决于你关注的是学习机制还是应用场景。

注意 本书的重点在于监督学习,因为它是当前深度学习的主要形式,行业应用非常广泛。后续章节也会简要介绍自监督学习。

4.1.4 强化学习

强化学习一直以来被人们所忽视,但最近随着 Google 的 DeepMind 公司将其成功应用于学习玩 Atari 游戏(以及后来学习下围棋并达到最高水平),机器学习的这一分支开始受到大量关注。 在强化学习中,智能体(agent)接收有关其环境的信息,并学会选择使某种奖励最大化的行动。 例如,神经网络会“观察”视频游戏的屏幕并输出游戏操作,目的是尽可能得高分,这种神经网络可以通过强化学习来训练。

目前,强化学习主要集中在研究领域,除游戏外还没有取得实践上的重大成功。但是,我们期待强化学习未来能够实现越来越多的实际应用:自动驾驶汽车、机器人、资源管理、教育等。 强化学习的时代已经到来,或即将到来。

分类和回归术语表

分类和回归都包含很多专业术语。前面你已经见过一些术语,在后续章节会遇到更多。 这些术语在机器学习领域都有确切的定义,你应该了解这些定义。

- 样本(sample)或输入(input):进入模型的数据点。

- 预测(prediction)或输出(output):从模型出来的结果。

- 目标(target):真实值。对于外部数据源,理想情况下,模型应该能够预测出目标。

- 预测误差(prediction error)或损失值(loss value):模型预测与目标之间的距离。

- 类别(class):分类问题中供选择的一组标签。例如,对猫狗图像进行分类时,“狗” 和“猫”就是两个类别。

- 标签(label):分类问题中类别标注的具体例子。比如,如果 1234 号图像被标注为 包含类别“狗”,那么“狗”就是 1234 号图像的标签。 真值(ground-truth)或标注(annotation):数据集的所有目标,通常由人工收集。