CVPR 2022 | 网易&华科提出特征采样与分组:基于Transformer的场景文字检测方法

点击下方卡片,关注“CVer”公众号

AI/CV重磅干货,第一时间送达

转载自:CSIG文档图像分析与识别专委会

本文简要介绍了CVPR 2022录用的论文”Few Could be Better Than All: Feature Sampling and Grouping for Scene Text Detection”的主要工作。该论文提出了一种简单高效的特征采样和特征组合的方法用于场景文本检测,不同与以往将所有的特征都用于预测的方法,该方法会挑选出一些具有代表性的前景文本特征进行组合和预测。特征采样和组合的策略可以让模型避免背景噪声的干扰,在提升检测精度的同时降低了计算复杂度,不再依赖于繁杂的后处理模块。

一、研究背景

场景文本检测一直是一个活跃的研究领域,并且在实际中有着非常广泛的应用,例如场景理解、自动驾驶和照片翻译。由于场景文本所具有不同的尺度、复杂的照明环境、视角的失真、多方向性以及复杂的形状,场景文本检测仍然是一项具有挑战性的任务。此前大多数的场景文本检测的方法都依赖于复杂的后处理,例如锚点生成、非最大抑制、二值化或轮廓提取,来生成或者细化最终的预测结果,而复杂的后处理往往会影响最终的检测结果。随着Transformer被不断应用于各种视觉任务中,一些基于DETR[1]的目标检测方法也成功摆脱了对复杂后处理模块的依赖,并且获得了优异的检测性能。虽然基于DETR的目标检测框架大获成功,但是他们仍然被小目标和高计算复杂度所困扰。例如最近的一个基于DETR的文本检测方法[2],无法在ICDAR2015[3]和ICDAR2017-MLT[4]数据上取得令人满意的结果,是因为在这两个数据集中的文本实例具有更极端的尺度和长宽比,而Transformer通常无法在小尺度上充分地获取小文本特征。此前,研究者们通常会使用多尺度特征来解决小目标的检测问题,但是对于DETR的检测框架而言,多尺度特征检测方法的时间成本是不可预测的。因此,如何有效降低Transformer 在多尺度特征检测上的计算复杂度,如何更好的检测具有极端长宽比的文本仍然需要更多的探索与研究。

二、方法简述

图1 网络整体框架图

本文提出了一个简单而有效的基于Transformer的场景文本检测网络,其主要由特征采样和特征组合两个模块所组成。特征采样模块主要是对骨干网络提取的多尺度特征进一步提取和筛选,特征组合模块主要是对筛选后的特征进行建模与预测。在特征采样阶段,通过观察发现前景文本实例通常只占据了场景图中的几个狭窄的区域。因此,本文认为模型的特征学习并不需要基于所有的特征点,只需要选择具有代表性的前景文本特征进行组合和预测,这样会带来以下几个优势:(1)可以大幅度降低模型在多尺度特征上的计算复杂度;(2)可以显著的消除背景的冗余信息,利于提高Transformer 的效率;(3)利用Transformer对采样特征进行分组,可以获得更准确的组合结果以及不需要任何后处理模块的检测框;(4)由于特征采样和组合是以端到端的方式实现的,这两个阶段可以互相促进、共同提高最终的检测性能。

特征采样:由于场景文本尺度和长宽比的极端分布,本文使用了基于FPN[4]的多尺度特征来提高检测性能。然而,这种方案给Transformer带来了非常高的计算成本和更长的收敛时间。通过观察发现,前景文本实例只占据很小的区域,而定位文本位置所需的有用信息也相对较为稀疏,所以本文提出了一种特征采样策略来减少多尺度特征所包含的冗余的背景噪声以降低模型的计算复杂度,增强模型的特征学习能力。

为了从前景文本中提取代表性特征,本文使用一个简单的多尺度文本提取器来预测像素级上文本区域的置信度分数,具体结构如下图2所示。首先,本文将特征映射与两个来自 CoordConv[5]的标准化坐标通道进行合并以使特征图具备位置信息。其次,受到Deformable ROI Pooling[6]的启发,本文专门设计了一个Constrained Deformable Pooling来对多尺度特征图进行下采样,区别于Deformable ROI Pooling中预测的偏移量会将无关信息合并入特征图中,Constrained Deformable pooling增加了一个可学习的尺度参数来约束预测的偏移量。然后,本文构造了一个由卷积层和Sigmoid函数组成的评分网络以生成所有尺度上的代表性文本区域的置信度评分。最后,对各个特征图中的置信度得分进行排序并分别选择每张特征图中得分最高的N个特征点,用于输入特征分组模块进行建模。

通过上述的特征采样策略,在所有尺度上的特征数量会显著减少,这将极大程度减小模型的计算复杂度和冗余的背景噪声。本文主要选择的特征基本都来自于前景文本区域,而这些采样的特征将包含充足的几何和上下文信息供模型进行建模与定位。

图2 特征采样策略结构图

特征组合:通过特征选择,只有少数与前景文本高度相关的代表性特征被提取出来输入到Transformer中。然后利用Transformer结构,通过注意力机制隐式的将来自同一文本实例的特征进行聚合,如下图3所示,本文在最后一个Transformer层中可视化了一个文本实例的特征注意力权重,当颜色由蓝色变为红色时,其权值从0增加到1。从图中可以看出,红色检测框中的文本实例的输出特性主要由内部文本点的特征进行聚合得到。

对比之前的方法,在特征图![]() 上应用注意力机制是在所有空间位置上的计算复杂度。以原始的DETR编码器为例,注意力操作的复杂度为

上应用注意力机制是在所有空间位置上的计算复杂度。以原始的DETR编码器为例,注意力操作的复杂度为![]() ,然而在本文的方法中,复杂度只与所选特征数量的N有关,所以本文所设计的模块的计算复杂度为

,然而在本文的方法中,复杂度只与所选特征数量的N有关,所以本文所设计的模块的计算复杂度为![]() ,同时在本文的实验中,所选择的特征数量

,同时在本文的实验中,所选择的特征数量![]() 。

。

综上所述,通过本文所设计的采样策略可以减小模型的计算复杂度,同时保留极具代表性的特征进行检测任务,再利用自注意力机制所拥有的特征聚合能力得到精确的检测框并且无需任何后处理。

图3 特征采样与特征组合示意图

三、主要实验结果及可视化效果

图4 在不同情况下的定性结果,包括多面向文本、长文本、多语言文本、低分辨率文本、弯曲文本、密集文本。对于曲线文本检测,贝塞尔曲线的控制点用红色表示。

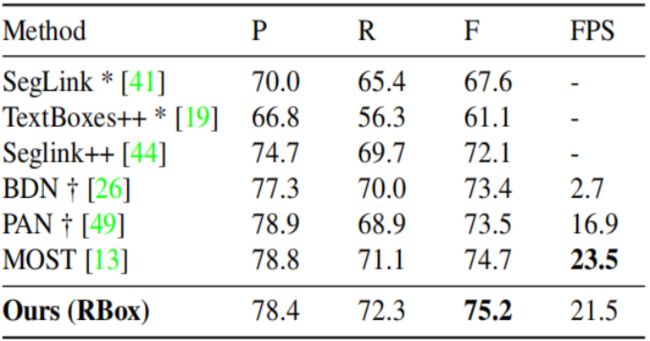

表1 ICDAR2015、MSRA-TD500、Total-Text和CTW1500的检测结果

表2 在MLT-2017测试数据集上的检测结果

表3 对MTWI数据集的检测结果

表4 在IC15测试数据集和MLT17验证数据集上进行了特征采样数量的实验

表5对特征分组网络中transformer层的实验

表6 在IC15测试数据集和MLT17验证数据集上与基于transformer的方法进行比较

图5 DETR、Deformable DETR、Conditional DETR和本文模型(RBox)的收敛曲线

表7 与基于Transformer的方法在flop、参数数量和推理速度上的比较

图6 拓展至遥感数据DOTA-v1.0测试集的定性结果

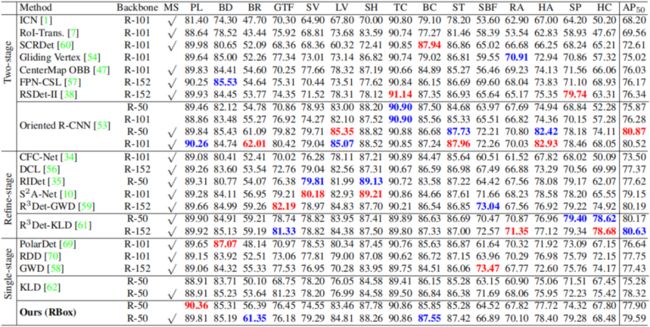

表8 在DOTA-v1.0测试集上的检测结果

四、总结与讨论

本文提出了一种简单而有效的基于Transformer的场景文本检测网络,与以往的场景文本检测方法不同,该方法只利用了少数包含前景文本几何特征和上下文信息的代表性特征就能够有效地减少冗余的背景噪声,并且能够改善自注意模块在多尺度特征下高计算复杂度的问题。利用Transformer的特征聚合能力,可以获得更精确的检测框,且无需任何后处理模块。本文所提出的方法,在有更先进的Transformer结构支持时,例如Swin Transformer,在各数据集上有更好的表现。充分的实验表明,本文所提出的方法在多方向文本数据集和任意形状文本数据集上取得了最优的结果,同时也在遥感数据集上展现了极具竞争力的结果,从而证明了该方法的有效性。

五、相关资源

论文地址:https://arxiv.org/abs/2203.15221

六、参考文献

[1]Nicolas Carion, Francisco Massa, Gabriel Synnaeve, Nicolas Usunier, Alexander Kirillov, and Sergey Zagoruyko. End-toend object detection with transformers. In ECCV, 2020.

[2]Zobeir Raisi, Mohamed A Naiel, Georges Younes, Steven Wardell, and John S Zelek. Transformer-based text detection in the wild. In CVPR Workshop, 2021.

[3]Tsung-Yi Lin, Piotr Doll´ar, Ross Girshick, Kaiming He, Bharath Hariharan, and Serge Belongie. Feature pyramid networks for object detection. In CVPR, 2017.

[4]Dimosthenis Karatzas, Lluis Gomez-Bigorda, Anguelos Nicolaou, Suman Ghosh, Andrew Bagdanov, Masakazu Iwamura, Jiri Matas, Lukas Neumann, Vijay Ramaseshan Chandrasekhar, Shijian Lu, et al. Icdar 2015 competition on robust reading. In ICDAR, 2015.

[5]Nibal Nayef, Fei Yin, Imen Bizid, Hyunsoo Choi, Yuan Feng, Dimosthenis Karatzas, Zhenbo Luo, Umapada Pal, Christophe Rigaud, Joseph Chazalon, et al. Icdar2017 robust reading challenge on multi-lingual scene text detection and script identification-rrc-mlt. In ICDAR, 2017.

[6]Rosanne Liu, Joel Lehman, Piero Molino, Felipe Petroski Such, Eric Frank, Alex Sergeev, and Jason Yosinski. An intriguing failing of convolutional neural networks and the coordconv solution. NeurIPS, 2018.

[7]Jifeng Dai, Haozhi Qi, Yuwen Xiong, Yi Li, Guodong Zhang, Han Hu, and Yichen Wei. Deformable convolutional networks. In ICCV, 2017.

原文作者:Jingqun Tang, Wenqing Zhang, Hongye Liu, MingKun Yang, Bo Jiang, Guanglong Hu, Xiang Bai

撰稿:唐景群 编排:高 学

审校:连宙辉 发布:金连文

ICCV和CVPR 2021论文和代码下载

后台回复:CVPR2021,即可下载CVPR 2021论文和代码开源的论文合集

后台回复:ICCV2021,即可下载ICCV 2021论文和代码开源的论文合集

后台回复:Transformer综述,即可下载最新的3篇Transformer综述PDF

目标检测和Transformer交流群成立

扫描下方二维码,或者添加微信:CVer6666,即可添加CVer小助手微信,便可申请加入CVer-目标检测或者Transformer 微信交流群。另外其他垂直方向已涵盖:目标检测、图像分割、目标跟踪、人脸检测&识别、OCR、姿态估计、超分辨率、SLAM、医疗影像、Re-ID、GAN、NAS、深度估计、自动驾驶、强化学习、车道线检测、模型剪枝&压缩、去噪、去雾、去雨、风格迁移、遥感图像、行为识别、视频理解、图像融合、图像检索、论文投稿&交流、PyTorch、TensorFlow和Transformer等。

一定要备注:研究方向+地点+学校/公司+昵称(如目标检测或者Transformer+上海+上交+卡卡),根据格式备注,可更快被通过且邀请进群

▲扫码或加微信: CVer6666,进交流群

CVer学术交流群(知识星球)来了!想要了解最新最快最好的CV/DL/ML论文速递、优质开源项目、学习教程和实战训练等资料,欢迎扫描下方二维码,加入CVer学术交流群,已汇集数千人!

▲扫码进群

▲点击上方卡片,关注CVer公众号