- 云服务器性能优化全攻略:CPU、内存、磁盘IO调优实战

Gloria歌洛莉亚

c语言数据库服务器python性能优化

在云计算时代,服务器性能直接影响应用响应速度、用户体验和运营成本。无论是高并发网站、实时数据分析还是机器学习训练,优化云服务器性能都是开发者必须掌握的核心技能。本攻略将从CPU调度、内存管理、磁盘IO三个维度,结合Linux系统特性和实际场景,提供可落地的优化方案。一、CPU性能调优:从调度策略到并行计算1.1CPU资源监控与瓶颈定位实时监控工具:top-c#动态查看进程CPU占用(按P键按CPU

- Promise入门

m0dw

javascript前端开发语言

文章目录为什么使用PromisePromise介绍为什么使用Promise在ES5中使用回调函数来处理异步任务,当多个异步任务有依赖关系时(如下定时器的层层嵌套),就需要回调函数互相嵌套,当嵌套结构多了后,就出现了回调地狱的问题,难以维护setTimeout(function(){console.log('a1');setTimeout(function(){console.log('a2');s

- AI 驱动自动化运维平台架构与实现

大富大贵7

程序员知识储备1程序员知识储备2程序员知识储备3算法机器学习人工智能决策树大数据

摘要:随着云计算、容器化和大规模分布式系统的普及,传统人工运维方法已难以满足现代IT环境中海量指标、日志和拓扑关系的实时分析与故障响应需求。AI驱动的自动化运维(AIOps)平台通过融合机器学习、深度学习、图分析以及强化学习等多学科技术,实现对海量运维数据的智能感知、预测、诊断和自动化修复。本文深入探讨AI驱动自动化运维平台的整体架构设计与核心技术实现,涵盖数据采集与预处理、AI引擎设计、自动化执

- 目录

我还年轻还年轻

基础认知1.易智教育教学理念公司的历程,文化创始人故事突出教育理念2.理清自己所在级别享受权益课程相关推广权益相关3.报课上课相关流程开课时间报名方式上课方式推广1.合伙人项目的愿景教育行业的前景互联网+的优势易智教育的优势未来的规划2.课程销售逻辑两个主题合伙人,精英班两个路径线上,线下(熟人,陌生人)两种方式直推,体验两个作用微信,朋友圈准备工作1.微信号的基础设置头像签名背景朋友圈权限2.朋

- 存档python爬虫、Web学习资料

1python爬虫学习学习Python爬虫是个不错的选择,它能够帮你高效地获取网络数据。下面为你提供系统化的学习路径和建议:1.打好基础首先要掌握Python基础知识,这是学习爬虫的前提。比如:变量、数据类型、条件语句、循环等基础语法。列表、字典等常用数据结构的操作。函数、模块和包的使用方法。文件读写操作。推荐通过阅读《Python编程:从入门到实践》这本书或者在Codecademy、LeetCo

- Python爬虫入门到实战(3)-对网页进行操作

荼蘼

爬虫

一.获取和操作网页元素1.获取网页中的指定元素tag_name()方法:获取元素名称。text()方法:获取元素文本内容。click()方法():点击此元素。submit()方法():提交表单。send_keys()方法:模拟输入信息。size()方法:获取元素的尺寸可进入selenium库文件夹下的webdriver\remote\webelement.py中查看更多的操作方法,2.在元素中输入

- 给即将进入三年级的孩子们的暑期建议(2.2班)

徐老师_b38d

一、假期里,请提前让孩子在家里有钢笔写字第二学段与第一学段不一样,首先是用钢笔写字了。多年的三年级教学经验告诉我们,很多孩子一入学才学着用钢笔,问题相当多。但每届班级学生中,总有几位用钢笔写字,好像没有任何问题。一问便知,他们暑假两个月,爸妈就带着他(她)选择钢笔、墨水,并在家里在爸妈的指导下写了两个月了。原来如此。也许家长又会说,这是你老师的事,又把指导孩子写钢笔字推给家长了。别忙指责。请你仔细

- 我的青春,不留遗憾

沉辰雨

我现在已经大一,面对着我18年的生涯,我不知道要说什么,但我也不知道我为什么一直又想说些什么。或许是说给自己,或许是你们,那些不会看我文章的人。我从小生长在不太富裕的家庭,甚至有点贫穷,或许是这才造就了现在的我,与众不同。从小生长在外婆家,现在仍把她看成我最亲近的人,因为她在我需要爱的时候给了我。看,就是这么简单,不像现在的社会,爱成了稀缺。小学是在家附近上的,说实话,教学质量不怎么样,学校靠着那

- 语音识别开源项目推荐:GitHub热门仓库盘点

AGI大模型与大数据研究院

AI大模型应用开发实战语音识别开源githubai

2024年必看!GitHub热门语音识别开源项目全解析:从入门到实战关键词语音识别(ASR)、开源项目、GitHub、Whisper、FunASR、PaddleSpeech、深度学习摘要想象一下:开车时只需说一句话就能自动发消息,听英文演讲时实时获得中文翻译,给视障人士读文本时精准转换——这些场景的背后,语音识别(AutomaticSpeechRecognition,ASR)技术正在改变我们与机器

- MySQL入门学习-查询优化.EXPLAIN

在MySQL中,'EXPLAIN'命令用于获取查询执行计划的信息。一、关于'EXPLAIN'的一些常见查询优化方面的特点、使用方法、与其他比较及高级应用:1.特点:-提供查询执行计划的详细信息,帮助了解查询的执行方式。-可以用于优化查询性能,找出潜在的性能问题。-适用于各种类型的查询,包括简单查询和复杂查询。2.使用方法:-在查询语句前添加'EXPLAIN'关键字,例如:'EXPLAINSELEC

- 靠声音赚钱的六大方式,靠声音赚钱

配音就业圈

在当今这个数字化与多媒体蓬勃发展的时代,声音作为一种独特而强大的媒介,正以前所未有的方式创造价值与财富。配音兼职接单推荐公众号,配音新手圈,声优配音圈,新配音兼职圈,配音就业圈,鼎音副业,有声新手圈,每天更新各种的配音任务,新手小白也可以接单。1、配音新手圈这是一个公众号配音新手圈里面每天更新配音任务(只要有手机就可以接单,对经验无要求),都是适合没有基础的人去做的,每天都会发布新任务。适合新入门

- 番茄畅听刷视频广告怎么赚钱?番茄畅听挣零花钱教程攻略大揭秘

清风导师

番茄畅听赚钱怎么赚钱的?番茄畅听刷视频赚钱教学攻略曝光!番茄畅听是字节公司旗下的一款综合性娱乐产品,具有听书、小说、直播、短剧等免费功能,不光如此番茄畅听还为大家提供了赚钱的板块【领现金】,下面就具体说一下思路吧。一、番茄畅听是如何赚钱的?番茄畅听的话,里面赚钱板块还是内容比较丰富的,比如说我们老用户回归每天进行签到可以直接获得收益,比如下载推荐的其他字节产品软件有收益,当然这些都是有限的,只能前

- 分布式文件存储(GlusterFS) 入门指南, 有一定难度!! ubuntu

努力一点948

分布式gluster分布式ubuntulinux服务器运维人工智能gpu算力

以下有免费的4090云主机提供ubuntu22.04系统的其他入门实践操作地址:星宇科技|GPU服务器高性能云主机云服务器-登录相关兑换码星宇社区---4090算力卡免费体验、共享开发社区-CSDN博客兑换码要是过期了,可以私信我获取最新兑换码!!!之所以推荐给大家使用,是因为上面的云主机目前是免费使用的,不需要大家再去安装虚拟机,部署虚拟机,环境都搭配好了,非常适合新手入门,减少搭建的时间,把时

- 读《小学教师与民主运动》有感

红领巾旳小辫子

本周拜读的是陶行知文集中的《小学教师与民主运动》一文,真的是令我感慨万千。其中令我印象深刻的是先生在文中提到的六大解放:一、解放他的头脑,使他能想;二、解放他的双手,使他能干;三、解放他的眼睛,使他能看;四、解放他的嘴,使他能谈;五、解放他的空间,使他能到大自然大社会里去取得更丰富的学问;六、解放他的时间,不把他的功课表填满,不逼迫他赶考,不和家长联合起来在功课上夹攻。即使是放在现在课堂教学中,也

- 【狂神说JAVA】JVM快速入门-1

Jackson Cortex

jvmjava

链接http://player.bilibili.com/player.html?aid=76728711&bvid=BV1iJ411d7jS&cid=131232435&page=1http://player.bilibili.com/player.html?aid=76728711&bvid=BV1iJ411d7jS&cid=131232435&page=1内容一、探究JVM0、面试题谈谈对J

- 校内教研三原则

程景轩

68到74页《静悄悄的革命》355天20190820图片发自App根据先生的设计,改变教学,从学校的改变开始,从开放教室开始,然而真正在校内进行教研活动时,他的原则真的让我大吃一惊。第一个原则,对应学生的教学。这个原则真的让我特别吃惊,在改革的第1年,所有教研活动的中心,目的不是上出精彩的课,而恰恰相反,改革的目的最重要的就是,在教师和学生之间建立起教师尊重每个学生的相互关系,以及学生之间相互影响

- yolov8涨点系列之替换幽灵卷积GhostConv

没脾气的小玩家

yolov8涨点系列YOLO目标检测

文章目录核心思想主要步骤优势yolov8.yaml文件增加CBAMyolov8.yamlyolov8.yaml将Conv卷积替换成GhostConv 幽灵卷积(GhostConv)是一种新颖的卷积操作方法,旨在解决传统卷积神经网络中参数量和计算量过大的问题,尤其适用于资源受限的设备。以下是对幽灵卷积的详细介绍:核心思想 常规的卷积操作会产生大量的特征图,其中存在一定的冗余信息。幽灵卷积的核心思

- DL00478-涡轮叶片缺陷检测数据集yolo格式1300张左右

涡轮叶片缺陷检测数据集yolo格式1300张左右涡轮叶片缺陷检测数据集YOLO格式解析:提升研究与论文写作的关键要点在研究涡轮叶片缺陷检测的过程中,数据集的选择和格式处理是一个至关重要的环节。特别是当你打算通过卷积神经网络(CNN)等深度学习模型进行缺陷检测时,数据集的标注和格式化直接影响到模型的训练效果和论文的质量。本文将重点探讨涡轮叶片缺陷检测数据集的YOLO格式,并分析如何利用这一格式为研究

- Android UI 组件系列(五):CheckBox、RadioButton 与 Switch 控件详解

博客专栏:Android初级入门UI组件与布局源码:通过网盘分享的文件:Android入门布局及UI相关案例链接:https://pan.baidu.com/s/1EOuDUKJndMISolieFSvXXg?pwd=4k9n提取码:4k9n引言在Android开发中,用户与应用的交互往往离不开各种“选择”操作,例如:注册表单中选择兴趣爱好(可多选)设置界面中切换通知、Wi-Fi开关(开/关状态)

- PyCharm高效入门指南:从零开始掌握Python开发利器

软考和人工智能学堂

Python开发经验强化学习PyCharm

引言PyCharm是JetBrains公司推出的一款强大的Python集成开发环境(IDE),被全球数百万Python开发者所青睐。无论你是Python初学者还是经验丰富的开发者,掌握PyCharm都能显著提升你的开发效率。本文将带你从零开始,全面了解PyCharm的核心功能和使用技巧。1.PyCharm的安装与配置1.1下载与安装首先访问JetBrains官网下载PyCharm。PyCharm有

- 2023-07-22

付宇杰

在我看来,王老师对整个课堂节奏把控的很好,从开始王老师从现实生活入手,将数学与实际相结合,通过现实生活中的数学问题引导学生进入课堂,接着就是王老师准备的六个例题,诱导引入,变式深入,带领学生逐步深入,了解学习排列问题的本质,王老师用准确、清晰、易懂、生动的语言,呈现知识,践行“以学生为主体“的课堂模式,选择适合该龄段的教学方法,从而激发学生的学习兴趣,促进学生的思维活动,能注意因材施教、因人施教,

- 秒火|得大妈者得天下,这个APP是如何通广场舞闷声发大财的?

秒火炎焱燚

知乎上有一个问题非常火:互联网行业有哪些闷声发大财的公司。结果排名第一的公司竟然是一个广场舞视频教学APP——糖豆。可能你的手机上并没有它的身影,但是妈妈们的手机上似乎都安装了它。而且如今的糖豆已经完成了c轮融资,直至今日已经获得包括腾讯在内的1亿美金的支持,这时候人们才发现原来糖豆网真的在闷声发大财。一个广场舞视频教学软件,究竟是如何快速如今大妈市场?今天我们就来聊聊糖豆网是如何做到得大妈者得天

- 开源模型应用落地-qwen模型小试-Qwen2.5-7B-Instruct-玩转ollama(一)

开源技术探险家

开源模型-实际应用落地#深度学习自然语言处理语言模型

一、前言在AI大模型百花齐放的时代,很多人都对新兴技术充满了热情,都想尝试一下。然而,实际上要入门AI技术的门槛非常高。除了需要高端设备,还需要面临复杂的部署和安装过程,这让很多人望而却步。在这样的背景下,Ollama的出现为广大开发者和爱好者提供了一条便捷的道路,极大地降低了应用机器学习的门槛。Ollama的优势在于其极致的简化。通过这个平台,用户可以轻松下载、运行和管理各种机器学习模型,而无需

- 刘萍萍老师《基于新课标的情境活动与学习任务群设计策略》学习

青箬笠0

刘萍萍新乡市基础教育教学研究室“让学生直接思考真实问题有助于激发和唤醒学生的理解。”(「美]格兰特·威金斯·「美」杰伊·麦克泰格《追求理解的教学设计》P44)所以要设计情境活动。一、情境活动与学习任务群概念从何而来“考试命题应以情境为载体,依据学生在真实情境下解决问题的过程和结果评定其素养水平。日常生活情境指向真实具体的社会生活,关注学生在生活场景中的语言实践,凸显语言交际活动的对象、目的和表述方

- 【流水账】平淡一日

金台望道

6月4日,星期五,晴【流水账】平淡一日早上:继续充实《启蒙第一课》第二册内容。上午:开始阅卷,半上午完成一个班的判卷。下午:参加教学改革经验座谈交流会,散会后搭同事便车一起回京。晚上:仅得完成当日百件文物之推送。

- 机器学习之——认识机器学习

-睡到自然醒~

golang重构开发语言

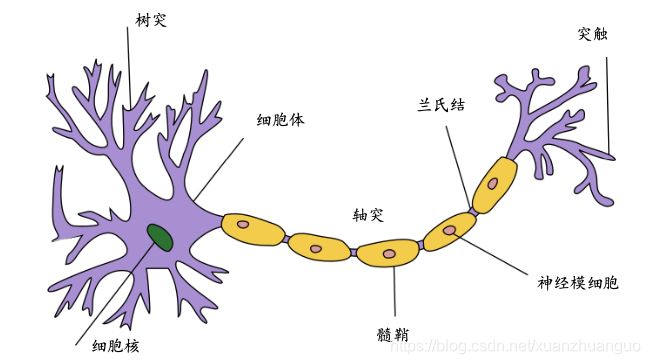

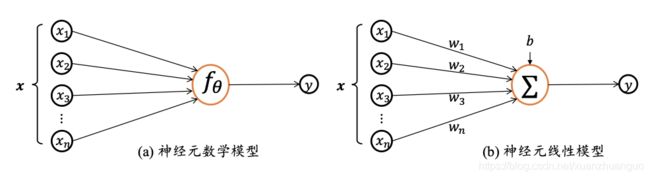

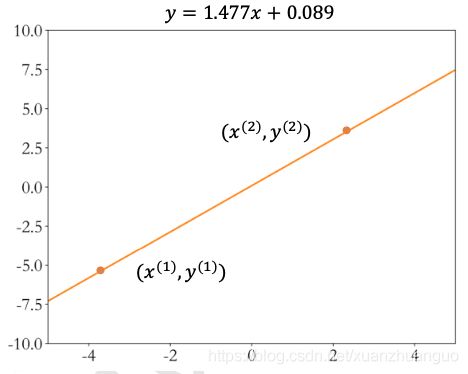

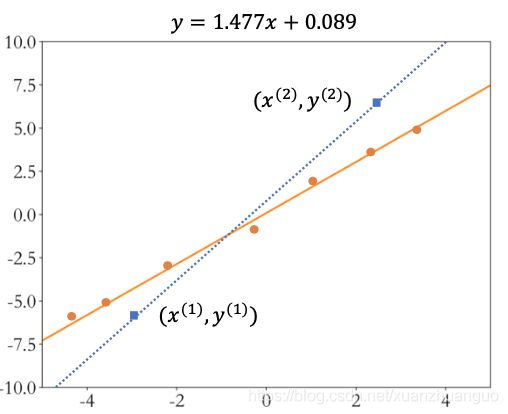

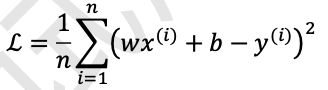

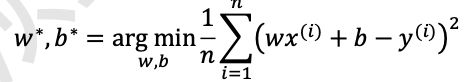

首先,什么是机器学习?参照百度百科的讲解,“机器学习是一门多领域交叉学科,设计概率论、统计学、逼近论、凸分析、算法复杂度理论等多门学科。专门研究计算机怎样模拟或实现人类的学习能力,以获取新的知识或技能,重新组织已有的知识结构使之不断改善自身的性能。”什么意思呢?也就是说,机器学习是一门跨领域的学科,是一种能够让机器模仿人类学习能力的一种学科。在Andrew的课程中,提到了几个机器学习的定义:1,A

- 王阳明心外无物,是一种先后观,不是主客观2022-05-08

仁也

王阳明心外无物,是一种先后观,不是主客观王阳明说的心外无物,不是在所谓的主客观层面上说的,不是说心之外就没有客观世界存在,如果你从主客观的层面来解读心学,其实是走偏了。【原文】爱问:“‘知止而后有定’,朱子以为‘事事物物皆有定理’,似与先生之说相戾。”【仁也详解】徐爱问:“知止而后有定”,朱熹认为是事事物物都有定理的意思,这个好像和先生的说法相悖?徐爱这里问的,还是“四书”中的入门书《大学》里面的

- Epoch

老兵发新帖

人工智能

在深度学习和机器学习中,Epoch(轮次或周期)是一个核心训练概念,指模型在整个训练数据集上完成一次完整遍历的过程。以下是关于Epoch的详细解析:一、核心定义基本含义Epoch表示模型将所有训练数据完整学习一次的过程。例如:若训练集有10,000个样本,则1个Epoch即模型用这10,000个样本训练一轮。与相关概念的关系Batch(批次):数据集被分割成的小组(如每批32个样本)。Iterat

- Python --- day 10 Opencv模块的使用

AnAn__kang

pythonopencv开发语言

系列文章目录前言今天博主带大家进入Opencv的学习,这是一个专门针对处理图像和视频的一个模块,大家以理解为主,增强自己的编程思维,再后续我们训练模型时会大批量的处理图片时会经常用到这个模块。1OpenCV介绍OpenCV(开放源代码计算机视觉库)是一个开源的计算机视觉和机器学习软件库。由一系列C++类和函数构成,用于图像处理、计算机视觉领域的算法实现。1.1OpenCV优势**开源免费:**完全

- 深度学习图像分类数据集—百种病虫害分类

AI街潜水的八角

深度学习图像数据集深度学习分类人工智能

该数据集为图像分类数据集,适用于ResNet、VGG等卷积神经网络,SENet、CBAM等注意力机制相关算法,VisionTransformer等Transformer相关算法。数据集信息介绍:百种病虫害识别分类,训练集45095张,验证集7508张,测试集22619张具体类别为以下:insect_classes=["rice_leaf_roller","rice_leaf_caterpillar

- apache ftpserver-CentOS config

gengzg

apache

<server xmlns="http://mina.apache.org/ftpserver/spring/v1"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="

http://mina.apache.o

- 优化MySQL数据库性能的八种方法

AILIKES

sqlmysql

1、选取最适用的字段属性 MySQL可以很好的支持大数据量的存取,但是一般说来,数据库中的表越小,在它上面执行的查询也就会越快。因此,在创建表的时候,为了获得更好的 性能,我们可以将表中字段的宽度设得尽可能小。例如,在定义邮政编码这个字段时,如果将其设置为CHAR(255),显然给数据库增加了不必要的空间,甚至使用VARCHAR这种类型也是多余的,因为CHAR(6)就可以很

- JeeSite 企业信息化快速开发平台

Kai_Ge

JeeSite

JeeSite 企业信息化快速开发平台

平台简介

JeeSite是基于多个优秀的开源项目,高度整合封装而成的高效,高性能,强安全性的开源Java EE快速开发平台。

JeeSite本身是以Spring Framework为核心容器,Spring MVC为模型视图控制器,MyBatis为数据访问层, Apache Shiro为权限授权层,Ehcahe对常用数据进行缓存,Activit为工作流

- 通过Spring Mail Api发送邮件

120153216

邮件main

原文地址:http://www.open-open.com/lib/view/open1346857871615.html

使用Java Mail API来发送邮件也很容易实现,但是最近公司一个同事封装的邮件API实在让我无法接受,于是便打算改用Spring Mail API来发送邮件,顺便记录下这篇文章。 【Spring Mail API】

Spring Mail API都在org.spri

- Pysvn 程序员使用指南

2002wmj

SVN

源文件:http://ju.outofmemory.cn/entry/35762

这是一篇关于pysvn模块的指南.

完整和详细的API请参考 http://pysvn.tigris.org/docs/pysvn_prog_ref.html.

pysvn是操作Subversion版本控制的Python接口模块. 这个API接口可以管理一个工作副本, 查询档案库, 和同步两个.

该

- 在SQLSERVER中查找被阻塞和正在被阻塞的SQL

357029540

SQL Server

SELECT R.session_id AS BlockedSessionID ,

S.session_id AS BlockingSessionID ,

Q1.text AS Block

- Intent 常用的用法备忘

7454103

.netandroidGoogleBlogF#

Intent

应该算是Android中特有的东西。你可以在Intent中指定程序 要执行的动作(比如:view,edit,dial),以及程序执行到该动作时所需要的资料 。都指定好后,只要调用startActivity(),Android系统 会自动寻找最符合你指定要求的应用 程序,并执行该程序。

下面列出几种Intent 的用法

显示网页:

- Spring定时器时间配置

adminjun

spring时间配置定时器

红圈中的值由6个数字组成,中间用空格分隔。第一个数字表示定时任务执行时间的秒,第二个数字表示分钟,第三个数字表示小时,后面三个数字表示日,月,年,< xmlnamespace prefix ="o" ns ="urn:schemas-microsoft-com:office:office" />

测试的时候,由于是每天定时执行,所以后面三个数

- POJ 2421 Constructing Roads 最小生成树

aijuans

最小生成树

来源:http://poj.org/problem?id=2421

题意:还是给你n个点,然后求最小生成树。特殊之处在于有一些点之间已经连上了边。

思路:对于已经有边的点,特殊标记一下,加边的时候把这些边的权值赋值为0即可。这样就可以既保证这些边一定存在,又保证了所求的结果正确。

代码:

#include <iostream>

#include <cstdio>

- 重构笔记——提取方法(Extract Method)

ayaoxinchao

java重构提炼函数局部变量提取方法

提取方法(Extract Method)是最常用的重构手法之一。当看到一个方法过长或者方法很难让人理解其意图的时候,这时候就可以用提取方法这种重构手法。

下面是我学习这个重构手法的笔记:

提取方法看起来好像仅仅是将被提取方法中的一段代码,放到目标方法中。其实,当方法足够复杂的时候,提取方法也会变得复杂。当然,如果提取方法这种重构手法无法进行时,就可能需要选择其他

- 为UILabel添加点击事件

bewithme

UILabel

默认情况下UILabel是不支持点击事件的,网上查了查居然没有一个是完整的答案,现在我提供一个完整的代码。

UILabel *l = [[UILabel alloc] initWithFrame:CGRectMake(60, 0, listV.frame.size.width - 60, listV.frame.size.height)]

- NoSQL数据库之Redis数据库管理(PHP-REDIS实例)

bijian1013

redis数据库NoSQL

一.redis.php

<?php

//实例化

$redis = new Redis();

//连接服务器

$redis->connect("localhost");

//授权

$redis->auth("lamplijie");

//相关操

- SecureCRT使用备注

bingyingao

secureCRT每页行数

SecureCRT日志和卷屏行数设置

一、使用securecrt时,设置自动日志记录功能。

1、在C:\Program Files\SecureCRT\下新建一个文件夹(也就是你的CRT可执行文件的路径),命名为Logs;

2、点击Options -> Global Options -> Default Session -> Edite Default Sett

- 【Scala九】Scala核心三:泛型

bit1129

scala

泛型类

package spark.examples.scala.generics

class GenericClass[K, V](val k: K, val v: V) {

def print() {

println(k + "," + v)

}

}

object GenericClass {

def main(args: Arr

- 素数与音乐

bookjovi

素数数学haskell

由于一直在看haskell,不可避免的接触到了很多数学知识,其中数论最多,如素数,斐波那契数列等,很多在学生时代无法理解的数学现在似乎也能领悟到那么一点。

闲暇之余,从图书馆找了<<The music of primes>>和<<世界数学通史>>读了几遍。其中素数的音乐这本书与软件界熟知的&l

- Java-Collections Framework学习与总结-IdentityHashMap

BrokenDreams

Collections

这篇总结一下java.util.IdentityHashMap。从类名上可以猜到,这个类本质应该还是一个散列表,只是前面有Identity修饰,是一种特殊的HashMap。

简单的说,IdentityHashMap和HashM

- 读《研磨设计模式》-代码笔记-享元模式-Flyweight

bylijinnan

java设计模式

声明: 本文只为方便我个人查阅和理解,详细的分析以及源代码请移步 原作者的博客http://chjavach.iteye.com/

import java.util.ArrayList;

import java.util.Collection;

import java.util.HashMap;

import java.util.List;

import java

- PS人像润饰&调色教程集锦

cherishLC

PS

1、仿制图章沿轮廓润饰——柔化图像,凸显轮廓

http://www.howzhi.com/course/retouching/

新建一个透明图层,使用仿制图章不断Alt+鼠标左键选点,设置透明度为21%,大小为修饰区域的1/3左右(比如胳膊宽度的1/3),再沿纹理方向(比如胳膊方向)进行修饰。

所有修饰完成后,对该润饰图层添加噪声,噪声大小应该和

- 更新多个字段的UPDATE语句

crabdave

update

更新多个字段的UPDATE语句

update tableA a

set (a.v1, a.v2, a.v3, a.v4) = --使用括号确定更新的字段范围

- hive实例讲解实现in和not in子句

daizj

hivenot inin

本文转自:http://www.cnblogs.com/ggjucheng/archive/2013/01/03/2842855.html

当前hive不支持 in或not in 中包含查询子句的语法,所以只能通过left join实现。

假设有一个登陆表login(当天登陆记录,只有一个uid),和一个用户注册表regusers(当天注册用户,字段只有一个uid),这两个表都包含

- 一道24点的10+种非人类解法(2,3,10,10)

dsjt

算法

这是人类算24点的方法?!!!

事件缘由:今天晚上突然看到一条24点状态,当时惊为天人,这NM叫人啊?以下是那条状态

朱明西 : 24点,算2 3 10 10,我LX炮狗等面对四张牌痛不欲生,结果跑跑同学扫了一眼说,算出来了,2的10次方减10的3次方。。我草这是人类的算24点啊。。

然后么。。。我就在深夜很得瑟的问室友求室友算

刚出完题,文哥的暴走之旅开始了

5秒后

- 关于YII的菜单插件 CMenu和面包末breadcrumbs路径管理插件的一些使用问题

dcj3sjt126com

yiiframework

在使用 YIi的路径管理工具时,发现了一个问题。 <?php

- 对象与关系之间的矛盾:“阻抗失配”效应[转]

come_for_dream

对象

概述

“阻抗失配”这一词组通常用来描述面向对象应用向传统的关系数据库(RDBMS)存放数据时所遇到的数据表述不一致问题。C++程序员已经被这个问题困扰了好多年,而现在的Java程序员和其它面向对象开发人员也对这个问题深感头痛。

“阻抗失配”产生的原因是因为对象模型与关系模型之间缺乏固有的亲合力。“阻抗失配”所带来的问题包括:类的层次关系必须绑定为关系模式(将对象

- 学习编程那点事

gcq511120594

编程互联网

一年前的夏天,我还在纠结要不要改行,要不要去学php?能学到真本事吗?改行能成功吗?太多的问题,我终于不顾一切,下定决心,辞去了工作,来到传说中的帝都。老师给的乘车方式还算有效,很顺利的就到了学校,赶巧了,正好学校搬到了新校区。先安顿了下来,过了个轻松的周末,第一次到帝都,逛逛吧!

接下来的周一,是我噩梦的开始,学习内容对我这个零基础的人来说,除了勉强完成老师布置的作业外,我已经没有时间和精力去

- Reverse Linked List II

hcx2013

list

Reverse a linked list from position m to n. Do it in-place and in one-pass.

For example:Given 1->2->3->4->5->NULL, m = 2 and n = 4,

return

- Spring4.1新特性——页面自动化测试框架Spring MVC Test HtmlUnit简介

jinnianshilongnian

spring 4.1

目录

Spring4.1新特性——综述

Spring4.1新特性——Spring核心部分及其他

Spring4.1新特性——Spring缓存框架增强

Spring4.1新特性——异步调用和事件机制的异常处理

Spring4.1新特性——数据库集成测试脚本初始化

Spring4.1新特性——Spring MVC增强

Spring4.1新特性——页面自动化测试框架Spring MVC T

- Hadoop集群工具distcp

liyonghui160com

1. 环境描述

两个集群:rock 和 stone

rock无kerberos权限认证,stone有要求认证。

1. 从rock复制到stone,采用hdfs

Hadoop distcp -i hdfs://rock-nn:8020/user/cxz/input hdfs://stone-nn:8020/user/cxz/运行在rock端,即源端问题:报版本

- 一个备份MySQL数据库的简单Shell脚本

pda158

mysql脚本

主脚本(用于备份mysql数据库): 该Shell脚本可以自动备份

数据库。只要复制粘贴本脚本到文本编辑器中,输入数据库用户名、密码以及数据库名即可。我备份数据库使用的是mysqlump 命令。后面会对每行脚本命令进行说明。

1. 分别建立目录“backup”和“oldbackup” #mkdir /backup #mkdir /oldbackup

- 300个涵盖IT各方面的免费资源(中)——设计与编码篇

shoothao

IT资源图标库图片库色彩板字体

A. 免费的设计资源

Freebbble:来自于Dribbble的免费的高质量作品。

Dribbble:Dribbble上“免费”的搜索结果——这是巨大的宝藏。

Graphic Burger:每个像素点都做得很细的绝佳的设计资源。

Pixel Buddha:免费和优质资源的专业社区。

Premium Pixels:为那些有创意的人提供免费的素材。

- thrift总结 - 跨语言服务开发

uule

thrift

官网

官网JAVA例子

thrift入门介绍

IBM-Apache Thrift - 可伸缩的跨语言服务开发框架

Thrift入门及Java实例演示

thrift的使用介绍

RPC

POM:

<dependency>

<groupId>org.apache.thrift</groupId>