Hadoop介绍

1、简述大数据研究的意义。

研究大数据,最重要的意义是预测。因为数据从根本上讲,是对过去和现在的归纳和总结,其本身不具备趋势和方向性的特征,但是我们可以应用大数据去了解事物发展的客观规律、了解人类行为,并且能够帮助我们改变过去的思维方式,建立新的数据思维模型,从而对未来进行预测和推测。比如,商业公司对消费者日常的购买行为和使用商品习惯进行汇总和分析,了解到消费者的需求,从而改进已有商品并适时推出新的商品,消费者的购买欲将会提高。知名互联网公司谷歌对其用户每天频繁搜索的词汇进行数据挖掘,从而进行相关的广告推广和商业研究。

1、简述什么是SSH以及SSH协议解决的问题。

SSH为Secure Shell的缩写,它是一种网络安全协议,专为远程登录会话和其他网络服务提供安全性的协议。通过使用SSH服务,可以把传输的数据进行加密,有效防止远程管理过程中的信息泄露问题。

2、简述Hadoop集群部署方式以及各方式使用场景。

(1)独立模式:又称为单机模式,在该模式下,无需运行任何守护进程,所有的程序都在单个JVM上执行。独立模式下调试Hadoop集群的MapReduce程序非常方便,所以一般情况下,该模式在学习或者开发阶段调试使用。

(2)伪分布式模式:Hadoop程序的守护进程运行在一台节点上,通常使用伪分布式模式用来调试Hadoop分布式程序的代码,以及程序执行是否正确,伪分布式模式是完全分布式模式的一个特例。

(3)完全分布式模式:Hadoop的守护进程分别运行在由多个主机搭建的集群上,不同节点担任不同的角色,在实际工作应用开发中,通常使用该模式构建企业级Hadoop系统。

大数据的特点

volume(大量) velocity(高速) variety(多样) value(低价值密度)

大数据的应用场景

物流仓储、零售、旅游、保险、金融、房产、人工智能

大数据部门组织结构

hadoop是什么?

狭义:hadoop是一个分布式系统基础框架

广义讲:hadoop是一个生态圈

主要解决,海量数据的存储 和海量数据的 分析计算问题

学习问题要从四个方面

它是什么?为什么用它?怎么用它?在哪里用?

hadoop是由三个部分组成的

hadoop1 hadoop2

common(辅助工具) common(辅助工具)

HDFS(数据存储) HDFS(数据存储)

MapReduce(计算+资源调整) MapReduce(计算)

计算:必然调用 cpu、 内存、 硬盘、 yarn(资源调度)

Hadoop的优势(四高)

高可靠:hadoop底层维护多个数据副本,所以即使hadoop某个计算元素或存储出现故障,也不会导致数据丢失。

高扩展性:在集群间分配任务,可方便的扩展数以千计的节点

高效性:hadoop是并行工作的,以加快任务的处理速度。

高容错性:能够自动将失败的任务重新分配。 它有很多台服务器 一台坏了还有其他的可以使用

HDFS架构概述

NameNode:存储文件的元数据,如文件名,文件目录结构,文件属性,以及每个文件的块列表和块所在的DateNode

DataNode(dei te node):在本地文件系统存储文件块数据,以及数据的校验

(2nn):辅助NameNode,分担其工作量;由于它上面有NameNode的信息备份,所以在NameNode出问题时,可以恢复NameNode,每隔一段时间对NameNode元数据进行备份。

yarn是干什么的?

是用来资源调度的。

yarn的组成部分?

ResourceManager(RM)(rui sao si mai nei ge):的主要作用是,处理客户端请求 、 监控NodeManager、启动或监控applicationMaster、资源的分配与调度

NodeManager(NM):的主要作用是,管理单个节点上的资源,处理来自ResourceManager和applicationMaster的命令

ApplicationMaster(AM)(a pu lei kei sen ma si te):负责数据的切分,为应用程序申请资源并分配给内部的任务,任务的监控与容错

Container(kang tei ne):是yarn中的资源抽象,它封装了某个节点上多个维度资源,如内存、cpu、磁盘、网络等。

MapReduce架构概述

MapReduce(mai pu rui diu si)将计算过程分为两个阶段:Map和Reduce

Map 阶段 就是对输入的数据进行清洗 处理 得到我们想要的数据

reduce 阶段 就是对map结果进行汇总 处理

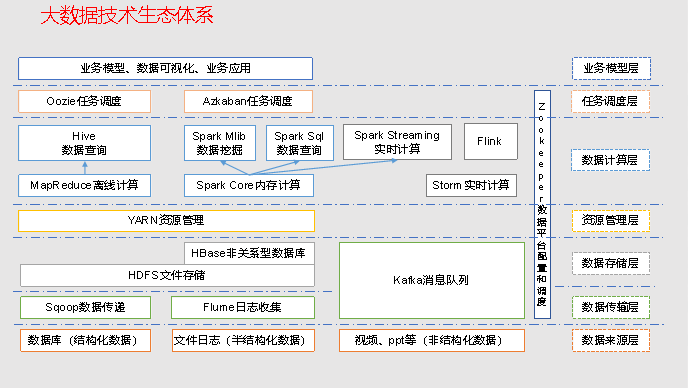

大数据技术的生态体系

大数据的生态体系 分为 数据来源层、数据传输层、数据存储层、资源管理层、数据计算层、任务调度层、业务模型层。

数据来源层 :里面有数据库(机构化数据),文件日志(半结构化数据),视频 ppt等(非结构化数据)

1.数据来源层:

数据库数据(机构化数据)

Oracle、MySQL、SqlServer…

文件日志数据(半结构化数据)

Tomcat 日志…

视频、PPT等(非结构化数据)

2.数据传输层:

Sqoop(sou po)

Sqoop是一款开源的工具,主要用于在Hadoop、Hive与传统的数据库(MySql)间进行数据的传递,可以将一个关系型数据库(例如 :MySQL,Oracle 等)中的数据导进到Hadoop的HDFS中,也可以将HDFS的数据导进到关系型数据库中。

Flume(fu lu mu)

Flume是Cloudera提供的一个高可用的,高可靠的,分布式的海量日志采集、聚合和传输的系统,Flume支持在日志系统中定制各类数据发送方,用于收集数据;同时,Flume提供对数据进行简单处理,并写到各种数据接受方(可定制)的能力。处理日志非常专业

Kafka

Kafka是一种高吞吐量的分布式发布订阅消息系统,有如下特性:

(1)通过O(1)的磁盘数据结构提供消息的持久化,这种结构对于即使数以TB的消息存储也能够保持长时间的稳定性能。

(2)高吞吐量:即使是非常普通的硬件Kafka也可以支持每秒数百万的消息。

(3)支持通过Kafka服务器和消费机集群来分区消息。

(4)支持Hadoop并行数据加载。

3.数据存储层:

HDFS

分布式文件存储系统,Hadoop最擅长存储数据的地方

Kafka

Kafka内部也能缓存一些数据,默认就是1G的数据,通常不拿它来存储数据

HBase

HBase是一个分布式的、面向列的开源数据库。HBase不同于一般的关系数据库,它是一个适合于非结构化数据存储的数据库。

非关系型数据库,使用的是列存储方式

4.资源管理层:

YARN资源调度

将数据存储下来,就需要对数据进行分析,分析就需要资源、CPU、内存、磁盘,

这些都由Yarn来调度

5.数据计算层:

数据计算,又分为:实时计算、离线计算 两部分

5.1 离线计算:

离线计算:主要来统计日活、月活、年统计、本月消费情况等,并不是实时的数据

MapReduce 离线计算(MR属于Hadoop的核心计算框架)

基于MR之上,有 Hive 和 Mahout 等数据分析工具

Hive:Hive是基于Hadoop的一个数据仓库工具,可以将结构化的数据文件映射为一张数据库表,并提供简单的SQL查询功能,可以将SQL语句转换为MapReduce任务进行运行。 其优点是学习成本低,可以通过类SQL语句快速实现简单的MapReduce统计,不必开发专门的MapReduce应用,十分适合数据仓库的统计分析。

Hive 底层就是 MapReduce,写 MapReduce 程序需要 Map、Reduce、Driver类,写起来比较麻烦。为了简化就有了 Hive,它通过简单的写一条 SQL 就可以实现 MapReduce 过程。Hive就是底层封装成MapReduce、上层就是写SQL

Mahout:Apache Mahout是个可扩展的机器学习和数据挖掘库,偏机器学习方向

Spark Core 基于内存离线计算(断电数据丢失,也很危险的)

基于Spark之上,集成了很多功能

Spark Mlib:机器学习的一些算法

Spark R:R语言是用于统计分析、绘图的语言和操作环境。R是属于GNU系统的一个自由、免费、源代码开放的软件,它是一个用于统计计算和统计制图的优秀工具

Spark Sql:和 Hive 很相似,写 Sql 实现分析计算的过程

5.2 实时计算:

Spark Streaming 准实时计算

Spark 是当前最流行的开源大数据内存计算框架。可以基于 Hadoop 上存储的大数据进行计算。

Spark Streaming 并不是完全实时的,它底层采用的是批处理技术(就是一批一批的处理,相当于是微批处理),所以说 Spark Streaming 是准实时计算

Storm:实时计算

Storm 是实时计算。Storm用于“连续计算”,对数据流做连续查询,在计算时就将结果以流的形式输出给用户。但是它已经在走下坡路了。新起的 Flink 项目更优秀

Flink():实时计算

Flink 是时下很流行的实时计算框架。全面对标 Spark。Flink 支持实时计算,由于 Flink 引擎比较强大,它也同样支持离线计算。

6.任务调度层

主要完成任务之间的执行调度问题。比如:任务何时启动、任务运行多长时间、r任务间的依赖问题,必须在A任务完成后才能执行B任务、多个任务的并行执行等,就需要用到任务调度了。

Oozie 任务调度

Oozie(you rei)是一个管理Hdoop作业(job)的工作流程调度管理系统

Oozie属于偏重量级的,功能是这三个调度中最复杂的。

Azkaban 任务调度

Azkaban,使用起来比较简单

crontab(kang tai bu) 任务调度

crontab 是 Linux自带的一个调度工具。

7.数据平台配置

Zookeeper

Zookeeper(zu kei bo)是Google的Chubby一个开源的实现。它是一个针对大型分布式系统的可靠协调系统,提供的功能包括:配置维护、名字服务、 分布式同步、组服务等。ZooKeeper的目标就是封装好复杂易出错的关键服务,将简单易用的接口和性能高效、功能稳定的系统提供给用户。

收集大数据生态体系中很多框架的配置信息,经常需要改变的统统都放到ZK中,如果改变时,只改变ZK中的配置就行。

比如:Spark 中易改变的配置,都放在ZK中,改完后进行配置分发即可(Spark比如有1000台机器,就很方便了

8.业务模型层

JavaEE

主要来解决企业问题,使用到的都是 JavaEE 相关技术,包括业务指标,数据可视化、BI报表等

Hadoop思维导图