LVS负载均衡和nat模式的实操

LVS理论和实操

- 一、企业群集应用概述

-

- 1、群集的含义

- 2、问题

- 3、解决方法

- 总结:

- 二、集群的分类

- 三、负载均衡群集架构

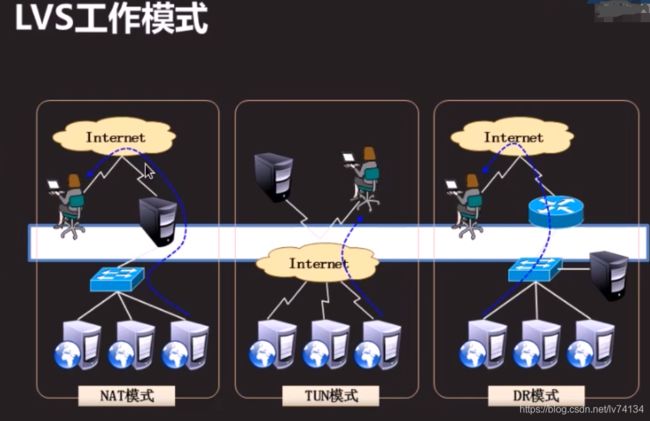

- 四、LVS负载均衡群集工作模式分析

-

- 1、负载均衡群集是目前企业用得最多的群集类型

- 2、群集的负载调度技术有3种工作模式

-

- (1)地址转换(NAT模式)

- (2)IP隧道(TUN模式)

- (3)直接路由(DR模式)

- 3、ip_ vs模块的版本信息

- 4、LVS的负载调度算法

-

- 4.1、轮询(Round Robin)

- 4.2、加权轮询 (Weighted Round Robin)

- 4.3、最少连接 (Least Connections )

- 4.4、加权最少连接(Weighted Least Connections )

- 五、LVS群集创建与管理

- 六、lvs负载均衡集群部署-NAT 模式

-

- 实验环境:

- 1、部署共享存储(NFS服务器:192.168.100.7)

- 2、配置节点服务器(后端服务器)

-

- 2.1设置web1目录

- 2.2、设置web2的目录

- 3、配置负载调度器LVS(ens33:192.168.100.254 ens36:192.168.99.100)

-

- (1)、配置SNAT转发规则

- (2)、加载LVS内核模块

- (3)、安装ipvsadm管理工具

- (4)、配置负载分配策

- (5)启动策略

- (6)测试(192.168.99.12)

一、企业群集应用概述

1、群集的含义

①、Cluster、集群、群集

②、由多台主机构成,但对外只表现为一个整体,只提供一个访问入口(域名与IP地址),相当于一台大型计算机。

集群的含义:一组通过高速网络互联的计算组,并以单一系统的模式加以管理

将很多服务器集中起来一起,提供同一种服务,在客户端看来就象是只有一个服务器

可以在付出较低成本的情况下获得在性能、可靠性、灵活性方面的相对较高的收益

任务调度是集群系统中的核心技术

2、问题

①、互联网应用中,随着站点对硬件性能、响应速度、服务稳定性、数据可靠性等要求越来越高,单台服务器已经无法满足负载均衡及高可用性的要求。

3、解决方法

①、使用价格昂贵的小型机、大型机

②、使用多台相对廉价的普通服务器构建服务集群

通过整合多台服务器,使用LVS来达到服务器的高可用和负载均衡,并且同一个IP地址对外提供相同的服务。

在企业中常用的一种集群技术——LVS(Linux Virtual Server,Linux虚拟服务器)

总结:

lvs服务器在集群中器调度任务的作用,用来转发数据包实现负载均衡(区别于nginx代理服务器的再次访问),可以把lvs服务器看成一个特殊的路由器

二、集群的分类

1、根据群集所针对的目标差异,可分为三种类型

①、负载均衡群集LB

#客户端负载在计算机集群中尽可能平均分摊

②、高可用群集HA

#避免单点故障,当一个系统发生故障时,可以快速迁移

③、高性能运算群集HPC

#通过集群开发并行应用程序,解决复杂的科学问题

三、负载均衡群集架构

1、负载均衡的结构

第一层,负载调度器(Load Balancer或Director)(前端:负载均衡层)

访问整个群集系统的唯一入口, 对外使用所有服务器共有的VIP地址,也称为群集IP地址。通常会配置主、备两台调度器实现热备份,当主调度器失效以后能够平滑替换至备用调度器,确保高可用性。

第二层,服务器池(Server Pool) (中间:服务器 群组层)

群集所提供的应用服务、由服务器池承担,其中每个节点具有独立的RIP地址(真实IP),只处理调度器分发过来的客户机请求。当某个节点暂时失效时,负载调度器的容错机制会将其隔离,等待错误排除以后再重新纳入服务器池。

第三层,共享存储(Share Storage) (底端:数据共享存储层)

为服务器池中的所有节点提供稳定、一致的文件存取服务, 确保整个群集的统一性共享存储可以使用NAS设备,或者提供NFS共享服务的专用服务器。

术语拓展:

Director Server:调度服务器-将负载分发到Real Server的服务器

Real Server :真实服务器

-真正提供应用服务的服务器

VIP:虚拟IP地址

-公布给用户访问的虚拟IP地址

RIP:真实IP地址

-集群节点上使用的IP地址

DIP:调度器连接节点服务器的IP地址

四、LVS负载均衡群集工作模式分析

1、负载均衡群集是目前企业用得最多的群集类型

2、群集的负载调度技术有3种工作模式

(1)地址转换(NAT模式)

● Network Address Translation,简称NAT模式

● 类似于防火墙的私有网络结构,负载调度器作为所有服务器节点的网关,即作为客户机的访问入口,也是各节点回应客户机的访问出口

● 服务器节点使用私有IP地址,与负载调度器位于同一个物理网络,安全性要优于其他两种方式

优点:集群中的物理服务器可以使用任何支持TCP/IP操作系统,只有负载均衡器需要一个合法的IP地址。

缺陷:在LVS(NAT)模式的集群环境中,由于所有的数据请求及响应的数据包都需要经过LVS调度器转发,如果后端服务器的数量大于10台,则调度器就会成为整个集群环境的瓶颈

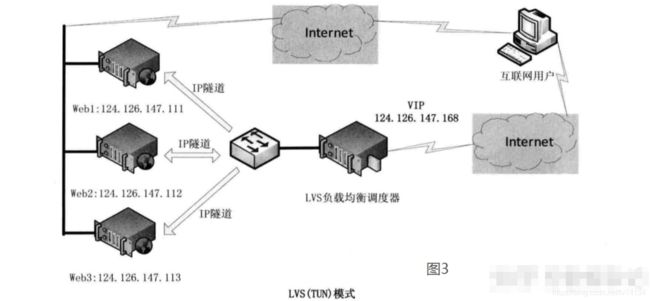

(2)IP隧道(TUN模式)

不常用

● 采用开放式的网络结构,负载调度器仅作为客户机的访问入口,各节点通过各自的Internet连接直接回应客户机,而不再经过负载调度器

● 服务器节点分散在互联网中的不同位置,具有独立的公网IP地址,通过专用IP隧道与负载调度器相互通信

#总结:简单而言,负载均衡器和服务器不在同一个区域(可能一个在上海,一个在深圳),负载均衡器转发数据包到真实服务器上时,需要的跨网段,所以将其做成隧道模式;返回包不经过lvs均衡器

优点:负载均衡器只负责将请求包分发给后端节点服务器,而RS将应答包直接发给用户。所以,减少了负载均衡器的大量数据流动,负载均衡器不再是系统的瓶颈,就能处理很巨大的请求量,这种方式,一台负载均衡器能够为很多RS进行分发。而且跑在公网上就能进行不同地域的分发。

缺陷:在LVS(TUN)模式下,由于需要在LVS调度器与真实服务器之间创建隧道连接,这同样会增加服务器的负担。 这种方式需要所有的服务器支持”IP Tunneling”(IP Encapsulation)协议,服务器可能只局限在部分Linux系统上。

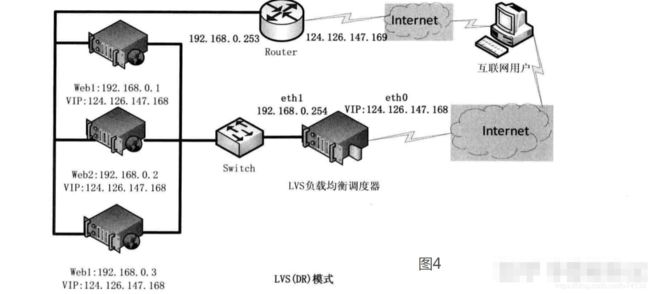

(3)直接路由(DR模式)

● Direct Routing,简称DR模式

● 采用半开放式的网络结构,与TUN模式的结构类似,但各节点并不是分散在各地,而是与调度器位于同一个物理网络

● 负载调度器与各节点服务器通过本地网络连接,不需要建立专用的IP隧道

优点:和TUN(隧道模式)一样,负载均衡器也只是分发请求,应答包通过单独的路由方法返回给客户端。与VS-TUN相比,VS-DR这种实现方式不需要隧道结构,因此可以使用大多数操作系统做为物理服务器。

缺陷:后端服务器和LVS调度器必须在同一机房

三种模式对比总结

性能:DR> TUN > NAT > FULL NAT

注意:DR模式的效率很高,但是配置稍微复杂一点,因此对于访问量不是特别大的公司可以用haproxy/nginx取代。日1000-2000W PV或者并发请求1万一下都可以考虑用haproxy/nginx。

(文献可参考:https://zhuanlan.zhihu.com/p/372073885)

3、ip_ vs模块的版本信息

LVS现在已成为Linux内核的一部分,默认编译为ip_ vs模块,必要时能够自动调用。在CentOS 7系统中,以下操作可以手动加载ip_ vs模块,并查看当前系统中ip_ vs模块的版本信息。

modprobe ip_vs

cat /proc/net/ip_vs #确认内核对LVS的支持

4、LVS的负载调度算法

目前lvs 可实现的调度算法有10中,常用的有以下4种

4.1、轮询(Round Robin)

● 将收到的访问请求按照顺序轮流分配给群集中的各节点(真实服务器) ,均等地对待每一台服务器 ,而不管服务器实际的连接数和系统负载

简称rr

4.2、加权轮询 (Weighted Round Robin)

● 根据调度器设置的权重值来分发请求,权重值高的节点优先获得任务,分配的请求数越多

● 保证性能强的服务器承担更多的访问流量

简称wrr

4.3、最少连接 (Least Connections )

● 根据真实服务器已建立的连接数进行分配,将收到的访问请求优先分配给连接数最少的节点(谁少给谁)

简称lc

4.4、加权最少连接(Weighted Least Connections )

● 在服务器节点的性能差异较大时,可以为真实服务器自动调整权重

● 性能较高的节点将承担更大比例的活动连接负载

简称wlc

阿里云支持轮询和最小连接

五、LVS群集创建与管理

①、步骤

1、创建虚拟服务器

2、添加、删除服务器节点

3、查看群集及节点情况

4、保存负载分配策略

LVS的管理工具是ipvsadm

②、ipvsadm工具选项说明

-A 添加虚拟服务器

-D 删除整个虚拟服务器

-E 修改虚拟服务器

-C 清空所有

-l 列表查看 LVS 虚拟服务器 (默认为查看所有)

-s 指定负载调度算法 (轮询:rr、加权轮询: wrr、最少连接: lc、加权最少连接: wlc )

-a 表示添加真实服务器 (节点服务器)

-d 删除某一个节点

-e 修改真实虚拟器

-t 指定 VIP地址及 TCP端口

-r 指定 RIP地址及 TCP端口

-m 表示使用 NAT群集模式.

-g 表示使用 DR模式

-i 表示使用 TUN模式

-w 设置权重 (权重为 0 时表示暂停节点)

-p 60 表示保持长连接60秒

-n 以数字形式显示地址、端口等信息,常与 “-l” 选项组合使用。ipvsadm -ln

需要通过ipvsadm 管理lvs

yum -y install ipvsadm

[root@manager scripts]# ipvsadm -A -t 192.168.100.8:80 -s lc

# -A 创建,-t指定协议tcp,-s指定调度算法

[root@manager scripts]#

[root@manager scripts]# ipvsadm -L

IP Virtual Server version 1.2.1 (size=4096)

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

TCP manager:http lc

六、lvs负载均衡集群部署-NAT 模式

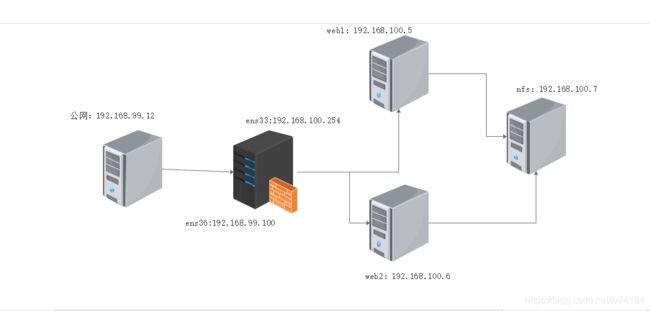

实验环境:

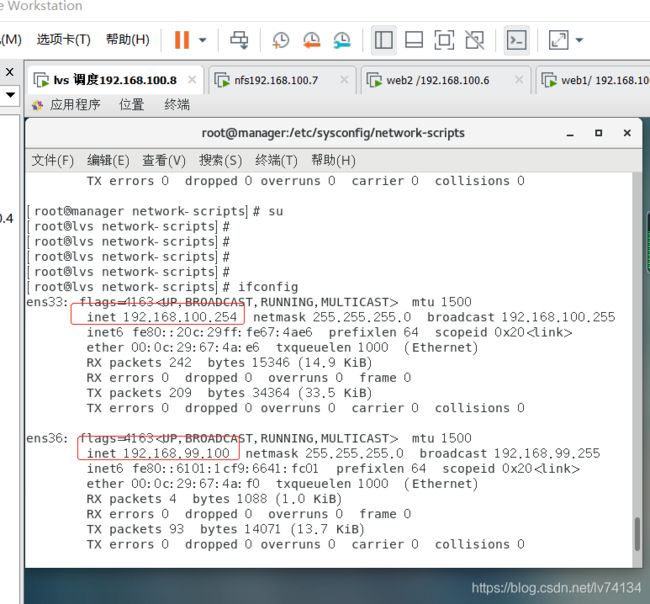

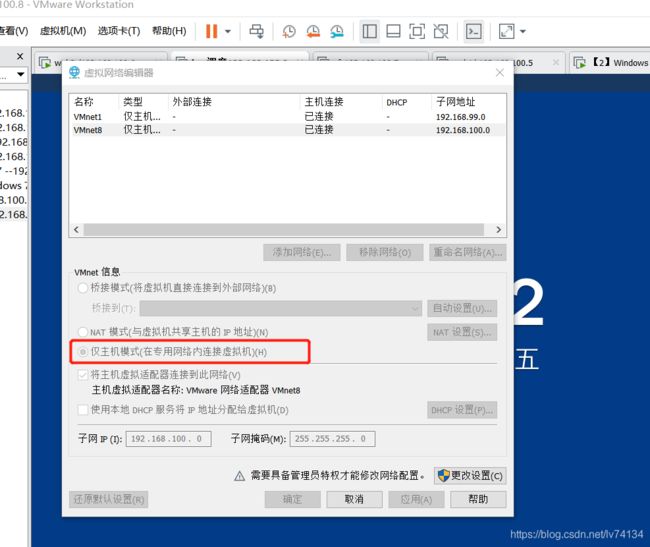

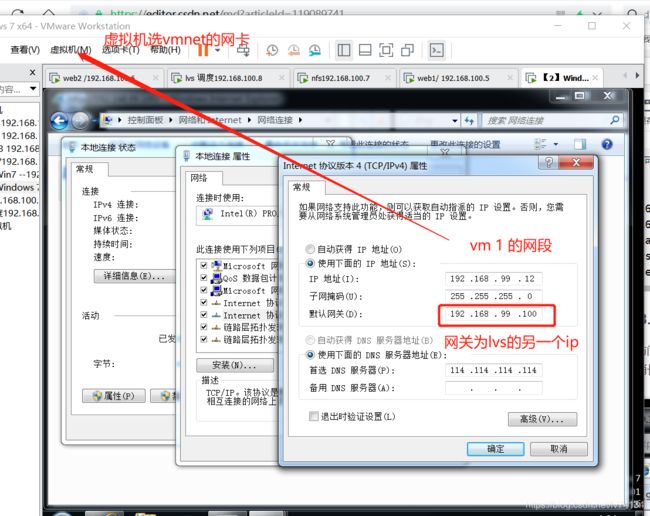

LVS负载调度器:ens33:192.168.100.254 ens36:192.168.99.100(vmnet1)

Web 节点服务器1:192.168.100.5

Web 节点服务器2:192.168.100.6

NFS服务器:192.168.100.7

客户端(win10):192.168.99.10 (Vmnet1)

PS:

① win10虚拟机(客户端)网关设置为192.168.99.100 (指向lvs调度器上第一个网卡)

② web服务器 网关设置为 192.168.100.254(指向第二块网卡)

hostnamectl set-hostname nfs

su

hostnamectl set-hostname web1

su

hostnamectl set-hostname web2

su

hostnamectl set-hostname lvs

su

1、部署共享存储(NFS服务器:192.168.100.7)

关闭防火墙

systemctl stop firewalld.service

systemctl disable firewalld.service

setenforce 0

下载和启动nfs服务

yum install -y nfs-utils rpcbind

systemctl start nfs.service

systemctl start rpcbind.service

systemctl enable nfs.service

systemctl enable rpcbind.service

挂载目录

mkdir /opt/kgc /opt/accp

chmod 777 /opt/kgc /opt/accp/

vim /etc/exports #用户可以把需要共享的文件系统直接编辑到/etc/exports文件中,这样当NFS服务器重新启动时系统就会自动读取/etc/exports 文件

/opt/kgc 192.186.100.0/24(rw,sync,no_root_squash)

/opt/accp 192.186.100.0/24(rw,sync,no_root_squash)

#发布共享

exportfs -rv

showmount -e #检查nfs是否设置成功

[root@nfs ~]# exportfs -rv

exporting 192.186.100.0/24:/opt/accp

exporting 192.186.100.0/24:/opt/kgc

[root@nfs ~]# showmount -e

[root@nfs ~]# showmount -e

Export list for master:

/opt/accp 192.186.100.0/24

/opt/kgc 192.186.100.0/24

2、配置节点服务器(后端服务器)

192.168.100.6、192.168.100.5

systemctl stop firewalld.service

systemctl disable firewalld.service

setenforce 0

#修改web的网卡网关为LVS服务器,设置静态路由

TYPE=Ethernet

PROXY_METHOD=none

BROWSER_ONLY=no

BOOTPROTO=static #设置静态

DEFROUTE=yes

IPV4_FAILURE_FATAL=no

IPV6INIT=yes

IPV6_AUTOCONF=yes

IPV6_DEFROUTE=yes

IPV6_FAILURE_FATAL=no

IPV6_ADDR_GEN_MODE=stable-privacy

NAME=ens33

UUID=a84eac34-bb29-4fe8-a4c6-def7c2ace97f

DEVICE=ens33

ONBOOT=yes

IPADDR=192.168.100.5 #另一台为192.168.100.6

GATEWAY=192.168.100.254 #网关指向lvs调度器的内网ip

NETMASK=255.255.255.0

yum install -y httpd

systemctl start httpd.service

systemctl enable httpd.service

yum install -y nfs-utils rpcbind

systemctl start rpcbind.service

systemctl enable rpcbind.service

showmount -e 192.168.100.7 #检查nfs是否设置成功

2.1设置web1目录

mount.nfs 192.168.100.7:/opt/kgc /var/www/html/

echo 'this is gcc'

> /var/www/html/index.html #设置页面

vim /etc/fstab #磁盘被手动挂载之后都必须把挂载信息写入/etc/fstab这个文件中,否则下次开机启动时仍然需要重新挂载

192.168.100.7:/opt/gcc /var/www/html nfs defaults,_netdev 0 0

mount -a

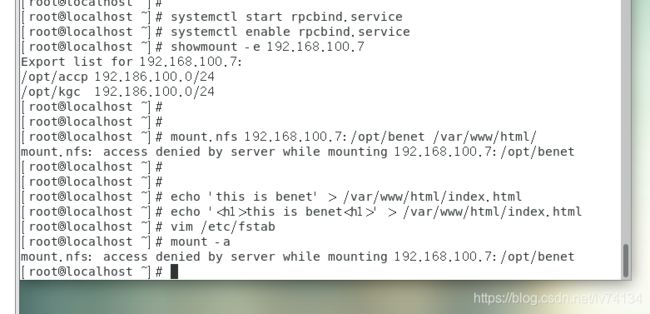

2.2、设置web2的目录

mount.nfs 192.168.100.7:/opt/benet /var/www/html/

echo 'this is benet' > /var/www/html/index.html

vim /etc/fstab

192.168.100.7:/opt/benet /var/www/html nfs defaults,_netdev 0 0

mount -a

3、配置负载调度器LVS(ens33:192.168.100.254 ens36:192.168.99.100)

systemctl stop firewalld.service

systemctl disable firewalld.service

setenforce 0 #关闭防火墙

[root@lvs ~]# cp /etc/sysconfig/network-scripts/ifcfg-ens33 /etc/sysconfig/network-scripts/ifcfg-ens36

[root@lvs ~]# vim /etc/sysconfig/network-scripts/ifcfg-ens36

TYPE="Ethernet"

PROXY_METHOD="none"

BROWSER_ONLY="no"

BOOTPROTO="static" #设置为静态ip

DEFROUTE="yes"

IPV4_FAILURE_FATAL="no"

IPV6INIT="yes"

IPV6_AUTOCONF="yes"

IPV6_DEFROUTE="yes"

IPV6_FAILURE_FATAL="no"

IPV6_ADDR_GEN_MODE="stable-privacy"

NAME="ens36"

DEVICE="ens36"

ONBOOT="yes" #开机自动识别

IPADDR=192.168.99.100 #这个ip不为其设置网关

NETMASK=255.255.255.0

[root@lvs ~]# vim /etc/sysconfig/network-scripts/ifcfg-ens33

TYPE=Ethernet

PROXY_METHOD=none

BROWSER_ONLY=no

BOOTPROTO=static #设置为静态

DEFROUTE=yes

IPV4_FAILURE_FATAL=no

IPV6INIT=yes

IPV6_AUTOCONF=yes

IPV6_DEFROUTE=yes

IPV6_FAILURE_FATAL=no

IPV6_ADDR_GEN_MODE=stable-privacy

NAME=ens33

UUID=d84cd1bf-01dc-4841-bf64-f65375841a81

DEVICE=ens33

ONBOOT=yes

IPADDR=192.168.100.254 #ip地址为web1与2的网关

NETMASK=255.255.255.0 #不设置网关

~

(1)、配置SNAT转发规则

#加载路由器功能

vim /etc/sysctl.conf

net.ipv4.ip_forward=1

sysctl -p

iptables -t nat -F

iptables -F #清除规则

#配置nat地址转换

iptables -t nat -A POSTROUTING -s 192.168.100.0/24 -o ens36 -j SNAT --to-source 192.168.99.100

#nat表:修改数据包中的源、目标IP地址或端口

POSTROUTING: 在进行路由判断之"后"所要进行的规则(SNAT/MASQUERADE)

PREROUTING: 在进行路由判断之"前"所要进行的规则(DNAT/REDIRECT)

-A: 在规则链的末尾加入新规则

-s:匹配来源地址IP/MASK.

-o 网卡名称匹配从这块网卡流出的数据

-i 网卡名称匹配从这块网卡流入的数据

-j 控制类型

(2)、加载LVS内核模块

[root@lvs network-scripts]# modprobe ip_vs # #手动加载ip_vs模块

[root@lvs network-scripts]# cat /proc/net/ip_vs # #查看ip_vs版本信息

IP Virtual Server version 1.2.1 (size=4096)

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

[root@lvs network-scripts]#

(3)、安装ipvsadm管理工具

[root@lvs network-scripts]# yum install -y ipvsadm #安装ipvsadm

[root@lvs network-scripts]# ipvsadm-save > /etc/sysconfig/ipvsadm ##注意:启动服务前必须保存负载分配策略,否则将会报错

[root@lvs network-scripts]#

[root@lvs network-scripts]# systemctl start ipvsadm.service

(4)、配置负载分配策

(NAT模式只要在服务器上配置,节点服务器不需要特殊配置)

写成脚本

[root@lvs network-scripts]# vim /opt/nat.sh

#!/bin/bash

ipvsadm -C

ipvsadm -A -t 192.168.99.100:80 -s rr

ipvsadm -a -t 192.168.99.100:80 -r 192.168.100.5:80 -m -w 1

ipvsadm -a -t 192.168.99.100:80 -r 192.168.100.6:80 -m -w 1

ipvsadm

~

#解析

-A 添加虚拟服务器

-s 指定负载调度算法 (轮询:rr、加权轮询: wrr、最少连接: lc、加权最少连接: wlc )

-a 表示添加真实服务器 (后端节点服务器)

-t 指定 VIP地址及 TCP端口

-m 表示使用 NAT群集模式.

-w 设置权重 (权重为 0 时表示暂停节点)

(5)启动策略

cd /opt

[root@lvs opt]# chmod +x nat.sh

[root@lvs opt]# ./nat.sh

IP Virtual Server version 1.2.1 (size=4096)

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

TCP lvs:http rr

-> 192.168.100.5:http Masq 1 0 0

-> 192.168.100.6:http Masq 1 0 0

[root@lvs opt]# ipvsadm-save > /etc/sysconfig/ipvsadm #保存策略

备注:其他在实际生产中可能用到的指令

```cpp

ipvsadm -d -t 192.168.100.10:80 -r 192.168.226.129:80 -m -w 1 #删除群集中某一节点服务器

ipvsadm -D -t 192.168.100.10:80 #删除整个虚拟服务器

systemctl stop ipvsadm #停止服务(清除策略)

systemctl start ipvsadm #启动服务(重建规则)

ipvsadm-restore > /etc/sysconfig/ipvsadm #恢复LVS策略

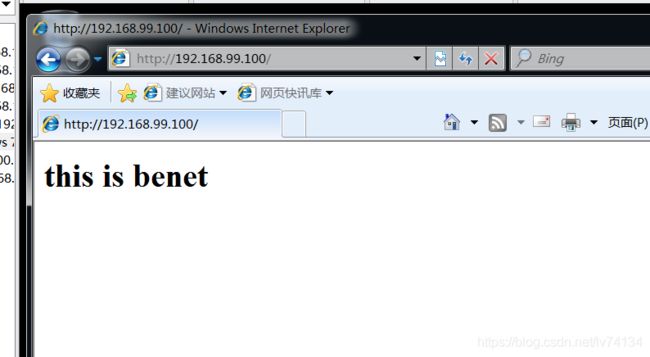

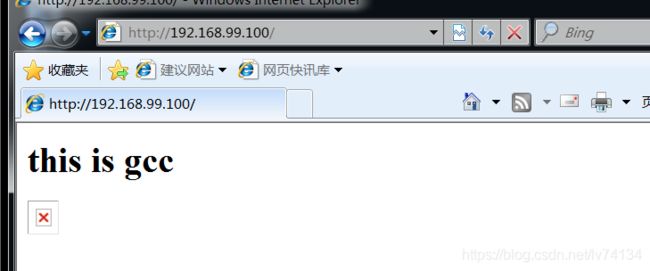

(6)测试(192.168.99.12)

在win10上使用浏览器访问192.168.99.100,刷新浏览器测试负载均衡

PS:刷新间隔时间需要稍长一点

总结:lvs上的两种相对比较麻烦,网卡编辑器是全局的,所有vmnet8也选为net模式,就可以单独设置网关了

ipvsadm规则组好写成脚本

lvs的nat模式其瓶颈是中间的lvs调度器。