datawhale组队学习task1(跳过的后续补充)

第一章 绪论

引言

- 机器学习致力于研究如何让通过计算的手段,利用经验来改善自身的性能;

- 经验通常以数据的形式存在,因此,机器学习所研究的内容,是关于在计算机上从数据中产生模型的算法,即学习算法

基本术语

数据集:(色泽=青绿;根蒂=蜷缩;敲声=浊响), (色泽=乌黑;根蒂:稍蜷;敲声=沉 闷), (色泽=浅自;根蒂 硬挺;敲声=清脆),……

示例/样本:(色泽=青绿;根蒂=蜷缩;敲声=浊响)

属性/特征:色泽、根蒂、敲声

属性值/特征值:青绿、乌黑…

样本空间/属性空间/输入空间:属性值张成的空间,例如我们把"色泽" “根蒂” "敲声"作为三个坐标轴,则它们张成 一个用于描述西瓜的三维空间,每个西瓜都可在这个空间中找到自己的坐标位置。

特征向量:于空间中的每个点对应一个坐标向量,因此我们也把…个示例称为一个 “特征向量”

一般地,

D = { x 1 , x 2 , . . . x m } 可以看成 D = { x 1 ⃗ , x 2 ⃗ , . . . x m ⃗ } D = \{x_1,x_2,...x_m\} \\ 可以看成 D = \{\vec{x_1},\vec{x_2},...\vec{x_m}\} D={x1,x2,...xm}可以看成D={x1,x2,...xm}

表示包含 个示例的数据集,每个 示例由 个属性描述(例如上面的西瓜数据使用了 个属性,则每个示例

x i ⃗ = x i = ( x i 1 , x i 2 , . . . x i d ) \vec{x_i} = x_i = (x_{i1},x_{i2},...x_{id}) xi=xi=(xi1,xi2,...xid)

维样本空间 中的一个向量 Xi 其中 Xij 凯在第 个属性上的取值(例如上述第 个西瓜在第 个属性上的值是"硬 挺" ), 称为样本院的"维数" (dimensionality).

( ( 色泽 : 青绿 ; 根蒂二蜷缩 ; 敲声 = 浊响 ) ,好瓜 ) ((色泽:青绿;根蒂二蜷缩; 敲声=浊响),好瓜) ((色泽:青绿;根蒂二蜷缩;敲声=浊响),好瓜)

”好瓜“ :标记(label)

样例: 拥有标记信息的示例

标记空间\输出空间 :

一般的,用 ( x i , y i ) 表示第 i 个样例,其中 y i ∈ Y 是示例 x i 的标记 Y 是所有标记的集合 , 被称为标记空间或者输出空间 一般的,用(x_i,y_i)表示第i个样例,其中y_i\in Y是示例x_i的标记 \\ Y是所有标记的集合, 被称为标记空间或者输出空间 一般的,用(xi,yi)表示第i个样例,其中yi∈Y是示例xi的标记Y是所有标记的集合,被称为标记空间或者输出空间

分类与回归

一般地,预测任务是希望通过对训练

{ ( x 1 , y 1 ) , ( x 2 , y 2 ) , . . . , ( x m , y m ) } \{(x_1, y_1) , (x_2 , y_2) ,..., (x_m, y_m)\} {(x1,y1),(x2,y2),...,(xm,ym)}

进行学习,建立一个从输入空间到输出空间的映射

f : χ ⟼ Y . f: \chi \longmapsto Y. f:χ⟼Y.

对二分类任务,通常令

Y = { − 1 , + 1 } 或 { 0 , 1 } ; Y= \{-1 ,+ 1\}\quad 或 \quad\{0,1\}; Y={−1,+1}或{0,1};多分类任务:

∣ Y ∣ > 2 ∗ ∣ { ⋅ ⋅ ⋅ } ∣ 表示集合 { ⋅ ⋅ ⋅ } 中的元素 |Y| >2 \quad\quad \\* |\{···\}| 表示集合\{···\}中的元素 ∣Y∣>2∗∣{⋅⋅⋅}∣表示集合{⋅⋅⋅}中的元素

对回归任务,

Y = R , R 为实数集 . Y= R,R为实数集. Y=R,R为实数集.

假设空间

机器学习中可能的函数构成的空间称为“假设空间”。

监督学习的目的在于学习一个由输入到输出的映射,这一映射由模型来表示。换句话说,学习的目的就在于找到最好的这样的模型。模型属于由输入空间到输出空间的映射的集合,这个集合就是假设空间(hypothesis space)。假设空间的确定意味着学习的范围的确定。

---- 百度百科

归纳偏好

先跳过

第二章 模型评估与选择

经验误差与过拟合

-

把分类错误的样本数占样本总量的比例称为**“错误率”**,即如果在m个样本中有a个样本分类错误,则错误率

E = a / m 相应的 1 − a / m 称为精度 一般写为 E = ( 1 − a / m ) ∗ 100 % E = a/m\\ 相应的\quad 1-a/m \quad称为精度\\ 一般写为 \quad E = (1-a/m)*100\% \quad E=a/m相应的1−a/m称为精度一般写为E=(1−a/m)∗100% -

误差、训练误差、经验误差、泛化误差

- 学习器的实际预测输出与样本的真实输出之间的差异称为"误差" (error),

- 学习器在训练集上的误差称为"训练误差" (training error) 或"经验误 差" (empirical error)

- 在新样本上的误差称为"泛化误差" (generalization error).

-

过拟合和欠拟合

“我们实际希望的,是在新样本上能表现得很好的学习器.为了达到这个 目的,应该从训练样本中尽可能学出适用于所有潜在样本的"普遍规律”,这 样才能在遇到新样本时做出正确的判别.然而,当学习器把训练样本学得"太 好"了的时候,很可能巳经把训练样本自身的一些特点当作了所有潜在样本都 会具有的一般性质,这样就会导致泛化性能下降这种现象在机器学习中称为 “过拟合” (overfitting). 与"过拟合"相对的是"欠拟合" (underfitting) ,这 是指对训练样本的一般性质尚未学好."

--------- 西瓜书

评估方法

目的与背景

机器学习需要将数据集分为测试集和训练集,用训练集得出的模型在测试集上得出测试误差,所以测试集应该尽量的与训练集相互互斥。

1. 留出法

直接将数据集 D划分为两个互斥的集合,其中一个 集合作为训练集 S,另一个作为测试集 T,即

D = S ∪ T , S ∩ T = ∅ D = S\cup T, S\cap T = \emptyset D=S∪T,S∩T=∅

在 S上训 练出模型后,用 T来评估其测试误差,作为对泛化误差的估计.常见做法是将大约4/5 样本用于训练,剩余样本用 测试。

2. 交叉验证呢法

“交叉验证法” (cross alidation) 将数据D分为k个大小相似的 互斥子集,

D = D 1 ∪ D 2 ∪ . . . ∪ D k , D i ∩ D j = ∅ ( i ≠ j ) D = D_1\cup D_2 \cup ...\cup D_k, D_i\cap D_j = \emptyset (i\neq j) D=D1∪D2∪...∪Dk,Di∩Dj=∅(i=j)

每个子集Di尽可 保持数据分布的 致性,即从D通过分层采样得到.然 后,每次用 k-1 子集的并集作为训练集。余下的那个子集作测试集;这样就可获得k组训练/测试集,从而可进行k次训练和测试?.最终返回的是K个测试结果 的均值。

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-XiR7EeZv-1673955633014)(C:\Users\puthmars\AppData\Roaming\Typora\typora-user-images\image-20230117190957632.png)]

3. 自助法

问题:在留出法和交叉验证法中,由于保留了一部分样本用于测试,造成的结果就是实际评估的模型所使用的训练集比D小。

自助法给定m个样本的数据集D,我们对他进行采样产生数据集D’ :每次随即从D中跳出一个样本,将其拷贝放入D’,然后再将该样本放回初始的数据集D中,使得下一次能够被再次采到。这个过程经过m次后,可以得到包含m个样本的数据集D’。

样本在 m 次采样中始终不被采到的概率是 ( 1 − 1 m ) m 取极限得 lim m → + ∞ ( 1 − 1 m ) m = 1 e ≈ 0.368 样本在m次采样中始终不被采到的概率是\quad (1-\frac{1}{m})^m \quad 取极限得\\ \lim_{m\rightarrow+\infty}(1-\frac{1}{m})^m = \frac{1}{e} \approx 0.368 样本在m次采样中始终不被采到的概率是(1−m1)m取极限得m→+∞lim(1−m1)m=e1≈0.368

适用范围

自助法适用于数据集较小、难以有效划分训练/测试集时很有用,但是自助法产生的数据改变了初始数据集得分布,这会引入估计偏差

所以当数据量充足的情况下适用于留出法和交叉验证法

调参与最终模型

性能度量

回归任务

回归任务最常用的性能度量时**“均方误差”**

E ( f ; D ) = 1 m ∑ i = 0 m ( f ( x i ) − y i ) 2 对于数据分布 D 和概率密度函数 p ( ∗ ) , 均方误差可描述为 E ( f ; D ) = ∫ x ∼ D ( f ( x ) − y ) 2 p ( x ) d x E(f;D) = \frac{1}{m}\sum_{i = 0}^m(f(x_i)-y_i)^2 \\ 对于数据分布D和概率密度函数p(*),均方误差可描述为 \\ E(f;D) = \int_{x\sim D}(f(x)-y)^2p(x)dx E(f;D)=m1i=0∑m(f(xi)−yi)2对于数据分布D和概率密度函数p(∗),均方误差可描述为E(f;D)=∫x∼D(f(x)−y)2p(x)dx

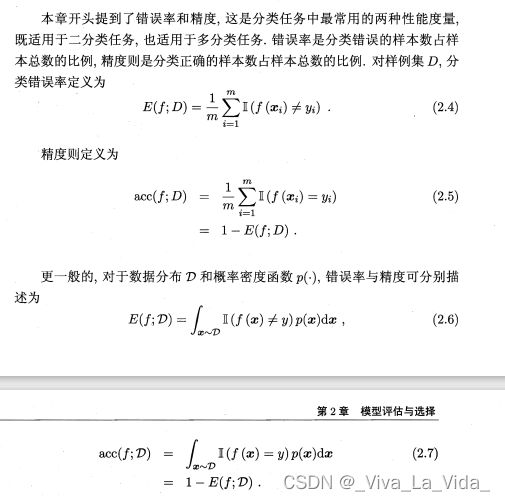

错误率与精度

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-Z6MS06Jr-1673955633015)(

image-20230117193655337.png)]