【云计算】Hadoop环境搭建

目录

一、环境准备

二、把Linux系统设置成固定IP

三、建立Hadoop用户

3.1、创建hadoop用户

3.2、修改 hadoop 用户权限

3.3、切换为 hadoop 用户

3.4、更新源

3.5、检查 SSH服务

3.6、配置 SSH 无密码登录

四、 安装 Java 环境

五、安装hadoop

六、Hadoop单机配置

使用MapReduce测试单词出现的次数

七、Hadoop 伪分布式配置

7.1修改配置文件,运行HDFS分布式文件系统

7.2修改 core-site.xml 文件

7.3修改 hdfs-site.xml 文件

7.4修改 hadoop-env.sh 配置文件

7.5 NameNode 格式化

7.6开启 NameNode 和 DataNode

7.7使用浏览器访问web界面

一、环境准备

VMware 15 版本以上

Linux CenterOS 7 64位 【linux学习笔记】红帽Linux 7.8系统在虚拟机上的安装_Ein hübscher Kerl.的博客-CSDN博客_红帽linux 虚拟机

Xshell 5

【Linux学习笔记】远程控制Linux主机_Ein hübscher Kerl.的博客-CSDN博客_linux远程主机

JDK 1.8

Hadoop 3.1.3

二、把Linux系统设置成固定IP

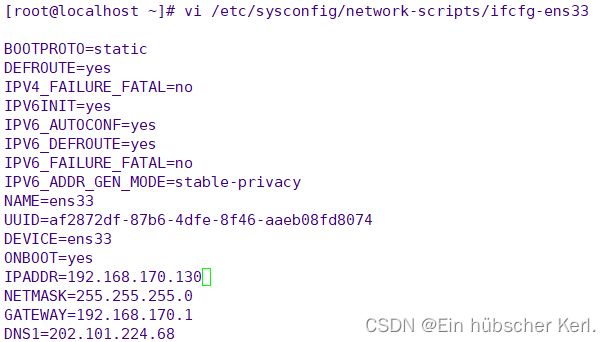

Linux设置静态IP在/etc/sysconfig/network-scripts/ifcfg-ens33文件中,在文件中设置固定IP即可,这里IP固定为192.168.170.130

vi /etc/sysconfig/network-scripts/ifcfg-ens33

TYPE=Ethernet

PROXY_METHOD=none

BROWSER_ONLY=no

BOOTPROTO=static #dhcp改为static

DEFROUTE=yes

IPV4_FAILURE_FATAL=no

IPV6INIT=yes

IPV6_AUTOCONF=yes

IPV6_DEFROUTE=yes

IPV6_FAILURE_FATAL=no

IPV6_ADDR_GEN_MODE=stable-privacy

NAME=ens33

UUID=af2872df-87b6-4dfe-8f46-aaeb08fd8074

DEVICE=ens33

ONBOOT=yes

IPADDR=192.168.170.130 #增加一下内容

NETMASK=255.255.255.0

GATEWAY=192.168.170.1

DNS1=202.101.224.68

reboot #修改完IP需要重启一下

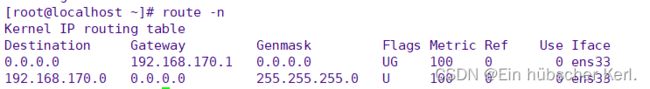

查看网关命令route -n

三、建立Hadoop用户

Linux权限最高的是root用户,但是搭建Hadoop环境必须创建一个普通用户,使用普通用户来搭建环境,千万不要用root用户搭建,会出现一些意想不到的问题。

3.1、创建hadoop用户

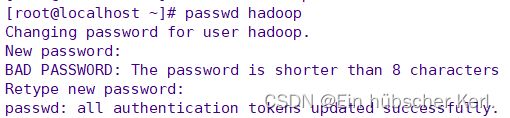

使用root用户来创建hadoop用户,用户与用户组都是hadoop

[root@localhost ~] useradd hadoop #创建hadoop用户,用户组也是hadoop设置hadoop密码需要输入两次,这里密码设置为:hadoop

3.2、修改 hadoop 用户权限

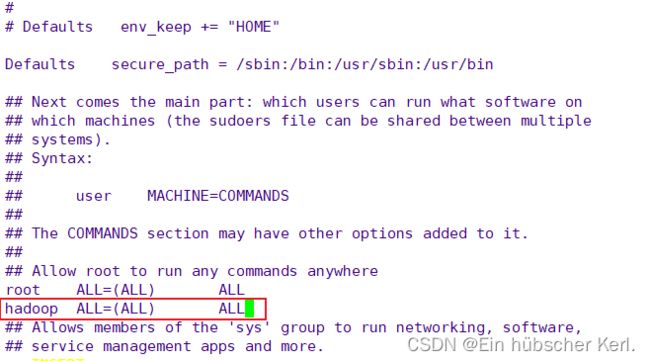

hadoop用户为普通用户,系统会对普通用户的一些操作进行限制,这里我们需要为hadoop用户增加管理员权限,之后便可以使用 sudo 命令进行一些限制操作,编辑/etc/sudoers文件给hadoop用户增加管理员权限,红色字就是新增的内容。

[root@localhost ~]# vi /etc/sudoers

## The COMMANDS section may have other options added to it.

##

## Allow root to run any commands anywhere

root ALL=(ALL) ALL

hadoop ALL=(ALL) ALL

## Allows members of the 'sys' group to run networking, software,

## service management apps and more.

# %sys ALL = NETWORKING, SOFTWARE, SERVICES, STORAGE, DELEGATING, PROCESSES, LOCATE, DRIVERS

3.3、切换为 hadoop 用户

目前使用的是root用户,现在需要切换成hadoop用户进行操作

[root@localhost ~]# su hadoop

[hadoop@localhost root]$ cd

[hadoop@localhost ~]$

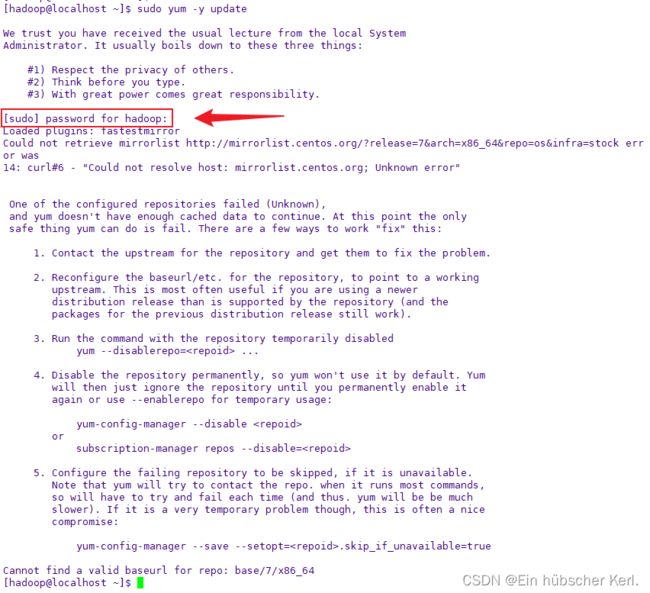

3.4、更新源

我们在下载软件时,可能会因为网络原因而下载失败,因此我们选择更新软件源,输入以下命令更新软件源,我们现在登录的用户是hadoop,因此需要使用 sudo 命令来进行需要 root 权限的操作

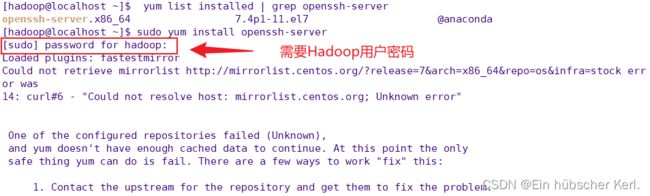

3.5、检查 SSH服务

集群、单机模式都需要用到 SSH 登陆(类似于远程登陆,你可以登录某台 Linux 主机,并且在上面运行命令),在使用 SSH 登陆服务之前,我们需要先输入 yum list installed | grep openssh-server 命令检测 openssh-server 是否安装,有信息输出表示已安装,无信息输出表示未安装。

如果未安装,则无任何输出,安装 openssh-server 命令为:sudo yum install openssh-server

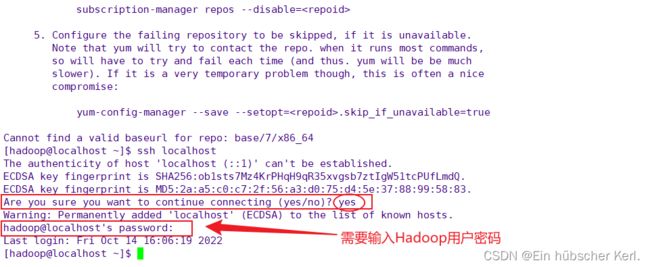

3.6、配置 SSH 无密码登录

确定 openssh-server 已安装后,我们就可以愉快的使用 SSH 服务了,输入 ssh localhost 命令登陆本机:

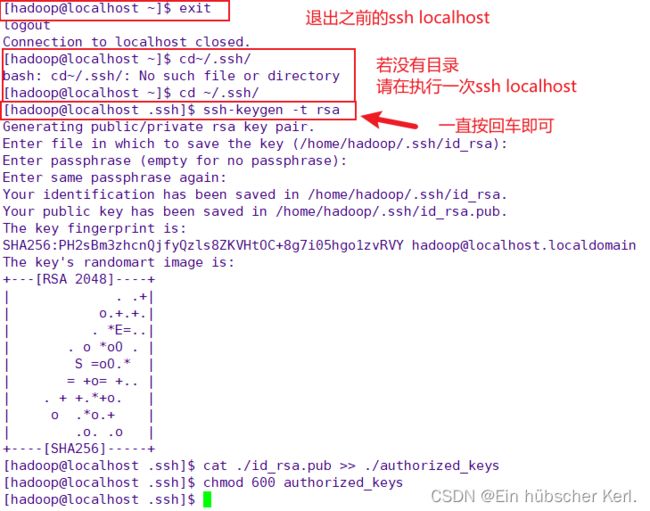

按照以上的登陆方式:每次登陆都需要输入密码,很不方便,因此我们需要配置成SSH无密码登陆,更方便一点。具体操作如下:

cat ./id_rsa.pub >> ./authorized_keys # 加入授权

chmod 600 authorized_keys # 更改文件权限

四、 安装 Java 环境

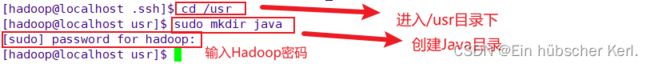

第一步:指定java的安装路径,这里我们把java安装到/usr/java目录下

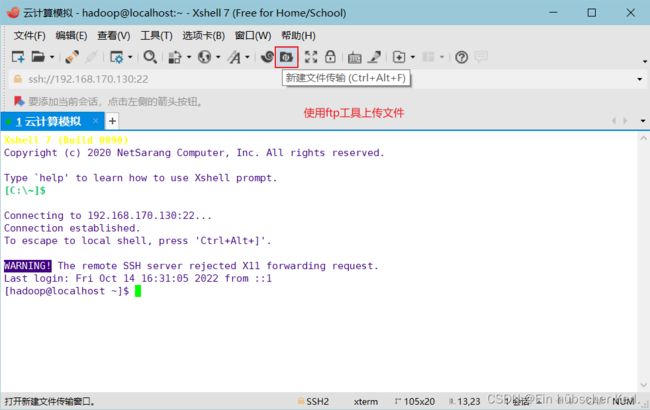

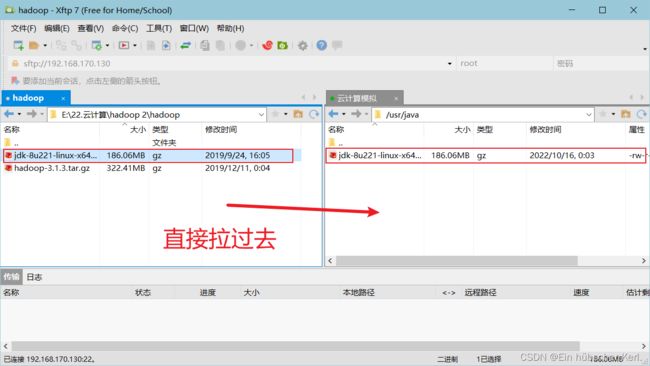

第二步:把jdk安装包上传到/usr/java目录下,进行解压

[hadoop@localhost usr]$ cd /usr/java #进入到/usr/java目录下

[hadoop@localhost java]$ sudo tar -xzvf jdk-8u221-linux-x64.tar.gz #解压

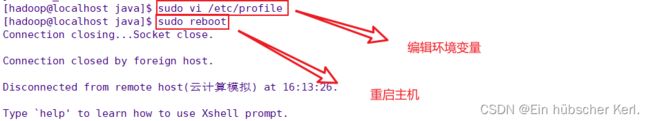

第三步:配置环境变量,编辑/etc/profile文件进行添加环境变量

export JAVA_HOME=/usr/java/jdk1.8.0_221

export JRE_HOME=${JAVA_HOME}/jre

export CLASSPATH=.:${JAVA_HOME}/lib:${JRE_HOME}/lib:$CLASSPATH

export JAVA_PATH=${JAVA_HOME}/bin:${JRE_HOME}/bin

export PATH=$PATH:${JAVA_PATH}

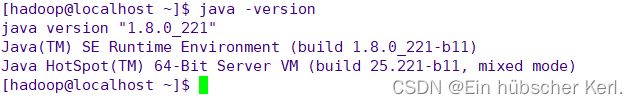

第四步:执行java版本命令,检查java是否安装成功

五、安装hadoop

第一步:指定hadoop的安装路径,这里我们把hadoop安装到/usr/hadoop目录下,一定要把hadoop文件夹的所属主与所属组改成hadoop,否则运行会没有权限

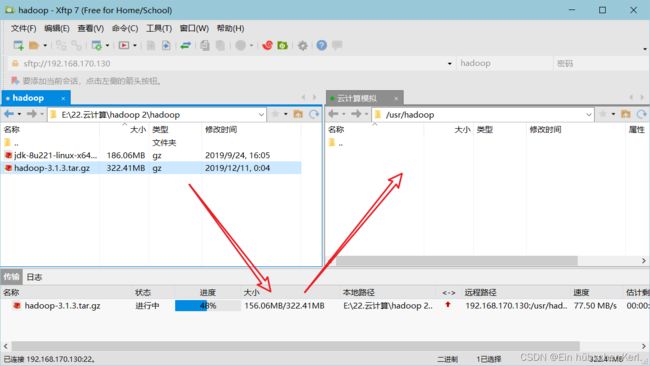

第二步:使用Xftp把hadoop安装包上传到/usr/hadoop目录下,进行解压

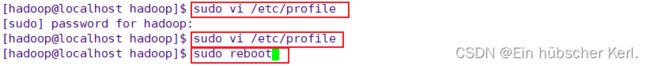

第三步:配置环境变量,编辑/etc/profile文件进行添加环境变量

#文档末尾增加以下信息

export HADOOP_HOME=/usr/hadoop/hadoop-3.1.3

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

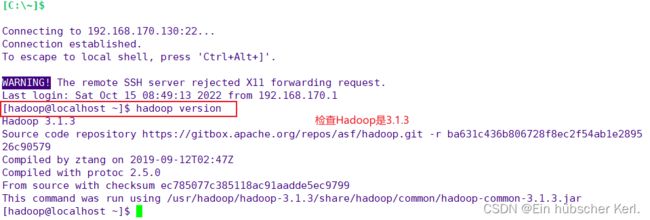

第四步:执行hadoop版本命令,检查hadoop是否安装成功

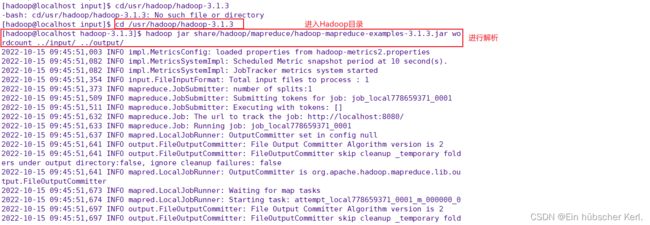

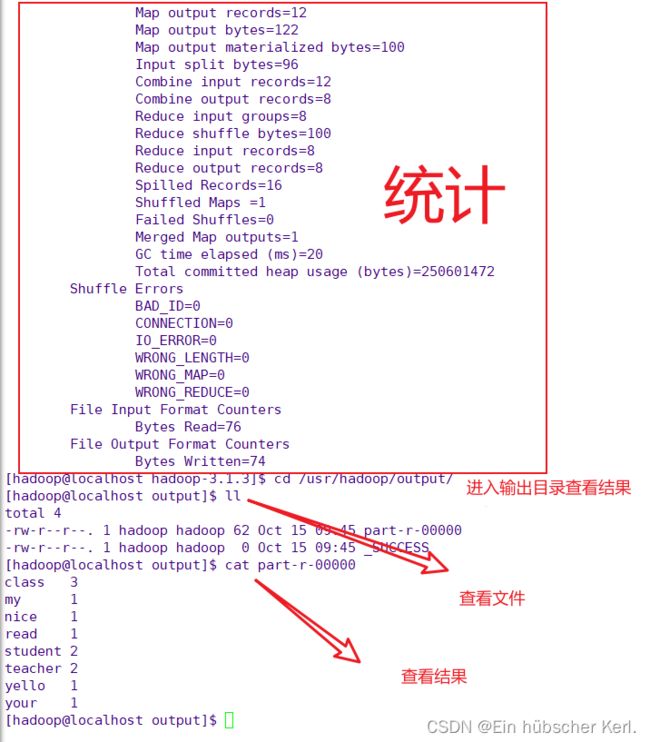

六、Hadoop单机配置

使用MapReduce测试单词出现的次数

在/usr/hadoop/下创建一个input文件夹,在此文件夹中创建一个word.txt,在文件中随机写一些英文单词,统计每个英文单词的次数

七、Hadoop 伪分布式配置

7.1修改配置文件,运行HDFS分布式文件系统

Hadoop 可以在单节点上以伪分布式的方式运行,Hadoop 进程以分离的 Java 进程来运行,节点既作为 NameNode 也作为 DataNode,同时,其读取的是 HDFS 中的文件。

Hadoop 的配置文件位于 /usr/hadoop/hadoop-3.1.3/etc/hadoop/ 中,伪分布式需要修改 2 个配置文件 core-site.xml 和 hdfs-site.xml 。Hadoop的配置文件是 xml 格式,每个配置以声明 property 的 name 和 value 的方式来实现。

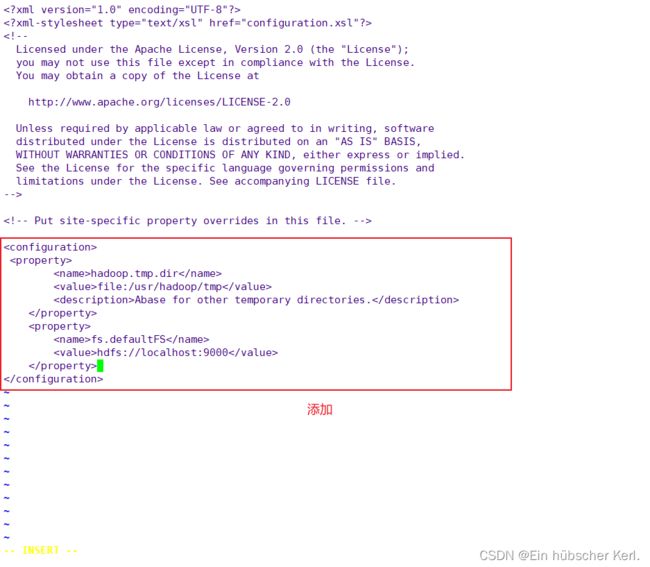

7.2修改 core-site.xml 文件

添加内容

hadoop.tmp.dir

file:/usr/hadoop/tmp

Abase for other temporary directories.

fs.defaultFS

hdfs://localhost:9000

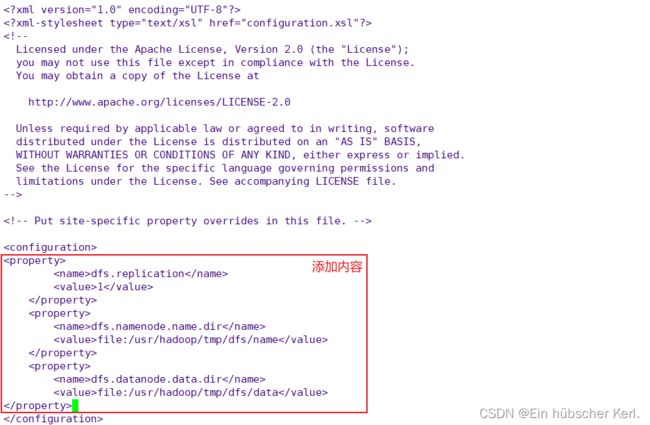

7.3修改 hdfs-site.xml 文件

添加内容

dfs.replication

1

dfs.namenode.name.dir

file:/usr/hadoop/tmp/dfs/name

dfs.datanode.data.dir

file:/usr/hadoop/tmp/dfs/data

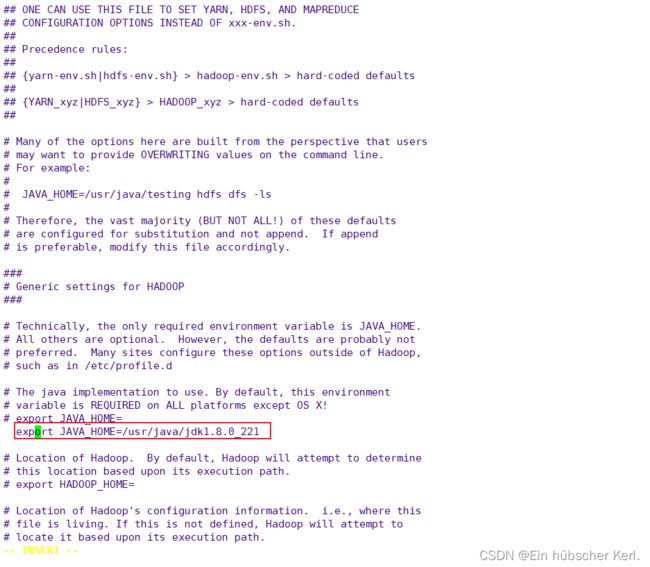

7.4修改 hadoop-env.sh 配置文件

在 hadoop-env.sh 文件里找到 # export JAVA_HOME= 这行,如下所示:export JAVA_HOME=/usr/java/jdk1.8.0_221

[hadoop@localhost hadoop]$ vi hadoop-env.sh

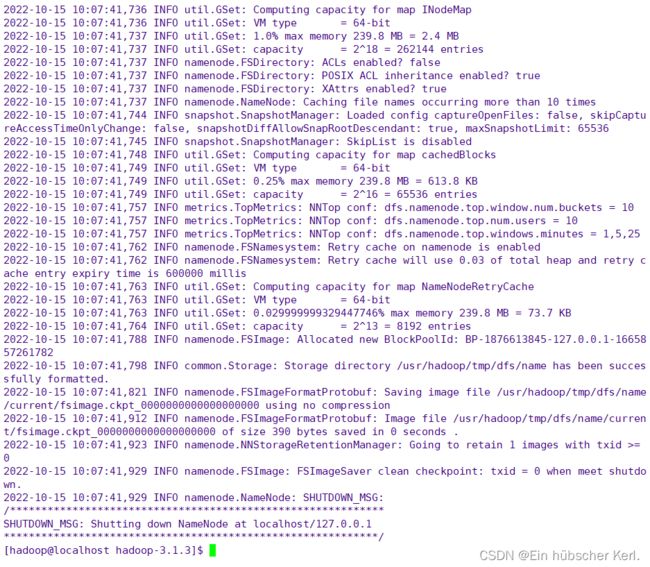

7.5 NameNode 格式化

格式化成功

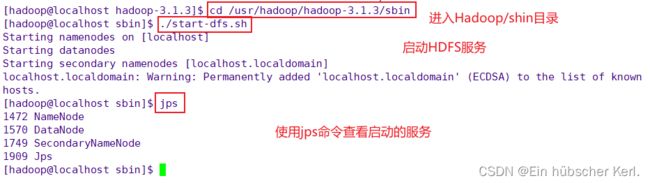

7.6开启 NameNode 和 DataNode

7.7使用浏览器访问web界面

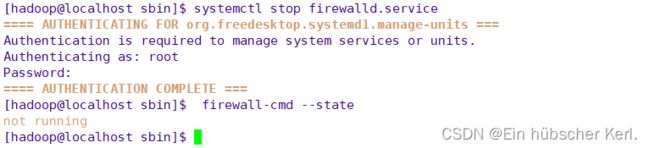

成功启动后,可以在浏览器上访问 Web 界面 http://192.168.170.130:9870 查看 NameNode 和 Datanode 信息,还可以在线查看 HDFS 中的文件,记得关闭Linux防火墙,否则外部无法访问。

【Linux学习笔记】管理Linux操作系统:简单的关闭防火墙_Ein hübscher Kerl.的博客-CSDN博客_termux关闭防火墙

安装包下载地址

链接:https://pan.baidu.com/s/1sCmMTFrt3VPKFIUtlG9x2w?pwd=ydd9

提取码:ydd9