为什么神经网络不适合自然语言理解

本文来自 Ben Dickson

在过去十年中,人工智能的一个主要趋势是通过创建更大的深度学习模型来解决问题。这种趋势在自然语言处理领域最为明显,同时自然语言处理是人工智能最具挑战性的领域之一。

近年来,研究人员发现,在神经网络中加入参数可以提高其在语言任务中的表现。然而,理解语言的根本问题——单词和句子,仍然没有解决。

Rensselaer理工学院的两位科学家所著的《人工智能时代的语言学》一书讨论了当前自然语言理解方法(NLU)的缺点,并探讨了开发智能体的未来途径,这种智能体可以与人类进行互动,而不会造成挫折或犯愚蠢的错误。

《人工智能时代语言学》的作者Marjorie McShane和Sergei Nirenburg认为人工智能系统必须超越文字的范畴。在他们的书中,他们提出了NLU系统可以了解世界,向人类解释他们的知识,并在探索世界时学习的理由。

基于知识的系统vs倚靠知识的系统

例如,“I made her duck。”句子的主语是扔了一块石头让对方弯下腰,还是他给她煮了鸭肉?

再如:“Elaine poked the kid with the stick。”是伊莱恩用棍子戳了那个孩子,还是她用手指戳了那个碰巧拿着棍子的孩子?

这些语言充满了歧义。人类通过说话人的语气、前面的单词和句子、对话的大致场景以及对世界的基本了解来建立语境,来解决这些歧义。如果这些都不奏效,人类会提出问题。对人类来说,决定情境的过程很容易,但是用可计算的方式定义情境的过程做起来很难。

通常有两种方法来解决这个问题。

人工智能时代的语言学-Marjorie McShane and Sergei Nirenburg著

在人工智能的早期,科学家们使用基于知识的系统来定义句子中每个单词的角色,并提取上下文和含义。基于知识的系统依赖于关于语言、情境和世界的大量特征。这些信息可能来自不同的来源,必须以不同的方式计算。

基于知识的系统提供可靠和可解释的语言分析。但它们之所以失宠,是因为它们需要太多的人力来设计功能、创建词汇结构和本体,以及开发将所有这些部分整合在一起的软件系统。研究人员认为知识工程的人工智能是一个瓶颈,需要寻求其他方法来处理语言处理。

“公众认为任何试图克服这种所谓的知识瓶颈的努力都是徒劳的,这深刻影响了人工智能的发展道路,特别是自然语言处理,使该领域远离了理性主义、基于知识的方法,并促成了经验主义的出现,”McShane和Nirenburg在《人工智能时代的语言学》中写道。

近几十年来,机器学习算法一直是NLP和NLU的中心。机器学习模型是一种知识密集型系统,它试图通过统计关系来处理上下文问题。在训练过程中,机器学习模型处理大量的文本语料库,并根据单词相邻的方式调整参数。在这些模型中,上下文是由单词序列之间的统计关系决定的,而不是单词背后的意义。自然地,数据集越大,例子越多样化,这些数字参数就越能捕捉单词相邻出现的各种情况。

知识精益系统之所以受到欢迎,主要是因为有大量的计算资源和大数据集可用来训练机器学习系统。通过维基百科这样的公共数据库,科学家们已经能够收集巨大的数据集,并训练他们的机器学习模型来完成各种任务,比如翻译、文本生成和问答。

机器学习并不计算文字意义

今天,有了深度学习模型,人们可以生成文章,回答科学考试问题,编写软件源代码,并完成基本的客户服务。由于深度学习体系结构(LSTMs, transformers)的改进,这些领域的大多数都取得了进展,更重要的是,由于神经网络每年都在成长。

深度学习语言模型大小表。近年来,深度学习语言模型在规模上不断增长(以对数尺度可视化)

但是,虽然深度神经网络可以在特定任务上提供渐进式的改进,但它们并不能解决一般自然语言理解的更广泛问题。这就是为什么各种实验表明,即使是最复杂的语言模型也无法解决关于世界如何运转的简单问题。

在他们的书中,McShane和Nirenburg将当前人工智能系统解决的问题描述为“唾手可得的果实”。一些科学家认为,继续沿着神经网络的扩展道路前进,最终将解决机器学习面临的问题。但McShane和Nirenburg认为,还有更根本的问题需要解决。

他们写道:“这种系统与人类不同:它们不知道自己在做什么,为什么要这样做,它们解决问题的方法与人类的不相似,它们不依赖于世界模型、语言或代理。相反,它们在很大程度上依赖于将通用机器学习算法应用于越来越大的数据集,并得到了现代计算机惊人的速度和存储容量的支持。”

McShane是一名认知科学家和计算语言学家,他在TechTalks上评论说,机器学习必须克服几个障碍,首先是意义的缺失。

“统计/机器学习(S-ML)方法并不试图计算意义,”McShane说。相反,实践者认为词语是其意义的充分代理,但事实并非如此。事实上,当涉及到完整的上下文意义时,一个句子的单词只是冰山一角。对于人工智能来说,混淆词语的含义就像让船驶向冰山一样令人担忧。”

在大多数情况下,机器学习系统通过缩小任务范围或扩大训练数据集,来回避处理单词含义的问题。但是,即使一个大型神经网络能够在相当长的一段文本中保持连贯性,在其背后,它仍然无法理解自己所生成单词的含义。

McShane说:“当然,人们可以构建看起来像智能行为的系统,但实际上他们并不知道发生了什么(例如GPT-3)。”

所有基于深度学习的语言模型,只要你问它们一系列琐碎但相关的问题,它们就会开始崩溃,因为它们的参数无法捕捉日常生活中无限的复杂性。在这个问题上投入更多的数据并不是在语言模型中明确集成知识的解决办法。

语言天赋智能代理(LEIA)

《人工智能时代的语言学》作者Marjorie McShane 和Sergei Nirenburg,

在书中,McShane和Nirenburg提出了一种解决自然语言理解的“知识瓶颈”的方法,而不需要求助于纯基于机器学习的方法,但这种方法需要大量的数据。

人工智能时代语言学的核心是call language—赋有语言的智能主体(LEIA)的概念,它有三个关键特征:

(1) LEIAs能够理解语境敏感的语言意义,并通过词语和句子的歧义进行导航。

(2) LEIAs可以向其人类合作者解释其思想、行动和决策。

(3)与人类一样,LEIAs可以在与人类、其他代理和世界互动时进行终身学习。终身学习减少了人类持续努力扩展智能代理的知识库的需要。

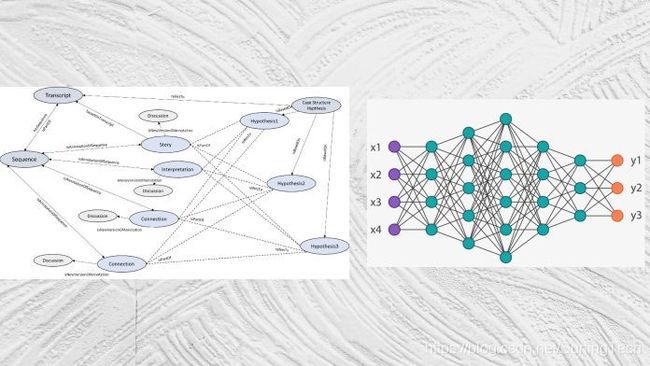

LEIAs对自然语言进行了六个阶段的处理,从确定单词在句子中的作用,到语义分析,最后到情景推理。这些阶段使得LEIA能够解决单词和短语不同含义之间的冲突,并将句子整合到主体工作的更广泛的环境中。

LEIAs为他们对语言表达的解释分配了信心水平,并知道他们的技能和知识在哪里达到了他们的极限。在这种情况下,它们与人类(或其环境和其他可用资源中的智能代理)交互以解决歧义。这些互动反过来使他们能够学习新事物,扩大他们的知识。

LEIAs分几个阶段处理语言输入

LEIAs将句子转换为文本意义表征(TMR),即对句子中每个单词的可解释和可操作的定义。基于上下文和目标,LEIAs确定需要跟踪哪些语言输入。举个例子,如果一个修复机器人股份机器修理车间地板与几个人技术人员和人类参与讨论昨天的体育比赛的结果,AI应该能够区分句子相关的工作(机器修复)和那些可以忽略(体育)。

LEIAs倾向于基于知识的系统,但它们也在过程中集成了机器学习模型,特别是在语言处理的句子解析的初始阶段。

McShane说:“如果更多的S-ML引擎能够提供各种高质量的启发性证据,我们将很高兴集成它们。我们也期待结合S-ML方法来执行一些面向大数据的任务,比如通过阅读选择例子来进行种子学习。”

语言理解需要人脑的复制品吗?

LEIA的主要特点之一是知识库、推理模块和感觉输入的集成。目前,计算机视觉和自然语言处理等领域的重叠很少。

正如McShane和Nirenburg在他们的书中指出的那样,“语言理解不能从主体的整体认知中分离出来,因为支持语言理解的启发法(除其他外)来自处理其他知觉模式(如视觉)的结果,对说话者的计划和目标进行推理,还要考虑要花多少精力来理解困难的输入。”

在现实世界中,人类利用丰富的感官经验来填补语言表达的空白(例如,当有人告诉你,“看那边?”他们会认为你能看到手指所指的方向)。人类进一步发展彼此的思维模式,并使用这些模式做出假设,省略语言中的细节。我们期望任何用自己的语言与我们交互的智能代理都具有类似的能力。

McShane说:“我们完全理解为什么竖井式方法如今成为常态:每个解释问题本身都很困难,每个问题的实质性方面都需要单独解决。”“然而,如果没有集成,每个问题的实质性方面都无法得到解决,所以必须抵制(a)假设模块化必然导致简化,(b)无限期地推迟集成。”

与此同时,实现类人行为并不需要LEIAs成为人类大脑的复制。McShane说:“我们同意Raymond Tallis和其他人所说的神经学——解释大脑作为一个生物实体,可以告诉我们关于认知和意识的东西——已经导致了不可靠的说法和解释。但至少在目前的发展阶段,并不能真正解释神经科学,还不能为这种类型的认知模型提供任何有意义的(语法或结构的)支持,也不能实现我们的目标。”

在《人工智能时代的语言学》一书中,McShane和Nirenburg认为,复制大脑并不符合人工智能的可解释性目标。他们写道:“以人为主体的团队运作的[代理]需要了解所需的输入,以确定作为NLU的结果,他们应该追求哪些目标、计划和行动。”

一个长期目标

《人工智能时代的语言学》中讨论的许多主题仍停留在概念层面,尚未实现。作者为NLU的每个阶段应该如何工作提供了蓝图,尽管工作系统还不存在。

但McShane对LEIA的发展取得进展持乐观态度。“在概念上和方法上,工作方案都很先进。主要的障碍是在当前的环境下,没有资源被分配到以知识为基础的工作上。

McShane认为,知识瓶颈已经成为对基于知识的系统的批评焦点,它在以下几个方面被误导了:

(1)实际上没有瓶颈,只是有工作要做。

(2)借助人们所获得的高质量的核心词汇和本体,代理通过自身的操作来学习语言和世界,该工作可以在很大程度上实现自动化。

(3)尽管McShane和Nirenburg相信许多种类的知识是可以自动学习的——特别是随着促进自举的知识库越来越大——但最有效的知识获取工作流程将包括人在循环中,无论是质量控制还是处理困难的情况。

她说:“我们准备进行一项大规模的工作,在一般和面向应用的习得方面,这将使涉及语言交流的各种应用程序更像人类。”

在他们的工作中,McShane和Nirenburg也承认需要做很多工作,开发LEIAs是一个“持续的、长期的、广泛的工作计划”。

他们在《人工智能时代的语言学》(Linguistics for The Age of AI)一书中写道:“要完成的工作的深度和广度,与这个目标的崇高性是相称的:让机器能够像人类一样熟练地使用语言。”