k8s的集群搭建

目 录

- 搭建k8s环境平台规划

-

- 1、硬件配置要求

-

- ① 测试环境:

- ② 生产环境:

- 搭建k8s集群的部署方式

-

- ① Kuberadm方式

- ② 二进制方式

- 一、Kuberadm方式搭建k8s集群

-

- 1、部署方式

- 2、安装要求

- 3、环境准备

- 4、搭建过程

-

- ① 操作系统初始化

- ② 所有节点安装Docker/kubeadm/kubelet

-

- 安装docker

- 添加阿里云yum软件源

- 安装kubeadm、kubelet、kubectl

- ③ 部署Kubernetes Master

-

- 使用kubectl工具

- ④ 加入Kubernetes Node

- ⑤ 部署CNI网络插件

- ⑥ 测试Kubernetes集群

- 二、二进制方式搭建k8s集群

-

- 1、安装要求

- 2、环境准备

- 3、搭建过程

-

- ① 操作系统初始化

- ② 为etcd和 apiserver自签证书

-

- 准备cfssl证书生成工具

- 生成初始证书

- 创建ca-csr.json文件

- 通过cfssl初始化证书

- 为apiserver自签证书

-

- 创建ca-config.json文件

- 创建server-csr.json文件

- 生成apiserver自签证书

- 生成admin证书

-

- 创建admin-csr.json文件

- 生成admin证书

- 生成kube-proxy证书

-

- 创建kube-proxy-csr.json文件

- 生成kube-proxy证书

- ③ 部署etcd集群

-

- 创建etcd.conf文件

- 创建etcd.service文件

- 拷贝数据文件到其他节点

- 启动etcd

-

- 设置开机启动:

- 三、总结

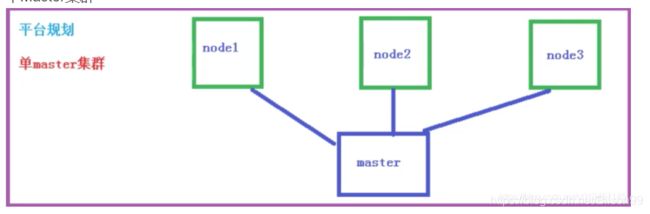

搭建k8s环境平台规划

1、硬件配置要求

① 测试环境:

master节点:CPU:2核;内存:4G;硬盘:20G;

node节点: CPU:4核;内存:8G;硬盘:40G;

② 生产环境:

master节点:CPU:8核;内存:16G;硬盘:100G;

node节点: CPU:16核;内存:64G;硬盘:500G;

搭建k8s集群的部署方式

① Kuberadm方式

② 二进制方式

一、Kuberadm方式搭建k8s集群

Kubeadm是一个K8s部署工具,提供kubeadm init和kubeadm join,用于快速部署Kubernetes集群。

1、部署方式

第一、创建一个Master节点kubeadm init

第二,将Node节点加入到当前集群中$ kubeadm join [Master节点的IP和端口]

2、安装要求

- 一台或多台机器,操作系统CentOS7.x-x86_64

- 硬件配置:2G或更多ARM,2个CPU或更多CPU,硬盘20G及以上

- 集群中所有机器网络互通

- 可以访问外网,需要拉取镜像

- 禁止swap分区

3、环境准备

| 主机 | 操作系统 | IP地址 | 软件包 |

|---|---|---|---|

| master | centos7.6 | 192.168.217.40 | kube-apiserver、kube-controller-manager、kube-scheduler、etcd |

| node1 | centos7.6 | 192.168.217.50 | kubelet、kube-proxy、docker、etcd |

| node2 | centos7.6 | 192.168.217.60 | kubelet、kube-proxy、docker、etcd |

4、搭建过程

① 操作系统初始化

所有主机都要操作

# 1、关闭防火墙

systemctl stop firewalld

systemctl disable firewalld

# 2、关闭selinux

sed -i 's/enforcing/disabled/' /etc/selinux/config #永久关闭

setenforce 0 #临时关闭

# 3、关闭swap

swapoff -a #临时关闭

sed -ri 's/.*swap.*/#&/' /etc/fstab #永久关闭

# 4、根据规划设置主机名

hostnamectl set-hostname <主机名> #修改主机名

hostname #查看主机名

# 5、在master节点中添加hosts (IP后面跟的是hostname)

cat >> /etc/hosts << EOF

192.168.217.40 k8s-master

192.168.217.50 k8s-node1

192.168.217.60 k8s-node2

EOF

# 6、将桥接的IPv4流量传递到iptables的链

cat > /etc/sysctl.d/k8s.conf <<EOF

net.bridge.bridge‐nf‐call‐ip6tables=1

net.bridge.bridge‐nf‐call‐iptables=1

EOF

sysctl --system #生效

# 7、时间同步

yum install ntpdate -y

ntpdate time.windows.com

② 所有节点安装Docker/kubeadm/kubelet

Kubernetes默认的CRI(运行容器时)为Docker,所有需要先安装Docker。

安装docker

Docker的安装

添加阿里云yum软件源

cat >/etc/yum.repos.d/kubernetes.repo << EOF

[kubernetes]

name=Kubernetes

baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64

enabled=1

gpgcheck=0

repo_gpgcheck=0

gpgkey=https://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg https://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg

EOF

安装kubeadm、kubelet、kubectl

kubeadm:部署工具

kubelet:systemd守护进程管理

kubectl:k8s命令行管理工具

# 最新版本安装

yum install -y kubelet kubeadm kubectl

# 安装指定版本

yum install -y kubelet-1.18.0 kubeadm-1.18.0 kubectl-1.18.0

#设置开机启动

systemctl enable kubelet

③ 部署Kubernetes Master

master(192.168.217.40)

kubeadm init \

--apiserver-advertise-address=192.168.217.40 \

--image-repository registry.aliyuncs.com/google_containers \

--kubernetes-version v1.18.0 \

--service-cidr=10.96.0.0/12 \

--pod-network-cidr=10.244.0.0/16

## --apiserver-advertise-address 当前节点的IP地址

## --image-repository 由于默认拉取镜像地址k8s.gcr.io国内无法访问,这里指定阿里云镜像仓库地址。

## --kubernetes-version K8s版本,与上面安装的一致

## --service-cidr 集群内部虚拟网络,Pod统一访问入口

## --pod-network-cidr Pod网络,与下面部署的CNI网络组件yaml中保持一致

kubeadm token create --print-join-command

使用kubectl工具

mkdir -p $HOME/.kube

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

sudo chown $(id -u):$(id -g) $HOME/.kube/config

执行完成后可以使用kubectl命令查看k8s节点信息

kubectl get nodes

④ 加入Kubernetes Node

node1(192.168.217.50)

node2(192.168.217.60)

kubeadm join 192.168.217.40:6443 --token 9hrjna.udm6dwfwhtjfsvgu \

--discovery-token-ca-cert-hash sha256:68073deafc5c3fbcc7ab3675597816305726483c6a6d71912a418f266e7bcc32

echo "1" >/proc/sys/net/bridge/bridge-nf-call-iptables

⑤ 部署CNI网络插件

这里使用Flannel作为Kubernetes容器网络方案,解决容器跨主机网络通信。 Flannel是CoreOS维护的一个网络组件,Flannel为每个Pod提供全局唯一的IP,Flannel使用ETCD来存储Pod子网与Node IP之间的关系。flanneld守护进程在每台主机上运行,并负责维护ETCD信息和路由数据包。

方式一:

# 如果此地址无法访问,可以更改网络的DNS为8.8.8.8试试,如果还是不行就只能使用方式二

kubectl apply -f https://raw.githubusercontent.com/coreos/flannel/master/Documentation/kube-flannel.yml

方式二:

kube-flannel.yml下载:

链接: https://pan.baidu.com/s/1ANoUdrexA6N_VVc5HOc3QA 密码: h11w

# 安装flannel

kubectl apply -f kube-flannel.yml

# 查看pod组件状态

kubectl get pods -n kube-system

各个组件都成功启动后再次查看k8s节点状态,各个节点状态都已经是Ready状态,至此,说明整个k8s已经搭建完成。

kubectl get nodes

⑥ 测试Kubernetes集群

master(192.168.217.40)

在Kubernetes集群中创建一个pod,验证是否正常运行。

# 创建镜像容器

kubectl create deployment nginx --image=nginx

# 对外暴露端口

kubectl expose deployment nginx --port=80 --type=NodePort

# 查看当前对外的端口

kubectl get pod,svc

二、二进制方式搭建k8s集群

1、安装要求

- 一台或多台机器,操作系统CentOS7.x-x86_64

- 硬件配置:2G或更多ARM,2个CPU或更多CPU,硬盘20G及以上

- 集群中所有机器网络互通

- 可以访问外网,需要拉取镜像

- 禁止swap分区

2、环境准备

| 主机 | 操作系统 | IP地址 | 软件包 |

|---|---|---|---|

| master | centos7.6 | 192.168.217.40 | kube-apiserver、kube-controller-manager、kube-scheduler、etcd |

| node1 | centos7.6 | 192.168.217.50 | kubelet、kube-proxy、docker、etcd |

| node2 | centos7.6 | 192.168.217.60 | kubelet、kube-proxy、docker、etcd |

3、搭建过程

① 操作系统初始化

所有主机都要操作

# 1、关闭防火墙

systemctl stop firewalld

systemctl disable firewalld

# 2、关闭selinux

sed -i 's/enforcing/disabled/' /etc/selinux/config #永久关闭

setenforce 0 #临时关闭

# 3、关闭swap

swapoff -a #临时关闭

sed -ri 's/.*swap.*/#&/' /etc/fstab #永久关闭

# 4、根据规划设置主机名

hostnamectl set-hostname <主机名> #修改主机名

hostname #查看主机名

# 5、在master节点中添加hosts (IP后面跟的是hostname)

cat >> /etc/hosts << EOF

192.168.217.40 k8s-master

192.168.217.50 k8s-node1

192.168.217.60 k8s-node2

EOF

# 6、将桥接的IPv4流量传递到iptables的链

cat > /etc/sysctl.d/k8s.conf <<EOF

net.bridge.bridge‐nf‐call‐ip6tables=1

net.bridge.bridge‐nf‐call‐iptables=1

EOF

sysctl --system #生效

# 7、时间同步

yum install ntpdate -y

ntpdate time.windows.com

② 为etcd和 apiserver自签证书

| 组件 | 使用证书 |

|---|---|

| kube-apiserver | ca.pem,server.pem,server-key.pem |

| kubelet | ca.pem,ca-key.pem |

| kube-proxy | ca.pem,kube-proxy.pem,kube-proxy-key.pem |

| etcd | ca.pem,server.pem,server-key.pem |

| kubectl | ca.pem,admin.pem,admin-key.pem |

准备cfssl证书生成工具

cfssl是一个开源的证书管理工具,使用json文件生成证书,相比openssl更方便使用。找任意一台服务器操作,这里用Master节点。

手动下载:

wget https://pkg.cfssl.org/R1.2/cfssl_linux-amd64

wget https://pkg.cfssl.org/R1.2/cfssljson_linux-amd64

wget https://pkg.cfssl.org/R1.2/cfssl-certinfo_linux-amd64

chmod +x cfssl_linux-amd64 cfssljson_linux-amd64 cfssl-certinfo_linux-amd64

mv cfssl_linux-amd64 /usr/local/bin/cfssl

mv cfssljson_linux-amd64 /usr/local/bin/cfssljson

mv cfssl-certinfo_linux-amd64 /usr/bin/cfssl-certinfo

打包下载:

链接: https://pan.baidu.com/s/1aNwJRF1o9CQvmGClQKX8Pg 密码: iwh6

验证cfssl是否安装成功

cfssl version

生成初始证书

创建/u01/etcd文件夹,并在此文件夹下生成相关证书。

# 创建文件夹

mkdir -p /u01/etcd

# 进入文件夹

cd /u01/etcd

创建ca-csr.json文件

cat > ca-csr.json <<EOF

{

"CN": "kubernetes",

"key": {

"algo": "rsa",

"size": 2048

},

"names": [

{

"C": "CN",

"L": "Beijing",

"ST": "Beijing",

"O": "k8s",

"OU": "System"

}

]

}

EOF

通过cfssl初始化证书

cfssl gencert -initca ca-csr.json | cfssljson -bare ca -

为apiserver自签证书

创建ca-config.json文件

cat > ca-config.json <<EOF

{

"signing": {

"default": {

"expiry": "87600h"

},

"profiles": {

"kubernetes": {

"expiry": "87600h",

"usages": [

"signing",

"key encipherment",

"server auth",

"client auth"

]

}

}

}

}

EOF

创建server-csr.json文件

此证书用户api、http加密使用。

注意修改hosts中的IP为自己集群的IP。其他的都不需要修改。

cat > server-csr.json <<EOF

{

"CN": "kubernetes",

"hosts": [

"192.168.75.133",

"192.168.75.134",

"192.168.75.135"

],

"key": {

"algo": "rsa",

"size": 2048

},

"names": [

{

"C": "CN",

"L": "Beijing",

"ST": "Beijing",

"O": "k8s",

"OU": "System"

}

]

}

EOF

生成apiserver自签证书

cfssl gencert -ca=ca.pem -ca-key=ca-key.pem -config=ca-config.json -profile=kubernetes server-csr.json | cfssljson -bare server

生成admin证书

创建admin-csr.json文件

cat > admin-csr.json <<EOF

{

"CN": "admin",

"hosts": [],

"key": {

"algo": "rsa",

"size": 2048

},

"names": [

{

"C": "CN",

"L": "Beijing",

"ST": "Beijing",

"O": "system:masters",

"OU": "System"

}

]

}

EOF

生成admin证书

cfssl gencert -ca=ca.pem -ca-key=ca-key.pem -config=ca-config.json -profile=kubernetes admin-csr.json | cfssljson -bare admin

生成kube-proxy证书

创建kube-proxy-csr.json文件

cat > kube-proxy-csr.json <<EOF

{

"CN": "system:kube-proxy",

"hosts": [],

"key": {

"algo": "rsa",

"size": 2048

},

"names": [

{

"C": "CN",

"L": "Beijing",

"ST": "Beijing",

"O": "k8s",

"OU": "System"

}

]

}

EOF

生成kube-proxy证书

cfssl gencert -ca=ca.pem -ca-key=ca-key.pem -config=ca-config.json -profile=kubernetes kube-proxy-csr.json | cfssljson -bare kube-proxy

③ 部署etcd集群

为了便于管理,需要给etcd指定一个安装目录,此处指定安装目录为**/opt/etcd**,并且在安装目录创建bin、cfg、ssl文件夹,分别用于存储二进制文件,配置文件,证书文件

注意:复制ca.pem、server-key.pem、server.pem到/opt/etcd/ssl目录下

# 创建文件夹命令

mkdir -p /opt/etcd/{bin,cfg,ssl}

#复制pem命令

cp /u01/etcd/ca.pem /opt/etcd/ssl

cp /u01/etcd/server.pem /opt/etcd/ssl

cp /u01/etcd/server-key.pem /opt/etcd/ssl

下载地址: https://github.com/coreos/etcd/relxeases/tag/v3.2.12 ,可以根据实际需要下载各自的版本。

此博客的安装包版本下载:

wget https://github.com/etcd-io/etcd/releases/download/v3.2.12/etcd-v3.2.12-linux-amd64.tar.gz

下载完成并解压,将解压后的etcd和etcdctl文件移动到/opt/etcd/bin目录下。

创建etcd.conf文件

在/opt/etcd/cfg目录下创建etcd.conf文件。

cat > etcd.conf <<EOF

#[Member]

ETCD_NAME="etcd-1"

ETCD_DATA_DIR="/var/lib/etcd/default.etcd"

ETCD_LISTEN_PEER_URLS="https://192.168.75.133:2380"

ETCD_LISTEN_CLIENT_URLS="https://192.168.75.133:2379"

#[Clustering]

ETCD_INITIAL_ADVERTISE_PEER_URLS="https://192.168.75.133:2380"

ETCD_ADVERTISE_CLIENT_URLS="https://192.168.75.133:2379"

ETCD_INITIAL_CLUSTER="etcd-1=https://192.168.75.133:2380,etcd-2=https://192.168.75.134:2380,etcd-3=https://192.168.75.135:2380"

ETCD_INITIAL_CLUSTER_TOKEN="etcd-cluster"

ETCD_INITIAL_CLUSTER_STATE="new"

EOF

注:

ETCD_NAME:节点名称,集群中唯一

ETCD_DATA_DIR:数据目录

ETCD_LISTEN_PEER_URLS:集群通信监听地址

ETCD_LISTEN_CLIENT_URLS:客户端访问监听地址

ETCD_INITIAL_ADVERTISE_PEER_URLS:集群通告地址

ETCD_ADVERTISE_CLIENT_URLS:客户端通告地址

ETCD_INITIAL_CLUSTER:集群节点地址

ETCD_INITIAL_CLUSTER_TOKEN:集群 Token

ETCD_INITIAL_CLUSTER_STATE:加入集群的当前状态,new是新集群,existing表示加入已有集群

创建etcd.service文件

在/usr/lib/systemd/system目录下创建etcd.service文件

1.创建etcd.service文件

vi etcd.service

2.插入以下数据

[Unit]

Description=Etcd Server

After=network.target

After=network-online.target

Wants=network-online.target

Service]

Type=notify

EnvironmentFile=/opt/etcd/cfg/etcd.conf

ExecStart=/opt/etcd/bin/etcd \

--name=${ETCD_NAME} \

--data-dir=${ETCD_DATA_DIR} \

--listen-peer-urls=${ETCD_LISTEN_PEER_URLS} \

--listen-client-urls=${ETCD_LISTEN_CLIENT_URLS},http://127.0.0.1:2379 \

--advertise-client-urls=${ETCD_ADVERTISE_CLIENT_URLS} \

--initial-advertise-peer-urls=${ETCD_INITIAL_ADVERTISE_PEER_URLS} \

--initial-cluster=${ETCD_INITIAL_CLUSTER} \

--initial-cluster-token=${ETCD_INITIAL_CLUSTER_TOKEN} \

--initial-cluster-state=${ETCD_INITIAL_CLUSTER_STATE} \

--cert-file=/opt/etcd/ssl/server.pem \

--key-file=/opt/etcd/ssl/server-key.pem \

--peer-cert-file=/opt/etcd/ssl/server.pem \

--peer-key-file=/opt/etcd/ssl/server-key.pem \

--trusted-ca-file=/opt/etcd/ssl/ca.pem \

--peer-trusted-ca-file=/opt/etcd/ssl/ca.pem

Restart=on-failure

LimitNOFILE=65536

[Install]

WantedBy=multi-user.tartget

拷贝数据文件到其他节点

master(192.168.217.40)

#拷贝etcd.service到192.168.217.40主机的/usr/lib/systemd/system目录下

scp -r /usr/lib/systemd/system/etcd.service root@192.168.217.40:/usr/lib/systemd/system

#拷贝etcd到192.168.217.40主机的/opt/目录下

scp -r /opt/etcd root@192.168.217.40:/opt/

#拷贝etcd.service到192.168.217.50主机的/usr/lib/systemd/system目录下

scp -r /usr/lib/systemd/system/etcd.service root@192.168.217.50:/usr/lib/systemd/system

#拷贝etcd到192.168.217.50主机的/opt/目录下

scp -r /opt/etcd root@192.168.217.50:/opt/

拷贝完成后,在其他节点上修改/opt/etcd/cfg/etcd.conf文件,主要修改的内容:

ETCD_NAME=etcd的名称

ETCD_LISTEN_PEER_URLS=“https://当前节点的IP:2380”

ETCD_LISTEN_CLIENT_URLS=“https://当前节点的IP:2379”

ETCD_INITIAL_ADVERTISE_PEER_URLS=“https://当前节点的IP:2380”

ETCD_ADVERTISE_CLIENT_URLS=“https://当前节点的IP:2379”

启动etcd

#重新加载配置文件

systemctl daemon-reload

#启动etcd

systemctl start etcd

#查看etcd状态

systemctl status etcd.service

设置开机启动:

#方式一:使用这个命令报错,不起作用,可以使用(方式二)来设置开机启动

systemctl enable etcd

#方式二

#1、修改/etc/rc.d/rc.local文件,在文件最后加入需要执行的命令:systemctl start etcd

#2、给/etc/rc.d/rc.local文件授予执行权限,完成后重启即可。

chmod +x /etc/rc.d/rc.local

查看集群状态

ETCDCTL_API=3 /opt/etcd/bin/etcdctl \

--cacert=/opt/etcd/ssl/ca.pem \

--cert=/opt/etcd/ssl/server.pem \

--key=/opt/etcd/ssl/server-key.pem \

--endpoints="https://192.168.217.40:2379,https://192.168.217.50:2379,https://192.168.217.60:2379" endpoint health

其他具体步骤:

链接: 二进制方法部署k8s集群架构.

三、总结

两种方式的对比:

Kubeadm降低部署门槛,但屏蔽了很多细节,遇到问题很难排查。如果想更容易可控,推荐使用二进制包部署Kubernetes集群,虽然手动部署麻烦点,期间可以学习很多工作原理,也利于后期维护。