关于x.view()的理解

x.view()就是对tensor进行reshape:

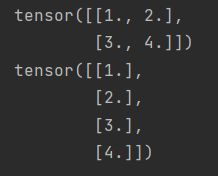

import torch

v1 = torch.range(1, 4)

v2 = v1.view(2, 2)

print(v2)

v3 = v2.view(4,-1)

print(v3)

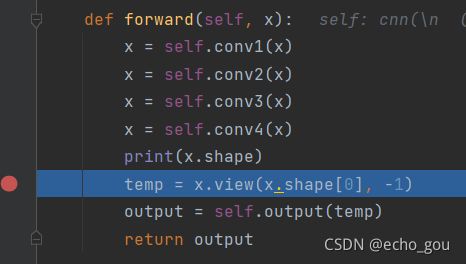

我们在创建一个网络的时候,会在Foward函数内看到view的使用

首先这里是一个简单的网络,有4层卷积和一层全连接组成。它的foward函数如下:

def forward(self, x):

x = self.conv1(x)

x = self.conv2(x)

x = self.conv3(x)

x = self.conv4(x)

temp = x.view(x.shape[0], -1)

output = self.output(temp)

return output一开始我对于这句话不是很理解:temp = x.view(x.shape[0], -1)

只知道他是将向量铺平,便于传入全连接层,但是具体怎么操作的就不清楚。

输出一下x.shape看看x具体是什么东西:

![]()

发现x就是一个四维变量,这才知道x变量的本质就是一个4维向量,而在conv1层的输入的x为一个10*3*100*100的向量,参数分别表示batchsize,RGB,100*100图片大小,x经过一层层的卷积,最后10*256*4*4向量作为第四层卷积输出。

最后使用x.view(x.shape(0),-1)将x转化成一个10行的矩阵,矩阵的每一行就是这个批量(批量大小为10)中每张图片的各个参数(即256*4*4),即矩阵中一行对应一张图片。