一套简单但完整的伪分布式大数据分析流程(二)(图文详解),适用于Windows系统

步骤二、hadoop2.7.1伪分布式安装配置

上一篇:一套简单但完整的伪分布式大数据分析流程(一)(图文详解),适用于Windows系统

https://blog.csdn.net/qq_42800581/article/details/106248006

所有所需软件链接:https://pan.baidu.com/s/1ovYL1O_89ZDDy5TCL6oB4Q

提取码:kh8b

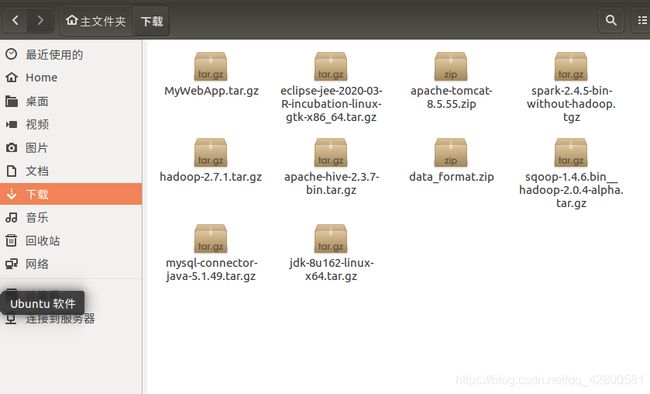

建议一次性把所有软件下载好,可以先下载到Windows,直接跨平台复制到Ubuntu下载目录

建议一次性把所有软件下载好,可以先下载到Windows,直接跨平台复制到Ubuntu下载目录

复制完如图所示

如果不能直接复制粘贴的话,看下边解决办法:

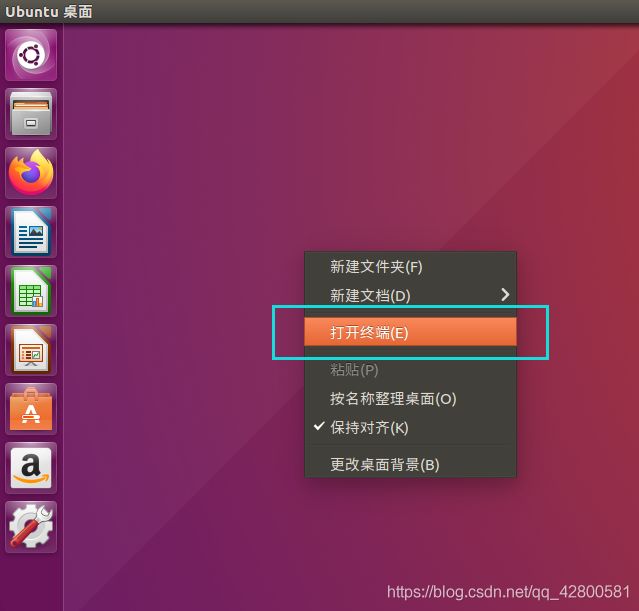

在桌面直接右键打开终端(或者CTRL+Alt+T快捷键打开)

注意:在Ubuntu终端窗口中,复制粘贴的快捷键需要加上 shift,即粘贴是 ctrl+shift+v

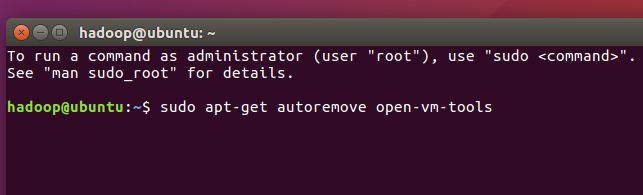

先输入:sudo apt-get autoremove open-vm-tools

敲回车,输入密码

再输入:sudo apt-get install open-vm-tools-desktop

敲回车

装好了 Ubuntu 系统之后,在安装 Hadoop 前还需要做一些必备工作。

从现在开始,读者可以用虚拟机中的Ubuntu自带firefox浏览器访问本教程,或者用上个步骤中安装的Chrome,个人来说比较喜欢Chrome

如果你安装 Ubuntu 的时候用的是“hadoop” 用户,那没事了

如果你安装 Ubuntu 的时候不是用的 “hadoop” 用户,那么需要改名为hadoop(正常情况下名字其实无所谓,起什么都不影响,不过本教程大量代码都默认当前用户为hadoop,所以本教程内需要更改用户名,否则很多代码无法直接用)

更改用户名的方法如图所示

确认名字无误后,去桌面直接右键打开终端(或者CTRL+Alt+T快捷键打开),输入

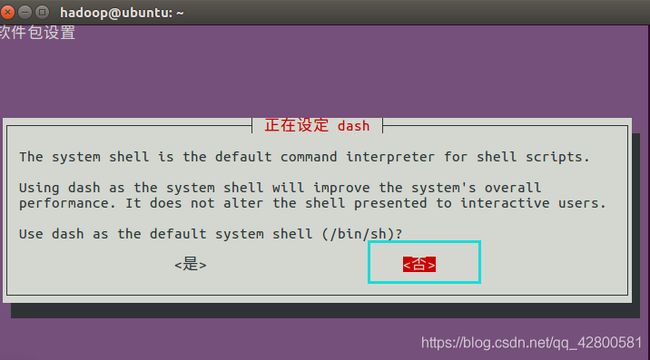

sudo dpkg-reconfigure dash

sudo命令

本文中会大量使用到sudo命令。sudo是ubuntu中一种权限管理机制,管理员可以授权给一些普通用户去执行一些需要root权限执行的操作。当使用sudo命令时,就需要输入您当前用户的密码.

密码

在Linux的终端中输入密码,终端是不会显示任何你当前输入的密码,也不会提示你已经输入了多少字符密码。而在windows系统中,输入密码一般都会以“*”表示你输入的密码字符

Ubuntu终端复制粘贴快捷键

在Ubuntu终端窗口中,复制粘贴的快捷键需要加上 shift,即粘贴是 ctrl+shift+v

ll /bin/sh

可以看到,已经成功切换为bash

![]()

可为 hadoop 用户增加管理员权限,方便部署,避免一些比较棘手的权限问题:

sudo adduser hadoop sudo

我们再更新一下 apt,后续我们使用 apt 安装软件,如果没更新可能有一些软件安装不了。在终端窗口,执行如下命令:

sudo apt-get update

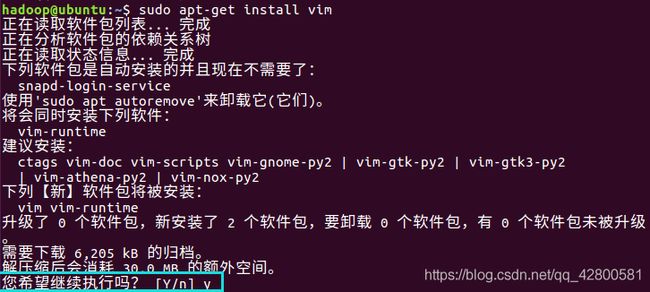

后续需要更改一些配置文件,这里推荐 vim

sudo apt-get install vim

安装软件时若需要确认,在提示处输入 y 即可。

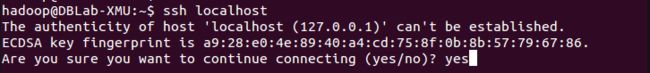

安装SSH、配置SSH无密码登陆

集群、单节点模式都需要用到 SSH 登陆(类似于远程登陆,你可以登录某台 Linux 主机,并且在上面运行命令),Ubuntu 默认已安装了 SSH client,此外还需要安装 SSH server:

sudo apt-get install openssh-server

安装后,可以使用如下命令登陆本机:

ssh localhost

此时会有如下提示(SSH首次登陆提示),输入 yes 。然后按提示输入密码 hadoop,这样就登陆到本机了。

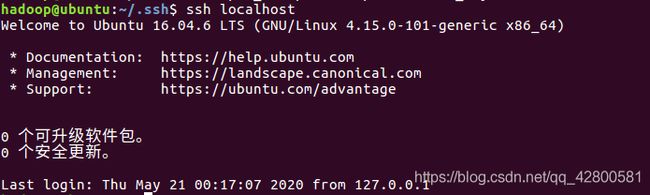

但这样登陆是需要每次输入密码的,我们需要配置成SSH无密码登陆比较方便。

但这样登陆是需要每次输入密码的,我们需要配置成SSH无密码登陆比较方便。

首先退出刚才的 ssh,就回到了我们原先的终端窗口,然后利用 ssh-keygen 生成密钥,并将密钥加入到授权中:

命令中的 # 后面的文字是注释,只需要输入前面命令即可。另外每行都是一个命令

exit # 退出刚才的 ssh localhost

cd ~/.ssh/ # 若没有该目录,请先执行一次ssh localhost

ssh-keygen -t rsa

最后一步会有提示,都按回车就可以

cat ./id_rsa.pub >> ./authorized_keys # 加入授权

~的含义

在 Linux 系统中,~ 代表的是用户的主文件夹,即 “/home/用户名” 这个目录,如你的用户名为 hadoop,则 ~就代表 “/home/hadoop/”。

此时再用 ssh localhost 命令,无需输入密码就可以直接登陆了,如下图所示。

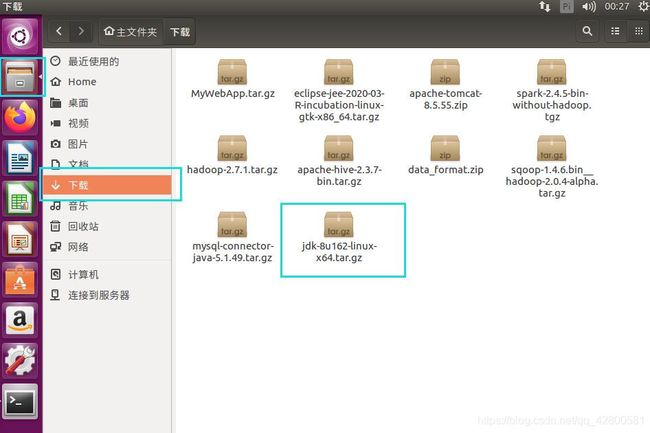

3.安装Java环境

按照下面步骤来安装JDK1.8。之前已经把全部软件都下载完的不必再单独下载,

没下载的可以单独下载JDK1.8的安装包jdk-8u162-linux-x64.tar.gz,https://pan.baidu.com/s/1ovYL1O_89ZDDy5TCL6oB4Q

提取码:kh8b

请把文件都放在下载目录下

在Linux命令行界面中,执行如下Shell命令(注意:当前登录用户名是hadoop):

cd /usr/lib

sudo mkdir jvm #创建/usr/lib/jvm目录用来存放JDK文件

cd ~ #进入hadoop用户的主目录

cd 下载 #刚才已经通过FTP软件把JDK安装包jdk-8u162-linux-x64.tar.gz上传到该目录下

sudo tar -zxvf ./jdk-8u162-linux-x64.tar.gz -C /usr/lib/jvm #把JDK文件解压到/usr/lib/jvm目录下

JDK文件解压缩以后,可以执行如下命令到/usr/lib/jvm目录查看一下:

cd /usr/lib/jvm

ls

可以看到,在/usr/lib/jvm目录下有个jdk1.8.0_162目录。

下面继续执行如下命令,设置环境变量:

cd ~

vim ~/.bashrc

上面命令将使用vim编辑器进行修改操作

打开vim编辑器后,需要键盘敲击输入一个英文字母i,进入编辑状态以后才能修改内容。

修改后,需要按键盘上的Esc键退出vim的编辑状态,之后有以下几种选择:

一、 从键盘输入“:wq”三个英文字母,然后回车,表示保存文件并退出。

二、从键盘输入“:q”两个英文字母,然后回车,表示不保存并退出。如果本次编辑过程只是查看了文件内容,没有对文件做任何修改,则可以顺利退出。但是,如果已经修改了文件内容,则vim编辑器不允许就这样退出,会给出提示信息,这时,要想不保存就退出vim编辑器,就要采用下面一种方式,即输入“:q!”。

三、从键盘输入“:q!”三个英文字母,然后回车,表示不保存并强制退出。

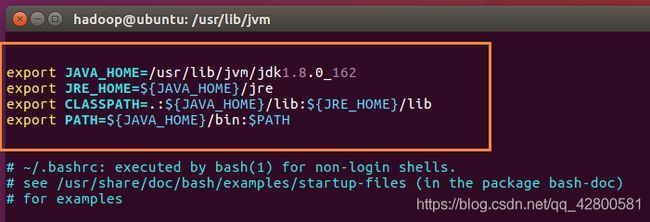

打开了hadoop这个用户的环境变量配置文件,在这个文件的开头位置,添加如下几行内容(整段复制就行):

先键盘敲击输入一个英文字母i,进入编辑状态,再把这段复制过去

export JAVA_HOME=/usr/lib/jvm/jdk1.8.0_162

export JRE_HOME=${JAVA_HOME}/jre

export CLASSPATH=.:${JAVA_HOME}/lib:${JRE_HOME}/lib

export PATH=${JAVA_HOME}/bin:$PATH

如图所示

修改后,需要按键盘上的Esc键退出vim的编辑状态,再从键盘输入“:wq”三个英文字母,然后回车,表示保存文件并退出。

修改后,需要按键盘上的Esc键退出vim的编辑状态,再从键盘输入“:wq”三个英文字母,然后回车,表示保存文件并退出。

然后,务必执行如下命令让.bashrc文件的配置立即生效:

source ~/.bashrc

可以使用如下命令查看是否安装成功:

java -version

如果能够在屏幕上返回如下信息,则说明安装成功:

hadoop@ubuntu:~$ java -version

java version “1.8.0_162”

Java™ SE Runtime Environment (build 1.8.0_162-b12)

Java HotSpot™ 64-Bit Server VM (build 25.162-b12, mixed mode)

到此,JDK安装完毕

4.安装 Hadoop2.7.1

之前已经把全部软件都下载完的不必再单独下载,

没下载的可以单独下载hadoop-2.7.1.tar.gz

https://pan.baidu.com/s/1ovYL1O_89ZDDy5TCL6oB4Q

提取码:kh8b

将 Hadoop 安装至 /usr/local/ 中:

sudo tar -zxf ~/下载/hadoop-2.7.1.tar.gz -C /usr/local # 解压到/usr/local中

cd /usr/local/

sudo mv ./hadoop-2.7.1/ ./hadoop # 将文件夹名改为hadoop

sudo chown -R hadoop ./hadoop # 修改文件权限

输入如下命令来检查 Hadoop 是否可用,成功则会显示 Hadoop 版本信息:

cd /usr/local/hadoop

./bin/hadoop version

相对路径与绝对路径

请务必注意命令中的相对路径与绝对路径,本文后续出现的 ./bin/…,./etc/… 等包含 ./ 的路径,均为相对路径,以 /usr/local/hadoop 为当前目录。例如在 /usr/local/hadoop 目录中执行 ./bin/hadoop version 等同于执行 /usr/local/hadoop/bin/hadoop version。可以将相对路径改成绝对路径来执行,但如果你是在主文件夹 ~ 中执行 ./bin/hadoop version,执行的会是 /home/hadoop/bin/hadoop version,就不是我们所想要的了

Hadoop伪分布式配置

Hadoop 可以在单节点上以伪分布式的方式运行,Hadoop 进程以分离的 Java 进程来运行,节点既作为 NameNode 也作为 DataNode,同时,读取的是 HDFS 中的文件。

Hadoop 的配置文件位于 /usr/local/hadoop/etc/hadoop/ 中,伪分布式需要修改2个配置文件 core-site.xml 和 hdfs-site.xml 。Hadoop的配置文件是 xml 格式,每个配置以声明 property 的 name 和 value 的方式来实现。

修改配置文件 core-site.xml

cd /usr/local/hadoop/etc/hadoop/

vim core-site.xml

按一下键盘上的 i 键进入编辑模式,将

</configuration>

修改为下面配置:

hadoop.tmp.dir</name>

file:/usr/local/hadoop/tmp</value>

Abase for other temporary directories.</description>

</property>

fs.defaultFS</name>

hdfs://localhost:9000</value>

</property>

</configuration>

之后看看文件第一行有没有空行,有的话删除,图片是正确情况,不要让

按键盘左上角ESC键退出编辑模式,并键盘输入

:wq

敲回车保存退出

同样的,修改配置文件 hdfs-site.xml:

vim hdfs-site.xml

将

</configuration>

修改为

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/usr/local/hadoop/tmp/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/usr/local/hadoop/tmp/dfs/data</value>

</property>

</configuration>

配置完成后,执行 NameNode 的格式化:

cd /usr/local/hadoop

./bin/hdfs namenode -format

成功的话,会看到 “successfully formatted” 和 “Exitting with status 0” 的提示,若为 “Exitting with status 1” 则是出错。

如果在这一步时提示 Error: JAVA_HOME is not set and could not be found.

的错误,则说明之前设置 JAVA_HOME 环境变量那边就没设置好,请按教程先设置好 JAVA_HOME

变量,否则后面的过程都是进行不下去的。如果已经按照前面教程在.bashrc文件中设置了JAVA_HOME,还是出现 Error:

JAVA_HOME is not set and could not be found.

的错误,那么,请到hadoop的安装目录修改配置文件“/usr/local/hadoop/etc/hadoop/hadoop-env.sh”,在里面找到“export

JAVA_HOME=${JAVA_HOME}”这行,然后,把它修改成JAVA安装路径的具体地址,比如,“export

JAVA_HOME=/usr/lib/jvm/default-java”,然后,再次启动Hadoop。

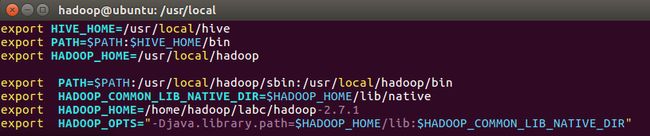

配置环境变量

vim ~/.bashrc

去文件最前边添加下面配置:

export HADOOP_HOME=/home/hadoop/labc/hadoop-2.7.1

export HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/native

export HADOOP_OPTS="-Djava.library.path=$HADOOP_HOME/lib:$HADOOP_COMMON_LIB_NATIVE_DIR"

source ~/.bashrc

使变量设置生效

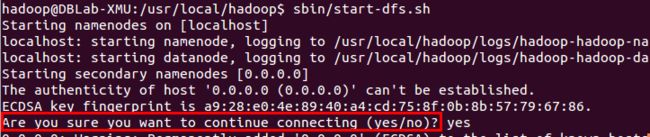

接着开启 NameNode 和 DataNode 守护进程。

cd /usr/local/hadoop

./sbin/start-dfs.sh #start-dfs.sh是个完整的可执行文件,中间没有空格

若出现如下SSH提示,输入yes即可。

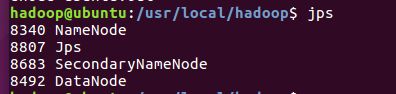

启动完成后,可以通过命令 jps 来判断是否成功启动,若成功启动则会列出如下进程: “NameNode”、”DataNode” 和 “SecondaryNameNode”

(如果 SecondaryNameNode 没有启动,请运行 sbin/stop-dfs.sh 关闭进程,然后再次尝试启动尝试)。如果没有 NameNode 或 DataNode,那就是配置不成功,请仔细检查之前步骤,或通过查看启动日志排查原因。

若要关闭 Hadoop,则运行

./sbin/stop-dfs.sh

上面的教程中,我们都是先进入到 /usr/local/hadoop 目录中,再执行 sbin/hadoop,实际上等同于运行

/usr/local/hadoop/sbin/hadoop。我们可以将 Hadoop 命令的相关目录加入到 PATH

环境变量中,这样就可以直接通过 start-dfs.sh 开启 Hadoop,也可以直接通过 hdfs 访问 HDFS

的内容,方便平时的操作。

在 ~/.bashrc 中进行设置

vim ~/.bashrc

在文件最前面加入如下单独一行:

export PATH=$PATH:/usr/local/hadoop/sbin:/usr/local/hadoop/bin

添加后执行

source ~/.bashrc

使设置生效,生效后,在任意目录中,都可以直接使用 hdfs 等命令了

5.安装hive

之前已经把全部软件都下载完的不必再单独下载,

没下载的可以单独下载apache-hive-2.3.7-bin.tar.gz

https://pan.baidu.com/s/1ovYL1O_89ZDDy5TCL6oB4Q

提取码:kh8b

注意:这些命令尽量都要一行一行的复制,#后边是注释不必复制,sudo命令需要手动输入密码,多行复制会出现密码错误!

sudo tar -zxvf ~/下载/apache-hive-2.3.7-bin.tar.gz -C /usr/local # 解压到/usr/local中

cd /usr/local/

sudo mv apache-hive-2.3.7-bin hive # 将文件夹名改为hive

sudo chown -R hadoop:hadoop hive # 修改文件权限

注意,上面的hadoop:hadoop是用户组和用户名,如果你当前使用其他用户名登录了Linux系统,则把hadoop替换成其他用户名。

为了方便使用,我们把hive命令加入到环境变量中去,

使用vim编辑器打开.bashrc文件:

vim ~/.bashrc

在该文件最前面一行添加如下内容:

export HIVE_HOME=/usr/local/hive

export PATH=$PATH:$HIVE_HOME/bin

export HADOOP_HOME=/usr/local/hadoop

HADOOP_HOME需要被配置成你机器上Hadoop的安装路径,比如这里是安装在/usr/local/hadoop目录

保存退出后,运行如下命令使配置立即生效:

source ~/.bashrc

修改/usr/local/hive/conf下的hive-site.xml

cd /usr/local/hive/conf

mv hive-default.xml.template hive-default.xml

上面命令是将hive-default.xml.template重命名为hive-default.xml;

然后,使用vim编辑器新建一个配置文件hive-site.xml,命令如下:

cd /usr/local/hive/conf

vim hive-site.xml

在hive-site.xml中添加如下配置信息:

"1.0" encoding="UTF-8" standalone="no"?>

-stylesheet type="text/xsl" href="configuration.xsl"?>

javax.jdo.option.ConnectionURL</name>

jdbc:mysql://localhost:3306/hive?createDatabaseIfNotExist=true&;useSSL=false</value>

JDBC connect string for a JDBC metastore</description>

</property>

javax.jdo.option.ConnectionDriverName</name>

com.mysql.jdbc.Driver</value>

Driver class name for a JDBC metastore</description>

</property>

<!-- 数据库的用户名 -->

javax.jdo.option.ConnectionUserName</name>

root</value>

username to use against metastore database</description>

</property>

<!-- 数据库的密码 -->

javax.jdo.option.ConnectionPassword</name>

hadoop</value>

password to use against metastore database</description>

</property>

</configuration>

然后,按键盘上的“ESC”键退出vim编辑状态,再输入:wq

保存并退出vim编辑器。

cp hive-env.sh.template hive-env.sh

vim hive-env.sh

将下边代码加入文件最上边

HADOOP_HOME=/usr/local/hadoop

保存并退出

接下来删除hive本身的日志jar包,不删除的话会有冲突

rm /usr/local/hive/lib/log4j-slf4j-impl-2.6.2.jar

6.安装并配置mysql

这里我们采用MySQL数据库保存Hive的元数据

使用以下命令即可进行mysql安装,注意安装前先更新一下软件源以获得最新版本:

cd ~

sudo apt-get update #更新软件源

sudo apt-get install mysql-server #安装mysql

安装过程会提示设置mysql root用户的密码,输入hadoop就行,还要重复确认

设置完成后等待自动安装即可。默认安装完成就启动了mysql。

启动mysql服务器:

service mysql start

关闭服务器:service mysql stop

确认是否启动成功,mysql节点处于LISTEN状态表示启动成功(这一步可能会等待较长时间):

sudo netstat -tap | grep mysql

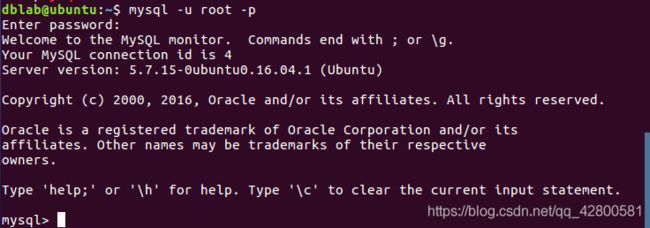

mysql -u root -p

解决利用sqoop导入MySQL中文乱码的问题(可以插入中文,但不能用sqoop导入中文)

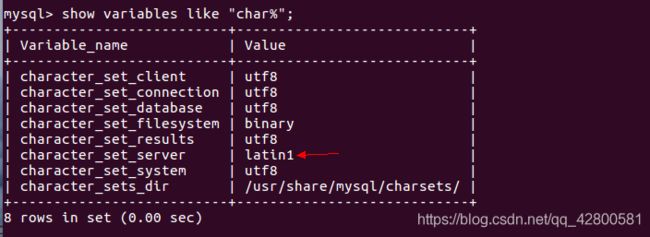

导致导入时中文乱码的原因是character_set_server默认设置是latin1,如下图。

exit;

编辑配置文件

sudo vi /etc/mysql/mysql.conf.d/mysqld.cnf

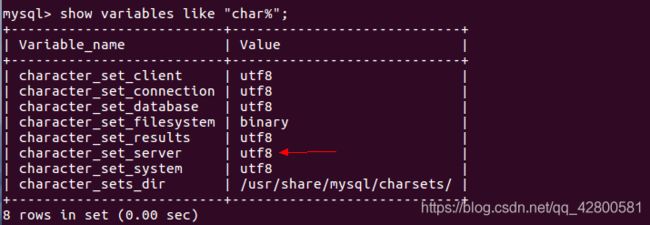

在[mysqld]下添加一行character_set_server=utf8 如图

保存并退出,然后重启MySQL服务

service mysql restart

进入MySQL shell

mysql -u root -p

并查看MySQL目前设置的编码,如图

show variables like "char%";

注意:MySQL中每个命令后都要以英文分号;结尾

exit;

之前已经把全部软件都下载完的不必再单独下载,

没下载的可以单独下载mysql-connector-java-5.1.49.tar.gz

https://pan.baidu.com/s/1ovYL1O_89ZDDy5TCL6oB4Q

提取码:kh8b

cd ~/下载

tar -zxvf mysql-connector-java-5.1.49.tar.gz #解压

cp mysql-connector-java-5.1.49/mysql-connector-java-5.1.49-bin.jar /usr/local/hive/lib #将mysql-connector-java-5.1.49-bin.jar拷贝到/usr/local/hive/lib目录下

启动并登陆mysql shell

service mysql start #启动mysql服务

mysql -u root -p #登陆shell界面

新建hive数据库。

create database hive; #这个hive数据库与hive-site.xml中localhost:3306/hive的hive对应,用来保存hive元数据

配置mysql允许hive接入:

grant all on *.* to root@localhost identified by 'hadoop'; #将所有数据库的所有表的所有权限赋给root用户,后面的hive是配置hive-site.xml中配置的连接密码

flush privileges; #刷新mysql系统权限关系表

退出MySQL shell界面

exit;

schematool是一个用于 Hive Metastore 架构操控的脱机工具,此工具可用于初始化当前 Hive 版本的 Metastore 架构:

schematool -dbType mysql -initSchema

启动hive,在启动hive之前,请先启动hadoop集群。

start-all.sh #启动hadoop

hive #启动hive

注意,我们这里已经配置了PATH,所以,不要把start-all.sh和hive命令的路径加上。如果没有配置PATH,请加上路径才能运行命令,比如,本教程Hadoop安装目录是“/usr/local/hadoop”,Hive的安装目录是“/usr/local/hive”,因此,启动hadoop和hive,也可以使用下面带路径的方式:

cd /usr/local/hadoop ./sbin/start-all.sh

cd /usr/local/hive ./bin/hive

启动进入Hive的交互式执行环境以后,会出现如下命令提示符:

hive>

可以在里面输入SQL语句,要退出Hive交互式执行环境,可以输入如下命令:

exit;

7.安装sqoop

之前已经把全部软件都下载完的不必再单独下载,

没下载的可以单独下载sqoop-1.4.6.bin__hadoop-2.0.4-alpha.tar.gz

https://pan.baidu.com/s/1ovYL1O_89ZDDy5TCL6oB4Q

提取码:kh8b

解压sqoop1.4.6

cd ~/下载 #sqoop-1.4.6.bin__hadoop-2.0.4-alpha.tar.gz文件下载后就被保存在该目录下面

sudo tar -zxvf sqoop-1.4.6.bin__hadoop-2.0.4-alpha.tar.gz -C /usr/local #解压安装文件

cd /usr/local

sudo mv sqoop-1.4.6.bin__hadoop-2.0.4-alpha sqoop #修改文件名

sudo chown -R hadoop:hadoop sqoop #修改文件夹属主,如果你当前登录用户名不是hadoop,请修改成你自己的用户名

修改配置文件sqoop-env.sh

cd sqoop/conf/

cat sqoop-env-template.sh >> sqoop-env.sh #将sqoop-env-template.sh复制一份并命名为sqoop-env.sh

vim sqoop-env.sh #编辑sqoop-env.sh

在sqoop-env.sh最上边插入以下信息:

export HADOOP_COMMON_HOME=/usr/local/hadoop

export HADOOP_MAPRED_HOME=/usr/local/hadoop

export HBASE_HOME=/usr/local/hbase

export HIVE_HOME=/usr/local/hive

保存并退出,然后配置环境变量

vim ~/.bashrc

在配置文件第一行键入如下信息:

export SQOOP_HOME=/usr/local/sqoop

export PATH=$PATH:$SBT_HOME/bin:$SQOOP_HOME/bin

export CLASSPATH=$CLASSPATH:$SQOOP_HOME/lib

保存该文件,退出vim编辑器。

然后,执行下面命令让配置文件立即生效:

source ~/.bashrc

将mysql驱动包拷贝到$SQOOP_HOME/lib

cp ~/下载/mysql-connector-java-5.1.49/mysql-connector-java-5.1.49-bin.jar /usr/local/sqoop/lib

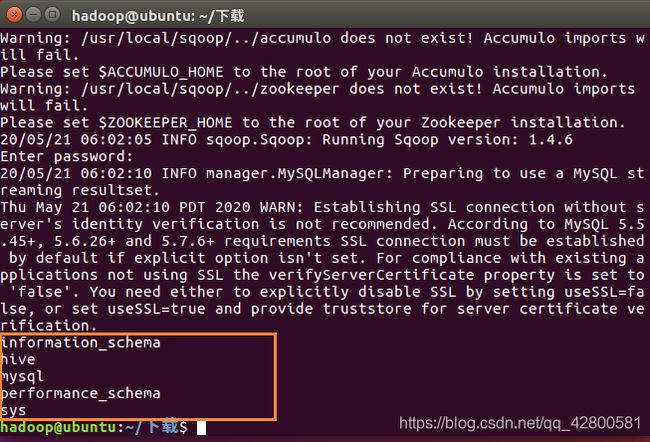

测试与MySQL的连接

首先请确保mysql服务已经启动了,如果没有启动,请执行下面命令启动:

service mysql start

然后就可以测试sqoop与MySQL之间的连接是否成功:

sqoop list-databases --connect jdbc:mysql://127.0.0.1:3306/ --username root -P

8.安装Spark

还是那句不厌其烦的老话,唉,之前已经把全部软件都下载完的不必再单独下载,

没下载的可以单独下载spark-2.4.5-bin-without-hadoop.tgz

https://pan.baidu.com/s/1ovYL1O_89ZDDy5TCL6oB4Q

提取码:kh8b

sudo tar -zxf ~/下载/spark-2.4.5-bin-without-hadoop.tgz -C /usr/local/

cd /usr/local

sudo mv ./spark-2.4.5-bin-without-hadoop/ ./spark

sudo chown -R hadoop:hadoop ./spark # 此处的 hadoop 为你的用户名

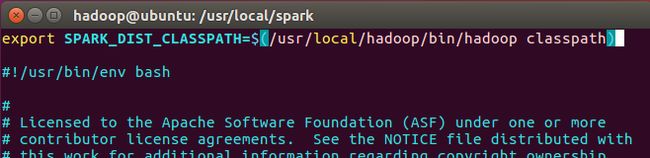

安装后,还需要修改Spark的配置文件spark-env.sh

cd /usr/local/spark

cp ./conf/spark-env.sh.template ./conf/spark-env.sh

编辑spark-env.sh文件

vim ./conf/spark-env.sh

在第一行添加以下配置信息:

export SPARK_DIST_CLASSPATH=$(/usr/local/hadoop/bin/hadoop classpath)

配置完成后就可以直接使用,不需要像Hadoop运行启动命令。

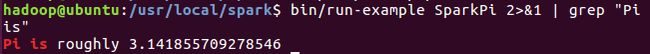

通过运行Spark自带的示例,验证Spark是否安装成功。

执行时会输出非常多的运行信息,输出结果不容易找到,可以通过 grep 命令进行过滤(命令中的 2>&1 可以将所有的信息都输出到

stdout 中,否则由于输出日志的性质,还是会输出到屏幕中):

cd /usr/local/spark

bin/run-example SparkPi 2>&1 | grep "Pi is"

过滤后的运行结果如下图示,可以得到π 的小数近似值:

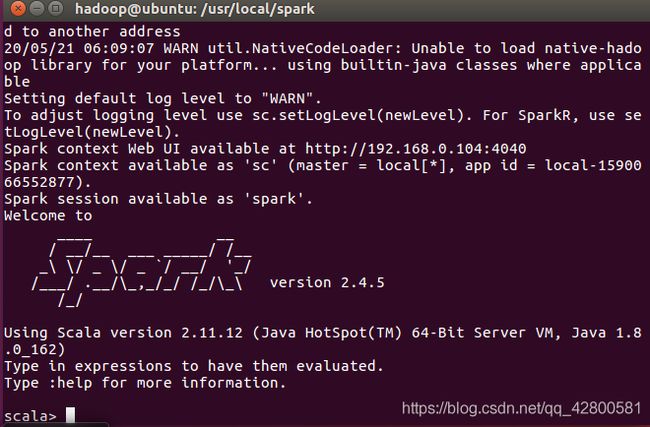

启动Spark Shell

cd /usr/local/spark

bin/spark-shell

启动spark-shell后,会自动创建名为sc的SparkContext对象和名为spark的SparkSession对象,如图:

输入

:quit

即可退出spark shell

9.安装Tomcat

之前已经把全部软件都下载完的不必再单独下载,

没下载的可以单独下载apache-tomcat-8.5.55.zip

https://pan.baidu.com/s/1ovYL1O_89ZDDy5TCL6oB4Q

提取码:kh8b

解压apache-tomcat-8.5.55.zip :

cd ~/下载/

unzip apache-tomcat-8.5.55.zip -d ~

至此,除了软件eclipse外所有环境搭建完毕

开心不?(◕ˇ∀ˇ◕)

(〟-_・)ン? 别开心太早,现在才完成一半,下边继续

一套简单但完整的伪分布式大数据分析流程(三)(图文详解),适用于Windows系统

https://blog.csdn.net/qq_42800581/article/details/106268361