zookeeper的介绍、安装、集群架构

[TOC]

一、Zookeeper介绍

1.Zookeeper是什么

Zookeeper(zoo+keeper动物园管理者):它是一个分布式协调服务

最初作为研发Hadoop时的副产品,使用java语言编写

由于分布式系统中一致性处理较为困难,其他的分布式系统没有必要费劲重复造轮子,故随后的分布式系统中大量应用了zookeeper,以至于zookeeper成为了各种分布式系统的基础组件,

著名的hadoop、kafka、dubbo 都是基于zookeeper而构建

2.Zookeeper能干什么

分布式应用程序可以基于它实现同步服务,配置维护和命名服务等

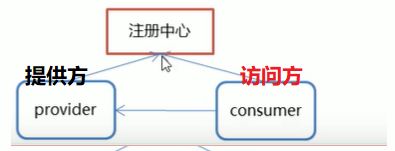

- 1 微服务中的注册发现

dubbo框架,springcloud框架作为注册中心 - 2 为Hadoop,kafka集群做做协调

- 3 实现分布式的锁

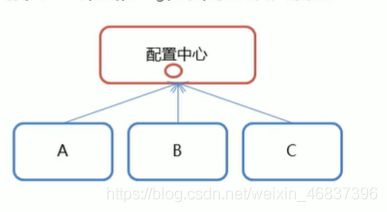

- 4.配置管理

3.应用场景

zookeepepr是一个经典的分布式数据一致性解决方案,致力于为分布式应用提供一个高性能、高可用,且具有严格顺序访问控制能力的分布式协调存储服务。

- 维护配置信息

- 分布式锁服务

- 集群管理

- 生成分布式唯一ID

1)维护配置信息

`java`编程经常会遇到配置项,比如数据库的`url、 schema、user`和 `password`等。通常这些配置项我们会放置在配置文件中,再将配置文件放置在服务器上当需要更改配置项时,需要去服务器上修改对应的配置文件。

但是随着分布式系统的兴起,由于许多服务都需要使用到该配置文件,因此有必须保证该**配置服务的高可用性**`(highavailability)`和各台服务器上配置数据的一致性。

通常会将配置文件部署在一个集群上,然而一个集群动辄上千台服务器,此时如果再一台台服务器逐个修改配置文件那将是非常繁琐且危险的的操作,**因此就需要一种服务,能够高效快速且可靠地完成配置项的更改**等操作,并能够保证各配置项在每台服务器上的数据一致性。

`zookeeper`就可以提供这样一种服务,其使用Zab这种一致性协议来保证一致性。现在有很多开源项目使用`zookeeper`来维护配置,如在 `hbase`中,客户端就是连接一个` zookeeper`,获得必要的` hbase`集群的配置信息,然后才可以进一步操作。还有在开源的消息队列 kafka中,也便用`zookeeper`来维护 `brokers`的信息。在 `alibaba`开源的`soa`框架`dubbo`中也广泛的使用`zookeeper`管理一些配置来实现服务治理。

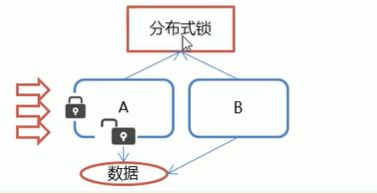

2)分布式锁服务

一个集群是一个分布式系统,由多台服务器组成。为了提高并发度和可靠性,多台服务器上运行着同一种服务。当多个服务在运行时就需要协调各服务的进度,有时候需要保证当某个服务在进行某个操作时,其他的服务都不能进行该操作,即对该操作进行加锁,如果当前机器挂掉后,释放锁并 `fail over`到其他的机器继续执行该服务

集群管理

3)集群管理

一个集群有时会因为各种软硬件故障或者网络故障,出现棊些服务器挂掉而被移除集群,而某些服务器加入到集群中的情况,`zookeeper`会将这些服务器加入/移出的情况通知给集群中的其他正常工作的服务器,以及时调整存储和计算等任务的分配和执行等。此外`zookeeper`还会对故障的服务器做出诊断并尝试修复。

4)生产分布式唯一ID

在过去的单库单表型系统中,通常可以使用数据库字段自带的auto_ increment属性来自动为每条记录生成一个`唯一的ID`。但是分库分表后,就无法在依靠数据库的`auto_ Increment`属性来唯一标识一条记录了。此时我们就可以用`zookeeper`在分布式环境下`生成全局唯一ID`。

做法如下:每次要生成一个新id时,创建一个持久顺序节点,创建操作返回的节点序号,即为新id,然后把比自己节点小的删除即可

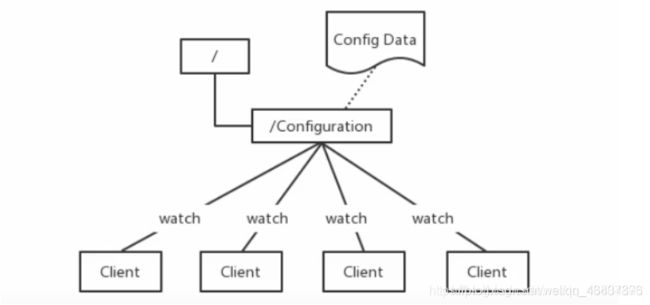

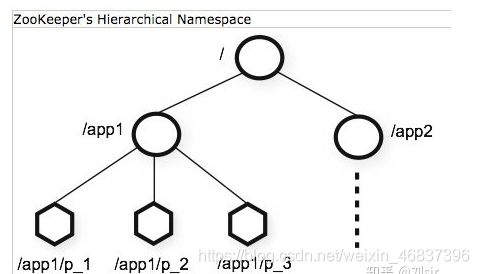

4.Zookeeper数据模型

`Zookeeper`本身是一个分布式的应用,通过对共享的数据的管理来实现对分布式应用的协调。

`ZooKeeper`使用一个树形目录作为数据模型,这个目录和文件目录类似,目录上的每一个节点被称作`ZNodes`

每个子目录项如` NameService` 都被称作为 `znode`(目录节点),和文件系统一样,我们能够自由的增加、删除znode,在一个`znode`下增加、删除`子znode`,唯一的不同在于`znode`是可以**存储数据**的。

数据结构的特点

每个子目录项如` NameService` 都被称作为 `znode`,这个 znode 是被它所在的路径唯一标识,**如 p_1 这个 znode 的标识为 /app1/p_1**

`znode `可以有子节点目录,**并且每个 znode 可以存储数据**,注意 `EPHEMERAL` 类型的目录节点不能有子节点目录

`znode` 是有版本的,每个 znode 中存储的数据可以有多个版本,也就是一个访问路径中可以存储多份数据

`znode` 可以是临时节点,一旦创建这个 `znode` 的客户端与服务器失去联系,这个 `znode` 也将自动删除,`Zookeeper` 的客户端和服务器通信采用长连接方式,每个客户端和服务器通过心跳来保持连接,这个连接状态称为` session`,如果 `znode` 是临时节点,这个 `session` 失效,`znode` 也就删除了

`znode `的目录名可以自动编号,如 **App1 已经存在,再创建的话,将会自动命名为 App2**

`znode` 可以被监控,包括这个目录节点中存储的数据的修改,子节点目录的变化等,一旦变化可以通知设置监控的客户端,这个是 `Zookeeper `的核心特性,`Zookeeper` 的很多功能都是基于这个特性实现的。

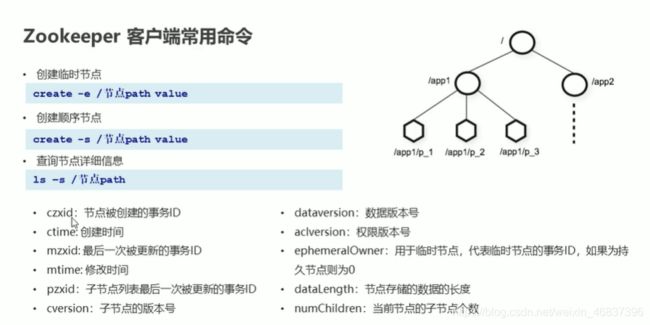

节点的类型:

`PERSISTENT`-持久化目录节点 客户端与zookeeper断开连接后,该节点依旧存在

`PERSISTENT_SEQUENTIAL` `-s参数`:持久化顺序编号目录节点 客户端与zookeeper断开连接后,该节点依旧存在,只是Zookeeper给该节点名称进行顺序编号

`EPHEMERAL` `-e参数:` 临时目录节点 客户端与zookeeper断开连接后,该节点被删除

`EPHEMERAL_SEQUENTIAL` ` -es参数`:临时顺序编号目录节点 客户端与zookeeper断开连接后,该节点被删除,只是Zookeeper给该节点名称进行顺序编号

二、单机安装

1、Zookeeper单机安装

需要java环境 jdk8就行 rpm包也可以

# 1.安装Java

[root@zookeeper01 ~]# yum install java-1.8.0-openjdk* -y

[root@zookeeper01 ~/zookeeper-3.6.3]# java -version #出现java后继续进行

openjdk version "1.8.0_302"

OpenJDK Runtime Environment (build 1.8.0_302-b08)

OpenJDK 64-Bit Server VM (build 25.302-b08, mixed mode)

# 2.安装zookeeper(不用要最新版)

[root@zookeeper01 ~]# wget https://mirrors.bfsu.edu.cn/apache/zookeeper/zookeeper-3.6.3/apache-zookeeper-3.6.3-bin.tar.gz

# 3.解压

[root@zookeeper01 ~]# tar -xzf apache-zookeeper-3.6.3-bin.tar.gz

# 4.重命名,进入

[root@zookeeper01 ~]# mv apache-zookeeper-3.6.3-bin zookeeper-3.6.3

# 5.查看

# bin启动目录,conf配置文件目录

[root@zookeeper01 ~/zookeeper-3.6.3]# ll

total 32

drwxr-xr-x 2 1000 1000 289 Apr 9 00:34 bin

drwxr-xr-x 2 1000 1000 70 Sep 22 23:54 conf

drwxr-xr-x 5 1000 1000 4096 Apr 9 00:34 docs

drwxr-xr-x 2 root root 4096 Sep 22 23:48 lib

-rw-r--r-- 1 1000 1000 11358 Apr 9 00:34 LICENSE.txt

drwxr-xr-x 2 root root 78 Sep 22 23:50 logs

-rw-r--r-- 1 1000 1000 432 Apr 9 00:34 NOTICE.txt

-rw-r--r-- 1 1000 1000 1963 Apr 9 00:34 README.md

-rw-r--r-- 1 1000 1000 3166 Apr 9 00:34 README_packaging.md

# 6.修改配置文件

[root@zookeeper01 ~/zookeeper-3.6.3]# mkdir data

[root@zookeeper01 ~/zookeeper-3.6.3/conf]# mv zoo_sample.cfg zoo.cfg

[root@zookeeper01 ~/zookeeper-3.6.3/conf]# vim zoo.cfg

dataDir=/root/zookeeper-3.6.3/data/ #修改zookeeper存放的目录

# 7.启动

# 这里命令写的长是为了便于知道ZooKeeper是如何使用配置文件的。

[root@zookeeper01 ~/zookeeper-3.6.3]# ./bin/zkServer.sh start ./conf/zoo.cfg

# 8.查看ZooKeeper是否运行

[root@zookeeper01 ~/zookeeper-3.6.3]# ps aux |grep zookeeper

# 也可以使用jps ,可以看到java进程中有QuorumPeerMain列出来。

# 9.查看ZooKeeper的状态

[root@zookeeper01 ~/zookeeper-3.6.3]# ./bin/zkServer.sh status

# 10.常用的ZooKeeper用法

[root@zookeeper01 ~/zookeeper-3.6.3]# ./zkServer.sh {start|start-foreground|stop|restart|status|upgrade|print-cmd}

# 11.客户端启动

[root@zookeeper01 ~/zookeeper-3.6.3]# bin/zkCli.sh

[zk: localhost:2181(CONNECTED) 2] ls /

[zookeeper]

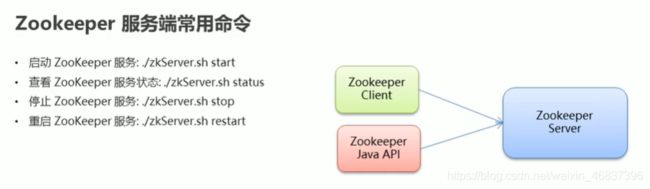

2、zookeeper服务端命令

启动服务端的命令:./zkServer.sh start

查看服务端的状态 :./zkServer.sh status

停止服务端的服务:./zkServer.sh stop

重启服务端的服务:./zkServer.sh restart

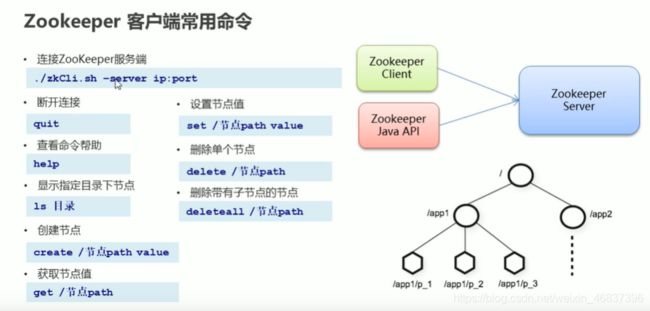

3、客户端连接与命令

# 客户端连接

./bin/zkCli.sh -server localhost:2181

# 执行命令

ls / # 查看节点 一层一层查看

version # 查看版本

#退出:

quit

[zk: localhost:2181(CONNECTED) 2] ls /

[zookeeper]

[zk: localhost:2181(CONNECTED) 3] ls /zookeeper

[config, quota]

#创建===create 节点 数据(不写默认就是空的)

[zk: localhost:2181(CONNECTED) 6] ls /

[zookeeper]

[zk: localhost:2181(CONNECTED) 7] create /app1 it

Created /app1

[zk: localhost:2181(CONNECTED) 8] ls /

[app1, zookeeper]

#查看====get

[zk: localhost:2181(CONNECTED) 9] get /app1

it

[zk: localhost:2181(CONNECTED) 10] create /app2

Created /app2

[zk: localhost:2181(CONNECTED) 11] get /app2

null

#修改

[zk: localhost:2181(CONNECTED) 12] set /app

app1 app2

[zk: localhost:2181(CONNECTED) 12] set /app2 itcast

[zk: localhost:2181(CONNECTED) 13] get /app2

itcast

#删除

[zk: localhost:2181(CONNECTED) 14] delete /app1

[zk: localhost:2181(CONNECTED) 15] ls /

[app2, zookeeper]

...

子节点的增删改查

[zk: localhost:2181(CONNECTED) 16] create /app1

Created /app1

[zk: localhost:2181(CONNECTED) 17] create /app1/p1

Created /app1/p1

[zk: localhost:2181(CONNECTED) 18] create /app1/p2

Created /app1/p2

[zk: localhost:2181(CONNECTED) 19] ls /

[app1, app2, zookeeper]

[zk: localhost:2181(CONNECTED) 20] ls /app1

[p1, p2]

[zk: localhost:2181(CONNECTED) 21] delete /app1/p1

[zk: localhost:2181(CONNECTED) 22] delete /app1

Node not empty: /app1

[zk: localhost:2181(CONNECTED) 23] deleteall /app1

[zk: localhost:2181(CONNECTED) 24] ls /

[app2, zookeeper]

注意:删除子节点的数据可以直接用delete

如果node节点有数据,子节点也有数据,这时候需要deleteall强制删除node节点

# 停止服务

./bin/zkServer.sh stop

#万能命令

help

1、创建临时节点和顺序节点

#创建临时节点

[zk: localhost:2181(CONNECTED) 27] create -e /app1

Created /app1

[zk: localhost:2181(CONNECTED) 28] ls /

[app1, app2, zookeeper]

只要会话断开,临时节点消失。

#创建顺序节点

[zk: localhost:2181(CONNECTED) 2] create -s /app1

Created /app10000000004

[zk: localhost:2181(CONNECTED) 3] create -s /app1

Created /app10000000005

[zk: localhost:2181(CONNECTED) 4] create -s /app1

Created /app10000000006

[zk: localhost:2181(CONNECTED) 5] create -s /app1

Created /app10000000007

[zk: localhost:2181(CONNECTED) 6] ls /

[app10000000004, app10000000005, app10000000006, app10000000007, app2, zookeeper]

#创建临时顺序节点

[zk: localhost:2181(CONNECTED) 8] create -es /app3

Created /app30000000008

[zk: localhost:2181(CONNECTED) 9] ls /

[app10000000004, app10000000005, app10000000006, app10000000007, app2, app30000000008, zookeeper]

2、查看节点的详细信息

ls -s /节点path

3、zookeeper配置文件参数解读

# 心跳 2000ms

tickTime=2000

# Leader和Follow刚开始通信的时候,初始化最大的延迟时间:10个心跳,一个心跳2000毫秒,20秒,超过说明连接不上

initLimit=10

# 集群正常启动后,Leader和Follow通信的最大延迟时间: 5 * 2000 毫秒

syncLimit=5

# 日志和数据存储路径

dataDir=/tmp/zookeeper

dataLogDir=/tmp/log

# 客户端访问服务的端口号 IP + clientPort

clientPort=2181

# 限制连接到zk客户端的数量,根据IP来区分不同的客户端。默认不开启,不限制连接数量

maxClientCnxns=60

# 保留多少个快照文件

#autopurge.snapRetainCount=3

# 快照和事务日志清理的频率,单位小时

#autopurge.purgeInterval=1

## Metrics Providers

# https://prometheus.io Metrics Exporter

#metricsProvider.className=org.apache.zookeeper.metrics.prometheus.PrometheusMetricsProvider

# Jetty使用的端口号

#metricsProvider.httpPort=7000

#metricsProvider.exportJvmInfo=true

4、Docker安装

# 拉取镜像

docker pull zookeeper

# 运行容器

docker run -id --name zk -p 2181:2181 zookeeper

# 今日容器

docker exec -it df249b28f9cc /bin/bash

# 查看节点

zkCli.sh -server localhost:2181

ls /

三、zookeeper集群架构(三台)

1、环境准备

| 准备机器 | IP | 服务名称 | 环境 |

|---|---|---|---|

| zookeeper01 | 192.168.10.20 | zookeeper01 | 闭防火墙和selinux |

| zookeeper02 | 192.168.10.21 | zookeeper02 | 关闭防火墙和selinux |

| zookeeper03 | 192.168.10.22 | zookeeper03 | 关闭防火墙和selinux |

# 0.本地hosts配置 (三台都要配置)

[root@zookeeper01 ~]# cat /etc/hosts

127.0.0.1 localhost localhost.localdomain localhost4 localhost4.localdomain4

::1 localhost localhost.localdomain localhost6 localhost6.localdomain6

172.16.1.20 zookeeper01

172.16.1.21 zookeeper02

172.16.1.22 zookeeper03

#1.zookeeper01机器做免密

[root@zookeeper01 ~]# ssh-keygen

[root@zookeeper01 ~]# for i in zookeeper01 zookeeper02 zookeeper03;do ssh-copy-id -i ~/.ssh/id_rsa.pub root@$i;done

2.企业实战

需要java环境 jdk8就行 rpm包也可以

# 1.安装Java

[root@zookeeper01 ~]# yum install java-1.8.0-openjdk* -y

[root@zookeeper01 ~/zookeeper-3.6.3]# java -version # 出现java后继续进行

openjdk version "1.8.0_302"

OpenJDK Runtime Environment (build 1.8.0_302-b08)

OpenJDK 64-Bit Server VM (build 25.302-b08, mixed mode)

# 2.安装zookeeper(不用要最新版)

[root@zookeeper01 ~]# wget https://mirrors.bfsu.edu.cn/apache/zookeeper/zookeeper-3.6.3/apache-zookeeper-3.6.3-bin.tar.gz

# 3.解压

[root@zookeeper01 ~]# tar -xzf apache-zookeeper-3.6.3-bin.tar.gz

# 4.重命名,进入

[root@zookeeper01 ~]# mv apache-zookeeper-3.6.3-bin zookeeper-3.6.3

# 5.查看

# bin启动目录,conf配置文件目录

[root@zookeeper01 ~/zookeeper-3.6.3]# ll

total 32

drwxr-xr-x 2 1000 1000 289 Apr 9 00:34 bin

drwxr-xr-x 2 1000 1000 70 Sep 22 23:54 conf

drwxr-xr-x 5 1000 1000 4096 Apr 9 00:34 docs

drwxr-xr-x 2 root root 4096 Sep 22 23:48 lib

-rw-r--r-- 1 1000 1000 11358 Apr 9 00:34 LICENSE.txt

drwxr-xr-x 2 root root 78 Sep 22 23:50 logs

-rw-r--r-- 1 1000 1000 432 Apr 9 00:34 NOTICE.txt

-rw-r--r-- 1 1000 1000 1963 Apr 9 00:34 README.md

-rw-r--r-- 1 1000 1000 3166 Apr 9 00:34 README_packaging.md

# 6.修改配置文件

[root@zookeeper01 ~/zookeeper-3.6.3]# mkdir data

[root@zookeeper01 ~/zookeeper-3.6.3/data]# vim myid

20 #每台机器数字不一样

[root@zookeeper01 ~/zookeeper-3.6.3/conf]# mv zoo_sample.cfg zoo.cfg

[root@zookeeper01 ~/zookeeper-3.6.3/conf]# vim zoo.cfg

[root@kafka conf]# grep -E ^[^#] zoo.cfg

tickTime=2000

initLimit=10

syncLimit=5

dataDir=/root/zookeeper-3.6.3/data/ #修改zookeeper存放的目录

clientPort=2181

#######################cluster##########################

server.20=zookeeper01:2888:3888

server.21=zookeeper02:2888:3888

server.22=zookeeper03:2888:3888

# 解释:

A 是一个数字,表示这个是第几号服务器;

集群模式下配置一个文件 myid,这个文件在 dataDir 目录下,这个文件里面有一个数据

就是 A 的值,Zookeeper 启动时读取此文件,拿到里面的数据与 zoo.cfg 里面的配置信息比

较从而判断到底是哪个 server。

B 是这个服务器的地址;

C 是这个服务器 Follower 与集群中的 Leader 服务器交换信息的端口;

D 是万一集群中的 Leader 服务器挂了,需要一个端口来重新进行选举,选出一个新的

Leader,而这个端口就是用来执行选举时服务器相互通信的端口。

# 7.分发zookeeper-3.6.3到其他机器上

[root@zookeeper01 ~]# scp -r zookeeper-3.6.3/ zookeeper02:/root/

[root@zookeeper02 ~]# vim zookeeper-3.6.3/data/myid

21 #zookeeper02机器上修改这个

[root@zookeeper01 ~]# scp -r zookeeper-3.6.3/ zookeeper03:/root/

[root@zookeeper03 ~]# vim zookeeper-3.6.3/data/myid

22 #zookeeper03机器上修改这个

# 8.分别在每天机器上一次启动

# 这里命令写的长是为了便于知道ZooKeeper是如何使用配置文件的。

[root@zookeeper01 ~/zookeeper-3.6.3]# ./bin/zkServer.sh start

[root@zookeeper02 ~/zookeeper-3.6.3]# ./bin/zkServer.sh start

[root@zookeeper03 ~/zookeeper-3.6.3]# ./bin/zkServer.sh start

# 9.脚本启动

[root@zookeeper01 ~]# vim zk.sh

#!/bin/bash

case $1 in

"start"){

for i inzookeeper01 zookeeper02 zookeeper03

do

echo ---------- zookeeper $i 启动 ------------

ssh $i "/root/zookeeper-3.6.3/bin/zkServer.sh

start"

done

};;

"stop"){

for i inzookeeper01 zookeeper02 zookeeper03

do

echo ---------- zookeeper $i 停止 ------------

ssh $i "/root/zookeeper-3.6.3/bin/zkServer.sh

stop"

done

};;

"status"){

for i inzookeeper01 zookeeper02 zookeeper03

do

echo ---------- zookeeper $i 状态 ------------

ssh $i "/root/zookeeper-3.6.3/bin/zkServer.sh

status"

done

};;

esac

# 10.查看集群状态

[root@zookeeper01 ~/zookeeper-3.6.3]# bin/zkServer.sh status

JMX enabled by default

Using config: /opt/module/zookeeper-3.5.7/bin/../conf/zoo.cfg

Mode: `follower

[root@zookeeper02 ~/zookeeper-3.6.3]# bin/zkServer.sh status

JMX enabled by default

Using config: /opt/module/zookeeper-3.5.7/bin/../conf/zoo.cfg

Mode: `leader

[root@zookeeper03 ~/zookeeper-3.6.3]# bin/zkServer.sh status

JMX enabled by default

Using config: /opt/module/zookeeper-3.5.7/bin/../conf/zoo.cfg

Mode: `follower

一般为集群为单数超过一半就会成master

如果有三个服务器,按顺序启动,第二个机器就是loader和follower

3、模拟测试

如果三号机器挂掉

[root@zookeeper03 ~/zookeeper-3.6.3]# bin/zkServer.sh status stop

[root@zookeeper03 ~/zookeeper-3.6.3]# bin/zkServer.sh status status

/usr/bin/java

ZooKeeper JMX enabled by default

Using config: /usr/local/zookeeper-cluster/zookeeper/bin/../conf/zoo.cfg

Client port found: 2181. Client address: localhost. Client SSL: false.

Mode: follower

[root@zookeeper03 ~/zookeeper-3.6.3]# bin/zkServer.sh status

/usr/bin/java

ZooKeeper JMX enabled by default

Using config: /usr/local/zookeeper-cluster/zookeeper/bin/../conf/zoo.cfg

Client port found: 2181. Client address: localhost. Client SSL: false.

Mode: leader

# 结论:一号机器仍然为following ,二号机器为loader

结论:停掉三号机器不影响大局

继续测试:

继续停掉一号机器

[root@zookeeper01 ~/zookeeper-3.6.3]# bin/zkServer.sh status

/usr/bin/java

ZooKeeper JMX enabled by default

Using config: /usr/local/zookeeper-cluster/zookeeper/bin/../conf/zoo.cfg

Client port found: 2181. Client address: localhost. Client SSL: false.

Error contacting service. It is probably not running.

# 结论:二号机器的状态为报错,类似于没有运行

这时候一号机器启动,查看二号机器的状态

一号机器:

[root@zookeeper01 ~/zookeeper-3.6.3]# bin/zkServer.sh start

/usr/bin/java

ZooKeeper JMX enabled by default

Using config: /usr/local/zookeeper-cluster/zookeeper/bin/../conf/zoo.cfg

Starting zookeeper ... STARTED

二号机器:

[root@zookeeper02 ~/zookeeper-3.6.3]# bin/zkServer.sh status

/usr/bin/java

ZooKeeper JMX enabled by default

Using config: /usr/local/zookeeper-cluster/zookeeper/bin/../conf/zoo.cfg

Client port found: 2181. Client address: localhost. Client SSL: false.

Mode: leader

# 结论:一号机器重新启动,然后二号机器再次成为leader,活过来了。一号机器成为following

继续测试:

启动三号机器,三号机器成为following

这时候停掉二号机器

[root@zookeeper02 ~/zookeeper-3.6.3]# bin/zkServer.sh status

/usr/bin/java

ZooKeeper JMX enabled by default

Using config: /usr/local/zookeeper-cluster/zookeeper/bin/../conf/zoo.cfg

Stopping zookeeper ... STOPPED

[root@zookeeper03 ~/zookeeper-3.6.3]# bin/zkServer.sh status

/usr/bin/java

ZooKeeper JMX enabled by default

Using config: /usr/local/zookeeper-cluster/zookeeper/bin/../conf/zoo.cfg

Client port found: 2181. Client address: localhost. Client SSL: false.

Mode: leader

# 结论:三号机器成为leader

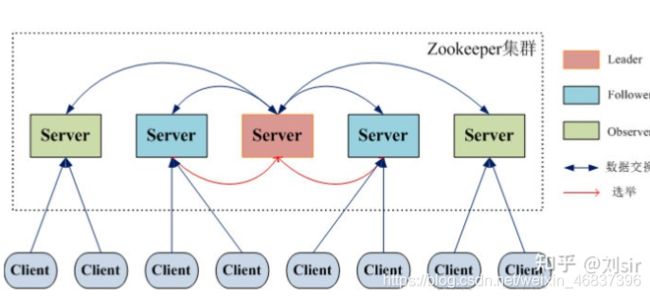

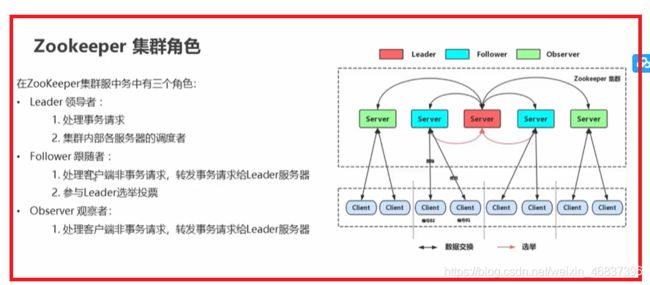

4、集群的角色

在zookeeper的集群中,各个节点共有下面3种角色和4种状态:

角色:leader,follower,observer 状态:leading,following,observing,looking

Zookeeper的核心是原子广播,这个机制保证了各个Server之间的同步。

实现这个机制的协议叫做Zab协议(ZooKeeper Atomic Broadcast protocol:原子广播协议)。

Zab协议有两种模式,它们分别是恢复模式(Recovery选主)和广播模式(Broadcast同步)。

当服务启动或者在领导者崩溃后,Zab就进入了恢复模式,当领导者被选举出来,且大多数Server完成了和leader的状态同步以后,恢复模式就结束了。

状态同步保证了leader和Server具有相同的系统状态。

为了保证事务的顺序一致性,zookeeper采用了递增的事务id号(zxid)来标识事务。所有的提议(proposal)都在被提出的时候加上了zxid。实现中zxid是一个64位的数字,它高32位是epoch用来标识leader关系是否改变,每次一个leader被选出来,它都会有一个新的epoch,标识当前属于那个leader的统治时期。低32位用于递增计数。

每个Server在工作过程中有4种状态:

LOOKING:当前Server不知道leader是谁,正在搜寻。

LEADING:当前Server即为选举出来的leader。

FOLLOWING:leader已经选举出来,当前Server与之同步。

OBSERVING:observer的行为在大多数情况下与follower完全一致,但是他们不参加选举和投票,而仅仅接受(observing)选举和投票的结果

Zookeeper节点部署越多,服务的可靠性越高,

建议部署奇数个节点,因为zookeeper集群是以宕机个数过半才会让整个集群宕机的。

了解(观察者节点)

加入观察者节点

具体可以参考: https://zookeeper.apache.org/doc/r3.4.14/zookeeperObservers.html

观察者节点为192.168.10.21,myid为21

#第一步,在观察者节点的配置文件中增加以下内容:

peerType=observer

# 第二步,在其它的节点上修改配置添加

server.21=192.168.10.21:6002:6003:observer