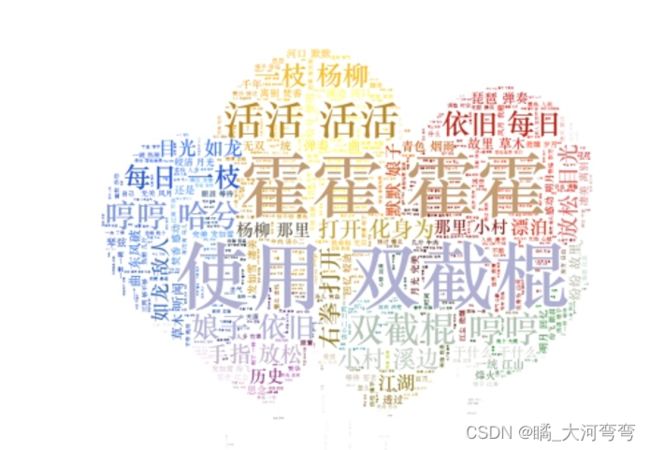

【jieba分词+wordcloud词云制作实战(附代码链接一键运行)】文本结巴分词去停用词后统计高频词并制作词云

【jieba分词+wordcloud词云制作实战(附代码链接一键运行)】文本结巴分词去停用词后统计高频词并制作词云

下载连接

下载连接

下载连接

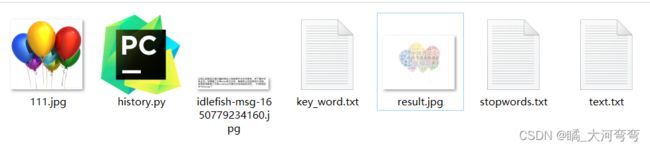

从网上获取自己感兴趣的党史人物故事作为文本素材,并下载中文停止词。利用第三方库jieba进行分词,剔除停止词后再统计词频,将高频词用第三方库wordcloud可视化为有特色的词云。

准备

1.停用词

2.找一个生成词云的模板

随便找一张图即可;

第一步 jieba分词

# jieba分词库分词

words = jieba.lcut(text.strip())

第二步 获取停用词

stopwords = [line.strip() for line in open('stopwords.txt', 'r', encoding='utf-8').readlines()]

第三步 统计词频

# 统计词频

for word in words:

if (len(word) == 1):

continue

else:

word_clear.append(word)

counts[word] = counts.get(word, 0) + 1