面向深度强化学习的策略迁移框架

点击蓝字

关注我们

AI TIME欢迎每一位AI爱好者的加入!

深度强化学习解决很多复杂问题的能力已经有目共睹,然而,如何提升其学习效率是目前面临的主要问题之一。现有的很多方法已验证迁移学习可利用相关任务中获得的先验知识来加快强化学习任务的学习效率。然而,这些方法需要明确计算任务之间的相似度,或者只能选择一个适合的源策略,并利用它提供针对目标任务的指导性探索。目前仍缺少如何不显式的计算策略间相似性,自适应的利用源策略中的先验知识的方法。

本文提出了一种通用的策略迁移框架(PTF),利用上述思想实现高效的强化学习。PTF通过将多策略迁移过程建模为选项(option)学习,option判断何时和哪种源策略最适合重用,何时终止该策略的重用。PTF可以自然地与现有的深度强化学习方法结合。实验结果表明,PTF在离散和连续动作空间中的学习效率和最终性能方面,都优于原始的强化学习方法,并超越了最新的策略迁移方法。

杨天培:天津大学智能与计算学部四年级博士生,导师是郝建业老师。主要研究领域包括利用迁移学习,层次强化学习,对手建模等促进深度强化学习和多智能体强化学习的效率和性能。目前已在IJCAI、AAAI、ICLR等会议发表论文10余篇。

一、背景知识

深度强化学习,目前已经在很多的游戏领域验证了它的学习性能和效果,但是目前还面临着采样低效性的问题,因此复杂的任务从头来学习一个策略是非常困难。

强化学习已被验证可有效地利用先验知识来辅助当前任务的学习。现有的强化学习领域,利用迁移来加速分为以下两个方向:

通过计算两个任务之间的相似性来进行迁移,包括 state的相似性或者是mdp的相似性。缺点是扩展性较低,无法直接应用在这种连续空间或者是比较大规模的状态空间问题上。

利用一个或者多个源策略来帮助当前任务进行探索。

本文主要关注在第二个方向上的研究工作

存在问题:

问题1:之前大部分方法只能在一个 episode的里面选择一个源策略来进行探索,无法从每个源策略中识别有用信息的组成部分。

问题2:考虑用多个源策略来进行探索,但这类工作对原任务和源策略有一些比较强烈的假设。

要求源策略在原始任务上的最优性;

要求人为添加原始策略到策略库里面;

导致无法直接应用在连续动作空间上。

因此,如何在不明确测量相似性的情况下,交替地利用来自适当来源策略的知识来直接优化目标策略?

二、研究动机

挑战1:对于每个源策略只有部分信息对于当前策略是有帮助的情况,该怎么样去解决?

■ 把多策略迁移问题建模为一个选项学习的问题,通过option来控制,复用源策略知识,控制开始终止的时刻。

挑战2:选择多个源策略来进行探索,需要有强有力的假设

■ 直接用知识来优化学习策略而不是直接把源策略里的知识来探索;

■ 在学习的过程中还通过权重来调整学习比例,这样可以有效的避免负迁移的出现。

挑战3:弱化先前工作的假设

■ 使用多源策略直接优化目标策略;

■ 易于与现有的DRL方法相结合;

■ 离散和连续动作空间上的验证效果良好。

三、模型与方法

(Policy Tranfer Framework)

◆ PTF包括agent模块和option模块;

◆ 给定 Пs = {π1,π2,…πn},O = {o1,o2,…on}

◆ Option模块将多策略转移建模为Option learning;

◆ Agent模块与环境交互,并根据自身的经验和来自选项模块的知识更新策略

PDF模型框架。

▷ 智能体(agent)模块

Agent模块负责与环境交互,并根据环境的经验和option的指导进行策略更新。

▷ option module更新

每个 source policy都定义一个option,n个source policy对应n个option;从初始化n个option中选出一个。

Option更新和决策过程:

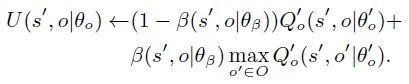

参照DQN的形式,学习option value,通过target network来计算 target value。

1. target value是通过计算option upon arrival的U函数,

U函数它是通过一个线性组合,结合当前 option下一个状态的 option value,以及终止之后,选择下一时刻 option value的最大值;

2. 计算 target value之后,通过 option loss更新option value network。

3. 同时隔一段时间将 option value network的参数复制target network之中。

使用ε-greedy的策略直到选项终止

更新终止网络的梯度

▷ 从选定的源策略迁移知识

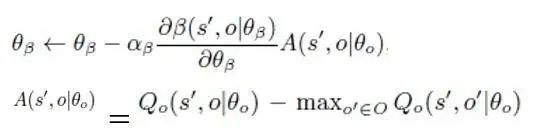

PTF将当前策略和所选选项内的策略之间的差异计算为补充损失。

通过模仿学习进行知识蒸馏

1. 对于基于策略的方法:

![]()

2. 对于基于值的方法:

3. 自适应加权因子:

四、实验与评估

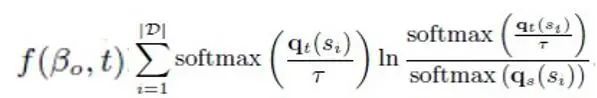

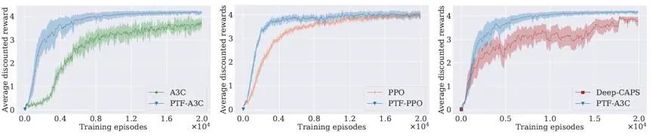

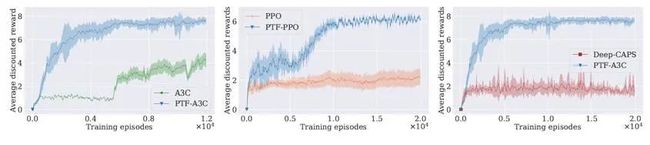

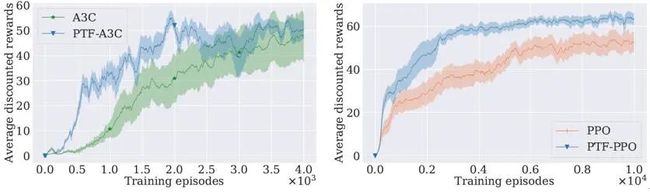

PTF框架和深度强化学习算法A3C和PPO结合的实验验证平台

实验场景:

◎ Grid world – 离散动作导航游戏

◎ Pinball – 连续动作导航游戏

◎ Reacher – 非导航环境

1. Grid world – 离散动作导航游戏

2. Pinball – 连续动作导航游戏

3. Reacher – 非导航环境

学习速度和表现高于原始算法及之前的策略迁移方法

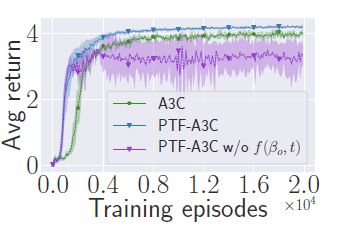

4. 验证

源政策不是最优时对策略学习的影响

验证自适应权重的影响

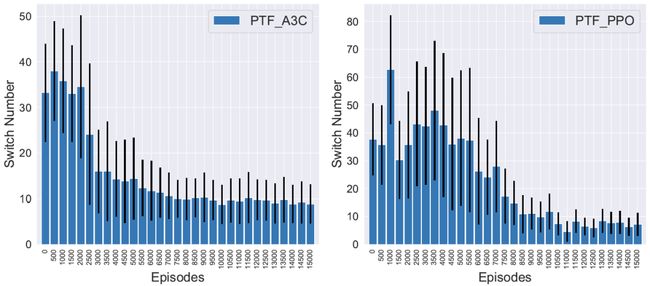

验证Option切换频率随时间的变化

五、总结与展望

总结:

● PTF模型多策略转移作为选项学习

1. 使用所传递的知识直接优化目标策略;

2. 提出了一种自适应、启发式的机制来避免负转移的出现;

3. 与现有的value-based和policy-based的深度强化学习的方法相结合。

● PTF显著提高了现有DRL方法的性能,在离散和连续的行动空间中优于最先进的策略转移方法。

展望:

● 如何学习抽象知识,以便在新的环境中快速适应?

例如策略表征、高层次技能和抽象策略。

● 如何将PTF扩展到多智能体系统?

1. 跨多智能体任务之间迁移知识;

2. 在同一个任务下,多个智能体之间迁移知识,以实现更有效的多智能体学习。

REF

论文链接:

https://arxiv.org/abs/2002.08037v2

视频链接:

https://www.bilibili.com/video/BV17v411s7K3

Tianjin University-Deep Reinforcement Learning Lab

http://www.icdai.org

E-mail:[email protected]

整理:唐家欣

审稿:杨天培

排版:岳白雪

AI TIME欢迎AI领域学者投稿,期待大家剖析学科历史发展和前沿技术。针对热门话题,我们将邀请专家一起论道。同时,我们也长期招募优质的撰稿人,顶级的平台需要顶级的你!

请将简历等信息发至[email protected]!

微信联系:AITIME_HY

AI TIME是清华大学计算机系一群关注人工智能发展,并有思想情怀的青年学者们创办的圈子,旨在发扬科学思辨精神,邀请各界人士对人工智能理论、算法、场景、应用的本质问题进行探索,加强思想碰撞,打造一个知识分享的聚集地。

更多资讯请扫码关注

(直播回放:https://b23.tv/KF3UZ1)

(点击“阅读原文”下载本次报告ppt)