爬虫基础了解

安装ipython

前提:已经安装Python环境

步骤:

1、win + R 输入cmd,进入命令行界面,输入:pip install ipython ,等待安装成功

2、进入ipython 运行环境: 在命令行界面输入:ipython

基础内容梳理

requests库

1、requests库的基础语法使用

作用:网络下载的库

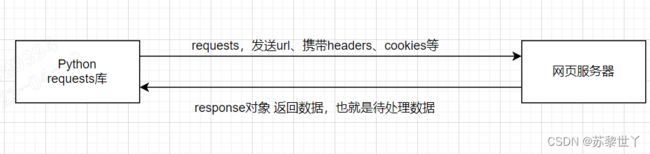

数据流转

用法

requests的两种方法:get和post方法 post方法一般用于表单

携带的元素

- url:目标网页的url

- params:设置参数;参数较少时可以拼接在url后面,较多时采用字典形式

- data:一般用于post提交数据,常用字典或者JSON字符串

- headers:用于模拟浏览器访问(有些网站会根据是否有headers来判断是否是爬虫);可以设置user-agent、refer等请求头

- timeout:超时时间,单位为秒;当浏览器超时时,设置之后,可以跳过阻塞的部分,继续执行后续的代码

- vertify:是否进行https证书验证,True/False,默认值为True,此时需要将证书下载到本地,使用变量指向证书地址;False会跳过证书验证(有些url是安全加密的HTTPS)

- allow-redirects:是否让requests进行重定向处理,应用场景:有些url仅进行跳转到其他url;True是指做重定向处理,获取跳转后的url的数据;False是指仅获取当前url的数据

- cookies:附带本地的cookies数据,应用场景:有些网站须登录,并且登录状态应用在不同的网页上,此时需要携带cookies;该cookies可能是response返回的cookies,也可能是重新组装后的cookies

response返回数据

通过:r = requests.get/post(url)

返回基础用法:

- r.status_code :返回状态码,200:请求成功

- r.encoding :编码方式:requests会自动推测编码方式,如果推测不到就会使用ISO-8859-1(国际编码)编码,但也可能会存在乱码;如果找不到可以手动查看charset

- r.text:返回内容,主要解析内容,一般解析成字符串,通常是HTML、JSON字符串

- r.headers:浏览器返回的headers,比如charset,r.encoding从这里推测编码方式

- r.url :浏览器返回的url,即编码后的url,可能会和我们传入的有所不同

- r.content:以字节的方式返回内容,应用场景:用于下载图片

- r.cookies:服务端返回的客户端的cookies,