【ElasticSearch】学习笔记(一)es的基本操作

【ElasticSearch】学习笔记(一)es的基本操作

文章目录

- 【ElasticSearch】学习笔记(一)es的基本操作

-

- 1. 基本概念

-

- 1.1 文档和字段

- 1.2 索引和映射

- 1.3 概念对比

- 1.4 分词器

- 1.5 mapping映射属性

- 2. 索引库的基本操作

-

- 2.1 创建索引库和映射

- 2.2 查询索引库

- 2.3 修改索引库

- 2.4 删除索引库

- 2.5 总结

- 3. 文档操作

-

- 3.1 新增文档

- 3.2 查询文档

-

- 3.2.1 查询所有文档

- 3.3 删除文档

- 3.3 修改文档

-

- 3.3.1 全量修改

- 3.3.2 增量修改

- 3.4 总结

- 4. RestAPI

-

- 4.1 准备工作

- 4.2 初始化RestClient

- 4.3 创建索引库

- 4.4 删除索引库

- 4.5 判断索引库是否存在

- 4.6 总结

- 5. RestClient操作文档

-

- 5.1 新增文档

- 5.2 查询文档

- 5.3 删除文档

- 5.4 修改文档

- 5.5 批量导入文档

- 5.6 总结

1. 基本概念

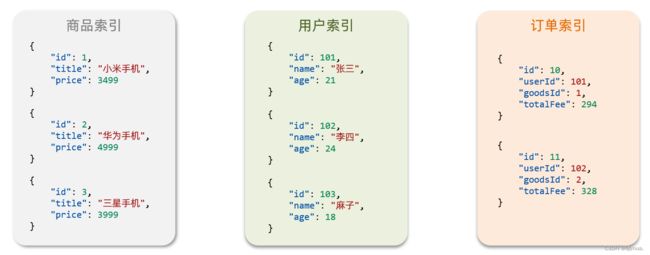

1.1 文档和字段

es是面向文档存储的,可以是数据库中的一条商品数据,一个订单信息。文档数据会被序列化为json格式后存储在es中。

Json文档中一般包含很多的字段,类似于数据库中的列。

1.2 索引和映射

索引:就是相同类型的文档的集合,类似与数据库中的表。

- 所有用户文档,就可以组织在一起,称为用户的索引;

- 所有商品的文档,可以组织在一起,称为商品的索引;

- 所有订单的文档,可以组织在一起,称为订单的索引;

映射:数据库的表会有约束信息,用来定义表的结构、字段的名称、类型等信息。因此,索引库中就有映射,是索引中文档的字段约束信息,类似表的结构约束。

1.3 概念对比

我们把mysql和es的概念做一下对比:

| MySQL | Elasticsearch | 说明 |

|---|---|---|

| Table | Index | 索引(index),就是文档的集合,类似数据库的表(table) |

| Row | Document | 文档(Document),就是一条条的数据,类似数据库中的行(Row),文档都是JSON格式 |

| Column | Field | 字段(Field),就是JSON文档中的字段,类似数据库中的列(Column) |

| Schema | Mapping | Mapping(映射)是索引中文档的约束,例如字段类型约束。类似数据库的表结构(Schema) |

| SQL | DSL | DSL是elasticsearch提供的JSON风格的请求语句,用来操作elasticsearch,实现CRUD |

es和mysql往往是相互补充的关系而不是相互替代的关系。

- mysql:擅长事务类型的操作,可以确保数据的安全性和一致性。

- es:擅长海量数据的搜索,分析,计算。

所以在企业中往往是两者结合使用:

- 对安全性要求较高的写操作,使用mysql实现

- 对查询性能要求较高的搜索需求,使用es实现

- 两者再基于某种方式,实现数据的同步,保证一致性

1.4 分词器

分词器的作用:

- 创建倒排索引时对文档分词

- 用户搜索时,对输入的内容分词

IK分词器(支持中文)有几种模式:

- ik_smart:智能切分,粗粒度

- ik_max_word:最细切分,细粒度

IK分词器拓展词条和停用词条:

- 在ik文件夹的config目录的

IKAnalyzer.xml文件中添加拓展词典和停用词典 - 在词典中添加拓展词条或停用词条

1.5 mapping映射属性

映射是对索引库中文档的约束,常见的映射属性如下所示:

- type:字段数据类型,常见的简单类型有:

- 字符串:text(可分词的文本)、keyword(精确值,例如:品牌、过假、IP地址)

- 数值:long、integer、short、byte、double、float

- 布尔:boolean

- 日期:date

- 对象:object

- index:是否创建索引,默认为true

- analyzer:使用哪种分词器

- properties:该字段的子字段

例如下面的json文档:

{

"age": 21,

"weight": 52.1,

"isMarried": false,

"info": "黑马程序员Java讲师",

"email": "[email protected]",

"score": [99.1, 99.5, 98.9],

"name": {

"firstName": "云",

"lastName": "赵"

}

}

对应的每个字段映射(mapping):

- age:类型为 integer;参与搜索,因此需要index为true;无需分词器

- weight:类型为float;参与搜索,因此需要index为true;无需分词器

- isMarried:类型为boolean;参与搜索,因此需要index为true;无需分词器

- info:类型为字符串,需要分词,因此是text;参与搜索,因此需要index为true;分词器可以用ik_smart

- email:类型为字符串,但是不需要分词,因此是keyword;不参与搜索,因此需要index为false;无需分词器

- score:虽然是数组,但是我们只看元素的类型,类型为float;参与搜索,因此需要index为true;无需分词器

- name:类型为object,需要定义多个子属性

- name.firstName;类型为字符串,但是不需要分词,因此是keyword;参与搜索,因此需要index为true;无需分词器

- name.lastName;类型为字符串,但是不需要分词,因此是keyword;参与搜索,因此需要index为true;无需分词器

2. 索引库的基本操作

采用DSL演示

2.1 创建索引库和映射

基本语法:

- 请求方式:PUT

- 请求路径:/索引库名(可自定义)

- 请求参数:mapping映射

格式:

PUT /索引库名称

{

"mappings": {

"properties": {

"字段名":{

"type": "text",

"analyzer": "ik_smart"

},

"字段名2":{

"type": "keyword",

"index": "false"

},

"字段名3":{

"properties": {

"子字段": {

"type": "keyword"

}

}

},

// ...略

}

}

}

实例:

#创建索引库

PUT /heima

{

"mappings": {

"properties": {

"info":{

"type": "text",

"analyzer": "ik_smart"

},

"email":{

"type": "keyword",

"index": false

},

"name":{

"type": "object",

"properties": {

"firstName":{

"type": "keyword"

},

"lastName":{

"type": "keyword"

}

}

}

}

}

}

2.2 查询索引库

基本语法:

- 请求方式:GET

- 请求路径:/索引库名

- 请求参数:无

格式:

GET /索引库名

示例:

#查询

GET /heima

2.3 修改索引库

倒排索引结构虽然不复杂,但是数据结构一旦改变(比如改变了分词器),就需要重新创建倒排索引,这简直是灾难。因此索引库一般创建就无法修改mapping。

虽然无法修改mapping中已有的字段,但是却可以添加新的字段到mapping中,因为这不会对倒排索引产生影响。

所以“修改索引库”实际上就是为索引库添加新字段。

基本语法:

- 请求方式:PUT

- 请求路径:/索引库名/_mapping

- 请求参数:有

格式即示例:

#修改(添加新字段)

put /heima/_mapping

{

"properties": {

"age":{

"type":"integer"

}

}

}

2.4 删除索引库

基本语法:

- 请求方式:DELETE

- 请求路径:/索引库名

- 请求参数:无

格式即示例:

#删除

DELETE /heima

2.5 总结

对索引库的操作:

- 创建索引库:PUT /索引库名

- 查询索引库:GET /索引库名

- 删除索引库:DELETE /索引库名

- 修改索引库(添加新字段):PUT /索引库名/_mapping

3. 文档操作

3.1 新增文档

语法:

POST /索引库名/_doc/文档id

{

"字段1": "值1",

"字段2": "值2",

"字段3": {

"子属性1": "值3",

"子属性2": "值4"

},

// ...

}

示例:

#新增文档

POST /heima/_doc/1

{

"info": "第一,绝不意气用事",

"email": "[email protected]",

"name": {

"firstName": "hj",

"lastName": "z"

}

}

3.2 查询文档

语法:

GET /索引库名/_doc/id

示例:

#查询

GET /heima/_doc/1

3.2.1 查询所有文档

语法:

GET /索引库名/_search

3.3 删除文档

语法:

DELETE /索引库名/_doc/id

示例:

#删除

DELETE /heima/_doc/1

3.3 修改文档

3.3.1 全量修改

**全量修改:**全量修改是直接覆盖原来的文档。

本质:

- 根据指定的id先删除文档

- 再新增一个相同id的文档

**注意:**如果根据id删除时,id不存在,第二步的新增操作依旧会执行,也就从修改变成了新增能操作。

简单来说就是“有则改之无则添加”。

语法:

PUT /索引库名/_doc/id

{

"字段1": "值1",

"字段2": "值2",

// ... 略

}

示例:

#全量修改文档

PUT /heima/_doc/1

{

"info": "第二,绝不漏判任何一件坏事",

"email": "[email protected]",

"name": {

"firstName": "hj",

"lastName": "z"

}

}

3.3.2 增量修改

**增量修改:**执行该指定id匹配的文档中的部分字段。

语法:

POST /索引库名/_update/id

{

"doc": {

"字段名": "新的值",

}

}

示例:

#局部修改文档字段

POST /heima/_update/1

{

"doc": {

"email": "[email protected]"

}

}

3.4 总结

文档操作:

- 创建文档:POST /索引库名/_doc/id { json文档 }

- 查询文档:GET /索引库名/_doc/id

- 删除文档:DELETE /索引库名/_doc/id

- 修改文档:

- 全量修改:PUT /索引库名/_doc/文档id { json文档 }

- 增量修改:POST /索引库名/_update/id { “doc”: {字段}}

4. RestAPI

4.1 准备工作

创建索引库,最关键的就是mapping映射,而mapping映射要考虑的信息包括:

- 字段名

- 字段数据类型

- 是否参与搜索

- 是否需要分词

- 如果分词,分词器是什么?

其中:

- 字段名、字段数据类型,可以参考数据表结构的名称和类型

- 是否参与搜索要分析业务来判断,例如图片地址,就无需参与搜索

- 是否分词呢要看内容,内容如果是一个整体就无需分词,反之则要分词

- 分词器,我们可以统一使用ik_max_word

来看下酒店数据的索引库结构:

PUT /hotel

{

"mappings": {

"properties": {

"id": {

"type": "keyword"

},

"name":{

"type": "text",

"analyzer": "ik_max_word",

"copy_to": "all"

},

"address":{

"type": "keyword",

"index": false

},

"price":{

"type": "integer"

},

"score":{

"type": "integer"

},

"brand":{

"type": "keyword",

"copy_to": "all"

},

"city":{

"type": "keyword",

"copy_to": "all"

},

"starName":{

"type": "keyword"

},

"business":{

"type": "keyword"

},

"location":{

"type": "geo_point"

},

"pic":{

"type": "keyword",

"index": false

},

"all":{

"type": "text",

"analyzer": "ik_max_word"

}

}

}

}

几个特殊字段说明:

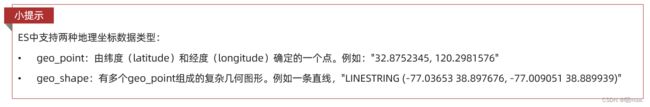

- location:地理坐标,里面包含精度、纬度

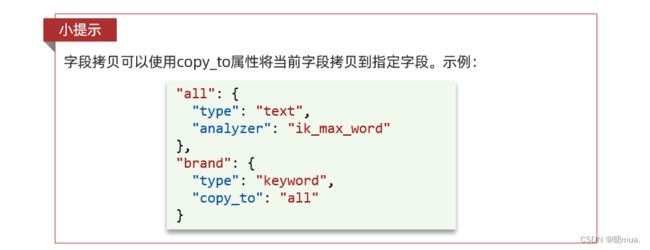

- all:一个组合字段,其目的是将多字段的值 利用copy_to合并,提供给用户搜索

地理坐标说明:

copy_to说明:

4.2 初始化RestClient

1)引入es的RestHighLevelClient依赖:

由于SpringBoot默认的es版本是7.6.2,所以我们需要覆盖的es版本:

<dependency>

<groupId>org.elasticsearch.clientgroupId>

<artifactId>elasticsearch-rest-high-level-clientartifactId>

<version>7.12.1version>

dependency>

2)初始化RestHighLevelClient:

编写测试方法,测试连接是否成功:

public class HotelIndexTest {

private RestHighLevelClient client;

@Test

void testInit() {

System.out.println(client);

}

@BeforeEach

void setUp() {

this.client=new RestHighLevelClient(RestClient.builder(

HttpHost.create("http://127.0.0.1:9200")

));

}

@AfterEach

void tearDown() throws IOException {

this.client.close();

}

}

4.3 创建索引库

创建索引库的API如下:

代码分为三步:

- 1)创建Request对象。因为是创建索引库的操作,因此Request是CreateIndexRequest。

- 2)添加请求参数,其实就是DSL的JSON参数部分。因为json字符串很长,这里是定义了静态字符串常量MAPPING_TEMPLATE,让代码看起来更加优雅。

- 3)发送请求,client.indices()方法的返回值是IndicesClient类型,封装了所有与索引库操作有关的方法。

示例:

在常量类中定义一个dsl语句:

public class HotelConstants {

public static final String MAPPING_TEMPLATE="{\n" +

" \"mappings\": {\n" +

" \"properties\": {\n" +

" \"id\": {\n" +

" \"type\": \"keyword\"\n" +

" },\n" +

" \"name\":{\n" +

" \"type\": \"text\",\n" +

" \"analyzer\": \"ik_max_word\",\n" +

" \"copy_to\": \"all\"\n" +

" },\n" +

" \"address\":{\n" +

" \"type\": \"keyword\",\n" +

" \"index\": false\n" +

" },\n" +

" \"price\":{\n" +

" \"type\": \"integer\"\n" +

" },\n" +

" \"score\":{\n" +

" \"type\": \"integer\"\n" +

" },\n" +

" \"brand\":{\n" +

" \"type\": \"keyword\",\n" +

" \"copy_to\": \"all\"\n" +

" },\n" +

" \"city\":{\n" +

" \"type\": \"keyword\",\n" +

" \"copy_to\": \"all\"\n" +

" },\n" +

" \"starName\":{\n" +

" \"type\": \"keyword\"\n" +

" },\n" +

" \"business\":{\n" +

" \"type\": \"keyword\"\n" +

" },\n" +

" \"location\":{\n" +

" \"type\": \"geo_point\"\n" +

" },\n" +

" \"pic\":{\n" +

" \"type\": \"keyword\",\n" +

" \"index\": false\n" +

" },\n" +

" \"all\":{\n" +

" \"type\": \"text\",\n" +

" \"analyzer\": \"ik_max_word\"\n" +

" }\n" +

" }\n" +

" }\n" +

"}";

}

然后在测试类中编写测试方法,实现创建索引的操作:

@Test

void createHotelIndex() throws IOException {

//1.创建Request对象

CreateIndexRequest request = new CreateIndexRequest("hotel");

//2.准备请求的参数:DSL语句

request.source(MAPPING_TEMPLATE, XContentType.JSON);

//3.发送请求

client.indices().create(request, RequestOptions.DEFAULT);

}

4.4 删除索引库

与创建索引库相比:

- 请求方式从PUT变为DELETE

- 请求路径不变

- 无请求参数

删除代码主要体现在Request对象上:

- 创建request对象,这次是DeleteIndexRequest对象

- 准备参数。这里是无参

- 发送请求,改用delete方法

编写测试方法,删除索引库:

//删除索引库

@Test

void testDeleteHotelIndex() throws IOException {

//1.创建Request对象

DeleteIndexRequest request = new DeleteIndexRequest("hotel");

//2.发送请求

client.indices().delete(request, RequestOptions.DEFAULT);

}

4.5 判断索引库是否存在

判断索引库是否存在本质上就是查询操作。

因此与删除的Java代码流程是类似的。依然是三步走:

- 1)创建Request对象。这次是GetIndexRequest对象

- 2)准备参数。这里是无参

- 3)发送请求。改用exists方法

代码如下:

//判断索引库是否存在

@Test

void testExistHotelIndex() throws IOException {

//1.创建Request对象

GetIndexRequest request = new GetIndexRequest("hotel");

//2.发送请求

boolean exists = client.indices().exists(request, RequestOptions.DEFAULT);

//3.输出

System.out.println(exists ? "存在" : "不存在");

}

4.6 总结

JavaRestClient操作elasticsearch的流程基本类似。核心是client.indices()方法来获取索引库的操作对象。

索引库操作的基本步骤:

- 初始化RestHighLevelClient

- 创建XxxIndexRequest。XXX是Create、Get、Delete

- 准备DSL( Create时需要,其它是无参)

- 发送请求。调用RestHighLevelClient#indices().xxx()方法,xxx是create、exists、delete

5. RestClient操作文档

5.1 新增文档

需求:

将数据库中的酒店信息查询出来写入es中。

思路:

我们导入酒店数据,基本流程一致,但是需要考虑几点变化:

- 酒店数据来自于数据库,我们需要先查询出来,得到hotel对象

- hotel对象需要转为HotelDoc对象

- HotelDoc需要序列化为json格式

因此,代码整体步骤如下:

- 1)根据id查询酒店数据Hotel

- 2)将Hotel封装为HotelDoc

- 3)将HotelDoc序列化为JSON

- 4)创建IndexRequest,指定索引库名和id

- 5)准备请求参数,也就是JSON文档

- 6)发送请求

实现:

在测试类中编写一个测试方法:

@Test

void testAddDocument() throws IOException {

//根据id查询酒店数据

Hotel hotel = hotelService.getById(36934l);

//转换为文档类型

HotelDoc hotelDoc = new HotelDoc(hotel);

//1.准备Request对象

IndexRequest request = new IndexRequest("hotel").id(hotel.getId().toString());

//2.准备Json文档

request.source(JSON.toJSONString(hotelDoc), XContentType.JSON);

//3.发送请求

client.index(request, RequestOptions.DEFAULT);

}

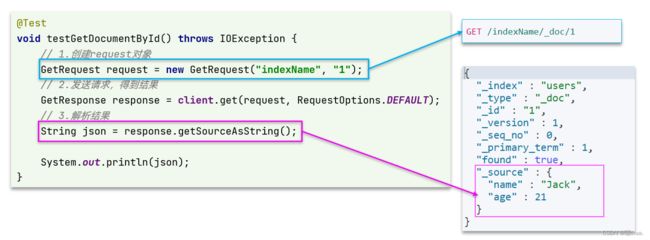

5.2 查询文档

与之前类似,也是三步走:

- 准备Request对象。这次是查询,所以是GetRequest

- 发送请求,得到结果。因为是查询,这里调用client.get()方法

- 解析结果,就是对JSON做反序列化

//查询文档

@Test

void testGetDocumentById() throws IOException {

//1.准备Request对象

GetRequest request = new GetRequest("hotel", "36934");

//2.发送请求

GetResponse response = client.get(request, RequestOptions.DEFAULT);

//3.解析结果

String json = response.getSourceAsString();

HotelDoc hotelDoc = JSON.parseObject(json, HotelDoc.class);

System.out.println(hotelDoc);

}

5.3 删除文档

与查询相比,删除操作仅仅是请求方式从GET变成DELETE,可以想象Java代码应该依然是三步走:

- 1)准备Request对象,因为是删除,这次是DeleteRequest对象。要指定索引库名和id

- 2)准备参数,无参

- 3)发送请求。因为是删除,所以是client.delete()方法

在测试类中编写一个测试方法:

//删除文档

@Test

void testDeleteDocument() throws IOException {

//1.准备request

DeleteRequest request = new DeleteRequest("hotel", "36934");

//2.发送请求

client.delete(request,RequestOptions.DEFAULT);

}

5.4 修改文档

在RestClient的API中,全量修改和新增的API完全一致,判断依据是id:

- 如果新增时,id已经存在,则修改

- 如果新增时,id不存在,则新增

所以这里的修改操作只有增量修改。

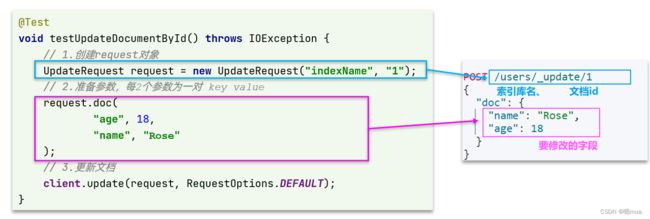

代码示例如下图:

与之前类似,也是三步走:

- 1)准备Request对象。这次是修改,所以是UpdateRequest

- 2)准备参数。也就是JSON文档,里面包含要修改的字段

- 3)更新文档。这里调用client.update()方法

在测试类中编写测试方法:

//修改文档

@Test

void testUpdateDocument() throws IOException {

//1.准备Request

UpdateRequest request = new UpdateRequest("hotel", "36934");

//2.准备请求参数

request.doc(

"price","350",

"starName","三钻"

);

//3.发送请求

client.update(request,RequestOptions.DEFAULT);

}

5.5 批量导入文档

需求:

将所有的酒店数据导入到索引库中。

思路:

-

利用mybatis-plus查询酒店数据

-

将查询到的酒店数据(Hotel)转换为文档类型数据(HotelDoc)

-

利用JavaRestClient中的BulkRequest批处理,实现批量新增文档

批量处理的本质就是将多个普通的crud请求组合在一起发送。

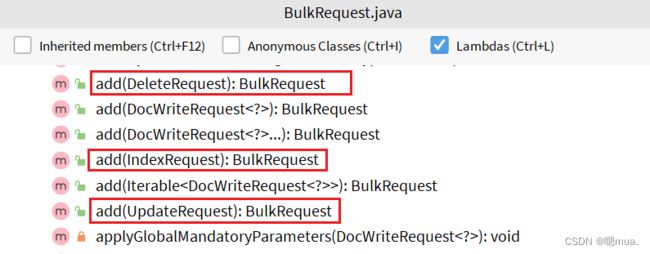

其中提供了一个add方法,用来添加其他请求:

可以看到,能添加的请求包括:

- IndexRequest,也就是新增

- UpdateRequest,也就是修改

- DeleteRequest,也就是删除

所以Bulk中添加了多个IndexRequest,就是批量新增功能了。示例图如下:

在测试类中编写测试方法,代码示例如下:

//批量导入文档

@Test

void testBulkRequest() throws IOException {

//批量查询酒店数据

List<Hotel> hotels = hotelService.list();

//1.创建Request

BulkRequest request = new BulkRequest();

//2.准备参数,添加多个新增的request

for (Hotel hotel : hotels) {

HotelDoc hotelDoc = new HotelDoc(hotel);

request.add(new IndexRequest("hotel")

.id(hotelDoc.getId().toString())

.source(JSON.toJSONString(hotelDoc), XContentType.JSON));

}

//3.发送请求

client.bulk(request, RequestOptions.DEFAULT);

}

5.6 总结

文档操作的基本步骤:

- 初始化RestHighLevelClient

- 创建XxxRequest。XXX是Index、Get、Update、Delete、Bulk

- 准备参数(Index、Update、Bulk时需要)

- 发送请求。调用RestHighLevelClient#.xxx()方法,xxx是index、get、update、delete、bulk

- 解析结果(Get时需要)

文档操作和索引库操作的区别:

- 文档操作的Request为XXXRequest,而索引库操作的是XXXIndexRequest

- 文档操作发送请求直接是

client.xxx(),而索引库操作的是client.indices().xxx()