python文献检索工具与技巧答案_短文本分析----基于python的TF-IDF特征词标签自动化提取...

绪论

最近做课题,需要分析短文本的标签,在短时间内学习了自然语言处理,社会标签推荐等非常时髦的技术。我们的需求非常类似于从大量短文本中获取关键词(融合社会标签和时间属性)进行用户画像。这一切的基础就是特征词提取技术了,本文主要围绕关键词提取这个主题进行介绍(英文)。

不同版本python混用(官方用法)

Python2 和python3 是一个神一般的存在,如何让他们共存呢,直到我用了pycharm我才知道为啥这么多人选择它,如下图所示配置两个目录直接可以混用了,叼炸天。

插播一个广告,想修改pycharm中python注释的颜色找了半天居然得这么搞:

当大家搜索如何在系统中混合使用python2和python3,国内网站经常会让大家把其中一个python.exe改个名字,这样区分开两个可执行文件的名字,但是这样做有一个重大的隐患,就是修改了名字的那个python对应的pip将无法使用。有时候还是需要用用命令行的,怎么办?

官方用法为:

在安装Python3(>=3.3)时,Python的安装包实际上在系统中安装了一个启动器py.exe,默认放置在文件夹C:\Windows\下面。这个启动器允许我们指定使用Python2还是Python3来运行代码(当然前提是你已经成功安装了Python2和Python3)。

如果你有一个Python文件叫 hello.py,那么你可以这样用Python2运行它

py -2 hello.py

类似的,如果你想用Python3运行它,就这样

py -3 hello.py

去掉参数 -2/-3

每次运行都要加入参数-2/-3还是比较麻烦,所以py.exe这个启动器允许你在代码中加入说明,表明这个文件应该是由python2解释运行,还是由python3解释运行。说明的方法是在代码文件的最开始加入一行

#! python2

或者

#! python3

分别表示该代码文件使用Python2或者Python3解释运行。这样,运行的时候你的命令就可以简化为

py hello.py

使用pip

当Python2和Python3同时存在于windows上时,它们对应的pip都叫pip.exe,所以不能够直接使用 pip install 命令来安装软件包。而是要使用启动器py.exe来指定pip的版本。命令如下:

py -2 -m pip install XXXX

-2 还是表示使用 Python2,-m pip 表示运行 pip 模块,也就是运行pip命令了。如果是为Python3安装软件,那么命令类似的变成

py -3 -m pip install XXXX

#! python2 和 # coding: utf-8 哪个写在前面?

对于Python2用户还有另外一个困惑,Python2要在代码文件顶部增加一行说明,才能够在代码中使用中文。如果指明使用的Python版本也需要在文件顶部增加一行,那哪一行应该放在第一行呢?

#! python2 需要放在第一行,编码说明可以放在第二行。所以文件开头应该类似于:

#!python2

# coding: utf-8

有了这些技巧,Python2和Python3就可以愉快地在一起玩耍了~

Python标准:https://www.python.org/dev/peps/pep-0397/

信息检索概述

信息检索是当前应用十分广泛的一种技术,论文检索、搜索引擎都属于信息检索的范畴。通常,人们把信息检索问题抽象为:在文档集合D上,对于由关键词w[1] … w[k]组成的查询串q,返回一个按查询q和文档d匹配度 relevance (q, d)排序的相关文档列表D。

对于这一基问题,先后出现了布尔模型、向量模型等各种经典的信息检索模型,它们从不同的角度提出了自己的一套解决方案。

布尔模型以集合的布尔运算为基础,查询效率高,但模型过于简单,无法有效地对不同文档进行排序,查询效果不佳。

向量模型把文档和查询串都视为词所构成的多维向量,而文档与查询的相关性即对应于向量间的夹角。不过,由于通常词的数量巨大,向量维度非常高,而大量的维度都是0,计算向量夹角的效果并不好。另外,庞大的计算量也使得向量模型几乎不具有在互联网搜索引擎这样海量数据集上实施的可行性。

TF-IDF原理概述

如何衡量一个特征词在文本中的代表性呢?以往就是通过词出现的频率,简单统计一下,从高到低,结果发现了一堆的地得,和英文的介词in of with等等,于是TF-IDF应运而生。

TF-IDF不但考虑了一个词出现的频率TF,也考虑了这个词在其他文档中不出现的逆频率IDF,很好的表现出了特征词的区分度,是信息检索领域中广泛使用的一种检索方法。

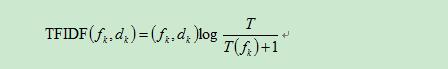

Tf-idf算法公式以及说明:

具体实现如下所示,公式分成两项,词频*逆词频,逆词频取log值。

注意分母中的+1,在很多文献中并没有出现,这个可能引发异常。

本人写了一份代码近期正在修改,后续传到github 上,再贴出来。文章末尾贴出了两份我认为比较好的代码,一份是面向对象的实现一份是分布式的。

tfidf源代码实现及相关博客资料:

python scikit-learn计算tf-idf词语权重(scikit-learn包中提供了tfidf的矩阵实现,缺点是词数量过大可能溢出)

http://www.tuicool.com/articles/U3uiiu

参考文献

github代码:

本文同步分享在 博客“shiter”(CSDN)。

如有侵权,请联系 [email protected] 删除。

本文参与“OSC源创计划”,欢迎正在阅读的你也加入,一起分享。