时间序列 | MATLAB实现CNN-LSTM-Attention时间序列预测

时间序列 | MATLAB实现CNN-LSTM-Attention时间序列预测

目录

-

- 时间序列 | MATLAB实现CNN-LSTM-Attention时间序列预测

-

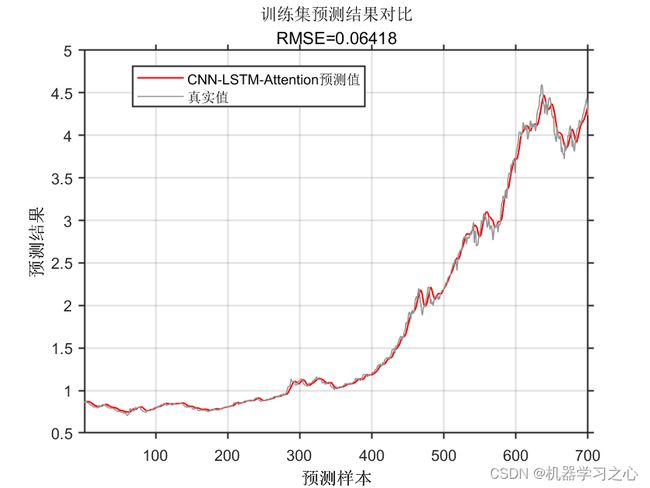

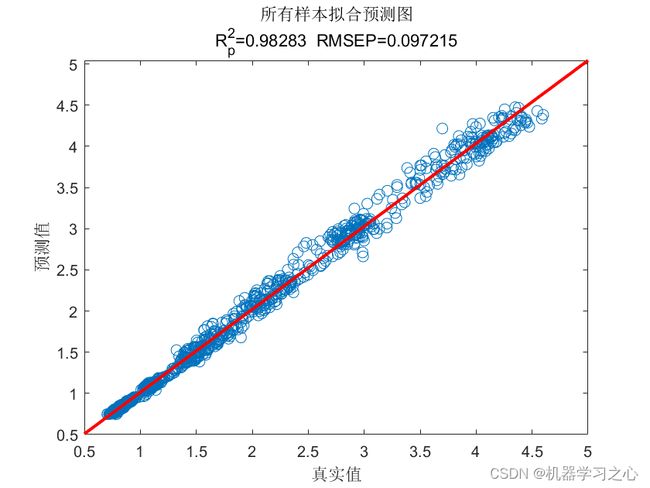

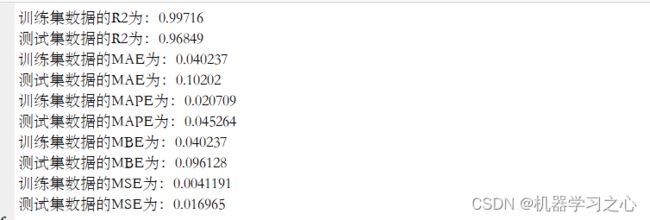

- 预测效果

- 基本介绍

- 模型描述

- 程序设计

- 参考资料

预测效果

基本介绍

MATLAB实现CNN-LSTM-Attention时间序列预测,CNN-LSTM结合注意力机制时间序列预测。

模型描述

Matlab实现CNN-LSTM-Attention多变量时间序列预测

1.data为数据集,格式为excel,单变量时间序列预测,输入为一维时间序列数据集;

2.CNN_LSTM_AttentionTS.m为主程序文件,运行即可;

3.命令窗口输出R2、MAE、MAPE、MSE和MBE,可在下载区获取数据和程序内容;

注意程序和数据放在一个文件夹,运行环境为Matlab2020b及以上。

4.注意力机制模块:

SEBlock(Squeeze-and-Excitation Block)是一种聚焦于通道维度而提出一种新的结构单元,为模型添加了通道注意力机制,该机制通过添加各个特征通道的重要程度的权重,针对不同的任务增强或者抑制对应的通道,以此来提取有用的特征。该模块的内部操作流程如图,总体分为三步:首先是Squeeze 压缩操作,对空间维度的特征进行压缩,保持特征通道数量不变。融合全局信息即全局池化,并将每个二维特征通道转换为实数。实数计算公式如公式所示。该实数由k个通道得到的特征之和除以空间维度的值而得,空间维数为H*W。其次是Excitation激励操作,它由两层全连接层和Sigmoid函数组成。如公式所示,s为激励操作的输出,σ为激活函数sigmoid,W2和W1分别是两个完全连接层的相应参数,δ是激活函数ReLU,对特征先降维再升维。最后是Reweight操作,对之前的输入特征进行逐通道加权,完成原始特征在各通道上的重新分配。

![]()

![]()

程序设计

- 完整程序和数据获取方式1:同等价值程序兑换;

- 完整程序和数据获取方式2:私信博主获取。

% CNN特征提取

convolution2dLayer(FiltZise,32,'Padding','same','WeightsInitializer','he','Name','conv','DilationFactor',1);

batchNormalizationLayer('Name','bn')

eluLayer('Name','elu')

averagePooling2dLayer(1,'Stride',FiltZise,'Name','pool1')

% 展开层

sequenceUnfoldingLayer('Name','unfold')

% 平滑层

flattenLayer('Name','flatten')

% LSTM特征学习

lstmLayer(128,'Name','lstm1','RecurrentWeightsInitializer','He','InputWeightsInitializer','He')

dropoutLayer(0.25,'Name','drop1')

% LSTM输出

lstmLayer(32,'OutputMode',"last",'Name','bil4','RecurrentWeightsInitializer','He','InputWeightsInitializer','He')

dropoutLayer(0.25,'Name','drop2')

% 全连接层

fullyConnectedLayer(numResponses,'Name','fc')

regressionLayer('Name','output') ];

layers = layerGraph(layers);

layers = connectLayers(layers,'fold/miniBatchSize','unfold/miniBatchSize');

%% 训练选项

if gpuDeviceCount>0

mydevice = 'gpu';

else

mydevice = 'cpu';

end

options = trainingOptions('adam', ...

'MaxEpochs',MaxEpochs, ...

'MiniBatchSize',MiniBatchSize, ...

'GradientThreshold',1, ...

'InitialLearnRate',learningrate, ...

'LearnRateSchedule','piecewise', ...

'LearnRateDropPeriod',56, ...

'LearnRateDropFactor',0.25, ...

'L2Regularization',1e-3,...

'GradientDecayFactor',0.95,...

'Verbose',false, ...

'Shuffle',"every-epoch",...

'ExecutionEnvironment',mydevice,...

'Plots','training-progress');

%% 模型训练

rng(0);

net = trainNetwork(XrTrain,YrTrain,layers,options);

%% 测试数据预测

% 测试集预测

————————————————

版权声明:本文为CSDN博主「机器学习之心」的原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接及本声明。

参考资料

[1] http://t.csdn.cn/pCWSp

[2] https://download.csdn.net/download/kjm13182345320/87568090?spm=1001.2014.3001.5501

[3] https://blog.csdn.net/kjm13182345320/article/details/129433463?spm=1001.2014.3001.5501