【Hadoop-HDFS】HDFS的读写流程 & SNN的数据写入流程

【Hadoop-HDFS】HDFS的读写流程 & SNN的数据写入流程

- 1)HDFS的数据写入流程

- 2)HDFS的数据读取流程

- 3)SNN的数据写入的流程

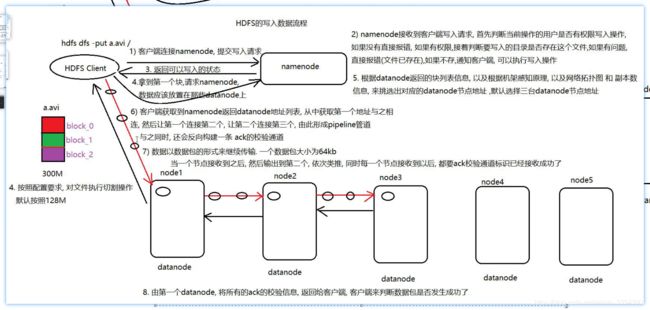

1)HDFS的数据写入流程

(1)客户端发送写入请求给 namenode。

(2)namenode 接收到请求,然后首先判断当前操作的用户是否具有写入的权限,如果没有直接报错,如果有权限,接着判断要写入的数据目录下是否存在这个文件,如果存在直接报错,如果不存在,此时就会给客户端返回可以写入的状态。

(3)当客户端获取可以写入的状态后,开始对文件执行切割操作,默认情况下会按照 128M 方式来切割文件。

(4)客户端拿着第一个 block 再次请求 namenode,让 namenode 为这个 blcok 分配 datanode 地址列表。

(5)namenode 会根据 datanode 的块信息、以及根据机架感知原理、网络拓扑关系和副本信息来挑选出最合适的 datanode 地址,将这些地址按照由近到远的顺序放置到列表中返回客户端。

(6)客户端根据列表中第一个地址连接指定的 datanode,然后由这个 datanode 连接下一次,然后由下一个连接下一个依次类推,由此形成一个 pipeline 的管道 ,同时反向还会形成一条 ack 的校验管道。

(7)客户端开始写入,数据以数据包的形成进行传输,一个数据包为 64kb,当第一个 datanode 接收到,接着传输给下一个,依次类推;同时,每一个接收到数据后,都要在ack校验通道中进行记录。

(8)第一个 datanode,将 ack 中校验信息收集起来,统计发送给客户端,由客户端校验此数据包是否全部都接收到了。

(9)客户端一次次的开始传输,一次次进行校验,直到将第一个 block 传输完成,接下来拿的第二个 block 再次请求 namenode,获取 block 要存储在那些 datanode 上,接下来执行第 6~8,直到将所有的 block 传输完成,到此写入流程结束了。

2)HDFS的数据读取流程

(1)客户端发起数据读取的请求。

(2)namenode 接收到数据读取的请求, 首先判断要读取的文件是否存在, 如果不存在直接报错, 如果存在, 接着会判断当前操作的用户是否具备读取数据的权限, 如果没有直接报错, 如果有权限, namenode 会根据 block 信息, 机架感知原理, 网络拓扑关系, 副本信息 ,本地原则, 返回这个文件部分或者全部的 block 的地址。

(3)客户端拿到 block 部分或者全部地址, 接下来, 采用并行读取策略, 将block数据全部读取到客户端。

(4)如果 namenode 之前返回的部分的 block 地址, 此时客户端接着再次请求 namenode, 获取下一批的 block 地址,执行第四步,以此类推, 直到将所有的 block 全部的读取到客户端。

(5)客户端将读取到 block 数据按照顺序依次拼接,形成最终的文件返回给用户。

3)SNN的数据写入的流程

(1)通知 namenode 将 hdfs 更新记录写入一个新的文件——edits.new。

(2)将 fsimage 和 editlog 通过 http 协议发送至 secondary namenode。

(3)将 fsimage 与 editlog 合并,生成一个新的文件——fsimage.ckpt(这步之所以要在 secondary namenode 中进行,是因为比较耗时,如果在 namenode 中进行,或导致整个系统卡顿)

(4)将生成的 fsimage.ckpt 通过 http 协议发送至 namenode。

(5)重命名 fsimage.ckpt 为 fsimage,edits.new 为 edits。

(6)等待下一次 checkpoint 触发 SecondaryNameNode 进行工作,一直这样循环操作。