9.2 回归分析

学习目标:

回归分析是一种广泛应用于数据分析和预测的统计方法,可以用来探索自变量与因变量之间的关系并进行预测。我学习回归分析,我会采取以下步骤:

-

学习基本概念:回归分析中的基本概念包括自变量和因变量、回归系数、截距、残差等。我会花时间理解这些概念的含义和作用,以便更好地理解回归分析的原理和应用。

-

选择合适的回归模型:回归分析有许多不同的模型,如线性回归、多项式回归、逻辑回归等等。我会学习各种模型的优缺点以及何时应该选择哪种模型。

-

数据收集和清理:回归分析的结果受到数据质量的影响,所以我会花时间收集高质量的数据,并对数据进行清理和处理,例如删除异常值、填充缺失值等。

-

模型拟合和评估:拟合回归模型是回归分析的核心部分。我会使用统计软件拟合模型,并使用统计指标和图形来评估模型的拟合质量和可靠性。

-

模型应用和解释:一旦我拟合了回归模型,我会使用模型来预测未来值或解释自变量与因变量之间的关系。我会学习如何解释模型参数,如何进行因果推断等等。

-

进一步学习:回归分析是一个庞大而复杂的领域,我可能只是入门。我会继续学习高级回归技术,如岭回归、lasso回归、深度学习等,以拓展我的技能和知识。

解析:

一元线性回归分析是一种常用的统计方法,用于分析两个连续变量之间的关系,其中一个变量是自变量,另一个变量是因变量。它建立在以下假设的基础上:自变量和因变量之间存在一个线性关系,即因变量可以被自变量的线性组合所解释。这个方法可以用来预测因变量的值,也可以用来研究自变量和因变量之间的关系。

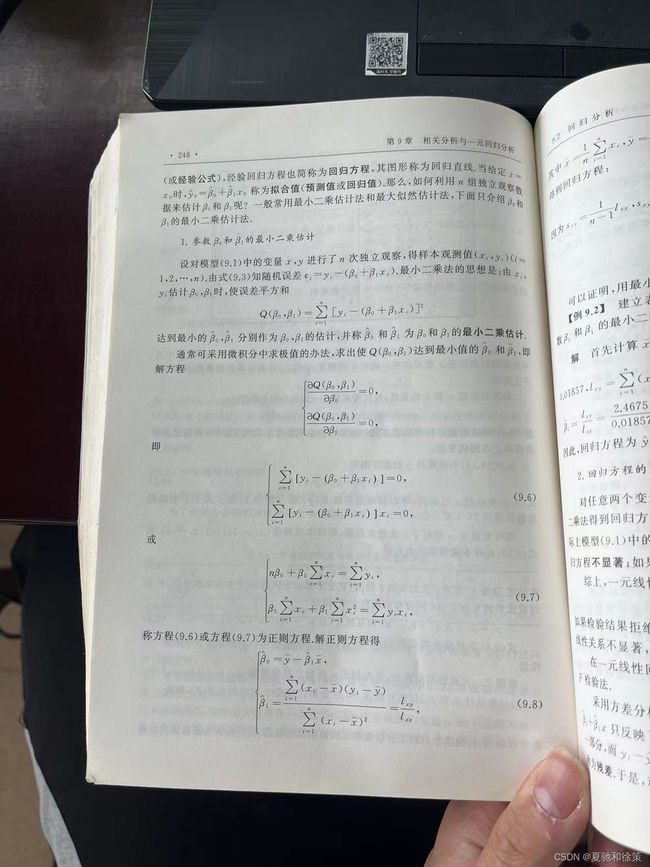

一元线性回归分析的目标是找到一条直线,使得这条直线最能够代表自变量和因变量之间的关系。具体而言,回归分析的目标是求解一个线性方程y = a + bx,其中y表示因变量,x表示自变量,a和b分别表示截距和斜率,通过最小化残差平方和来确定a和b的值。残差是因变量的观察值与回归直线上的预测值之间的差异。

一元线性回归分析通常涉及下列步骤:

-

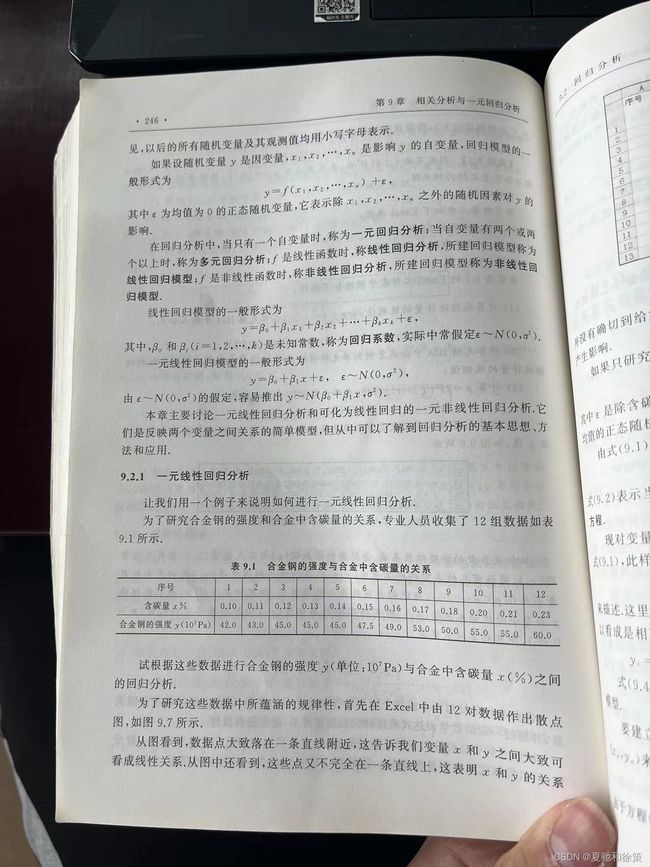

收集数据:收集有关自变量和因变量的数据,并确保数据满足回归分析的假设。

-

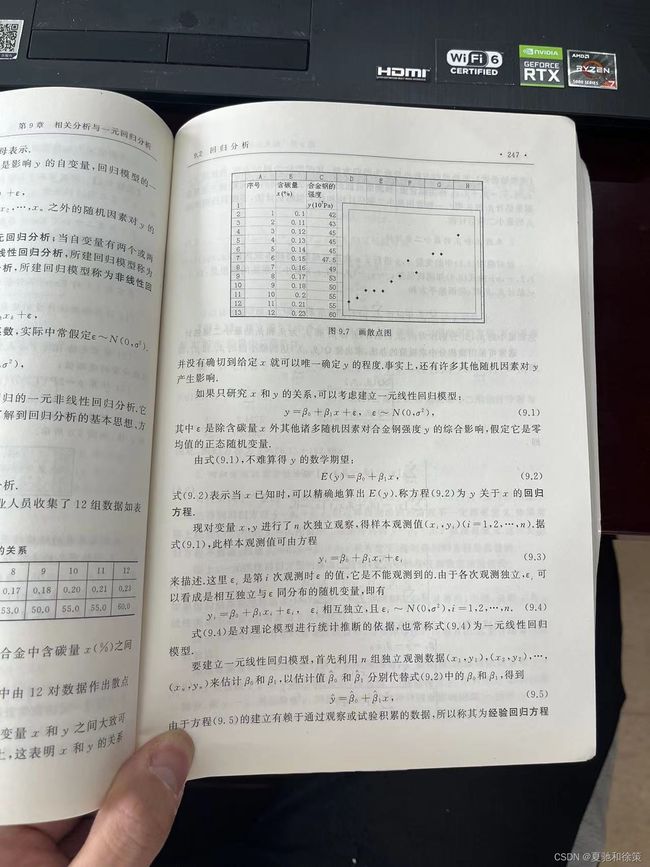

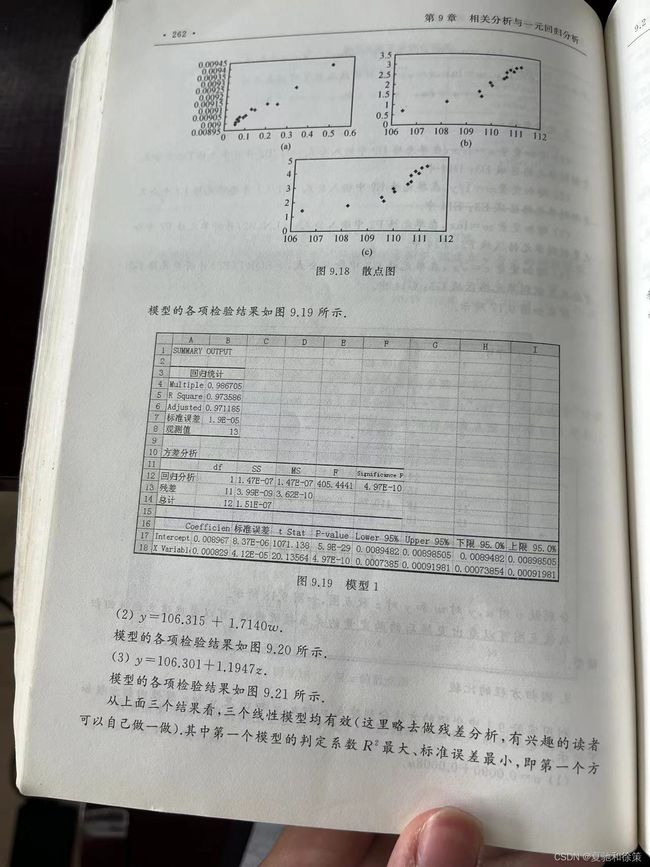

确定关系:绘制散点图,观察自变量和因变量之间的关系,并确定是否存在线性关系。

-

拟合直线:使用回归分析方法拟合一条直线,该直线最能够代表自变量和因变量之间的关系。

-

评估拟合:评估回归分析的拟合程度,并确定拟合是否显著。

-

进行预测:使用回归方程进行预测,并评估预测结果的可靠性。

我的理解:

一元线性回归分析是一种统计分析方法,它用于研究两个连续型变量之间的关系。其中一个变量被称为自变量,通常是独立变量,另一个变量被称为因变量,通常是需要解释的变量。一元线性回归模型建立了自变量与因变量之间的线性关系,并通过拟合一条直线来描述这种关系。回归分析可以用于预测、模拟和探索数据之间的关系。

在一元线性回归分析中,我们通常会首先绘制散点图,以便可视化自变量和因变量之间的关系。然后,我们会计算出相关系数来度量这种关系的强度和方向。接下来,我们会拟合一条直线,这条直线应该能够在一定程度上解释因变量的变化。最后,我们会进行统计检验来确定这条直线是否能够很好地解释数据,以及自变量对因变量的影响是否显著。

我的理解:

最小二乘估计是一种用于确定回归系数的方法。回归系数包括截距项(参数β0)和自变量的系数(参数β1),最小二乘估计的目标是找到一条直线,使得这条直线的残差平方和(即预测值与真实值之差的平方和)最小。这样的直线称为最小二乘回归线。

具体来说,最小二乘估计首先需要选择一个假设的函数形式,例如一元线性回归中假设因变量和自变量之间的关系为一条直线。然后,根据样本数据计算出回归系数β0和β1,使得残差平方和最小。这个过程可以使用数学公式计算,也可以利用计算机软件进行计算。

最小二乘估计是一种经典的回归分析方法,被广泛应用于各种领域,包括自然科学、社会科学、工程和商业等。

我的理解:

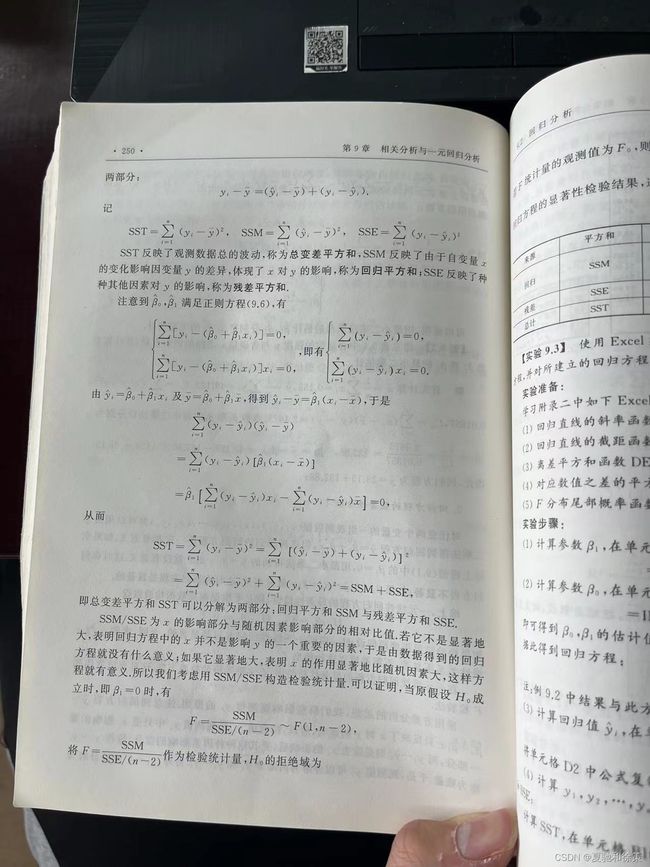

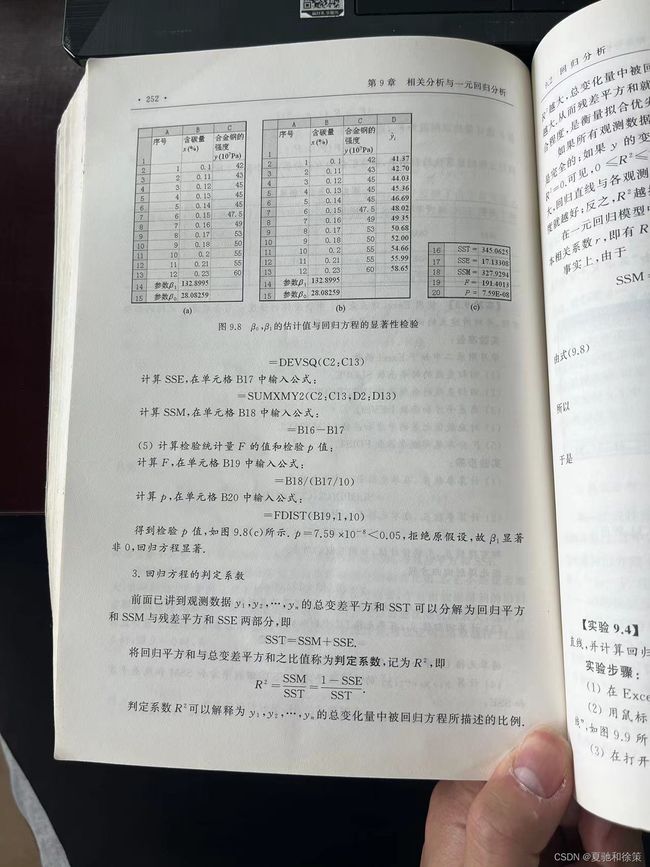

回归方程的显著性检验是用来判断一元线性回归模型中自变量是否显著影响因变量。它是基于一个假设检验的方法进行的,其中原假设为自变量的系数等于0,即自变量不对因变量产生显著影响;备择假设为自变量的系数不等于0,即自变量对因变量有显著影响。在进行显著性检验时,需要计算回归方程中的F值,然后与F分布的临界值进行比较。如果计算得到的F值大于F分布的临界值,就可以拒绝原假设,认为自变量对因变量具有显著影响;否则不能拒绝原假设,即认为自变量对因变量没有显著影响。

我的解析:

我的解析:

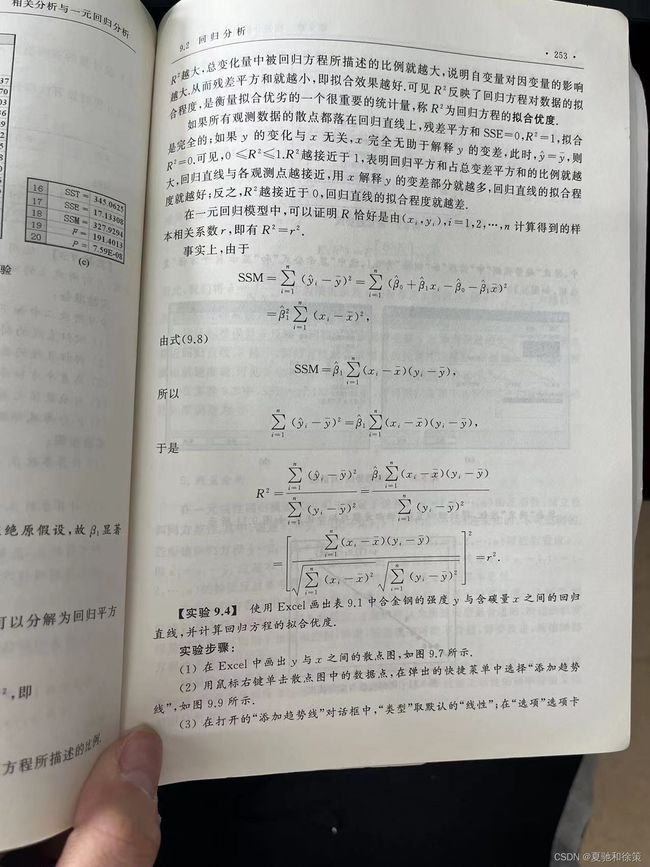

回归方程的判定系数(coefficient of determination)是用来衡量回归方程对观测值的解释程度的一个指标,通常用R²表示。

在一元线性回归分析中,R²等于相关系数r的平方,它的取值范围是0到1之间。R²越接近1,表示回归方程对观测值的解释程度越高,也就是说,回归方程所描述的自变量与因变量之间的关系越紧密。

在多元线性回归分析中,R²的计算方式稍有不同,但其含义与一元线性回归分析相同。

需要注意的是,判定系数只能反映因变量的变异中有多少是由自变量解释的,并不能证明因变量完全由自变量解释。此外,R²也无法衡量回归系数的精度和是否稳健。因此,在解释回归方程时,需要综合考虑回归系数的显著性检验结果和回归方程的判定系数。

我的理解:

回归方程的判定系数(Coefficient of Determination)是用来衡量自变量对因变量的解释程度的一个统计量,通常用符号 R^2 表示。R^2 的取值范围是 0 到 1,数值越接近 1 表示模型拟合程度越好,即自变量对因变量的解释程度越高。

具体而言,R^2 表示模型拟合数据所占的比例,即因变量的变异中有多少能够被自变量所解释。如果 R^2 等于 1,则说明回归方程能够完全解释因变量的变异;如果 R^2 等于 0,则说明自变量对因变量的解释能力为零。

需要注意的是,R^2 只是衡量了回归方程的拟合程度,而不是衡量回归方程是否具有预测能力。因此,即使 R^2 很高,也不一定能够预测新的数据,因为可能存在其他变量或因素对因变量的影响。

我的理解:

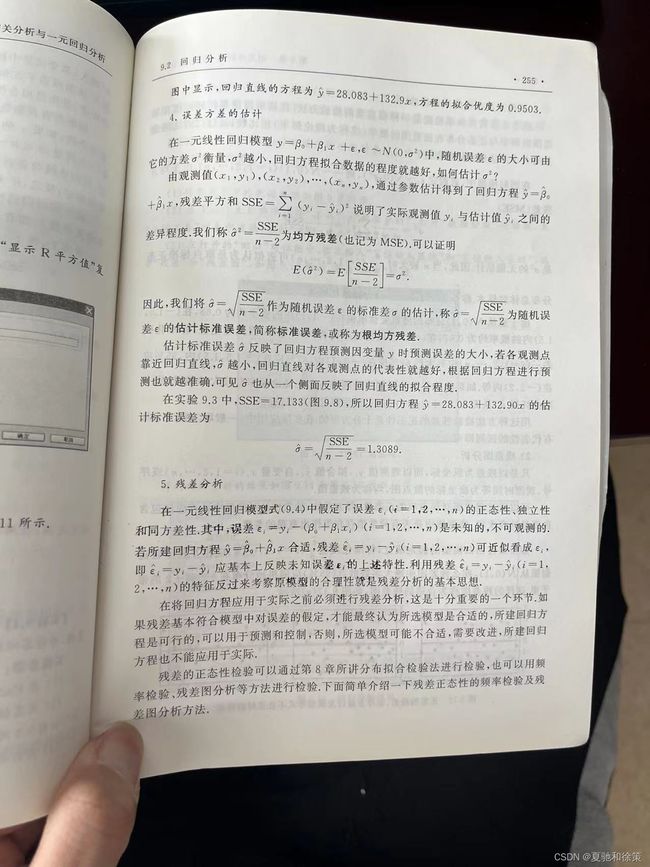

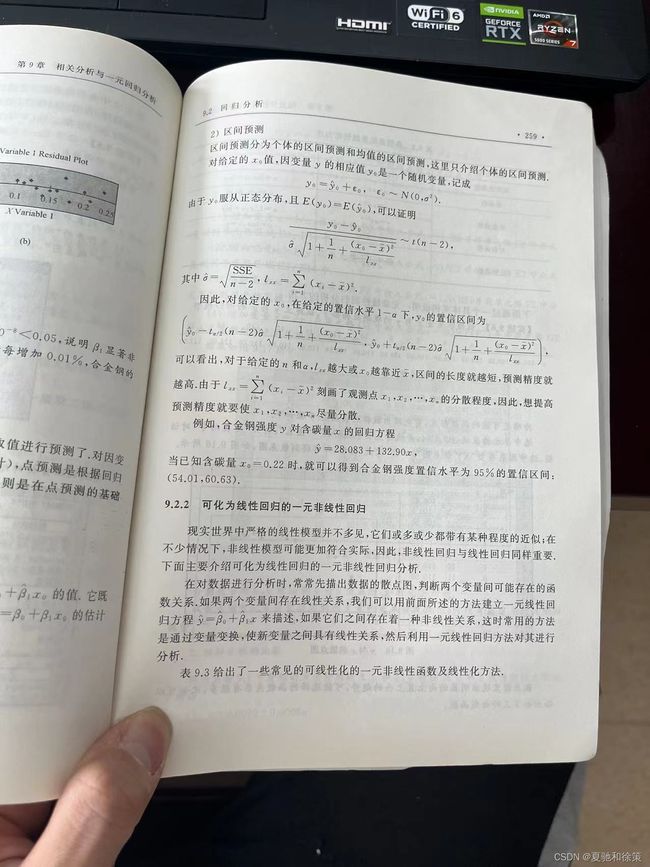

在一元线性回归分析中,模型误差方差的估计是指使用样本数据来估计模型中随机误差的方差。模型误差是指因为未知的因素而无法用自变量解释的因变量的变异,也就是模型与真实数据之间的偏差。

通常,我们使用残差平方和(SSE)来估计模型误差方差。残差是因变量与回归方程预测值之间的差异,而残差平方和是所有残差的平方和。模型误差方差的估计可以通过将SSE除以自由度来得到,自由度为样本大小减去回归系数个数减一。这个估计量被称为均方误差(MSE)。

MSE的大小与数据的离散程度有关,离散程度越大,MSE越大。在实际应用中,我们可以将MSE用于计算标准误差(SE),以便进行假设检验和置信区间的计算。

我的理解:

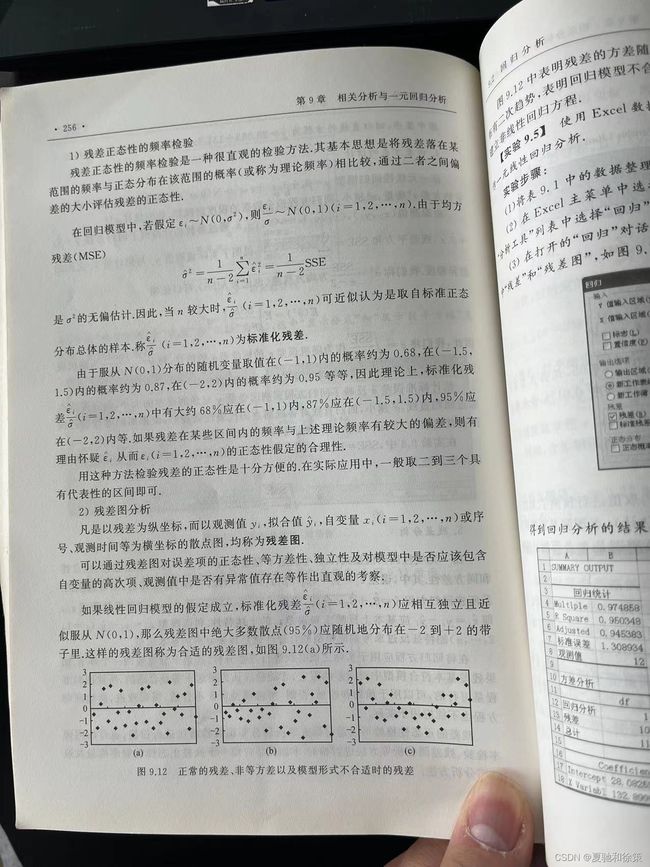

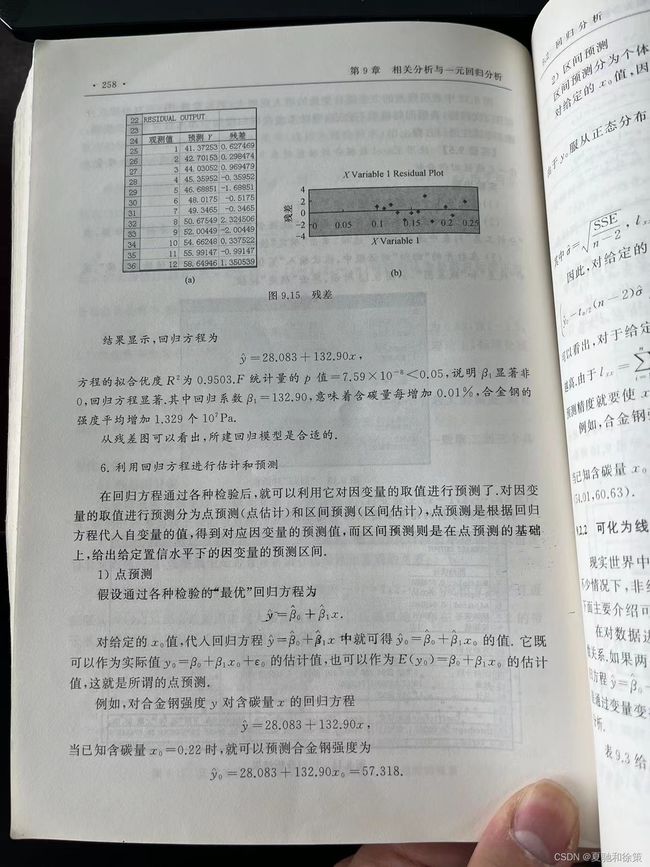

一元线性回归分析中,模型误差残差是指预测值与真实值之间的差异,即残差=观察值-预测值。在进行回归分析时,需要对残差进行分析来评估模型的拟合优度和检查是否存在异常值等情况。

一般来说,残差应当满足以下假设:

- 残差的分布是正态分布。

- 残差的均值为零。

- 残差的方差是常数(即不存在异方差)。

- 残差之间是相互独立的。

对于第一个假设,可以通过画出残差的正态概率图或Q-Q图来检验,如果残差点落在一条直线上,则说明残差服从正态分布。

对于第二个假设,可以计算残差的平均值,如果残差的平均值接近于0,则说明该假设成立。

对于第三个假设,可以通过画出残差与预测值的散点图或残差的方差稳定性图来检验,如果残差与预测值的散点图呈现出“喇叭口”或“倒U”型,则可能存在异方差;如果残差的方差稳定性图呈现出平行的线,则说明该假设成立。

对于第四个假设,可以通过画出残差与预测值的散点图或残差的自相关图来检验,如果残差与预测值的散点图呈现出“带状”或“宽U”型,则说明残差之间存在相关性;如果残差的自相关图在0处左右交替变换,则说明残差之间存在自相关。

除了对残差的假设检验外,还可以通过画出残差与预测值的散点图或残差图来检查是否存在异常值或离群值。如果残差与预测值的散点图中出现了明显的偏离,或者残差图中存在离群点,则说明可能存在异常值或离群值。在这种情况下,可以对异常值或离群值进行删除或转换处理,再重新进行回归分析。

我的理解:

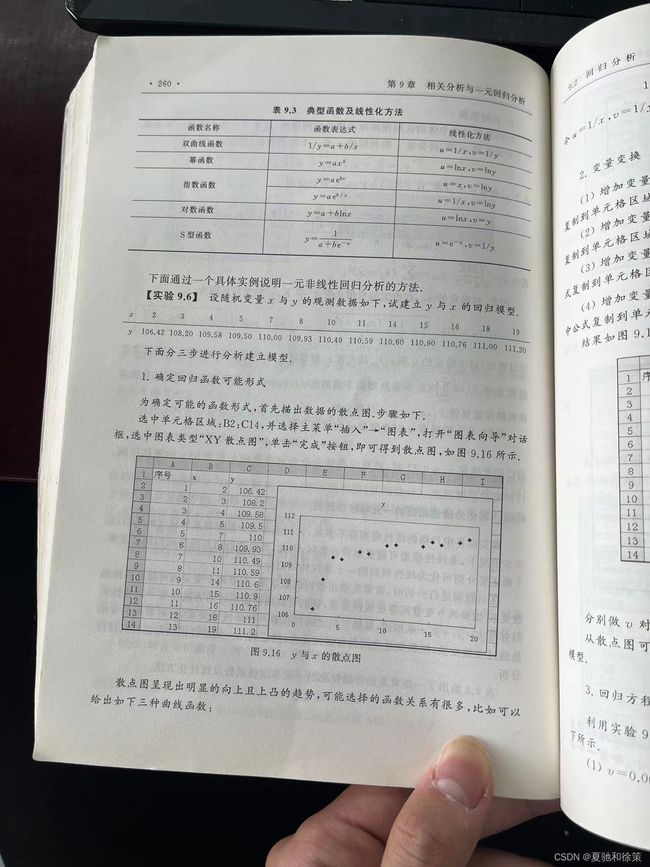

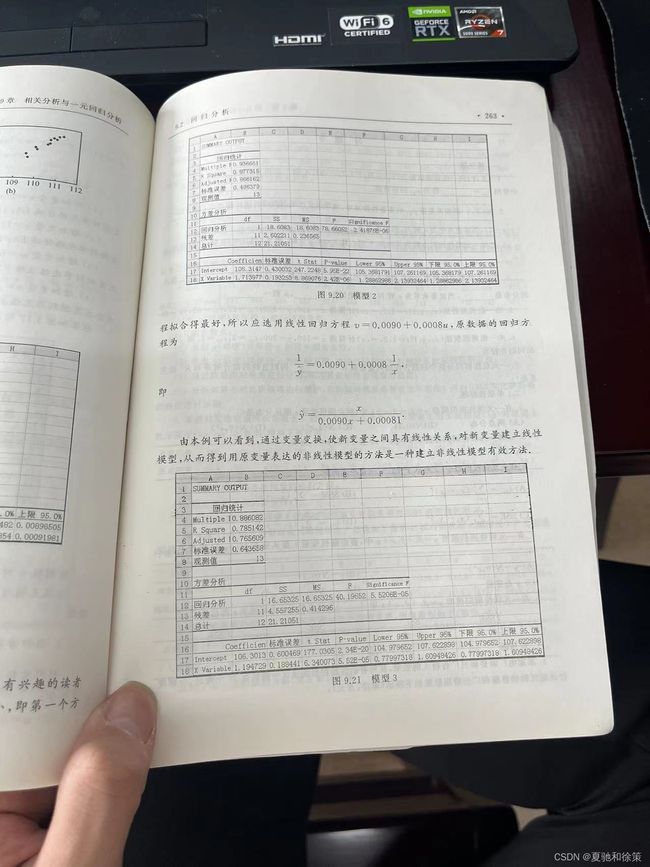

可化为线性回归的一元非线性回归是指,通过对原始数据进行某些数学变换或者转化,将一元非线性回归模型转化为一元线性回归模型,从而可以使用线性回归分析方法进行分析和预测。这样做的目的是简化模型,提高分析和预测的准确性和可靠性。

在实际应用中,经常会遇到非线性关系的数据,而线性回归模型只适用于线性关系。为了解决这个问题,可以通过一些数据预处理的方法,将非线性关系的数据转化为线性关系的数据,使其符合线性回归模型的假设前提,从而可以应用线性回归模型进行数据分析和预测。

常用的数据预处理方法包括对数变换、平方根变换、指数变换、幂次变换等。需要注意的是,转化后的数据要符合线性回归的假设前提,如线性性、正态性、同方差性等。

总结:

回归分析是一种常用的统计方法,旨在探究自变量和因变量之间的关系。以下是回归分析的重点和难点和易错点的总结:

重点:

- 回归方程的建立和解释;

- 参数的显著性检验和置信区间估计;

- 判定系数和调整后判定系数的解释和应用;

- 模型误差和残差的分析;

- 多元回归分析中多重共线性的检验和处理。

难点:

- 回归分析需要具有较强的数学功底,包括矩阵运算、偏导数等知识;

- 参数的显著性检验需要掌握统计学中的假设检验方法,包括t检验、F检验等;

- 对于非线性回归分析,需要了解函数拟合和变量转换的方法;

- 对于多元回归分析,需要了解变量选择和多重共线性的处理方法。

易错点:

- 在回归分析中,需要注意自变量和因变量之间的因果关系,不能将相关性看作因果关系;

- 在参数显著性检验中,需要注意是否满足正态分布和方差齐性的假设;

- 判定系数不能作为模型好坏的唯一标准,需要考虑调整后判定系数和残差分析等因素;

- 多元回归分析中,需要注意多重共线性对参数估计和显著性检验的影响。