RCNN论文翻译(更新中……)

目录

- RCNN论文翻译

-

-

- Abstract

- 1.Introduction

- 2.Object dection with R-CNN

-

- 2.1. Module design

- 2.2. Test-time dection

- 2.3. Training

- 2.4. Results on PASCAL VOC 2010-12

- 2.5. Results on ILSVRC2013 detection

- 3. Visualization, ablation, and modes of error

-

- 3.1. Visualizing learned features

- 3.2. Ablation studies

- 3.3. Network architectures

- 3.4. Detection error analysis

- 3.5. Bounding-box regression

- 3.6. Qualitative results

- 4. The ILSVRC2013 detection dataset

-

- 4.1. Dataset overview

- References

-

RCNN论文翻译

注:本人英语水平欠佳,翻译有误之处还望海涵,欢迎指正,不胜感激。

论文地址:Rich feature hierarchies for accurate object detection and semantic segmentation Tech report

作者:Ross Girshick Jeff Donahue Trevor Darrell Jitendra Malik UC Berkeley

作者邮箱:{rbg,jdonahue,trevor,malik}@eecs.berkeley.edu

Abstract

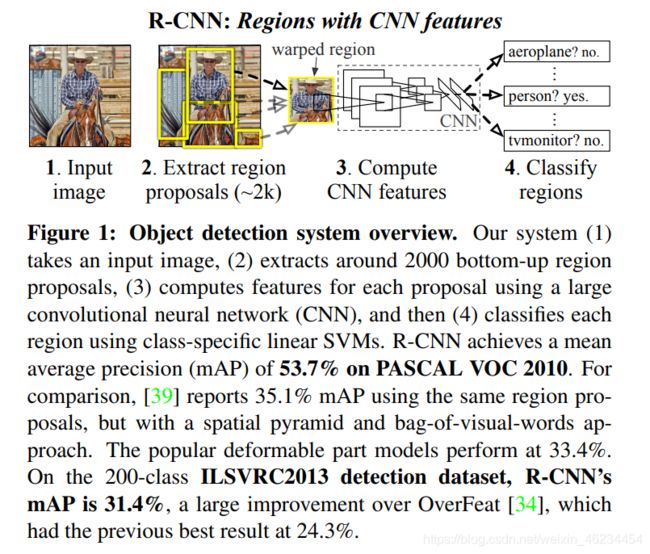

在公开数据集 P A S C A L V O C PASCAL VOC PASCALVOC上测试的目标检测性能在最近几年趋于平稳。性能最好的方法是复杂的集成系统,通常将多个低级图像特征和高级上下文结合在一起。在这篇文章中,我们提出了一种简单、可扩展的检测算法,相比于之间在 V O C 2012 VOC 2012 VOC2012上的实现了 m A P mAP mAP为 53.3 53.3% 53.3的最佳结果相比,我们将平均精度提升了 30 30% 30。我们的方法包括两个关键的见解:

- 我们将具有大容量的卷积神经网络应用于自底向上的区域建议,以便来定位和分割目标。

- 由于带有标签的训练数据的缺乏,对辅助任务进行监督性的预训练,接着进行特定区域的微调,可以显著提高性能。

因为我们结合了区域提案和卷积神经网络,所以我们称这个方法为 R − C N N R-CNN R−CNN:具有 C N N CNN CNN特征的区域。我们也比较了 R − C N N R-CNN R−CNN和 O v e r F e a t OverFeat OverFeat,这是一个基于类 C N N CNN CNN架构的滑动窗口检测器。我们发现 R − C N N R-CNN R−CNN在 200 200 200类的 I L S V R C 2013 ILSVRC2013 ILSVRC2013校验数据集上的表现远远超过 O v e r F e a t OverFeat OverFeat。代码可在下述链接查看:http://www.cs.berkeley.edu/˜rbg/rcnn.。

1.Introduction

功能问题。最近十几年,在视觉识别任务的进展很大程度上取决于 S I F T SIFT SIFT和 H O G HOG HOG。如果我们看一下规范的视觉识别任务 P A S C L A V O C PASCLA VOC PASCLAVOC目标检测的表现,人们普遍认为该过程在 2010 − 2012 2010-2012 2010−2012年发展缓慢,在构建集成系统和对成功的方法进行细微改变而取得了较小的进展。

S I F T SIFT SIFT和 H O G HOG HOG是 b l o c k − w i s e block-wise block−wise定向直方图,我们可以粗略地将其与V1中的复杂细胞联系起来, V 1 V1 V1是灵长类动物视觉通路上的第一个皮层区域。但是我们知道识别发生在下游的几个阶段,这表明计算特征时可能存在分层、多阶段的过程,而这些过程相对于视觉识别来说信息更加丰富。

福岛的“新认知机”[19],一种受生物学启发的层次和移动不变模式识别模型,是一种对这一过程的早期尝试。但是这种“新认知机”缺乏一个监督训练算法。在 R u m e l h a r t Rumelhart Rumelhart等人的基础上, L e C u n LeCun LeCun等人证明了:通过反向传播的随机梯度下降可以有效地训练卷积神经网络,这是一种“新认知机”的推广模型。

C N N CNN CNN在20世纪90年代大量使用[27],但是后来随着支持向量机的兴起而过时。2012年, K r i z h e v s k y Krizhevsky Krizhevsky[25]等人通过在 I m a g e N e t ImageNet ImageNet大尺度视觉识别挑战 ( I L S V R C ) (ILSVRC) (ILSVRC)上显示了更高的视觉分类准确率而重燃了大家对 C N N CNN CNN的热情。他们的成功源于对 120 120 120万张标签图像进行训练,并对 L e C u n LeCun LeCun的 C N N CNN CNN进行了一些调整(例如: m a x ( 0 , x ) max(0,x) max(0,x)校正非线性和 “ d r o p o u t ” “dropout” “dropout”正则化)。

在 I L S V R C 2012 ILSVRC 2012 ILSVRC2012年的研讨会上, I m a g e N e t ImageNet ImageNet结果的意义受到了热烈的讨论。中心问题可以归纳如下: I m a g e N e t ImageNet ImageNet上的 C N N CNN CNN分类结果在多大程度上可以推广到 P A S C A L V O C PASCAL VOC PASCALVOC挑战下的目标检测结果?

我们通过弥合图像分类和目标检测之间的差距来回答这个问题。这篇文章是第一篇证明了相比于基于类 H O G HOG HOG特征的系统, C N N CNN CNN可以明显地提高目标检测的性能。为了实现这个目标,我们聚焦于两点:用深度网络定位目标,用少量的带注的检测数据训练高容量的模型。

不同于图像分类,检测需要对图像中的目标进行定位。一种方法是将框架定位问题作为回归问题。然而, S z e g e d y Szegedy Szegedy等人和我们自己的研究都表明,这种策略在实践中并不是非常的合适(他们在 V O C 2007 VOC 2007 VOC2007上报告的 m A P mAP mAP为 30.5 30.5% 30.5,我们是 58.5 58.5% 58.5)。另一种方法是建立滑动窗口检测器。 C N N CNN CNN以这种方式使用了至少 20 20 20年,尤其是受约束的物体上,例如:人脸或者步行者。为了保持高的空间分辨率,这些CNNs通常有2个卷积和池化层。然而,在我们的网络中,高度较高的单元有5个卷积层,在输入图像中有很大的接受域( 195 ∗ 195 195 * 195 195∗195像素)和步长( 32 ∗ 32 32 * 32 32∗32像素),这使得在滑动窗口模式下的精确定位成为一个开放的科技挑战。

相反,我们在“区域识别”的范式下解决 C N N CNN CNN定位问题,该范式在目标检测和语义分割下都非常成功。测试时,我们的方法为每个输入图像生成约 2000 2000 2000个不同类别的区域建议,并通过 C N N CNN CNN对每个区域建议提取一个特定长度的特征向量,最后,使用特定类别的线性支持向量机对区域进行分类。我们使用一种简单的技术(放射图像扭曲)来计算每个区域建议的特征大小的CNN输入,而不管区域的形状。图1显示了我们方法的一个概况,高亮显示了我们的结果。因为我们的方法结合了区域提案和 C N N CNN CNN,所以我们命名为 R − C N N R-CNN R−CNN:具有 C N N CNN CNN特征的区域。

在这篇论文的跟新版本中,通过在 200 200 200类的 I L S V R C 2013 ILSVRC2013 ILSVRC2013数据集上跑 R − C N N R-CNN R−CNN模型,我们对 R − C N N R-CNN R−CNN和最新提出的 O v e r F e a t OverFeat OverFeat检测系统进行了直接的比较。 O v e r F e a t OverFeat OverFeat使用了滑动窗口进行检测,并且是到现在为止在 I L S V R C 2013 ILSVRC2013 ILSVRC2013数据集上表现最好的方法。结果表明, R − C N N R-CNN R−CNN显著优于 O v e r F e a t OverFeat OverFeat,其 m A P mAP mAP达到 31.4 31.4% 31.4,相比于 O v e r F e a t OverFeat OverFeat其 m A P mAP mAP为 24.3 24.3% 24.3。

检测面临的第二个问题是带标签的数据不足,现有的所有可用数据对于训练一个大的 C N N CNN CNN网络来说仍然是不足的。对于这个问题,传统的解决方法是:首先使用不监督方法进行预训练,再使用监督性的微调。(比如:[35])。这篇论文的第二个贡献是证明了:当数据缺失的时候,先在大数据集( I L S V R C ILSVRC ILSVRC)上试用监督式的预训练,然后在小数据集上( P A S C A L PASCAL PASCAL)进行一个特定区域的微调,是一种更加有效的方法。在我们的实验中,检测时的微调贡献了 8 8% 8个百分点的 m A P mAP mAP性能。经过微调,我们的系统在 V O C 2010 VOC 2010 VOC2010上实现了 54 54% 54的 m A P mAP mAP,相比之下,进行高度调优的基于 H O G HOG HOG的可变形部件模型是 33 33% 33[17,20]。我们还向读者介绍了 D o n a h u e Donahue Donahue等人的同时代研究,他们的研究表明, K r i z h e v s k y Krizhevsky Krizhevsky的 C N N CNN CNN可以(无需微调)作为黑盒特征提取器,在包括场景分类、细粒度子分类和领域适应在内的多个识别任务中产生出色的性能。

我们的系统也是相当有效的。唯一特定于类的计算是一个相当小的矩阵向量乘积和贪婪的非最大抑制。这个计算特性来自于所有类别共享的特征,这些特征比以前使用的区域特征低两个数量级(cf.[39])。

了解我们方法的失效模式对于改进它也很关键,因此我们报告了来自 H o i e m Hoiem Hoiem等人[23]的检测分析工具的结果。作为这个分析的一个直接的结果,我们得出结论:一个简单的边界框回归方法可以有效的减少错误定位,这是主要错误模型。

这介绍技术细节之前,我们强调:由于 R − C N N R-CNN R−CNN操作是在区域上的,因此将其扩展到语义分割也是非常自然的。话不多说,我们也实现了在 P A S C A L V O C PASCAL VOC PASCALVOC分割任务上很有竞争力的结果,在 V O C 2011 VOC 2011 VOC2011测试数据集上其平均分解准确率达到 47.9 47.9% 47.9。

2.Object dection with R-CNN

我们的目标检测系统包含了三个部分,首先产生独立类别的区域提案。这些提议定义了我们提供给检测器的候选检测集。第二部分是一个可以从每个区域提取特定长度的特征向量的卷积神经网络。第三部分是一个特定类别的线性支持向量机的结合。在这一节,我们展示我们每一个模块的设计,描述他们的测试时的用法,以及他们学习怎样的参数和在 P A S C A L V O C 2010 − 12 PASCAL VOC 2010-12 PASCALVOC2010−12和 I L S V R C 2013 ILSVRC2013 ILSVRC2013上的检测结果。

2.1. Module design

Regin proposals. 最近有很多论文提供了生成独立类别的区域提案的方法。比如: o b j e c t n e s s [ 1 ] , s e l e c t i v e s e a r c h [ 39 ] , c a t e g o r y − i n d e p e n d e n t o b j e c t p r o p o s a l s [ 14 ] , c o n s t r a i n e d p a r a m e t r i c m i n − c u t s ( C P M C ) [ 5 ] , m u l t i − s c a l e c o m b i n a t o r i a l g r o u p i n g [ 3 ] , 和 C i r e s ¸ a n e t a l . [ 6 ] , objectness [1], selective search [39], category-independent object proposals [14], constrained parametric min-cuts (CPMC) [5], multi-scale combinatorial grouping [3], 和Cires¸an et al. [6], objectness[1],selectivesearch[39],category−independentobjectproposals[14],constrainedparametricmin−cuts(CPMC)[5],multi−scalecombinatorialgrouping[3],和Cires¸anetal.[6],他通过将 C N N CNN CNN作用于规律分割的正方形的作物来检测有丝分裂细胞。这是一种区域提案的特殊情况。尽管 R − C N N R-CNN R−CNN对于特殊的区域提案方法是不可知的,但是我们使用选择性搜索来与之前的工作进行一个控制比较。

Feature extraction. 我们使用 K r i z h e v s k y Krizhevsky Krizhevsky等人描述的 C N N CNN CNN的 C a f f e Caffe Caffe[24]实现,从每个区域建议中提取一个 4096 4096 4096维的特征向量。特征的计算方法是通过五个卷积层和两个完全连通的层向前传播一幅均值减后的 227 × 227 R G B 227×227 RGB 227×227RGB图像。我们向读者推荐[24,25]以了解更多的网络架构细节。

为了计算每个区域提案的特征,我们首先要将图像数据转变成一种 C N N CNN CNN可以接受的形式(他的构架需要 227 ∗ 227 227 * 227 227∗227的像素大小的特定输入)。在对于我们任意形状区域的许多可能变换中,我们选择最简单的。尽管候选区域的大小和长宽比不同,我们都使用严格的边界框将其扭曲到所需的大小。在翘曲之前,我们扩大了紧密边界框,这样在翘曲大小下,原始框周围的翘曲图像上下文正好是 p p p像素(我们使用 p = 16 p = 16 p=16)。图2显示了变形训练区域的随机抽样。替代翘曲的方法在附录 A A A中讨论。

2.2. Test-time dection

在测试阶段,我们使用 S S SS SS方法在测试图像上提取 2000 2000 2000个区域提案(在所有实验中我们都使用 S S SS的“ f a s t m o d e fast mode fastmode”)。为了计算特征,我们扭曲每个提议,并使用 C N N CNN CNN进行前向传播。然后,对于每个类,我们使用 S V M SVM SVM训练每个提取的特征向量。给定图像中所有的得分区域,我们应用贪婪非最大抑制(每个类独立),如果一个区域与大于学习阈值的更高的得分选择区域有交集-overunion ( I o U IoU IoU)重叠,则拒绝该区域。 ( G i v e n a l l s c o r e d r e g i o n s i n a n i m a g e , w e a p p l y a g r e e d y n o n − m a x i m u m s u p p r e s s i o n ( f o r e a c h c l a s s i n d e p e n d e n t l y ) t h a t r e j e c t s a r e g i o n i f i t h a s a n i n t e r s e c t i o n − o v e r u n i o n ( I o U ) o v e r l a p w i t h a h i g h e r s c o r i n g s e l e c t e d r e g i o n l a r g e r t h a n a l e a r n e d t h r e s h o l d . ) (Given all scored regions in an image, we apply a greedy non-maximum suppression (for each class independently) that rejects a region if it has an intersection-overunion (IoU) overlap with a higher scoring selected region larger than a learned threshold.) (Givenallscoredregionsinanimage,weapplyagreedynon−maximumsuppression(foreachclassindependently)thatrejectsaregionifithasanintersection−overunion(IoU)overlapwithahigherscoringselectedregionlargerthanalearnedthreshold.)

Run-time analysis. 两个特性使得检测更加地高效,一是 C N N CNN CNN的参数由所有的类别所共享。第二,与其他常见的方法相比,例如使用视觉字袋编码的空间金字塔 ( s p a t i a l p y r a m i d s w i t h b a g − o f − v i s u a l − w o r d e n c o d i n g s ) ( spatial pyramids with bag-of-visual-word encodings) (spatialpyramidswithbag−of−visual−wordencodings), C N N CNN CNN计算的特征向量是低维的。例如, U V A UVA UVA检测系统[39]使用的特征比我们的大两个数量级( 360 k 360k 360k v s . vs. vs. 4 k 4k 4k维)。

这种共享的结果是,花费在计算区域建议和特征上的时间( G P U GPU GPU上是 13 s / 图 像 13s/图像 13s/图像, C P U CPU CPU上是 53 s / 图 像 53s/图像 53s/图像)被摊分在所有类上。唯一的特定类的计算是特征和支持向量机权值之间的点积,和非最大抑制。在实践中,一幅图像的所有点积都被批成一个矩阵-矩阵积。特征矩阵一般为 2000 × 4096 2000×4096 2000×4096,支持向量机权值矩阵为 4096 × N 4096×N 4096×N,其中 N N N为类数。

该分析表明, R − C N N R-CNN R−CNN可以扩展到数千个对象类,而无需使用近似技术,如散列。即使有 100 k 100k 100k个类,在现代的多核 C P U CPU CPU上,得到的矩阵乘法也只需要 10 秒 10秒 10秒。这种效率不仅仅是使用区域提案和共享特征的结果。 U V A UVA UVA系统,UVA系统,由于其高维特性,将慢两个数量级,同时需要 134 G B 134GB 134GB的内存,仅存储 100 k 100k 100k线性预测器,相比之下,我们的低维特性仅 1.5 G B 1.5GB 1.5GB。

将 R − C N N R-CNN R−CNN与 D e a n Dean Dean等人最近关于使用 D P M s DPMs DPMs和哈希[8]进行可扩展检测的工作进行对比也很有趣。当引入 10 , 000 10,000 10,000个分心物类时,他们报告了在每幅图像 5 5 5分钟的运行时间下,在 V O C 2007 VOC 2007 VOC2007上的 m A P mAP mAP约为 16 16% 16。使用我们的方法, 10 k 10k 10k检测器可以在一个 C P U CPU CPU上运行大约一分钟,因为没有做出近似, m A P mAP mAP将保持在 59 59% 59(章节 3.2 3.2 3.2)。

2.3. Training

Supervisede pre-training. 我们在一个仅有图像级标注的辅助数据集( I L S V R C 2012 ILSVRC2012 ILSVRC2012分类)上对 C N N CNN CNN进行有区别的预训练,预训练使用开源的 C a f f e C N N Caffe CNN CaffeCNN库。简单提一下,我们的 C N N CNN CNN和 K r i z h e v s k y Krizhevsky Krizhevsky等人的 C N N CNN CNN的性能表现很接近,在 I L S V R C 2012 ILSVRC2012 ILSVRC2012分类数据集, t o p − 1 top-1 top−1上的错误率提高了 2.2 2.2 2.2个百分点。这种差异是由于训练过程的简化所致。这种误差是由于训练过程的简化构成的。

Domain-speciific fine-tuning. 为了使我们的 C N N CNN CNN适应新的任务(检测)和新的域(弯曲建议窗口),我们继续使用仅弯曲区域建议的 C N N CNN CNN参数的随机梯度下降( S G D SGD SGD)训练。除了用一个随机初始化的 ( N + 1 ) (N + 1) (N+1)路分类层( N N N为对象类的数量, 1 1 1为背景)替换 C N N CNN CNN的 I m a g e N e t ImageNet ImageNet特有的 1000 1000 1000路分类层外, C N N CNN CNN的架构没有改变。 V O C VOC VOC的 N = 20 , I L S V R C 2013 N = 20, ILSVRC2013 N=20,ILSVRC2013的 N = 200 N = 200 N=200。 我们将所有与 g r o u n d − t r u t h ground-truth ground−truth方框重叠的 L o U ≥ 0.5 LoU≥0.5 LoU≥0.5的区域提案视为该方框类别的积极因素,其余的视为消极因素。我们以 0.001 0.001 0.001(初始预训练率的十分之一)的学习率开始 S G D SGD SGD,这允许在不破坏初始化的情况下进行微调。在每个 S G D SGD SGD迭代中,我们统一抽样 32 32 32个正窗口(所有类)和 96 96 96个背景窗口,以构建大小为 128 128 128的小批。我们将抽样倾向于正窗口,因为与背景相比,正窗口是非常罕见的。

Object catagory classifiers. 考虑一个检测车的二分类器。很明显,一个紧紧围绕着汽车的图像区域应该是一个积极的例子。同样,与汽车无关的背景区域显然也是一个反面例子。但不太清楚的是,如何标记与汽车部分重叠的区域。我们用 l o U loU loU重叠阈值来解决这个问题,低于该阈值的区域被定义为否定。重叠阈值 0.3 0.3 0.3是通过网格搜索 0 , 0.1 , … , 0.5 {0,0.1,…, 0.5} 0,0.1,…,0.5。我们发现仔细选择这个阈值很重要。设置为 0.5 0.5 0.5,如[39],减少 5 5 5点的 m A P mAP mAP。类似地,设置为 0 0 0减少了 4 4 4个点的 m A P mAP mAP。正例子被简单地定义为每个类的要求解的范围的预测范围。

一旦特征被提取,并且训练标签被使用,对于每一个类别,我们来优化线性 S V M SVM SVM。因为训练数据太大难以存在内存中,我们采用标准的硬负挖掘方法[17,37](hard negative mining method)。硬负挖掘会迅速收敛,在实践中,mAP在经过所有图像之后就会停止增长。在附录 B B B中,我们讨论了为什么在微调和支持向量机训练中,正面和负面例子的定义是不同的。我们还讨论了训练检测支持向量机所涉及的权衡,而不是简单地使用经过微调的 C N N CNN CNN的最终 s o f t m a x softmax softmax层的输出。

2.4. Results on PASCAL VOC 2010-12

遵循 P A S C A L V O C PASCAL VOC PASCALVOC最佳实践[15],我们在 V O C 2007 VOC 2007 VOC2007数据集上验证了所有设计决策和超参数(章节3.2)。对于 V O C 2010 − 12 VOC 2010-12 VOC2010−12数据集的最终结果,我们在 V O C 2012 VOC 2012 VOC2012训练上微调 C N N CNN CNN,在 V O C 2012 VOC 2012 VOC2012训练上优化我们的检测支持向量机。我们只向评估服务器提交了两种主要算法变体的测试结果一次(带和不带边界框回归)。

表 1 1 1显示了 V O C 2010 VOC 2010 VOC2010的完整结果。我们将我们的方法与四个方法进行比较,包括 S e g D P M SegDPM SegDPM[18],它将 D P M DPM DPM检测器与语义分割系统[4]的输出相结合,并使用额外的检测器间上下文和图像分类器重评分。

最相关的比较是与 U i j l i n g s Uijlings Uijlings等人[39]的= U V A UVA UVA系统,因为我们的系统使用相同的区域建议算法。为了对区域进行分类,他们的方法构建了一个四级空间金字塔,并使用密集采样的 S I F T SIFT SIFT、扩展的对手 S I F T SIFT SIFT和 R G B S I F T RGBSIFT RGBSIFT描述符进行填充,每个向量都用4000字的码本进行量化。采用直方图交集核支持向量机 ( a h i s t o g r a m i n t e r s e c t i o n k e r n e l S V M ) (a histogram intersection kernel SVM) (ahistogramintersectionkernelSVM)进行分类。与他们的多特征、非线性核支持向量机方法相比,我们在 m A P mAP mAP方面取得了很大的改进,从 35.1 35.1% 35.1提高到 53.7 53.7% 53.7,同时速度也快得多(章节 2.2 2.2 2.2)。我们的方法在 V O C 2011 / 12 VOC 2011/12 VOC2011/12测试中取得了类似的性能( 53.3 53.3% mAP 53.3)。

2.5. Results on ILSVRC2013 detection

我们使用与 P A S C A L V O C PASCAL VOC PASCALVOC相同的系统超参数,在 200 200 200类 I L S V R C 2013 ILSVRC2013 ILSVRC2013检测数据集上运行 R − C N N R-CNN R−CNN。我们遵循相同的协议,只向 I L S V R C 2013 ILSVRC2013 ILSVRC2013评估服务器提交两次测试结果,一次带边界框回归,一次不带边界框回归。

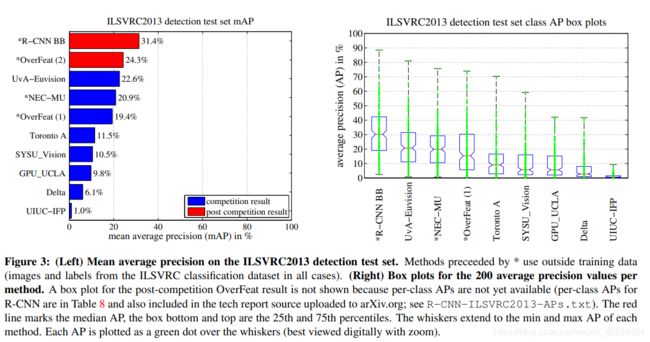

图 3 3 3将 R − C N N R-CNN R−CNN与 2013 2013 2013年 I L S V R C ILSVRC ILSVRC竞赛的参赛作品以及竞赛后的 O v e r F e a t OverFeat OverFeat结果[34]进行了比较。 R − C N N R-CNN R−CNN获得了 31.4 31.4% 31.4的 m A P mAP mAP,这明显领先于 O v e r F e a t OverFeat OverFeat的 24.3 24.3% 24.3的第二好结果。为了了解 A P AP AP在类上的分布情况,本文还给出了箱形图,并在本文末尾的表 8 8 8中给出了 p e r c l a s s A P perclass AP perclassAP的表。大多数参赛作品 ( O v e r F e a t 、 N E C − M U 、 U v A E u v i s i o n 、 T o r o n t o A (OverFeat、NEC-MU、UvAEuvision、Toronto A (OverFeat、NEC−MU、UvAEuvision、TorontoA和 U I U C − I F P UIUC-IFP UIUC−IFP)使用了卷积神经网络,这表明在如何将cnn应用于目标检测方面存在显著的细微差别,导致结果差异很大。在第 4 4 4节中,我们将概述 I L S V R C 2013 ILSVRC2013 ILSVRC2013检测数据集,并提供有关在其上运行 R − C N N R-CNN R−CNN时所做选择的详细信息。

3. Visualization, ablation, and modes of error

3.1. Visualizing learned features

第一层滤镜可以直接可视化,很容易理解[25]。它们捕捉有方向的边缘和对手的颜色。理解随后的层则更具挑战性。 Z e i l e r Zeiler Zeiler和 F e r g u s Fergus Fergus在[42]中提出了一种视觉上吸引人的反卷积方法。我们提出了一种简单的(和补充的)非参数方法,可以直接显示网络学习到了什么。

其理念是在网络中挑选出一个特定的单元(特征),并将其当作自身的目标探测器来使用。也就是说,我们计算了该单元在一组大量的未提交的区域提案(大约 1000 1000 1000万个)上的激活情况,将提案从激活程度最高到最低进行排序,执行非最大抑制,然后显示得分最高的区域。我们的方法让被选中的单位“自己说话”,通过显示它触发的确切输入。我们避免平均,以便看到不同的视觉模式和洞察由单位计算的不变性。

我们从 p o o l 5 pool_5 pool5层可视化单元,这是网络的第五层,也是最后一个卷积层的maxpooled输出。 p o o l 5 pool_5 pool5$ feature map$为 6 × 6 × 256 = 9216 6×6×256 = 9216 6×6×256=9216维。忽略边界效应,在原始的 227 × 227 227×227 227×227像素输入中,每个 p o o l 5 pool_5 pool5单元都有 195 × 195 195×195 195×195像素的接受场。一个中央的 p o o l 5 pool_5 pool5单元有一个接近全局的视图,而靠近边缘的一个有一个较小的、剪切的支撑。

图 4 4 4中的每一行显示了来自 C N N CNN CNN的 p o o l 5 pool_5 pool5单元的前 16 16 16个激活,我们在 V O C 2007 t r a i n v a l VOC 2007 trainval VOC2007trainval上对其进行了微调。 256 256 256个功能独特的单元中的 6 6 6个被可视化(附录 D D D包括更多)。这些单元被选择来展示网络学习的一个代表性样本。在第二行,我们看到一个单位发射狗脸和点数组。第三行对应的单元是一个红色斑点检测器。也有检测人脸和更多抽象图案的探测器,如文本和带窗的三角形结构。网络似乎学习了一种表现形式,它将少数类调优的特征与形状、纹理、颜色和材料属性的分布式表现形式结合在一起。随后的全连接层fc6有能力为这些丰富特性的大量组合建模。

3.2. Ablation studies

Performance layer-by-layer, without fine-tuning. 为了了解哪些层对检测性能至关重要,我们分析了 V O C 2007 VOC 2007 VOC2007数据集上 C N N CNN CNN最后三层的每一层的结果。第 3.1 3.1 3.1节简要描述了层 p o o l 5 pool_5 pool5。最后两层概述如下。

f c 6 fc6 fc6层与 p o o l 5 pool_5 pool5已完全连接。为了计算特征,它将一个 4096 × 9216 4096×9216 4096×9216权重矩阵乘以 p o o l 5 pool_5 pool5特征映射(重塑为一个 9216 9216 9216维向量),然后添加一个偏差向量。这个中间向量是分量式半波整流( x ← m a x ( 0 , x ) x←max(0, x) x←max(0,x))。

f c 7 fc7 fc7层是网络的最后一层。它是通过将 f c 6 fc6 fc6计算的特征乘以一个 4096 × 4096 4096×4096 4096×4096的权重矩阵来实现的,同样地,加上一个偏差向量并进行半波校正。

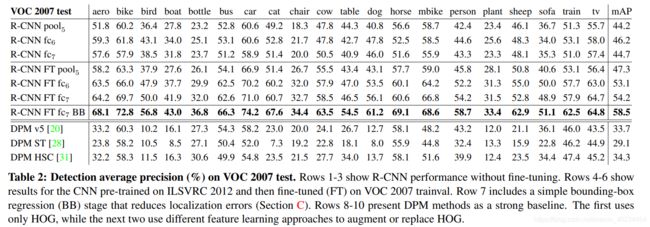

我们首先查看没有在 P A S C A L PASCAL PASCAL上进行微调时 C N N CNN CNN的结果,也就是说,所有 C N N CNN CNN参数都只在 I L S V R C 2012 ILSVRC 2012 ILSVRC2012上进行了预先训练。逐层分析性能(表 2 2 2第 1 − 3 1-3 1−3行)显示, f c 7 fc7 fc7特性的泛化程度比fc6差。这意味着 29 29% 29,即大约 1680 1680 1680万, C N N CNN CNN的参数可以在不降低 m A P mAP mAP的情况下被删除。更令人惊讶的是,除去 f c 7 fc7 fc7和 f c 6 fc6 fc6产生了相当好的结果,即使 p o o l 5 pool_5 pool5的特征计算只使用了 C N N CNN CNN的 6 6% 6的参数。 C N N CNN CNN的大部分表征能力来自于它的卷积层,而不是更大、更紧密相连的层。这一发现表明,仅使用 C N N CNN CNN的卷积层,在计算任意大小的图像的密集特征图(在 H O G HOG HOG意义上)时,具有潜在的实用价值。这种表示方式将支持在 p o o l 5 pool_5 pool5特性之上使用滑动窗口检测器(包括 D P M DPM DPM)进行实验。

Performance layer-by-layer, with fine-tuning. 现在我们看看当有微调时 C N N CNN CNN在 V O C 2007 VOC 2007 VOC2007 训练集上表现结果。提升效果是显著的(如表 2 2 2的 4 − 6 4-6 4−6行):微调将 m A P mAP mAP增加了 8.0 8.0 8.0个百分点。其对 p o o l 5 pool_5 pool5层的贡献远大于 f c 6 fc6 fc6和 f c 7 fc7 fc7,这表明从 I m a g e N e t ImageNet ImageNet学习到的 p o o l 5 pool_5 pool5特性是通用的,大多数改进是通过在它们之上学习特定领域的非线性分类器获得的。

Comparison to recent feature learning methods. 在 P A S C A L V O C PASCAL VOC PASCALVOC检测中,特征学习方法的尝试相对较少。我们来看看最近的两种建立在可变形部件模型上的方法。为了参考,我们还包括了基于 h o g hog hog的标准 D P M DPM DPM[20]的结果。

第一种 D P M DPM DPM特征学习方法 D P M S T DPM ST DPMST [28], 用“sketch token”概率的直方图来增强HOG特征。直观地说,sketch token是通过图像中心的紧密分布的轮廓。通过随机森林训练(在机器学习中,随机森林是一个包含多个决策树的分类器, 并且其输出的类别是由个别树输出的类别的众数而定。),将 35 × 35 35×35 35×35个像素斑块分类为 150 150 150个 s k e t c h t o k e n sketch token sketchtoken或背景中的一个,计算每个像素处的 s k e t c h t o k e n sketch token sketchtoken概率。

第二种方法 D P M H S C DPM HSC DPMHSC[31]用稀疏编码( H S C HSC HSC)直方图代替 H O G HOG HOG。为了计算一个 H S C HSC HSC,在每个像素使用 100 个 7 × 7 100个7×7 100个7×7像素(灰度)原子的学习字典来解决稀疏代码激活。由此产生的激活将以三种方式(全波和半波)、空间池、单元l2归一化,然后进行功率转换( x ← s i g n ( x ) ∣ x ∣ α x←sign(x)|x|^α x←sign(x)∣x∣α)。

所有的 R − C N N R-CNN R−CNN变量都强于三个 D P M DPM DPM方法(表 2 2 2第 8 − 10 8-10 8−10行),包括两个使用特征学习的方法。与仅使用HOG特性的DPM最新版本相比,我们的 m A P mAP mAP高出了 20 20 20个百分点: 54.2 54.2% 54.2比 33.7 33.7% 33.7——相对提高了 61 61% 61。结合使用 H O G HOG HOG和 s k e t c h t o k e n s sketch tokens sketchtokens 比单独使用 H O G HOG HOG高 2.5 2.5 2.5个百分点的 m A P mAP mAP值,而 H S C HSC HSC比 H O G HOG HOG提高了 4 4 4个映射点(对它们内部的 D P M DPM DPM进行比较——两者都使用了性能低于开源版本[20]的非开源 D P M DPM DPM实现)。这些方法分别获得 29.1 29.1% 29.1和 34.3 34.3% 34.3的 m A P mAP mAP。

3.3. Network architectures

在这篇论文中我们的大部分结果所使用的网络结构都是来自 K r i z h e v s k y Krizhevsky Krizhevsky等人所提出的网络结构。但是我们发现网络结构的选择对于 R − C N N R-CNN R−CNN检测性能具有很大的影响。在表 3 3 3中我们展示了最近由 S i m o n y a n Simonyan Simonyan 和 Z i s s e r m a n Zisserman Zisserman[47]提出的使用 16 16 16层网络在 V O C 2007 VOC 2007 VOC2007上的检测结果。这个网络结构是在最近的ILSVRC 2014 2014 2014分类挑战比赛中获得最好的表现之一的。该网络具有同质结构,由13层 3 × 3 3×3 3×3个卷积核组成,最大池化层 5 5 5个,顶层 3 3 3个全连通层。我们将该网络简称为 O − N e t O-Net O−Net,将基线成为 T − N e t T-Net T−Net。

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-l18OCSRn-1611559357080)(images/image-20210123110028147.png)]

为了在 R − C N N R-CNN R−CNN中使用 O − N e t O-Net O−Net,我们从 C a f f e M o d e l Z o o Caffe Model Zoo CaffeModelZoo下载了 V G G I L S V R C 1 6 l a y e r s VGG_ILSVRC_16_layers VGGILSVRC16layers的公开预训练网络权重。然后我们使用曾用于 T − N e t T-Net T−Net的方法对网络进行微调。唯一的区别是为了适应 G P U GPU GPU的内存我们使用使用更小的批( 24 e x a m p l e s 24 examples 24examples)。表三的结果表明当 R − C N N R-CNN R−CNN使用 O − N e t O-Net O−Net网络时其表现明显优于使用 T − N e t T-Net T−Net时 R − C N N R-CNN R−CNN的表现,其 m A P mAP mAP从 58.5 58.5% 58.5提升到了 66.0 66.0% 66.0。但是这也有一个不可忽视地缺点就是计算时间太长,大约是使用 T − N e t T-Net T−Net时的 7 7 7倍时长。

3.4. Detection error analysis

[23]为了揭示我们方法的错误模式,了解微调是如何改变它们的,并查看我们的错误类型与 D P M DPM DPM的比较,我们使用了 H o i e m Hoiem Hoiem等人的优秀的检测分析工具。分析工具的完整总结超出了本文的范围,我们鼓励读者咨询[23]以了解一些更详细的细节(如“规范化 A P AP AP”)。为了使得上下文相关内容可以被最好地理解消化,所以我们在图5和图 6 6 6的标题中进行讨论。

3.5. Bounding-box regression

基于错误分析,我们提出了一种简单的减少定位错误的方法,受DPM的边界框回归的启发,我们训练一个线性回归模型来预测一个新的检测窗口对于给定 p o o l 5 pool_5 pool5特征的选择性搜索区域建议。详见附录 C C C,表 1 1 1,表 2 2 2和图 5 5 5的结果表明这个简单的方法修正了很多的错误定位检测,提升了 3 3 3到 4 4 4个百分点的 m A P mAP mAP。

3.6. Qualitative results

I L S V R C 2013 ILSVRC2013 ILSVRC2013的定性检测结果如图8和图9所示。每幅图像都是从 v a l 2 val_2 val2集合中随机采样的,所有探测器的检测精度都大于 0.5 0.5 0.5。注意,这些并不是精心策划的,并且给出了实际运行中的检测器的真实印象。图 10 10 10和图 11 11 11中显示了更多定性的结果,但这些结果是经过策划的。我们选择每一张图片是因为它包含有趣的、令人惊讶的或神奇的结果。这里也显示了精度大于 0.5 0.5 0.5的所有检测。

4. The ILSVRC2013 detection dataset

在第 2 2 2节中,我们展示了 I L S V R C 2013 ILSVRC2013 ILSVRC2013检测数据集的结果。这个数据集不如 P A S C A L V O C PASCAL VOC PASCALVOC均匀,需要选择如何使用它。由于这些决策非常重要,所以我们将在本节讨论它们。

4.1. Dataset overview

将 I L S V R C 2013 ILSVRC2013 ILSVRC2013检测数据集分为三个集合: t r a i n ( 395 , 918 ) , v a l ( 20 , 121 ) , t e s t train (395,918), val (20,121), test train(395,918),val(20,121),test(40,152),其中每个集合中的图像数量在括号中。val和测试分割来自相同的图像分布。这些图像在复杂性(对象数量、杂波数量、姿态变化等)方面与 P A S C A L V O C PASCAL VOC PASCALVOC图像相似。 v a l val val和 t e s t test test分割被详尽地注释,这意味着在每个图像中,来自所有 200 200 200个类的所有实例都用边界框标记。相比之下,训练集是根据 I L S V R C 2013 ILSVRC2013 ILSVRC2013分类图像分布来提取的。这些图像具有更多的可变复杂性,偏向于单个中心对象的图像。与 v a l val val和 t e s t test test不同的是, t r a i n train train图像(因为它们的数量很大)没有被详尽地注释。在任何给定的 t r a i n train train映像中,来自 200 200 200个类的实例可以被标记,也可以不被标记。除了这些图像集之外,每个类还有一组额外的负面图像。负面图像会被手动检查,以确认它们不包含相关类的任何实例。在这项工作中没有使用负图像集。关于 I L S V R C ILSVRC ILSVRC如何收集和注释的更多信息可以在[11,36]中找到。

因为它们的数量很大)没有被详尽地注释。在任何给定的 t r a i n train train映像中,来自 200 200 200个类的实例可以被标记,也可以不被标记。除了这些图像集之外,每个类还有一组额外的负面图像。负面图像会被手动检查,以确认它们不包含相关类的任何实例。在这项工作中没有使用负图像集。关于 I L S V R C ILSVRC ILSVRC如何收集和注释的更多信息可以在[11,36]中找到。

未完更新中…

References

[1] B. Alexe, T. Deselaers, and V. Ferrari. Measuring the objectness of image windows. TPAMI, 2012. 2

[2] P. Arbelaez, B. Hariharan, C. Gu, S. Gupta, L. Bourdev, and ´ J. Malik. Semantic segmentation using regions and parts. In CVPR, 2012. 10, 11

[3] P. Arbelaez, J. Pont-Tuset, J. Barron, F. Marques, and J. Ma- ´lik. Multiscale combinatorial grouping. In CVPR, 2014. 3

[4] J. Carreira, R. Caseiro, J. Batista, and C. Sminchisescu. Semantic segmentation with second-order pooling. In ECCV, 2012. 4, 10, 11, 13, 14

[5] J. Carreira and C. Sminchisescu. CPMC: Automatic object segmentation using constrained parametric min-cuts. TPAMI, 2012. 2, 3

[6] D. Cires¸an, A. Giusti, L. Gambardella, and J. Schmidhuber. Mitosis detection in breast cancer histology images with deep neural networks. In MICCAI, 2013. 3

[7] N. Dalal and B. Triggs. Histograms of oriented gradients for human detection. In CVPR, 2005. 1

[8] T. Dean, M. A. Ruzon, M. Segal, J. Shlens, S. Vijayanarasimhan, and J. Yagnik. Fast, accurate detection of 100,000 object classes on a single machine. In CVPR, 2013. 3

[9] J. Deng, A. Berg, S. Satheesh, H. Su, A. Khosla, and L. FeiFei. ImageNet Large Scale Visual Recognition Competition 2012 (ILSVRC2012). http://www.image-net.org/ challenges/LSVRC/2012/. 1

[10] J. Deng, W. Dong, R. Socher, L.-J. Li, K. Li, and L. FeiFei. ImageNet: A large-scale hierarchical image database. In CVPR, 2009. 1

[11] J. Deng, O. Russakovsky, J. Krause, M. Bernstein, A. C. Berg, and L. Fei-Fei. Scalable multi-label annotation. In CHI, 2014. 8

[12] J. Donahue, Y. Jia, O. Vinyals, J. Hoffman, N. Zhang, E. Tzeng, and T. Darrell. DeCAF: A Deep Convolutional Activation Feature for Generic Visual Recognition. In ICML, 2014. 2

[13] M. Douze, H. Jegou, H. Sandhawalia, L. Amsaleg, and ´

C. Schmid. Evaluation of gist descriptors for web-scale image search. In Proc. of the ACM International Conference on Image and Video Retrieval, 2009. 13

[14] I. Endres and D. Hoiem. Category independent object proposals. In ECCV, 2010. 3

[15] M. Everingham, L. Van Gool, C. K. I. Williams, J. Winn, and

A. Zisserman. The PASCAL Visual Object Classes (VOC)

Challenge. IJCV, 2010. 1, 4

[16] C. Farabet, C. Couprie, L. Najman, and Y. LeCun. Learning

hierarchical features for scene labeling. TPAMI, 2013. 10

[17] P. Felzenszwalb, R. Girshick, D. McAllester, and D. Ramanan. Object detection with discriminatively trained part

based models. TPAMI, 2010. 2, 4, 7, 12

[18] S. Fidler, R. Mottaghi, A. Yuille, and R. Urtasun. Bottom-up

segmentation for top-down detection. In CVPR, 2013. 4, 5

[19] K. Fukushima. Neocognitron: A self-organizing neural network model for a mechanism of pattern recognition unaffected by shift in position. Biological cybernetics, 36(4):193–202, 1980. 1

[20] R. Girshick, P. Felzenszwalb, and D. McAllester. Discriminatively trained deformable part models, release 5. http: //www.cs.berkeley.edu/˜rbg/latent-v5/. 2, 5, 6, 7

[21] C. Gu, J. J. Lim, P. Arbelaez, and J. Malik. Recognition ´ using regions. In CVPR, 2009. 2

[22] B. Hariharan, P. Arbelaez, L. Bourdev, S. Maji, and J. Malik. ´

Semantic contours from inverse detectors. In ICCV, 2011. 10

[23] D. Hoiem, Y. Chodpathumwan, and Q. Dai. Diagnosing error in object detectors. In ECCV. 2012. 2, 7, 8

[24] Y. Jia. Caffe: An open source convolutional architecture for fast feature embedding. http://caffe. berkeleyvision.org/, 2013. 3

[25] A. Krizhevsky, I. Sutskever, and G. Hinton. ImageNet classification with deep convolutional neural networks. In NIPS, 2012. 1, 3, 4, 7

[26] Y. LeCun, B. Boser, J. Denker, D. Henderson, R. Howard, W. Hubbard, and L. Jackel. Backpropagation applied to handwritten zip code recognition. Neural Comp., 1989. 1

[27] Y. LeCun, L. Bottou, Y. Bengio, and P. Haffner. Gradientbased learning applied to document recognition. Proc. of the IEEE, 1998. 1

[28] J. J. Lim, C. L. Zitnick, and P. Dollar. Sketch tokens: A ´ learned mid-level representation for contour and object detection. In CVPR, 2013. 6, 7 object detection. In CVPR, 2013. 6, 7

[32] H. A. Rowley, S. Baluja, and T. Kanade. Neural networkbased face detection. TPAMI, 1998. 2

[33] D. E. Rumelhart, G. E. Hinton, and R. J. Williams. Learning internal representations by error propagation. Parallel Distributed Processing, 1:318–362, 1986. 1

[34] P. Sermanet, D. Eigen, X. Zhang, M. Mathieu, R. Fergus, and Y. LeCun. OverFeat: Integrated Recognition, Localization and Detection using Convolutional Networks. In ICLR, 2014. 1, 2, 4, 10

[35] P. Sermanet, K. Kavukcuoglu, S. Chintala, and Y. LeCun. Pedestrian detection with unsupervised multi-stage feature learning. In CVPR, 2013. 2

[36] H. Su, J. Deng, and L. Fei-Fei. Crowdsourcing annotations for visual object detection. In AAAI Technical Report, 4th Human Computation Workshop, 2012. 8

[37] K. Sung and T. Poggio. Example-based learning for viewbased human face detection. Technical Report A.I. Memo No. 1521, Massachussets Institute of Technology, 1994. 4

[38] C. Szegedy, A. Toshev, and D. Erhan. Deep neural networks for object detection. In NIPS, 2013. 2

[39] J. Uijlings, K. van de Sande, T. Gevers, and A. Smeulders. Selective search for object recognition. IJCV, 2013. 1, 2, 3, 4, 5, 9

[40] R. Vaillant, C. Monrocq, and Y. LeCun. Original approach for the localisation of objects in images. IEE Proc on Vision, Image, and Signal Processing, 1994. 2

[41] X. Wang, M. Yang, S. Zhu, and Y. Lin. Regionlets for generic object detection. In ICCV, 2013. 3, 5

[42] M. Zeiler, G. Taylor, and R. Fergus. Adaptive deconvolutional networks for mid and high level feature learning. In CVPR, 2011. 4

[43] K. Simonyan and A. Zisserman. Very Deep Convolutional Networks for Large-Scale Image Recognition. arXiv preprint, arXiv:1409.1556, 2014. 6, 7, 14