手把手带你部署OpenStack环境

这里写目录标题

- 1. OpenStack 环境部署

-

- 1.1 部署准备

- 1.2 部署思路

- 2.配置OpenStack 基础环境

-

- 2.1 配置网卡环境

- 2.2 所有节点上的基本操作

-

- 2.2.1 关闭防火墙、核心防护

- 2.2.2 添加主机名映射

- 2.2.3 免交互的配置

- 2.2.4 安装基础环境依赖包

- 2.3 设置时间同步

-

- 2.3.1 控制节点上的配置

- 2.3.2 计算节点上的配置

- 2.4 设置任务计划

- 3. OpenStack系统环境配置

-

- 3.1 安装,配置MariaDB

-

- 3.1.1 安装软件

- 3.1.2 添加MySQL子配置文件

- 3.1.3 开启服务并设置开机自启动

- 3.1.4 执行MariaDB 安全配置脚本

- 3.1.5 登录数据库并验证

- 3.2 安装RabbitMQ(消息队列)

-

- 3.2.1 RabbitMQ的相关配置

- 3.2.2 访问验证

- 3.3 安装memcached

-

- 3.3.1 memcached概述

- 3.3.2 配置memcached

- 3.4 安装etcd

-

- 3.4.1 etcd特点

- 3.4.2 应用场景

- 3.4.3 安装etcd的配置

1. OpenStack 环境部署

1.1 部署准备

- 相关虚拟机资源

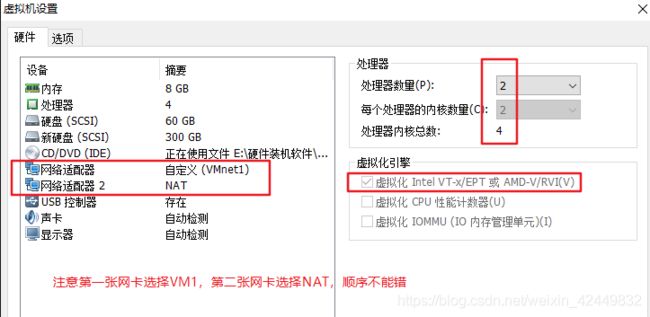

1、控制节点ct(controller)

CPU:双核双线程-CPU虚拟化开启

内存:8G 硬盘:60G+300G(CEPH块存储)

双网卡:VM1-(局域网)192.168.70.10 NAT-192.168.140.50

操作系统:Centos 7.6(1810)-最小化安装

2、计算节点c1(computer01)

CPU:双核双线程-CPU虚拟化开启

内存:8G 硬盘:60G+300G(CEPH块存储)

双网卡:VM1(局域网)-192.168.70.11 NAT-192.168.140.60

操作系统:Centos 7.6(1810)-最小化安装

3、计算节点c2(computer02)

CPU:双核双线程-CPU虚拟化开启

内存:8G 硬盘:60G+300G(CEPH块存储)

双网卡:VM1(局域网)-192.168.70.12 NAT-192.168.140.70

操作系统:Centos 7.6(1810)-最小化安装

- 安装时网卡的选择

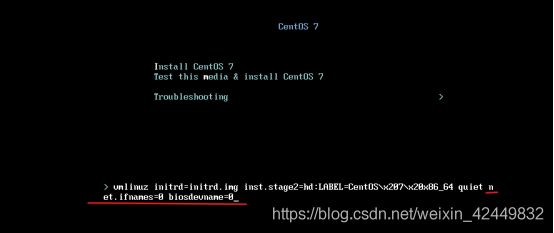

注意:在安装过程中设置,选择Install CentOS 7

按tab键,输入命令 net.ifnames=0 biosdevname=0

创建时修改网卡为eth0

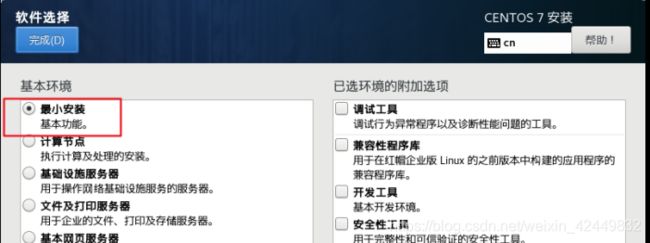

- 软件选择最小化安装即可

- 确认网卡为 eth0 和 eth1

注意:

- 当多个用户同时提交创建虚拟机,只有一个节点压力大;

- 有多个节点,控制节点接收请求,并将请求发送给计算节点,进行调度

如存在多个计算节点,用户可以并行操作。

1.2 部署思路

- 配置 操作系统+OpenStack运行环境

- 配置 OpenStack平台基础服务(rabbitmq,mariadb,memcache,Apache)

rabbitmq:各个组件之间传递信息,消息队列

mariadb:数据库

memcache:身份验证存储令牌,数据库

2.配置OpenStack 基础环境

2.1 配置网卡环境

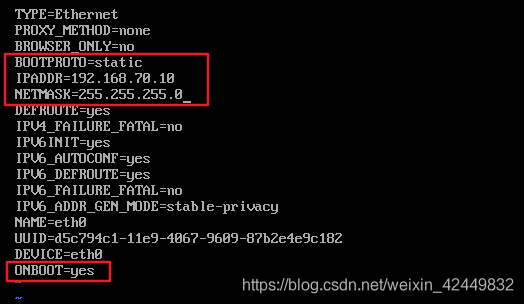

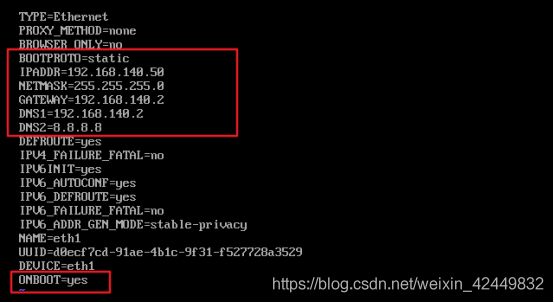

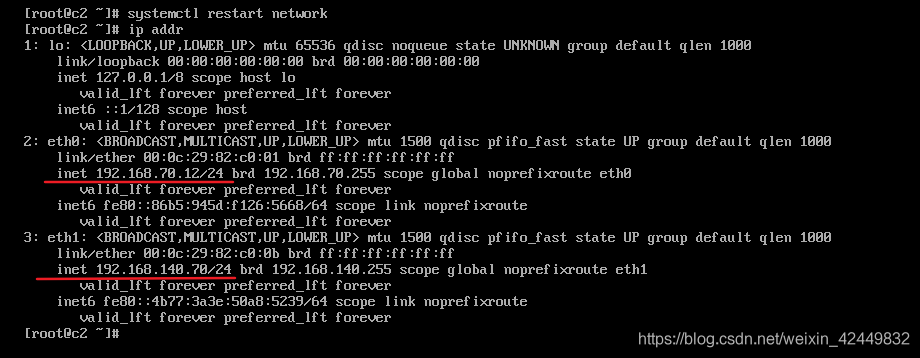

- 配置网卡信息并重启网卡

1)控制节点的网卡设置

vi /etc/sysconfig/network-scripts/ifcfg-eth0

vi /etc/sysconfig/network-scripts/ifcfg-eth1

systemctl restart network

ip addr

2)两个计算节点的设置如下

- 查看网卡情况与网络联通性

2.2 所有节点上的基本操作

- 注意:在同步运行时,需留意其他节点是否出现错误,以控制节点为例子

2.2.1 关闭防火墙、核心防护

[root@ct ~]#systemctl stop firewalld

[root@ct ~]#setenforce 0

[root@ct ~]#systemctl disable firewalld

[root@ct ~]# sed -i 's/SELINUX=enforcing/SELINUX=disabled/g' /etc/selinux/config

2.2.2 添加主机名映射

[root@ct ~]#vi /etc/hosts

...//添加以下映射

192.168.70.10 ct

192.168.70.11 c1

192.168.70.12 c2

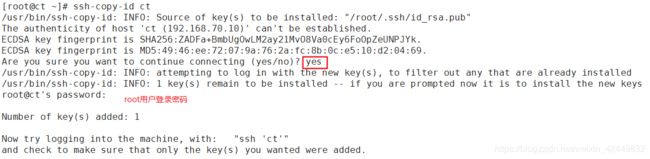

2.2.3 免交互的配置

- 生成密钥对,并发送给其他节点(三台设备同步进行)

[root@ct ~]# ssh-keygen -t rsa //出现提示信息,按回车即可

[root@ct ~]# ssh-copy-id ct

[root@ct ~]# ssh-copy-id c1

[root@ct ~]# ssh-copy-id c2

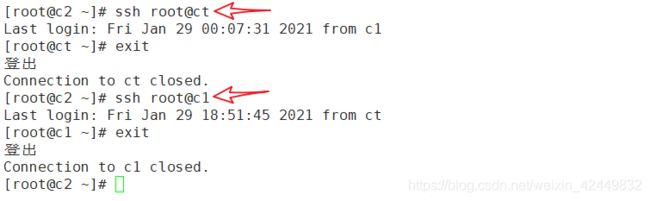

- 控制节点上,验证免交互是否配置完成

[root@ct ~]# ssh root@c1

Last login: Fri Jan 29 18:39:25 2021 from 192.168.70.1

[root@c1 ~]# exit

登出

Connection to c1 closed.

[root@ct ~]# ssh root@c2

Last login: Thu Jan 28 23:49:05 2021 from 192.168.70.1

[root@c2 ~]# exit

登出

Connection to c2 closed.

2.2.4 安装基础环境依赖包

- 也是面向所有设备进行安装

[root@controller ~]# yum -y install net-tools bash-completion vim gcc gcc-c++ make pcre pcre-devel expat-devel cmake bzip2

##net-tools: 可以使用ifconfig命令

##bash-completion: 表示自动补全

##pcre和pcre-devel: 表示支持正则和devel库

##expat-devel: 表示Apache依赖包,C语言开发,解析XML文档的开发库

[root@controller ~]# yum -y install centos-release-openstack-train python-openstackclient openstack-selinux openstack-utils

//centos-release-openstack-train:保证安装更新openstack版本为最新版本t版

##python-openstackclient:openstack的python客户端

##因为openstack中的API大多数是python编写的,并且连接数据库,也需要python

##openstack-selinux:openstack核心安全防护

##openstack-utils:openstack其它util工具

注意:以上安装均需安装两次以上,避免漏装

2.3 设置时间同步

2.3.1 控制节点上的配置

- 控制节点上安装同步软件

[root@ct ~]# yum -y install chrony

- 在控制节点上设置为同步源

[root@ct ~]# vi /etc/chrony.conf //默认指向centos时间同步服务器

...//添加修改

#server 0.centos.pool.ntp.org iburst //注释在线时间源

#server 1.centos.pool.ntp.org iburst //注释在线时间源

#server 2.centos.pool.ntp.org iburst //注释在线时间源

#server 3.centos.pool.ntp.org iburst //注释在线时间源

server ntp.aliyun.com iburst //设置为时间同步源

allow 192.168.70.0/24 //第26行下,添加为192.168.70网段提供时间同步

- 重启服务,更新时间同步源

[root@ct ~]# systemctl restart chronyd //重启服务

[root@ct ~]# systemctl enable chronyd //设置开机自启动

[root@ct ~]# chronyc sources //更新时间同步源

210 Number of sources = 1

MS Name/IP address Stratum Poll Reach LastRx Last sample

===============================================================================

^* 203.107.6.88 2 6 17 37 +336us[+1188us] +/- 25ms

- 注意:iburst可以直接同步一个大的时间跨度

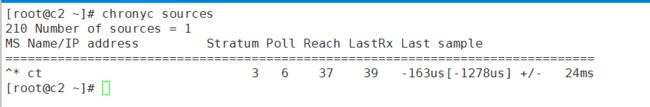

2.3.2 计算节点上的配置

- 计算节点上的配置几乎一样,这里以c1节点为例

安装软件

[root@c1 ~]# yum -y install chrony

修改配置文件

[root@c2 ~]# vi /etc/chrony.conf

#server 0.centos.pool.ntp.org iburst

#server 1.centos.pool.ntp.org iburst

#server 2.centos.pool.ntp.org iburst

#server 3.centos.pool.ntp.org iburst

server ct iburst //注释在线时间源,并添加ct为时间同步源

重启服务

[root@c1 ~]# systemctl restart chronyd

[root@c1 ~]# systemctl enable chronyd

时间同步

[root@c1 ~]# chronyc sources

210 Number of sources = 1

MS Name/IP address Stratum Poll Reach LastRx Last sample

===============================================================================

^* ct 3 6 7 2 +1030ns[+67838s] +/- 25ms

2.4 设置任务计划

- 面向所有节点

[root@ct ~]# which chronyc

/usr/bin/chronyc

[root@ct ~]# crontab -e

*/30 * * * * /usr/bin/chronyc sources >> /var/log/chronyc.log

注意:时间间隔设置不要太小,尽量拉长,因为频次太快,导致日志量越来越大,存储空间受影响

3. OpenStack系统环境配置

3.1 安装,配置MariaDB

3.1.1 安装软件

[root@controller ~]# yum -y install mariadb mariadb-server python2-PyMySQL

//此包用于openstack的控制端连接mysql所需要的模块,如果不安装,则无法连接数据库;且此包只安装在控制端

[root@controller ~]# yum -y install libibverbs //安装支持底层库文件

3.1.2 添加MySQL子配置文件

[root@ct ~]# vi /etc/my.cnf.d/openstack.cnf

[mysqld]

bind-address=192.168.70.10 //控制节点局域网地址

default-storage-engine=innodb //默认存储引擎

innodb_file_per_table=on //每张表独立表空间文件

max_connections=4096 //最大连接数

collation-server=utf8_general_ci //字符集

character-set-server=utf8

- 扩展

mysql 5.6(大版本)和mysql 5.7(小版本)区别:

大版本更新内容更为复杂

小版本更多是修复bug,打补丁

mysql 5.7把mysql 5.6 收购

在读写分离操作时 5.6与5.7,对应的默认库文件是 test mysql

客户端无法远程连接到数据库,由于5.7把 5.6 收购,故在5.7中进行调整:

底层库文件 test mysql 库文件

表空间(类似名称空间)

名称文件:是一种相互独立的隔离环境

3.1.3 开启服务并设置开机自启动

[root@ct ~]# systemctl start mariadb

[root@ct ~]# systemctl enable mariadb

3.1.4 执行MariaDB 安全配置脚本

[root@controller ~]# mysql_secure_installation

Enter current password for root (enter for none): //当前密码,没有回车

Set root password? [Y/n] y //是否设置密码,设置密码为 abc123

New password:

Re-enter new password:

Password updated successfully!

Reloading privilege tables..

... Success!

Remove anonymous users? [Y/n] y //是否移除匿名账户,移除

... skipping.

Disallow root login remotely? [Y/n] n //不允许root账户远程登录

Remove test database and access to it? [Y/n] y //是否移除test数据库,空数据库

- Dropping test database...

... Success!

- Removing privileges on test database...

... Success!

Reload privilege tables now? [Y/n] y //是否重置权限的表,重置

... Success!

3.1.5 登录数据库并验证

[root@ct ~]# mysql -uroot -pabc123 //登录数据库

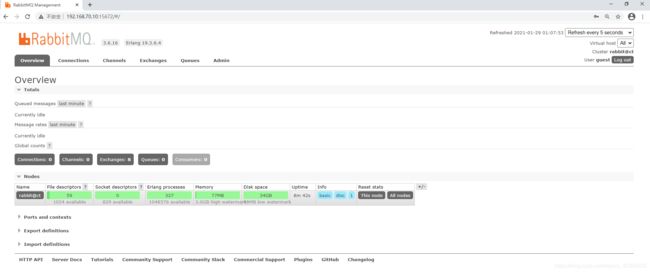

3.2 安装RabbitMQ(消息队列)

- 所有创建虚拟机的指令,控制端都会发送到rabbitmq,node节点监听rabbitmq

3.2.1 RabbitMQ的相关配置

(1)安装软件

[root@ct ~]# yum -y install rabbitmq-server

(2)启动RabbitMQ服务,并设置其开机启动

[root@ct ~]# systemctl enable rabbitmq-server

Created symlink from /etc/systemd/system/multi-user.target.wants/rabbitmq-server.service to /usr/lib/systemd/system/rabbitmq-server.service.

[root@ct ~]# systemctl start rabbitmq-server

(3)创建消息队列用户,用于controler和node节点连接rabbitmq的认证

[root@ct ~]# rabbitmqctl add_user openstack RABBIT_PASS

Creating user "openstack"

(4)配置openstack用户的操作权限(正则,配置读写权限)

[root@ct ~]# rabbitmqctl set_permissions openstack ".*" ".*" ".*"

Setting permissions for user "openstack" in vhost "/"

为什么需要配置读写权限:

Nova与Keystone进行通讯

1.rabbidb,把nova请求读取写入到本地内部

2.Nova把请求相关写入到Rabbitmq的内部

3.把消息传递过程中,也会进行读写操作

故授予独立的用户身份,读写权限

(5)查询端口

[root@ct ~]# netstat -anptu | grep 5672

tcp 0 0 0.0.0.0:25672 0.0.0.0:* LISTEN 16125/beam.smp

tcp6 0 0 :::5672 :::* LISTEN 16125/beam.smp

//5672是Rabbitmq默认端口,25672是Rabbit的测试工具CLI的端口

[root@ct ~]# rabbitmq-plugins list

(7)开启rabbitmq的web管理界面的插件,端口为15672

[root@ct ~]# rabbitmq-plugins enable rabbitmq_management

[root@ct ~]# netstat -anptu | grep 5672

tcp 0 0 0.0.0.0:25672 0.0.0.0:* LISTEN 16125/beam.smp

tcp 0 0 0.0.0.0:15672 0.0.0.0:* LISTEN 16125/beam.smp

tcp 0 0 192.168.70.10:37068 192.168.70.10:25672 TIME_WAIT -

tcp6 0 0 :::5672 :::* LISTEN 16125/beam.smp

3.2.2 访问验证

3.3 安装memcached

3.3.1 memcached概述

作用:

- 安装memcached是用于存储session信息;服务身份验证机制使用Memcached来缓存令牌 在登录openstack的dashboard时,会产生一些session信息,这些session信息会存放到memcached中

memcached介绍:

1.Memcached是一个自由开源的, 高性能,分布式内存对象缓存系统。

2.Memcached是以LiveJourmal旗下Danga Interactive公司的Brad Fitzpatric为首开发的一款软件。现在已成为

mixi、hatena、 Facebook. Vox、 LiveJournal等众多服务中提高Web应用扩展性的重要因素

3.Memcached是一种基于内存的key-value存储,用来存储小块的任意数据(字符串、对象)。这些数据可以是数据库调用、

API调用或者是页面渲染的结果

4.Memcached简洁而强大。它的简洁设计便于快速开发,减轻开发难度,解决了大数据量缓存的很多问题。它的API兼容

大部分流行的开发语言。

本质上,它是一个简洁的key-value存储系统。

一般的使用目的是,通过缓存数据库查询结果,减少数据库访问次数,以提高动态Web应用的速度、提高可扩展性。

并且在BAT里,redis已经逐渐取代了memcached,成为分布式场景广泛使用的缓存方案

3.3.2 配置memcached

- 安装软件

[root@ct ~]# yum install -y memcached python-memcached

//python-*模块在OpenStack中起到连接数据库的作用

- 修改memcached配置文件

[root@ct ~]# vi /etc/sysconfig/memcached

PORT="11211" //默认端口号

USER="memcached" //默认账户名

MAXCONN="1024" //最大连接数

CACHESIZE="64" //缓存大小

OPTIONS="-l 127.0.0.1,::1,ct" //修改,添加主机名ct

- 重启服务,查看端口

[root@ct ~]# vi /etc/sysconfig/memcached

[root@ct ~]# systemctl enable memcached

Created symlink from /etc/systemd/system/multi-user.target.wants/memcached.service to /usr/lib/systemd/system/memcached.service.

[root@ct ~]# systemctl start memcached

[root@ct ~]# netstat -anptu | grep 11211

tcp 0 0 192.168.70.10:11211 0.0.0.0:* LISTEN 17659/memcached

tcp 0 0 127.0.0.1:11211 0.0.0.0:* LISTEN 17659/memcached

tcp6 0 0 ::1:11211 :::* LISTEN 17659/memcached

3.4 安装etcd

3.4.1 etcd特点

简单: 基于HTTP+JSON的API让你可以用CURL命令就可以轻松使用。

安全: 可以选择SSL客户认证机制。

快速: 每个实例每秒支持一千次写操作。

可信: 使用Ralf算法充分实现了分布式。

3.4.2 应用场景

- 服务发现

- 消息发布和订阅

- 负载均衡

- 分布式通知与协调

- 分布式锁

- 分布式队列

- 集群监控与Leader竞选

扩展:

为什么使用etcd而不用Zookeeper?

相比较之下,Zookeeper有如下缺点:

1.复杂。 Zookeeper的部署维护复杂,管理员必须掌握一系列的知识和技能;而Paxos强一致性算法也是素来以复杂难懂

而闻名于世;另外,Zookeeper的使用也比较复杂,需要安装客户端,官方只提供Java和C的两种语言的接口。

2.Java编写。这里不是对Java有偏见,而是Java本身就偏向重型应用,它会引入大量的依赖。而运维人员则普遍希望机器

集群能尽可能的简单,维护起来也不容易出错

3.发展缓慢。 Apache基金会项目特有的“Apache Way”在开源界也饱受争议,其中一大原因就是由于基金会庞大的结构

和松散的管理导致项目发展缓慢。

etcd作为一个后起之秀,其优点也很明显:

1.简单。 使用Go编写部署简单;使用HTTP作为接口使用简单;使用Raft算法保证强一致性让用户易于理解。

2.数据持久化。 etcd默认数据一更新就进行持久化。

3.安全。 etcd支持SSL客户端安全认证。

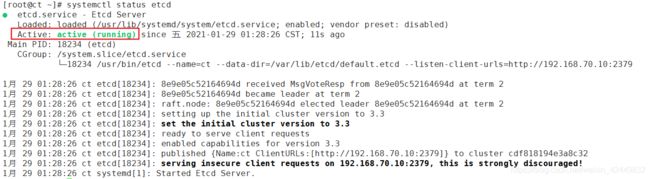

3.4.3 安装etcd的配置

- 安装软件

[root@ct ~]# yum -y install etcd

- 修改etcd配置文件

[root@ct ~]# vi /etc/etcd/etcd.conf

...//修改以下配置

5 ETCD_LISTEN_PEER_URLS="http://192.168.100.11:2380"

6 ETCD_LISTEN_CLIENT_URLS="http://192.168.100.11:2379"

9 ETCD_NAME="controller"

20 ETCD_INITIAL_ADVERTISE_PEER_URLS="http://192.168.100.11:2380"

21 ETCD_ADVERTISE_CLIENT_URLS="http://192.168.100.11:2379"

26 ETCD_INITIAL_CLUSTER="controller=http://192.168.100.11:2380"

27 ETCD_INITIAL_CLUSTER_TOKEN="etcd-cluster-01"

28 ETCD_INITIAL_CLUSTER_STATE="new"

- 启动服务并设置开机自启

[root@ct ~]# systemctl enable etcd

Created symlink from /etc/systemd/system/multi-user.target.wants/etcd.service to /usr/lib/systemd/system/etcd.service.

[root@ct ~]# systemctl start etcd

[root@ct ~]# systemctl status etcd

- 检测端口

[root@ct ~]# netstat -anpt | grep 2379