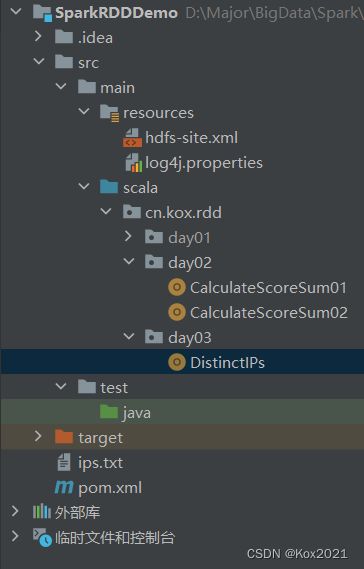

Spark大数据处理学习笔记(3.2.1)掌握RDD算子

该文章主要为完成实训任务,详细实现过程及结果见【http://t.csdn.cn/FArNP】

文章目录

- 一、准备工作

-

- 1.1 准备文件

-

- 1. 准备本地系统文件

- 2. 把文件上传到

- 1.2 启动Spark Shell

-

- 1. 启动HDFS服务

- 2. 启动Spark服务

- 3. 启动Spark Shell

- 二、掌握转换算子

-

- 2.1 映射算子 - map()

-

- 1. 映射算子功能

- 2. 映射算子案例

-

- 任务1、将rdd1每个元素翻倍得到rdd2

- 任务2、将rdd1每个元素平方得到rdd2

- 任务3、利用映射算子打印菱形

- 2.2 过滤算子 - filter()

-

- 1. 过滤算子功能

- 2. 过滤算子案例

-

- 任务1、过滤出列表中的偶数

- 任务2、过滤出文件中包含spark的行

- 任务3、利用过滤算子输出[2000, 2500]之间的全部闰年

- 任务4、利用过滤算子输出[10, 100]之间的全部素数

- 2.3 扁平映射算子 - flatMap()

-

- 1. 扁平映射算子功能

- 2. 扁平映射算子案例

-

- 任务1、统计文件中单词个数

-

- 方法一、利用Scala来实现

- 方法二、利用Spark RDD来实现

- 2.4 按键归约算子 - reduceByKey()

-

- 1. 按键归约算子功能

- 2. 按键归约算子案例

-

- 任务1、在Spark Shell里计算学生总分

- 任务2、在IDEA里计算学生总分

- 2.5 合并算子 - union()

-

- 1. 合并算子功能

- 2. 合并算子案例

- 2.6 排序算子 - sortBy()

-

- 1. 排序算子功能

- 2. 排序算子案例

- 2.7 按键排序算子 - sortByKey()

-

- 1. 按键排序算子功能

- 2. 按键排序算子案例

- 2.8 连接算子

-

- 1. 内连接算子 - join()

- 2. 左外连接算子 - leftOuterJoin()

- 3. 右外连接算子 - rightOuterJoin()

- 4. 全外连接算子 - fullOuterJoin()

- 2.9 交集算子 - intersection()

- 2.10 去重算子 - distinct()

-

- 1. 去重算子案例

- 2. IP地址去重案例

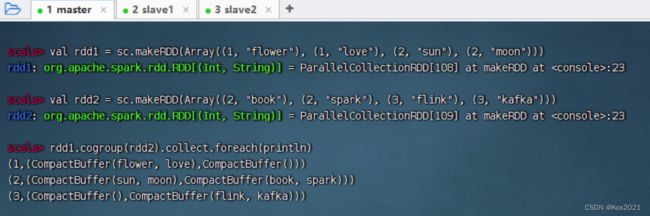

- (十一)组合分组算子 - cogroup()

一、准备工作

1.1 准备文件

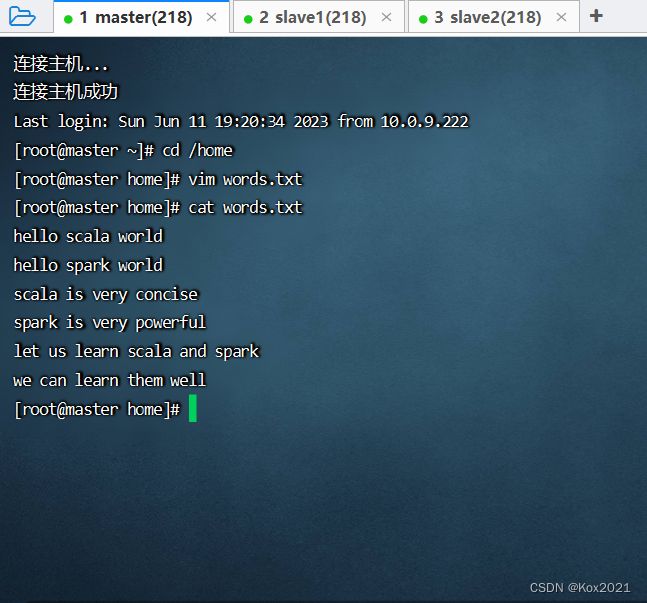

1. 准备本地系统文件

2. 把文件上传到

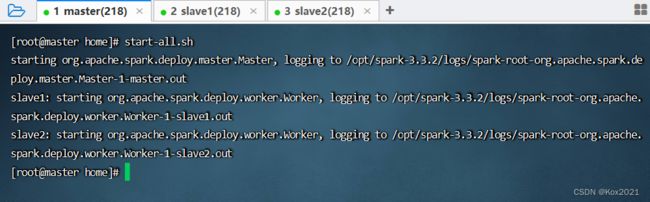

1.2 启动Spark Shell

1. 启动HDFS服务

2. 启动Spark服务

3. 启动Spark Shell

二、掌握转换算子

2.1 映射算子 - map()

1. 映射算子功能

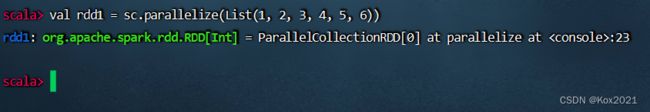

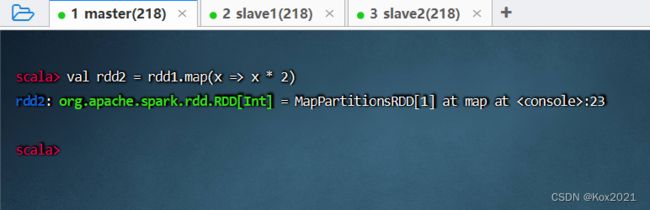

- map()是一种转换算子,它接收一个函数作为参数,并把这个函数应用于RDD的每个元素,最后将函数的返回结果作为结果RDD中对应元素的值。

2. 映射算子案例

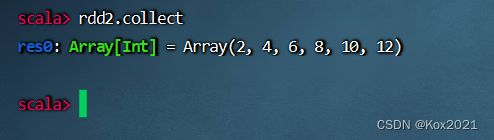

任务1、将rdd1每个元素翻倍得到rdd2

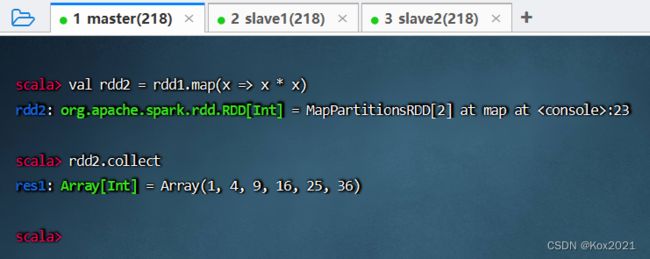

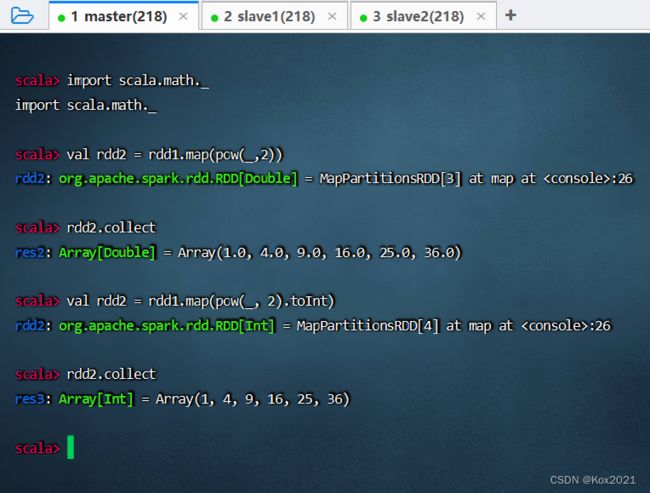

任务2、将rdd1每个元素平方得到rdd2

任务3、利用映射算子打印菱形

(1)Spark Shell里实现

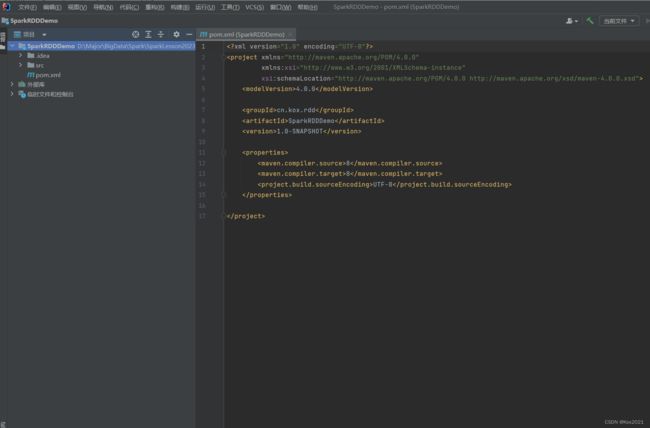

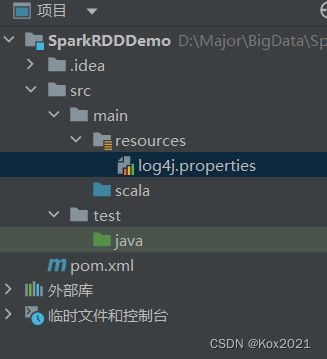

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<modelVersion>4.0.0modelVersion>

<groupId>cn.kox.rddgroupId>

<artifactId>SparkRDDDemoartifactId>

<version>1.0-SNAPSHOTversion>

<dependencies>

<dependency>

<groupId>org.scala-langgroupId>

<artifactId>scala-libraryartifactId>

<version>2.12.15version>

dependency>

<dependency>

<groupId>org.apache.sparkgroupId>

<artifactId>spark-core_2.12artifactId>

<version>3.1.3version>

dependency>

dependencies>

<build>

<sourceDirectory>src/main/scalasourceDirectory>

build>

<properties>

<maven.compiler.source>8maven.compiler.source>

<maven.compiler.target>8maven.compiler.target>

<project.build.sourceEncoding>UTF-8project.build.sourceEncoding>

properties>

project>

log4j.rootLogger=ERROR, stdout, logfile

log4j.appender.stdout=org.apache.log4j.ConsoleAppender

log4j.appender.stdout.layout=org.apache.log4j.PatternLayout

log4j.appender.stdout.layout.ConversionPattern=%d %p [%c] - %m%n

log4j.appender.logfile=org.apache.log4j.FileAppender

log4j.appender.logfile.File=target/rdd.log

log4j.appender.logfile.layout=org.apache.log4j.PatternLayout

log4j.appender.logfile.layout.ConversionPattern=%d %p [%c] - %m%n

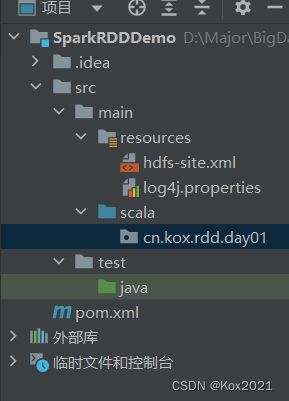

<configuration>

<property>

<description>only config in clientsdescription>

<name>dfs.client.use.datanode.hostnamename>

<value>truevalue>

property>

configuration>

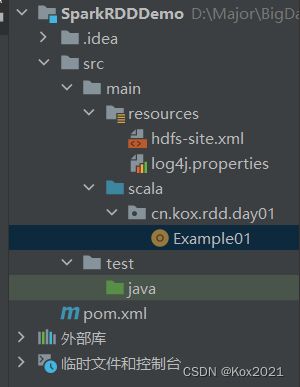

package cn.kox.rdd.day01

import org.apache.spark.{SparkConf, SparkContext}

import scala.collection.mutable.ListBuffer

import scala.io.StdIn

/**

* @ClassName: Example01

* @Author: Kox

* @Data: 2023/6/12

* @Sketch:

*/

object Example01 {

def main(args: Array[String]): Unit = {

// 创建Spark配置对象

val conf = new SparkConf()

.setAppName("PrintDiamond") // 设置应用名称

.setMaster("local[*]") // 设置主节点位置(本地调试)

// 基于Spark配置对象创建Spark容器

val sc = new SparkContext(conf)

// 输入一个奇数

print("输入一个奇数:")

val n = StdIn.readInt()

//判断n的奇偶性

if (n % 2 == 0) {

println("温馨提示:你输入的不是奇数")

return

}

// 创建一个可变列表

val list = new ListBuffer[Int]()

// 给列表赋值

(1 to n by 2).foreach(list.append(_))

(n - 2 to 1 by -2).foreach(list.append(_))

// 基于列表创建rdd

val rdd = sc.makeRDD(list)

// 对rdd进行映射操作

val rdd1 = rdd.map(i => " " * ((n - i) / 2) + "*" * i)

// 输出rdd1结果

rdd1.collect.foreach(println)

}

}

2.2 过滤算子 - filter()

1. 过滤算子功能

- filter(func):通过函数func对源RDD的每个元素进行过滤,并返回一个新RDD,一般而言,新RDD元素个数会少于原RDD。

2. 过滤算子案例

任务1、过滤出列表中的偶数

- 整数(Integer):奇数(odd number)+ 偶数(even number)

- 基于列表创建RDD,然后利用过滤算子得到偶数构成的新RDD

- 方法一、将匿名函数传给过滤算子

- 方法二、用神奇占位符改写传入过滤算子的匿名函数

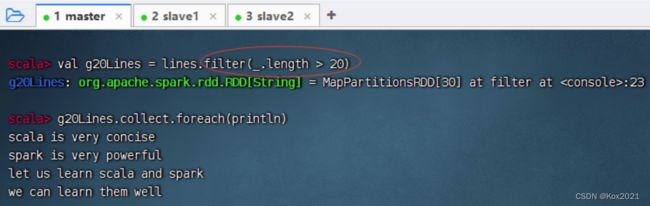

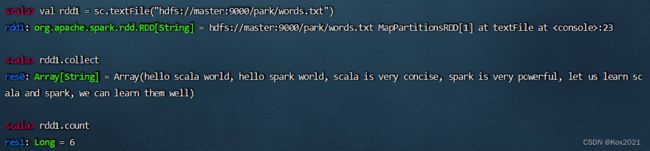

任务2、过滤出文件中包含spark的行

- 查看源文件

/park/words.txt内容

- 执行命令:

val lines= sc.textFile("/park/words.txt"),读取文件/park/words.txt生成RDD -lines

- 执行命令:

val sparkLines = lines.filter(_.contains("spark")),过滤包含spark的行生成RDD - sparkLines

- 执行命令:

sparkLines.collect,查看sparkLines内容,可以采用遍历算子,分行输出内容

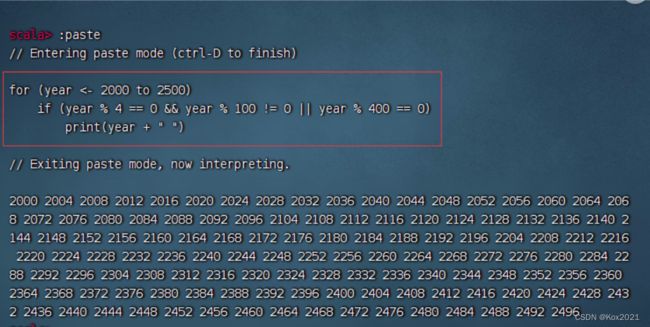

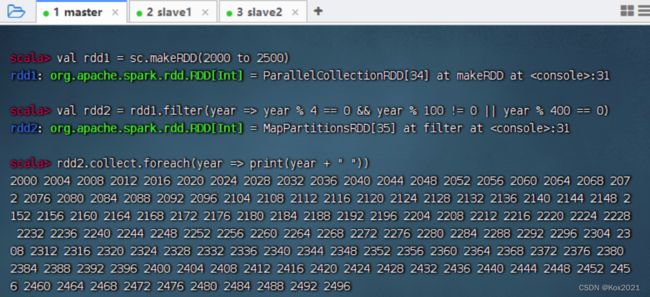

任务3、利用过滤算子输出[2000, 2500]之间的全部闰年

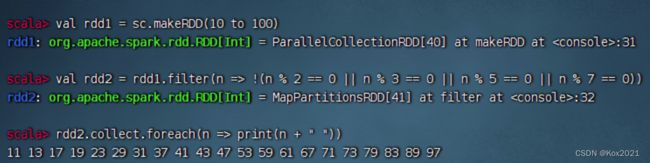

任务4、利用过滤算子输出[10, 100]之间的全部素数

2.3 扁平映射算子 - flatMap()

1. 扁平映射算子功能

- flatMap()算子与map()算子类似,但是每个传入给函数func的RDD元素会返回0到多个元素,最终会将返回的所有元素合并到一个RDD。

2. 扁平映射算子案例

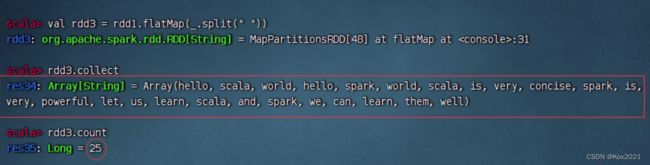

任务1、统计文件中单词个数

- 读取文件,生成RDD - rdd1,查看其内容和元素个数

- 对于rdd1按空格拆分,做映射,生成新RDD - rdd2

- 对于rdd1按空格拆分,做扁平映射,生成新RDD - rdd3,有一个降维处理的效果

- 统计结果:文件里有25个单词

方法一、利用Scala来实现

package cn.kox.rdd.day01

import org.apache.spark.{SparkConf, SparkContext}

/**

* @ClassName: Example02

* @Author: Kox

* @Data: 2023/6/12

* @Sketch:

*/

object Example02 {

def main(args: Array[String]): Unit = {

// 创建不规则二维列表

val mat = List(

List(7, 8, 1, 5),

List(10, 4, 9),

List(7, 2, 8, 1, 4),

List(21, 4, 7, -4)

)

// 输出二维列表

println(mat)

// 将二维列表扁平化为一维列表

val arr = mat.flatten

// 输出一维列表

println(arr)

// 输出元素个数

println("元素个数:" + arr.size)

}

}

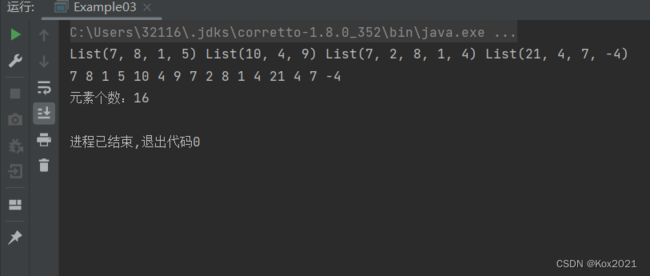

方法二、利用Spark RDD来实现

- 利用flatMap算子

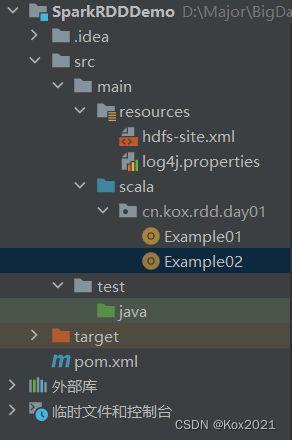

- 在

cn.kox.rdd.day01包里创建Example03单例对象

package cn.kox.rdd.day01

import org.apache.spark.{SparkConf, SparkContext}

/**

* @ClassName: Example03

* @Author: Kox

* @Data: 2023/6/12

* @Sketch:

*/

object Example03 {

def main(args: Array[String]): Unit = {

// 创建Spark配置对象

val conf = new SparkConf()

.setAppName("PrintDiamond") // 设置应用名称

.setMaster("local[*]") // 设置主节点位置(本地调试)

// 基于Spark配置对象创建Spark容器

val sc = new SparkContext(conf)

// 创建不规则二维列表

val mat = List(

List(7, 8, 1, 5),

List(10, 4, 9),

List(7, 2, 8, 1, 4),

List(21, 4, 7, -4)

)

// 基于二维列表创建rdd1

val rdd1 = sc.makeRDD(mat)

// 输出rdd1

rdd1.collect.foreach(x => print(x + " "))

println()

// 进行扁平化映射

val rdd2 = rdd1.flatMap(x => x.toString.substring(5, x.toString.length - 1).split(", "))

// 输出rdd2

rdd2.collect.foreach(x => print(x + " "))

println()

// 输出元素个数

println("元素个数:" + rdd2.count)

}

}

- 运行程序,查看结果

2.4 按键归约算子 - reduceByKey()

1. 按键归约算子功能

- reduceByKey()算子的作用对像是元素为(key,value)形式(Scala元组)的RDD,使用该算子可以将相同key的元素聚集到一起,最终把所有相同key的元素合并成一个元素。该元素的key不变,value可以聚合成一个列表或者进行求和等操作。最终返回的RDD的元素类型和原有类型保持一致。

2. 按键归约算子案例

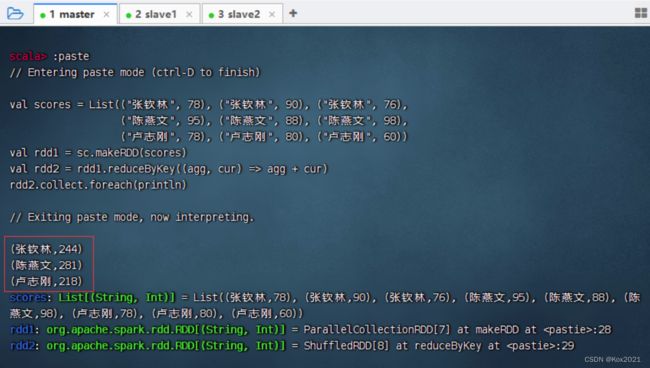

任务1、在Spark Shell里计算学生总分

val scores = List(("张钦林", 78), ("张钦林", 90), ("张钦林", 76),

("陈燕文", 95), ("陈燕文", 88), ("陈燕文", 98),

("卢志刚", 78), ("卢志刚", 80), ("卢志刚", 60))

val rdd1 = sc.makeRDD(scores)

val rdd2 = rdd1.reduceByKey((x, y) => x + y)

rdd2.collect.foreach(println)

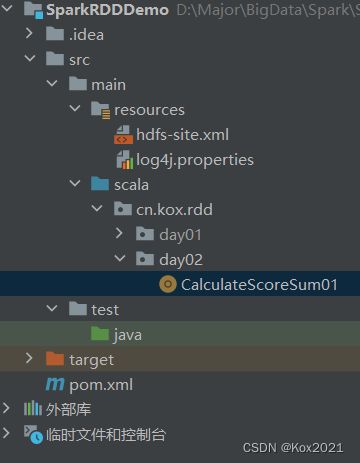

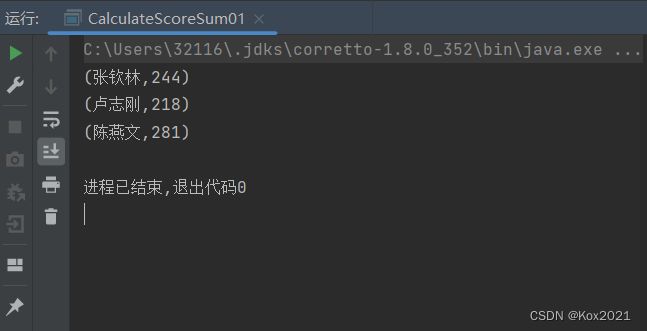

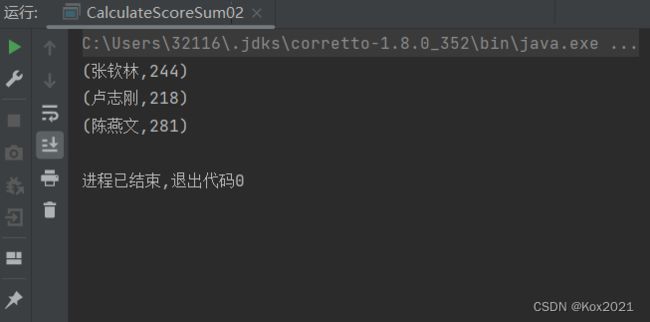

任务2、在IDEA里计算学生总分

package cn.kox.rdd.day02

import org.apache.spark.{SparkConf, SparkContext}

/**

* @ClassName: CalculateScoreSum01

* @Author: Kox

* @Data: 2023/6/12

* @Sketch:

*/

object CalculateScoreSum01 {

def main(args: Array[String]): Unit = {

// 创建Spark配置对象

val conf = new SparkConf()

.setAppName("PrintDiamond") // 设置应用名称

.setMaster("local[*]") // 设置主节点位置(本地调试)

// 基于Spark配置对象创建Spark容器

val sc = new SparkContext(conf)

// 创建二元组成绩列表

val scores = List(

("张钦林", 78), ("张钦林", 90), ("张钦林", 76),

("陈燕文", 95), ("陈燕文", 88), ("陈燕文", 98),

("卢志刚", 78), ("卢志刚", 80), ("卢志刚", 60))

// 基于二元组成绩列表创建RDD

val rdd1 = sc.makeRDD(scores)

// 对成绩RDD进行按键归约处理

val rdd2 = rdd1.reduceByKey(_ + _)

// 输出归约处理结果

rdd2.collect.foreach(println)

}

}

package cn.kox.rdd.day02

import org.apache.spark.{SparkConf, SparkContext}

import scala.collection.mutable.ListBuffer

/**

* @ClassName: CalculateScoreSum02

* @Author: Kox

* @Data: 2023/6/12

* @Sketch:

*/

object CalculateScoreSum02 {

def main(args: Array[String]): Unit = {

// 创建Spark配置对象

val conf = new SparkConf()

.setAppName("PrintDiamond") // 设置应用名称

.setMaster("local[*]") // 设置主节点位置(本地调试)

// 基于Spark配置对象创建Spark容器

val sc = new SparkContext(conf)

// 创建四元组成绩列表

val scores = List(

("张钦林", 78, 90, 76),

("陈燕文", 95, 88, 98),

("卢志刚", 78, 80, 60)

)

// 将四元组成绩列表转化成二元组成绩列表

val newScores = new ListBuffer[(String, Int)]()

// 通过遍历算子遍历四元组成绩列表

scores.foreach(score => {

newScores.append(Tuple2(score._1, score._2))

newScores.append(Tuple2(score._1, score._3))

newScores.append(Tuple2(score._1, score._4))

}

)

// 基于二元组成绩列表创建RDD

val rdd1 = sc.makeRDD(newScores)

// 对成绩RDD进行按键归约处理

val rdd2 = rdd1.reduceByKey(_ + _)

// 输出归约处理结果

rdd2.collect.foreach(println)

}

}

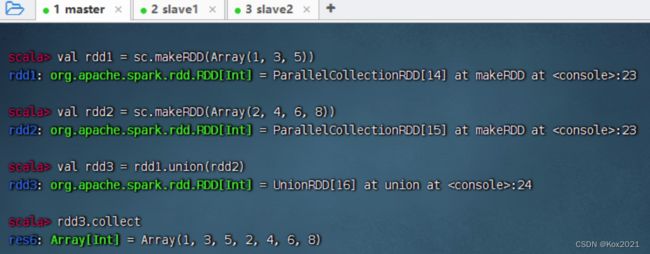

2.5 合并算子 - union()

1. 合并算子功能

- union()算子将两个RDD合并为一个新的RDD,主要用于对不同的数据来源进行合并,两个RDD中的数据类型要保持一致。

2. 合并算子案例

- 创建两个RDD,合并成一个新RDD

- 课堂练习:将两个二元组成绩表合并

- 在集合运算里,并集符号:∪ \cup∪,并集运算:A ∪ B A \cup BA∪B

- 在集合运算里,交集符号:∩ \cap∩,交集运算:A ∩ B A \cap BA∩B

- 在集合运算里,补集运算:A ˉ \bar A

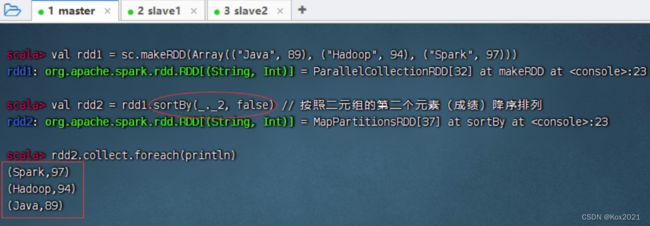

2.6 排序算子 - sortBy()

1. 排序算子功能

- sortBy()算子将RDD中的元素按照某个规则进行排序。该算子的第一个参数为排序函数,第二个参数是一个布尔值,指定升序(默认)或降序。若需要降序排列,则需将第二个参数置为false。

2. 排序算子案例

- 一个数组中存放了三个元组,将该数组转为RDD集合,然后对该RDD按照每个元素中的第二个值进行降序排列。

- sortBy(x=>x._2,false)中的x代表rdd1中的每个元素。由于rdd1的每个元素是一个元组,因此使用x._2取得每个元素的第二个值。当然,sortBy(x=>x.2,false)也可以直接简化为sortBy(._2,false)。

2.7 按键排序算子 - sortByKey()

1. 按键排序算子功能

- sortByKey()算子将(key, value)形式的RDD按照key进行排序。默认升序,若需降序排列,则可以传入参数false。

2. 按键排序算子案例

- 将三个二元组构成的RDD按键先降序排列,然后升序排列

- 其实,用排序算子也是可以搞定的

2.8 连接算子

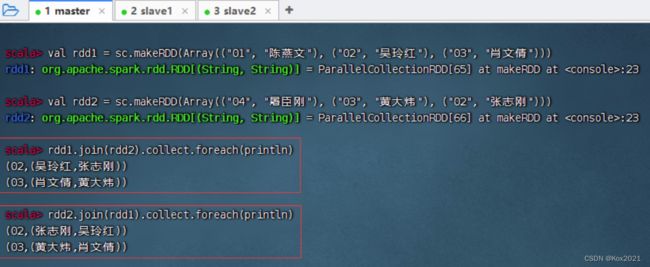

1. 内连接算子 - join()

2. 左外连接算子 - leftOuterJoin()

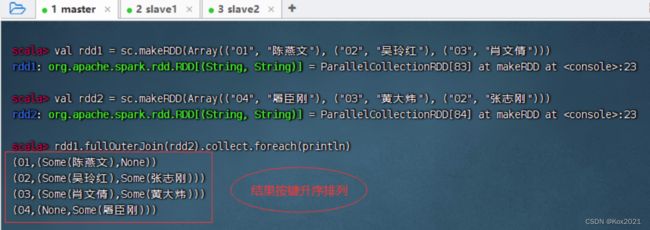

- leftOuterJoin()算子与数据库的左外连接类似,以左边的RDD为基准(例如rdd1.leftOuterJoin(rdd2),以rdd1为基准),左边RDD的记录一定会存在。例如,rdd1的元素以(k,v)表示,rdd2的元素以(k, w)表示,进行左外连接时将以rdd1为基准,rdd2中的k与rdd1的k相同的元素将连接到一起,生成的结果形式为(k, (v, Some(w))。rdd1中其余的元素仍然是结果的一部分,元素形式为(k,(v, None)。Some和None都属于Option类型,Option类型用于表示一个值是可选的(有值或无值)。若确定有值,则使用Some(值)表示该值;若确定无值,则使用None表示该值。

- rdd1与rdd2进行左外连接

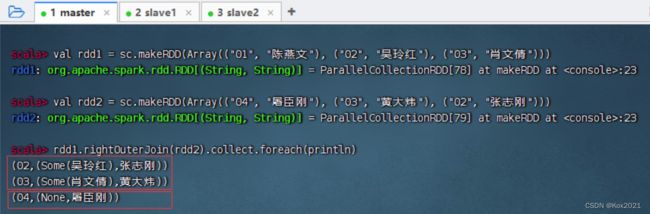

3. 右外连接算子 - rightOuterJoin()

- rightOuterJoin()算子的使用方法与leftOuterJoin()算子相反,其与数据库的右外连接类似,以右边的RDD为基准(例如rdd1.rightOuterJoin(rdd2),以rdd2为基准),右边RDD的记录一定会存在。

- rdd1与rdd2进行右外连接

4. 全外连接算子 - fullOuterJoin()

2.9 交集算子 - intersection()

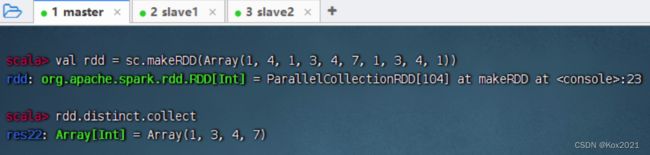

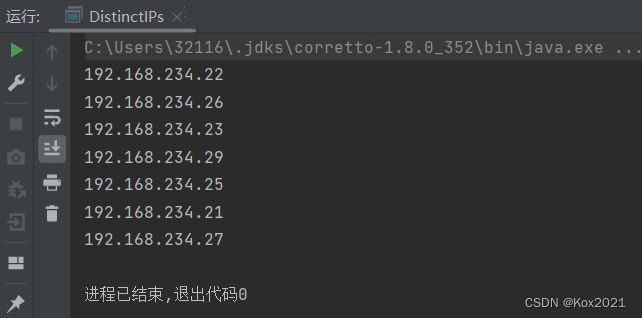

2.10 去重算子 - distinct()

- distinct()算子对RDD中的数据进行去重操作,返回一个新的RDD。有点类似与集合的不允许重复元素。

1. 去重算子案例

2. IP地址去重案例

192.168.234.21

192.168.234.22

192.168.234.21

192.168.234.21

192.168.234.23

192.168.234.21

192.168.234.21

192.168.234.21

192.168.234.25

192.168.234.21

192.168.234.21

192.168.234.26

192.168.234.21

192.168.234.27

192.168.234.21

192.168.234.27

192.168.234.21

192.168.234.29

192.168.234.21

192.168.234.26

192.168.234.21

192.168.234.25

192.168.234.25

192.168.234.21

192.168.234.22

192.168.234.21

package cn.kox.rdd.day03

import org.apache.spark.{SparkConf, SparkContext}

/**

* @ClassName: DistinctIPs

* @Author: Kox

* @Data: 2023/6/12

* @Sketch:

*/

object DistinctIPs {

def main(args: Array[String]): Unit = {

// 创建Spark配置对象

val conf = new SparkConf()

.setAppName("DistinctIPs ") // 设置应用名称

.setMaster("local[*]") // 设置主节点位置(本地调试)

// 基于Spark配置对象创建Spark容器

val sc = new SparkContext(conf)

// 读取本地IP地址文件,得到RDD

val ips = sc.textFile("D:\\Major\\BigData\\Spark\\SparkLesson2023U\\SparkRDDDemo\\ips.txt")

// rdd去重再输出

ips.distinct.collect.foreach(println)

}

}