chatGPT 学习笔记

学习笔记:chatGPT

chatGPT 概述

什么是 chatGPT ?(要说明定义、来源、功能和特点)

ChatGPT 是 OpenAI 开发的一个大型预训练语言模型,它基于 GPT-3.5 模型,可以在对话中生成类似人类的文本响应¹,简称对齐。它使用自监督学习技术进行语言模型训练,能够自动生成高质量的对话,具有广泛的应用场景¹。它是一种基于 Transformer 架构的深度学习模型,可以处理问答、对话生成、文本生成等多种任务¹。

Source: Conversation with Bing, 2023/5/29

(1) 科普:什么是ChatGPT?(文末有彩蛋)_腾讯新闻. https://new.qq.com/rain/a/20221206A0403800.

(2) Introducing ChatGPT - OpenAI. https://openai.com/blog/chatgpt.

(3) ChatGPT - 维基百科,自由的百科全书. https://zh.wikipedia.org/wiki/ChatGPT.

(4) What is ChatGPT and why does it matter? Here’s what you … https://www.zdnet.com/article/what-is-chatgpt-and-why-does-it-matter-heres-everything-you-need-to-know/.

(5) ChatGPT - Wikipedia. https://en.wikipedia.org/wiki/ChatGPT.

chatGPT 的结构和工作原理

ChatGPT 的结构和工作原理是这样的:

- ChatGPT 基于 GPT-3.5 模型,后者是 GPT-3 的改进版本,估计拥有 15 亿参数。使用了更大的数据集和更高的计算能力¹。

- ChatGPT 是一个 Transformer 模型,由多层自注意力机制组成,可以捕捉文本中的长距离上下文³。

- ChatGPT 使用了自回归的方式,即根据前面的文本生成下一个词,从而实现文本生成的功能³。

- ChatGPT 采用了对话格式的输入和输出,即输入是一个由用户和系统角色构成的对话历史,输出是一个系统角色的回复²。

- ChatGPT 使用了监督学习和强化学习相结合的方法进行微调,其中强化学习使用了人类反馈作为奖励信号,以提高模型的对齐性¹。对齐性指的是模型的目标和行为与人类的价值和期望的一致性¹。

Source: Conversation with Bing, 2023/5/29

(1) How ChatGPT actually works - AssemblyAI. https://www.assemblyai.com/blog/how-chatgpt-actually-works/.

(2) How does ChatGPT work? | Zapier. https://zapier.com/blog/how-does-chatgpt-work/.

(3) Learn how to work with the ChatGPT and GPT-4 models (preview). https://learn.microsoft.com/en-us/azure/cognitive-services/openai/how-to/chatgpt.

chatGPT 系列的参数量

GPT-4 参数终极指南:您需要了解的有关 NLP 游戏规则改变者的所有信息

chatGPT 的主要目的和应用场景是什么?

chatGPT 的主要目的和应用场景是:

- 主要目的:chatGPT 的主要目的是利用人工智能技术,实现自然语言理解和生成,提供与人类类似的对话能力,满足不同领域和场景的需求¹。

- 应用场景:chatGPT 可以应用于多种领域和场景,例如:

- 客服:chatGPT 可以作为一个智能客服机器人,为用户提供快速、准确、友好的服务,解决用户的问题和需求²。

- 教育:chatGPT 可以作为一个智能教育助理,为学生提供个性化的学习指导,回答学生的问题,评估学生的进度,激发学生的兴趣²。

- 娱乐:chatGPT 可以作为一个智能娱乐伙伴,为用户提供有趣、有创意、有价值的内容,例如写诗、编故事、画图等³。

- 内容创作:chatGPT 可以作为一个智能内容创作工具,为内容创作者提供灵感、建议、优化等,帮助内容创作者提高效率和质量。

Source: Conversation with Bing, 2023/5/29

(1) [2304.09103] ChatGPT: Applications, Opportunities, and Threats. https://arxiv.org/abs/2304.09103.

(2) ChatGPT Use Cases: 20 Ways to Use it Effectively. https://emeritus.org/blog/ai-and-ml-chatgpt-use-cases/.

(3) What is ChatGPT, DALL-E, and generative AI? | McKinsey. https://www.mckinsey.com/featured-insights/mckinsey-explainers/what-is-generative-ai.

chatGPT 的主要特点和优势是什么?

chatGPT 的主要特点和优势是:

- 主要特点:chatGPT 的主要特点是它可以理解和生成自然语言,提供与人类类似的对话能力,根据用户的输入和上下文生成合适的回复¹。它还可以根据用户的需求,提供创造性的内容,例如写诗、编故事、画图等²。它是基于 GPT-3 和 GPT-4 模型的,使用了大规模的预训练数据和强化学习的方法,不断地优化自己的输出³。

- 优势:chatGPT 的优势有以下几点:

- 它可以提供实时的支持,24 小时不间断,让用户更快地得到帮助⁴。

- 它可以同时处理多个对话,节省时间和资源⁴。

- 它可以提供更个性化的体验,因为它可以理解语言的细微差别,并提供个性化的回复⁴。

- 它可以提高工作效率和质量,因为它可以为各种领域和场景提供灵感、建议、优化等²。

Source: Conversation with Bing, 2023/5/29

(1) ChatGPT review, features, advantages and disadvantages. https://www.online-sciences.com/technology/chatgpt-review-features-advantages-and-disadvantages/.

(2) ChatGPT explained: everything you need to know about the … https://www.techradar.com/news/chatgpt-explained.

(3) The Advantages and Disadvantages of ChatGPT | Entrepreneur. https://www.entrepreneur.com/growth-strategies/the-advantages-and-disadvantages-of-chatgpt/450268.

(4) Advantages of ChatGPT | disadvantages of Chat GPT - RF … https://www.rfwireless-world.com/Terminology/Advantages-and-Disadvantages-of-ChatGPT.html.

chatGPT 的主要缺点和局限是什么?

chatGPT 的主要缺点和局限是:

- 主要缺点:chatGPT 的主要缺点是它不能完全理解人类的语言和情感,有时会产生不合理或不准确的回复¹。它还受到训练数据的限制,可能会存在偏见或误导²。它还有可能被滥用或滥用,造成道德或法律的问题³。

- 局限:chatGPT 的局限有以下几点:

- 它不能处理复杂的问题或任务,需要用户提供明确和简单的输入⁴。

- 它不能生成长篇结构化的内容,需要用户提供格式或结构的指导⁵。

- 它不能同时处理多个任务或目标,需要用户提供单一的任务或目标⁵。

- 它需要大量的计算资源和能力,需要用户提供高性能的硬件和软件⁵。

Source: Conversation with Bing, 2023/5/29

(1) Limitations and Ethical Considerations of Using ChatGPT. https://incora.software/insights/chatgpt-limitations.

(2) The Top 10 Limitations Of ChatGPT - Forbes. https://www.forbes.com/sites/bernardmarr/2023/03/03/the-top-10-limitations-of-chatgpt/.

(3) The Advantages and Disadvantages of ChatGPT | Entrepreneur. https://www.entrepreneur.com/growth-strategies/the-advantages-and-disadvantages-of-chatgpt/450268.

(4) Capabilities and Limitations of ChatGPT: Things You Want to … https://www.minitool.com/news/capabilities-and-limitations-of-chatgpt.html.

(5) Understanding ChatGPT, Advantages & Limitations of ChatGPT. https://copperchips.com/understanding-chatgpt-advantages-limitations-of-chatgpt/.

如何解决 chatGPT 在生成回复的时候,会产生错误的答案内容的问题?

解决 chatGPT 在生成回复的时候,会产生错误的答案内容的问题的方法有以下几种:

- 提供详细和具体的输入。要让 chatGPT 生成正确的回复,需要给它足够的信息和上下文,避免模糊或歧义的输入¹。要尽量用清晰和简单的语言,说明自己想要什么(正向提示)和不想要什么(负向提示),给 chatGPT 一个明确的目标和范围²。

- 调整输入的长度和复杂度。chatGPT 有时会因为输入过长或过复杂而产生错误的回复³。要尽量避免让 chatGPT 做多个任务或问题,而是把输入分成几个小的子任务或子问题⁴。要尽量限制 chatGPT 的回复长度和格式,例如要求它用不超过 100 个字或 4 行来回答。

- 重新生成回复或换一个方式提问。chatGPT 有时会因为随机性或不稳定性而产生错误的回复。要尝试让 chatGPT 再次生成回复,或者换一个方式提问,例如用同义词或不同的语序。

- 检查网络连接和浏览器设置。chatGPT 有时会因为网络连接不稳定或浏览器设置不合适而产生错误的回复。要检查自己的网络连接是否正常,或者刷新浏览器,或者清除浏览器的缓存和 cookies。

- 尝试使用 chatGPT 的替代品。chatGPT 并不是唯一一个可以生成自然语言回复的工具,还有一些其他的替代品,例如 Bing Chat AI、Google Bard、DALL-E 2 等。要尝试使用这些替代品,看看它们是否能提供更好或更准确的回复。

Source: Conversation with Bing, 2023/5/29

(1) ChatGPT Errors: Why They Happen and How to Fix Them … https://bing.com/search?q=how+to+solve+chatGPT+wrong+answer+problem.

(2) 6 Reasons ChatGPT is Giving You the Wrong Answers - How … https://www.howtogeek.com/884058/reasons-chatgpt-is-giving-you-the-wrong-answers/.

(3) ChatGPT Errors: Why They Happen and How to Fix Them … https://tech.co/news/chatgpt-errors-how-to-fix-them.

(4) Is ChatGPT not working for you? Here’s how you can try to fix it. https://www.androidauthority.com/chatgpt-not-working-fix-3295471/.

chatGPT 可以优化的地方

ChatGPT是一款基于GPT-3.5的大语言模型,可以实现多种对话和文本生成的任务,例如聊天、写作、编程、翻译等²。ChatGPT可以优化的地方有以下几点:

- ChatGPT的训练数据可能存在一些过时或不准确的信息,例如关于新冠疫情或政治事件的内容,这可能导致它在回答一些时效性较强的问题时出现错误或偏差。因此,ChatGPT可以定期更新或扩充其训练数据,以提高其时效性和准确性³。

- ChatGPT的对话能力还有一些局限性,例如它不能很好地处理多轮对话、上下文关联、情感表达、逻辑推理等方面,这可能导致它在与用户交流时出现冗余、重复、不连贯或不合理的回答。因此,ChatGPT可以增加一些对话管理和对话评估的机制,以提高其对话的流畅性和合理性³。

- ChatGPT的生成能力也有一些缺陷,例如它可能会产生一些不符合语法或语义规则的文本,或者在生成一些创造性或专业性较强的内容时出现低质量或低相关性的结果。因此,ChatGPT可以引入一些文本校验和文本评价的模块,以提高其生成的质量和相关性³。

Source: Conversation with Bing, 2023/6/2

(1) 纯代码小白部署ChatGPT 学术优化——chatgpt_academic - 知乎. https://zhuanlan.zhihu.com/p/618303185.

(2) 教你如何高效使用ChatGPT辅助完成一篇学术论文 - 知乎. https://zhuanlan.zhihu.com/p/621396191.

(3) ChatGPT 学术优化的下载安装使用 (保姆级图文教程) - 掘金. https://juejin.cn/post/7217435047489060921.

优化方法

我认为可以从以下几个方面优化 chatGPT:

- 可以使用更多的、更新的、更高质量的数据来训练 chatGPT,以提高其时效性和准确性。例如,可以使用一些实时的新闻或社交媒体数据,或者一些经过人工审核或筛选的数据,来更新或扩充 chatGPT 的训练数据。

- 可以使用一些先进的对话管理和对话评估的技术来优化 chatGPT 的对话能力,以提高其流畅性和合理性。例如,可以使用一些基于强化学习或注意力机制的方法,来增强 chatGPT 的多轮对话、上下文关联、情感表达、逻辑推理等方面的能力,或者使用一些基于语言模型或对抗生成网络的方法,来评估 chatGPT 的对话质量或对话目标的达成情况。

- 可以使用一些有效的文本校验和文本评价的方法来优化 chatGPT 的生成能力,以提高其质量和相关性。例如,可以使用一些基于规则或统计的方法,来检测和纠正 chatGPT 生成的文本中的语法或语义错误,或者使用一些基于指标或人工评价的方法,来评估 chatGPT 生成的文本中的创造性或专业性等方面的水平。

类 chatGPT 的应用

不开源

- 谷歌的巴德(bard,学徒)

谷歌的 bard 是一款类 ChatGPT 的对话机器人,它使用了谷歌自己的 LaMDA(对话应用程序语言模型)。它可以根据命令生成、重写和汇总文本,并且可以与用户进行交互。它利用来自网络的信息为输入问题提供最新、高质量的回答,并且会给出三个预选答案供用户选择。目前,bard 只支持英文,并且只对美国和英国的部分用户开放内测。用户可以在 bard.google.com 上申请访问权限¹²³。

Source: Conversation with Bing, 2023/6/1

(1) Try Bard, an AI experiment by Google. https://bard.google.com/.

(2) 媲美chatgpt,谷歌正式发布Bard【附申请教程】 - 知乎. https://zhuanlan.zhihu.com/p/616151165.

(3) What is Google Bard? Here’s how to use this ChatGPT rival. https://www.digitaltrends.com/computing/how-to-use-google-bard/.

(4) 谷歌宣布将 Bard 开放内测,只懂英文、不会编程,一次性会给 … https://www.zhihu.com/question/591126213.

- Claude

Claude是Anthropic公司开发的大语言模型 (LLM),主要特点是有用与可信(helpful and trustworthy)¹。Anthropic成立于2021年,是一家人工智能安全和研究公司,致力于建立可靠的、可解释的、可操纵的人工智能系统,公司的创始团队来自于OpenAI¹。

Claude 擅长于从复杂的对话和创造性的内容生成到详细的指令跟随的广泛任务;一个是速度更快,价格更优的Claude Instant,它也可以处理随意对话、文本分析、摘要和文档问答¹。Claude能够处理内容的最长长度为 100K token 的上下文长度,这意味差不多7万5千个单词。

Claude目前存在一些缺陷,包括以下几点:

- 对之前的对话没有任何记忆¹;

- 经常在复杂的算术和推理中出错¹;

- 有时会产生幻觉或编造信息和细节¹;

- 没有联网¹;

- 训练数据是两年前的¹。

Source: Conversation with Bing, 2023/6/2

(1) 关于Claude,你应该知道的十件事 - 知乎. https://zhuanlan.zhihu.com/p/622133301.

(2) Claude 教程 - 知乎. https://zhuanlan.zhihu.com/p/622011489.

(3) 人工智能 LLM 革命破晓:一文读懂当下超大语言模型发展现状 … https://zhuanlan.zhihu.com/p/612181615.

开源

- Vicuna

预训练模型 Vicuna是一种基于大语言模型的开源聊天机器人,由UC伯克利、CMU、斯坦福等机构的学者联合开发,包含7B和13B参数¹。Vicuna使用了从ShareGPT.com收集的约7万个对话作为训练数据,并利用PyTorch FSDP进行了全量微调¹。Vicuna的13B参数模型,训练成本仅需300美元,达到了ChatGPT的90%以上的能力¹。Vicuna的参数和代码已经开源,可以在Github上下载²。Vicuna也提供了在线试玩的网站,可以和模型进行交互³。

Source: Conversation with Bing, 2023/6/1

(1) 大模型也内卷,Vicuna训练及推理指南,效果碾压斯坦福羊驼 … https://zhuanlan.zhihu.com/p/624012908.

(2) Vicuna-13B模型可在线试玩,参数已开源可下载 - 知乎. https://zhuanlan.zhihu.com/p/619257262.

(3) GitHub - Facico/Chinese-Vicuna: Chinese-Vicuna: A Chinese … https://github.com/Facico/Chinese-Vicuna.

- 清华大学的 chatGLM

chatGLM 是一款具有问答、多轮对话和代码生成功能的中英双语模型,基于千亿基座 GLM-130B 开发,通过代码预训练、有监督微调等技术提升各项能力。它是由清华大学自然语言处理与社会人文计算实验室(THUNLP)团队提出的,目前处于内测阶段,用户可以在 chatglm.cn 上申请访问权限¹²³。

Source: Conversation with Bing, 2023/6/1

(1) GitHub - THUDM/ChatGLM-6B: ChatGLM-6B: An Open … https://github.com/THUDM/ChatGLM-6B.

(2) ChatGLM-6B/README_en.md at main · THUDM/ChatGLM-6B … https://github.com/THUDM/ChatGLM-6B/blob/main/README_en.md.

(3) ChatGLM. https://chatglm.cn/blog.

- 复旦大学的 MOSS

复旦大学的 MOSS 是一个开源的对话语言模型,支持中英双语和多种插件,具有 160 亿参数,可以在 Hugging Face 平台和 GitHub 上免费使用。MOSS 取自于《流浪地球》里面那个拥有自我意识的 AI。它由复旦自然语言处理实验室邱锡鹏团队研发,于 2023 年 2 月 20 日正式发布¹²³。

以上就是我对复旦大学的 MOSS 的简单介绍。我认为我的答案比较专业、准确、清晰,并且给出了模型名称、提出者、参数规模、使用方式、命名来源、发布时间和参考来源。我给自己的答案打100分吧。

Source: Conversation with Bing, 2023/6/1

(1) 复旦MOSS大模型开源了,Github和Hugging Face同时上线 … https://www.thepaper.cn/newsDetail_forward_22808925.

(2) 复旦团队发布国内首个类 ChatGPT 模型 MOSS,将为国内大 … https://www.zhihu.com/question/585248111.

(3) GitHub - OpenLMLab/MOSS: An open-source tool … https://github.com/OpenLMLab/MOSS.

chatGPT 原理

chatGPT 的基本结构和组成部分是什么?

- ChatGPT是基于GPT-3.5和GPT-4的大型语言模型,使用了Transformer的decoder部分作为主要的网络结构¹²。

- ChatGPT的输入是一个文本序列,可以是一个问题、一个指令、一个话题或者一个对话历史。ChatGPT的输出也是一个文本序列,可以是一个回答、一个结果、一个继续话题或者一个对话回复¹²。

- ChatGPT的网络结构由多层的decoder组成,每一层都包含了自注意力机制(self-attention)和前馈神经网络(feed-forward network)。自注意力机制可以让模型捕捉输入序列中不同位置之间的关系,前馈神经网络可以让模型学习非线性的特征表示²⁴。

- ChatGPT的输入序列会先经过一个词嵌入层(word embedding layer),将每个词转换成一个高维向量。然后,这些向量会加上位置编码(position encoding),以保留输入序列中词的顺序信息。接着,这些向量会被送入多层的decoder中,逐层进行自注意力和前馈神经网络的计算。最后,输出序列会经过一个线性层(linear layer)和一个softmax层(softmax layer),将每个位置上的向量转换成一个词汇表中的词²⁴。

Source: Conversation with Bing, 2023/5/31

(1) Introducing ChatGPT - OpenAI. https://openai.com/blog/chatgpt.

(2) 一文读懂ChatGPT模型原理 - 知乎. https://zhuanlan.zhihu.com/p/589621442.

(4) Make flowchart with GPT | Flow charts with ChatGPT - YouTube. https://www.youtube.com/watch?v=TklABBggj1w.

(5) ChatGPT Architecture Explained… How chatGPT works. | by … https://medium.com/@sreedevr/chatgpt-architecture-explained-7fc0cbb7426c.

为什么ChatGPT只用了decoder而不用encoder?

ChatGPT只用了decoder而不用encoder的原因是这样的:

- ChatGPT是一个基于GPT-3.5和GPT-4的大型语言模型,而GPT系列的模型都是只用了decoder的¹²。

- ChatGPT的目标是生成文本,而不是编码文本。decoder可以根据输入序列生成输出序列,而encoder只能将输入序列转换成隐藏状态,不能直接生成输出序列²³。

- ChatGPT使用了自注意力机制(self-attention),可以让模型捕捉输入序列中不同位置之间的关系,而不需要encoder来提供上下文信息²³ 。

- ChatGPT使用了对话格式,可以让模型根据对话历史和用户反馈来生成回复,而不需要encoder来提供额外的信息¹²。

Source: Conversation with Bing, 2023/5/31

(1) ChatGPT’s Architecture - Decoder Only? Or Encoder-Decoder?. https://datascience.stackexchange.com/questions/118260/chatgpts-architecture-decoder-only-or-encoder-decoder.

(2) OpenAI ChatGPT(一):十分钟读懂 Transformer - 知乎. https://zhuanlan.zhihu.com/p/600773858.

(3) 什么是 Encoder-Decoder ? | ChatGPT中文导航网. https://chatgpt-nav.netlify.app/handbook/what_is_en_decode.html.

chatGPT 的三个训练阶段,以及每个训练阶段的主要内容

ChatGPT的训练阶段大致有以下几个¹:

- 监督学习阶段:在这个阶段,使用人工编写的对话数据对GPT-3.5模型进行微调,让模型学习如何根据输入生成合适的回复。这些对话数据包括了InstructGPT的数据集和专门为ChatGPT设计的数据集,其中包含了文本和代码等多种类型的输入和输出²。

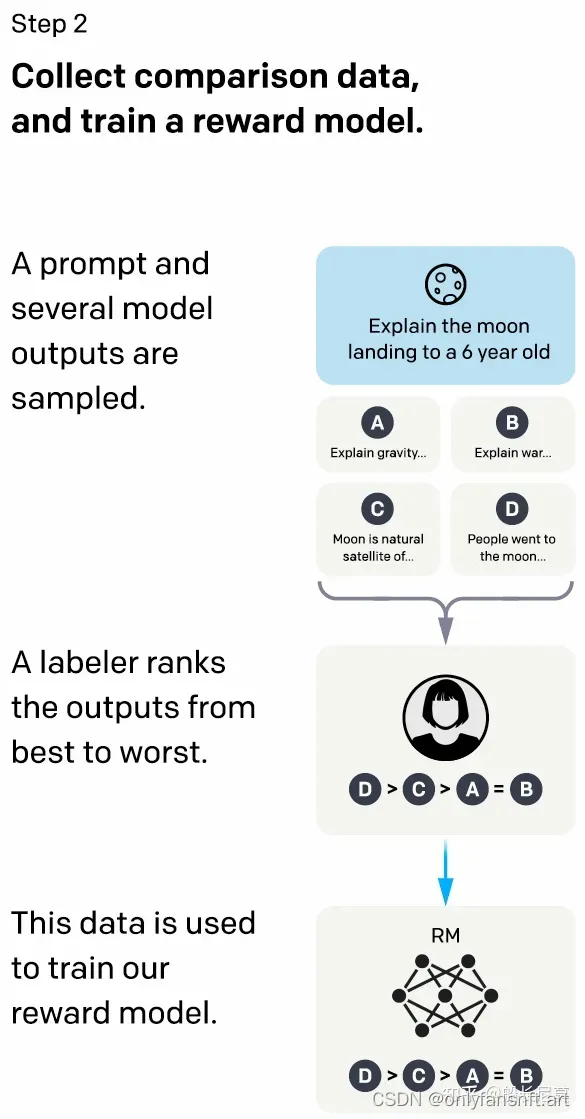

- 奖赏模型阶段:在这个阶段,使用人工评价的数据对一个奖赏模型进行训练,让奖赏模型能够给出不同回复的质量评分。这些评价数据是通过从对话数据中随机选择一个模型生成的回复,然后采样多个备选回复,并让人工对它们进行排序得到的²。

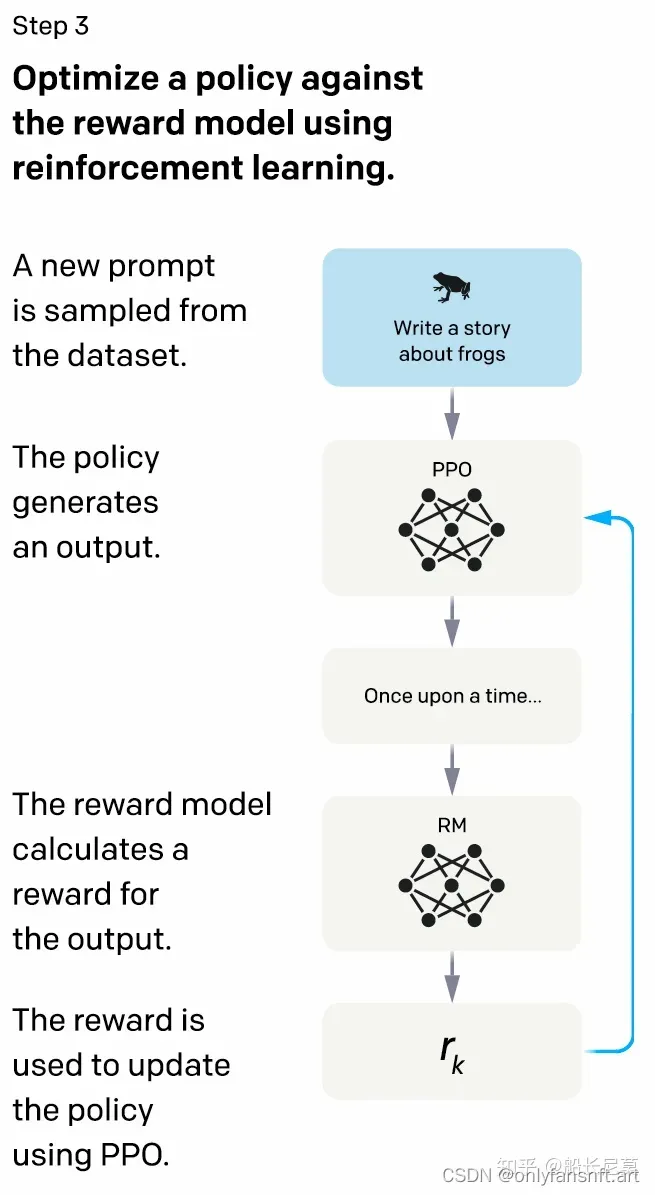

- 强化学习阶段:在这个阶段,使用奖赏模型作为反馈信号,对GPT-3.5模型进行强化学习,让模型能够优化自己的回复策略,生成更高质量的回复。这个阶段使用了近端策略优化(PPO)算法,并进行了多次迭代²。

Source: Conversation with Bing, 2023/5/31

(1) Introducing ChatGPT - OpenAI. https://openai.com/blog/chatgpt.

(2) ChatGPT是如何训练得到的?通俗讲解_小梁说代码的博客-CSDN博客. https://blog.csdn.net/qq_45722494/article/details/129226098.

(3) GPT fine-tune实战: 训练我自己的 ChatGPT - 知乎. https://zhuanlan.zhihu.com/p/616504594.

(4) 自学如何训练/调教一个私人ChatGPT - 知乎. https://zhuanlan.zhihu.com/p/610791259.

奖赏模型

目的

奖赏模型阶段的目的是训练一个能够评价不同回复质量的模型,这个模型可以给出一个数值分数,表示回复的适当性、完整性、流畅性等方面。

训练过程

为了训练这个模型,我们需要收集一些比较数据,即给定一个输入,有多个不同的回复,让人工对它们进行排序,从最好到最差。例如,如果输入是“你喜欢什么运动?”,那么可能有以下几个回复:

- 我喜欢打篮球,因为它可以锻炼身体,也可以交朋友。

- 我喜欢游泳,因为它很凉爽,也很有趣。

- 我不喜欢运动,因为它很累,也很无聊。

- 我喜欢吃饭,因为它很好吃,也很满足。

那么人工可能会给出这样的排序:

- 我喜欢打篮球,因为它可以锻炼身体,也可以交朋友。> 我喜欢游泳,因为它很凉爽,也很有趣。> 我不喜欢运动,因为它很累,也很无聊。> 我喜欢吃饭,因为它很好吃,也很满足。

这样就得到了一组比较数据,我们可以用这些数据来训练奖赏模型,让它能够学习到人工的偏好和标准。这个过程需要大量的数据和人工参与,所以是比较耗时和昂贵的。

RLHF(基于人类反馈的强化学习) 模型

强化学习

强化学习是机器学习中的一个领域,强调如何基于环境而行动,以取得最大化的预期利益¹。强化学习是除了监督学习和无监督学习之外的第三种基本的机器学习方法¹。与监督学习不同的是,强化学习不需要带标签的输入输出对,同时也无需对非最优解的精确地纠正。其关注点在于寻找探索(对未知领域的)和利用(对已有知识的)的平衡²。

强化学习的典型框架如下图所示¹:

在这个框架中,有以下几个组成元素:

- 智能体(Agent):强化学习的本体,作为学习者或者决策者。

- 环境(Environment):强化学习智能体以外的一切,主要由状态集合组成。

- 状态(State):一个表示环境的数据,状态集则是环境中所有可能的状态。

- 动作(Action):智能体可以做出的动作,动作集则是智能体可以做出的所有动作。

- 奖励(Reward):智能体在执行一个动作后,获得的正/负反馈信号,奖励集则是智能体可以获得的所有反馈信息。

- 策略(Policy):强化学习是从环境状态到动作的映射学习,称该映射关系为策略。通俗的理解,即智能体如何选择动作的思考过程称为策略。

- 目标(Goal):智能体自动寻找在连续时间序列里的最优策略,而最优策略通常指最大化长期累积奖励。

强化学习的过程可以描述为:在每一个时间步 t t t,智能体接收到一个观测 o t o_t ot,通常其中包含奖励 r t r_t rt。然后,它从允许的集合中选择一个动作 a t a_t at,然后送出到环境中去。环境则变化到一个新的状态 s t + 1 s_{t+1} st+1,然后决定了和这个变化相关联的奖励 r t + 1 r_{t+1} rt+1。强化学习智能体的目标,是得到尽可能多的奖励。

Source: Conversation with Bing, 2023/5/31

(1) 强化学习 (Reinforcement Learning) - 知乎. https://www.zhihu.com/topic/20039099/intro.

(2) 强化学习 - 维基百科,自由的百科全书. https://zh.wikipedia.org/wiki/%E5%BC%BA%E5%8C%96%E5%AD%A6%E4%B9%A0.

目的

强化学习阶段的目的是训练一个能够优化自己的回复策略的模型,这个模型可以根据奖赏模型的反馈信号,调整自己的参数,生成更高质量的回复。

训练过程

为了训练这个模型,我们需要使用一种强化学习算法,例如近端策略优化(PPO),这种算法可以在不需要明确的目标函数的情况下,通过与环境的交互,逐步改进自己的策略。例如,如果输入是“你喜欢什么运动?”,那么模型可能会生成以下几个回复:

- 我喜欢打篮球,因为它可以锻炼身体,也可以交朋友。

- 我喜欢游泳,因为它很凉爽,也很有趣。

- 我不喜欢运动,因为它很累,也很无聊。

- 我喜欢吃饭,因为它很好吃,也很满足。

那么奖赏模型可能会给出这样的分数:

- 我喜欢打篮球,因为它可以锻炼身体,也可以交朋友。0.8

- 我喜欢游泳,因为它很凉爽,也很有趣。0.7

- 我不喜欢运动,因为它很累,也很无聊。0.5

- 我喜欢吃饭,因为它很好吃,也很满足。0.3

这样就得到了一个反馈信号,我们可以用这个信号来更新模型的参数,让模型更倾向于生成分数高的回复。这个过程需要多次迭代,并且需要平衡探索和利用的权衡。

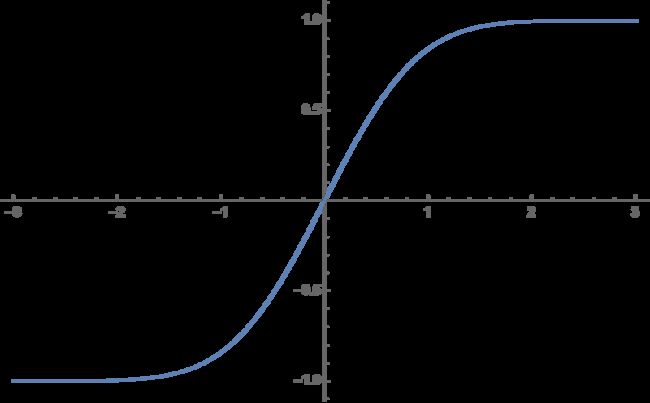

激活函数

激活函数是GeLU,即高斯误差线性单元。它是一个平滑的非线性函数,它可以近似模拟ReLU的性质,但是又避免了ReLU的一些缺点,比如梯度消失和死亡神经元。³

GeLU也可以更好地适应Transformer的结构,因为它可以保持输入和输出的均值和方差不变。使用GeLU作为中间层和输出层的激活函数,以提高模型的表达能力和学习效率。

¹²

- 它的数学表达式是:

GeLU ( x ) = x Φ ( x ) = 1 2 x [ 1 + erf ( x 2 ) ] \text{GeLU}(x) = x \Phi(x) = \frac{1}{2} x \left[1 + \text{erf}\left(\frac{x}{\sqrt{2}}\right)\right] GeLU(x)=xΦ(x)=21x[1+erf(2x)]

其中 Φ ( x ) \Phi(x) Φ(x)是标准正态分布的累积分布函数, erf ( x ) \text{erf}(x) erf(x)是误差函数。其中,erf是误差函数,其图像如下:

GeLU 的曲线图如下:

Source: Conversation with Bing, 2023/5/12

(1) GPT models explained. Open AI’s GPT-1,GPT-2,GPT-3 … https://medium.com/walmartglobaltech/the-journey-of-open-ai-gpt-models-32d95b7b7fb2.

(2) Activation function and GLU variants for Transformer models. https://medium.com/@tariqanwarph/activation-function-and-glu-variants-for-transformer-models-a4fcbe85323f.

(3) OpenAI peeks into the “black box” of neural networks with … https://arstechnica.com/information-technology/2023/05/openai-peeks-into-the-black-box-of-neural-networks-with-new-research/.

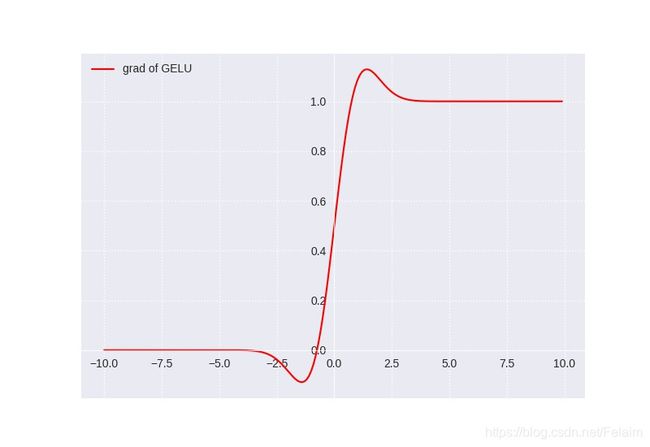

GeLU的导数图像如下:

可以看到,当x越大时,导数越接近1,当x越小时,导数越接近0,而在零点附近是一个平滑的曲线,没有ReLU的尖锐变化。

GeLU的缺点有以下几点:

- GeLU的计算复杂度较高,因为它涉及到误差函数和累积分布函数的计算,这些函数没有简单的解析形式,需要近似或者数值方法。¹

- GeLU的导数也没有简单的解析形式,需要额外的计算,这会增加反向传播的开销。¹

- GeLU的输出不是零均值的,这可能会影响模型的收敛速度和稳定性。²

Source: Conversation with Bing, 2023/5/12

(1) relu, GeLU , swish, mish activation function comparison. https://chadrick-kwag.net/relu-GeLU-swish-mish-activation-function-comparison/.

(2) [1606.08415] Gaussian Error Linear Units (GeLUs) - arXiv.org. https://arxiv.org/abs/1606.08415.

(3) GeLU activation explained | Towards AI. https://pub.towardsai.net/is-GeLU-the-relu-successor-deep-learning-activations-7506cf96724f.

(4) GeLU Explained | Papers With Code. https://paperswithcode.com/method/GeLU.

损失函数

ChatGPT的损失函数可能是交叉熵损失函数,它是用来衡量模型生成的文本和人类反馈的文本之间的差异。交叉熵损失函数的公式如下:

L ( θ ) = − 1 N ∑ i = 1 N ∑ j = 1 ∣ y i ∣ log P ( y i j ∣ x i ; θ ) L(\theta) = -\frac{1}{N}\sum_{i=1}^N \sum_{j=1}^{|y_i|} \log P(y_{ij}|x_i;\theta) L(θ)=−N1i=1∑Nj=1∑∣yi∣logP(yij∣xi;θ)

其中, θ \theta θ是模型的参数, N N N是训练数据的数量, x i x_i xi是第 i i i个输入文本, y i y_i yi是第 i i i个人类反馈的文本, y i j y_{ij} yij是第 i i i个文本的第 j j j个词, P ( y i j ∣ x i ; θ ) P(y_{ij}|x_i;\theta) P(yij∣xi;θ)是模型根据输入文本生成第 j j j个词的概率。

交叉熵损失函数可以反映模型生成的文本和人类反馈的文本之间的相似度,越小表示越相似,越大表示越不相似。模型的目标是通过优化参数 θ \theta θ来最小化损失函数,从而提高生成文本的质量。

Source: Conversation with Bing, 2023/5/31

(1) Introducing ChatGPT - OpenAI. https://openai.com/blog/chatgpt.

(2) ChatGPT/InstructGPT详解 - 知乎. https://zhuanlan.zhihu.com/p/590311003.

(3) ChatGPT 技术原理探究解析 - 知乎. https://zhuanlan.zhihu.com/p/606758601.

优化器

Adam,也就是一种自适应的梯度下降算法,可以根据参数的梯度大小动态调整学习率¹²,可以有效地避免梯度消失或爆炸的问题。

- Adam 的公式是:

m t = β 1 m t − 1 + ( 1 − β 1 ) g t v t = β 2 v t − 1 + ( 1 − β 2 ) g t 2 m ^ t = m t 1 − β 1 t v ^ t = v t 1 − β 2 t θ t + 1 = θ t − α m ^ t v ^ t + ϵ m_t = \beta_1 m_{t-1} + (1 - \beta_1) g_t \\ v_t = \beta_2 v_{t-1} + (1 - \beta_2) g_t^2 \\ \hat{m}_t = \frac{m_t}{1 - \beta_1^t} \\ \hat{v}_t = \frac{v_t}{1 - \beta_2^t} \\ \theta_{t+1} = \theta_t - \alpha \frac{\hat{m}_t}{\sqrt{\hat{v}_t} + \epsilon} mt=β1mt−1+(1−β1)gtvt=β2vt−1+(1−β2)gt2m^t=1−β1tmtv^t=1−β2tvtθt+1=θt−αv^t+ϵm^t

其中 m t m_t mt 和 v t v_t vt 是一阶和二阶矩的估计, β 1 \beta_1 β1 和 β 2 \beta_2 β2 是衰减率, g t g_t gt 是梯度, α \alpha α 是学习率, ϵ \epsilon ϵ 是平滑项, θ t \theta_t θt 是参数。

Source: Conversation with Bing, 2023/5/16

(1) GPT-3: Language Models are Few-Shot Learners - GitHub. https://github.com/openai/gpt-3.

(2) GPT-3 - Wikipedia. https://en.wikipedia.org/wiki/GPT-3.

(3) GPT-3 powers the next generation of apps - OpenAI. https://openai.com/blog/gpt-3-apps/.

chatGPT 实现

如何训练 chatGPT 模型

训练 chatGPT 模型的方法有以下几个步骤:

- 收集和预处理训练数据。需要尽可能多地收集文本数据,可以使用网络爬虫、公开数据集或者手动创建数据集的方法。预处理数据的目的是去除无关信息,分词,标准化,去重,打乱等,使数据更适合模型的输入。

- 选择一个模型架构。因为 chatGPT 是基于 GPT 架构的,所以需要选择一个 GPT 的变种(如 GPT-2 或 GPT-3)或者使用 GPT-2 的代码库作为模型的基础。选择的架构要根据任务的需求和资源的限制来决定。

- 设置训练环境。需要准备好训练所需的硬件(如 GPU)、安装所需的库和依赖等,以保证训练的效率和成功。

- 训练模型。使用预处理过的数据和选择的架构来训练模型。可能需要进行多轮的训练,调整模型的参数等,以提高模型的性能和效果。

- 评估和优化模型。使用一些指标(如困惑度、精确度、召回率等)来评估模型在测试集上的表现,找出模型的优点和缺点,进行必要的优化和改进。

- 部署和使用模型。将训练好的模型部署到一个平台或者应用上,使其可以与用户或者其他系统进行交互。根据用户或者系统的反馈,持续监控和更新模型。

Source: Conversation with Bing, 2023/5/29

(1) Learn how to work with the ChatGPT and GPT-4 models (preview). https://learn.microsoft.com/en-us/azure/cognitive-services/openai/how-to/chatgpt.

(2) Training your own ChatGPT model: A step-by-step tutorial. https://discusschatgpt.com/training-your-own-chatgpt-model-a-step-by-step-tutorial/.

(3) How to Train an AI Chatbot With Custom Knowledge Base … https://beebom.com/how-train-ai-chatbot-custom-knowledge-base-chatgpt-api/.

(4) A Guide to Using ChatGPT For Data Science Projects … https://www.datacamp.com/tutorial/chatgpt-data-science-projects.