Linux5.2 LVS+keepalived高可用群集

文章目录

- 计算机系统

-

- 5G云计算

-

- 第三章 LINUX LVS+Keepalived群集

-

- 一、Keepalived 概述

-

- 1. Keepalived 作用

- 2.Keepalived 实现原理剖析

- 3.VRRP协议(虚拟路由冗余协议)

- 4.Keepalived 主要模块及其作用

- 5.健康检查方式(学名:探针)

- 6.==脑裂的形成和解决==

- 二、LVS+Keepalived 高可用集群部署

-

- 1.LVS 部署,配置负载调度器(主、备相同)

- 2.配置节点服务器(192.168.58.61、192.168.68.62)

- 3.测试效果

- 三、Nginx+Keepalived 高可用集群部署

-

- 1.配置负载调度器(主、备相同)

- 2.配置Nginx四层负载均衡

- 3.测试效果

- 四、常见问题

-

- 1. Keepalived 通过什么判断哪台主机为主服务器,通过什么方式配置浮动IP

- 2. keepalived 的抢占与非抢占模式

- 五、总结

-

- 1. 一个合格的集群应该具有的特性

计算机系统

5G云计算

第三章 LINUX LVS+Keepalived群集

在这个高度信息化的 IT 时代,企业的生产系统、业务运营、销售和支持,以及日常管理等环节越来越依赖于计算机信息和服务,对高可用(HA)技术的应用需求不断提高,以便提供持续的、不间断的计算机系统或网络服务

一、Keepalived 概述

Keeplived是一款专为LVS和HA设计的健康检查工具。主要支持故障自动切换(Failover)和支持节点健康状态检查(Health Checking)。官方网站: http://www.keepalived.org

Keepalived 是一个基于VRRP协议来实现的LVS服务高可用方案,可以解决静态路由出现的单点故障问题

1. Keepalived 作用

判断LVS负载调度器、节点服务器的可用性,当master主机出现故障及时切换到backup节点保证业务正常,当master故障主机恢复后将其重新加入群集并且业务重新切换回master节点

2.Keepalived 实现原理剖析

Keepalived是一个基于VRRP热备份协议来实现服务高可用方案,可用解决静态路由吹西安的单点故障问题。

在一个LVS服条集群中通常有主服条器(MASTER)和备份服务器(BACKUP)两种角色的服务器,但是对外表现为一个虚拟IP(VIP),主服务器会发送VRRP通告信息给备份服务器,当备份服务器收不到VRRP消息的时候,即主服务器异常的时候,备份服务器就会接管虚拟IP,继续提供服务,从而保证了高可用性

3.VRRP协议(虚拟路由冗余协议)

VRRP是一种容错协议,它通过把几台路由设备联合组成一台虚拟的路由设备,并通过一定的机制来保证当主机的下一跳设备出现故障时,可以及时将业务切换到其它设备,从而保持通讯的连续性和可靠性。

VRRP将局域网内的一组路由器划分在一起,称为一个备份组。备份组由一个Master路由器和多个Backup路由器组成,功能上相当于一台虚拟路由器。局域网内的主机只需要知道这个虚拟路由器的IP地址,并不需知道具体某台设备的IP地址,将网络内主机的缺省网关设置为该虚拟路由器的IP地址,主机就可以利用该虚拟网关与外部网络进行通信。

VRRP将该虚拟路由器动态关联到承担传输业务的物理路由器上,当该物理路由器出现故障时,再次选择新路由器来接替业务传输工作,整个过程对用户完全透明,实现了内部网络和外部网络不间断通信。

4.Keepalived 主要模块及其作用

keepalived体系架构中主要有三个模块,分别是core、check和vrrp

| 模块 | 说明 |

|---|---|

| core模块 | 为keepalived的核心,负责主进程的启动、维护及全局配置文件的加载和解析 |

| vrrp模块 | 是来实现VRRP协议的。(调度器之间的健康检查和主备切换) |

| check模块 | 负责健康检查,常见的方式有端口检查及URL检查。(节点服务器的健康检查) |

5.健康检查方式(学名:探针)

| 健康检查方式 | 说明 |

|---|---|

| 发送心跳信息 | 例如ping/pong命令等 |

| TCP端口检查 | 例如向一台主机的 IP:PROT 发送TCP三次握手连接 |

| HTTP URL检查 | 例如向一台主机的http://IP+PROT/…URL路径发送HTTP GET{}请求方法 主机响应返回2xx或者3xx为正常,若响应返回4xx或者5xx则认为健康检查异常 |

6.脑裂的形成和解决

1)什么是脑裂

脑裂(split-brain):指在一个高可用(HA)系统中,当联系着的两个节点断开联系时,本来为一个整体的系统,分裂为两个独立节点,这时两个节点开始争抢共享资源,结果会导致系统混乱,数据损坏

对于无状态服务的HA,无所谓脑裂不脑裂;但对有状态服务(比如MySQL)的HA,必须要严格防止脑裂

2)脑裂发生时的现象及原因

Master主机一直发送心跳消息给backup主机,如果中间的链路突然断掉,backup主机将无法收到master主机发送过来的心跳消息(也就是vrrp报文),backup主机这时候会立即抢占master的工作,但其实这时候的master是正常工作的,此时就会出现脑裂的现象,即两台主机都为master状态,都有VIP且都正常工作

3)脑裂的解决方法

关闭两个都成为master主机中的一个,一般关闭原本就为master的主机

4)脑裂的预防方案

Ⅰ.使用shell脚本对这两个主机之间的连通性进行监测,如果发现有问题,就会立即关闭keepalived服务来防止脑裂的产生

Ⅱ.增加一条链路作为备用链路,即使主链路挂掉了,备用链路也会顶上来,master主机可以继续给backup主机发送心跳消息

Ⅲ.使用监控软件的方法,这边主要是采用的zabbix来监控的,主要就是创建监控项,创建触发器来测试关闭keepalived服务

###Shell脚本判断主机之间是否时链路断开

###主调度器

###判断主从调度器之间链路是否断连

ping -c 3 -i 0.5 -w 2 192.168.58.63 &> /dev/null

if [ $? -ne 0 ];then

ssh 192.168.58.61 ping -c 3 -i 0.5 -w 2 -I 192.168.58.61 192.168.58.64 &> /dev/null

if [ $? -eq 0 ];then

systemctl stop keepalived

fi

fi

二、LVS+Keepalived 高可用集群部署

主DR负载调度器:本地网卡 ens33:192.168.58.63/24

VIP虚拟网卡ens33:0:192.168.58.188/32

备DR负载调度器:本地网卡 ens33:192.168.58.64/24

Web节点服务器1:本地网卡 ens33:192.168.58.61/24

VIP虚拟回环网卡 lo:0:192.168.58.188/32

Web节点服务器2:本地网卡 ens33:192.168.68.62/24

VIP虚拟回环网卡 lo:0:192.168.58.188/32

tomcat多实例服务器:192.168.58.60/24

客户端:192.168.58.10/24

1.LVS 部署,配置负载调度器(主、备相同)

systemctl stop firewalld.service

setenforce 0

yum -y install ipvsadm keepalived

modprobe ip_vs

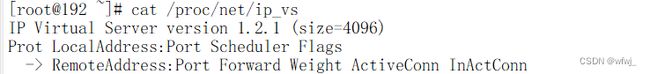

cat /proc/net/ip_vs

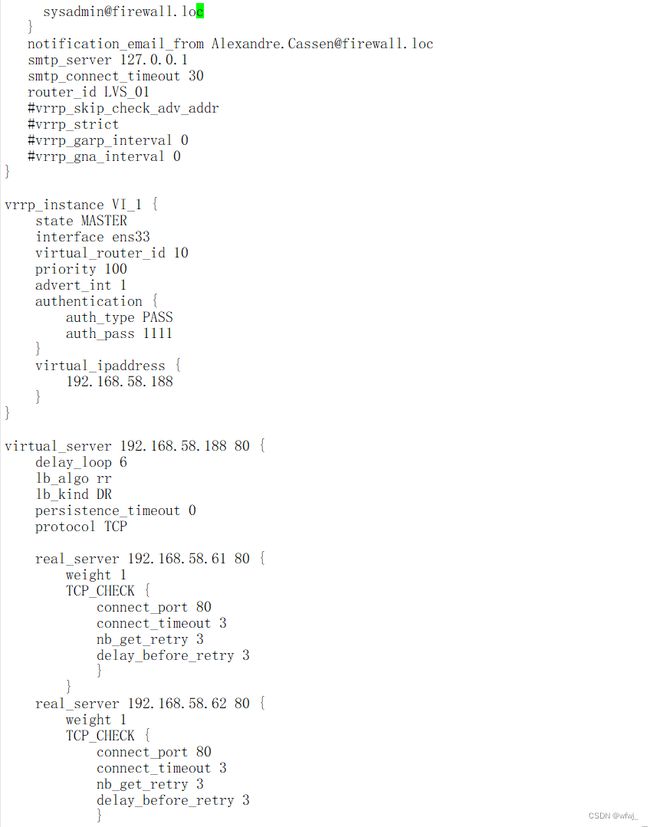

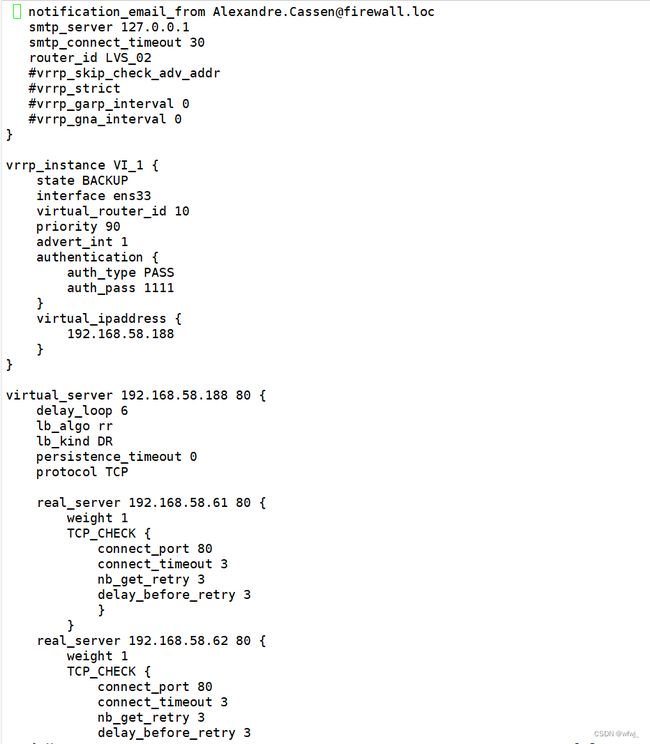

(1)配置keeplived(主、备DR 服务器上都要设置)

cd /etc/keepalived/

cp keepalived.conf keepalived.conf.bak

vim keepalived.conf

......

global_defs { #定义全局参数

--10行--修改,邮件服务指向本地

smtp_server 127.0.0.1

--12行--修改,指定服务器(路由器)的名称,主备服务器名称须不同,主为LVS_01,备为LVS_02

router_id LVS_01

--14行--注释掉,取消严格遵守VRRP协议功能,否则VIP无法被连接

#vrrp_strict

}

vrrp_instance VI_1 { #定义VRRP热备实例参数

--20行--修改,指定热备状态,主为MASTER,备为BACKUP

state MASTER

--21行--修改,指定承载vip地址的物理接口

interface ens33

--22行--修改,指定虚拟路由器的ID号,每个热备组保持一致

virtual_router_id 10

#nopreempt #如果设置非抢占模式,两个节点state必须为BACKUP,并加上配置 nopreempt

--23行--修改,指定优先级,数值越大优先级越高,这里设置主为100,备为90

priority 100

advert_int 1 #通告间隔秒数(心跳频率)

authentication { #定义认证信息,每个热备组保持一致

auth_type PASS #认证类型

--27行--修改,指定验证密码,主备服务器保持一致

auth_pass 1111

}

virtual_ipaddress { #指定群集vip地址

192.168.58.188

}

}

--36行--修改,指定虚拟服务器地址(VIP)、端口,定义虚拟服务器和Web服务器池参数

virtual_server 192.168.58.188 80 {

delay_loop 6 #健康检查的间隔时间(秒)

lb_algo rr #指定调度算法,轮询(rr)

--39行--修改,指定群集工作模式,直接路由(DR)

lb_kind DR

persistence_timeout 0 #连接保持时间(秒)

protocol TCP #应用服务采用的是 TCP协议

--43行--修改,指定第一个Web节点的地址、端口

real_server 192.168.58.61 80 {

weight 1 #节点的权重

--45行--删除,添加以下健康检查方式

TCP_CHECK {

connect_port 80 #添加检查的目标端口

connect_timeout 3 #添加连接超时(秒)

nb_get_retry 3 #添加重试次数

delay_before_retry 3 #添加重试间隔

}

}

real_server 192.168.58.62 80 { #添加第二个 Web节点的地址、端口

weight 1

TCP_CHECK {

connect_port 80

connect_timeout 3

nb_get_retry 3

delay_before_retry 3

}

}

##删除后面多余的配置##

}

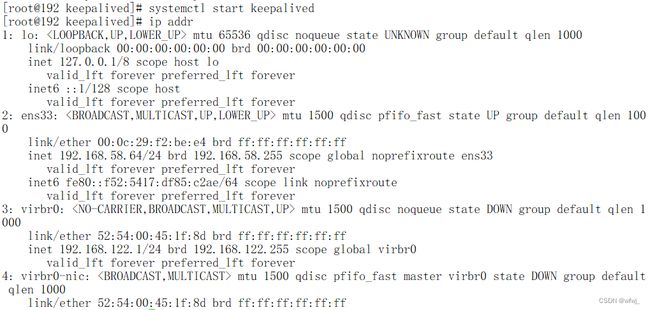

systemctl start keepalived

ip addr #查看虚拟网卡vip

(2)启动 ipvsadm 服务

--192.168.58.63---

ipvsadm-save > /etc/sysconfig/ipvsadm

systemctl start ipvsadm

ipvsadm -ln

#如没有VIP 的分发策略,则重启 keepalived 服务,systemctl restart keepalived

--192.168.80.64---

ipvsadm-save > /etc/sysconfig/ipvsadm

systemctl start ipvsadm

ipvsadm -ln

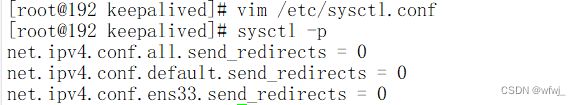

(3)调整 proc 响应参数,关闭Linux 内核的重定向参数响应

vim /etc/sysctl.conf

net.ipv4.conf.all.send_redirects = 0

net.ipv4.conf.default.send_redirects = 0

net.ipv4.conf.ens33.send_redirects = 0

sysctl -p

2.配置节点服务器(192.168.58.61、192.168.68.62)

参考上一篇博客的七层nginx服务器轮询,动静分离

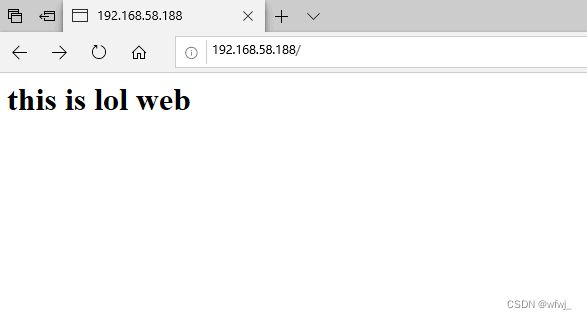

3.测试效果

在客户端访问 http://192.168.58.188/

再在主服务器关闭 keepalived 服务后再测试, systemctl stop keepalived

三、Nginx+Keepalived 高可用集群部署

1.配置负载调度器(主、备相同)

vim keepalived.conf

......

global_defs {

smtp_server 127.0.0.1

router_id Nginx_01

#vrrp_strict

}

vrrp_script chk_nginx {

###指定监控脚本的路径

script "/etc/keepalived/nginx_check.sh"

###检测的间隔时间

interval 2

###权重

weight 2

}

vrrp_instance VI_1 {

state MASTER

interface ens33

virtual_router_id 10

#nopreempt

priority 100

advert_int 1

authentication {

auth_type PASS

auth_pass 1111

}

virtual_ipaddress {

192.168.58.188

}

track_script { ###加载追踪模块

chk_nginx

}

}

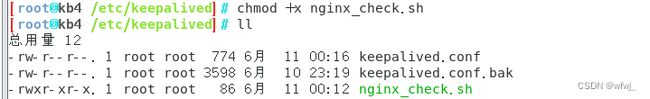

###检测nginx是否启动的脚本

#!/bin/bash

if ! killall -0 nginx &> /dev/null

then

systemctl stop keepalived

fi

###给脚本添加执行权限

chmod +x nginx_check.sh

2.配置Nginx四层负载均衡

参考之前博客的七层nginx服务器轮询,负载均衡

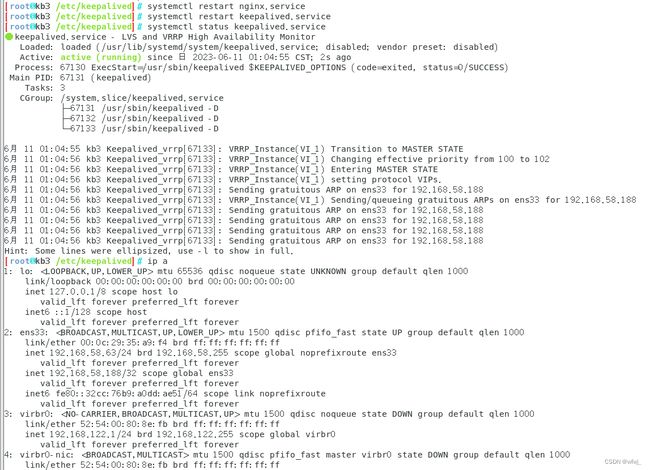

3.测试效果

在客户端访问 http://192.168.58.188/

再在主服务器关闭 nginx 服务后再测试,看keepalived服务是否同时关闭,VIP是否转移,再次启动keepalived服务,是否启动成功,再次启动nginx 服务后,启动keepalived服务,是否启动成功

四、常见问题

1. Keepalived 通过什么判断哪台主机为主服务器,通过什么方式配置浮动IP

Keepalived首先做初始化先检查state状态,master为主服务器,backup为备服务器。

然后再对比所有服务器的priority,谁的优先级高谁是最终的主服务器。

优先级高的服务器会通过ip命令为自己的电脑配置一个提前定义好的浮动IP地址

2. keepalived 的抢占与非抢占模式

抢占模式即MASTER从故障中恢复后,会将VIP从BACKUP节点中抢占过来。非抢占模式即MASTER恢复后不抢占BACKUP升级为MASTER后的VIP。

非抢占式俩节点state必须为bakcup,且必须配置nopreempt。

[root@localhost ~]# vim /etc/keepalived/keepalived.conf

vrrp_instance VI_1 {

state BACKUP

nopreempt

interface ens32

virtual router_id 51

priority 100

advert_int 1

authentication{

auth_type PASS

auth_pass 1111

}

virtual ipaddress {

192.168.58.188

}

}

五、总结

1. 一个合格的集群应该具有的特性

负载均衡:LVS、Nginx、Haproxy

给调度器/节点服务器健康检查:Keepalived、Heartbeat

故障转移