少林派问题汇总

少林派问题汇总:

A:缺少bmodel,没有指定bmodel的路径,测试图片不在同一文件路径下 复制过来就解决了

Q: docker容器下运行./install_lib.sh nntc会rm不到文件怎么回事?

A:文件已经被删除

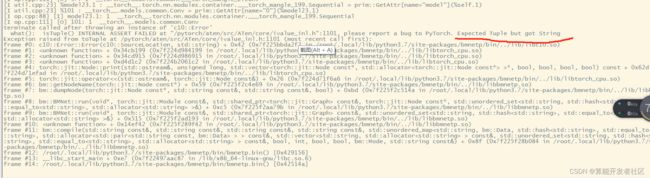

Q: 我将pytorch的模型用export工具转换成.torchscript.pt文件后还是出现这样的错误, pytorch的版本都是一致,且跑算能官方提供的模型没问题

A: 要求pytorch trace时版本为1.8

A: 没有配置环境,执行 source envsetup_cmodel.sh

Q:opt/下没有sophon

A:SDK3..0以下在/system中,以上在/opt中

Q: 移植自己训练好的yolov5模型 除了修改权重文件,coco class类是直接修改成自己模型里面的类别吗? 还有移植自己的模型的话 脚本怎么修改?

A:需要找到coco.name或者ulits文件,修改成自己的类

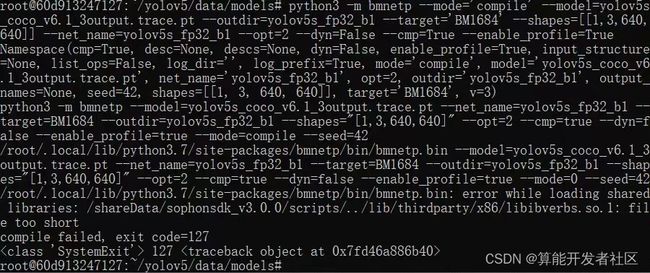

Q: 想问一下yolov5s_640_coco_v6.1_3output_fp32_1b.bmodel 这个案例的模型有测试过性能么,为什么我用本地视频跑起来才5帧1秒

A:推理速度太慢,需要训练自己的数据集,后期通过调整batch等方法加速

Q: 目前有客户自己训练的pt文件识别精度还是蛮高的,但是转成bmodel文件上板子几乎识别不出,而且只能识别出人和椅子。识别出来精度很低。这是什么问题?

A:需要做一些精度调优

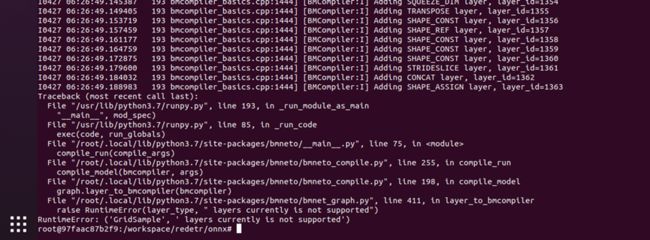

Q:onnx转bmodel时出现这个算子不支持,在训练模型时用其他算子等效实现这个算子,速度会不会慢很多

A: 具体速度慢多少当然是看你怎么用其他算子等效实现,不过如果能自己解决不支持的算子已经很不错了

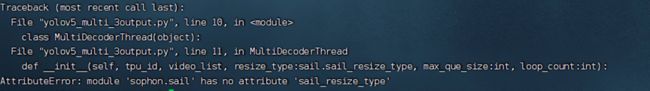

Q:编译sail的时候出现这个错误是什么原因呢?内置的2.7版本的sail没有'sail_resize_type'这个属性,是要重新安装吗?

A: 新的特性在2.7上面是不支持的,必须升级到最新的才行

Q:在docker的镜像下,用这个sdk,然后运行docker说没有这个指令

A: Workspace说明已经在docker容器里了

Q:使用bmnetu转bmodel的时候是会占用大量的CPU资源的吗?在使用这串代码转int8模型的bmodel的时候电脑的CPU资源会跑到100%然后进程就被KILLED了

![]()

A: 对开发环境的设备性能有一定要求,被killed了可以试下重启或者把其他软件关一下,也有可能是内存不够了

Q: 请问一下上面的cmake编译问题可以吗? 是在build里找不到libsophon_0.4.1_aarch64的意思吗,但是build是教程里手动创建的空文件夹

LIBSOPHON_BASIC_PATH : 交叉编译模式下,libsophon的路径,如果配置不正确则会编译失败。pcie模式下面此编译选项不生效。

Q: 我输入的命令是这样的,模型的输入shapes是图中获取的, 那我的shape应该定义为【1,2048,1】吗

A:输入shape有四个维度, batchsize,channel,图片的长宽

Q: 我重新输入了一下shapes,他会报错如下,是卷积核移动的步长必须小与16吗

![]()

A:步长需要小于16

Q: 设置环境变量之后,安装sail推理库时报错system/bin里没有 GLIBC 2.29怎么解决,需要自己更新GLIBC么?

A:版本不匹配,开发版本和运行版本不一致,修改成正确的