RabbitMQ

文章目录

- RabbitMQ

-

- 1.初识MQ

-

- 1.1 同步和异步通讯

-

- 1.1.1 同步通讯

- 1.1.2 异步通讯

- 1.2 技术对比

- 2.快速入门

-

- 2.1 安装RabbitMQ

- 2.2 RabbitMQ消息模型

- 2.3 导入Demo工程

- 2.4 入门案例

-

- 2.4.1 publisher实现

- 2.4.2 consumer实现

- 2.5 总结

- 3.SpringAMQP

-

- 3.1 Basic Queue

-

- 3.1.1 消息发送

- 3.1.2 消息接收

- 3.1.3 测试

- 3.2 WorkQueue

-

- 3.2.1 消息发送

- 3.2.2 消息接收

- 3.2.3 测试

- 3.2.4 能者多劳

- 3.2.5 总结

- 3.3 发布/订阅

- 3.4 Fanout

-

- 3.4.1 声明队列和交换机

- 3.4.2 消息发送

- 3.4.3 消息接收

- 3.4.4 总结

- 3.5 Direct

-

- 3.5.1 注解声明队列和交换机

- 3.5.2 消息发送

- 3.5.3 总结

- 3.6 Topic

-

- 3.6.1 说明

- 3.6.2 消息发送

- 3.6.3 消息接收

- 3.6.4 总结

- 3.7 消息转换器

-

- 3.7.1 测试默认转换器

- 3.7.2 配置JSON转换器

- 4.高级特性

-

- 4.1 消息的可靠投递

- 4.2 Consumer Ack

- 4.3 消费端限流

- 4.4 TTL

- 4.5 死信队列

- 4.6 延迟队列

- 4.7 日志与监控

- 4.8 消息追踪

- 5.应用问题

-

- 5.1 消息可靠性保障

- 5.2 消息幂等性保障

- 6.集群搭建

-

- 6.1 集群方案的原理

- 6.2 单机多实例部署

- 6.3 集群管理

- 6.4 RabbitMQ镜像集群配置

- 6.5 负载均衡-HAProxy

-

- 6.5.1 安装HAProxy

- 6.5.2 配置HAProxy

课前资料

链接:https://pan.baidu.com/s/1NryeeOHthhKruiwrmuE3VA

提取码:ljiq

RabbitMQ

1.初识MQ

1.1 同步和异步通讯

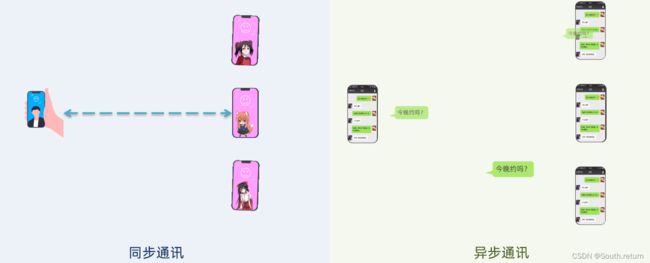

微服务间通讯有同步和异步两种方式:

同步通讯:就像打电话,需要实时响应。

异步通讯:就像发邮件,不需要马上回复。

两种方式各有优劣,打电话可以立即得到响应,但是你却不能跟多个人同时通话。发送邮件可以同时与多个人收发邮件,但是往往响应会有延迟。

1.1.1 同步通讯

Feign调用就属于同步方式,虽然调用可以实时得到结果,但存在下面的问题:

总结:

同步调用的优点:

- 时效性较强,可以立即得到结果

同步调用的问题:

- 耦合度高

- 性能和吞吐能力下降

- 有额外的资源消耗

- 有级联失败问题

1.1.2 异步通讯

异步调用则可以避免上述问题:

以购买商品为例,用户支付后需要调用订单服务完成订单状态修改,调用物流服务,从仓库分配响应的库存并准备发货。

在事件模式中,支付服务是事件发布者(publisher),在支付完成后只需要发布一个支付成功的事件(event),事件中带上订单id。订单服务和物流服务是事件订阅者(Consumer),订阅支付成功的事件,监听到事件后完成自己业务即可。

为了解除事件发布者与订阅者之间的耦合,两者并不是直接通信,而是有一个中间人(Broker)。发布者发布事件到Broker,不关心谁来订阅事件。订阅者从Broker订阅事件,不关心谁发来的消息。

Broker 是一个像数据总线一样的东西,所有的服务要接收数据和发送数据都发到这个总线上,这个总线就像协议一样,让服务间的通讯变得标准和可控。

好处:

-

吞吐量提升:无需等待订阅者处理完成,响应更快速

-

故障隔离:服务没有直接调用,不存在级联失败问题

-

调用间没有阻塞,不会造成无效的资源占用

-

耦合度极低,每个服务都可以灵活插拔,可替换

-

流量削峰:不管发布事件的流量波动多大,都由Broker接收,可以按照自己的速度去处理事件

缺点:

- 架构复杂了,业务没有明显的流程线,不好管理

- 需要依赖于Broker的可靠、安全、性能

1.2 技术对比

MQ中文是消息队列(MessageQueue)字面来看就是存放消息的队列。事件驱动架构中的Broker。

比较常见的MQ实现:

- ActiveMQ

- RabbitMQ

- RocketMQ

- Kafka

几种常见MQ的对比:

| RabbitMQ | ActiveMQ | RocketMQ | Kafka | |

|---|---|---|---|---|

| 公司/社区 | Rabbit | Apache | 阿里 | Apache |

| 开发语言 | Erlang | Java | Java | Scala&Java |

| 协议支持 | AMQP,XMPP,SMTP,STOMP | OpenWire,STOMP,REST,XMPP,AMQP | 自定义协议 | 自定义协议 |

| 可用性 | 高 | 一般 | 高 | 高 |

| 单机吞吐量 | 一般 | 差 | 高 | 非常高 |

| 消息延迟 | 微秒级 | 毫秒级 | 毫秒级 | 毫秒以内 |

| 消息可靠性 | 高 | 一般 | 高 | 一般 |

追求可用性:Kafka、 RocketMQ 、RabbitMQ

追求可靠性:RabbitMQ、RocketMQ

追求吞吐能力:RocketMQ、Kafka

追求消息低延迟:RabbitMQ、Kafka

2.快速入门

2.1 安装RabbitMQ

RabbitMQ 官方地址:http://www.rabbitmq.com/

在Centos7虚拟机中使用Docker来安装。

1.下载镜像

方式一:在线拉取

docker pull rabbitmq:3-management

方式二:从本地加载

在课前资料已经提供了镜像包:

上传到虚拟机中后,使用命令加载镜像即可:

docker load -i mq.tar

2.安装MQ

执行下面的命令来运行MQ容器:

docker run \

-e RABBITMQ_DEFAULT_USER=itcast \

-e RABBITMQ_DEFAULT_PASS=123321 \

--name mq \

--hostname mq1 \

-p 15672:15672 \

-p 5672:5672 \

-d \

rabbitmq:3-management

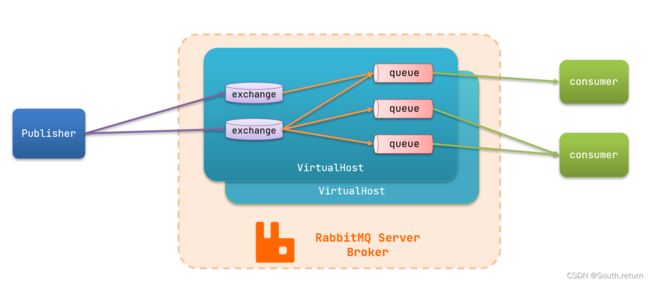

MQ的基本结构:

RabbitMQ中的一些角色:

- publisher:生产者

- consumer:消费者

- exchange个:交换机,负责消息路由

- queue:队列,存储消息

- virtualHost:虚拟主机,隔离不同租户的exchange、queue、消息的隔离

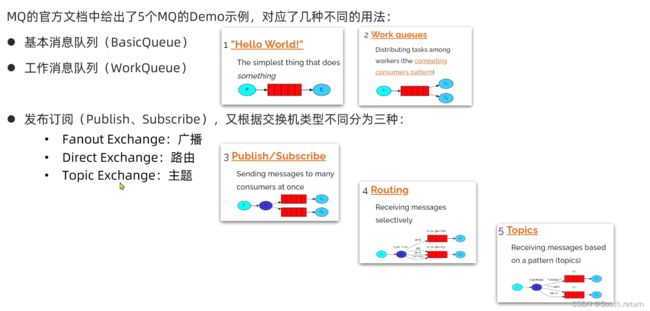

2.2 RabbitMQ消息模型

RabbitMQ官方提供了5个不同的Demo示例,对应了不同的消息模型:

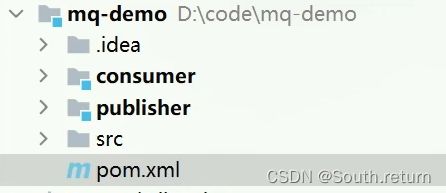

2.3 导入Demo工程

课前资料提供了一个Demo工程,mq-demo:

导入后可以看到结构如下:

包括三部分:

- mq-demo:父工程,管理项目依赖

- publisher:消息的发送者

- consumer:消息的消费者

2.4 入门案例

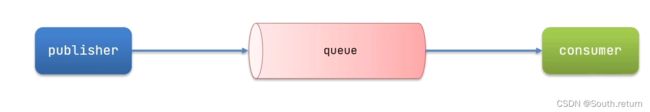

简单队列模式的模型图:

官方的HelloWorld是基于最基础的消息队列模型来实现的,只包括三个角色:

- publisher:消息发布者,将消息发送到队列queue

- queue:消息队列,负责接受并缓存消息

- consumer:订阅队列,处理队列中的消息

2.4.1 publisher实现

思路:

- 建立连接

- 创建Channel

- 声明队列

- 发送消息

- 关闭连接和channel

代码实现:

package cn.itcast.mq.helloworld;

import com.rabbitmq.client.Channel;

import com.rabbitmq.client.Connection;

import com.rabbitmq.client.ConnectionFactory;

import org.junit.Test;

import java.io.IOException;

import java.util.concurrent.TimeoutException;

public class PublisherTest {

@Test

public void testSendMessage() throws IOException, TimeoutException {

// 1.建立连接

ConnectionFactory factory = new ConnectionFactory();

// 1.1.设置连接参数,分别是:主机名、端口号、vhost、用户名、密码

factory.setHost("192.168.150.101");

factory.setPort(5672);

factory.setVirtualHost("/");

factory.setUsername("itcast");

factory.setPassword("123321");

// 1.2.建立连接

Connection connection = factory.newConnection();

// 2.创建通道Channel

Channel channel = connection.createChannel();

// 3.创建队列

String queueName = "simple.queue";

channel.queueDeclare(queueName, false, false, false, null);

// 4.发送消息

String message = "hello, rabbitmq!";

channel.basicPublish("", queueName, null, message.getBytes());

System.out.println("发送消息成功:【" + message + "】");

// 5.关闭通道和连接

channel.close();

connection.close();

}

}

2.4.2 consumer实现

代码思路:

- 建立连接

- 创建Channel

- 声明队列

- 订阅消息

代码实现:

package cn.itcast.mq.helloworld;

import com.rabbitmq.client.*;

import java.io.IOException;

import java.util.concurrent.TimeoutException;

public class ConsumerTest {

public static void main(String[] args) throws IOException, TimeoutException {

// 1.建立连接

ConnectionFactory factory = new ConnectionFactory();

// 1.1.设置连接参数,分别是:主机名、端口号、vhost、用户名、密码

factory.setHost("192.168.150.101");

factory.setPort(5672);

factory.setVirtualHost("/");

factory.setUsername("itcast");

factory.setPassword("123321");

// 1.2.建立连接

Connection connection = factory.newConnection();

// 2.创建通道Channel

Channel channel = connection.createChannel();

// 3.创建队列

String queueName = "simple.queue";

channel.queueDeclare(queueName, false, false, false, null);

// 4.订阅消息

channel.basicConsume(queueName, true, new DefaultConsumer(channel){

@Override

public void handleDelivery(String consumerTag, Envelope envelope,

AMQP.BasicProperties properties, byte[] body) {

// 5.处理消息

String message = new String(body);

System.out.println("接收到消息:【" + message + "】");

}

});

System.out.println("等待接收消息。。。。");

}

}

2.5 总结

基本消息队列的消息发送流程:

-

建立connection

-

创建channel

-

利用channel声明队列

-

利用channel向队列发送消息

基本消息队列的消息接收流程:

-

建立connection

-

创建channel

-

利用channel声明队列

-

定义consumer的消费行为handleDelivery()

-

利用channel将消费者与队列绑定

3.SpringAMQP

SpringAMQP是基于RabbitMQ封装的一套模板,并且还利用SpringBoot对其实现了自动装配,使用起来非常方便。

SpringAmqp的官方地址:https://spring.io/projects/spring-amqp

SpringAMQP提供了三个功能:

- 自动声明队列、交换机及其绑定关系

- 基于注解的监听器模式,异步接收消息

- 封装了RabbitTemplate工具,用于发送消息

3.1 Basic Queue

简单队列模型

在父工程mq-demo中引入依赖

<dependency>

<groupId>org.springframework.bootgroupId>

<artifactId>spring-boot-starter-amqpartifactId>

dependency>

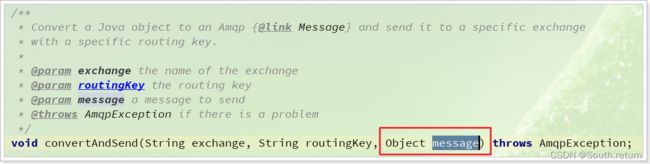

3.1.1 消息发送

首先配置MQ地址,在publisher服务的application.yml中添加配置:

spring:

rabbitmq:

host: 192.168.150.101 # 主机名

port: 5672 # 端口

virtual-host: / # 虚拟主机

username: itcast # 用户名

password: 123321 # 密码

然后在publisher服务中编写测试类SpringAmqpTest,并利用RabbitTemplate实现消息发送:

package cn.itcast.mq.spring;

import org.junit.Test;

import org.junit.runner.RunWith;

import org.springframework.amqp.rabbit.core.RabbitTemplate;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.boot.test.context.SpringBootTest;

import org.springframework.test.context.junit4.SpringRunner;

@RunWith(SpringRunner.class)

@SpringBootTest

public class SpringAmqpTest {

@Autowired

private RabbitTemplate rabbitTemplate;

@Test

public void testSimpleQueue() {

// 队列名称

String queueName = "simple.queue";

// 消息

String message = "hello, spring amqp!";

// 发送消息

rabbitTemplate.convertAndSend(queueName, message);

}

}

3.1.2 消息接收

首先配置MQ地址,在consumer服务的application.yml中添加配置:

spring:

rabbitmq:

host: 192.168.150.101 # 主机名

port: 5672 # 端口

virtual-host: / # 虚拟主机

username: itcast # 用户名

password: 123321 # 密码

然后在consumer服务的cn.itcast.mq.listener包中新建一个类SpringRabbitListener,代码如下:

package cn.itcast.mq.listener;

import org.springframework.amqp.rabbit.annotation.RabbitListener;

import org.springframework.stereotype.Component;

@Component

public class SpringRabbitListener {

@RabbitListener(queues = "simple.queue")

public void listenSimpleQueueMessage(String msg) throws InterruptedException {

System.out.println("spring 消费者接收到消息:【" + msg + "】");

}

}

3.1.3 测试

启动consumer服务,然后在publisher服务中运行测试代码,发送MQ消息。

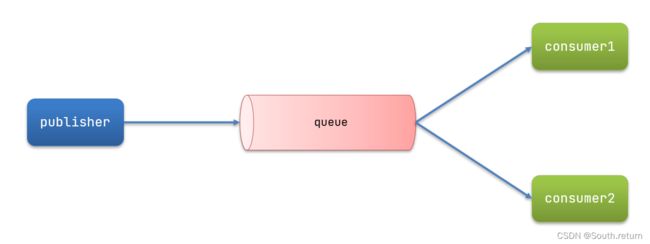

3.2 WorkQueue

Work queues,也被称为(Task queues),任务模型。简单来说就是让多个消费者绑定到一个队列,共同消费队列中的消息。

当消息处理比较耗时的时候,可能生产消息的速度会远远大于消息的消费速度。长此以往,消息就会堆积越来越多,无法及时处理。

此时就可以使用work 模型,多个消费者共同处理消息处理,速度就能大大提高了。

3.2.1 消息发送

这次循环发送,模拟大量消息堆积现象。

在publisher服务中的SpringAmqpTest类中添加一个测试方法:

/**

* workQueue

* 向队列中不停发送消息,模拟消息堆积。

*/

@Test

public void testWorkQueue() throws InterruptedException {

// 队列名称

String queueName = "simple.queue";

// 消息

String message = "hello, message_";

for (int i = 0; i < 50; i++) {

// 发送消息

rabbitTemplate.convertAndSend(queueName, message + i);

Thread.sleep(20);

}

}

3.2.2 消息接收

模拟多个消费者绑定同一个队列,在consumer服务的SpringRabbitListener中添加2个新的方法:

@RabbitListener(queues = "simple.queue")

public void listenWorkQueue1(String msg) throws InterruptedException {

System.out.println("消费者1接收到消息:【" + msg + "】" + LocalTime.now());

Thread.sleep(20);

}

@RabbitListener(queues = "simple.queue")

public void listenWorkQueue2(String msg) throws InterruptedException {

System.err.println("消费者2接收到消息:【" + msg + "】" + LocalTime.now());

Thread.sleep(200);

}

注意到这个消费者sleep了1000秒,模拟任务耗时。

3.2.3 测试

启动ConsumerApplication后,在执行publisher服务中刚刚编写的发送测试方法testWorkQueue。

可以看到消费者1很快完成了自己的25条消息。消费者2却在缓慢的处理自己的25条消息。也就是说消息是平均分配给每个消费者,并没有考虑到消费者的处理能力。这样显然是有问题的。

3.2.4 能者多劳

在spring中有一个配置可以解决,修改consumer服务的application.yml文件,添加配置:

spring:

rabbitmq:

listener:

simple:

prefetch: 1 # 每次只能获取一条消息,处理完成才能获取下一个消息

3.2.5 总结

Work模型的使用:

- 多个消费者绑定到一个队列,同一条消息只会被一个消费者处理

- 通过设置prefetch来控制消费者预取的消息数量

3.3 发布/订阅

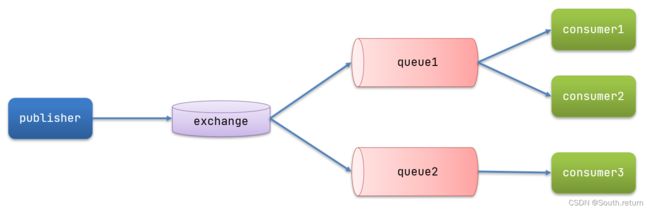

发布订阅的模型如图:

可以看到,在订阅模型中,多了一个exchange角色,而且过程略有变化:

- Publisher:生产者,也就是要发送消息的程序,但是不再发送到队列中,而是发给X(交换机)

- Exchange:交换机,图中的X。一方面,接收生产者发送的消息。另一方面,知道如何处理消息,例如递交给某个特别队列、递交给所有队列、或是将消息丢弃。到底如何操作,取决于Exchange的类型。Exchange有以下3种类型:

- Fanout:广播,将消息交给所有绑定到交换机的队列

- Direct:定向,把消息交给符合指定routing key 的队列

- Topic:通配符,把消息交给符合routing pattern(路由模式) 的队列

- Consumer:消费者,与以前一样,订阅队列,没有变化

- Queue:消息队列也与以前一样,接收消息、缓存消息。

Exchange(交换机)只负责转发消息,不具备存储消息的能力,因此如果没有任何队列与Exchange绑定,或者没有符合路由规则的队列,那么消息会丢失!

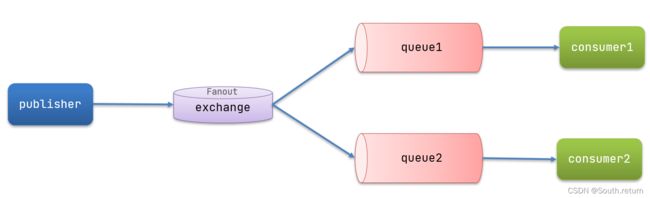

3.4 Fanout

Fanout,英文翻译是扇出,在MQ中叫广播更合适。

在广播模式下,消息发送流程是这样的:

- 1) 可以有多个队列

- 2) 每个队列都要绑定到Exchange(交换机)

- 3) 生产者发送的消息,只能发送到交换机,交换机来决定要发给哪个队列,生产者无法决定

- 4) 交换机把消息发送给绑定过的所有队列

- 5) 订阅队列的消费者都能拿到消息

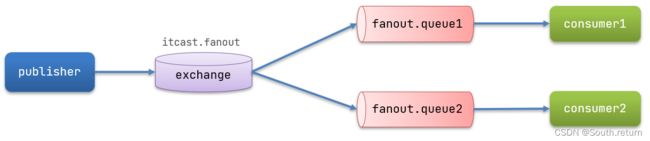

计划是这样的:

- 创建一个交换机 itcast.fanout,类型是Fanout

- 创建两个队列fanout.queue1和fanout.queue2,绑定到交换机itcast.fanout

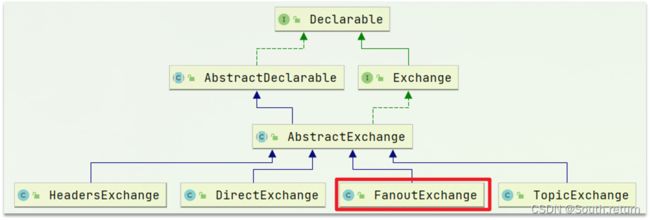

3.4.1 声明队列和交换机

Spring提供了一个接口Exchange,来表示所有不同类型的交换机:

在consumer中创建一个类,声明队列和交换机:

package cn.itcast.mq.config;

import org.springframework.amqp.core.Binding;

import org.springframework.amqp.core.BindingBuilder;

import org.springframework.amqp.core.FanoutExchange;

import org.springframework.amqp.core.Queue;

import org.springframework.context.annotation.Bean;

import org.springframework.context.annotation.Configuration;

@Configuration

public class FanoutConfig {

/**

* 声明交换机

* @return Fanout类型交换机

*/

@Bean

public FanoutExchange fanoutExchange(){

return new FanoutExchange("itcast.fanout");

}

/**

* 第1个队列

*/

@Bean

public Queue fanoutQueue1(){

return new Queue("fanout.queue1");

}

/**

* 绑定队列和交换机

*/

@Bean

public Binding bindingQueue1(Queue fanoutQueue1, FanoutExchange fanoutExchange){

return BindingBuilder.bind(fanoutQueue1).to(fanoutExchange);

}

/**

* 第2个队列

*/

@Bean

public Queue fanoutQueue2(){

return new Queue("fanout.queue2");

}

/**

* 绑定队列和交换机

*/

@Bean

public Binding bindingQueue2(Queue fanoutQueue2, FanoutExchange fanoutExchange){

return BindingBuilder.bind(fanoutQueue2).to(fanoutExchange);

}

}

3.4.2 消息发送

在publisher服务的SpringAmqpTest类中添加测试方法:

@Test

public void testFanoutExchange() {

// 队列名称

String exchangeName = "itcast.fanout";

// 消息

String message = "hello, everyone!";

rabbitTemplate.convertAndSend(exchangeName, "", message);

}

3.4.3 消息接收

在consumer服务的SpringRabbitListener中添加两个方法,作为消费者:

@RabbitListener(queues = "fanout.queue1")

public void listenFanoutQueue1(String msg) {

System.out.println("消费者1接收到Fanout消息:【" + msg + "】");

}

@RabbitListener(queues = "fanout.queue2")

public void listenFanoutQueue2(String msg) {

System.out.println("消费者2接收到Fanout消息:【" + msg + "】");

}

3.4.4 总结

交换机的作用是什么?

- 接收publisher发送的消息

- 将消息按照规则路由到与之绑定的队列

- 不能缓存消息,路由失败,消息丢失

- FanoutExchange的会将消息路由到每个绑定的队列

声明队列、交换机、绑定关系的Bean是什么?

- Queue

- FanoutExchange

- Binding

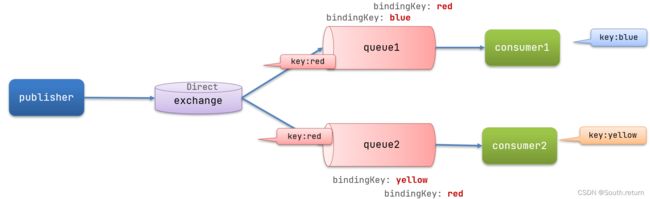

3.5 Direct

在Fanout模式中,一条消息,会被所有订阅的队列都消费。但是,在某些场景下,我们希望不同的消息被不同的队列消费。这时就要用到Direct类型的Exchange。

在Direct模型下:

- 队列与交换机的绑定,不能是任意绑定了,而是要指定一个

RoutingKey(路由key) - 消息的发送方在 向 Exchange发送消息时,也必须指定消息的

RoutingKey。 - Exchange不再把消息交给每一个绑定的队列,而是根据消息的

Routing Key进行判断,只有队列的Routingkey与消息的Routing key完全一致,才会接收到消息

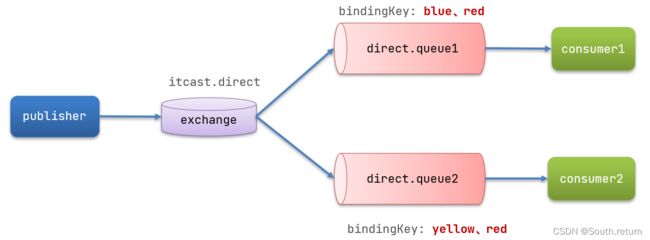

案例需求如下:

-

利用@RabbitListener声明Exchange、Queue、RoutingKey

-

在consumer服务中,编写两个消费者方法,分别监听direct.queue1和direct.queue2

-

在publisher中编写测试方法,向itcast. direct发送消息

3.5.1 注解声明队列和交换机

基于@Bean的方式声明队列和交换机比较麻烦,Spring还提供了基于注解方式来声明。

在consumer的SpringRabbitListener中添加两个消费者,同时基于注解来声明队列和交换机:

@RabbitListener(bindings = @QueueBinding(

value = @Queue(name = "direct.queue1"),

exchange = @Exchange(name = "itcast.direct", type = ExchangeTypes.DIRECT),

key = {"red", "blue"}

))

public void listenDirectQueue1(String msg){

System.out.println("消费者接收到direct.queue1的消息:【" + msg + "】");

}

@RabbitListener(bindings = @QueueBinding(

value = @Queue(name = "direct.queue2"),

exchange = @Exchange(name = "itcast.direct", type = ExchangeTypes.DIRECT),

key = {"red", "yellow"}

))

public void listenDirectQueue2(String msg){

System.out.println("消费者接收到direct.queue2的消息:【" + msg + "】");

}

3.5.2 消息发送

在publisher服务的SpringAmqpTest类中添加测试方法:

@Test

public void testSendDirectExchange() {

// 交换机名称

String exchangeName = "itcast.direct";

// 消息

String message = "红色警报!日本乱排核废水,导致海洋生物变异,惊现哥斯拉!";

// 发送消息

rabbitTemplate.convertAndSend(exchangeName, "red", message);

}

3.5.3 总结

描述下Direct交换机与Fanout交换机的差异?

- Fanout交换机将消息路由给每一个与之绑定的队列

- Direct交换机根据RoutingKey判断路由给哪个队列

- 如果多个队列具有相同的RoutingKey,则与Fanout功能类似

基于@RabbitListener注解声明队列和交换机有哪些常见注解?

- @Queue

- @Exchange

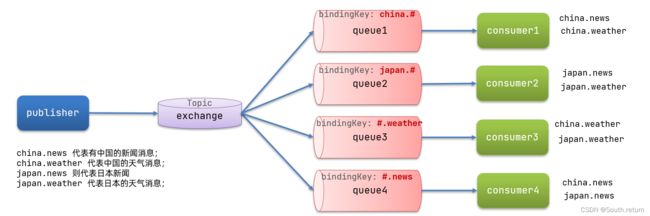

3.6 Topic

3.6.1 说明

Topic类型的Exchange与Direct相比,都是可以根据RoutingKey把消息路由到不同的队列。只不过Topic类型Exchange可以让队列在绑定Routing key 的时候使用通配符!

Routingkey 一般都是有一个或多个单词组成,多个单词之间以”.”分割,例如: item.insert

通配符规则:

#:匹配一个或多个词

*:匹配不多不少恰好1个词

举例:

item.#:能够匹配item.spu.insert 或者 item.spu

item.*:只能匹配item.spu

图示:

解释:

- Queue1:绑定的是

china.#,因此凡是以china.开头的routing key都会被匹配到。包括china.news和china.weather - Queue2:绑定的是

#.news,因此凡是以.news结尾的routing key都会被匹配。包括china.news和japan.news

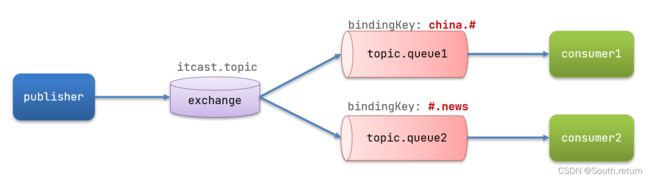

案例需求:

实现思路如下:

-

并利用@RabbitListener声明Exchange、Queue、RoutingKey

-

在consumer服务中,编写两个消费者方法,分别监听topic.queue1和topic.queue2

-

在publisher中编写测试方法,向itcast. topic发送消息

3.6.2 消息发送

在publisher服务的SpringAmqpTest类中添加测试方法:

/**

* topicExchange

*/

@Test

public void testSendTopicExchange() {

// 交换机名称

String exchangeName = "itcast.topic";

// 消息

String message = "喜报!孙悟空大战哥斯拉,胜!";

// 发送消息

rabbitTemplate.convertAndSend(exchangeName, "china.news", message);

}

3.6.3 消息接收

在consumer服务的SpringRabbitListener中添加方法:

@RabbitListener(bindings = @QueueBinding(

value = @Queue(name = "topic.queue1"),

exchange = @Exchange(name = "itcast.topic", type = ExchangeTypes.TOPIC),

key = "china.#"

))

public void listenTopicQueue1(String msg){

System.out.println("消费者接收到topic.queue1的消息:【" + msg + "】");

}

@RabbitListener(bindings = @QueueBinding(

value = @Queue(name = "topic.queue2"),

exchange = @Exchange(name = "itcast.topic", type = ExchangeTypes.TOPIC),

key = "#.news"

))

public void listenTopicQueue2(String msg){

System.out.println("消费者接收到topic.queue2的消息:【" + msg + "】");

}

3.6.4 总结

描述下Direct交换机与Topic交换机的差异?

- Topic交换机接收的消息RoutingKey必须是多个单词,以

**.**分割 - Topic交换机与队列绑定时的bindingKey可以指定通配符

#:代表0个或多个词*:代表1个词

3.7 消息转换器

Spring会把发送的消息序列化为字节发送给MQ,接收消息的时候,还会把字节反序列化为Java对象。

默认情况下Spring采用的序列化方式是JDK序列化。众所周知,JDK序列化存在下列问题:

- 数据体积过大

- 有安全漏洞

- 可读性差

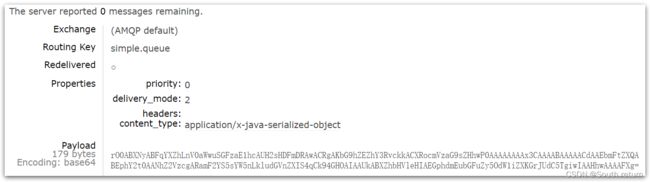

3.7.1 测试默认转换器

修改消息发送的代码,发送一个Map对象:

@Test

public void testSendMap() throws InterruptedException {

// 准备消息

Map<String,Object> msg = new HashMap<>();

msg.put("name", "Jack");

msg.put("age", 21);

// 发送消息

rabbitTemplate.convertAndSend("simple.queue","", msg);

}

停止consumer服务

发送消息后查看控制台:

3.7.2 配置JSON转换器

显然,JDK序列化方式并不合适。我们希望消息体的体积更小、可读性更高,因此可以使用JSON方式来做序列化和反序列化。

在publisher和consumer两个服务中都引入依赖:

<dependency>

<groupId>com.fasterxml.jackson.dataformatgroupId>

<artifactId>jackson-dataformat-xmlartifactId>

<version>2.9.10version>

dependency>

配置消息转换器。

在启动类中添加一个Bean即可:

@Bean

public MessageConverter jsonMessageConverter(){

return new Jackson2JsonMessageConverter();

}

4.高级特性

4.1 消息的可靠投递

在使用 RabbitMQ 的时候,作为消息发送方希望杜绝任何消息丢失或者投递失败场景。RabbitMQ 为我们提供了两种方式用来控制消息的投递可靠性模式。

- confirm 确认模式

- return 退回模式

rabbitmq 整个消息投递的路径为:

producer—>rabbitmq broker—>exchange—>queue—>consumer

- 消息从 producer 到 exchange 则会返回一个 confirmCallback

- 消息从 exchange–>queue 投递失败,则会返回一个 returnCallback

利用这两个 callback 控制消息的可靠性投递

确认模式:

- 确认模式开启,设置 ConnectionFactory 的 publisher-confirms=“true”

- 使用 rabbitTemplate.setConfirmCallback 设置回调函数。当消息发送到exchange后回调confirm方法。在方法中判断ack,如果为true,则发送成功,如果为false,则发送失败,需要处理

rabbitmq.host=172.16.98.133

rabbitmq.port=5672

rabbitmq.username=guest

rabbitmq.password=guest

rabbitmq.virtual-host=/

<context:property-placeholder location="classpath:rabbitmq.properties"/>

<rabbit:connection-factory id="connectionFactory" host="${rabbitmq.host}"

port="${rabbitmq.port}"

username="${rabbitmq.username}"

password="${rabbitmq.password}"

virtual-host="${rabbitmq.virtual-host}"

publisher-confirms="true"

/>

<rabbit:template id="rabbitTemplate" connection-factory="connectionFactory"/>

<rabbit:queue id="test_queue_confirm" name="test_queue_confirm">rabbit:queue>

<rabbit:direct-exchange name="test_exchange_confirm">

<rabbit:bindings>

<rabbit:binding queue="test_queue_confirm" key="confirm">rabbit:binding>

rabbit:bindings>

rabbit:direct-exchange>

/**

* 确认模式:

* 步骤:

* 1. 确认模式开启:ConnectionFactory中开启publisher-confirms="true"

* 2. 在rabbitTemplate定义ConfirmCallBack回调函数

*/

@Test

public void testConfirm() {

//2. 定义回调

rabbitTemplate.setConfirmCallback(new RabbitTemplate.ConfirmCallback() {

/**

* @param correlationData 相关配置信息

* @param ack exchange交换机 是否成功收到了消息。true 成功,false代表失败

* @param cause 失败原因

*/

@Override

public void confirm(CorrelationData correlationData, boolean ack, String cause) {

System.out.println("confirm方法被执行了....");

if (ack) {

//接收成功

System.out.println("接收成功消息" + cause);

} else {

//接收失败

System.out.println("接收失败消息" + cause);

//做一些处理,让消息再次发送。

}

}

});

//3. 发送消息

rabbitTemplate.convertAndSend("test_exchange_confirm111", "confirm", "message confirm....");

}

回退模式:

- 回退模式开启,设置ConnectionFactory的publisher-returns=“true” 开启

- 使用rabbitTemplate.setReturnCallback设置退回函数(如果不设置默认丢弃消息),当消息从exchange路由到queue失败后,如果设置了rabbitTemplate.setMandatory(true)参数,则会将消息退回给producer。并执行回调函数returnedMessage

<rabbit:connection-factory id="connectionFactory" host="${rabbitmq.host}"

port="${rabbitmq.port}"

username="${rabbitmq.username}"

password="${rabbitmq.password}"

virtual-host="${rabbitmq.virtual-host}"

publisher-confirms="true"

publisher-returns="true"

/>

/**

* 回退模式: 当消息发送给Exchange后,Exchange路由到Queue失败是 才会执行 ReturnCallBack

* 步骤:

* 1. 开启回退模式:publisher-returns="true"

* 2. 设置ReturnCallBack

* 3. 设置Exchange处理消息的模式:

* 1. 如果消息没有路由到Queue,则丢弃消息(默认)

* 2. 如果消息没有路由到Queue,返回给消息发送方ReturnCallBack

*/

@Test

public void testReturn() {

//设置交换机处理失败消息的模式

rabbitTemplate.setMandatory(true);

//2.设置ReturnCallBack

rabbitTemplate.setReturnCallback(new RabbitTemplate.ReturnCallback() {

/**

*

* @param message 消息对象

* @param replyCode 错误码

* @param replyText 错误信息

* @param exchange 交换机

* @param routingKey 路由键

*/

@Override

public void returnedMessage(Message message, int replyCode, String replyText, String exchange, String routingKey) {

System.out.println("return 执行了....");

System.out.println(message);

System.out.println(replyCode);

System.out.println(replyText);

System.out.println(exchange);

System.out.println(routingKey);

//处理

}

});

//3. 发送消息

rabbitTemplate.convertAndSend("test_exchange_confirm", "confirm", "message confirm....");

}

4.2 Consumer Ack

ack指Acknowledge,确认。 表示消费端收到消息后的确认方式。

有三种确认方式:

- 自动确认:acknowledge=“none”

- 手动确认:acknowledge=“manual”

- 根据异常情况确认:acknowledge=“auto”

其中自动确认是指,当消息一旦被Consumer接收到,则自动确认收到,并将相应 message 从 RabbitMQ 的消息缓存中移除。但是在实际业务处理中,很可能消息接收到,业务处理出现异常,那么该消息就会丢失。如果设置了手动确认方式,则需要在业务处理成功后,调用 channel.basicAck(),手动签收,如果出现异常,则调用 channel.basicNack()方法,让其自动重新发送消息。

- 设置acknowledge属性,设置ack方式 none:自动确认,manual:手动确认

- 如果在消费端没有出现异常,则调用channel.basicAck(deliveryTag,false);方法确认签收消息

- 如果出现异常,则在catch中调用 basicNack或 basicReject,拒绝消息,让MQ重新发送消息

<rabbit:listener-container connection-factory="connectionFactory" acknowledge="manual">

<rabbit:listener ref="ackListener" queue-names="test_queue_confirm">rabbit:listener>

rabbit:listener-container>

/**

* Consumer ACK机制:

* 1. 设置手动签收。acknowledge="manual"

* 2. 让监听器类实现ChannelAwareMessageListener接口

* 3. 如果消息成功处理,则调用channel的 basicAck()签收

* 4. 如果消息处理失败,则调用channel的basicNack()拒绝签收,broker重新发送给consumer

*/

@Component

public class AckListener implements ChannelAwareMessageListener {

@Override

public void onMessage(Message message, Channel channel) throws Exception {

long deliveryTag = message.getMessageProperties().getDeliveryTag();

try {

//1.接收转换消息

System.out.println(new String(message.getBody()));

//2.处理业务逻辑

System.out.println("处理业务逻辑...");

int i = 3/0;//出现错误

//3.手动签收

channel.basicAck(deliveryTag,true);

} catch (Exception e) {

//4.拒绝签收

/*

第三个参数:requeue:重回队列。

如果设置为true,则消息重新回到queue,broker会重新发送该消息给消费端

*/

channel.basicNack(deliveryTag,true,true);

//channel.basicReject(deliveryTag,true);

}

}

}

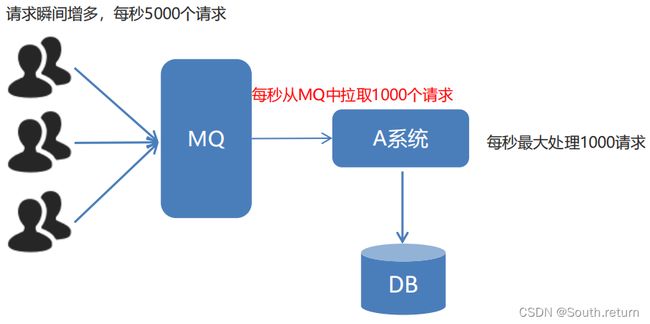

4.3 消费端限流

- 在rabbit:listener-container中配置prefetch属性设置消费端一次拉取多少消息

- 消费端的确认模式一定为手动确认。acknowledge=“manual”

<rabbit:listener-container connection-factory="connectionFactory" acknowledge="manual" prefetch="1" >

<rabbit:listener ref="ackListener" queue-names="test_queue_confirm">rabbit:listener>

rabbit:listener-container>

/**

* Consumer 限流机制

* 1. 确保ack机制为手动确认。

* 2. listener-container配置属性

* perfetch = 1,表示消费端每次从mq拉去一条消息来消费,直到手动确认消费完毕后,才会继续拉去 下一条消息。

*/

public class QosListener implements ChannelAwareMessageListener {

@Override

public void onMessage(Message message, Channel channel) throws Exception {

Thread.sleep(1000);

//1.获取消息

System.out.println(new String(message.getBody()));

//2. 处理业务逻辑

//3. 签收

channel.basicAck(message.getMessageProperties().getDeliveryTag(),true);

}

}

4.4 TTL

- TTL 全称 Time To Live(存活时间/过期时间)

- 当消息到达存活时间后,还没有被消费,会被自动清除

- RabbitMQ可以对消息设置过期时间,也可以对整个队列(Queue)设置过期时间

设置队列过期时间使用参数:x-message-ttl,单位:ms(毫秒)。

设置消息过期时间使用参数:expiration。单位:ms(毫秒)。

<rabbit:queue name="test_queue_ttl" id="test_queue_ttl">

<rabbit:queue-arguments>

<entry key="x-message-ttl" value="100000" value-type="java.lang.Integer">entry>

rabbit:queue-arguments>

rabbit:queue>

<rabbit:topic-exchange name="test_exchange_ttl" >

<rabbit:bindings>

<rabbit:binding pattern="ttl.#" queue="test_queue_ttl">rabbit:binding>

rabbit:bindings>

rabbit:topic-exchange>

/**

* TTL:过期时间

* 1. 队列统一过期

* 2. 消息单独过期

*

* 如果设置了消息的过期时间,也设置了队列的过期时间,它以时间短的为准。

* 队列过期后,会将队列所有消息全部移除。

* 消息过期后,只有消息在队列顶端,才会判断其是否过期(移除掉)

*/

@Test

public void testTtl() {

/* for (int i = 0; i < 10; i++) {

// 发送消息

rabbitTemplate.convertAndSend("test_exchange_ttl", "ttl.hehe", "message ttl....");

}*/

// 消息后处理对象,设置一些消息的参数信息

MessagePostProcessor messagePostProcessor = new MessagePostProcessor() {

@Override

public Message postProcessMessage(Message message) throws AmqpException {

//1.设置message的信息

message.getMessageProperties().setExpiration("5000");//消息的过期时间

//2.返回该消息

return message;

}

};

//消息单独过期

//rabbitTemplate.convertAndSend("test_exchange_ttl", "ttl.hehe", "message ttl....",messagePostProcessor);

for (int i = 0; i < 10; i++) {

if(i == 5){

//消息单独过期

rabbitTemplate.convertAndSend("test_exchange_ttl", "ttl.hehe", "message ttl....",messagePostProcessor);

}else{

//不过期的消息

rabbitTemplate.convertAndSend("test_exchange_ttl", "ttl.hehe", "message ttl....");

}

}

}

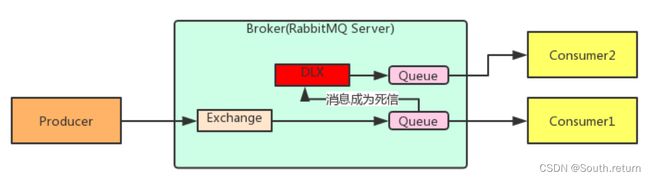

4.5 死信队列

死信队列,英文缩写:DLX 。Dead Letter Exchange(死信交换机),当消息成为Dead message后,可以被重新发送到另一个交换机,这个交换机就是DLX。

消息成为死信的三种情况:

- 队列消息长度到达限制

- 消费者拒接消费消息 basicNack/basicReject,并且不把消息重新放入原目标队列 requeue=false

- 原队列存在消息过期设置,消息到达超时时间未被消费

队列绑定死信交换机:

给队列设置参数: x-dead-letter-exchange 和 x-dead-letter-routing-key

<rabbit:queue name="test_queue_dlx" id="test_queue_dlx">

<rabbit:queue-arguments>

<entry key="x-dead-letter-exchange" value="exchange_dlx" />

<entry key="x-dead-letter-routing-key" value="dlx.hehe" />

<entry key="x-max-length" value="10" value-type="java.lang.Integer" />

rabbit:queue-arguments>

rabbit:queue>

<rabbit:topic-exchange name="test_exchange_dlx">

<rabbit:bindings>

<rabbit:binding pattern="test.dlx.#" queue="test_queue_dlx">rabbit:binding>

rabbit:bindings>

rabbit:topic-exchange>

<rabbit:queue name="queue_dlx" id="queue_dlx">rabbit:queue>

<rabbit:topic-exchange name="exchange_dlx">

<rabbit:bindings>

<rabbit:binding pattern="dlx.#" queue="queue_dlx">rabbit:binding>

rabbit:bindings>

rabbit:topic-exchange>

/**

* 发送测试死信消息:

* 1. 过期时间

* 2. 长度限制

* 3. 消息拒收

*/

@Test

public void testDlx(){

//1. 测试过期时间,死信消息

//rabbitTemplate.convertAndSend("test_exchange_dlx","test.dlx.haha","我是一条消息,我会死吗?");

//2. 测试长度限制后,消息死信

/* for (int i = 0; i < 20; i++) {

rabbitTemplate.convertAndSend("test_exchange_dlx","test.dlx.haha","我是一条消息,我会死吗?");

}*/

//3. 测试消息拒收

rabbitTemplate.convertAndSend("test_exchange_dlx","test.dlx.haha","我是一条消息,我会死吗?");

}

@Component

public class DlxListener implements ChannelAwareMessageListener {

@Override

public void onMessage(Message message, Channel channel) throws Exception {

long deliveryTag = message.getMessageProperties().getDeliveryTag();

try {

//1.接收转换消息

System.out.println(new String(message.getBody()));

//2. 处理业务逻辑

System.out.println("处理业务逻辑...");

int i = 3/0;//出现错误

//3. 手动签收

channel.basicAck(deliveryTag,true);

} catch (Exception e) {

//e.printStackTrace();

System.out.println("出现异常,拒绝接受");

//4.拒绝签收,不重回队列 requeue=false

channel.basicNack(deliveryTag,true,false);

}

}

}

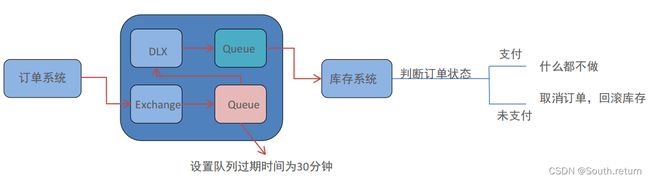

4.6 延迟队列

延迟队列,即消息进入队列后不会立即被消费,只有到达指定时间后,才会被消费。在RabbitMQ中并未提供延迟队列功能。

可以使用:TTL+死信队列 组合实现延迟队列的效果。

需求:

- 下单后,30分钟未支付,取消订单,回滚库存。

- 新用户注册成功7天后,发送短信问候。

<rabbit:queue id="order_queue" name="order_queue">

<rabbit:queue-arguments>

<entry key="x-dead-letter-exchange" value="order_exchange_dlx" />

<entry key="x-dead-letter-routing-key" value="dlx.order.cancel" />

<entry key="x-message-ttl" value="10000" value-type="java.lang.Integer" />

rabbit:queue-arguments>

rabbit:queue>

<rabbit:topic-exchange name="order_exchange">

<rabbit:bindings>

<rabbit:binding pattern="order.#" queue="order_queue">rabbit:binding>

rabbit:bindings>

rabbit:topic-exchange>

<rabbit:queue id="order_queue_dlx" name="order_queue_dlx">rabbit:queue>

<rabbit:topic-exchange name="order_exchange_dlx">

<rabbit:bindings>

<rabbit:binding pattern="dlx.order.#" queue="order_queue_dlx">rabbit:binding>

rabbit:bindings>

rabbit:topic-exchange>

@Test

public void testDelay() throws InterruptedException {

//1.发送订单消息。 将来是在订单系统中,下单成功后,发送消息

rabbitTemplate.convertAndSend("order_exchange","order.msg","订单信息:id=1,time=2019年8月17日16:41:47");

/*//2.打印倒计时10秒

for (int i = 10; i > 0 ; i--) {

System.out.println(i+"...");

Thread.sleep(1000);

}*/

}

<rabbit:listener-container connection-factory="connectionFactory" acknowledge="manual" prefetch="1" >

<rabbit:listener ref="orderListener" queue-names="order_queue_dlx">rabbit:listener>

rabbit:listener-container>

@Component

public class OrderListener implements ChannelAwareMessageListener {

@Override

public void onMessage(Message message, Channel channel) throws Exception {

long deliveryTag = message.getMessageProperties().getDeliveryTag();

try {

//1.接收转换消息

System.out.println(new String(message.getBody()));

//2. 处理业务逻辑

System.out.println("处理业务逻辑...");

System.out.println("根据订单id查询其状态...");

System.out.println("判断状态是否为支付成功");

System.out.println("取消订单,回滚库存....");

//3. 手动签收

channel.basicAck(deliveryTag,true);

} catch (Exception e) {

//e.printStackTrace();

System.out.println("出现异常,拒绝接受");

//4.拒绝签收,不重回队列 requeue=false

channel.basicNack(deliveryTag,true,false);

}

}

}

4.7 日志与监控

RabbitMQ默认日志存放路径: /var/log/rabbitmq/[email protected]

日志包含了RabbitMQ的版本号、Erlang的版本号、RabbitMQ服务节点名称、cookie的hash值、RabbitMQ配置文件地址、内存限制、磁盘限制、默认账户guest的创建以及权限配置等

查看队列

# rabbitmqctl list_queues

查看exchanges

# rabbitmqctl list_exchanges

查看用户

# rabbitmqctl list_users

查看连接

# rabbitmqctl list_connections

查看消费者信息

# rabbitmqctl list_consumers

查看环境变量

# rabbitmqctl environment

查看未被确认的队列

# rabbitmqctl list_queues name messages_unacknowledged

查看单个队列的内存使用

# rabbitmqctl list_queues name memory

查看准备就绪的队列

# rabbitmqctl list_queues name messages_ready

4.8 消息追踪

在使用任何消息中间件的过程中,难免会出现某条消息异常丢失的情况。对于RabbitMQ而言,可能是因为生产者或消费者与RabbitMQ断开了连接,而它们与RabbitMQ又采用了不同的确认机制;也有可能是因为交换器与队列之间不同的转发策略;甚至是交换器并没有与任何队列进行绑定,生产者又不感知或者没有采取相应的措施;另外RabbitMQ本身的集群策略也可能导致消息的丢失。这个时候就需要有一个较好的机制跟踪记录消息的投递过程,以此协助开发和运维人员进行问题的定位。

在RabbitMQ中可以使用 Firehose 和 rabbitmq_tracing插件功能来实现消息追踪。

firehose的机制是将生产者投递给rabbitmq的消息,rabbitmq投递给消费者的消息按照指定的格式发送到默认的exchange上。这个默认的exchange的名称为amq.rabbitmq.trace,它是一个topic类型的exchange。发送到这个exchange上的消息的routing key为 publish.exchangename 和 deliver.queuename。其中exchangename和queuename为实际exchange和queue的名称,分别对应生产者投递到exchange的消息,和消费者从queue上获取的消息。

注意:打开 trace 会影响消息写入功能,适当打开后请关闭。

- rabbitmqctl trace_on:开启 Firehose命令

- rabbitmqctl trace_off:关闭 Firehose命令

rabbitmq_tracing 和 Firehose在实现上如出一辙,只不过 rabbitmq_tracing的方式比Firehose多了一层GUI的包装,更容易使用和管理。

启用插件:rabbitmq-plugins enable rabbitmq_tracing

5.应用问题

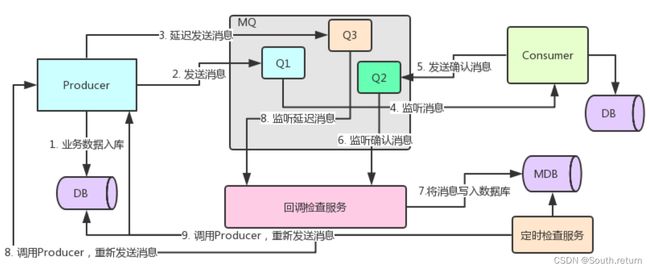

5.1 消息可靠性保障

消息补偿

5.2 消息幂等性保障

幂等性指一次和多次请求某一个资源,对于资源本身应该具有同样的结果。也就是说,其任意多次执行对资源本身所产生的影响均与一次执行的影响相同。

在MQ中指,消费多条相同的消息,得到与消费该消息一次相同的结果。

乐观锁机制

6.集群搭建

6.1 集群方案的原理

RabbitMQ这款消息队列中间件产品本身是基于Erlang编写,Erlang语言天生具备分布式特性(通过同步Erlang集群各节点的magic cookie来实现)。因此,RabbitMQ天然支持Clustering。这使得RabbitMQ本身不需要像ActiveMQ、Kafka那样通过ZooKeeper分别来实现HA方案和保存集群的元数据。集群是保证可靠性的一种方式,同时可以通过水平扩展以达到增加消息吞吐量能力的目的。

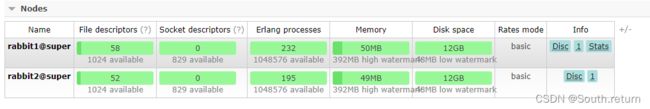

6.2 单机多实例部署

由于某些因素的限制,有时候你不得不在一台机器上去搭建一个rabbitmq集群,这个有点类似zookeeper的单机版。真实生成环境还是要配成多机集群的。有关怎么配置多机集群的可以参考其他的资料,这里主要论述如何在单机中配置多个rabbitmq实例。

主要参考官方文档:https://www.rabbitmq.com/clustering.html

首先确保RabbitMQ运行没有问题

[root@super ~]# rabbitmqctl status

Status of node rabbit@super ...

[{pid,10232},

{running_applications,

[{rabbitmq_management,"RabbitMQ Management Console","3.6.5"},

{rabbitmq_web_dispatch,"RabbitMQ Web Dispatcher","3.6.5"},

{webmachine,"webmachine","1.10.3"},

{mochiweb,"MochiMedia Web Server","2.13.1"},

{rabbitmq_management_agent,"RabbitMQ Management Agent","3.6.5"},

{rabbit,"RabbitMQ","3.6.5"},

{os_mon,"CPO CXC 138 46","2.4"},

{syntax_tools,"Syntax tools","1.7"},

{inets,"INETS CXC 138 49","6.2"},

{amqp_client,"RabbitMQ AMQP Client","3.6.5"},

{rabbit_common,[],"3.6.5"},

{ssl,"Erlang/OTP SSL application","7.3"},

{public_key,"Public key infrastructure","1.1.1"},

{asn1,"The Erlang ASN1 compiler version 4.0.2","4.0.2"},

{ranch,"Socket acceptor pool for TCP protocols.","1.2.1"},

{mnesia,"MNESIA CXC 138 12","4.13.3"},

{compiler,"ERTS CXC 138 10","6.0.3"},

{crypto,"CRYPTO","3.6.3"},

{xmerl,"XML parser","1.3.10"},

{sasl,"SASL CXC 138 11","2.7"},

{stdlib,"ERTS CXC 138 10","2.8"},

{kernel,"ERTS CXC 138 10","4.2"}]},

{os,{unix,linux}},

{erlang_version,

"Erlang/OTP 18 [erts-7.3] [source] [64-bit] [async-threads:64] [hipe] [kernel-poll:true]\n"},

{memory,

[{total,56066752},

{connection_readers,0},

{connection_writers,0},

{connection_channels,0},

{connection_other,2680},

{queue_procs,268248},

{queue_slave_procs,0},

{plugins,1131936},

{other_proc,18144280},

{mnesia,125304},

{mgmt_db,921312},

{msg_index,69440},

{other_ets,1413664},

{binary,755736},

{code,27824046},

{atom,1000601},

{other_system,4409505}]},

{alarms,[]},

{listeners,[{clustering,25672,"::"},{amqp,5672,"::"}]},

{vm_memory_high_watermark,0.4},

{vm_memory_limit,411294105},

{disk_free_limit,50000000},

{disk_free,13270233088},

{file_descriptors,

[{total_limit,924},{total_used,6},{sockets_limit,829},{sockets_used,0}]},

{processes,[{limit,1048576},{used,262}]},

{run_queue,0},

{uptime,43651},

{kernel,{net_ticktime,60}}]

停止rabbitmq服务

[root@super sbin]# service rabbitmq-server stop

Stopping rabbitmq-server: rabbitmq-server.

启动第一个节点:

[root@super sbin]# RABBITMQ_NODE_PORT=5673 RABBITMQ_NODENAME=rabbit1 rabbitmq-server start

RabbitMQ 3.6.5. Copyright (C) 2007-2016 Pivotal Software, Inc.

## ## Licensed under the MPL. See http://www.rabbitmq.com/

## ##

########## Logs: /var/log/rabbitmq/rabbit1.log

###### ## /var/log/rabbitmq/rabbit1-sasl.log

##########

Starting broker...

completed with 6 plugins.

启动第二个节点:

web管理插件端口占用,所以还要指定其web插件占用的端口号。

[root@super ~]# RABBITMQ_NODE_PORT=5674 RABBITMQ_SERVER_START_ARGS="-rabbitmq_management listener [{port,15674}]" RABBITMQ_NODENAME=rabbit2 rabbitmq-server start

RabbitMQ 3.6.5. Copyright (C) 2007-2016 Pivotal Software, Inc.

## ## Licensed under the MPL. See http://www.rabbitmq.com/

## ##

########## Logs: /var/log/rabbitmq/rabbit2.log

###### ## /var/log/rabbitmq/rabbit2-sasl.log

##########

Starting broker...

completed with 6 plugins.

结束命令:

rabbitmqctl -n rabbit1 stop

rabbitmqctl -n rabbit2 stop

rabbit1操作作为主节点:

[root@super ~]# rabbitmqctl -n rabbit1 stop_app

Stopping node rabbit1@super ...

[root@super ~]# rabbitmqctl -n rabbit1 reset

Resetting node rabbit1@super ...

[root@super ~]# rabbitmqctl -n rabbit1 start_app

Starting node rabbit1@super ...

[root@super ~]#

rabbit2操作为从节点:

[root@super ~]# rabbitmqctl -n rabbit2 stop_app

Stopping node rabbit2@super ...

[root@super ~]# rabbitmqctl -n rabbit2 reset

Resetting node rabbit2@super ...

[root@super ~]# rabbitmqctl -n rabbit2 join_cluster rabbit1@'super' ###''内是主机名换成自己的

Clustering node rabbit2@super with rabbit1@super ...

[root@super ~]# rabbitmqctl -n rabbit2 start_app

Starting node rabbit2@super ...

查看集群状态:

[root@super ~]# rabbitmqctl cluster_status -n rabbit1

Cluster status of node rabbit1@super ...

[{nodes,[{disc,[rabbit1@super,rabbit2@super]}]},

{running_nodes,[rabbit2@super,rabbit1@super]},

{cluster_name,<<"rabbit1@super">>},

{partitions,[]},

{alarms,[{rabbit2@super,[]},{rabbit1@super,[]}]}]

web监控:

6.3 集群管理

rabbitmqctl join_cluster {cluster_node} [–ram]

将节点加入指定集群中。在这个命令执行前需要停止RabbitMQ应用并重置节点。

rabbitmqctl cluster_status

显示集群的状态。

rabbitmqctl change_cluster_node_type {disc|ram}

修改集群节点的类型。在这个命令执行前需要停止RabbitMQ应用。

rabbitmqctl forget_cluster_node [–offline]

将节点从集群中删除,允许离线执行。

rabbitmqctl update_cluster_nodes {clusternode}

在集群中的节点应用启动前咨询clusternode节点的最新信息,并更新相应的集群信息。这个和join_cluster不同,它不加入集群。考虑这样一种情况,节点A和节点B都在集群中,当节点A离线了,节点C又和节点B组成了一个集群,然后节点B又离开了集群,当A醒来的时候,它会尝试联系节点B,但是这样会失败,因为节点B已经不在集群中了。

rabbitmqctl cancel_sync_queue [-p vhost] {queue}

取消队列queue同步镜像的操作。

rabbitmqctl set_cluster_name {name}

设置集群名称。集群名称在客户端连接时会通报给客户端。Federation和Shovel插件也会有用到集群名称的地方。集群名称默认是集群中第一个节点的名称,通过这个命令可以重新设置。

6.4 RabbitMQ镜像集群配置

上面已经完成RabbitMQ默认集群模式,但并不保证队列的高可用性,尽管交换机、绑定这些可以复制到集群里的任何一个节点,但是队列内容不会复制。虽然该模式解决一项目组节点压力,但队列节点宕机直接导致该队列无法应用,只能等待重启,所以要想在队列节点宕机或故障也能正常应用,就要复制队列内容到集群里的每个节点,必须要创建镜像队列。

镜像队列是基于普通的集群模式的,然后再添加一些策略,所以你还是得先配置普通集群,然后才能设置镜像队列,我们就以上面的集群接着做。

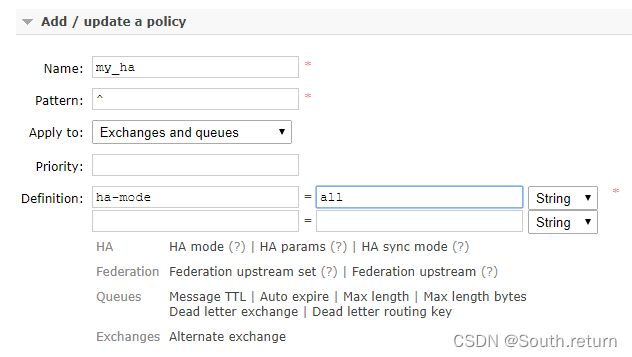

设置的镜像队列可以通过开启的网页的管理端Admin->Policies,也可以通过命令。

rabbitmqctl set_policy my_ha “^” ‘{“ha-mode”:“all”}’

- Name:策略名称

- Pattern:匹配的规则,如果是匹配所有的队列,是^.

- Definition:使用ha-mode模式中的all,也就是同步所有匹配的队列。问号链接帮助文档。

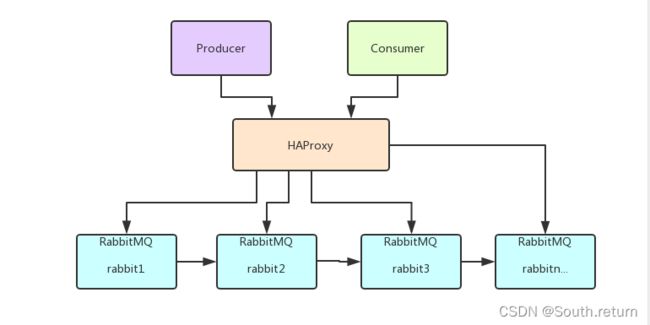

6.5 负载均衡-HAProxy

HAProxy提供高可用性、负载均衡以及基于TCP和HTTP应用的代理,支持虚拟主机,它是免费、快速并且可靠的一种解决方案,包括Twitter,Reddit,StackOverflow,GitHub在内的多家知名互联网公司在使用。HAProxy实现了一种事件驱动、单一进程模型,此模型支持非常大的并发连接数。

6.5.1 安装HAProxy

//下载依赖包

yum install gcc vim wget

//上传haproxy源码包

//解压

tar -zxvf haproxy-1.6.5.tar.gz -C /usr/local

//进入目录、进行编译、安装

cd /usr/local/haproxy-1.6.5

make TARGET=linux31 PREFIX=/usr/local/haproxy

make install PREFIX=/usr/local/haproxy

mkdir /etc/haproxy

//赋权

groupadd -r -g 149 haproxy

useradd -g haproxy -r -s /sbin/nologin -u 149 haproxy

//创建haproxy配置文件

mkdir /etc/haproxy

vim /etc/haproxy/haproxy.cfg

6.5.2 配置HAProxy

配置文件路径:/etc/haproxy/haproxy.cfg

#logging options

global

log 127.0.0.1 local0 info

maxconn 5120

chroot /usr/local/haproxy

uid 99

gid 99

daemon

quiet

nbproc 20

pidfile /var/run/haproxy.pid

defaults

log global

mode tcp

option tcplog

option dontlognull

retries 3

option redispatch

maxconn 2000

contimeout 5s

clitimeout 60s

srvtimeout 15s

#front-end IP for consumers and producters

listen rabbitmq_cluster

bind 0.0.0.0:5672

mode tcp

#balance url_param userid

#balance url_param session_id check_post 64

#balance hdr(User-Agent)

#balance hdr(host)

#balance hdr(Host) use_domain_only

#balance rdp-cookie

#balance leastconn

#balance source //ip

balance roundrobin

server node1 127.0.0.1:5673 check inter 5000 rise 2 fall 2

server node2 127.0.0.1:5674 check inter 5000 rise 2 fall 2

listen stats

bind 172.16.98.133:8100

mode http

option httplog

stats enable

stats uri /rabbitmq-stats

stats refresh 5s

启动HAproxy负载

/usr/local/haproxy/sbin/haproxy -f /etc/haproxy/haproxy.cfg

//查看haproxy进程状态

ps -ef | grep haproxy

访问如下地址对mq节点进行监控

http://172.16.98.133:8100/rabbitmq-stats

代码中访问mq集群地址,则变为访问haproxy地址:5672