ES系列--es初探

一、前言

一般传统数据库,全文检索都实现的很鸡肋,因为一般也没人用数据库存文本字段。进 行全文检索需要扫描整个表,如果数据量大的话即使对 SQL 的语法优化,也收效甚微。建 立了索引,但是维护起来也很麻烦,对于 insert 和 update 操作都会重新构建索引。

而这就是Elasticsearch存在的理由。

The Elastic Stack, 包括 Elasticsearch、Kibana、Beats 和 Logstash(也称为 ELK Stack)。 能够安全可靠地获取任何来源、任何格式的数据,然后实时地对数据进行搜索、分析和可视 化。Elaticsearch,简称为 ES,ES 是一个开源的高扩展的分布式全文搜索引擎,是整个 Elastic Stack 技术栈的核心。它可以近乎实时的存储、检索数据;本身扩展性很好,可以扩展到上 百台服务器,处理 PB 级别的数据。

二、ES

一、es数据格式

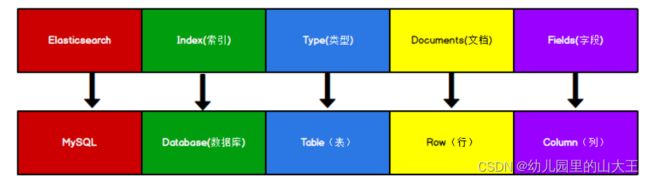

Elasticsearch 是面向文档型数据库,一条数据在这里就是一个文档。

ES 里的 Index 可以看做一个库,而 Types 相当于表,Documents 则相当于表的行。 这里 Types 的概念已经被逐渐弱化,Elasticsearch 6.X 中,一个 index 下已经只能包含一个 type,Elasticsearch 7.X 中, Type 的概念已经被删除了

二、核心概念

一、索引 (Index)

索引相当于mysql的数据库。比如说,你可以有一个客户数据的 索引,另一个产品目录的索引,还有一个订单数据的索引。一个索引由一个名字来标识(必 须全部是小写字母)。

能搜索的数据必须索引,这样的好处是可以提高查询速度,比如:新华字典前面的目录 就是索引的意思,目录可以提高查询速度。

Elasticsearch 索引的精髓:一切设计都是为了提高搜索的性能。

索引(index)这个词在Elasticsearch中有着不同的含义:

1、索引(名词) 如上文所述,一个索引(index)就像是传统关系数据库中的数据库,它是相关文档存储的地方。

2、索引(动词) 「索引一个文档」表示把一个文档存储到索引(名词)里,以便它可 以被检索或者查询。这很像SQL中的 INSERT 关键字,差别是,如果文档已经存在, 新的文档将覆盖旧的文档。

二、类型(Type)

在一个索引中,你可以定义一种或多种类型。 一个类型是你的索引的一个逻辑上的分类/分区,其语义完全由你来定。通常,会为具 有一组共同字段的文档定义一个类型。不同的版本,类型发生了不同的变化。其实就相当于mysql的一个数据库里有多张表。

三、文档 (Document)

一个文档是一个可被索引的基础信息单元,也就是一条数据。文档以 JSON(Javascript Object Notation)格式来表示,而 JSON 是一个 到处存在的互联网数据交互格式。 在一个 index/type 里面,你可以存储任意多的文档。

四、字段(Field)

相当于是数据表的字段,对文档数据根据不同属性进行的分类标识。

五、映射 (Mapping)

mapping 是处理数据的方式和规则方面做一些限制,如:某个字段的数据类型、默认值、 分析器、是否被索引等等。这些都是映射里面可以设置的,其它就是处理 ES 里面数据的一 些使用规则设置也叫做映射,按着最优规则处理数据对性能提高很大,因此才需要建立映射, 并且需要思考如何建立映射才能对性能更好。

类似于数据库(database)中的表结构(table)。 创建数据库表需要设置字段名称,类型,长度,约束等;索引库也一样,需要知道这个类型 下有哪些字段,每个字段有哪些约束信息,这就叫做映射(mapping)。

六、分片

分片是 Elasticsearch 最小的工作单元。

一个索引可以存储超出单个节点硬件限制的大量数据。。比如,一个具有 10 亿文档数据 的索引占据 1TB 的磁盘空间,而任一节点都可能没有这样大的磁盘空间。或者单个节点处 理搜索请求,响应太慢。为了解决这个问题,Elasticsearch 提供了将索引划分成多份的能力, 每一份就称之为分片。当你创建一个索引的时候,你可以指定你想要的分片的数量。每个分 片本身也是一个功能完善并且独立的“索引”,这个“索引”可以被放置到集群中的任何节点上。

分片很重要,主要有两方面的原因:

1)允许你水平分割 / 扩展你的内容容量。

2)允许你在分片之上进行分布式的、并行的操作,进而提高性能/吞吐量。

被混淆的概念是:

一个 Lucene 索引 我们在 Elasticsearch 称作 分片 。

一个 Elasticsearch 索引 是分片的集合。 当 Elasticsearch 在索引中搜索的时候, 他发送查询 到每一个属于索引的分片(Lucene 索引),然后合并每个分片的结果到一个全局的结果集。

分片原理:

传统的数据库每个字段存储单个值,但这对全文检索并不够。文本字段中的每个单词需 要被搜索,对数据库意味着需要单个字段有索引多值的能力。最好的支持是一个字段多个值需求的数据结构,这就是倒排索引。

七、副本

在一个网络 / 云的环境里,失败随时都可能发生,在某个分片/节点不知怎么的就处于离线状态,或者由于任何原因消失了,这种情况下,有一个故障转移机制是非常有用并且是强烈推荐的。为此目的,Elasticsearch 允许你创建分片的一份或多份拷贝,这些拷贝叫做复制分片(副本)。

复制分片之所以重要,有两个主要原因:

1、在分片/节点失败的情况下,提供了高可用性。因为这个原因,注意到复制分片从不与 原/主要(original/primary)分片置于同一节点上是非常重要的。

2、扩展你的搜索量/吞吐量,因为搜索可以在所有的副本上并行运行。

每个索引可以被分成多个分片。一个索引也可以被复制 0 次(意思是没有复制) 或多次。一旦复制了,每个索引就有了主分片(作为复制源的原来的分片)和复制分片(主分片的拷贝,就是副本)之别。分片和复制的数量可以在索引创建的时候指定。在索引创建之后,你可 以在任何时候动态地改变复制的数量,但是你事后不能改变分片的数量。默认情况下, Elasticsearch 中的每个索引被分片 1 个主分片和 1 个复制,这意味着,如果你的集群中至少 有两个节点,你的索引将会有 1 个主分片和另外 1 个复制分片(1 个完全拷贝),这样的话 每个索引总共就有 2 个分片,我们需要根据索引需要确定分片个数。

八、分配

将分片分配给某个节点的过程,包括分配主分片或者副本。如果是副本,还包含从主分 片复制数据的过程。这个过程是由 master 节点完成的。

九、节点

集群中包含很多服务器,一个节点就是其中的一个服务器。作为集群的一部分,它存储 数据,参与集群的索引和搜索功能。

一个节点也是由一个名字来标识的,默认情况下,这个名字是一个随机的漫威漫画角色 的名字,这个名字会在启动的时候赋予节点。这个名字对于管理工作来说挺重要的,因为在 这个管理过程中,你会去确定网络中的哪些服务器对应于 Elasticsearch 集群中的哪些节点。 一个节点可以通过配置集群名称的方式来加入一个指定的集群。默认情况下,每个节点 都会被安排加入到一个叫做“elasticsearch”的集群中,这意味着,如果你在你的网络中启动了 若干个节点,并假定它们能够相互发现彼此,它们将会自动地形成并加入到一个叫做 “elasticsearch”的集群中。

在一个集群里,只要你想,可以拥有任意多个节点。而且,如果当前你的网络中没有运 行任何 Elasticsearch 节点,这时启动一个节点,会默认创建并加入一个叫做“elasticsearch”的 集群。

十、倒排索引

Elasticsearch 使用一种称为倒排索引的结构,它适用于快速的全文搜索。

见其名,知其意,有倒排索引,肯定会对应有正向索引。正向索引(forward index), 反向索引(inverted index)更熟悉的名字是倒排索引。

1、正向索引

所谓的正向索引,就是搜索引擎会将待搜索的文件都对应一个文件 ID,搜索时将这个 ID 和搜索关键字进行对应,形成 K-V 对,然后对关键字进行统计计数。

比如:1001(id)My name is Tom(content) ----doc1

一般我们搜索这条信息的时候,我们有两种方法,

1、通过id搜索

2、模糊查询匹配content字段,但是这种效率太低 。

这个时候就需要倒排索引了

2、倒排索引

搜索引擎会将正向索引重新构建为倒排索引,即把文件 ID对应到关键词的映射转换为关键词到文件ID的映射,每个关键词都对应着一系列的文件, 这些文件中都出现这个关键词。

比如:1001(id) My name is Tom(content)----doc1

会变成

name(这个可以称为词条) doc1

Tom (这个可以称为词条) doc1

当你输入name或者tom时,就会通过倒排索引匹配到doc1这条数据。

倒排索引中的三个名词:

1、词条:索引中最小的存储和查询单元

2、词典:字典,词条的集合,底层一般会用两种数据结构实现:B+树,HashMap

3、倒排表:词条的位置,以及出现频率,每条记录被称为一个倒排项。

以上数据的结构在此不做详细记录。

倒排索引的搜索过程:

1、首先查看搜索的单词是否在词典中。如果不在直接结束

2、单词在词典中,这个时候就需要到倒排列表中查看单词的指针

3、然后通过倒排列表获取这个单词对应的文档id

4、最后拿这个文档id去获取对应的数据。

十一、文档分析

1、将一块文本分成适合于倒排索引的独立的 词条

2、将这些词条统一化为标准格式以提高它们的“可搜索性”,或者 recall 分析器执行上面的工作。分析器实际上是将三个功能封装到了一个包里:

a、字符过滤器:

首先,字符串按顺序通过每个字符过滤器 。他们的任务是在分词前整理字符串。一个 字符过滤器可以用来去掉 HTML,或者将 & 转化成 and。

b、分词器:

其次,字符串被 分词器 分为单个的词条。一个简单的分词器遇到空格和标点的时候, 可能会将文本拆分成词条。

c、Token 过滤器:

最后,词条按顺序通过每个 token 过滤器 。这个过程可能会改变词条(例如,小写化 Quick ),删除词条(例如, 像 a, and, the 等无用词),或者增加词条(例如,像 jump 和 leap 这种同义词)。