提示工程的前世今生

原文链接:芝士AI吃鱼

通过提示进行情境学习

在生物学中,涌现是一种令人难以置信的特性,由于相互作用的结果,各个部分聚集在一起,表现出新的行为(称为涌现),这是你在较小的尺度上看不到的。更令人难以置信的是,即使较小比例的版本看起来与较大比例相似,但事实上较大比例由更多部分和交互组成,它最终表现出一组完全不同的行为。

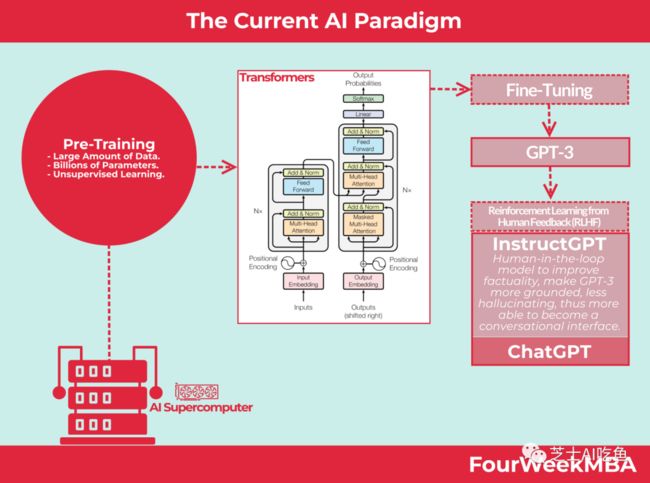

这一切都始于以无人监督的方式训练这些人工智能模型的能力。事实上,无监督学习一直是这场人工智能革命的关键原则之一,它阻碍了过去几年人工智能的进步。

2017 年之前,大多数人工智能都是通过小型结构化数据集利用监督学习来工作,这可以在非常狭窄的任务上训练机器学习模型。2017 年之后,随着一种名为 Transformer 的新架构的出现,情况开始发生变化。

这种新架构可以与无监督学习方法一起使用。机器学习模型可以在非常大的非结构化数据集上进行预训练,目标函数非常简单:文本到文本预测。

令人兴奋的方面是,机器学习模型为了学习如何正确执行文本到文本的预测(这可能看起来非常简单的任务),开始学习围绕数据的一系列模式和启发式方法它接受过训练。

这使得机器学习模型能够学习各种各样的任务。

大型语言模型不再尝试执行单个任务,而是开始从数据中推断模式,并在执行新任务时重新使用这些模式。

这是一场核心革命。另外,随着GPT-3论文的出现,另一个转折点是能够提示这些模型。

简而言之,它使这些模型能够通过自然语言指令进一步学习用户的上下文,这可能会极大地改变模型的输出。

这另一个方面也是新兴的,因为没有人明确要求这一点。因此,这就是我们通过提示作为当前机器学习模型的核心、新兴属性来获得上下文学习的方式。

了解提示工程

提示工程是当前人工智能范式的一个关键的、新兴的属性。

Prompt Engineering 最有趣的方面之一是它作为扩展 Transformer 架构以训练大型语言模型的新兴属性而出现。

就像你表达的愿望可能会反对你一样,当你提示机器时,你表达它需要做什么的方式可以极大地改变输出。

最有趣的部分是什么?提示并不是人工智能专家开发的功能。这是一个新兴的特征。简而言之,通过开发这些巨大的机器学习模型,提示成为让机器执行输入的方式。没有人要求这样做;就这样发生了!

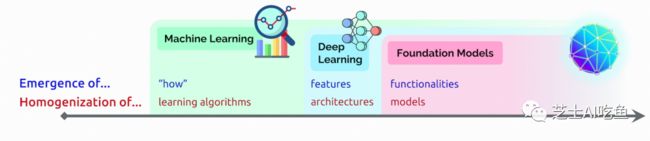

在 2021 年的一篇论文中,斯坦福大学的研究人员强调了基于 Transformer 的模型如何成为基础模型。

正如同一篇论文中所解释的:

人工智能的故事一直是一个不断涌现和同质化的故事。随着机器学习的引入,任务的执行方式从示例中浮现(自动推断);通过深度学习,用于预测的高级特征出现;通过基础模型,甚至可以出现情境学习等高级功能。同时,机器学习使学习算法同质化(例如逻辑回归),深度学习使模型架构同质化(例如卷积神经网络),基础模型使模型本身同质化(例如GPT-3)。

提示工程是人工智能中使用的一个过程,其中一个或多个任务被转换为基于提示的数据集,然后训练语言模型进行学习。

从表面上看,提示工程背后的动机可能很难理解,所以让我们用一个例子来描述这个想法。

想象一下,您正在建立一个在线食品配送平台,并且您拥有数千张不同蔬菜的图像可以包含在该网站上。唯一的问题是,没有任何图像元数据描述哪些蔬菜在哪些照片中。此时,你可以对图像进行繁琐的排序,并将土豆照片放入土豆文件夹中,将西兰花照片放入西兰花文件夹中,依此类推。

你还可以通过分类器运行所有图像,以更轻松地对它们进行排序,但是,正如您发现的那样,训练分类器模型仍然需要标记数据。 使用提示工程,你可以编写你认为会产生最佳图像分类结果的基于文本的提示。

例如,可以告诉模型显示“包含土豆的图像”。该提示的结构——或者定义模型如何识别图像的语句——是提示工程的基础。 写出最好的提示通常需要反复试验。事实上,提示“包含土豆的图像”与“土豆的照片”或“土豆的集合”有很大不同。

提示工程最佳实践

与大多数流程一样,输入的质量决定输出的质量。设计有效的提示可以增加模型返回有利且符合上下文的响应的可能性。编写好的提示就是理解模型“了解”世界的内容,然后相应地应用这些信息。有些人认为这类似于猜谜游戏,演员为他们的搭档提供足够的信息,以利用他们的智力找出单词或短语。

将该模型视为代表猜谜游戏中的伙伴,通过训练提示为模型提供了足够的信息来计算出模式并完成手头的任务。一次性让模型超载所有信息并中断其自然智能流是没有意义的。

快速工程和 CLIP 模型

CLIP(对比语言-图像预训练)模型由人工智能研究实验室OpenAI于2021年开发。

研究人员表示,CLIP 是“一种在各种(图像、文本)对上进行训练的神经网络。可以用自然语言指示它在给定图像的情况下预测最相关的文本片段,而无需直接优化任务,类似于 GPT-2 和 3 的零样本功能。 ”

基于神经网络 模型,CLIP 接受了超过 4 亿个图像文本对的训练,其中包含与标题匹配的图像。使用这些信息,人们可以将图像输入到模型中,模型将生成它认为最准确的标题或摘要。上面的引述还涉及到 CLIP 的零样本功能,这使得它在机器学习模型中有些特殊。

例如,大多数经过训练来识别苹果和橙子的分类器预计在对苹果和橙子进行分类时表现良好,但通常不会检测香蕉。某些型号(包括 CLIP、GPT-2 和 GPT-3)可以识别香蕉。换句话说,他们可以执行未经过明确培训的任务。这种能力被称为零样本学习。

提示工程示例

截至 2022 年,AI 模型的演变正在加速。这使得提示工程变得越来越重要。我们首先使用 GPT-3、BERT 等语言模型进行文本到文本的处理。然后我们使用 Dall-E、Imagen、MidJourney 和 StableDiffusion 进行文本到图像转换。在这个阶段,我们正在通过 Meta 的 Make-A-Video 转向文本到视频,现在 Google 正在开发自己的 Imagen Video。如今有效的人工智能模型专注于用更少的钱获得更多的东西!一个例子是 DreamFusion:使用 2D Diffusion 的文本转 3D,由 Google 研究实验室构建。

简而言之,人工智能扩散模型是生成模型,这意味着它们产生的输出与其经过训练的输出相似。根据定义,扩散模型的工作原理是向训练数据添加噪声,并通过噪声过程的逆转恢复该数据来生成输出。Google Research 的 DreamFusion 能够将文本转换为 3D 图像,而无需拥有大规模的标记 3D 数据数据集(目前不可用)。

就是这样!正如研究小组所解释的:

“使这种方法适应 3D 合成需要大规模的标记 3D 数据数据集和用于去噪 3D 数据的高效架构,而这两者目前都不存在。在这项工作中,我们通过使用预训练的 2D 文本到图像扩散模型来执行文本到 3D 合成,从而规避了这些限制。”

为什么这很重要?在二十多年来主要基于文本或基于 2D 图像的网络中,现在是时候启用增强格式,例如可以在 AR 环境中良好运行的 3D。

简而言之,想象一下您戴着 Google 的 AR 眼镜,下面的这些 AI 模型可以通过 3D 对象动态增强现实世界,从而使您能够使 AR 体验更加引人注目。

与此同时,OpenAI 宣布推出 Whisper 语音转文本功能。结合起来,这些人工智能模型将创建一个多模式环境,一个人或小团队可以利用所有这些工具进行内容生成、电影制作、医学等!这意味着随着进入壁垒的消除,一些以前无法进入的行业变得更容易扩展。可以更快地测试/启动/迭代,从而使市场更快地发展。

互联网发展了近 30 年,但许多行业(从医疗保健到教育)仍然局限于旧模式。十年的人工智能可能会彻底重新洗牌。每个人工智能模型都会以相同的方式进行提示,但提示机器的方式可能非常微妙,由于提示的变化,机器可以产生许多不同的输出。

就在 2022 年 10 月:

-

Stability AI 宣布为开源人工智能提供 1.01 亿美元资金。

-

Jasper AI 是一家开发“人工智能内容”平台的初创公司,已融资 1.25 亿美元,估值为 15 亿美元。Jasper 正在收购人工智能初创公司 Outwrite,这是一家拥有超过 100 万用户的语法和风格检查器。

-

OpenAI 估值近 200 亿美元,正在与微软就更多资金进行高级谈判。

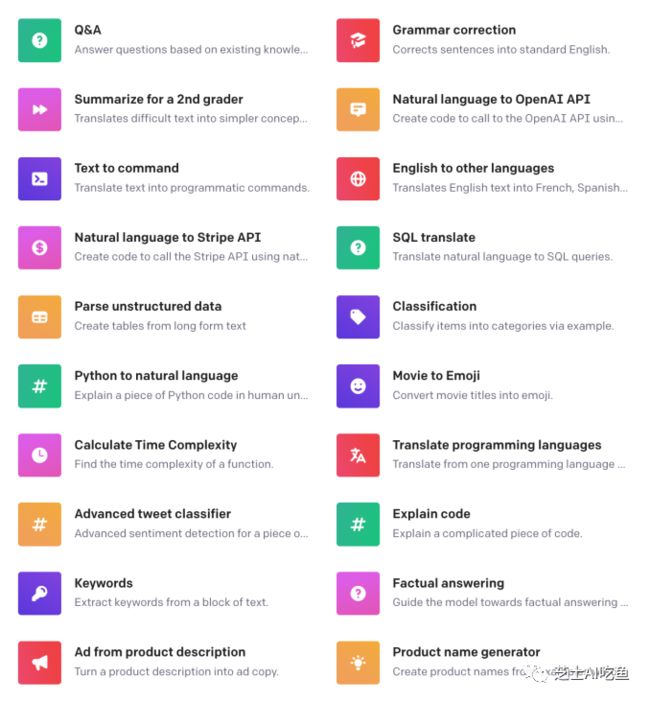

如今,通过提示,您可以生成越来越多的输出。

OpenAI 的一些用例可以通过提示生成。从问答到分类器和代码生成器。人工智能通过提示实现的用例数量呈指数级增长。

另一个很酷的应用程序?您可以根据提示设计自己的鞋子:

提示 DreamStudio AI 生成一双定制运动鞋。

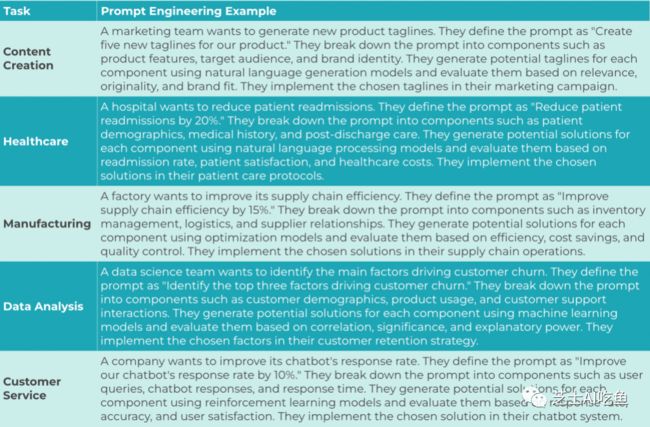

及时的工程实例和案例研究

这是一个快速的工程示例,其中包含该过程中的一些最佳实践。

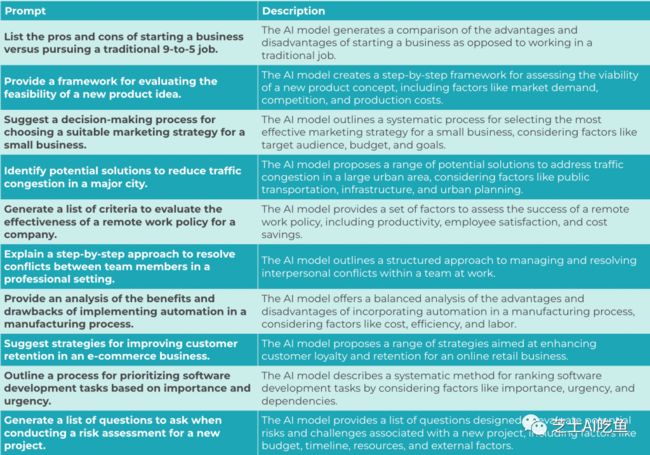

ChatGPT 提示示例

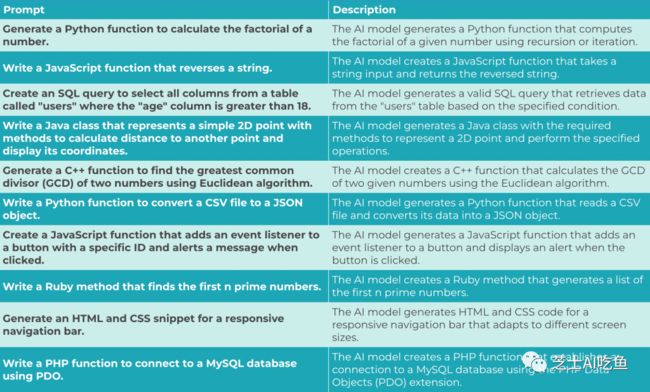

代码生成

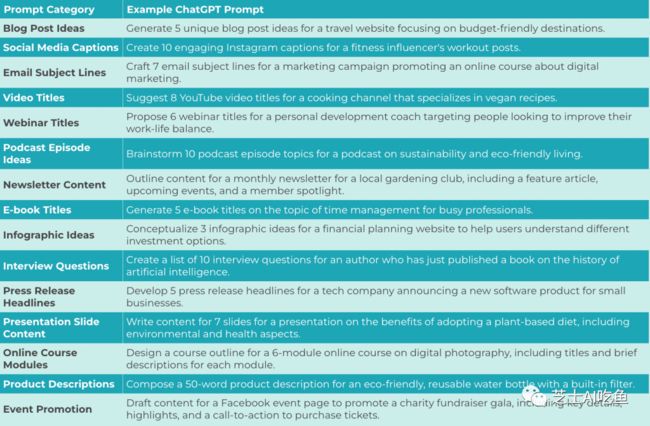

内容创作

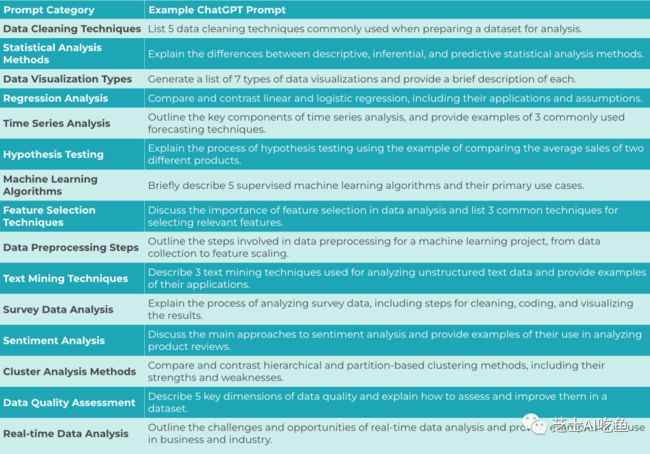

数据分析

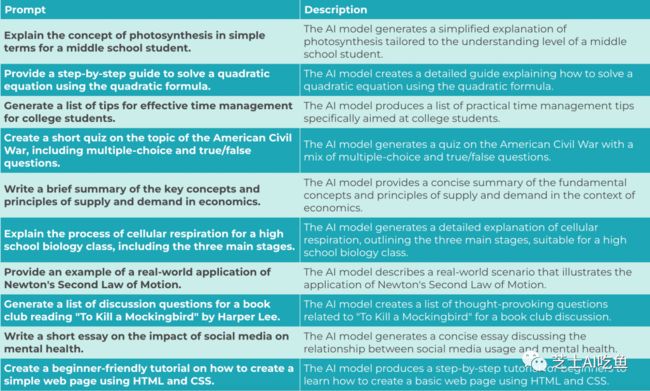

教育和培训

决策和解决问题

要点:

-

提示工程是一种自然语言处理 (NLP) 概念,涉及发现可产生所需或有用结果的输入。

-

与大多数流程一样,提示工程中输入的质量决定了输出的质量。设计有效的提示可以增加模型返回有利且符合上下文的响应的可能性。

-

CLIP(对比语言-图像预训练)模型由 OpenAI 开发,是利用提示对超过 4 亿个图像-标题对中的图像和标题进行分类的模型示例。