Brian2学习笔记_Introduction to Brian part3:Simulations

本文根据Brian2官方英文教程进行翻译总结。

Brian2官方安装教程链接:

https://brian2.readthedocs.io/en/stable/introduction/install.html

使用教程Tutorial:

Introduction to Brian part 1 : Neurons 原文

Introduction to Brian part 2 : Synapses 原文

Introduction to Brian part 3 : Simulation 原文

运行的三种环境:Brian提供的基于网页的交互式模拟仿真器“Binder”;本地的Jupyter Notebook;Ipython或标准Python终端。

与之前一样,本文所有代码均在Jupyter上运行。从导入Brian包开始:

from brian2 import *

%matplotlib inline

prefs.codegen.target = "numpy"

文章目录

- Introduction to Brian part3:Simulations

-

- 3.1 多次运行

- 在运行期间改变一些内容

- 3.3 添加输入

Introduction to Brian part3:Simulations

如果你还没有读过关于第1部分神经元和第2部分突触的内容,请先读一读。

本教程是关于管理在研究问题中出现的稍微复杂的任务,而不是我们目前看到的简单样例。所以这部分包含了输入传感器数据,模拟实验环境等内容。

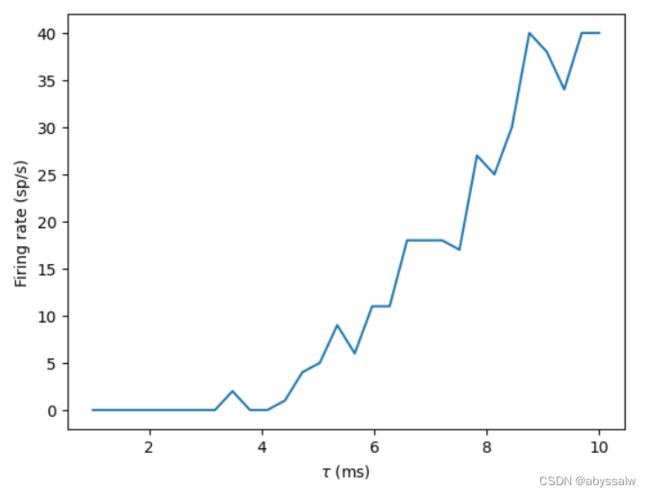

3.1 多次运行

从一个非常常见的任务开始:使用一些变化的参数多次运行模拟。

让我们从一个简单问题开始,一个由泊松脉冲神经元驱动的IF神经元的发射速率如何随其膜时间常数的变化而变化?

# remember, this is here for running separate simulations in the same notebook

start_scope()

# Parameters

num_inputs = 100

input_rate = 10*Hz

weight = 0.1

# Range of time constants

tau_range = linspace(1, 10, 30)*ms

# Use this list to store output rates

output_rates = []

# Iterate over range of time constants

for tau in tau_range:

# Construct the network each time

P = PoissonGroup(num_inputs, rates=input_rate)

eqs = '''

dv/dt = -v/tau : 1

'''

G = NeuronGroup(1, eqs, threshold='v>1', reset='v=0', method='exact')

S = Synapses(P, G, on_pre='v += weight')

S.connect()

M = SpikeMonitor(G)

# Run it and store the output firing rate in the list

run(1*second)

output_rates.append(M.num_spikes/second)

# And plot it

plot(tau_range/ms, output_rates)

xlabel(r'$\tau$ (ms)')

ylabel('Firing rate (sp/s)')

如果你运行了上述代码,你会发现它运行起来有点慢。这是因为对于每个循环,都要从头开始重新创建对象。我们可以通过建立一次网络来改善这一点。我们在循环之前存储网络状态的副本,并在每次迭代开始时恢复它。

start_scope()

num_inputs = 100

input_rate = 10*Hz

weight = 0.1

tau_range = linspace(1, 10, 30)*ms

output_rates = []

# Construct the network just once

P = PoissonGroup(num_inputs, rates=input_rate)

eqs = '''

dv/dt = -v/tau : 1

'''

G = NeuronGroup(1, eqs, threshold='v>1', reset='v=0', method='exact')

S = Synapses(P, G, on_pre='v += weight')

S.connect()

M = SpikeMonitor(G)

# Store the current state of the network

store()

for tau in tau_range:

# Restore the original state of the network

restore()

# Run it with the new value of tau

run(1*second)

output_rates.append(M.num_spikes/second)

plot(tau_range/ms, output_rates)

xlabel(r'$\tau$ (ms)')

ylabel('Firing rate (sp/s)')

这是使用存储store和恢复restore的一个非常简单的例子,也可以在更复杂的情况下使用它。例如,你可能想要进行一次长时间的训练,然后进行多次测试运行。只需在长时间的训练运行之后进行存储,并在每次测试运行之前进行恢复。

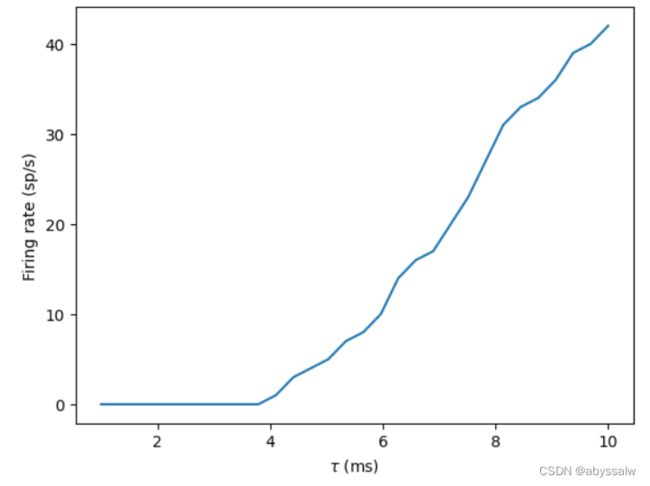

另外,可以看出输出曲线非常嘈杂,并且不像我们期望的那样单调地增加。噪音来自于我们每次都重新运行泊松神经元组。如果我们只想看到时间常数的影响,我们可以确保神经元每次的峰值都是相同的(尽管如此,实际上你应该进行多次运行并取平均值)。方便起见,我们只运行一次泊松神经元组,并记录其脉冲,然后创建一个新的 SpikeGeneratorGroup 来记录每次输出的脉冲。

start_scope()

num_inputs = 100

input_rate = 10*Hz

weight = 0.1

tau_range = linspace(1, 10, 30)*ms

output_rates = []

# Construct the Poisson spikes just once

P = PoissonGroup(num_inputs, rates=input_rate)

MP = SpikeMonitor(P)

# We use a Network object because later on we don't

# want to include these objects

net = Network(P, MP)

net.run(1*second)

# And keep a copy of those spikes

spikes_i = MP.i

spikes_t = MP.t

# Now construct the network that we run each time

# SpikeGeneratorGroup gets the spikes that we created before

SGG = SpikeGeneratorGroup(num_inputs, spikes_i, spikes_t)

eqs = '''

dv/dt = -v/tau : 1

'''

G = NeuronGroup(1, eqs, threshold='v>1', reset='v=0', method='exact')

S = Synapses(SGG, G, on_pre='v += weight')

S.connect()

M = SpikeMonitor(G)

# Store the current state of the network

net = Network(SGG, G, S, M)

net.store()

for tau in tau_range:

# Restore the original state of the network

net.restore()

# Run it with the new value of tau

net.run(1*second)

output_rates.append(M.num_spikes/second)

plot(tau_range/ms, output_rates)

xlabel(r'$\tau$ (ms)')

ylabel('Firing rate (sp/s)')

可以看到现在噪音少了很多而且它单调地增加,因为每次输入脉冲都是一样的,这意味着我们看到的是时间常数的影响,而不是随机的脉冲。

注意,在上面的代码中,我们创建了 Network 对象。因为在循环中,如果我们只调用 run,它会尝试模拟所有的对象,包括泊松神经元P。但我们只想运行一次,所以可以使用 Network 来明确指定我们想要包含的对象。

到目前为止,我们用到的技术是进行多次运行的概念上最简单的方法,但并不总是最有效的。由于在上面的模型中只有一个输出神经元,我们可以简单地复制输出神经元并将时间常数作为神经元组的参数。

start_scope()

num_inputs = 100

input_rate = 10*Hz

weight = 0.1

tau_range = linspace(1, 10, 30)*ms

num_tau = len(tau_range)

P = PoissonGroup(num_inputs, rates=input_rate)

# We make tau a parameter of the group

eqs = '''

dv/dt = -v/tau : 1

tau : second

'''

# And we have num_tau output neurons, each with a different tau

G = NeuronGroup(num_tau, eqs, threshold='v>1', reset='v=0', method='exact')

G.tau = tau_range

S = Synapses(P, G, on_pre='v += weight')

S.connect()

M = SpikeMonitor(G)

# Now we can just run once with no loop

run(1*second)

output_rates = M.count/second # firing rate is count/duration

plot(tau_range/ms, output_rates)

xlabel(r'$\tau$ (ms)')

ylabel('Firing rate (sp/s)')

可以看到,这次运行的速度快了很多。虽然在概念上有点复杂,而且并不是总能做到这一点,但如果可以实现的话,它会更高效。

让我们通过快速查看脉冲间隔的均值和标准差与时间常数的关系来结束这个示例。

trains = M.spike_trains()

isi_mu = full(num_tau, nan)*second

isi_std = full(num_tau, nan)*second

for idx in range(num_tau):

train = diff(trains[idx])

if len(train)>1:

isi_mu[idx] = mean(train)

isi_std[idx] = std(train)

errorbar(tau_range/ms, isi_mu/ms, yerr=isi_std/ms)

xlabel(r'$\tau$ (ms)')

ylabel('Interspike interval (ms)')

注意,我们使用了 SpikeMonitor 的 spike_trains() 方法。这是一个字典,键是神经元的索引,值是神经元的脉冲时间数组。它用于指示对应神经元的脉冲时间组成的数组中的值。

在运行期间改变一些内容

想象一个实验,向一个神经元注入电流,每10毫秒随机改变一次振幅。

使用的是Hodgkin-Huxley神经元模型。

start_scope()

# Parameters

area = 20000*umetre**2

Cm = 1*ufarad*cm**-2 * area

gl = 5e-5*siemens*cm**-2 * area

El = -65*mV

EK = -90*mV

ENa = 50*mV

g_na = 100*msiemens*cm**-2 * area

g_kd = 30*msiemens*cm**-2 * area

VT = -63*mV

# The model

eqs_HH = '''

dv/dt = (gl*(El-v) - g_na*(m*m*m)*h*(v-ENa) - g_kd*(n*n*n*n)*(v-EK) + I)/Cm : volt

dm/dt = 0.32*(mV**-1)*(13.*mV-v+VT)/

(exp((13.*mV-v+VT)/(4.*mV))-1.)/ms*(1-m)-0.28*(mV**-1)*(v-VT-40.*mV)/

(exp((v-VT-40.*mV)/(5.*mV))-1.)/ms*m : 1

dn/dt = 0.032*(mV**-1)*(15.*mV-v+VT)/

(exp((15.*mV-v+VT)/(5.*mV))-1.)/ms*(1.-n)-.5*exp((10.*mV-v+VT)/(40.*mV))/ms*n : 1

dh/dt = 0.128*exp((17.*mV-v+VT)/(18.*mV))/ms*(1.-h)-4./(1+exp((40.*mV-v+VT)/(5.*mV)))/ms*h : 1

I : amp

'''

group = NeuronGroup(1, eqs_HH,

threshold='v > -40*mV',

refractory='v > -40*mV',

method='exponential_euler')

group.v = El

statemon = StateMonitor(group, 'v', record=True)

spikemon = SpikeMonitor(group, variables='v')

figure(figsize=(9, 4))

for l in range(5):

group.I = rand()*50*nA

run(10*ms)

axvline(l*10, ls='--', c='k')

axhline(El/mV, ls='-', c='lightgray', lw=3)

plot(statemon.t/ms, statemon.v[0]/mV, '-b')

plot(spikemon.t/ms, spikemon.v/mV, 'ob')

xlabel('Time (ms)')

ylabel('v (mV)')

在上面的代码中,我们在多次运行中使用循环来实现这一点。这很好,但这不是最有效的方法,因为每次我们调用run时,都要做很多初始化工作,这会减慢运行速度。即使对于Brian这样高效的独立模式,它也没有太大的效果。以下是另一种办法:

start_scope()

group = NeuronGroup(1, eqs_HH,

threshold='v > -40*mV',

refractory='v > -40*mV',

method='exponential_euler')

group.v = El

statemon = StateMonitor(group, 'v', record=True)

spikemon = SpikeMonitor(group, variables='v')

# we replace the loop with a run_regularly

group.run_regularly('I = rand()*50*nA', dt=10*ms)

run(50*ms)

figure(figsize=(9, 4))

# we keep the loop just to draw the vertical lines

for l in range(5):

axvline(l*10, ls='--', c='k')

axhline(El/mV, ls='-', c='lightgray', lw=3)

plot(statemon.t/ms, statemon.v[0]/mV, '-b')

plot(spikemon.t/ms, spikemon.v/mV, 'ob')

xlabel('Time (ms)')

ylabel('v (mV)')

我们用run_regular替换了具有多个run调用的循环。这使得指定的代码块每 d t = 10 ∗ m s dt=10*ms dt=10∗ms 运行一次。run_regular允许你运行特定于单个NeuronGroup的代码,但有时可能更灵活的方法。为此,你可以使用network_operation,它允许您运行任意Python代码(但不适用于standalone模式)。

start_scope()

group = NeuronGroup(1, eqs_HH,

threshold='v > -40*mV',

refractory='v > -40*mV',

method='exponential_euler')

group.v = El

statemon = StateMonitor(group, 'v', record=True)

spikemon = SpikeMonitor(group, variables='v')

# we replace the loop with a network_operation

@network_operation(dt=10*ms)

def change_I():

group.I = rand()*50*nA

run(50*ms)

figure(figsize=(9, 4))

for l in range(5):

axvline(l*10, ls='--', c='k')

axhline(El/mV, ls='-', c='lightgray', lw=3)

plot(statemon.t/ms, statemon.v[0]/mV, '-b')

plot(spikemon.t/ms, spikemon.v/mV, 'ob')

xlabel('Time (ms)')

ylabel('v (mV)')

现在让我们把这个例子扩展到多个神经元上,每个神经元都有不同的电容,看看它是如何影响细胞的行为的。

start_scope()

N = 3

eqs_HH_2 = '''

dv/dt = (gl*(El-v) - g_na*(m*m*m)*h*(v-ENa) - g_kd*(n*n*n*n)*(v-EK) + I)/C : volt

dm/dt = 0.32*(mV**-1)*(13.*mV-v+VT)/

(exp((13.*mV-v+VT)/(4.*mV))-1.)/ms*(1-m)-0.28*(mV**-1)*(v-VT-40.*mV)/

(exp((v-VT-40.*mV)/(5.*mV))-1.)/ms*m : 1

dn/dt = 0.032*(mV**-1)*(15.*mV-v+VT)/

(exp((15.*mV-v+VT)/(5.*mV))-1.)/ms*(1.-n)-.5*exp((10.*mV-v+VT)/(40.*mV))/ms*n : 1

dh/dt = 0.128*exp((17.*mV-v+VT)/(18.*mV))/ms*(1.-h)-4./(1+exp((40.*mV-v+VT)/(5.*mV)))/ms*h : 1

I : amp

C : farad

'''

group = NeuronGroup(N, eqs_HH_2,

threshold='v > -40*mV',

refractory='v > -40*mV',

method='exponential_euler')

group.v = El

# initialise with some different capacitances

group.C = array([0.8, 1, 1.2])*ufarad*cm**-2*area

statemon = StateMonitor(group, variables=True, record=True)

# we go back to run_regularly

group.run_regularly('I = rand()*50*nA', dt=10*ms)

run(50*ms)

figure(figsize=(9, 4))

for l in range(5):

axvline(l*10, ls='--', c='k')

axhline(El/mV, ls='-', c='lightgray', lw=3)

plot(statemon.t/ms, statemon.v.T/mV, '-')

xlabel('Time (ms)')

ylabel('v (mV)')

注意,我们对所有神经元的输入电流是不同的。

原因在于,每个神经元运行run_reularly时,都是单独在运行,而 I I I 是一个参数,因此对于每个神经元是不同的。要想解决这个问题,只需要将 I I I 变成一个共享变量。

start_scope()

N = 3

eqs_HH_3 = '''

dv/dt = (gl*(El-v) - g_na*(m*m*m)*h*(v-ENa) - g_kd*(n*n*n*n)*(v-EK) + I)/C : volt

dm/dt = 0.32*(mV**-1)*(13.*mV-v+VT)/

(exp((13.*mV-v+VT)/(4.*mV))-1.)/ms*(1-m)-0.28*(mV**-1)*(v-VT-40.*mV)/

(exp((v-VT-40.*mV)/(5.*mV))-1.)/ms*m : 1

dn/dt = 0.032*(mV**-1)*(15.*mV-v+VT)/

(exp((15.*mV-v+VT)/(5.*mV))-1.)/ms*(1.-n)-.5*exp((10.*mV-v+VT)/(40.*mV))/ms*n : 1

dh/dt = 0.128*exp((17.*mV-v+VT)/(18.*mV))/ms*(1.-h)-4./(1+exp((40.*mV-v+VT)/(5.*mV)))/ms*h : 1

I : amp (shared) # everything is the same except we've added this shared

C : farad

'''

group = NeuronGroup(N, eqs_HH_3,

threshold='v > -40*mV',

refractory='v > -40*mV',

method='exponential_euler')

group.v = El

group.C = array([0.8, 1, 1.2])*ufarad*cm**-2*area

statemon = StateMonitor(group, 'v', record=True)

group.run_regularly('I = rand()*50*nA', dt=10*ms)

run(50*ms)

figure(figsize=(9, 4))

for l in range(5):

axvline(l*10, ls='--', c='k')

axhline(El/mV, ls='-', c='lightgray', lw=3)

plot(statemon.t/ms, statemon.v.T/mV, '-')

xlabel('Time (ms)')

ylabel('v (mV)')

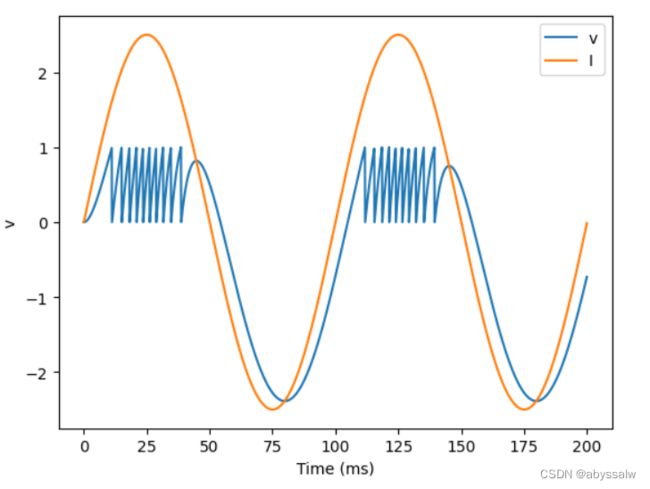

3.3 添加输入

现在我们来考虑一个由正弦输入驱动的神经元。神经元模型使用LIF模型来简化方程。

start_scope()

A = 2.5

f = 10*Hz

tau = 5*ms

eqs = '''

dv/dt = (I-v)/tau : 1

I = A*sin(2*pi*f*t) : 1

'''

G = NeuronGroup(1, eqs, threshold='v>1', reset='v=0', method='euler')

M = StateMonitor(G, variables=True, record=True)

run(200*ms)

plot(M.t/ms, M.v[0], label='v')

plot(M.t/ms, M.I[0], label='I')

xlabel('Time (ms)')

ylabel('v')

legend(loc='best')

到目前为止,一切顺利,就像我们在第一个教程中看到的那样。现在,如果输入电流是我们记录并保存在文件中的东西呢?在这种情况下,我们可以使用TimedArray。让我们从使用TimedArray复制上面的图片开始。

start_scope()

A = 2.5

f = 10*Hz

tau = 5*ms

# Create a TimedArray and set the equations to use it

t_recorded = arange(int(200*ms/defaultclock.dt))*defaultclock.dt

I_recorded = TimedArray(A*sin(2*pi*f*t_recorded), dt=defaultclock.dt)

eqs = '''

dv/dt = (I-v)/tau : 1

I = I_recorded(t) : 1

'''

G = NeuronGroup(1, eqs, threshold='v>1', reset='v=0', method='exact')

M = StateMonitor(G, variables=True, record=True)

run(200*ms)

plot(M.t/ms, M.v[0], label='v')

plot(M.t/ms, M.I[0], label='I')

xlabel('Time (ms)')

ylabel('v')

legend(loc='best')

注意,对于将sin函数直接放入方程的例子,我们必须使用 m e t h o d = ′ e u l e r ′ method='euler' method=′euler′ 参数,因为 e x a c t exact exact 积分器在这里不起作用。但是,TimedArray被认为在其时间步长上是恒定的,因此可以使用线性积分器。这意味着由于以下两个原因,您将无法从这两个方法获得相同的行为。首先,exact积分法和euler积分法的计算结果略有不同。其次,sin在时间步长上不是恒定的,而TimedArray是恒定的。现在,为了显示TimedArray适用于任意电流,让我们创建一个奇怪的“recorded”电流并运行它。

start_scope()

A = 2.5

f = 10*Hz

tau = 5*ms

# Let's create an array that couldn't be

# reproduced with a formula

num_samples = int(200*ms/defaultclock.dt)

I_arr = zeros(num_samples)

for _ in range(100):

a = randint(num_samples)

I_arr[a:a+100] = rand()

I_recorded = TimedArray(A*I_arr, dt=defaultclock.dt)

eqs = '''

dv/dt = (I-v)/tau : 1

I = I_recorded(t) : 1

'''

G = NeuronGroup(1, eqs, threshold='v>1', reset='v=0', method='exact')

M = StateMonitor(G, variables=True, record=True)

run(200*ms)

plot(M.t/ms, M.v[0], label='v')

plot(M.t/ms, M.I[0], label='I')

xlabel('Time (ms)')

ylabel('v')

legend(loc='best')

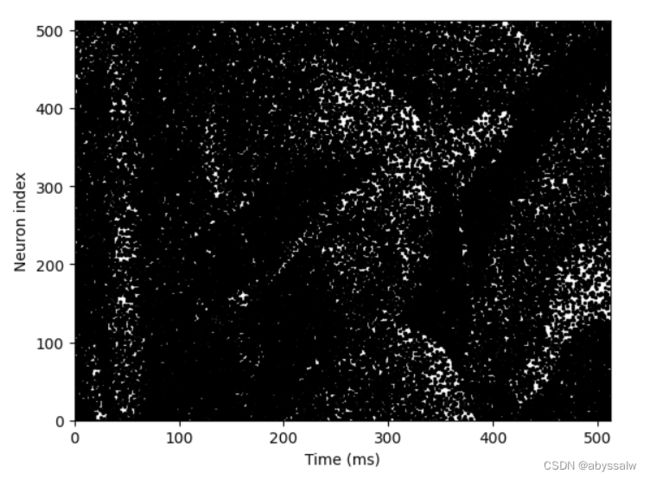

最后,让我们完成一个从文件中实际读取数据的示例。看看你能不能明白这个例子是如何工作的?

start_scope()

from matplotlib.image import imread

img = (1-imread('lena.png'))[::-1, :, 0].T

num_samples, N = img.shape

ta = TimedArray(img, dt=1*ms) # 228

A = 1.5

tau = 2*ms

eqs = '''

dv/dt = (A*ta(t, i)-v)/tau+0.8*xi*tau**-0.5 : 1

'''

G = NeuronGroup(N, eqs, threshold='v>1', reset='v=0', method='euler')

M = SpikeMonitor(G)

run(num_samples*ms)

plot(M.t/ms, M.i, '.k', ms=3)

xlim(0, num_samples)

ylim(0, N)

xlabel('Time (ms)')

ylabel('Neuron index')