使用Python搭建代理服务器- 爬虫代理服务器详细指南

搭建一个Python爬虫代理服务器可以让你更方便地管理和使用代理IP。下面是一个详细的教程来帮助你搭建一个简单的Python爬虫代理服务器:

1. 首先,确保你已经安装了Python。你可以在官方网站(https://www.python.org/)下载并安装最新版本的Python。

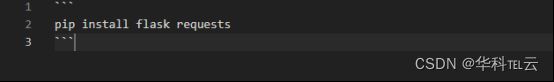

2. 安装所需的Python库。打开终端或命令行窗口,运行以下命令安装 `flask` 和 `requests` 库:

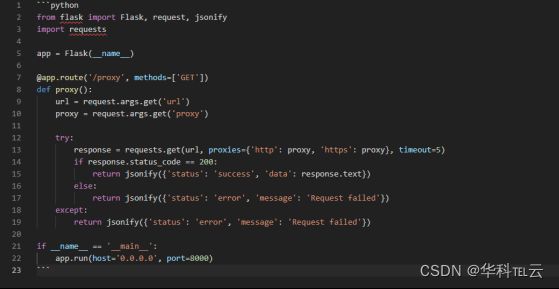

3. 创建一个名为 `proxy_server.py` 的新文件,并使用以下代码进行编写:

在上述代码中,我们使用 Flask 框架创建了一个简单的 Web 服务器。当收到 `/proxy` 路由的 GET 请求时,我们会获取 `url` 和 `proxy` 参数,并在请求中使用指定代理来访问指定的 URL。服务器会返回代理请求的响应内容。

4. 保存并关闭文件。

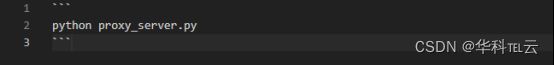

5. 打开终端或命令行窗口,切换到存放 `proxy_server.py` 文件的目录,并运行以下命令启动代理服务器:

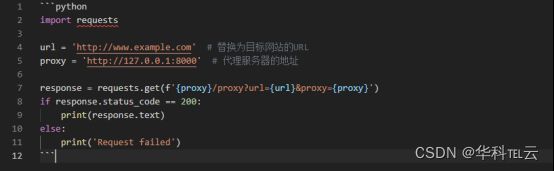

6. 代理服务器将会运行在 `http://0.0.0.0:8000` 地址。现在,你可以使用以下代码向代理服务器发送请求来获取网页内容:

将 `url` 替换为目标网站的URL,并将 `proxy` 替换为代理服务器的地址。

通过以上步骤,你就可以搭建一个简单的 Python 爬虫代理服务器,并使用代码进行测试。

下面是一个具体的例子,展示了一些常见的配置和改进选项:

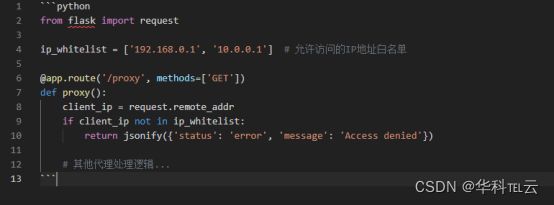

1. 添加IP限制:你可以添加一个IP白名单或黑名单,只允许特定的IP地址访问代理服务器,或者阻止特定的IP地址访问。这可以通过在代理路由的处理函数中添加一些逻辑来实现。

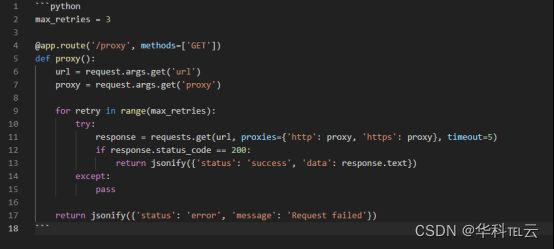

2. 添加重试机制:在代理请求失败时,你可以添加重试机制来执行多次请求,以增加成功的概率。

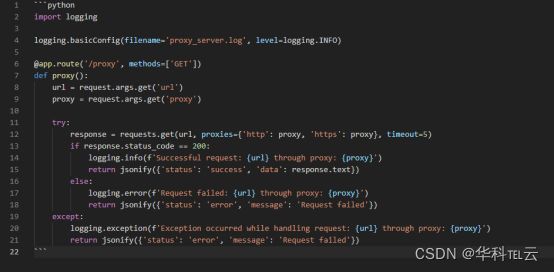

3. 日志记录:在代理服务器中添加日志记录功能,可以方便后续的排错和分析。

通过上述例子的配置和改进,你可以根据实际需求来扩展和定制你的Python爬虫代理服务器。以上示例,你可以根据具体情况进行更多的改进和优化。欢迎小伙伴们评论区指导交流。