V2V-PoseNet

V2V-PoseNet: Voxel-to-Voxel Prediction Network for Accurate 3D Hand and Human Pose Estimation from a Single Depth Map

2018--CVPR 作者:JY Chang,G Moon,KM Lee

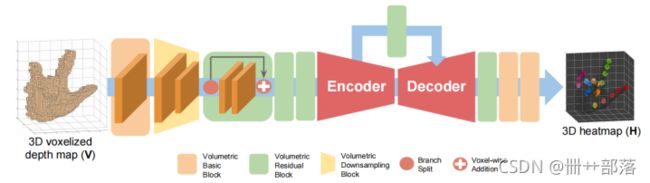

Fig.1 V2V-PoseNet. Each feature map without Z-axis and combined the 3D heatmaps of all keypoints in a single volume. Each color in the 3D heatmap indicates keypoints in the same finger.

图1显示了提出的V2V-PoseNet的总体架构。V2V-PoseNet接受体素化的输入,并通过编码器和解码器估算每个关键点的每个体素的可能性。为了简化该图,绘制了没有Z轴的每个特征图,并将所有关键点的3D热图合并到一个立方体中。3D热图中的每种颜色都表示同一根手指上的关键点。

该模型的目标是估计所有关键点的3D坐标。

首先,通过重新投影3D空间中的点并离散化连续空间,将2D深度图像转换为3D形式。然后对2D深度图像进行体素化后,V2V模型将3D体素化数据作为输入,并估计每个关键点的每个体素可能性。最后识别每个关键点的最高似然响应的位置,计算真实世界的坐标,即模型的最终结果。

该模型的主要贡献包括:

1.首先将从单个深度图估计3D姿势的问题转换为体素到体素的预测。与直接从2D深度图像中回归3D坐标的方法不同,本文提出的V2V-PoseNet从体素化的网格输入中估计每个体素的可能性。

2.通过比较每种输入类型(即2D深度图和体素化网格)和输出类型(即3D坐标和每个体素的似然性)的性能,从经验上验证体素输入和输出表示的有用性。

3.使用几乎所有现有的3D姿势估计数据集(包括三个3D手和一个3D人体姿势估计数据集)进行了广泛的实验。结果表明,所提出的方法比以前的方法产生的结果要准确得多。

1. Refining target object localization

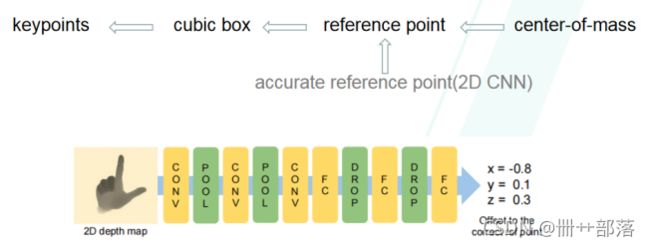

Fig.2 Reference point refining network. This network takes cropped depth image and outputs the 3D offset from the current reference point to the center of ground-truth joint locations.

细化目标对象定位。要定位关键点,例如手或人体关节,先决条件是要在3D空间中容纳手或人体的立方体盒。此立方盒通常放置在参考点周围,该参考点是使用真实的关节位置或在手部区域进行简单的深度阈值处理后获得的质心获得的。但是,在实际应用中,利用真实位置是不可行的。而且,由于杂乱场景中的质心计算中的误差,使用通过简单深度阈值计算的质心不能保证对象正确包含在获取的立方框中。如果其他对象在目标对象附近,简单的深度阈值方法无法正确过滤其他对象,因为它对所有输入数据都应用了相同的阈值。因此,计算出的质心不正确,会导致立方体框仅包含部分目标对象。为了克服这些限制,作者参考文献[29](Deep prior++,2015)训练了一个简单的2D CNN获得如图2所示的准确参考点。该网络获取深度图像,其参考点由手部区域周围的简单深度阈值计算得出,并输出从计算出的参考点到真实关节位置中心的3D偏移量。可以通过将网络的输出偏移值与计算出的参考点相加来获得精确的参考点。

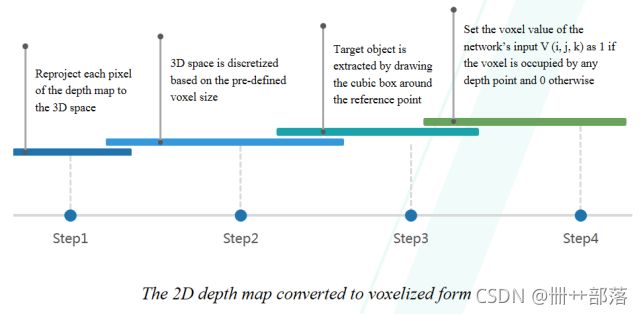

2. Generating input of the proposed system

生成输入。要创建系统的输入,应将2D深度图转换为体素化形式。为此首先将深度图的每个像素重新投影到3D空间。然后,根据预定义的体素大小离散化3D空间。再通过之前获得的参考点绘制立方体框来提取目标对象。如果体素被深度点占据,将网络输入V(i,j,k)的体素值设置为1,否则设置为0。

3. V2V-PoseNet

Building block design

(1) Volumetric basic block(first and last parts)

Volumetric convolution

Volumetric batch normalization

Activation function

(2) Volumetric residual block

(3) Volumetric downsampling block

(4) Volumetric upsampling block

在设计V2V-PoseNet时,使用了四种构建基块。第一个是体积基本块,它由体积卷积,体积批量归一化和激活函数(即ReLU)组成。该块位于网络的第一部分和最后一部分。第二个是从2D残差块扩展的体积残差块。第三个是体积下采样块,它与体积最大池化层相同。最后一个是体积上采样块,它由体积反卷积层,体积批量归一化层和激活函数(即ReLU)组成。向反卷积层添加批处理规范化层和激活功能有助于简化学习过程。剩余块的核大小为3×3×3,下采样和上采样层的核大小为2×2×2,步幅为2。

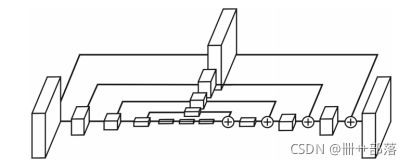

Fig.3 Hourglass module.

V2V-PoseNet执行体素到体素的预测。它基于3DCNN架构,将Z轴视为附加的空间轴,因此内核形状为w×h×d。该网络架构是基于沙漏模型(图3)的,该模型经过了略微修改,以实现更准确的估算。如图1所示,网络从7×7×7体积基本块和体积下采样块开始。对特征图进行下采样后,三个连续的残差块会提取有用的局部特征。剩余块的输出分别通过编码器和解码器。

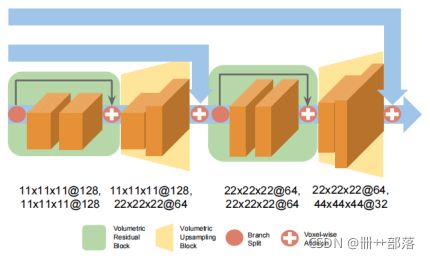

Fig.4 Encoder of the V2V-PoseNet. The numbers below each block indicate the spatial size and number of channels of each feature map. We plotted each feature map without Z-axis to simplify the figure.

Fig.5 Decoder of the V2V-PoseNet. The numbers below each block indicate the spatial size and number of channels of each feature map. We plotted feature map without Z-axis to simplify the figure.

图4是V2V-PoseNet的编码器。每个块下面的数字表示每个特征图的空间大小和通道数。为简化该图,绘制的是没有Z轴的每个特征图。

图5是V2V-PoseNet的解码器。每个块下面的数字表示每个特征图的空间大小和通道数。

在编码器中,体积下采样块减小了特征图的空间大小,而体积残余块增加了通道数。通道数量的增加有助于改善实验性能。另一方面,在解码器中,体积上采样块扩大了特征图的空间尺寸。上采样时,网络会减少通道数量以压缩提取的特征。解码器中体积的扩大有助于网络密集地定位关键点,因为它减小了特征图中体素之间的跨度。编码器和解码器针对每个比例与逐个体素连接,以便解码器可以更稳定地对特征图进行上采样。在使输入经过编码器和解码器之后,网络将通过两个1×1×1体积基本块和一个1×1×1体积卷积层来预测每个关键点的每个像素的似然值。

Network training

为了监督每个关键点的每个体素的可能性,首先生成了3D热图,其中高斯峰的平均值位于真实关节点的位置,如公式一所示。其中H∗n是第n个关键点的groundtruth-3D热图,(in,jn,kn)是第n个关键点的ground truth体素坐标,而σ=1.7是高斯峰的标准偏差。此外,采用均方误差作为损失函数L,如公式二所示。其中Hn是第n个关键点估计的热图,N表示关键点的数量。

4. Experiment

Datasets

ICVL手姿势数据集。ICVL数据集由330K训练和1.6K测试深度图像组成。手势注释包含16个关节,其中每个手指包括三个关节,而手掌则包括一个关节。

NYU手姿势数据集。NYU数据集由72K训练和8.2K测试深度图像组成。训练集是从受试者A收集的,而测试集是受试者A和B通过三个Kinects从不同的角度收集的。手势注释包含36个关节。

MSRA手姿势数据集。MSRA数据集包含9个主题,每个主题有17个手势。通过21个带注释的关节捕获了76K深度的图像。为了进行评估,采用了留一法制交叉验证策略。

HANDS 2017基于帧的3D手姿估计挑战数据集。HANDS 2017基于帧的3D手势估计挑战数据集包括从BigHand2.2M和First Person Hand Action(FHAD)数据集采样的957K训练和295K测试深度图像。这两个数据集都是完全注释(包含21个关节的3D坐标)。深度图像由Intel RealSense SR300相机以640×480像素分辨率拍摄。

ITOP人类姿势数据集。ITOP数据集包含40K训练和10K测试深度图像,包括前视图和顶视图。此数据集包含具有20位演员的深度图像,每个演员执行15个序列,并由两台相机记录。该数据集的ground-truth是15个人体关节的3D坐标。

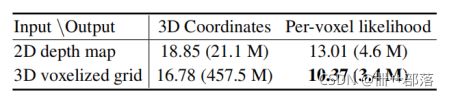

Table 1: Average 3D distance error (mm) and number of parameter comparison of the input and output types in the NYU dataset. The number in the parenthesis denotes the number of parameters.

Table 2: Effect of localization refinement and epoch ensemble. The average 3D distance error is calculated in the NYU dataset.

检测指标,用3D距离误差和成功帧指标的百分比用于3D手部姿势估计。对于3D人体姿势估计,使用平均精度(mAP)。

为了证明输入和每个体素似然估计的3D表示的有效性,在表1中比较了输入和输出形式的四种不同组合的性能。(平均3D距离误差(mm)和参数数量比较,括号中的数字表示参数的数量。)从2D转换输入表示类型深度图转换为3D体素化形式(也将模型从2D CNN转换为3D CNN),无论输出表示如何,都可以显着提高性能。这证明了所提出的没有透视失真的3D输入表示的有效性。结果还表明,无论输入类型如何,将输出表示形式从3D坐标转换为每个体素的可能性都会显着提高性能。在这四种组合中,体素到体素即使在参数数量最少的情况下也能提供最佳性能。因此,与其他输入和输出组合相比,体素到体素预测方案的优越性显然是合理的。(将体素到体素转换为像素到体素会减少参数的数量。为了弥补这一变化,在像素转体素模型中将每个特征图的通道数量增加了一倍。如果通道数未加倍,则性能会下降。)

为了证明定位调整的重要性,比较了使用和不使用定位调整步骤时两种方法的性能。如表2所示,(定位细化和epoch集成的效果。平均3D距离误差)调整的参考点大大提高了模型的准确性,这表明参考点的精炼程序对性能具有至关重要的影响。

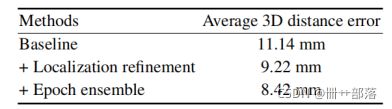

将V2V-PoseNet在三个3D手部姿势估计数据集(ICVL,NYU和MSRA)上的性能与大多数最新方法进行了比较,其中包括潜在的随机森林(LRF),分层采样优化(HSO),级联手姿势回归(Cascade),DeepPrior和优化(DeepPrior),局部表面法线(LSN),反馈回路训练方法(Feedback),基于手模型的方法(DeepModel),多视图CNN(MultiView),DISCO,Hand3D,DeepHand,lie-x组基于方法(Lie-X),改进的DeepPrior(DeepPrior ++),区域集成网络(REN-4×6×6,REN-9×6×6),CrossingNets,姿势指导REN(Pose-REN),全局到局部预测方法(Global-to-Local),分类指导方法(Cls-Guide),基于3DCNN的方法(3DCNN),基于遮挡感知的方法(Occlusion)和幻觉热分布方法(HeatDist)。

Fig.6 Comparison of the proposed method (V2V-PoseNet) with state-of-the-art methods. Top row: the percentage of success frames over different error thresholds. Bottom row: 3D distance errors per hand keypoints.

Table 3: Comparison of the proposed method (V2V-PoseNet) with state-of-the-art methods on the three 3D hand pose datasets. Mean error indicates the average 3D distance error.

如图6和表3所示,图6中,顶行:成功帧超过不同错误阈值的百分比。底行:每个手部关键点的3D距离误差。左:ICVL数据集,中:NYU数据集,右:MSRA数据集。表3中,所提出的方法与最先进的方法在三个3D手姿势数据集上的比较。平均误差表示平均3D距离误差。本文方法在标准评估指标中优于三个3D手势估计数据集上的所有现有方法。这显示了体素到体素预测的优越性。

Fig.7 Comparison of average 3D distance error overdifferent yaw (left) and pitch (right) angles on the MSRA dataset.

如图7所示,在MSRA数据集上测量了各种偏移角(左)和俯仰角(右)上的平均3D距离误差分布。如图所示,该方法在几乎所有偏移角和俯仰角上均表现优异。

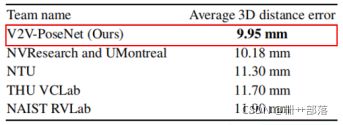

Table 4: The top-5 results of the HANDS 2017 frame-based 3D hand pose estimation challenge.

Table 5: Comparison of the proposed method (V2V-PoseNet) with state-of-the-art methods on the front and top views of the ITOP dataset.

表4是HANDS 2017基于帧的3D手势估计挑战的前五名排名结果。

在ITOP 3D人体姿势估计数据集上评估了所提出系统的性能。将系统与最新技术进行了比较,如基于随机森林的方法(RF),RTW,IEF,基于视点不变特征的方法(VI)和REN-9x6x6。结果如表5所示,所提出的系统在所有两个视图中都大大优于所有现有方法,这表明本文模型不仅可以应用于3D手势估计,而且还可以应用于从前视图和顶视图估计3D人体姿势。

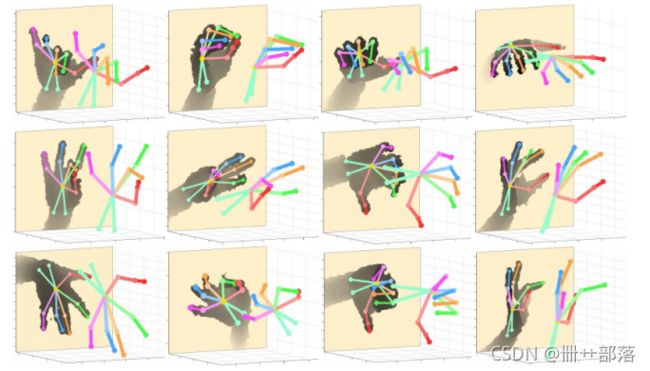

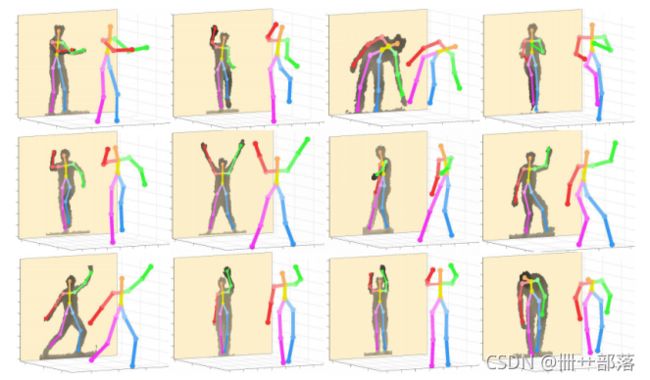

图8~13分别显示了ICVL,NYU,MSRA,HANDS 2017,ITOP前视图和ITOP顶视图数据集上V2V-PoseNet的定性结果。

Fig.8 Qualitative results of our V2V-PoseNet on the ICVL dataset. Backgrounds are removed to make them visually pleasing.

Fig.9 Qualitative results of our V2V-PoseNet on the NYU dataset. Backgrounds are removed to make them visually pleasing.

Fig.10 Qualitative results of our V2V-PoseNet on the MSRA dataset. Backgrounds are removed to make them visually pleasing.

Fig.11 Qualitative results of our V2V-PoseNet on the HANDS 2017 frame-based 3D hand pose estimation challenge dataset. Backgrounds are removed to make them visually pleasing.

Fig.11 Qualitative results of our V2V-PoseNet on the HANDS 2017 frame-based 3D hand pose estimation challenge dataset. Backgrounds are removed to make them visually pleasing.

Fig.12 Qualitative results of our V2V-PoseNet on the ITOP dataset (front-view). Backgrounds are removed to make them visually pleasing.

Fig.13 Qualitative results of our V2V-PoseNet on the ITOP dataset (top-view).Backgrounds are removed to make them visually pleasing.

Fig.13 Qualitative results of our V2V-PoseNet on the ITOP dataset (top-view).Backgrounds are removed to make them visually pleasing.