CVPR 2023 | LoGoNet:优于所有最先进的 3D 目标检测方法!

作者 | 派派星 编辑 | CVHub

点击下方卡片,关注“自动驾驶之心”公众号

ADAS巨卷干货,即可获取

点击进入→自动驾驶之心【3D目标检测】技术交流群

后台回复【3D检测综述】获取最新基于点云/BEV/图像的3D检测综述!

Title: LoGoNet: Towards Accurate 3D Object Detection with Local-to-Global Cross-Modal Fusion

Paper: https://arxiv.org/pdf/2303.03595.pdf

Code: https://github.com/sankin97/LoGoNet

导读

3D 目标检测是自动驾驶等安全领域中的一个必不可少的任务。通过在三维空间中对目标进行定位与分类,3D 目标检测技术能有效地提高自动驾驶汽车对周围环境的感知能力。

然而,3D 目标检测面临着许多挑战。首先,传感器数据可能存在误差和噪声,因此需要对数据进行处理和校准。其次,点云数据通常是稀疏的,因此需要采用合适的方法来处理数据。此外,传感器数据的多样性和复杂性也使得物体检测变得更加困难。

另外,不同的传感器有其各自的优点和局限性,如 LiDAR 可以提供准确的深度和几何信息,但点云通常是稀疏的,缺乏足够的上下文信息,难以准确地区分目标类别;而相机输出的是 2D 图像,不具备可靠的深度和几何信息,但可以提供丰富的语义和纹理信息。因此,融合不同传感器的信息,弥补和彼此的缺陷和不足,是提高 3D 目标检测性能的一个重要方法。

基于图像方法

基于图像的三维检测需要先进行深度估计,然后在三维空间中进行目标检测。由于从图像中准确估计深度信息非常困难,因此其性能不如基于激光雷达的方法。最近,一些研究者引入了基于 Transformer 的架构,利用 3D 目标查询和 3D-2D 对应来提高检测性能。

基于 LiDAR 方法

基于激光雷达的方法可以根据所使用的点云表示类型分为三种:点云表示方法、体素表示方法和点-体素融合方法。点云表示方法直接采用原始点云作为输入,并采用堆叠的多层感知器 (MLP) 层来提取点特征。体素表示方法将点云转换为体素并利用3D稀疏卷积层来提取体素特征。点-体素融合方法利用点云和体素表示方法来提取不同的特征表示。

基于多模态融合方法

多模态 3D 检测通过融合图像和点云的特点来提高性能。其中一些方法引入了交叉注意力机制,以自适应地对齐和融合点云和图像特征。

本文提出了一种新颖的 LiDAR-相机 融合网络 LoGoNet。这是一种在局部和全局两个层面上进行 LiDAR-相机信息融合的方法。在全局融合方面,在先前工作的基础上,通过添加点质心来更精确地表示体素特征的位置,从而实现更好的跨模态对齐。在局部融合方面,首先将每个 proposal 划分为均匀的网格,然后将这些网格中心投影到图像上。围绕投影的网格点的图像特征被采样,与带有位置信息的点云特征融合,最大限度地利用 proposal 周围丰富的上下文信息。此外,还提出了特征动态聚合模块,用于实现局部和全局融合特征之间的信息交互,从而产生更具信息量的多模态特征。

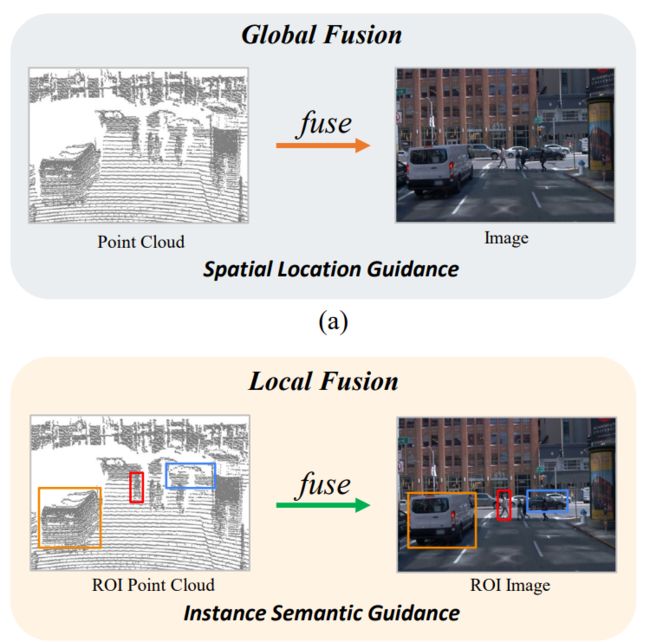

全局融合与局部融合的对比

全局融合方法,将整个场景中的点云特征与图像特征进行融合,缺乏精准的区域级 (region-level) 信息。局部融合方法,融合了每个 proposal 上的两种模态特征,是对全局融合方法的补充。

3D 目标检测性能对比

LoGoNet 在两个主流数据集上 (Waymo Open 和 KITTI) 的表现优于所有 3D 检测方法,并获得81.02 mAPH(L2)的检测性能。源码即将开源,这超强性能非常值得大家研究学习!

方法

概述

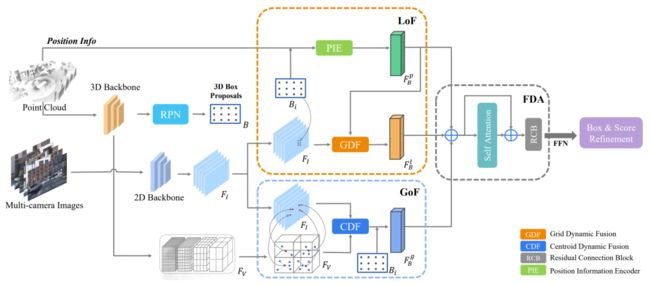

图1. LoGoNet 框架

图1. LoGoNet 框架

LoGoNet 输入为点云和其关联的多相机图像,输出为目标检测结果。其中,点云由空间坐标、特征和点数等信息组成;而图像经过 2D 检测器处理后,生成密集的语义图像特征。该网络包括三个主要的模块:全局融合(GoF)、局部融合(LoF)和特征动态聚合(FDA),用于实现点云和图像的局部到全局的跨模态特征融合。

全局融合模块

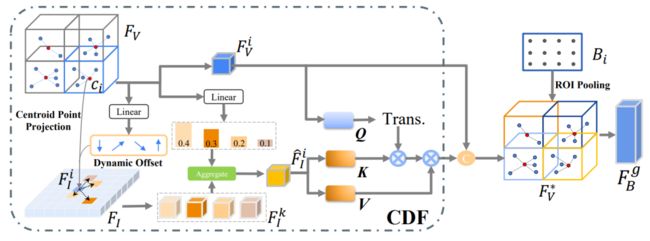

图2. 全局融合模块

图2. 全局融合模块

传统的全局融合方法通常使用体素中心来表示每个体素特征的位置,但这种方法忽略了每个体素内点的实际分布,质心动态融合模块 (Centroid Dynamic Fusion, CDF)使用体素内点的质心来表示非空体素特征的空间位置,并利用可变形交叉注意力模块自适应地融合点云特征与图像特征。

具体来说,对于非空体素特征和图像特征,首先计算每个体素内点的质心,并将其映射到图像平面得到参考点,然后通过一组注意力头和学习的权重来自适应地融合点云特征和图像特征,最终得到融合特征,用于后续 proposal 的生成与精细化。

这种融合方法充分考虑了点云特征的几何形状信息,能够更好地适应大规模点云。

局部融合模块

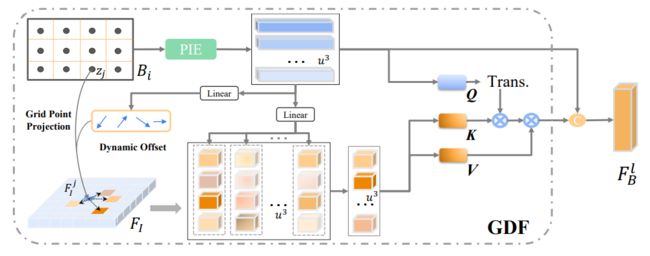

图3. 局部融合模块

图3. 局部融合模块

局部融合模块 (Local Fusion, LoF) 通过网格点动态融合(Grid point Dynamic Fusion, GDF)在 proposal 级别动态融合点云特征和图像特征,用于提供更多局部和细粒度的几何信息。

对于每个边界框 proposal ,将其划分为的规则体素网格,其中索引体素网格。然后使用位置信息编码 (Position Information Encoder, PIE)对每个体素网格特征进行编码,生成每个边界框 proposal 的局部网格-ROI特征 。然后,使用 GDF 模块,将图像特征与局部 proposal 的编码网格 ROI 特征自适应地融合起来。在融合过程中,使用交叉注意力机制将本地采样的图像特征和编码的局部 ROI 网格特征进行融合。最终,通过 FFN 对融合的局部网格特征进行处理,生成最终融合的 ROI-grid 特征 。

特征动态聚合模块

图4. 特征动态聚合模块

图4. 特征动态聚合模块

特征动态聚合模块 (Feature Dynamic Aggregation, FDA)用于建立不同网格点之间的自适应关系,从而增强特征信息。

首先,通过 LoF、GoF 和 PIE 模块获得三种特征,即、和。这些特征相互独立,信息交互和聚合较少。然后,采用自注意力机制建立非空网格点特征之间的交互,通过标准 Transformer 编码器层和残差连接块 (Residual Connection Block, RCB)实现。最后,使用 FDA 模块生成的共享扁平化特征来优化边界框。

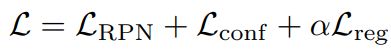

损失函数

在网络训练过程中,图像分支的权重被冻结,只有 LiDAR 分支被训练。总的训练损失函数由三个部分组成:RPN 损失 、置信度预测损失 和边界框回归损失 。

其中,超参数 α 用于平衡不同的损失,本文实验中将其设置为1。

实验

LoGoNet在Waymo 3D检测挑战赛中取得了最好的结果,LoGoNet Ens实现了81.02 mAPH(L2)的检测性能。

在不使用测试时数据增强和模型集成的情况下,LoGoNet 也优于所有竞争方法,并且 LoGoNet 的多帧输入方法比单帧和多帧方法都更有效。

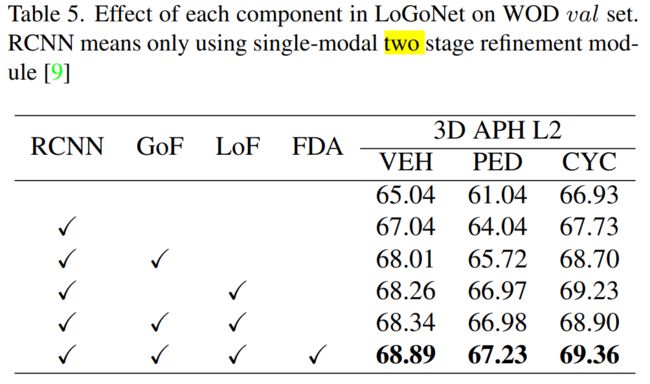

通过逐步增加不同的组件,模型性能都获得了进一步的提升。

总结

本文提出了一种新颖的多模态网络,称为 LoGoNet,采用局部到全局的跨模态特征融合,深度融合点云特征和图像特征,为精确检测提供更丰富的信息。在 WOD 和 KITTI 数据集上进行了大量实验,LoGoNet 超过了以前的方法,并在 Waymo 3D 检测排行榜上获得了第一名。结果表明,该框架具有很强的有效性和通用性。

(一)视频课程来了!

自动驾驶之心为大家汇集了毫米波雷达视觉融合、高精地图、BEV感知、传感器标定、传感器部署、自动驾驶协同感知、语义分割、自动驾驶仿真、L4感知、决策规划、轨迹预测等多个方向学习视频,欢迎大家自取(扫码进入学习)

(扫码学习最新视频)

视频官网:www.zdjszx.com

(二)国内首个自动驾驶学习社区

近1000人的交流社区,和20+自动驾驶技术栈学习路线,想要了解更多自动驾驶感知(分类、检测、分割、关键点、车道线、3D目标检测、Occpuancy、多传感器融合、目标跟踪、光流估计、轨迹预测)、自动驾驶定位建图(SLAM、高精地图)、自动驾驶规划控制、领域技术方案、AI模型部署落地实战、行业动态、岗位发布,欢迎扫描下方二维码,加入自动驾驶之心知识星球,这是一个真正有干货的地方,与领域大佬交流入门、学习、工作、跳槽上的各类难题,日常分享论文+代码+视频,期待交流!

(三)【自动驾驶之心】全栈技术交流群

自动驾驶之心是首个自动驾驶开发者社区,聚焦目标检测、语义分割、全景分割、实例分割、关键点检测、车道线、目标跟踪、3D目标检测、BEV感知、多传感器融合、SLAM、光流估计、深度估计、轨迹预测、高精地图、NeRF、规划控制、模型部署落地、自动驾驶仿真测试、产品经理、硬件配置、AI求职交流等方向;

添加汽车人助理微信邀请入群

备注:学校/公司+方向+昵称