数字媒体概论——视频

视频:视频是由一幅幅单独的画面序列(帧 frame)组成 ,这些画面以一定的速率(帧率 fps)连续地投射在屏幕上,使观察者具有图像连续运动的感觉

- 大于5 FPS时图像是活动的

- 大于24FPS是图像连续流畅

一:模拟视频

模拟视频(Analog Video)是一种用于传输图像并且随时间连续变化的电信号。依靠调幅的手段在空间传播,或用盒式磁带录像机存放在磁带上。

摄像机前的被拍摄物体的不同亮度对应于不同的亮度值,摄像机电子管中的电流会发生相应的变化。模拟信号就是利用这种电流的变化来表示或者模拟所拍摄的图像,记录下它们的光学特征,然后通过调制和解调,将信号传输给接收机,通过电子枪显示在荧光屏上,还原成原来的光学图像。

1.1:电视广播制式

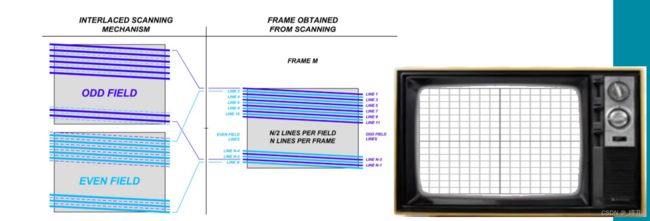

1.1.1:隔行扫描

隔行扫描(交错扫描 Interlaced Scanning):相对于逐行扫描;,这是一种在不消耗额外带宽的情况下将视频显示的感知帧速率加倍的技术。隔行扫描信号包含在两个不同时间捕获的视频帧的两个场(Field)。

模拟电视中最重要的因素之一是信号带宽,以兆赫为单位。带宽越大,整个生产和广播链越昂贵,越复杂。这包括摄像机,存储系统,广播系统和接收系统:地面,有线,卫星,互联网和最终用户显示器(电视和计算机监视器)。

对于固定带宽,隔行扫描为给定行数提供了两倍显示刷新率的视频信号(与逐行扫描相比)视频以类似的帧速率 - 例如1080i,每秒60帧半帧,而1080p每秒30帧全帧)。较高的刷新率改善了运动中物体的外观,因为它更频繁地更新其在显示器上的位置,并且当物体静止时,人类视觉组合来自多个相似半帧的信息以产生与所提供的相同的感知分辨率。通过渐进的全帧。如果源材料具有更高的刷新率,则此技术仅有用。电影电影通常以24fps记录,因此不会受益于隔行扫描,这种解决方案可将最大视频带宽降低到5MHz而不会降低60Hz的有效图像扫描速率。

给定固定带宽和高刷新率,隔行扫描视频还可以提供比逐行扫描更高的空间分辨率。例如,具有60 Hz场频的1920×1080像素分辨率隔行扫描HDTV(称为1080i60或1080i / 30)具有与具有60 Hz帧速率(720p60或720p / 60)的1280×720像素逐行扫描HDTV类似的带宽。 ,但是对于低运动场景,空间分辨率大约是其两倍。

但是,带宽优势仅适用于模拟或未压缩的数字视频信号。对于所有当前数字电视标准中使用的数字视频压缩,隔行扫描引入了额外的低效率。。EBU已经进行了测试,表明隔行扫描视频相对于逐行扫描视频的带宽节省最小,即使帧速率提高了两倍。即,1080p50信号产生与1080i50(又名1080i / 25)信号大致相同的比特率,和1080p50实际上需要较少的带宽,以便在编码“运动”时主观上比1080i / 25(1080i50)等效更好。输入“场景。

在VHS以及使用旋转鼓在录像带上录制视频的大多数其他模拟视频录制方法都受益于隔行扫描。在VHS上,鼓每帧转动一整圈,并带有两个图像头,每个图像头在每次旋转时扫描一次磁带表面。如果设备用于记录逐行扫描视频,则磁头的切换将落在图像的中间并显示为水平频带。隔行扫描允许切换发生在图像的顶部和底部,标准电视机中的区域对于观看者是不可见的。该设备也可以比每次扫描记录全帧时更紧凑,因为这需要双倍直径的鼓以角速度的一半旋转,并在磁带上进行更长,更浅的扫描以补偿每次扫描的双倍线数。然而,相同的图像区域,基本上将垂直分辨率减半,直到播放进行。另一种选择是在实际停止磁带之前按下暂停按钮捕获一个完整的帧(两个字段),然后从帧缓冲区重复再现它。后一种方法可以产生更清晰的图像,但是通常需要一定程度的去隔行以获得显着的视觉效果。虽然前一种方法会产生朝向图像顶部和底部的水平伪影,因为磁头不能沿着磁带表面精确地穿过与在移动磁带上记录时完全相同的路径,但这种不对准实际上会随着逐行记录而变差。

隔行扫描可用于制作3D电视节目,特别是对于CRT显示器,尤其是对于彩色滤光眼镜,通过在交替场中传输每只眼睛的彩色键控图像。这不需要对现有设备进行重大改动。快门眼镜也可以采用,显然需要实现同步。如果使用逐行扫描显示来查看这种编程,则任何对图像进行去隔行扫描的尝试都会使效果无效。对于彩色滤光眼镜,图像必须是缓冲的并且显示为具有交替的彩色键控线的渐进式,或者每个场必须被线性加倍并显示为离散帧。后一种程序是在逐行显示器上适合快门眼镜的一种方法。

1.1.2:YUV颜色编码

YUV是一种颜色编码方法,主要用于电视系统以及模拟视频领域,它将亮度信息(Y)与色彩信息(UV)分离。

- Y亮度(Luminance):也就是灰度值。(Y=R*0.3+G*0.59+B*0.11)

- U和V表示的则是色度(Chrominance):作用是描述影像色彩及饱和度,用于指定像素颜色

优点:

- 没有UV信息一样可以显示完整的灰度图像Y,很好地解决了彩色电视机与黑白电视的兼容问题。

- YUV不像RGB那样要求三个独立的视频信号同等传输,所以用YUV方式传送占用极少的频宽。

YCbCr 是在世界数字组织视频标准研制过程中作为ITU - R BT.601 建议的一部分,相当于YUV经过缩放和偏移的版本。

1.1.3:常见电视广播制式

- NTSC(美国国家电视标准委员会 National Television System Committee):YIQ颜色标准,帧率30fps,扫描线525行,逐行扫描,画面比例4:3。美、日使用

- SECAM(塞康制):按顺序传送彩色与存储,帧率25帧,扫描线625行,隔行扫描,画面比例为4:3。法、俄、东欧使用

- PAL(Phase Alternating Line 逐行倒相):YUV颜色标准,扫描线625行、帧率25fps、隔行扫描、PAL色彩编码。其他大部分地区使用

1.2:模拟视频信号类型

- 高频或射频信号:为了能够在空中传播电视信号,必须把视频全电视信号调制成高频或射频(RF-Radio Frequency)信号,每个信号占用一个频道,这样才能在空中同时传播多路电视节目而不会导致混乱。

- 复合视频信号:包括亮度和色度的单路模拟信号,也即从全电视信号中分离出伴音后的视频信号。这种信号一般可通过电缆输入或输出到家用录像机上,其信号带宽较窄,一般只有240线左右的水平分辨率

- 分量视频信号:为保证视频信号质量,近距离时可用分量视频信号传输, 分量信号是指每个基色分量( R,G,B 或 Y,U,V )作为独立的电视信号传输。计算机输出的VGA视频信号,即为分量形式的视频信号。

- S-Video信号:S-Video是一种两分量的视频信号,它把亮度和色度信号分成两路独立的模拟信号。这种信号亮度和色度分开传输,可以减少其互相干扰,水平分解率可达420线。

二:数字视频

2.1:数字视频与模拟视频数字化

数字视频:以数字形式记录的视频

- 与模拟视频相比,数字视频有不同的产生方式,存储介质和播出方式。

- 数字摄像机直接采集数字视频信号,存储在数字带,蓝光盘或者磁盘上,从而得到不同格式的数字视频。然后通过PC,特定的播放器等播放出来。

- 模拟视频转换,一般采用分量数字化方式,先把复合视频信号中的亮度和色度分离,得到YUV或YIQ分量,然后用三个模/数转换器对三个分量分别进行数字化,最后再转换成RGB空间。视频采集卡采用高速、高精度A/D转换芯片和专用数字编码器,直接输出数字视频信号。

A/D转换(将模拟信号转换成数字信号的电路,称为模数转换器,analog to digital converter):为了在PAL、NTSC和 SECAM电视制式之间确定共同的数字化参数,国家无线电咨询委员会(CCIR)制定了广播级质量的数字电视编码标准,称为CCIR 601标准,对采样频率、采样结构、色彩空间转换等都作了严格的规定

2.2:数字视频流

由于视频信息十分丰富且信息量大,而当今网络的传输速度慢,如果按传统的计算机文件的处理方式来处理网络视频数据信息,将会造成麻烦。通常情况下,计算机处理文件是完整地进行处理的,也就是说文件在被处理的时候必须是一个完整的整体。文件一旦遭到损坏,或者只有一半的内容,那么计算机将认为该文件是坏的,是不可处理的。如果这套原则也同时适用于网络视频文件的话,观赏者至少得等数十分钟到数小时,等视频文件下载完后才能看到,这显然让人难以接受。

解决的办法是采用一种专用的流体化技术提取文件。这种流体化技术的原理是这样的:服务器在向用户传输视频文件时,不是一次将文件整体发送出去,而是先按播放的时间顺序将其分为小的片断,类似于图像中的帧,然后将这些片断依次发给用户。用户的网络播放工具接收到这些片断后,连续播放这些片断,就可以产生完整的声音和图像,只是开始时有些延迟。网上直播时视频文件的产生也是不断生成新的片断。为了保证声音、图像的播放效果,服务器与用户计算机间的网络传输速度有一定的要求。如果网络传输速度较慢,播放时就会出现断断续续的现象。应用中可以根据用户的实际带宽,提供用户不同清晰度的播放效果。这就是视频流技术。

所谓视频流,就是一种视频数据信息的传输方式,使用这种方式,用户可以在没有接到完整的数据信息前就能处理那些已接收的信息。这种一边接收,一边处理的方式,很好地解决了视频数据信息在网络上的传输问题。使用者可以不必等待太长的时间,就能收看到视频数据信息。并且在此之后一边播放,一边接收,根本不会感觉到文件没有传完。

数据率 = (720像素 * 576行 * 25帧) * 2字节/s=20736000字节/s ≈ 165 Mbps

视频数据的压缩和解压缩:视频图像的信息量是巨大的。例如1幅640×480中分辨度的彩色图像(24bit/像素),其数据量为0.92MB,如果以每秒30帧的速度播放,则视频信号的数码率高达27.6Mbps。为了在一定的带宽条件下完成视频传送,必须压缩视频文件的信息量,容忍一定的视频质量降级。但是,压缩文件有时候会把原有的精华都给去掉,使得最终的产品失去了原有的魅力。所以还必须灵活有效地控制文件的压缩。显然,视频压缩技术数字化是压缩技术的关键。

目前比较流行的视频压缩和解压缩技术有动态视频压缩国际标准MPEG和微软的NetShow及Real Networks公司的RealVideo的音频视频编码/解码技术。

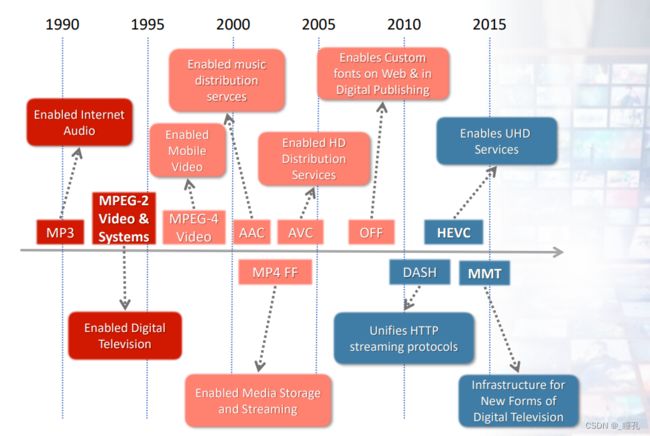

MPEG是国际标准化组织的运动图像专家组在1990年12月制定的,MPEG-1在1992年成为标准,它的核心技术是离散余弦变换及运动补偿算法,它的主要思想是通过减少每帧图像间时间上和空间上的冗余性和相关性信息来减少数据量。MPEG-l在800KbPs~2Mbps的传输速率下图像清晰度能达到较好的图像效果。MPEG针对宽带网或要求高清晰度画面的局域网(校园网)的视频数据压缩技术,而NetShow和RealVideo的音视频编码/解码技术针对低比特率的应用领域。

视频数据的实时传输:视频文件的传送是实时的,且视频数据发送主机(服务器)和接收显示主机(用户终端)位于不同地点,通过计算机局域网或广域网连接,具有分布性,但在用户终端显示时必须保持同步,另外,声音与视频也必须保持同步。为了确保视频数据传输的实时性和同步性。国际通信联合会(International Telecommunication Union,ITU)和国际互联网工程任务组(Internet Engineering Task Force,IETF)设计了一个实时传输协议RTP(RealTime Transport Protocol)来解决传输实时性数据的难题。RTP一般运行在不可靠的协议层上如UDP(事实上经数学统计UDP包的可靠性在99%以上)。每个经过RTP传输的数据包中有时间信息和一个相关的序列号,这个信息使应用程序混合音频和视频信息相对容易。由于应用程序可以很容易地决定当视频帧需要略过时将跳到的正确数据包号,因此同每个包相关的时间信息可以平滑同步过程。

2.3:常用标准分辨率

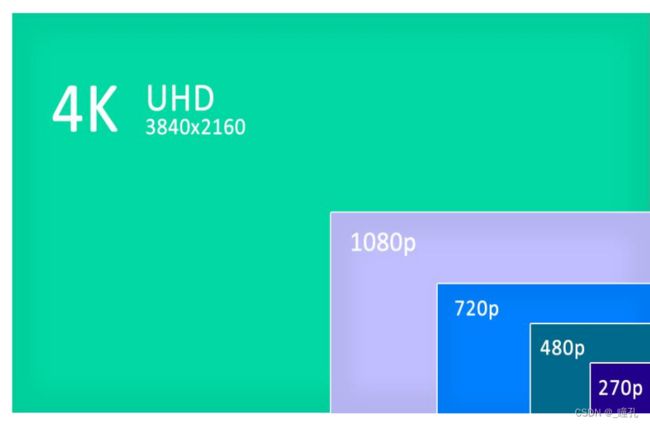

高清视频:HDTV规定了视频必须至少具备720线非交错式(720p)或1080线交错式隔行(1080i)扫描,屏幕纵横比为16:9。音频输出为5.1声道,同时能兼容接收其它较低格式的信号并进行数字化处理重放。

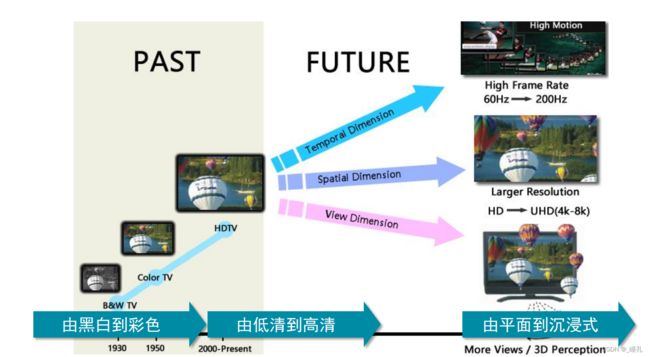

4K 超高清视频 UHD:4K分辨率是指水平方向每行像素值达到或者接近4096个,即4096x2160分辨率。根据使用范围的不同,4K分辨率也有各种各样的衍生分辨率 , 例如Full Aperture 4K的4096x3112、Academy 4K的3656x2664以及UHDTV标准的3840x2160等

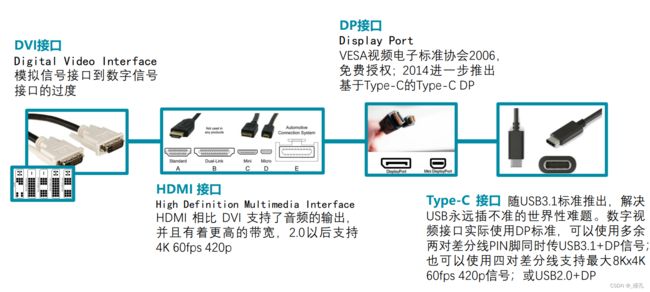

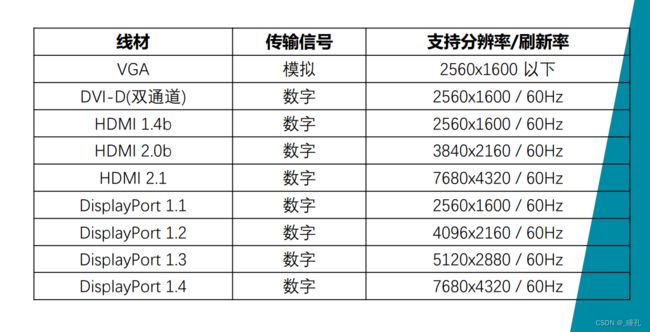

2.4:数字视频信号接口

规格表:

三:视频标准

3.1:视频压缩基础

为何要进行视频压缩:图象和视频通常在计算机中表示后会占用非常大的空间,而出于节省硬盘空间的考虑,往往要进行压缩。同时,传输过程中,为了节省珍贵的带宽资源和节省时间,也迫切要求压缩。压缩之后,传输过程中的误码率也会相应地减少。

视频为何能被压缩:因为冗余,视频有大量压缩空间

- 时域冗余:相邻图像间存在很大相似性,序列图像中的相邻帧往往包含相同或类似的背景和运动物体,只不过运动物体所在的空间位置略有不同。这种相邻帧间数据的高度相关性就称为时间冗余。

- 空间冗余:相邻像素存在相似性(图像是低秩的),在局部区域中所有点的光强和色彩以及饱和度都是非常相近的,这种空间连贯性就称为空间相关或空间冗余

- 视觉冗余:人眼的视觉系统对视频场景失真的敏感性是非均匀的,记录原始的图像数据时,通常假定视觉系统是线性的和均匀的,对视觉敏感和不敏感的部分同等对待,这样就产生了比理想编码更多的数据,这就是视觉冗余

- 编码冗余:信息熵冗余也称为编码冗余,由信息论可知,为表示图像数据的一个像素点,只要按其信息熵的大小分配相应比特数即可。而对于实际图像数据的每个像素,在图象获取时很难得到它的信息熵,因此一般是对每个像素采用相同的比特数来表示,这样就必然存在冗余,这种冗余称为信息熵冗余。

3.2:视频编解码系统

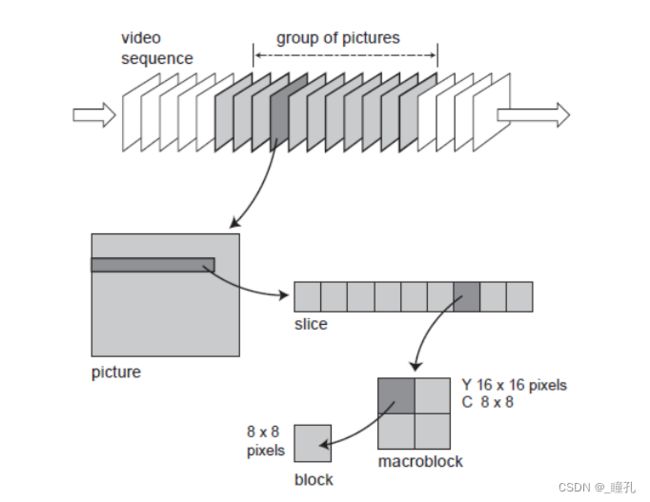

视频编解码系统有五步:预测、变换、量化、熵编码、环内滤波。

3.2.1:预测

原始值 = 预测值 + 残差。

一般地,残差的信息量 < 原始值的信息量,如果在解码端预测值能够通过某种方法估计到,那么只需要编码残差信息,就可在解码端恢复原始值,从而达到了压缩的目的

空域预测:图像被分成若干块,以块为单位做编解码,严格按照某种次序编码和解码。按照特定顺序解码, 在解码当前像素之前,如果相邻像素已经解码完,那么就可用来预测当前像素的值!

3.2.2:变换

DCT变换:

- 任意一个8x8的图像块都可以由64个基来加权组合

- 在频率域上对图像块进行了分解,便于应用人眼对高频分量不敏感的视觉冗余特性。一般地,自然图像块的高频分量较弱,变换系数较小,变换后的系数值分布更不均衡。

3.2.3:量化

量化是降低数据表示精度的过程,通过量化可以减少需要编码的数据量,达到压缩数据的目的。量化会引起失真。如果能利用人眼的视觉冗余特性,进行合理量化,使失真对人眼视觉的影响尽量小

3.2.4:熵编码

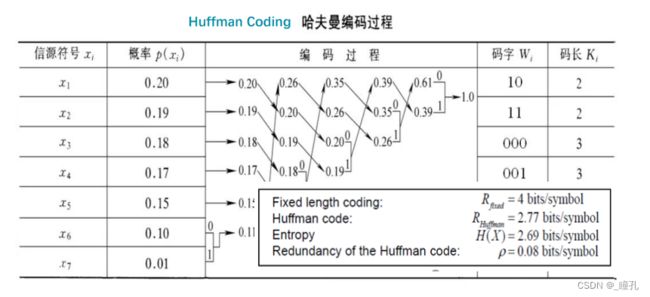

统计冗余的消除主要通过熵编码来实现。利用信源的信息熵进行码率压缩的编码方式称为熵编码

- 基本思想:为出现概率大的符号分配短码字,为出现概率小的符号分配长码字,从而达到总体平均码字最短。编码对象概率分布越不均匀,熵编码的效率越高

- 两种基本方法

- 哈夫曼编码:每个值分配一个码字,每个值至少要用一个比特表示

- 算术编码:用一个浮点数代表一串值

3.2.5:环内滤波

分块DCT和量化会引入块效应,降低解码图像质量和预测效率,对解码图像进行滤波有助于消除块效应,提高预测效率

一个复杂的平衡关系存在于以下因素之间:视频的失真、用来表示视频所需要的数据量(码率)、编码算法和解码算法复杂度

3.3:国际标准

既然都有国际标准了,为什么还要做国家标准:

- 编解码标准的商业化运作

- MPEG专利池对音视频产业的垄断

音视频国家标准AVS:距离H.265/HEVC标准正式发布已经有多年时间,虽然其压缩效率比H.264/AVC高出一倍,可以为视频公司节约带宽成本,但H.264仍是目前最流行的视频编码格式。除了复杂度高、实现困难外,H.265/HEVC高昂的专利费用和复杂的授权政策也是阻碍其推广的重要因素

MPEG LA还延续着以往的收费习惯,终端销量在10万台以下的不收费,超过的部分每台收取0.2美元的授权费,封顶费用每年2500万美元。值得一提的是,MPEG LA针对视频内容不再单独收费HEVC Advance终端设备要缴纳0.2-1.2美元不等,封顶年费4000万美元。在内容方面,除了对终端用户提供免费内容的供应商外,其他内容提供商也要根据订阅数、节目数和媒体数收费,封顶年费500万美元。保守估计每年需向三个专利池( 还有Velos Media )和Technicolor公司缴纳的H.265/HEVC专利许可封顶费用会超过1亿美元!

往事:中国DVD产业:

- 1999年6月,正是DVD开始在市场上流行的时代,6C(包括日立、松下、JVC、三菱、东芝、时代华纳)宣布“DVD专利联合许可”声明,要求世界上所有生产DVD的厂商必须向他们购买“专利许可”

- 2002年1月9日,深圳普迪公司出口到英国的3864台DVD机,被飞利浦通过当地海关扣押,依据是未经专利授权;2月21日,德国海关也扣押了惠州德赛公司的DVD机。至此,专利费之争走上国际贸易前台,逼迫出口量占世界DVD总产量70%的中国DVD企业直面此问题

- 起初6C的要价是每台DVD收取20美元,在当时中国DVD厂商200元人民币的利润空间中,6C就要拿走一多半。每台高达16~19美元的专利费,让前几年还在央视争夺广告标王的中国DVD厂商沦为代工,国产品牌大量消亡。再到9C推出蓝光新标,市场直接重新洗牌

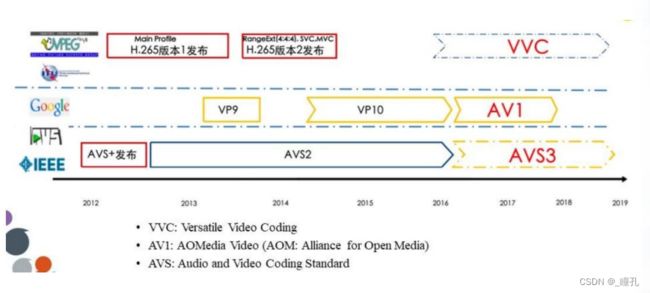

音视频国家标准AVS:

- 2002年6月,中国数字音视频编解码技术标准(AVS)工作组获批成立,主要目的就是解决我国音视频领域无可用标准而不得不缴纳高昂的专利许可费用使用国际标准的问题

- AVS工作组于2006年推出了第一代视频编码标准AVS1,被颁布为中国国家标准。

- 随后又推出了AVS1的增强版本AVS+,压缩效率和H.264/AVC的High Profile相当,并于2012年7月被国家电影电视总局颁布为广播电影电视行业标准,目前已有上千套AVS+的高清内容上星直播

- 2013年6月, IEEE(电气和电子工程师协会,国际电子信息领域影响最大的学术组织)将AVS系列标准颁布为IEEE标准,标准号为IEEE 1857,这标志着AVS标准正式走向国际。

音视频国家标准AVS2:

- 第二代AVS标准,简称AVS2,首要应用目标是超高清晰度视频,支持超高分辨率(4K以上)、高动态范围视频的高效压缩。2016年5月,AVS2被国家新闻出版广电总局颁布为广电行业标准《高效音视频编码 第1部分:视频》(行标号:GY/T 299.1-2016)。2016年12月,AVS2被国家质检总局和国家标准委颁布为国家标准《信息技术 高效多媒体编码 第2部分:视频》(国标号: GB/T 33475.2-2016)。同时提交了IEEE国际标准(标准号:IEEE1857.4)申请。

- 国家广播电影电视总局广播电视计量检测中心的测试结果表明:AVS2的压缩效率比上一代标准AVS+和H.264/AVC提高了一倍,超过国际同类型标准HEVC/H.265。AVS2还支持:三维视频、多视角和虚拟现实视频的高效编码;立体声、多声道音频的高效有损及无损编码;监控视频的高效编码;面向三网融合的新型媒体服务。

AVS1和AVS+采取“AVS专利池”统一许可模式,每个编解码器只象征性得收取1元专利费,不对内容收费;而且在工作组成立之初就制定了规则:凡是向AVS工作组提交技术和提案的单位都需要对其专利许可意向做出承诺,允许免费使用或者加入“AVS专利池”。AVS2的专利授权将沿用AVS1的统一许可模式,只对设备象征性收费,不对内容收费。特别的,对互联网上的软件服务免收专利费。实际上,AVS并没有收取过专利费

AV1简介:

- 2015年9月1日,谷歌宣布与亚马逊、思科、英特尔、微软、火狐、Netflix成立开放媒体联盟(Alliance of Open Media,简称AOM),专注于下一代视频编码格式的开发。新一代视频编码格式命名为AV1,被认为是开源编码器VP9的继承者

- 2018年,苹果加入AOM

- 特点:开放、针对互联网优化、低计算量高质量。AV1 可以提供更高的压缩比,文件尺寸较 H.265 和谷歌 VP9 编码还要少 25~35% 。

- AV1尚在制定中,免专利费用,但从目前的情况来看,编码性能和HEVC、AVS2相比还有超过10%的差距

音视频国家标准AVS3:

- AVS3进度:华为北大等多单位2019年初深圳鹏城实验室封闭开发,编码性能进一步提升30%

- 海思已推出支持AVS3芯片,华为北大协同在麒麟等多平台测试

- 2019年12月,AV3编解码器天枢、天璇开源,建设开源生态

3.4:FFMPEG工具使用

FFmpeg 是一套可以用来记录、转换数字音频、视频,并能将其转化为流的开源计算机程序。

-

FFmpeg在Linux平台下开发,但它同样也可以在其它操作系统环境中编译运行,包括Windows、Mac OS X等。这个项目最早由Fabrice Bellard发起,2004年至2015年间由Michael Niedermayer主要负责维护。许多FFmpeg的开发人员都来自MPlayer项目。

-

项目的名称来自MPEG视频编码标准,前面的"FF"代表"Fast Forward"。

-

ffmpeg:该项目提供的一个工具,可用于格式转换、解码、编码等

-

ffplay:一个简单的命令行播放器,使用ffmpeg 库解析和解码

-

ffprobe:查看多媒体文件信息的工具

-

一系列库函数

- libavcodec: 提供了一系列编码器的实现。

- libavformat: 实现在流协议,容器格式及其本IO访问。

- libavutil: 包括了hash器,解码器和各利工具函数。

- libavfilter: 提供了各种音视频过滤器。

- libavdevice: 提供了访问捕获设备和回放设备的接口。

- libswresample: 实现了混音和重采样。

- libswscale: 实现了色彩转换和缩放工能。

FFMPEG实例:

- 视频格式转换:

ffmpeg –i input.ts -c copy output.mp4。-i 指定输入视频路径;-c codec模式 copy 复制 -c:vffmpeg -i input.mp4 -vcodec mpeg4 -b:v 20m -r 30 -an output.avi。-b:v 20m:码率;-r 30:帧率

- 编码格式转YUV无压缩格式(视频编码库, 例libx264, libx265):

ffmpeg -i F:\test\4K.ts -vframes 500 F:\test\UHD.yuvffmpeg -s 1920x1080 -pix_fmt yuv444p -i 1.yuv -pix_fmt yuv420p 2.yuv

- 视频编码、压缩

ffmpeg -s 1920x1080 -i input.yuv -vcodec libx264 -crf 15 output_1920x1080.mp4(质量控制参数 -crf 0~51,0无损,18视觉无损,25直播常用,越高越差一般18-30)ffmpeg -i input_HEVC.mp4 -vcodec libx264 -acodec copy -r 24 -crf 25 output.mp4ffmpeg -i 4K_HDR.mp4 -pix_fmt yuv420p10 -vcodec libx264 -x264-params colormatrix=bt2020nc:transfer=smpte2084:colorprim=bt2020 -preset slow -b:v 20M output.mp4 -y

- 视频的旋转、剪辑、拼接

ffmpeg -i input.mp4 -metadata:s:v rotate="180" -codec copy out_rotation.mp4ffmpeg -i input.mp4 -an -f hls -hls_time 4 -vcodec copy -y ./path/%04d.mp4ffmpeg -f concat -safe 0 -i ./list.txt -vcodec libx265 -crf 15 out_concat.mp4(其中 list.txt 是合并视频的文件列表)

- 视频抽帧&图像合成视频

ffmpeg -i input.mp4 -vsync 0 PATH/%04d.png -y -pix_fmt yuv422pffmpeg -i input.mp4 -q:v 2 -s 1920x1080 -f image2 PATH/%04d.pngffmpeg -threads 8 -y -r 30 -i PATH /%04d.png -vcodec libx264 -crf 18 -pix_fmt yuv420p output.mp4

- 视频处理:缩放、锐化、去噪、水印

ffmpeg -i input.mp4 -vf scale=960x540:flags=lanczos -vcodec libx264 -crf 25 output.mp4ffmpeg -i input.mp4 -vf unsharp=5:5:2 output.mp4ffmpeg -i input.mp4 -vf hqdn3d output.mp4ffmpeg -i input.mp4 –vf "movie=logo.png,scale=64:32 [watermask];[in][watermask] overlay=30:10 [out]" watermark.mp4

- 视频中音频的处理

ffmpeg -i input.mp4 -c copy -an output_an.mp4ffmpeg -i input_v.mp4 -i input_a.ts -c copy -map 0:0 -map 1:0 -y output.mp4

- FFPROBE&FFPLAY使用示例

ffprobe input.mp4ffplay input.mp4ffplay -f lavfi -i 'movie=Left.mp4,pad=2*iw:ih[main]; movie=Right.mp4[ov];[main][ov]overlay=x=W-w'

FFmpeg是在LGPL/GPL开源协议下发布的(如果使用了其中一些使用GPL协议发布的模块则必须使用GPL协议),任何人都可以自由使用,但必须严格遵守LGPL/GPL协议。有很多播放软件都使用了FFmpeg的代码,但也有不少侵权商用行为。

四:生成及处理

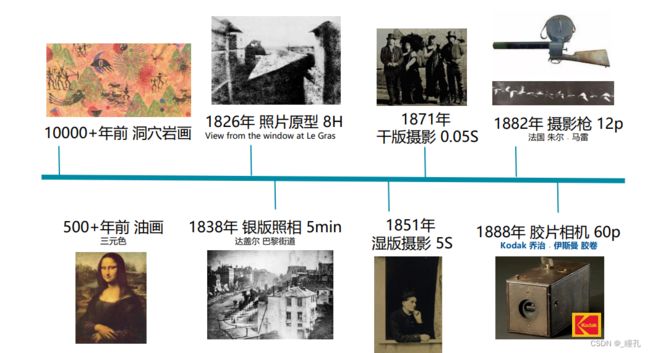

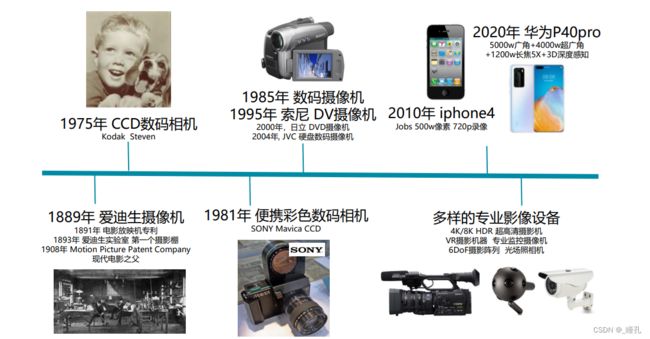

4.1:摄像设备的发展

4.2:视频数据的采集

将各类图像传感器、摄像机、录像机、电视机等视频设备输出的视频信号进行采样、量化等操作,从而转化成数字数据

- 视频采集卡

- 将模拟摄像机、录像机、电视机输出的视频信号等输出的视频数据或者视频和音频的混合数据输入电脑,并转换成电脑可辨别的数字数据,存储在电脑中,成为可编辑处理的视频数据文件。(模拟、数字)

- 数码相机/摄像机/智能手机拍摄

- 其他:人工制作合成、CG制作、AI生成 …

4.3:视频剪辑与编辑

-

视频剪辑是对视频源进行非线性编辑,属多媒体制作软件范畴。

- 线性编辑,早期磁带的编辑方式,使用专业设备将素材连接成新的连续画面的技术。通常使用组合编辑将素材顺序编辑成新的连续画面,然后再以插入编辑的方式对某一段进行同样长度的替换

- 非线性编辑,是借助计算机来进行数字化制作,突破单一的时间顺序编辑限制,

可以按各种顺序排列,具有快捷简便、随机的特性

-

通过对加入的图片、背景音乐、特效、场景等素材与视频进行重混合,对视频源进行切割、合并、编码,生成具有不同表现力的新视频。

- 直接剪辑,对片源不进行任何数据处理,切分拼接

- 剪辑转换,分割及编解码转换的过程

Adobe Premiere(Pr): Adobe开发的一款常用视频编辑软件, 目前广泛应用于广告制作和电视节目制作中,支持Windows和Mac OS。Premiere Pro是视频编辑爱好者和专业人士必不可少的视频编辑工具。它是高自由度、易学、高效、精确的视频剪辑软件。Premiere提供了采集、剪辑、调色、美化音频、字幕添加、输出、DVD刻录的一整套流程,并和其他Adobe软件高效集成,满足创建高质量视频作品的要求

DaVinci Resolve System:达芬奇调色系统自1984年以来就一直誉为后期制作的标准,许多电影/广告/纪录片/电视剧和音乐电视制作中调色师都使用达芬奇调色。

- 可以实时处理多格式:原生DPX、CIN、QuickTime、DNxHD和原生4K分辨率RED R3D文件。甚至可处理TIFF、JPEG、TGA及最高达16通道的音频。

- 在后期制作和电影行业正快速进入更高质量数字电影制作之时,DaVinci Resolve 7.1加入了对最新专业摄影机和扫描仪文件格式以及编解码器的支持。包括对Arri Alexa ARRI RAW、D-21ARRI RAW、无压缩和压缩OpenEXR格式、QuickTime格式的Sony XDCAM文件的原生实时支持

Adobe After Effect:是Adobe推出的一款图形视频处理软件,适用于从事设计和视频特技的机构,包括电视台、动画制作公司、个人后期制作工作室以及多媒体工作室。属于层类型后期软件。

- Adobe After Effects软件可以高效且精确地创建无数种引人注目的动态图形和震撼人心的视觉效果。利用与其他Adobe软件无与伦比的紧密集成和高度灵活的2D和3D合成,以及数百种预设的效果和动画,为电影、视频作品增添令人耳目一新的效果

- 涵盖影视特效制作中常见的文字特效、粒子特效、光效、仿真特效、调色技法以及高级特效等。和Premiere相比,Ae侧重特效、合成,Premiere侧重剪辑,可以配合使用。

其他影视后期特效软件:

- NUKE:The Foundry公司研发的一款数码节点式合成软件。NUKE具有先进的将最终视觉效果与电影电视的其余部分无缝结合的能力,Nuke 提供非常开放的架构 , 使用节点设计或Python语言指令

- HOUDINI:电影特效魔术师是Side Effects Software的旗舰级产品,计算机三维图形软件,便于制作三维动画及视觉效果

- Combustion:Discreet的三维视频特效软件,整合强大编辑、渲染和三维动画制作的多功能制作系统;包含矢量绘画、粒子、视频效果处理、轨迹动画以及3D效果合成等工具模块

如果有兴趣了解更多相关内容,欢迎来我的个人网站看看:瞳孔的个人空间