使用Python分析二手汽车的销售价格 -- 机器学习项目基础篇(9)

如今,随着技术的进步,机器学习等技术正在许多组织中大规模使用。这些模型通常使用一组以数据集形式提供的预定义数据点。这些数据集包含特定域的过去/先前信息。在将这些数据点馈送到模型之前组织这些数据点是非常重要的。这就是我们使用数据分析的地方。如果输入到机器学习模型的数据组织得不好,它就会给出错误或不希望的输出。这可能会给组织造成重大损失。因此,正确的数据分析非常重要。

关于数据集

我们在这个例子中使用的数据是关于汽车的。具体包含有关二手汽车的各种信息数据点,如价格,颜色等。在这里,我们需要明白,仅仅收集数据是不够的。原始数据没有用。在这里,数据分析在释放我们所需的信息并获得对这些原始数据的新见解方面发挥着至关重要的作用。

考虑一下这个场景,我们的朋友想卖掉他的车。但是他不知道他的车应该卖多少钱!他希望利润最大化,但他也希望以合理的价格出售给想要拥有它的人。所以在这里,我们,作为一个数据科学家,我们可以帮助我们的朋友。

让我们像数据科学家一样思考,并明确定义他的一些问题:例如,是否有其他汽车的价格及其特性的数据?汽车的哪些特点会影响其价格?颜色?品牌?马力是否也会影响销售价格,或者其他什么?

作为数据分析师或数据科学家,这些是我们可以开始思考的一些问题。为了回答这些问题,我们需要一些数据。但这些数据都是原始数据。因此,我们首先需要分析它。

数据源:https://archive.ics.uci.edu/ml/machine-learning-databases/autos/imports-85.data

所需模块

- pandas:Pandas是一个开源库,允许您在Python中执行数据操作。Pandas提供了一种简单的方法来创建、操作和处理数据。

- numpy:Numpy是使用Python进行科学计算的基本包。numpy可以用作通用数据的有效多维容器。

- Matplotlib:Matplotlib是一个Python 2D绘图库,可以生成各种格式的出版质量图。

- Seaborn是一个基于matplotlib的Python数据可视化库。Seaborn提供了一个高级界面,用于绘制有吸引力和信息丰富的统计图形。

- Scipy是一个基于Python的开源软件生态系统,用于数学,科学和工程。

以下代码中使用的步骤(简短说明)

- 导入软件包

- 设置数据文件(.csv文件)的路径

- 查找我们的文件中是否有任何空数据或NaN数据。如果有,请将其移除

- 对您的数据执行各种数据清理和数据可视化操作。为了更好地理解,这些步骤以注释的形式在每一行代码旁边进行了说明,因为并排查看代码比在这里完全解释代码更好,这是没有意义的。

- 获得结果!

让我们开始分析数据。

第1步:导入所需的模块

# importing section

import pandas as pd

import numpy as np

import matplotlib.pyplot as plt

import seaborn as sns

import scipy as sp

第2步:让我们检查数据集的前五个条目

# using the Csv file

df = pd.read_csv('output.csv')

# Checking the first 5 entries of dataset

df.head()

headers = ["symboling", "normalized-losses", "make",

"fuel-type", "aspiration","num-of-doors",

"body-style","drive-wheels", "engine-location",

"wheel-base","length", "width","height", "curb-weight",

"engine-type","num-of-cylinders", "engine-size",

"fuel-system","bore","stroke", "compression-ratio",

"horsepower", "peak-rpm","city-mpg","highway-mpg","price"]

df.columns=headers

df.head()

data = df

# Finding the missing values

data.isna().any()

# Finding if missing values

data.isnull().any()

第5步:将mpg转换为L/100 km,并检查每列的数据类型。

# converting mpg to L / 100km

data['city-mpg'] = 235 / df['city-mpg']

data.rename(columns = {'city_mpg': "city-L / 100km"}, inplace = True)

print(data.columns)

# checking the data type of each column

data.dtypes

第6步:这里,price是对象类型(string),它应该是int或者float,所以我们需要改变它

data.price.unique()

# Here it contains '?', so we Drop it

data = data[data.price != '?']

# checking it again

data.dtypes

第7步:使用简单的缩放方法示例(其余部分执行)和分箱值进行归一化-分组

data['length'] = data['length']/data['length'].max()

data['width'] = data['width']/data['width'].max()

data['height'] = data['height']/data['height'].max()

# binning- grouping values

bins = np.linspace(min(data['price']), max(data['price']), 4)

group_names = ['Low', 'Medium', 'High']

data['price-binned'] = pd.cut(data['price'], bins,

labels = group_names,

include_lowest = True)

print(data['price-binned'])

plt.hist(data['price-binned'])

plt.show()

# categorical to numerical variables

pd.get_dummies(data['fuel-type']).head()

# descriptive analysis

# NaN are skipped

data.describe()

# examples of box plot

plt.boxplot(data['price'])

# by using seaborn

sns.boxplot(x ='drive-wheels', y ='price', data = data)

# Predicting price based on engine size

# Known on x and predictable on y

plt.scatter(data['engine-size'], data['price'])

plt.title('Scatterplot of Enginesize vs Price')

plt.xlabel('Engine size')

plt.ylabel('Price')

plt.grid()

plt.show()

# Grouping Data

test = data[['drive-wheels', 'body-style', 'price']]

data_grp = test.groupby(['drive-wheels', 'body-style'],

as_index = False).mean()

data_grp

# pivot method

data_pivot = data_grp.pivot(index = 'drive-wheels',

columns = 'body-style')

data_pivot

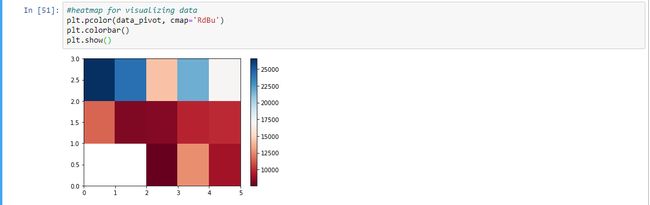

# heatmap for visualizing data

plt.pcolor(data_pivot, cmap ='RdBu')

plt.colorbar()

plt.show()

第12步:获得最终结果并以图形的形式显示。当斜率在正方向上增加时,它是正线性关系。

# Analysis of Variance- ANOVA

# returns f-test and p-value

# f-test = variance between sample group means divided by

# variation within sample group

# p-value = confidence degree

data_annova = data[['make', 'price']]

grouped_annova = data_annova.groupby(['make'])

annova_results_l = sp.stats.f_oneway(

grouped_annova.get_group('honda')['price'],

grouped_annova.get_group('subaru')['price']

)

print(annova_results_l)

# strong corealtion between a categorical variable

# if annova test gives large f-test and small p-value

# Correlation- measures dependency, not causation

sns.regplot(x ='engine-size', y ='price', data = data)

plt.ylim(0, )