卷积神经网络

卷积神经网络

卷积的作用

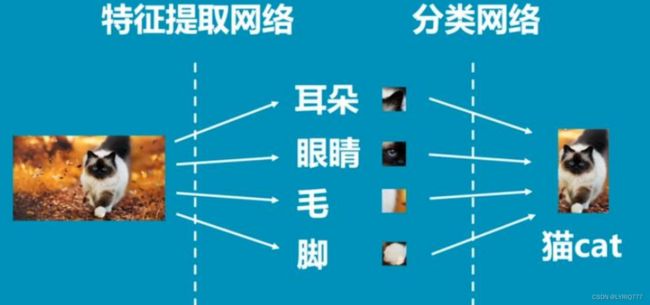

- 特征提取:卷积可以通过滤波器提取出信号中的特征,比如边缘、纹理等。这些特征对于图像分类和识别任务非常重要。

- 降维:卷积可以通过池化操作减小图像的尺寸,从而降低数据的维度。这对于处理大规模图像和文本数据非常有用。

- 去噪:卷积可以通过滤波器去除信号中的噪声。这在信号处理和图像处理领域中非常常见,有助于提高数据的质量。

- 图像增强:卷积可以通过一些滤波器对图像进行增强,比如锐化、平滑等。这有助于提高图像的视觉效果和品质。

卷积的意义

- 模拟生物视觉:卷积操作模拟了人眼对图像进行观察、辨认的过程,因此卷积在图像处理领域应用广泛。它可以帮助我们理解人类视觉系统如何工作,并且为我们提供了一种有效的处理图像和语音的方法。

- 提升算法性能:卷积神经网络(CNN)是目前深度学习中最重要的模型之一,其基本结构就是卷积层,卷积操作在图像识别、语音识别和自然语言处理等领域提升了算法的性能。这使得卷积成为了现代机器学习和人工智能的重要组成部分。

- 数据压缩:卷积可以通过降维和滤波等操作减小数据的尺寸,从而实现数据的压缩。这对于处理大规模数据、实现数据存储和传输非常有用。

我们又知道,深度学习是非常强大的

那么,卷积+深度学习有没有搞头?!

哎,容量够小,深度够深,哎~~~~~~~有东西啊

于是乎CNN(卷积神经网络就来了)

CNN过程

如图:这是特斯拉Model S,0~60英里只需要3.7秒,呸!看右边!

这是卷积的过程:

CONV:卷积

RELU:relu激活函数

激活函数的作用:

关于神经网络中的激活函数的作用,通常都是这样解释:不使用激活函数的话,神经网络的每层都只是做线性变换,多层输入叠加后也还是线性变换。因为线性模型的表达能力通常不够,所以这时候就体现了激活函数的作用了,激活函数可以引入非线性因素

POOL:吃货(操!这该死的输入法),池化!!!

池化层的作用:

神经网络中的一种常用操作,主要用于降低特征图的维度、减少参数数量、提高模型的鲁棒性和泛化能力等方面

看上图,发现什么规律了没,每个色块池化之后,组合成的数字,一定是最大的那个,为啥捏?!特征啊.夜空中最亮的星, 能否听清...(我想你了,开始网抑云时刻)

1,2,3,网抑云时间结束,写完继续emo

FC:全连接(Fully Connected,FC)

得出结果,然后归一化(softmax)进行分类

其中,前三个可以根据需要自由组合,分类可以作为下一个网络的输入.

"s1": "value1",

"s2 ": "value2 "

}

问题

反向传播啊!大哥.

怎么做?训练

看我上一篇推理和训练_LYRIQ777的博客-CSDN博客(刷阅读量了属于是)

这里有很多人不理解,卷积核是怎么更新的,我一开始也没理解,然后看了一下几位大佬的博客并结合一些资料

CNN | 03卷积层的训练_训练卷积核_“逛丢一只鞋”的博客-CSDN博客

卷积神经网络(CNN)的训练过程、权值更新_cnn网络权重怎么训练的_boringApp的博客-CSDN博客

深度学习之卷积神经网络CNN(二)训练方法_cnn网络训练_liuy9803的博客-CSDN博客

过程不想写了,写的头疼,看的也头疼,我现在对数学的认知停留在1+1=3

假设一个卷积核是3*3大小,那么对应的权重值其实就是9(3*3)个,以一层为例,那么就是w1~w9权重,多层同理

注意,这里都是针对最大池化,平均池化的话,需要把原先的池化结果进行均分

写到这边差不多了,see you next time

明天又要上班了,为了梦想奋斗(我的梦想就是不上班)