论文笔记:Zero-Reference Deep Curve Estimation for Low-Light Image Enhancement

来源:CVPR2020

提出背景:

Unsupervised GAN-based methods have the advantage of eliminating paired data for training. EnlightenGAN [12], an unsupervised GAN-based and pioneer method that learns to enhance low-light images using unpaired low/normal light data. The network was trained by taking into account elaborately designed discriminators and loss functions. However, unsupervised GAN-based solutions usually require careful selection of unpaired training data.

The proposed Zero-DCE is superior to existing datadriven methods in three aspects.

First, it explores a new learning strategy, i.e., one that requires zero reference, hence eliminating the need for paired and unpaired data.

Second, the network is trained by taking into account carefully defined non-reference loss functions. This strategy allows output image quality to be implicitly evaluated, the results of which would be reiterated for network learning.

Third, our method is highly efficient and costeffective. These advantages benefit from our zero-reference learning framework, lightweight network structure, and effective non-reference loss functions.

优点:

-

We propose the first low-light enhancement network that is independent of paired and unpaired training data, thus avoiding the risk of overfitting. As a result, our method generalizes well to various lighting conditions.

首个不依赖于图片是否成对的低光增强网络,避免了过拟合的风险。适用于不同的光照环境。 -

We design an image-specific curve that is able to approximate pixel-wise and higher-order curves by iteratively applying itself. Such image-specific curve can effectively perform mapping within a wide dynamic range.

设计了图像特定曲线,能够通过迭代自身,估计出逐像素高有序的曲线。图像特定曲线能够在广泛动态范围内提供映射。 -

We show the potential of training a deep image enhancement model in the absence of reference images through task-specific non-reference loss functions that indirectly evaluate enhancement quality.

展示了缺失参照图片情况下的深度图像增强网络模型的潜力,通过使用直接评估增强质量的特殊任务无参照损失函数。

结构图

To enable zero-reference learning in DCE-Net, we propose a set of differentiable non-reference losses that allow us to evaluate the quality of enhanced images.

Methodology

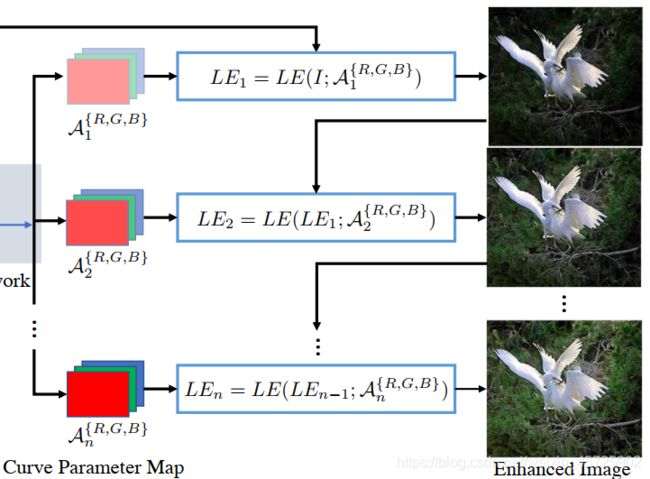

思想:设计了一个深度曲线估计网络(DCE-Net),给定输入图像,估计一组最佳拟合的增光曲线(LE-curves)。这个框架通过迭代应用曲线,来映射输入RGB通道的所有像素,以获得最终的增强图像。

Light-Enhancement Curve (LE-curve)

受照片编辑软件中曲线调整的启发,我们尝试设计一种可以自动将弱光图像映射到增强版的曲线,自适应曲线参数完全依赖于输入图像。

曲线应满足一下三个条件:

1)增强图像的每个像素值都应在[0,1]的归一化范围内,以避免溢出截断导致的信息丢失

2)这条曲线应该是单调的,以保持相邻像素的差异(对比度)

3)在梯度反向传播过程中,该曲线的形式应尽可能简单且可微

分别将LE曲线应用到三个RGB通道上,而不是只应用在照明通道上。

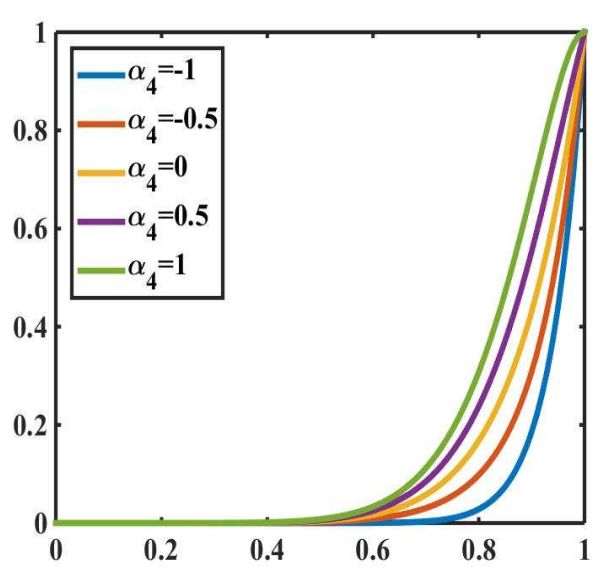

曲线如下图所示:(一阶曲线)

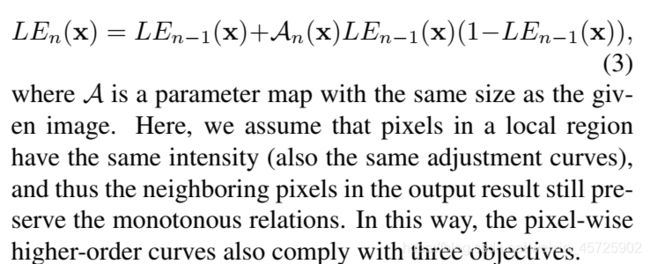

论文中将n设为8,高阶曲线如下图:

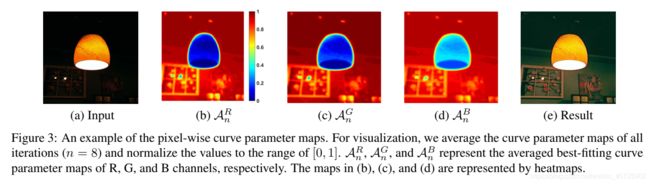

将 α \alpha α 推广至逐像素(pixel-wise)——给定输入图像的每个像素都有对应的具有最佳拟合 α \alpha α 的曲线,以调整其动态范围

从图中可以看出,不同通道的最佳拟合参数图的调整趋势相似,但值不同,说明了弱光图像的三个通道之间的相关性和差异性。

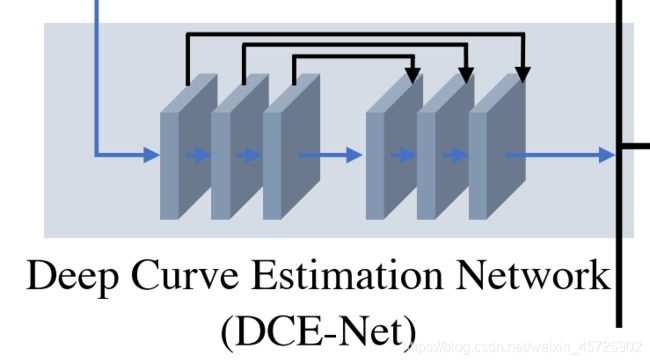

DCE-Net

DCE-Net的输入是一幅弱光图像,而输出是一组对应高阶曲线的像素曲线参数映射。

从代码中看,CNN最终输出24个通道,拆成8份,每份3个通道分别对应RGB。

采用了一个具有对称连接的七层卷积层的普通CNN。

损失函数:

(此部分引用自这篇博客)

为了使得模型的训练过程是Zero-reference的,作者提出了一系列non-reference loss用于评估增强图像的质量。

1. Spatial Consistency Loss:

L s p a L_{spa} Lspa能够维持输入图像与其增强版本之间的邻域差异(对比度),从而促进增强后图像仍能保持空间一致性。

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-PBx7SOZx-1617591291070)(C:\Users\62574\AppData\Local\Temp\1612512957163.png)]](http://img.e-com-net.com/image/info8/7a05be9340bc46248e62f7a4b0ea5e04.jpg)

其中,K为局部区域的数量,Ω(i)是以区域i为中心的四个相邻区域(top, down, left, right),Y和I分别为增强图像和输入图像的局部区域平均强度值。这个局部区域的Size经验性地设置为4x4,如果为其他Size,loss将会变得稳定下来。

2. Exposure Control Loss:

为了控制under-/over-曝光的区域,设计了 L e x p L_{exp} Lexp 来控制曝光程度,其可以衡量局部区域的平均强度与well-exposedness Level E之间的差距。作者遵循现有作法,将E设为RGB颜色空间中的gray level,本文实验中设为0.6(并且作者提到E在[0.4,0.7]之间基本无性能差异)。

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-Zxv2gqum-1617591291070)(C:\Users\62574\AppData\Local\Temp\1612512970665.png)]](http://img.e-com-net.com/image/info8/549fa06489334ed1839120e18e5b4d47.jpg)

其中,M为不重叠的局部区域数量,区域Size为16x16,Y为增强图像中局部区域的平均像素强度值。

3. Color Constancy Loss:

根据Gray-World颜色恒等假设(关于Gray-World可以参照这篇博客:https://zhuanlan.zhihu.com/p/84783847),设计了 L c o l L_{col} Lcol 用于纠正增强图像中的潜在色偏,同时也建立了三个调整通道之间的关系。

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-J2JDKsSN-1617591291071)(C:\Users\62574\AppData\Local\Temp\1612512980871.png)]](http://img.e-com-net.com/image/info8/b34baca9604144b7891b18c0c7837fc3.jpg)

其中,Jp 代表增强图像通道p的平均强度,(p, q)代表一对通道。

4. Illumination Smoothness Loss:

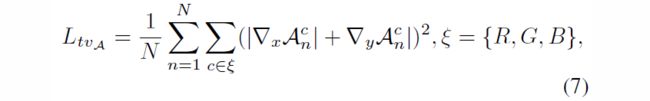

为了保持相邻像素间的单调关系,在每个curve parameter map A上增加了平滑度损失。

其中,N为迭代次数,▽x,▽y 分别代表水平和垂直方向的梯度操作。

Total Loss:

![]()

其中Wcol,WtvA 为Loss的权重(源码中Exposure control loss前也有权重)

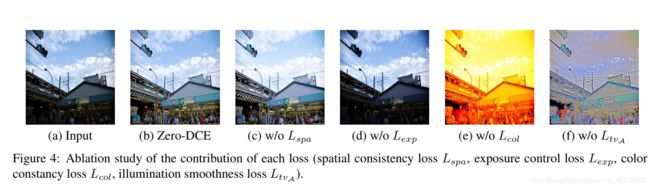

4项损失作用效果如下:

效果展示:

个人记录:

阅读时间:2021寒假

看论文图片的话,我觉得增强效果一般般。但是方法很有新意,论文和代码也很简洁易懂。

补充:但是论文中提出,后端任务(如人脸识别)的效果很好,可能更适用于后续任务,而不仅仅是人眼感知质量。

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-kk9CzIyG-1617591291063)(C:\Users\62574\AppData\Roaming\Typora\typora-user-images\image-20210209151547757.png)]](http://img.e-com-net.com/image/info8/3a5fe7967e47456fba2091b6fe87f3aa.jpg)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-Vm5rcKKS-1617591291064)(C:\Users\62574\AppData\Roaming\Typora\typora-user-images\image-20210209152459119.png)]](http://img.e-com-net.com/image/info8/4dadbf64d5e24fe1b1b9e67c45d37cfa.jpg)