神经网络与强化学习:揭示AI的超能力

文章目录

-

- 神经网络:模拟人脑的工具

- 强化学习:通过试错学习

- 结合神经网络和强化学习

-

- 价值网络

- 策略网络

- 结合训练

- 应用领域

-

- 游戏

- 机器人控制

- 金融交易

- 未来趋势

-

- 自动化和自主系统

- 个性化和自适应系统

- 跨学科研究

- 结论

欢迎来到AIGC人工智能专栏~神经网络与强化学习:揭示AI的超能力

- ☆* o(≧▽≦)o *☆嗨~我是IT·陈寒

- ✨博客主页:IT·陈寒的博客

- 该系列文章专栏:AIGC人工智能

- 其他专栏:Java学习路线 Java面试技巧 Java实战项目 AIGC人工智能 数据结构学习

- 文章作者技术和水平有限,如果文中出现错误,希望大家能指正

- 欢迎大家关注! ❤️

人工智能(AI)领域在过去几年取得了巨大的进展,其中神经网络和强化学习技术的发展尤为引人注目。这两者结合在一起,正在为AI赋予一种超能力,使其能够在各种领域实现卓越的表现。本文将深入探讨神经网络和强化学习的关键概念,以及它们如何相互结合,为AI赋予超能力。

神经网络:模拟人脑的工具

神经网络是一种受到生物神经元结构启发的计算模型。它由多层神经元组成,每一层都与前一层相连。这些神经元接收输入信号,进行加权计算,然后将结果传递给下一层。神经网络的核心思想是通过学习权重参数来逼近和模拟复杂的函数关系,从而实现对数据的分类、识别和预测。

import tensorflow as tf

from tensorflow import keras

# 创建一个深度神经网络

model = keras.Sequential([

keras.layers.Dense(128, activation='relu', input_shape=(784,)),

keras.layers.Dropout(0.2),

keras.layers.Dense(10, activation='softmax')

])

# 编译模型

model.compile(optimizer='adam',

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])

神经网络已经在图像识别、自然语言处理、语音识别等领域取得了巨大成功。然而,它们通常是监督学习的一部分,需要大量带有标签的数据进行训练。这在某些情况下可能不够高效,特别是当面临大规模复杂任务时。

强化学习:通过试错学习

强化学习是一种不同的学习范式,它侧重于通过与环境的互动来学习。在强化学习中,一个智能体(agent)通过采取不同的动作(actions)来最大化它所接收到的奖励信号(rewards)。这种学习方式与人类学习类似,我们通过试验和错误来学习如何最好地完成任务。

import gym

# 创建一个强化学习环境

env = gym.make('CartPole-v1')

# 初始化智能体

agent = MyAgent()

# 训练智能体

for episode in range(num_episodes):

state = env.reset()

done = False

while not done:

action = agent.choose_action(state)

next_state, reward, done, _ = env.step(action)

agent.learn(state, action, reward, next_state)

state = next_state

强化学习已经在许多领域取得了显著的成就,如 AlphaGo 在围棋中击败人类冠军。它对于需要决策制定和长期规划的任务非常有用,但它也面临一个挑战,即需要大量的试验和互动来进行训练。

结合神经网络和强化学习

神经网络和强化学习的结合为AI带来了巨大的威力。这种结合的核心思想是将神经网络用作强化学习智能体的一部分,以帮助其学习更复杂的策略和决策。

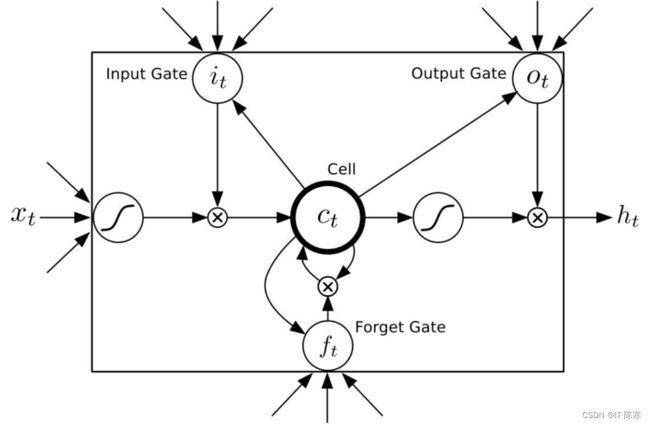

价值网络

在结合中的一个关键概念是“价值网络”(Value Network)。价值网络使用神经网络来估计在给定状态下采取不同动作的预期回报。这有助于智能体了解哪些动作可能导致更好的结果。

class ValueNetwork(tf.keras.Model):

def __init__(self):

super(ValueNetwork, self).__init__()

self.dense1 = keras.layers.Dense(128, activation='relu')

self.dense2 = keras.layers.Dense(1)

def call(self, state):

x = self.dense1(state)

return self.dense2(x)

策略网络

另一个关键概念是“策略网络”(Policy Network)。策略网络使用神经网络来输出在给定状态下采取每个动作的概率分布。这使智能体能够根据预期回报来选择最佳动作。

class PolicyNetwork(tf.keras.Model):

def __init__(self, num_actions):

super(PolicyNetwork, self).__init__()

self.dense1 = keras.layers.Dense(128, activation='relu')

self.dense2 = keras.layers.Dense(num_actions, activation='softmax')

def call(self, state):

x = self.dense1(state)

return self.dense2(x)

结合训练

在结合训练中,智能体使用价值网络来评估状态的价值,并使用策略网络来选择动作。通过与环境的互动,智能体可以不断地更新这两个网络,以改善其策略。

for episode in range(num_episodes):

state = env.reset()

done = False

while not done:

action_prob = policy_network(state)

action = sample_action(action_prob)

next_state, reward, done, _ = env.step(action)

value = value_network(state)

next_value = value_network(next_state)

advantage = reward + discount_factor * next_value - value

policy_loss = -tf.math.log(action_prob[action]) * advantage

value_loss = tf.square(value - (reward + discount_factor * next_value))

total_loss = policy_loss

+ value_loss

update_networks(total_loss)

state = next_state

这种结合的方法使强化学习智能体能够在学习中更好地探索环境,并更有效地选择动作。神经网络提供了对复杂状态和动作空间的建模能力,使智能体能够学习高度抽象的策略。

应用领域

神经网络和强化学习的结合已经在多个应用领域取得了显著的成就,这些成就正在改变我们生活的方方面面。下面将详细探讨这些领域以及它们的重要性。

游戏

游戏领域是神经网络和强化学习结合的一大亮点。AI已经在各种游戏中表现出色,包括国际象棋、围棋、星际争霸等。这些AI能够与人类冠军竞争,并在许多情况下获胜。这不仅仅是为了娱乐,还是为了测试和改进AI的智能和决策能力。此外,游戏领域的成功案例也激励着其他领域采用相似的方法。

在国际象棋领域,IBM的Deep Blue曾经战胜世界冠军国际象棋选手加里·卡斯帕罗夫。而在围棋领域,Google的AlphaGo更是战胜了围棋世界冠军李世石,展示出神经网络和强化学习的强大潜力。

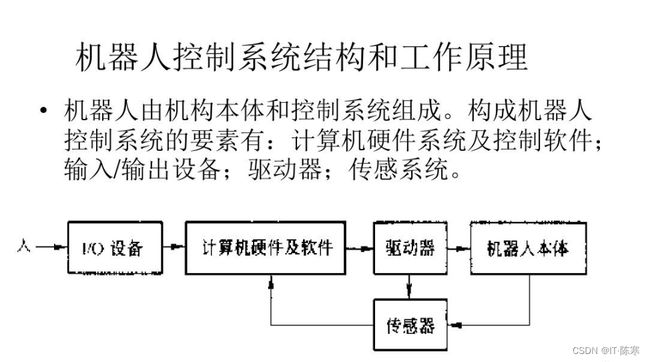

机器人控制

机器人领域是另一个受益匪浅的领域。结合方法已经用于实现机器人的自主导航、目标追踪和动作执行。这使得机器人能够在复杂的环境中执行任务,如自动驾驶汽车和无人机。在自动驾驶领域,神经网络和强化学习的应用使得汽车能够根据环境信息作出决策,提高了道路安全和交通效率。此外,无人机的自主飞行和任务执行也离不开这些技术。

这些应用不仅改善了机器人的性能,还扩大了它们在工业、医疗、军事等领域的应用范围。例如,在医疗领域,手术机器人可以通过结合神经网络和强化学习来提高手术的精确度,减少患者的痛苦和康复时间。

金融交易

金融领域也受益于神经网络和强化学习的结合。这种方法已经用于开发股票交易策略、风险管理和投资组合优化。通过分析海量的金融数据,神经网络可以识别出市场趋势和潜在的交易机会。而强化学习则可以用于制定交易策略,以最大化回报并降低风险。

高频交易是一个金融领域中应用广泛的领域,其中神经网络和强化学习的结合可以帮助交易系统更好地适应市场波动,并做出及时的决策。这不仅对金融机构有重要意义,也对个人投资者有潜在的影响。

未来趋势

神经网络和强化学习的结合代表了AI领域的一个重要趋势,未来我们可以期待更多创新和应用的出现。

自动化和自主系统

结合方法将推动自动化系统和自主机器人的发展。这些系统将能够在不断变化的环境中做出复杂的决策,并执行各种任务,从工业生产到医疗保健。例如,在工业生产中,自动化机器人可以根据生产线上的需求自主调整动作和速度,以提高效率和灵活性。在医疗保健领域,自主机器人可以用于手术、康复和病房服务,减轻医护人员的负担。

个性化和自适应系统

AI系统将变得更加个性化和自适应。它们将能够根据用户的需求和偏好来定制服务,从推荐系统到教育和医疗领域。例如,个性化推荐系统可以根据用户的浏览历史和兴趣来提供定制的产品和内容推荐。在教育领域,个性化学习系统可以根据学生的学习进度和能力调整课程内容和难度,提高学习效果。

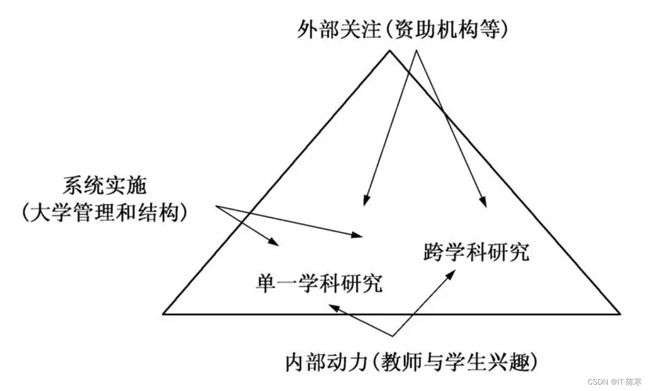

跨学科研究

神经网络和强化学习的结合将促进跨学科研究的发展。AI研究人员、神经科学家和心理学家将合作研究大脑和智能体之间的相似之处,以及如何将这些发现应用于AI系统的改进。这将推动我们更好地理解智能和决策的基本原理,为AI的未来发展提供更多的灵感和指导。

总之,神经网络和强化学习的结合为AI带来了巨大的潜力和机会,它们将继续推动科学技术的发展,并为我们的社会创造更多的可能性和进步。无论是在游戏、机器人控制、金融交易还是其他领域,这些方法都将发挥关键作用,带来更智能、更自适应的系统和服务。这是一个充满希望和挑战的时代,我们期待着看到这些技术的不断发展和应用。

结论

神经网络和强化学习的结合为AI赋予了超能力,使其能够在各种领域实现卓越的表现。这一趋势将继续推动AI领域的创新和发展,为我们的社会带来更多的可能性和机会。我们正处于一个充满挑战和机遇的时代,神经网络和强化学习将在其中发挥关键作用。

结尾

❤️ 感谢您的支持和鼓励!

您可能感兴趣的内容:

- 【Java面试技巧】Java面试八股文 - 掌握面试必备知识(目录篇)

- 【Java学习路线】2023年完整版Java学习路线图

- 【AIGC人工智能】Chat GPT是什么,初学者怎么使用Chat GPT,需要注意些什么

- 【Java实战项目】SpringBoot+SSM实战:打造高效便捷的企业级Java外卖订购系统

- 【数据结构学习】从零起步:学习数据结构的完整路径