【基于递归混合尺度:无监督GAN:Pansharpening】

Pansharpening Using Unsupervised Generative Adversarial Networks With Recursive Mixed-Scale Feature Fusion

(基于递归混合尺度特征融合的无监督生成对抗网络泛锐化)

全色锐化(pansharpening)是提高多光谱图像空间分辨率的重要技术。大多数模型都是在降低分辨率下实现的,导致在全分辨率下的结果不理想。此外,在细节注射中,质谱与全色(PAN)图像之间的复杂关系往往被忽略。针对上述问题,建立了基于递归混合尺度特征融合的无监督生成对抗网络(RMFF-UPGAN)模型,以提高空间分辨率并保留光谱信息。RMFF-UPGAN包括一个发生器和两个u型鉴别器。生成器中设计了双流梯形支路,以获取多尺度信息。在此基础上,设计了递归混合尺度特征融合子网。对提取的相同尺度的MS和PAN特征进行先验融合。在先前细尺度和粗尺度融合结果的基础上进行混合尺度融合。RMFF-UPGAN包括一个生成器和两个u型鉴别器。按照上述方式依次进行融合,构建递归混合尺度融合结构,最后生成关键信息。设计了一种补偿信息机制,对关键信息进行重构,对信息进行补偿。为了克服由于忽略了MS和PAN图像之间的复杂关系而引起的失真,提出了一种重构信息的非线性整流块。设计了两个u型鉴别器,定义了一个新的复合损失函数。使用两个卫星数据验证了所提出的模型,结果表明,在视觉评估和客观指标方面,该模型优于其他先进的方法。

INTRODUCTION

遥感图像广泛应用于地质勘探、地形分类、农业产量预测、病虫害检测、灾害预测、国防、环境变化检测等领域。在这些应用中,需要具有高空间分辨率、高光谱分辨率或高时间分辨率的图像。然而,由于传感器技术的限制,我们获得的是低空间分辨率多光谱或高光谱(LRMS/LRHS)图像,低时间分辨率多光谱或高光谱图像,以及低光谱分辨率全色(PAN)图像。这需要融合技术将LRMS和PAN图像融合在一起,生成高空间分辨率的多光谱(HRMS)图像。这种融合技术被称为全色锐化(pansharpening)。泛锐化技术一般分为组件替代(CS)方法、多分辨率分析(MRA)技术、变分优化(VO)方法和深度学习(DL)模型。

CS技术主要包括强度-色调-饱和度(IHS)及其变体、Gram-Schmidt (GS)、GS自适应(GSA)、主成分分析(PCA)和波段相关空间细节(BDSD)。首先,将LRMS图像投影到另一个空间域,然后提取空间结构信息并替换为高分辨率图像。最后,将图像反变换到原始空间中,得到融合图像。CS的优点是简单、应用广泛、可集成在单个软件中、易于实现,并且大大提高了LRMS图像的空间分辨率。缺点包括光谱失真、过锐化、混叠和模糊问题。

MRA方法主要包括基于平滑滤波器的强度调制(SFIM)、拉普拉斯金字塔(LP)变换、广义LP (GLP)变换、曲波变换、contourlet变换、非采样contourlet变换(NSCT)、调制传递函数-GLP (MTF-GLP)变换及其变体。MRA方法对LRMS和PAN图像进行分解,然后根据一定的规则进行融合,通过逆变换生成融合图像。与CS方法相比,MRA方法可以保留更多的光谱信息,减少光谱失真,但其空间分辨率相对较低。

VO方法可分为两部分:能量函数和优化方法。其核心是变分模型的优化,如全色和多光谱图像(P+XS)模型、非局部变分全色锐化模型等。与CS方法和MRA方法相比,VO方法具有更高的光谱保真度,但计算更复杂。

卷积神经网络(CNN)和生成对抗网络(GAN)在图像处理中得到了广泛的应用。在遥感图像的泛锐化方面取得了一些成果。早期,基于超分辨率重建,设计了三层的CNN pansharpening (PNN)。通过将LRMS和PAN图像对输入到PNN中,利用CNN的非线性映射生成HRMS图像。PNN相对简单,易于实现,但容易出现过拟合。随后,对目标自适应CNN (TA-CNN)进行建模,利用目标自适应调整阶段来解决数据源不匹配和训练数据不足的问题。Yang等提出了一种基于ResNet模块的深度泛锐化网络,即PanNet,利用LRMS和PAN图像的高频信息作为输入,输出HRMS和LRMS图像之间的残差。然而,PanNet忽略了低频信息,导致频谱失真。Wei等人建模了一个深度残差泛锐化神经网络(DRPNN),在ResNet块上实现。虽然DRPNN是利用CNN强大的非线性能力来实现的,但需要的样本数量应该随着网络深度的增加而增加,以避免过拟合。对于空间域的训练,模型的泛化能力还有待提高。Deng等提出了基于CS和MRA细节注入模型的FusionNet模型。注入细节通过深度CNN (DCNN)获得。与其他网络不同的是,该网络的输入是PAN图像与LRMS图像的差异,PAN图像与LRMS图像被复制到相同数量的通道中。因此,该网络可以引入多光谱信息,减少光谱失真。Hu等提出了一种多尺度动态卷积神经网络(MDCNN)。该MDCNN主要包含三个模块:滤波器生成网络、动态卷积网络和权值生成网络。MDCNN采用多尺度动态卷积提取LRMS和PAN图像的多尺度特征,并设计权值生成网络,调整不同尺度特征之间的关系,提高网络的适应性。动态卷积虽然提高了网络的灵活性,但网络设计更加复杂。该网络在同时提取LRMS和PAN图像的特征时,往往会降低有效细节信息和光谱信息。Wu等提出了基于分布式融合结构和残差模块的RDFNet,分别提取LRMS和PAN图像的多级特征。然后,将相应级别的MS和PAN图像特征与前一步的融合结果逐渐融合,得到HRMS图像。虽然网络尽可能地利用了多级LRMS和PAN的特征,但受网络深度的影响无法获得更多的细节和光谱信息。Wu等也设计了基于跨尺度融合和多尺度细节补偿的TDPNet。GAN为生成图像提供了巨大的潜力。Shao等提出了一种包含残差编码器-解码器的有监督条件GAN,即RED-cGAN,该GAN在PAN图像的限制下增强了锐化能力。Liu等开发了一种深度基于cnn的泛锐化GAN,即PsGAN,由双流发生器和鉴别器组成,用于将生成的MS图像与参考图像区分开来。Benzenati等介绍了一种由双流发生器和相对论平均鉴别器构成的细节注入GAN (DIGAN)。RED-cGAN, PsGAN和DIGAN是在退化分辨率数据上训练的监督方法,然而,产品不适用于全分辨率数据。Ozcelik等构建了一个将pansharpening视为一种着色的自监督学习框架,即PanColorGAN,该框架通过颜色注入和随机尺度降采样来减少模糊。Li等人提出了一种基于降分辨率数据训练的周期一致GAN的自监督方法,该方法构建了两个生成器和两个鉴别器。将LRMS和PAN图像输入到第一个生成器中得到预测图像,然后将预测图像输入到第二个生成器中得到与输入的PAN保持一致的PAN图像。针对没有参考HRMS图像的问题,提出了几种无监督GAN。Ma等提出了一种无监督泛锐化GAN (Pan-GAN),该GAN由一个生成器和两个鉴别器(一个光谱鉴别器和一个空间鉴别器)组成。该生成器生成HRMS图像与连接的MS和PAN图像。利用光谱鉴别器对HRMS和LRMS图像之间的光谱信息进行判断,使HRMS数据的光谱与LRMS数据的光谱一致。空间鉴别器对HRMS和PAN图像之间的空间信息进行识别,使生成的HRMS图像与PAN图像的空间信息一致。Pan-GAN利用两种鉴别器更好地保留了光谱信息和空间结构信息,解决了监督训练过程中下采样带来的模糊性问题。然而,输入的是串联的MS和PAN图像,导致细节和光谱信息不足。Zhou等提出了一种无监督双鉴别器GAN (PGMAN),它利用一个双流发生器产生HRMS和两个鉴别器分别保留光谱信息和细节。Pan-GAN和PGMAN都是直接在原始数据上进行训练,没有参考图像,在全分辨率下得到了较好的训练效果,但在分辨率下降的数据上得到的训练效果并不理想。这表明模型的泛化能力较差。虽然有学者提出了各种各样的泛锐化网络,并取得了一定的融合效果,但大多数模型都是在降分辨率数据上训练的,由于分辨率的变化,在融合全分辨率数据时存在光谱失真和细节丢失的问题。此外,在细节注入模型中,细节直接添加到上采样的MS图像中,忽略了MS图像和PAN图像之间的复杂的细节,这很可能导致频谱失真或振铃。针对上述问题,采用递归混合尺度特征融合的无监督泛锐化GAN (RMFF-UPGAN)模型,在没有参考图像的观测数据上进行训练,以提高空间分辨率并保留光谱信息。

本文的主要贡献如下:

1)生成器中设计了双流梯形支路,以获取多尺度信息。我们使用ResNeXt块和残差学习块来获取四个尺度的空间结构和光谱信息。

2)通过顺序执行先验融合和混合尺度融合,设计递归混合尺度特征融合结构,生成关键信息。

3)设计了一种补偿信息机制,对关键信息进行重构,对信息进行补偿。

4)为了克服由于忽略了MS和PAN图像之间的复杂关系而引起的失真,提出了一种重构信息的非线性整流块。

5)设计了两个u型鉴别器,并定义了一个新的复合损失函数,以更好地保留光谱信息和细节。

RELATED WORK

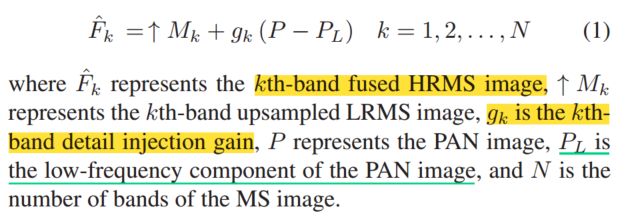

MRA-Based Detail Injection Model

MRA方法是一类图像融合方法,在遥感图像领域尤为常见。这些方法具有良好的多尺度空间频率分解特性、奇异结构表示能力和视觉感知特性。小波高效滤波器组的实现形式为处理大规模遥感图像融合提供了可能。基于MRA方法,首先通过某种分解方法将图像分解为低频分量和高频分量,然后通过融合方法将高频分量和低频分量融合。最后,对融合后的高频分量和低频分量进行逆变换重构,生成融合图像。基于核磁共振的细节注入模型可以用一个通用的细节注入框架来表示,如下式所示:

ResNeXt

Xie等人提出了一种ResNeXt结构,它是对ResNet的改进。该网络利用群卷积降低了网络的复杂度,提高了网络的表达能力。ResNeXt的核心是基数的提议,基数用来衡量模型的复杂性。ResNeXt证明,在计算复杂度和模型参数相似的情况下,增加基数比增加网络的深度或宽度可以获得更好的表达能力。ResNeXt网络结构利用了分裂-转换-合并的思想。但是,每种拓扑的卷积运算是相同的,从而降低了计算复杂度。数学表达式为:

METHODOLOGY

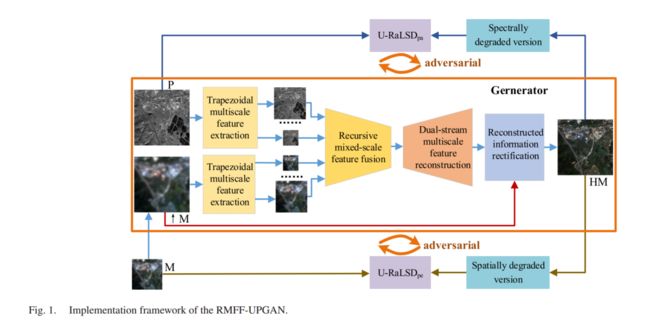

对RMFF-UPGAN进行建模以提高空间分辨率并保留光谱信息。RMFF-UPGAN直接使用原始全分辨率数据进行训练,以减少分辨率变化对结果的影响。RMFF-UPGAN的整体架构如图1所示,由一个双流生成器和两个U形相对平均鉴别器(即U- RaLSDpe和U- RaLSDpa)组成。

图1中,M和P分别代表MS和PAN的原始图像,↑M代表上采样后的MS图像,HM代表融合后的图像。对于发生器,首先设计了双流梯形支路来获取多尺度信息;ResNeXt块提取精细尺度的低级语义信息,残差学习块提取中尺度和粗尺度的高级语义信息,得到四个尺度的空间结构和光谱信息。其次,利用残差学习设计递归混合尺度特征融合子网络;对提取的相同尺度的MS和PAN特征进行先验融合。在细尺度和粗尺度融合结果的基础上进行混合尺度融合。按照上述方式依次进行融合,构建递归混合尺度融合结构,最终生成关键信息。然后,对关键信息进行重构,并设计了关键信息重构的补充信息结构,对信息进行补偿。最后,建立重构信息的整流块,得到融合图像,克服了忽略MS和PAN图像之间复杂关系所导致的失真。设计了两个U型鉴别器,以更好地保留光谱信息和细节。U−RaLSDpa鉴别器将HM图像中的细节与P图像中的细节区分开来,并提示HM图像中的细节与P图像中的细节一致。U - RaLSDpe鉴别器用于区分HM的光谱信息和M的光谱信息,它驱动HM的光谱信息与M图像中的光谱信息一致。

Dual-Stream Generator

所设计的双流发生器由双流梯形多尺度特征提取模块、递归混合尺度特征融合模块、双流多尺度特征重构模块和重构信息整改模块组成。每个模块的体系结构详细说明如下

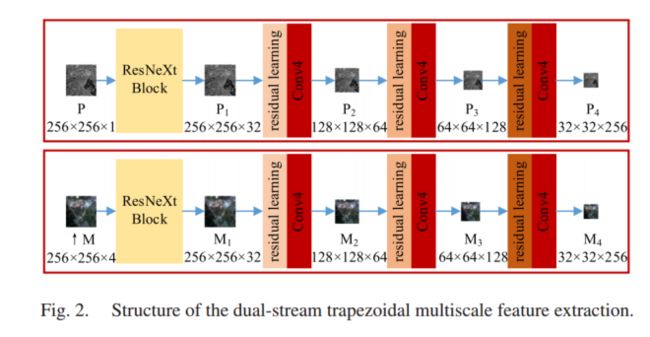

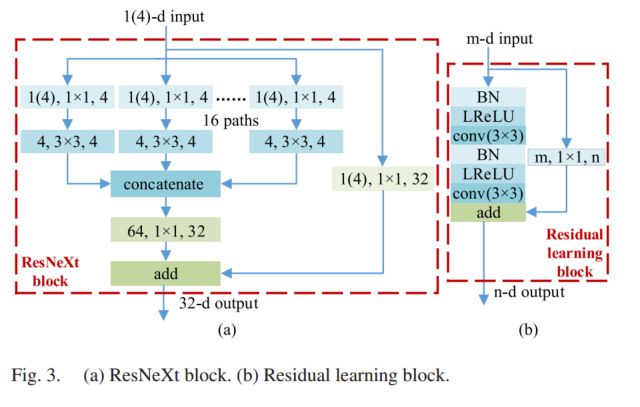

1)Dual-Stream Trapezoidal Multiscale Feature Extraction(DSTMFE):生成器的DSTMFE支路结构如图2所示,它由两个独立支路组成,不同于我们之前的工作TDPNet。我们将maxpooling操作替换为Conv4,即内核大小为4,步长为2的卷积操作。顶部分支提取PAN图像的4个尺度特征,底部分支提取MS图像的4个尺度特征,其中P1−P4表示从PAN图像中提取的4个尺度特征,M1−M4表示从MS图像中提取的4个尺度特征,其大小分别为256 × 256 × 32、128 × 128 × 64、64 × 64 × 128和32 × 32 × 256。由于底层语义特征所代表的PAN和MS图像信息最为丰富,因此组卷积图的ResNeXt提供了多个卷积分支,这提供了一种更好的方式来保留信息。这可以增加基数,提高网络精度,同时降低网络复杂性。因此,为了保留更多的原始信息,降低网络复杂度,ResNeXt模块分别提取第一尺度特征P1和M1。在后三个尺度中,残差学习块和下采样操作(即Conv4)分别提取P2−P4和M2−M4特征。RMFF-UPGAN中使用的ResNeXt块和残差学习块的结构如图3(a)和3(b)所示。在图3(a)中,ResNeXt块中使用的参数为1(4)、1 × 1、4,其中参数1(4)表示PAN (MS)图像的通道数,1 × 1和4表示核大小和卷积数。在图3(b)中,采用泄漏ReLU (LReLU)函数。

使用ResNeXt模块提取MS图像和PAN图像特征的表达式分别如(3)和(4)所示。利用残差学习模块提取MS图像和PAN图像特征的表达式为式(5)-式(8)中,I分别= 2、3、4。

2) Recursive Mixed-Scale Feature Fusion:

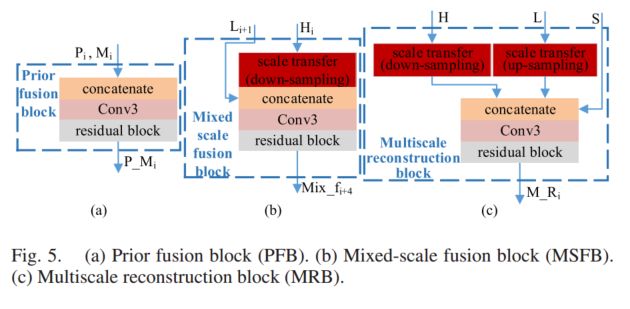

根据DSTMFE阶段生成的四尺度MS和PAN图像,基于残差学习设计递归混合尺度特征融合(RMSFF)子网络,如图4所示,由先验融合块和混合尺度融合块组成。针对MS图像和PAN图像的四尺度特征,设计了先验融合块(prior fusion block, PFB)对MS图像和PAN图像的信息进行聚合。PFB有助于多模态信息的学习和MS图像与PAN图像初步特征的融合。

采用“concatate +Conv3+residual block”模式构建PFB,如图5(a)所示。Conv3是先进行卷积运算,再进行LReLU函数进行初级融合,自适应调整通道数,然后对残差块进行进一步融合。Conv3和残差块的核大小为3 × 3,步长为1。卷积核的个数分别为32、64、128、256。混合尺度融合块(MSFB)进行不同尺度的信息,如图5(b)所示。MSFB使用尺度传输块(STB)、拼接、Conv3和残差块构建,其中Hi表示精细尺度图像,Li+1表示粗尺度图像。STB如图6所示。STB对精细尺度图像Hi进行下采样,生成与Li+1相同尺度的图像,然后与Li+1融合。下行采样采用Conv4,数字分别为64、128、256。混合尺度的融合得到三个尺度的结果,即Mix_f5、Mix_f9和Mix_f13。

如图4所示,首先,PFB将同尺度特征Mi和Pi (i = 1,2,3,4)融合生成P_Mi (i = 1,2,3,4)。然后,MSFB将先前的融合结果P_M~i ~(i = 1,2,3)与下一个尺度结果P_Mi+1 (i = 1,2,3)融合生成与P_Mi+1(i = 1,2,3)具有相同尺度的特征Mix_fi+4 (i = 1,2,3)。按上述顺序实现混合尺度信息融合,并进行递归融合生成关键信息Mix_f13。整个融合子网构成了一个递归混合尺度融合架构,该架构利用了不同模态和尺度的MS和PAN图像信息,减少了MS和PAN图像中的信息丢失。

PFB的表达式如下:

MSFB的表达式如下:

3) Dual-Stream Multiscale Feature Reconstruction: 为了获得更精确的重建信息,设计了双流多尺度重建(DSMR)子网来重建关键信息Mix_f13,如图7所示。

两个分支重构相同尺度不同层次的特征。为了对信息进行补偿,我们设计了一种补偿信息机制(CIM)来重构各个尺度的信息,如图7中绿色箭头所示。Mix_f13,在RMSFF阶段与待重构信息具有相同尺度和更细尺度的先验融合结果,并将与待重构信息具有相同尺度的混合尺度融合结果引入CIM。上层分支利用前一步的重构结果和CIM,通过多尺度重构块(MRB)生成多尺度信息。底部分支利用前一步重构结果、上分支结果、Mix_f13和CIM先前的融合结果生成多尺度信息。上支路M_R2和M_R4的重构结果分别为M_R3和M_R5的重构提供了补充信息。这些多尺度信息逐渐生成最终的重建信息TR。

MRB如图5©所示。与待重构信息的尺度相比,H代表更细尺度信息,S代表同尺度信息,L代表更粗尺度信息。重建前需要将多尺度信息转换成相同尺度的信息,STB如图6所示。通过反卷积操作将粗尺度信息转换为细尺度信息,通过降采样操作将细尺度信息转换为粗尺度信息。MRB使用的Conv3和残差学习块的卷积核大小为3 × 3,步长为1,数字分别为128、64、32。

提出的DSMR结构通过多尺度跳跃连接重用提取的底层特征进行重建。底层特征包含丰富的细节,如边缘和轮廓,可以减少细节的丢失。这样既减少了PAN图像和MS图像中细节的丢失,又提高了空间分辨率。

4) Reconstructed Information Rectification: 由于不同传感器的物理成像,MS图像和PAN图像之间的关系非常复杂。MS图像与PAN图像的波段范围并不完全重合,MS图像波段的线性组合不能准确表达PAN图像。细节注入模型直接将注入的细节与上采样的MS图像相加,作为表达式(1)。细节注入模型忽略了PAN图像与MS图像之间的复杂关系,可能导致光谱失真。因此,我们设计了一种“concatate +Conv1+conv(3 × 3)”模式来构建一个简单的重构信息纠错块(RIRB),该重构信息纠错块构建了一个非线性注入关系。RIRB在图7的橙色框中显示。Conv1的核大小为1 × 1,编号为12,其次是LReLU函数。conv(3 × 3)的核大小为3,数为4。HM图像由↑M图像与重构信息TR进行非线性映射生成。

pansharpening模型的生成器表达式如下:

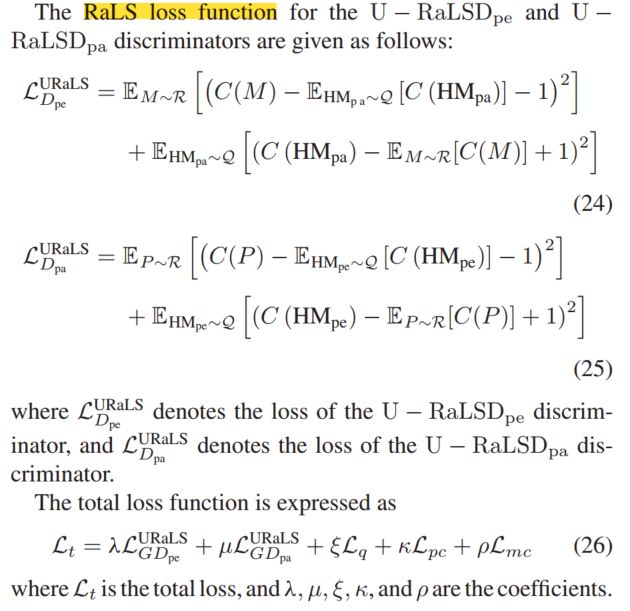

U-Shaped Relative Average Least-Squares Discriminator

为了提高pansharpening模型的性能和稳定性,我们使用了一个相对论平均鉴别器来区分生成的图像和真实图像之间的相对概率,并利用最小二乘损失函数,即相对论性平均最小二乘鉴别器(RaLSD)对模型进行优化。RaLSD的架构类似于Real-esrgan,采用u型结构增强了RaLSD的能力。但不同之处在于,我们采用残差结构来代替现有的卷积运算,在跳接部分,我们采用“concatenate+SN(conv11)+LReLU”模式来代替和运算,以增加网络的判别能力。SN(conv1-1)表示核大小为1、步长为1的卷积操作的谱归一化(SN)。

所提出的U型RaLSD (U-RaLSD)网络的结构如图8所示,该网络由一个频谱鉴别器U- RaLSDpe和一个细节鉴别器U- RaLSDpa组成,U- RaLSDpe和U- RaLSDpa的结构相同。图8为u型结构中彩色箭头的解释,除最后一层的卷积操作外,其余均进行SN操作。

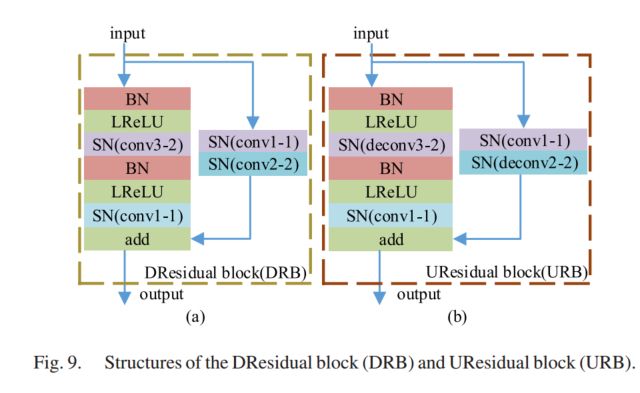

图9(a)和图9(b)显示了u型结构中采用的DRB和URB的架构。在DRB和URB中,我们使用步长为2的卷积而不是maxpooling操作来进行下采样,即SN(conv3-2)是指内核大小为3,步长为2的卷积操作,在conv3-2上执行SN操作。此外,我们对上采样采用了步长为2的反卷积而不是插值操作,即SN(deconv3-2)是指核大小为3,步长为2的转置卷积操作,在deconv3-2上执行SN操作。FURB操作通过简单的融合来完成,即“concatenate+SN(conv1-1)+LReLU”模式,然后是URB。原始MS图像或DHMpa是HM图像的空间简化版本,将其输入U - RaLSDpe以产生相对论性概率。U−RaLSDpa以PAN原始图像或HM图像的频谱化后的DHMpe作为输入。

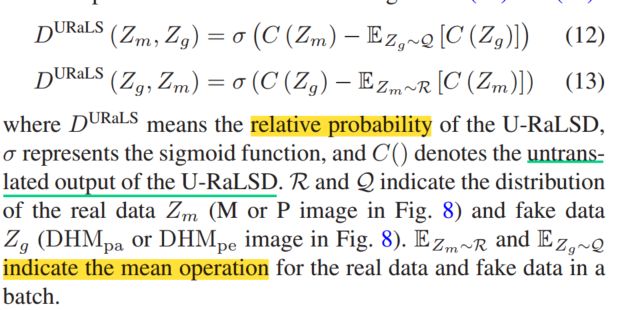

U-RaLSD的表达式如(12)和式(13)所示。

Composite Loss Function

我们建立了一个由空间一致性损失函数、频谱一致性损失函数、无参考损失函数和两个对抗损失函数组成的新的复合损失函数。

空间一致性的损失函数表示为:

目标是将PAN图像的空间信息整合到MS图像中。由于参考图像不存在,我们利用PAN图像的高频信息和梯度信息增强MS图像的空间信息。

为了保持HMt和MS原始图像之间光谱信息的一致性,谱一致性损失函数描述如下:

其中Lmc表示光谱一致性损失函数,ds表示由模糊操作和下采样操作组成的下分辨率操作,Mt为MS原始图像

由于没有参考数据,我们采用无参考指标QNR来衡量生成图像的质量。期望的QNR值为1,即生成的图像既没有频谱损失,也没有空间细节损失。因此,无参考损失函数的表达式为:

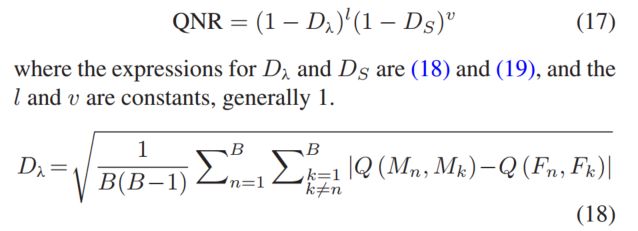

QNR与频谱损耗指标Dλ和空间损耗指标DS相关,表示如下:

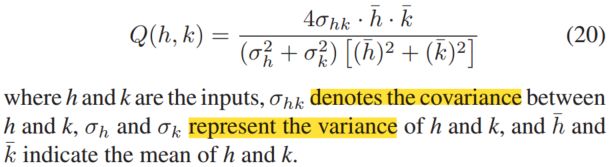

式中B为频带数,Mn和Fn分别为第n波段LRMS图像和生成的HRMS图像。Q为图像质量指数,表示为:

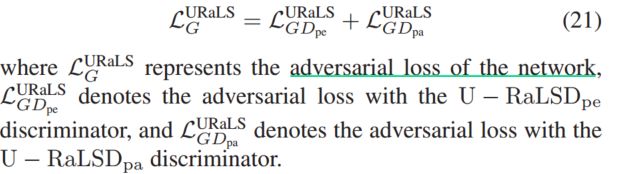

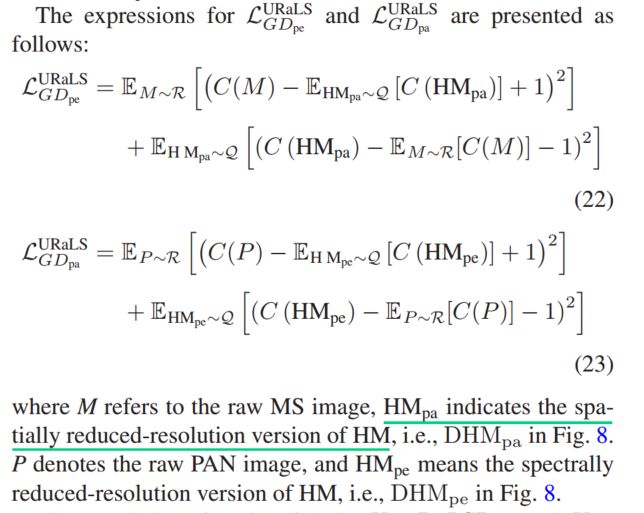

我们使用相对平均最小二乘(RaLS)损失函数对对抗模型进行优化,以提高模型的性能和稳定性。分别具有U - RaLSDpe和U - RaLSDpa鉴别器的生成器的对抗损耗表示为