使用selenium获取1000期双色球数据

使用 Python 爬虫获取双色球数据

文章目录

- 一、分析需求

-

- 1.需要爬取的页面

- 2.找到近1000期的彩票

- 3.保存数据

- 二、实现步骤

-

- 1.解决AJAX反爬技术

- 2.解析组件

- 3.定义表头

- 4.抓取、清洗及保存数据

- 5.完整代码

- 三、总结

一、分析需求

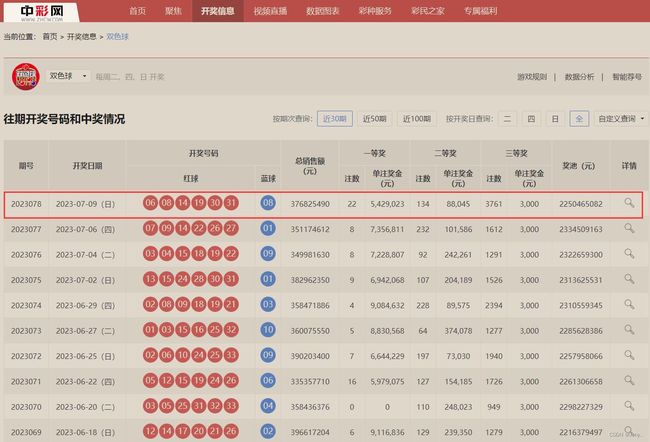

1.需要爬取的页面

url:双色球开奖结果_中彩网

2.找到近1000期的彩票

输入期数1000,跳转到拥有1000期历史数据的页面

通过点击每页页数,观察url变化得知,该页面采用了AJAX,因此无法通过改变url来获取每页的源代码。

3.保存数据

获取到1000期的数据后,存放到名为data1.csv文件中,,并重新命名表头。

二、实现步骤

1.解决AJAX反爬技术

使用 Selenium 库来模拟浏览器行为,访问双色球数据的网页。这能够动态加载网页内容,解决异步请求的机制,并在浏览器中执行 JavaScript 代码,以确保能获取到最新的数据。

import time

from selenium import webdriver

from selenium.webdriver.common.by import By

from selenium.webdriver.edge.service import Service

import pandas as pd

pd.set_option('display.max_columns', None) # 显示完整的列

pd.set_option('display.max_rows', None) # 显示完整的行

pd.set_option('display.expand_frame_repr', False)

# 2.创建浏览器操作对象

path = Service('msedgedriver.exe')

# 不会自动关闭

options = webdriver.EdgeOptions()

options.add_argument('User-Agent=Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/114.0.0.0 Safari/537.36 Edg/114.0.1823.67')

# 使浏览器的window.navigator.webdriver的属性为false

options.add_argument('--disable-blink-features=AutomationControlled')

options.add_experimental_option('detach', True)

browser = webdriver.Edge(service=path, options=options)

# 3.访问网站

url = 'https://www.zhcw.com/kjxx/ssq/'

browser.get(url)

2.解析组件

因选用的是selenium,故可以让程序模拟人为点击页面跟输入数据。

点击查询及下一页的代码如下:

button1 = browser.find_element(By.XPATH, '//div[@class="wq-xlk01"]')

button1.click()

input_1 = browser.find_element(By.XPATH, '//div[@class="xc-q"]/input[@class="qscount"]').send_keys('1000')

button2 = browser.find_element(By.XPATH, '//div[@class="JG-an03"]')

time.sleep(1)

button2.click()

time.sleep(2)

js_buttom = "var q=document.documentElement.scrollTop=10000"

browser.execute_script(js_buttom)

3.定义表头

df = pd.DataFrame(columns=['期号', '开奖日期', '开奖号码|红球', '开奖号码|蓝球', '总销售额(元)', '一等奖|注数',

'一等奖|单注奖金(元)', '二等奖|注数', '二等奖|单注奖金(元)', '三等奖|注数',

'三等奖|单注奖金(元)', '奖池(元)', '详情'])

df.to_csv('data1.csv', header=True, index=None, encoding='utf-8')

4.抓取、清洗及保存数据

-

利用Pandas 的

read_html()方法解析表格数据:Pandas 提供了便捷的方法来将网页中的表格数据解析为数据框架对象,简化了数据提取和处理的过程。 -

使用 Pandas 数据框架的

to_csv()方法将爬取到的数据保存为 CSV 文件。这样,我们可以将数据结构化存储,并可以随时使用 Pandas 或其他数据处理工具对数据进行分析和处理。

df = pd.DataFrame()

i = 1

while(i < 34):

content = browser.page_source

df = pd.DataFrame()

# 获取表格数据

df = df._append(pd.read_html(content, header=1), ignore_index=True)

# 数据清洗处理

df.drop("详情", axis=1, inplace=True)

df.drop(index=0, inplace=True)

print(df)

# 写入csv文件中

df.to_csv('data1.csv', mode='a', header=False, index=None, encoding='utf-8')

i += 1

time.sleep(1)

# 点击下一页

browser.find_element(By.XPATH, '//a[@title="' + str(i) + '"]').click()

5.完整代码

import time

from selenium import webdriver

from selenium.webdriver.common.by import By

from selenium.webdriver.edge.service import Service

import pandas as pd

pd.set_option('display.max_columns', None) # 显示完整的列

pd.set_option('display.max_rows', None) # 显示完整的行

pd.set_option('display.expand_frame_repr', False)

# 2.创建浏览器操作对象

path = Service('msedgedriver.exe')

# 不会自动关闭

options = webdriver.EdgeOptions()

options.add_argument('User-Agent=Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/114.0.0.0 Safari/537.36 Edg/114.0.1823.67')

# 使浏览器的window.navigator.webdriver的属性为false

options.add_argument('--disable-blink-features=AutomationControlled')

options.add_experimental_option('detach', True)

browser = webdriver.Edge(service=path, options=options)

# 3.访问网站

url = 'https://www.zhcw.com/kjxx/ssq/'

browser.get(url)

button1 = browser.find_element(By.XPATH, '//div[@class="wq-xlk01"]')

button1.click()

input_1 = browser.find_element(By.XPATH, '//div[@class="xc-q"]/input[@class="qscount"]').send_keys('1000')

button2 = browser.find_element(By.XPATH, '//div[@class="JG-an03"]')

time.sleep(1)

button2.click()

time.sleep(2)

js_buttom = "var q=document.documentElement.scrollTop=10000"

browser.execute_script(js_buttom)

content = browser.page_source

df = pd.DataFrame(columns=['期号', '开奖日期', '开奖号码|红球', '开奖号码|蓝球', '总销售额(元)', '一等奖|注数',

'一等奖|单注奖金(元)', '二等奖|注数', '二等奖|单注奖金(元)', '三等奖|注数',

'三等奖|单注奖金(元)', '奖池(元)', '详情'])

df.to_csv('data1.csv', header=True, index=None, encoding='utf-8')

i = 1

while(i < 34):

content = browser.page_source

df = pd.DataFrame()

# 获取表格数据

df = df._append(pd.read_html(content, header=1), ignore_index=True)

# 数据清洗处理

df.drop("详情", axis=1, inplace=True)

df.drop(index=0, inplace=True)

print(df)

# 写入csv文件中

df.to_csv('data1.csv', mode='a', header=False, index=None, encoding='utf-8')

i += 1

time.sleep(1)

# 点击下一页

browser.find_element(By.XPATH, '//a[@title="' + str(i) + '"]').click()

print(i)

三、总结

这篇博客中介绍了使用 Python 的 Selenium 和 Pandas 库来爬取双色球数据并发布到博客的过程。通过模拟浏览器行为和使用 Pandas 的数据处理功能,我们能够轻松地获取最新的数据,并将其保存为结构化的文件并发布到博客中,使读者可以方便地访问和下载数据。这个方法为数据获取和发布提供了简单、高效的解决方案,同时展示了 Python 在爬虫和数据处理方面的便捷性和灵活性。

文末:本文仅供学习使用,不支持任何商业或投资用途!

新的数据,并将其保存为结构化的文件并发布到博客中,使读者可以方便地访问和下载数据。这个方法为数据获取和发布提供了简单、高效的解决方案,同时展示了 Python 在爬虫和数据处理方面的便捷性和灵活性。

文末:本文仅供学习使用,不支持任何商业或投资用途!